Web Scraping extrahiert automatisch strukturierte Daten wie Preise, Produktdetails oder Social-Media-Kennzahlen von Websites.

Robotic Process Automation (RPA) konzentriert sich auf die Automatisierung routinemäßiger und sich wiederholender Aufgaben wie Dateneingabe, Berichterstellung oder Dateiverwaltung.

Bei nahtloser Integration durch Tools wie Webhooks oder API-Aufrufe können diese Technologien die betriebliche Effizienz eines Unternehmens erheblich steigern, indem sie datengesteuerte Arbeitsabläufe optimieren und Personalressourcen für höherwertige Aufgaben freisetzen.

Inhaltsverzeichnis

Was ist RPA?

Der Fortschritt ist großartig, aber er ist auch chaotisch. Wir hören häufig von bahnbrechenden Ideen, aber die iterative Reise, die Interaktionen von Tür zu Tür und die Schwierigkeiten bei der Datenerfassung werden selten hervorgehoben.

Die Entwicklung eines großartigen Produkts oder die Einführung einer neuen Funktion ist oft mit mühsamen, sich wiederholenden Aufgaben verbunden – Arbeit, die wichtig, aber nicht unbedingt glamourös ist.

Robotic Process Automation (RPA) ist eine Technologie, die darauf ausgelegt ist, diese auslöserbasierten, sich wiederholenden Aufgaben zu rationalisieren und zu automatisieren und so mehr Raum für kreatives Denken und Innovation zu schaffen.

Beispiele für alltägliche Aufgaben, die mit RPA automatisiert werden:

Dateneingabe:

Übertragen von Daten zwischen Systemen, beispielsweise die Eingabe von Informationen aus E-Mails, Formularen oder Tabellenkalkulationen in eine Datenbank oder ein CRM-System.

Bestandsverwaltung:

Automatische Aktualisierung der Lagerbestände, Verfolgung von Lagerbewegungen und Generierung von Bestellungen basierend auf vordefinierten Branchenschwellenwerten.

Dokumentenverwaltung:

Dateien von einem Speicherort an einen anderen kopieren, Daten organisieren und Dateistrukturen effizient verwalten.

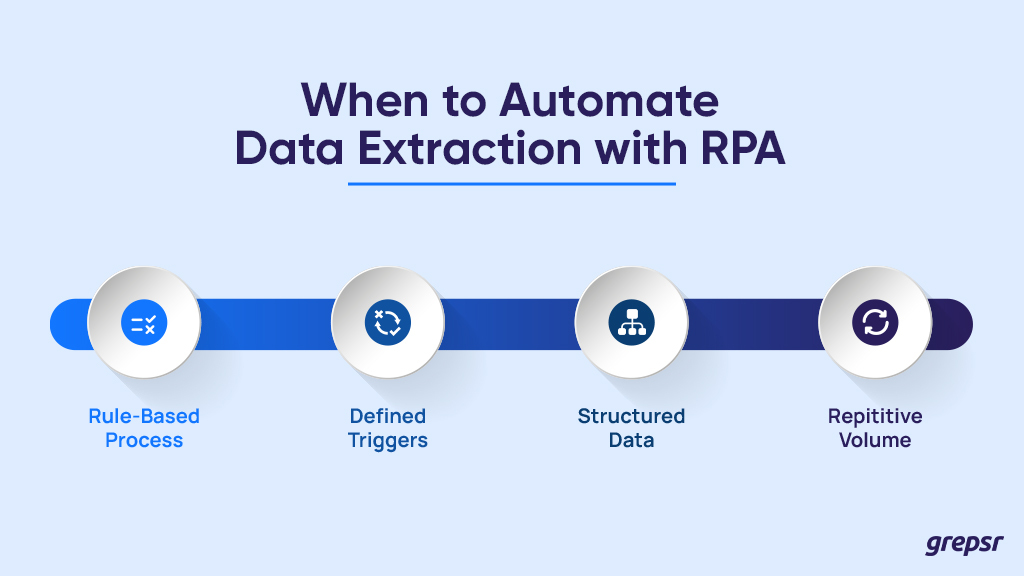

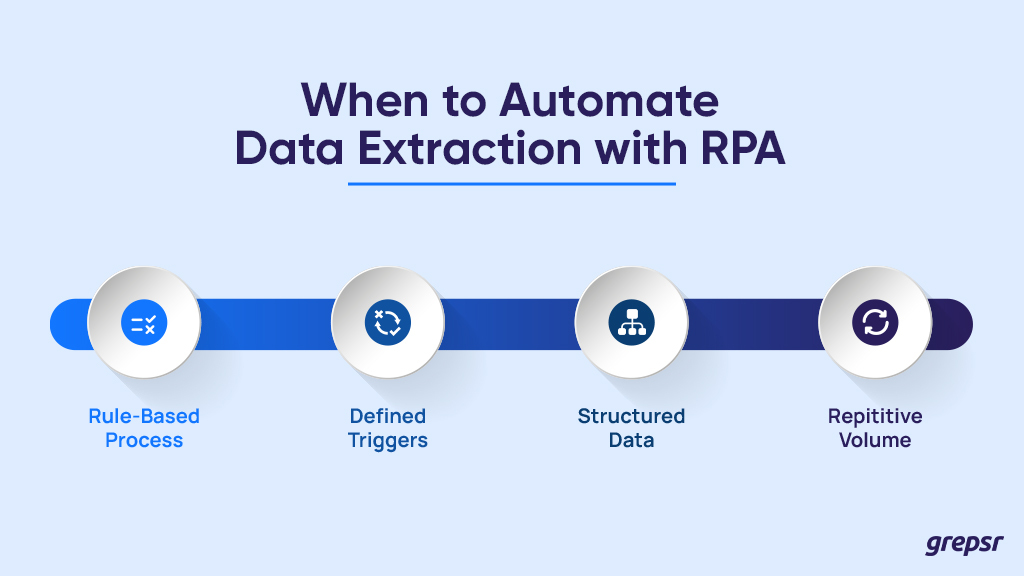

Die Automatisierung der Datenextraktion kann unglaublich effizient sein, aber nicht jedes Projekt ist für RPA geeignet. Hier sind einige wichtige Merkmale, die signalisieren, dass es Zeit ist, den Roboterassistenten hinzuzuziehen:

Regelbasierter Prozess: Kann der Datenextraktionsprozess mit konsistenten Regeln in vorhersehbare Schritte unterteilt werden? Denken Sie an das Ausfüllen von Formularen, das Navigieren auf bestimmten Seiten und das Extrahieren von Daten aus vorgegebenen Speicherorten.

Definierte Auslöser: Hat der Prozess einen klaren Startpunkt, wie z. B. das Hochladen einer neuen Datei, ein geplantes Zeitfenster oder eine bestimmte Benutzeraktion? Wenn Sie wissen, wann Sie beginnen müssen, stellen Sie sicher, dass Ihr RPA-Bot im richtigen Moment aktiv wird.

Strukturierte Daten: Folgen die Daten einem festen Format, sowohl bei der Eingabe als auch bei der Ausgabe? Konsistente Tabellenkalkulationen, API-Aufrufe und Datenbankeinfügungen sind ideale Partner für RPA.

Wiederholtes Volumen: Ist die Datenextraktionsaufgabe häufig und repetitiv und erfordert eine erhebliche Datenmenge? Je routinemäßiger und umfangreicher die Arbeit ist, desto größer ist der Nutzen der Automatisierung.

Denken Sie daran, dass es immer ratsam ist, zuerst manuelle Verfahren zu testen.

Manuelle Tests dienen als Vorbereitungsschritt für die RPA-Engine. Ein reibungslos laufender Motor erfordert eine ordnungsgemäße Vorbereitung, und genau deshalb sorgen ordnungsgemäße Tests für eine reibungslose Datenextraktion.

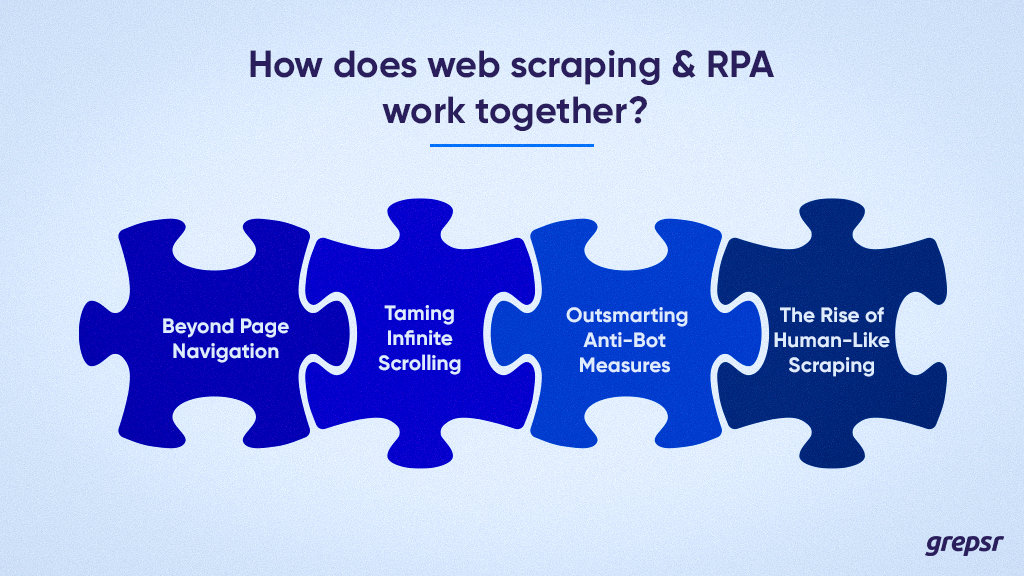

Wie arbeiten Web Scraping und RPA zusammen?

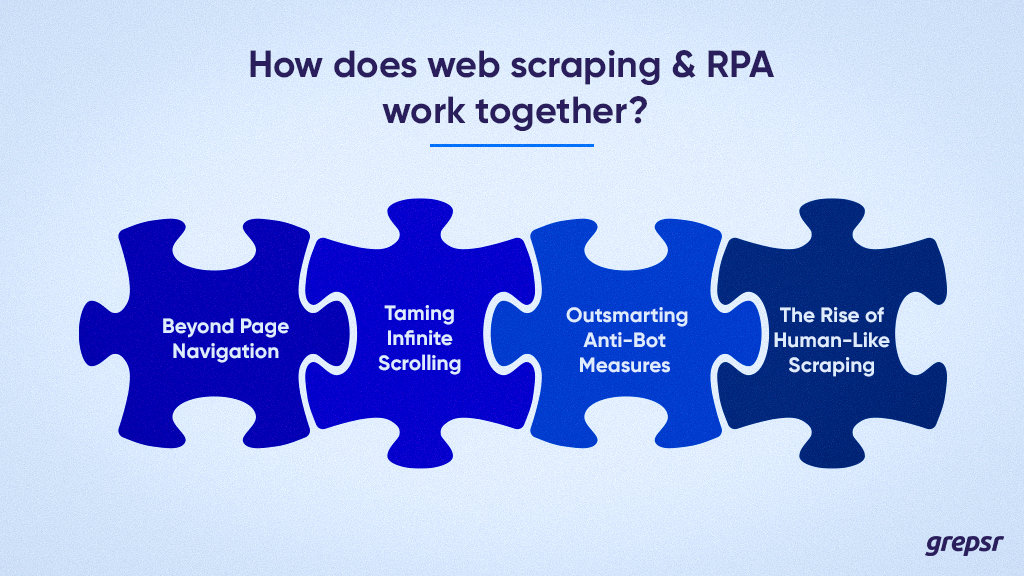

Während das Mantra „Daten abrufen“ jedem Web-Scraping-Projekt zugrunde liegt, geht es beim Web-Scraping selten nur darum, Website-URLs zu identifizieren, einen rudimentären Crawler zu schreiben und auf sauber organisierte CSV- oder JSON-Dateien zu warten. Dieses vereinfachte Szenario verdeckt das komplexe Netz an Herausforderungen, die das moderne Scraping mit sich bringt.

Lassen Sie uns tiefer eintauchen und die wahre Komplexität erkunden, die in realen Scraping-Szenarien auftritt:

Über die Seitennavigation hinaus: Einfache Crawler, die durch statische Seiten navigieren, gehören der Vergangenheit an. Heutige Websites erfordern häufig eine Benutzerinteraktion, etwa das Klicken auf Dropdown-Menüs oder das Navigieren durch die Schaltflächen „Mehr laden“.

Der Umgang mit dynamischen Elementen erfordert fortschrittliche Tools und Techniken, die über einfache Crawler hinausgehen.

Zähmung des unendlichen Scrollens: Websites mit Infinite-Scroll stellen eine einzigartige Herausforderung dar. Scraping-Tools müssen neue Datenblöcke beim Laden dynamisch erkennen und verarbeiten, um eine unvollständige oder ungenaue Datenerfassung zu verhindern.

Anti-Bot-Maßnahmen überlisten: Da Websites immer ausgefeilter werden und Bot-Erkennungsmechanismen nutzen, steigt der Bedarf an intelligenten Scraping-Strategien.

Die Nachahmung menschlichen Verhaltens und die Einhaltung der robots.txt-Protokolle sind von entscheidender Bedeutung, um eine Entdeckung zu vermeiden und eine erfolgreiche Datenextraktion sicherzustellen.

Der Aufstieg des menschenähnlichen Schabens: Die Entwicklung von Anti-Bot-Maßnahmen erfordert Scraping-Techniken, die die menschliche Interaktion nahtlos nachahmen. Dabei handelt es sich häufig um fortschrittliche Tools, die Techniken wie JavaScript-Rendering und Browser-Automatisierungs-Frameworks nutzen.

Wo RPA ins Spiel kommt

Die Bewältigung dieser Komplexität kann entmutigend sein, insbesondere für gelegentliche Datenextraktoren.

Hier kann Robotic Process Automation (RPA) Ihr Game-Changer sein. RPA-Bots können komplexe Arbeitsabläufe automatisieren, Benutzerinteraktionen nachahmen und dynamische Elemente problemlos handhaben.

Sie können auf Schaltflächen klicken, durch unendlich viele Seiten scrollen und durch komplizierte Website-Strukturen navigieren, was Sie von der technischen Belastung befreit.

Der Bedarf an Web Scraping- und RPA-Expertise

Da Websites aktiv daran arbeiten, Bots abzuschrecken, erfordert die Programmierung von Crawlern, die sich authentisch verhalten und der Erkennung entgehen, ein hohes Maß an Fachwissen.

Hier kommen verwaltete Datenextraktionsdienste wie Grepsr ins Spiel. Wir verfügen über qualifizierte Teams und fortschrittliche Werkzeuge, die für die Bewältigung der komplexesten Scraping-Herausforderungen gerüstet sind und eine zuverlässige und effiziente Datenerfassung gewährleisten.

Indem Sie die Feinheiten des modernen Web Scraping anerkennen und fortschrittliche Tools wie RPA nutzen, können Sie das wahre Potenzial dieser leistungsstarken Datenextraktionstechnik erschließen.

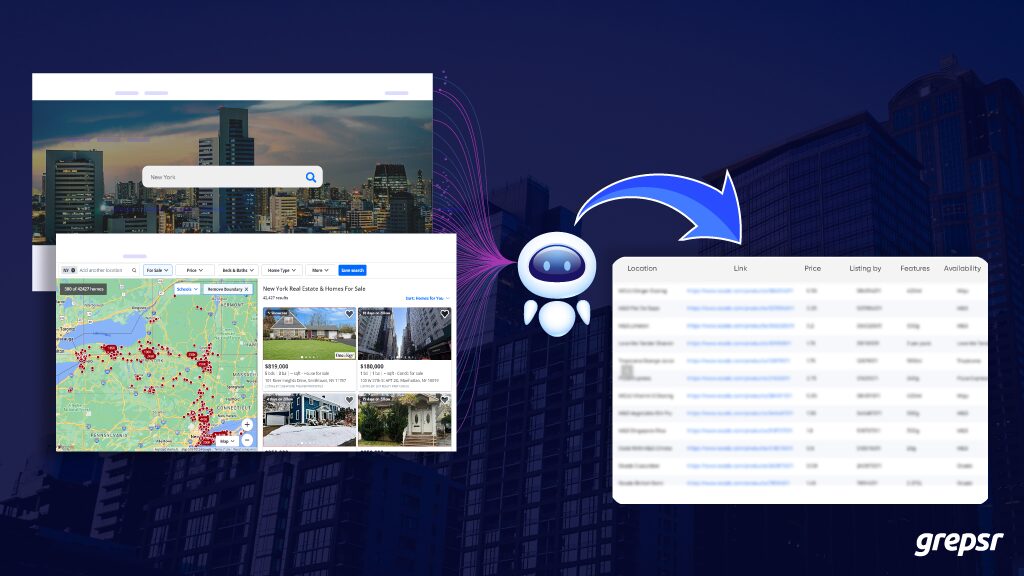

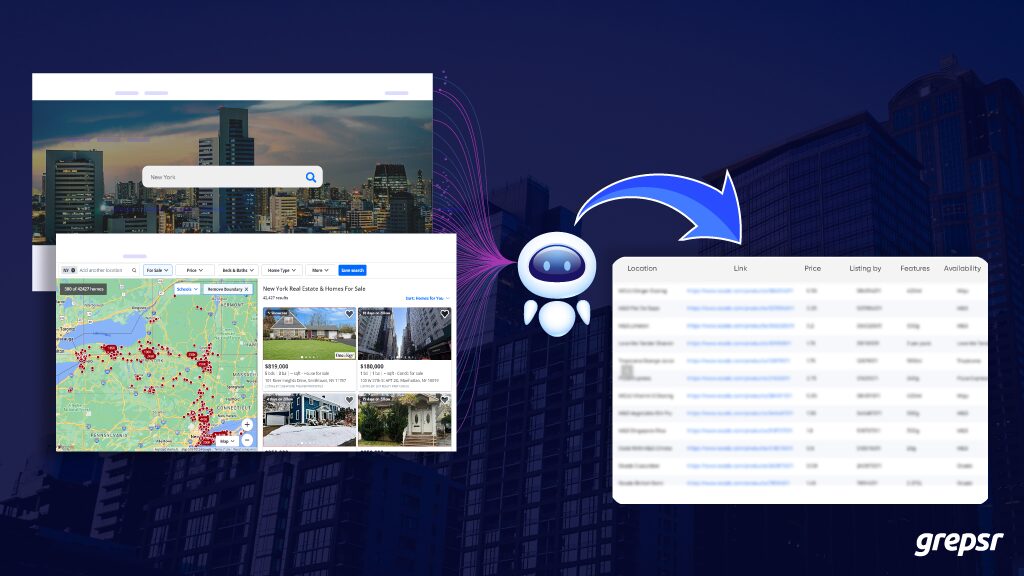

Ein Anwendungsfall für Web Scraping und RPA: Immobilienmarktanalyse

Hintergrund: Eine Immobilieninvestmentgesellschaft, ABC Realty, möchte den Prozess der Informationsbeschaffung zu Immobilienangeboten von Zillow automatisieren, um Markttrends zu analysieren und potenzielle Investitionsmöglichkeiten zu identifizieren.

Zielsetzung: Automatisieren Sie die Extraktion von Immobilieneintragsdetails, einschließlich Immobilienpreisen, Standorten und Merkmalen, aus Zillow zur Marktanalyse.

RPA-Bot-Navigation: Entwickeln Sie einen RPA-Bot, der zur Zillow-Website navigiert. Der Bot gibt bestimmte Suchkriterien wie Standort, Immobilientyp und Preisspanne ein, um die Suchergebnisse einzugrenzen.

Web-Scraping: Der RPA-Bot identifiziert den ersten Link zum Immobilienangebot auf der Suchergebnisseite und klickt darauf.

Auf der Immobilienlistenseite sammelt der Bot relevante Daten wie Immobilienpreis, Lage, Größe, Anzahl der Schlafzimmer/Badezimmer und alle zusätzlichen Funktionen.

Datenverarbeitung und -speicherung: Verarbeiten Sie die geschabten Daten, um die relevanten Informationen zu extrahieren und zu organisieren.

Speichern Sie die gesammelten Immobilienlistendaten in einem strukturierten Format (z. B. CSV, Excel oder Datenbank) zur weiteren Analyse oder Integration in die internen Systeme von ABC Realty.

In Daten begraben? Web Scraping und RPA können Ihnen dabei helfen

Das Web ist voller nutzloser Informationen? Finden Sie nicht die Erkenntnisse, die Sie benötigen? Die manuelle Datenerfassung überfordert Sie? Wir kapieren es. Der Wettbewerb ist schnell, Sie brauchen einen Vorsprung.

Web Scraping und RPA sind Ihre Schaufeln, mit denen Sie wertvolle Daten durchgraben und ans Tageslicht bringen.

Scraping greift genau das, was Sie brauchen, während RPA die Routinearbeit automatisiert.

Vorstellen:

- Markttrends und Wettbewerbsinformationen immer zur Hand.

- Keine endlosen Dateneingaben oder langwierigen Berichte mehr.

- Mehr Zeit für Strategien und Entscheidungen, die das Wachstum vorantreiben.

Wir bieten diskrete, effiziente und auf Sie zugeschnittene Lösungen.