Data kini telah menjadi suatu bentuk mata uang di abad ke-21. Namun ketika Anda berpikir tentang data, saat itulah Anda memikirkannya Pengikisan web A? Kami di sini untuk memberi tahu Anda bahwa memang seharusnya demikian.

Ide terbaik adalah yang paling sederhana, mirip dengan web scraping. Ambil contoh seorang pembicara.

Di luar, speaker adalah objek misterius yang mereproduksi musik dengan presisi yang bahkan tidak dapat ditiru oleh konser sungguhan. Secara teknis, ini tidak lebih dari kumparan suara yang menciptakan medan magnet di sekelilingnya.

Ketika sinyal listrik melewati kumparan, medan magnet yang dihasilkannya berinteraksi dengan magnet permanen.

Akibatnya, kerucut dan kumparan suara yang terhubung bergerak maju mundur, bercampur dengan udara dan menyebabkan kompresi dan penghalusan molekul udara.

Perubahan tekanan ini memancar sebagai gelombang suara.

Apa yang tampak seperti sihir bagi seseorang di abad ke-17 sebenarnya adalah tipuan yang bagus.

Demikian pula, web scraping adalah landasan dari raksasa teknologi paling berpengaruh saat ini – Google. Ini mengumpulkan data dari seluruh dunia dan menyajikannya kepada orang-orang yang mencari informasi spesifik. Rapi, bukan? Mungkin kita terlalu menyederhanakan di sini. Atau apakah kita?

Beberapa merek terbesar di dunia menggunakan data web untuk menciptakan produk dan layanan yang tidak hanya menghasilkan jutaan (bahkan miliaran) dolar, namun juga menciptakan dampak yang hanya dicapai oleh sedikit orang.

Baik untuk memprediksi resesi ekonomi atau menciptakan sensasi budaya besar berikutnya, data web sangat berguna. Semakin banyak data yang Anda miliki, semakin besar peluang Anda untuk sukses.

Sekarang Anda memiliki dua pilihan: menyalin dan menempelkan setiap titik data ke dalam spreadsheet dan meneruskan tugas tersebut kepada cucu Anda sebagai upaya generasi.

Atau Anda dapat mengotomatiskan ekstraksi data dengan web scraping. Dapatkan datanya dengan cepat. Dapatkan wawasan lebih cepat dan ambil keputusan yang tepat sebelum pesaing Anda mengetahuinya. Kami menyarankan Anda memilih dengan bijak.

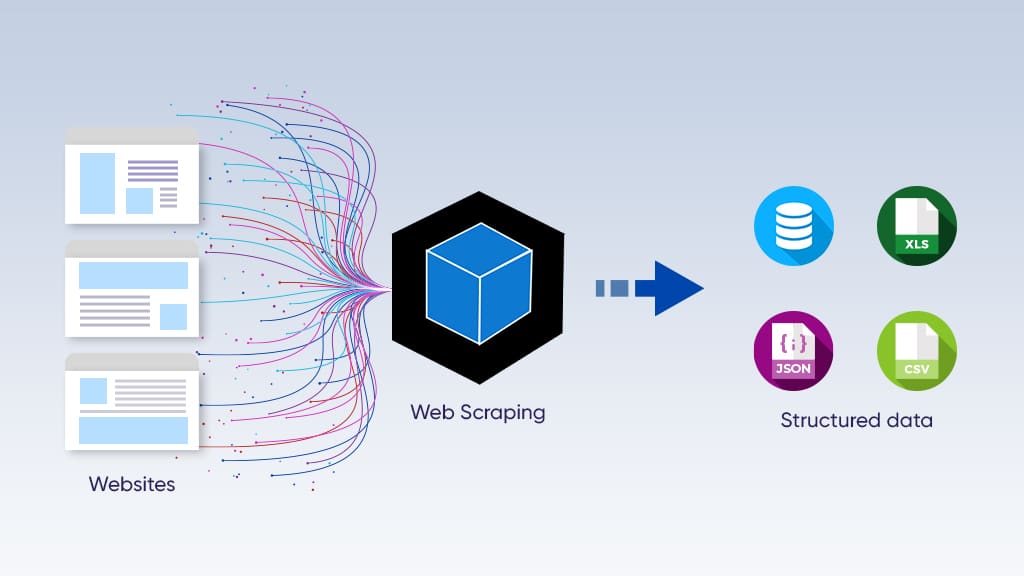

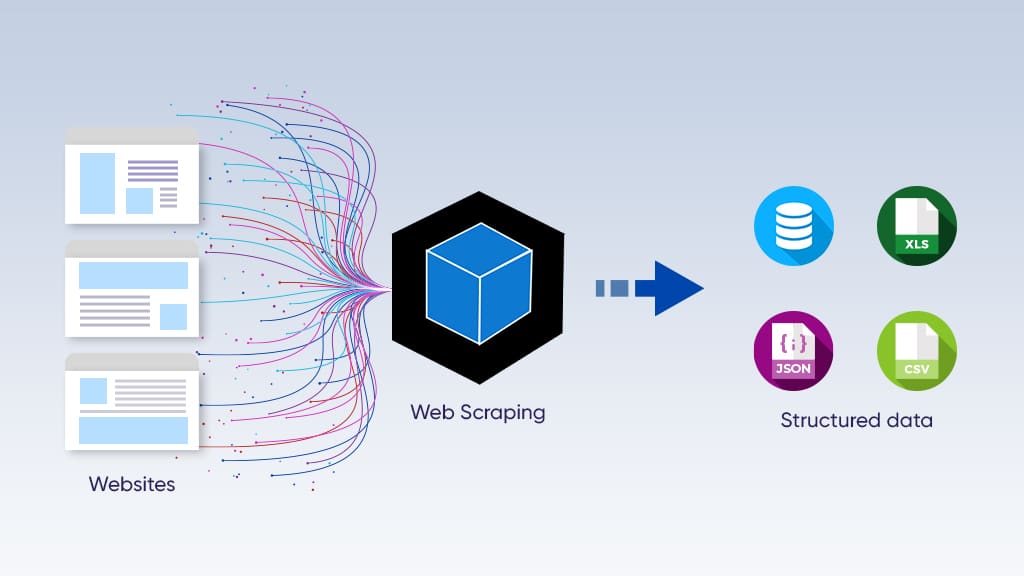

Pengikisan web adalah proses ekstraksi data otomatis dari situs web. Ekstraksi data kemudian melibatkan pengorganisasian informasi menjadi kumpulan data yang terstruktur dan dapat dibaca.

Saat Anda mengunjungi situs web, Anda mengirim permintaan HTTP ke server. Pada dasarnya Anda meminta untuk diizinkan masuk.

Dalam ekstraksi data otomatis, program komputer yang disebut crawler bertugas mengirimkan permintaan. Ia bertanggung jawab untuk menjelajahi web dengan mengikuti tautan dan menemukan halaman web tertentu. Ketika server web memberikan akses, crawler menyimpan beberapa link dari respons. Ia menambahkan tautan ini ke daftar yang dikenali sebagai kunjungan berikutnya.

Perayap menjalani proses ini secara berulang hingga serangkaian kriteria yang telah ditentukan sebelumnya terpenuhi.

Namun, scraper bertanggung jawab untuk mengekstrak data tertentu dari tautan yang dikunjungi oleh crawler. Ini mem-parsing kode HTML dan menggores data ke dalam format yang diinginkan, baik itu CSV, JSON atau spreadsheet Excel sederhana.

Ingatlah bahwa menulis crawler adalah bagian ekstraksi data yang paling mudah.

Lacak pemeliharaan? Tidak banyak.

Sebagian besar situs web sering mengubah strukturnya. Seiring dengan meningkatnya kebutuhan data, pemeliharaan crawler mendapat tempat khusus dalam proyek data. Ini menghabiskan sebagian besar biaya yang terkait dengan keseluruhan ekstraksi data.

Demikian pula, disposisi scraper harus berubah sesuai dengan jenis situs sumber. Misalnya, Anda mungkin perlu menulis scraper yang berbeda untuk menggores Google dan Amazon. Kami melakukan ini untuk memperhitungkan perbedaan semantik di seluruh situs web.

Anda dapat membayangkan Crawler sebagai seorang jenderal militer yang memimpin tentaranya (Scraper) ke medan perang. Perayap membuat strategi dan mengidentifikasi target saat tentara menjalankan strategi tersebut. Dalam web scraping, scraper mengekstrak data di bawah bimbingan crawler.

Baca lima alasan mengapa Anda harus mendapatkannya di sini penyedia data eksternal membutuhkan.

Daftar Isi

Pengikis web: buat atau beli

Solusi pengikisan web DIY

Situs web adalah toko virtual di World Wide Web. Wix menawarkan layanan pengembangan situs web sementara Amazon menjual produk.

Karena tujuannya yang berbeda, informasi disimpan dengan cara yang paling sesuai dengan tujuan situs web. Jika kebutuhan data Anda minimal, Anda dapat dengan mudah memprogram sendiri web scraper dan mengumpulkan data melalui proses web scraping yang dapat diprediksi.

Anda dapat menggunakan pustaka Python seperti BeautifulSoup dan Scrapy untuk web scraping. Panda dan Kutub termasuk dalam spesies serupa dan sangat membantu dalam memproses data yang berasal dari situs web.

Jika Anda ingin membuat web scraper kecil, Anda harus membaca panduan berikut tentang ekstraksi data menggunakan Python dan PHP.

Peringatan: Anda dapat memengaruhi kinerja situs web sumber jika Anda mulai mengumpulkan data dalam skala besar. Mengirimkan terlalu banyak permintaan ke server dapat berdampak negatif terhadap kinerjanya. Lagi pula, sebagian besar situs web memiliki tujuan tertentu: untuk melayani pembaca dan pelanggannya, dan dari waktu ke waktu, browser biasa.

Selain itu, Anda berisiko menghabiskan sebagian besar daya sistem komputer Anda, terutama memori dan RAM. Hingga proyek ekstraksi data Anda selesai, Anda tidak akan dapat menggunakan aplikasi lain dalam program Anda dengan benar.

Tidak semua orang menyukai rute pembangunan. Jika Anda tidak memiliki pengalaman pemrograman apa pun, Anda beruntung. Lihat alat pengikis web gratis kami di sini. Ini adalah ekstensi browser yang dapat Anda instal dengan mudah. Selain itu, alat pengikis web menawarkan antarmuka tunjuk-dan-klik yang intuitif untuk memudahkan ekstraksi data.

Katakanlah Anda perlu memantau ribuan harga produk di Amazon. Karena harga cukup sering berubah, fluktuasi harga perlu diwaspadai.

Tambahkan lebih banyak situs e-niaga seperti eBay, Target, dan Walmart, dan Anda akan menghadapi banyak kekacauan web.

Selain itu, situs web sering kali mengubah strukturnya dan menerapkan berbagai tindakan anti-bot. Selain mengaktifkan file robots.txt, yang memberi tahu web scraper konten apa yang dapat dan tidak dapat diakses, mereka juga menerapkan tindakan anti-bot tingkat lanjut seperti pemblokiran IP, captcha, dan perangkap honeypot.

- pemblokiran IP: Host web memantau pengunjung yang mengakses situs web mereka. Mereka memblokir alamat IP yang membuat terlalu banyak permintaan.

- Captcha: Situs web menerapkan tes Turing publik yang sepenuhnya otomatis untuk membedakan komputer dari manusia guna memblokir bot mengakses kontennya.

- pot madu: Biasanya, situs web menambahkan tautan yang tidak terlalu mencolok di laman webnya. Sesuatu yang bisa dibedakan oleh manusia.

Dan semua ini tanpa mempertanyakan legalitas web scraping. Sebagai aturan praktis, Anda tidak boleh mengekstraksi data yang tidak tersedia untuk umum. Baca lebih lanjut tentang legalitas web scraping di sini.

Sekarang setelah kita mengklarifikasi masalah yang terkait dengan ekstraksi data skala besar, kita akhirnya dapat mempelajari solusinya.

Grepsr adalah salah satu dari sedikit penyedia layanan ekstraksi data terkelola yang paling andal untuk kebutuhan data global. Kami menawarkan solusi khusus tanpa kode untuk ekstraksi data web.

Ini adalah layanan pramutamu yang dirancang untuk melindungi pengguna dari seluk-beluk proses pengikisan web. Kami mengandalkan kualitas dan pengalaman puluhan tahun.

Platform ekstraksi data dan manajemen data Grepsr dirancang untuk memenuhi kebutuhan web scraping perusahaan.

Platform manajemen data berskala besar kami memiliki ciri-ciri utama sebagai berikut:

- Otomatisasi pengikisan web: Menerapkan pembaruan tepat waktu pada web scraper dan memproses jutaan halaman setiap jam.

- Berbagai pilihan pengiriman: Mengirimkan data dalam format yang paling sesuai untuk Anda – Drobox, FTP, Webhooks, Slack, Amazon S3, Google Cloud, dll.

- Kualitas data dalam skala besar: Menyediakan secara kualitatif data berkualitas tinggi dalam skala besar, mengandalkan perpaduan sumber daya manusia, proses, dan teknologi.

- Otomatisasi dan integrasi yang mudah: Mengatur jadwal ekstraksi data khusus dan mengotomatiskan pengikisan rutin agar berjalan lancar.

- Pengikisan web yang bertanggung jawab: Rotasi IP 24/7 dan pembatasan otomatis untuk menghindari deteksi dan mencegah kerusakan pada sumber web.

kata-kata terakhir

Jika Anda baru mengenal web scraping, kami yakin Anda kini memiliki semua yang dibutuhkan untuk memulai.

Jika Anda seorang profesional berpengalaman, jangan ragu untuk menghubungi kami untuk konsultasi data tanpa kewajiban. Mungkin kami akan menemukan aspek-aspek yang belum Anda pikirkan.

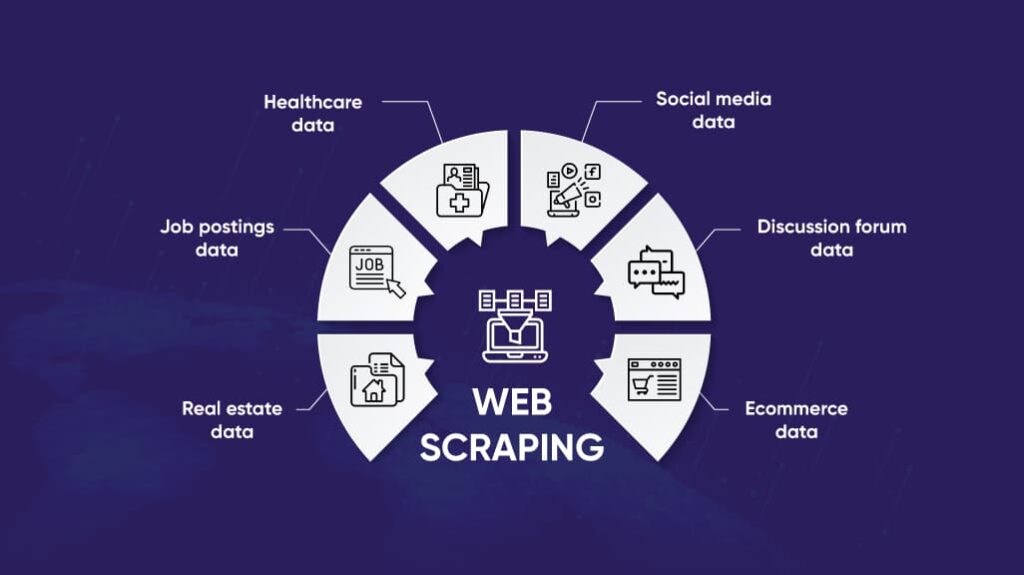

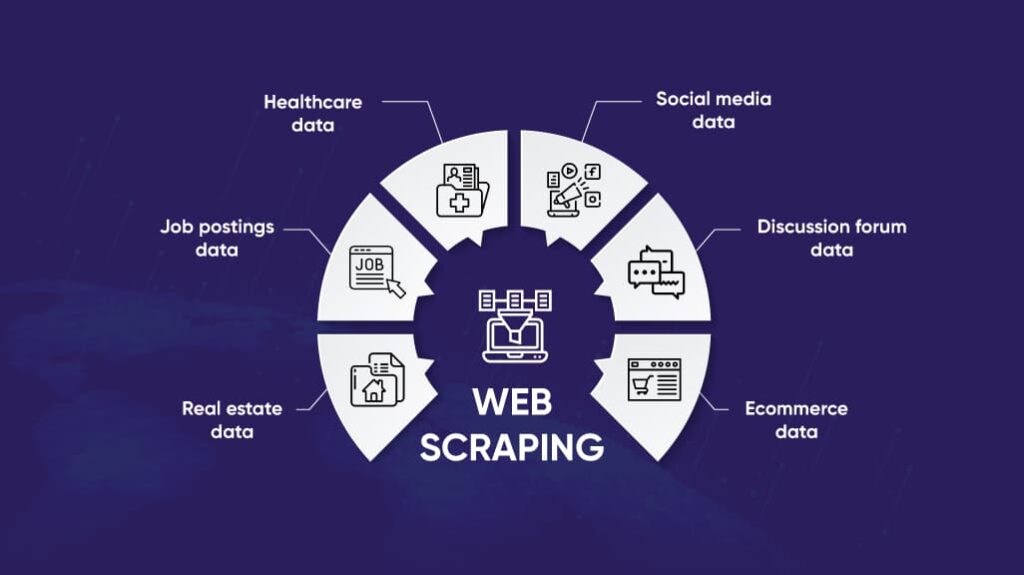

Mengenai aplikasi ekstraksi data, kami bahkan belum membahasnya secara mendalam di artikel ini. Namun demikian, Anda dapat mempelajari bagaimana web scraping dapat bermanfaat bagi ceruk industri Anda di bagian industri kami.

Dari e-commerce hingga jurnalisme, web scraping adalah cara yang efisien dan efektif untuk mendapatkan akses ke data yang dapat ditindaklanjuti. Dari sudut pandang intuitif, web scraping mungkin bukan hal pertama yang terlintas dalam pikiran.

Namun di sisi lain, ide-ide sederhanalah yang seringkali mengejutkan Anda.