Apakah Anda lelah mengekstraksi data secara manual dari situs web? Apakah Anda ingin menghemat waktu dan tenaga sambil mengumpulkan informasi berharga? Kemudian … Pengikisan web dengan tepat! Teknik canggih ini menggunakan skrip otomatis atau perayap web untuk mengekstrak data tertentu dari situs web dengan cepat dan akurat.

Artikel ini membahas seluk beluk web scraping – termasuk manfaat, teknik, alat, kasus penggunaan, dan pertimbangan hukumnya. Baik Anda seorang pengembang berpengalaman atau pemula dalam ilmu data, pemasaran, keuangan, investasi, dll., panduan ini cocok untuk Anda. Mari selami dan temukan bagaimana web scraping dapat merevolusi proses kerja Anda!

Daftar Isi

Apa itu pengikisan web?

Pengikisan web adalah teknik mengekstraksi data dari situs web menggunakan skrip otomatis, juga disebut perayap web atau laba-laba. Ini melibatkan pengunduhan kode HTML situs web dan menganalisisnya untuk mengekstrak informasi spesifik seperti teks, gambar, tautan, dll. Data yang diekstraksi kemudian dapat disimpan dalam database untuk dianalisis atau diedit lebih lanjut. Individu dan seluruh perusahaan menggunakan web scraping untuk membuat keputusan yang lebih cerdas.

Keuntungan utama dari web scraping adalah kemampuan untuk memproses data dalam jumlah besar dengan cepat dan akurat dengan mengotomatiskan seluruh proses dan memerlukan sedikit campur tangan manusia dari Anda. Selain itu, Anda dapat mengakses sejumlah besar informasi yang tersedia untuk umum yang mungkin sulit atau mahal untuk diperoleh dengan cara lain, seperti membeli kumpulan data.

Selain itu, karena sebagian besar pemilik situs web tidak menyadari bahwa situs web mereka sedang diretas, tidak ada masalah hukum terkait dengan pengambilan data yang tersedia untuk umum dari berbagai situs web di Internet, asalkan mereka mengikuti semua undang-undang yang berlaku di negara/wilayah negara mereka mengenai kebijakan dan ketentuan privasi. . kondisi dll.

Teknik pengikisan web

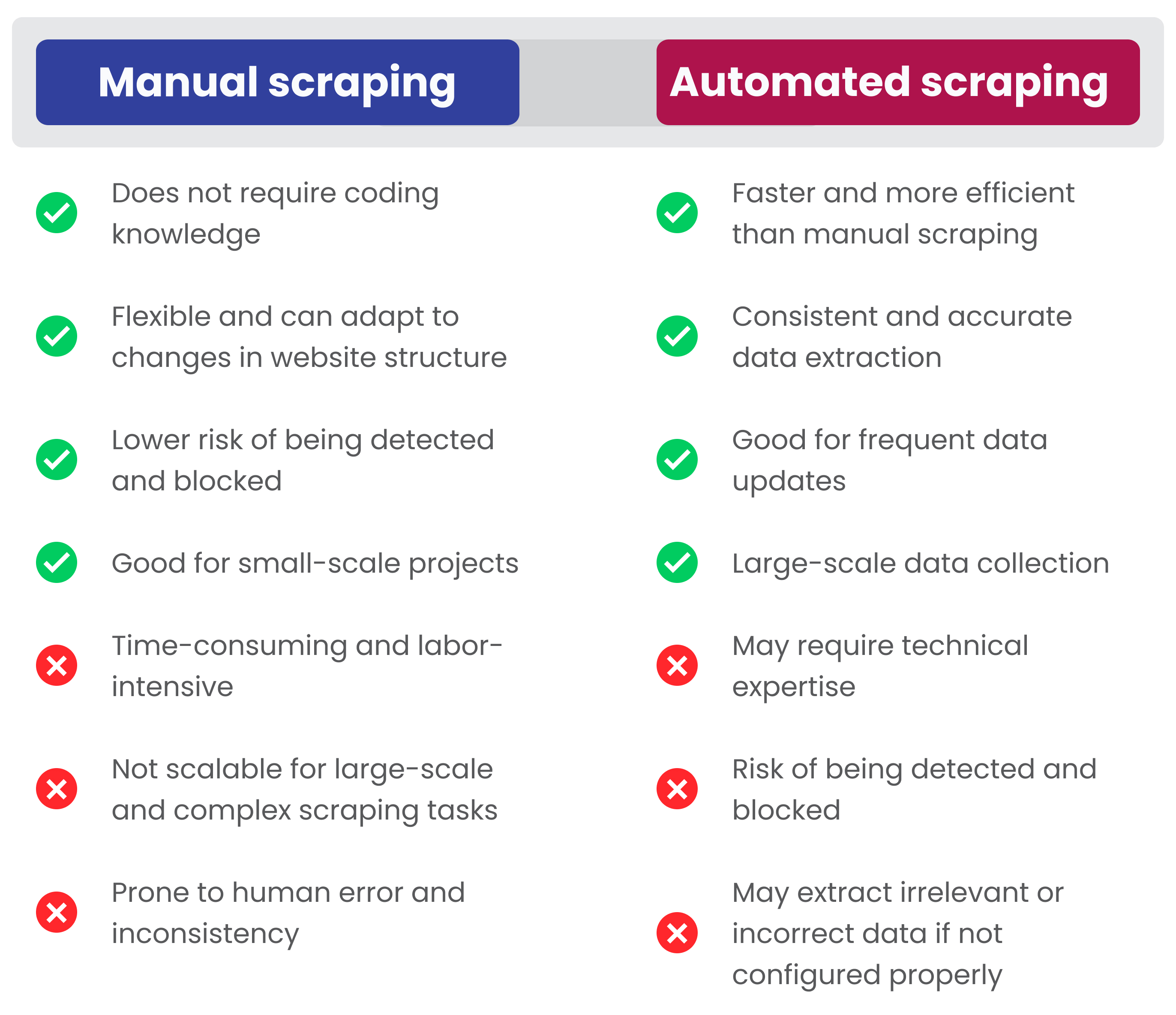

Saat Anda perlu mengekstrak data dari situs web, dua teknik paling umum adalah web scraping manual dan otomatis.

- Pengikisan web manual melibatkan pemeriksaan manual kode HTML situs web untuk elemen tertentu yang dapat diekstraksi.

- Pengikisan web otomatis memerlukan perangkat lunak khusus yang secara otomatis menavigasi situs web dan mengumpulkan informasi sepanjang prosesnya.

Kedua metode tersebut memiliki kelebihan dan kekurangan masing-masing tergantung pada jenis proyeknya.

Pengikisan web manual

Pengikisan web manual adalah tindakan menyalin teks atau konten lain secara manual dari halaman situs web, daripada menggunakan program otomatis untuk melakukannya untuk Anda. Ini adalah metode web scraping yang paling sederhana, memungkinkan pengguna memilih elemen spesifik mana yang ingin mereka hapus dari setiap halaman yang mereka kunjungi. Misalnya, jika Anda hanya perlu mencari beberapa nomor telepon atau alamat, ekstraksi data manual adalah cara yang baik untuk melakukannya.

Jenis ekstraksi ini tidak memerlukan keahlian pemrograman apa pun, tetapi merupakan metode pengikisan web yang paling lambat dan memakan waktu serta memiliki risiko kesalahan manusia. Dan kesalahan manusia bisa sangat merugikan Anda.

Pengikisan web otomatis

Pengikisan web otomatis menggunakan program perangkat lunak yang dirancang khusus untuk mengekstrak data dari situs web tanpa memerlukan campur tangan manusia setelah penyiapan. Program-program ini membuka halaman yang ditargetkan dalam situs web tertentu, atau beberapa situs web jika diinginkan, dan “mengikis” semua informasi relevan yang ditemukan di sana sebelum menggabungkannya ke dalam file keluaran mudah yang berisi apa yang diminta dalam bentuk yang paling berguna (misalnya Google Spreadsheet). , JSON, XLSX, CSV, XML, dll.). Salah satu keuntungan dibandingkan metode manual yang disebutkan di atas adalah otomatisasi menghilangkan potensi kesalahan pengguna dan mempercepat proses secara signifikan - menghemat banyak waktu!

Selain itu, Anda mungkin tidak hanya menemukan kata web scraping, tetapi juga web crawling, data mining, dan screen scraping. Orang yang tidak dikenal mungkin mengira ini adalah hal yang sama. Namun di sini kami menjelaskan perbedaannya satu sama lain.

| Teknologi | definisi | Tujuan utama | Fitur Utama | keluaran |

|---|---|---|---|---|

| Pengikisan web | Mengekstraksi data dari situs web menggunakan kode atau perangkat lunak | Mengekstraksi titik data tertentu dari situs web | Dapat mengekstrak data terstruktur dan tidak terstruktur | Data terstruktur dalam berbagai format seperti CSV, JSON atau Excel |

| Goresan layar | Mengekstraksi data dari output tampilan visual | Mengekstraksi data dari sistem lama atau aplikasi non-web | Mengekstrak data dari tampilan visual dan dapat menangani berbagai format file | Data diekstraksi oleh GUI |

| Perayapan web | Proses otomatis untuk mengumpulkan data web dengan mengikuti tautan | Mengindeks dan mengumpulkan data dari berbagai situs web | Dapat meng-crawl jutaan halaman web dan digunakan untuk mesin pencari | Data tidak terstruktur seperti HTML atau XML |

| Penambangan data | Proses menganalisis kumpulan data besar untuk mendapatkan wawasan dan pengetahuan | Analisis data untuk mengidentifikasi pola dan koneksi | Dapat bekerja dengan data terstruktur dan tidak terstruktur serta menangani algoritma yang kompleks | Wawasan dan wawasan diperoleh dari kumpulan data yang besar |

Pengikisan web vs. penambangan data

Perbedaan utama antara web scraping dan data mining terletak pada tujuannya: sementara web scraper mengumpulkan jenis konten tidak terstruktur tertentu dari situs web untuk diproses lebih lanjut, penambang data fokus pada mengidentifikasi pola tersembunyi dalam kumpulan data yang sudah ada menggunakan berbagai alat seperti pemrosesan bahasa alami (NLP) untuk menemukan. , pembelajaran mesin (ML), kecerdasan buatan (AI), dll. Selain itu, karena kedua proses tersebut memerlukan keterampilan yang berbeda - pengkodean untuk web scraping dan analisis data/statistik untuk penambangan data - kedua tugas tersebut sering kali ditangani oleh profesional yang berbeda.

Pengikisan web vs. perayapan web

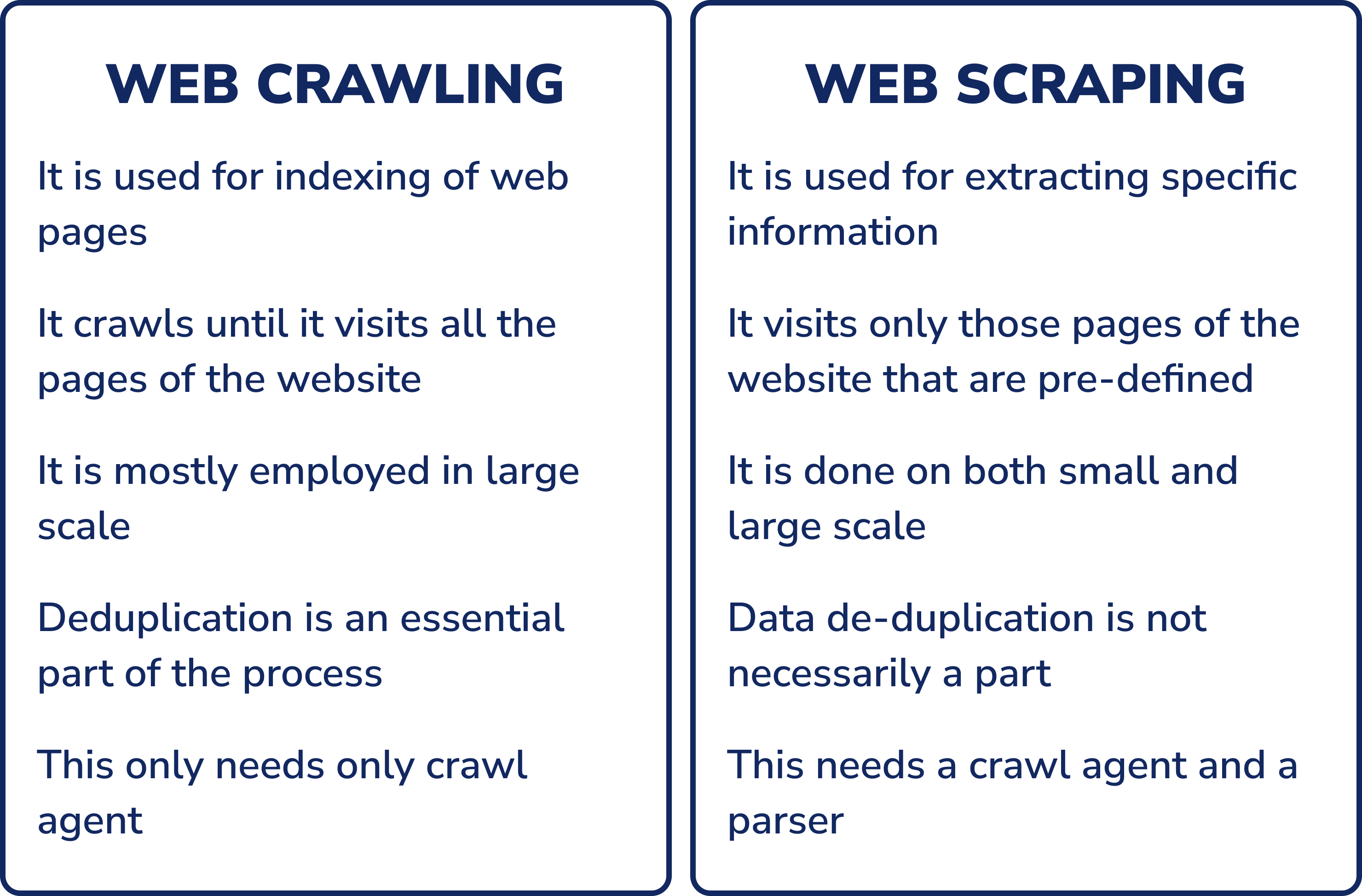

Jika Anda bukan ahli teknis, kata “web crawling” dan “web scraping” mungkin terdengar seperti memiliki arti yang sama. Pada kenyataannya, keduanya merupakan dua proses yang sangat berbeda dan sering kali membingungkan satu sama lain.

Perayap web, juga disebut “spider” atau “bot”, adalah program komputer otomatis yang menggunakan algoritme kecerdasan buatan untuk secara otomatis menemukan dan mengumpulkan informasi di World Wide Web. Perayap biasanya dimulai dengan daftar URL yang akan dikunjungi, yang disebut kumpulan benih. Saat perayap mengunjungi situs web ini, perayap mendeteksi tautan ke situs web lain dan menambahkannya ke antreannya. Perayap terus merayapi hingga ia mengunjungi semua situs dalam antreannya atau mencapai kondisi berhenti yang telah ditentukan.

Tidak seperti perayap web, yang secara otomatis mengikuti tautan untuk menemukan semua konten situs web, pengikis web hanya mengekstrak data spesifik yang seharusnya mereka cari.

Baik perayapan web maupun pengikisan web dapat digunakan untuk mengumpulkan data dari situs web. Saat memutuskan alat mana yang terbaik untuk kasus Anda, penting untuk mempertimbangkan jenis data yang Anda perlukan dan sumber data tersebut. Jika Anda memerlukan data dalam jumlah besar dari berbagai sumber, perayap web mungkin merupakan pilihan terbaik Anda. Namun, jika Anda hanya memerlukan data dari beberapa sumber tertentu, web scraper mungkin sudah cukup.

Pengikisan web vs. pengikisan layar

Pengikisan web dan pengikisan layar adalah dua istilah yang sering digunakan secara bergantian; Namun, keduanya memiliki arti yang sedikit berbeda.

Pengikisan layar adalah teknik yang berfokus pada mengekstraksi elemen UI visual seperti kotak teks atau dropdown dari aplikasi desktop - daripada mengumpulkan HTML mentah dari situs web - dan kemudian mengonversinya menjadi format yang dapat dibaca mesin seperti file CSV. Metode ini awalnya dirancang untuk mengubah sistem lama menjadi sistem modern dengan menghapus antarmuka pengguna lapis demi lapis sebelum memigrasikannya ke platform sistem baru dengan biaya berapa pun tanpa menyebabkan gangguan atau waktu henti penyampaian layanan.

Saat memilih alat pengikis web, tidak ada solusi yang cocok untuk semua; Setiap proyek memerlukan fitur yang berbeda tergantung pada kompleksitas dan cakupannya. Oleh karena itu, Anda harus selalu mengingat hal ini saat memilih alat yang tepat untuk kebutuhan Anda. Jenis yang paling umum meliputi:

- Ekstensi peramban

- Perangkat lunak yang dapat diinstal

- API pengikisan web

- Pencakar berbasis cloud

- Pencakar buatan sendiri

- Otomatisasi Proses Robot (RPA)

| Jenis alat | Keuntungan | pembatasan | Kasus penggunaan terbaik | keramahan pengguna |

|---|---|---|---|---|

| Ekstensi peramban | Mudah digunakan, terintegrasi langsung ke web browser | Fungsi terbatas, fungsi lanjutan tidak dapat dijalankan | Pengumpulan data kecil | ⭐️⭐️⭐️ |

| Perangkat lunak yang dapat diinstal | Fitur-fitur canggih seperti merotasi alamat IP, pengumpulan dan penjadwalan data secara bersamaan | Memerlukan instalasi dan konfigurasi, tetapi penggunaannya bisa lebih rumit | Ekstraksi data dari beberapa halaman | ⭐️⭐️ |

| API pengikisan web | Ekstraksi data yang tepat, fitur-fitur canggih seperti rendering JavaScript dan penghindaran CAPTCHA | Keahlian teknis mungkin diperlukan untuk implementasi dan penggunaan | Ekstraksi data tingkat lanjut | ⭐️⭐️ |

| Pencakar berbasis cloud | Skalabilitas, tidak ada persyaratan perangkat keras, pengumpulan data dapat dilakukan secara berkala tanpa entri manual | Membutuhkan layanan komputasi awan, mungkin dikenakan biaya tambahan | Pengumpulan data yang ekstensif | ⭐️⭐️ |

| Pencakar buatan sendiri | Dapat disesuaikan, tidak bergantung pada layanan pihak ketiga, lebih efisien dalam hal investasi waktu dan biaya | Membutuhkan keahlian teknis untuk konstruksi dan pemeliharaan | Ekstraksi data khusus | ⭐️ |

| Otomatisasi proses robotik |

Dapat mengotomatisasi tugas-tugas kompleks, terukur dan dapat memproses banyak sumber secara bersamaan | Memerlukan waktu pengembangan dan penyiapan dan mungkin tidak berfungsi di semua situs web | Mengotomatiskan tugas pengikisan web yang rumit | ⭐️⭐️ |

Ekstensi peramban

Pencakar web ini adalah ekstensi yang terintegrasi ke dalam browser Anda seperti Google Chrome atau Firefox untuk secara otomatis menangkap setiap situs web yang Anda kunjungi. Keuntungannya adalah mudah digunakan dan terintegrasi langsung ke browser web, sehingga cocok bagi mereka yang ingin mengumpulkan data dalam jumlah kecil. Namun, mereka mempunyai keterbatasan dalam cara kerjanya. Misalnya, fungsionalitas tingkat lanjut yang melampaui browser Anda tidak dapat dijalankan dengan ekstensi scraper web berbasis browser.

Perangkat lunak yang dapat diinstal

Pencakar web sebagai perangkat lunak yang diinstal memiliki banyak fitur tambahan, tidak seperti ekstensi browser, seperti: Seperti merotasi alamat IP untuk pengumpulan data yang lebih efisien, mengumpulkan informasi dari beberapa situs web secara bersamaan, berjalan di latar belakang secara terpisah dari browser, menampilkan data dalam format berbeda, mencari database, menjadwalkan sesi scraping dan masih banyak lagi Fitur lainnya.

API pengikisan web

API pengikisan web adalah alat otomatis yang memungkinkan perangkat lunak mengekstrak data dari situs web dan mengintegrasikannya ke perangkat lunak lain melalui panggilan API. Jenis alat ini sering kali mencakup teknik tingkat lanjut seperti memutar alamat IP, rendering JavaScript menggunakan browser tanpa kepala untuk menangkap konten dinamis, penghindaran CAPTCHA, dan menghindari pemblokiran anti-scraper. Semua fitur ini menjamin ekstraksi yang akurat sekaligus menghindari pemblokiran dengan tindakan anti-pengikisan yang dilakukan oleh pemilik situs web.

Baca selengkapnya: Web Scraping vs. API: Apa Cara Terbaik untuk Mengekstrak Data?

Pencakar berbasis cloud

Scraper berbasis cloud menggunakan layanan komputasi awan seperti Amazon Web Services (AWS) atau Microsoft Azure untuk menjalankan skrip otomatis yang secara berkala mengumpulkan data dari situs web tanpa memerlukan input manual tambahan dari pengguna, selain dari konfigurasi awal scraper bahkan saat menyiapkan. Jenis solusi ini menawarkan skalabilitas karena tidak ada batasan berapa banyak data yang dapat dikumpulkan sekaligus. Ini juga menghilangkan kebutuhan perangkat keras, sehingga pengguna tidak perlu khawatir tentang ruang penyimpanan yang akan penuh seiring waktu karena aktivitas penggunaan/pengikisan yang berlebihan (berlangsung dalam satu sesi/periode waktu).

Pencakar buatan sendiri

Bagi mereka yang memiliki pengetahuan teknis, membuat scraper khusus Anda sendiri menggunakan bahasa pemrograman seperti Python atau JavaScript sering kali merupakan solusi paling efisien dalam hal investasi waktu dan biaya. Pencakar buatan sendiri memerlukan lebih banyak usaha di awal, tetapi memungkinkan Anda menyesuaikan hasil dengan kebutuhan spesifik Anda tanpa bergantung pada layanan pihak ketiga. Pustaka Python populer yang digunakan untuk membuat scraper buatan sendiri adalah Beautiful Soup, Scrapy, Selenium, urllib.request, dan lxml. Untuk JavaScript, ini adalah Cheerio, Axios, Puppeteer, NightmareJS dan Request-Promise. Pustaka ini membuat penulisan kode lebih mudah dengan memungkinkan pengembang mengurai dokumen HTML lebih cepat dibandingkan jika mereka menulis kode dari awal hanya dalam bentuk bahasa biasa.

Jika Anda ingin mempelajari lebih lanjut tentang web scraping dengan Python dan NodeJS, tutorial kami mungkin bisa membantu.

Otomatisasi Proses Robot (RPA)

RPA melibatkan penggunaan bot, atau proses robotik, yang meniru interaksi manusia dengan situs web dengan mengotomatiskan tugas-tugas kompleks berdasarkan aturan yang telah ditentukan sebelumnya. Bot RPA dapat mengekstrak, memproses, dan menganalisis data dari halaman web dan kemudian menyimpan hasilnya dalam database atau sistem lain untuk digunakan lebih lanjut. Alat-alat ini menjadi semakin populer karena menawarkan hambatan masuk yang rendah, siklus pengembangan yang lebih cepat, skalabilitas kinerja yang kuat, keandalan, kepatuhan keamanan, dan kemampuan untuk memproses banyak sumber secara bersamaan.

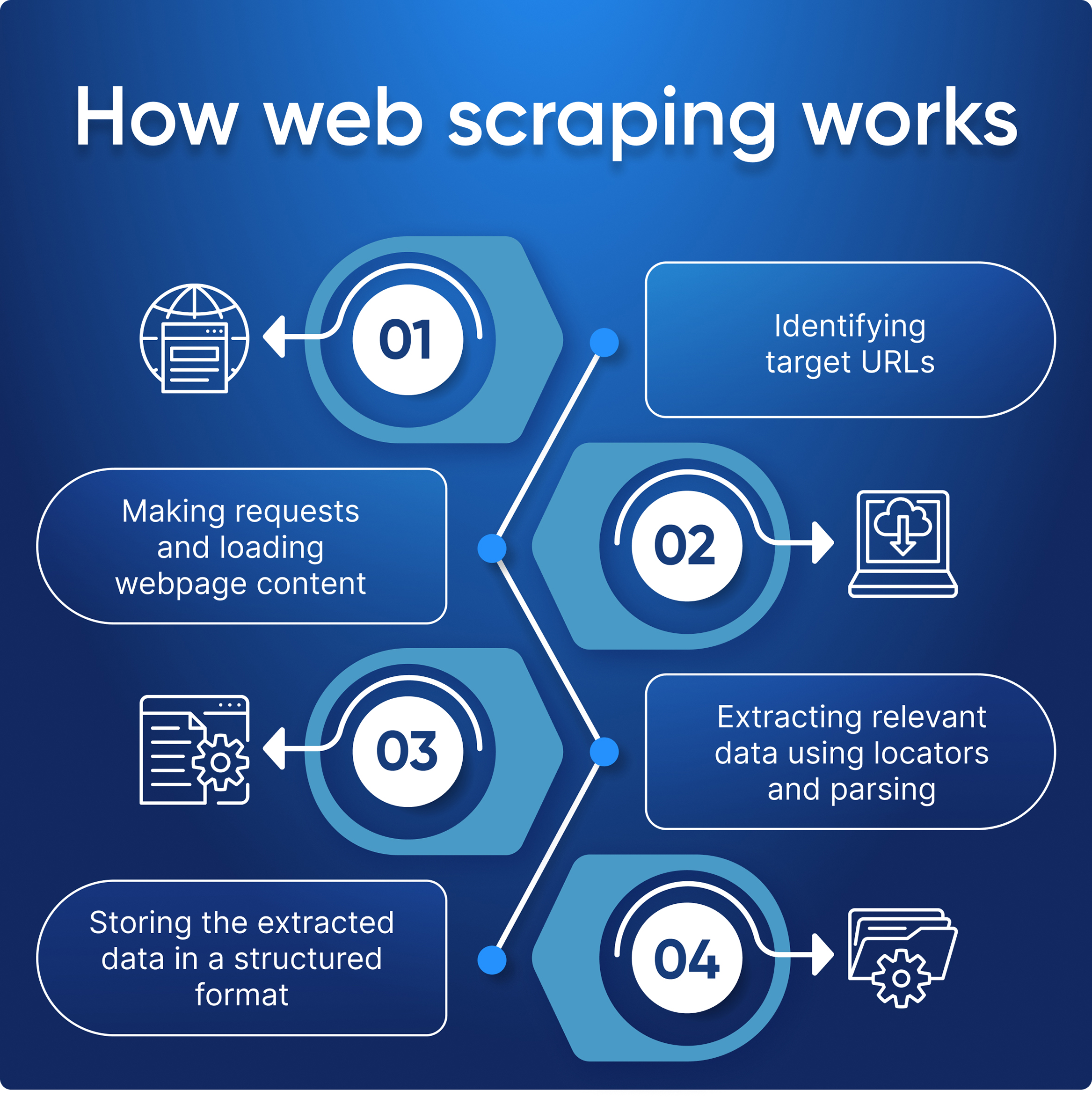

Bagaimana cara kerja web scraper?

Tujuan dari web scraper adalah untuk memahami struktur situs web untuk mengekstrak semua data yang diperlukan. Efektivitas pengikisan data Anda terutama bergantung pada pendefinisian jelas elemen apa yang ingin Anda ekstrak dan kemampuan Anda menangani kesalahan.

- Membuat permintaan HTTP untuk mengambil konten halaman HTML dari URL tujuan;

- Mengurai kode HTML untuk mengekstrak konten yang diinginkan ke dalam format terstruktur seperti CSV atau JSON;

- Simpan dan tampilkan data yang diekstraksi dengan cara yang berguna bagi Anda.

Pertama, web scraper diberikan URL tertentu (atau beberapa) yang dapat digunakan untuk mengekstrak data. Scraper kemudian memuat kode HTML dari halaman terkait. Pencakar yang lebih canggih memproses permintaan, menjalankan JavaScript, memuat sumber daya eksternal, dan menerapkan gaya CSS. Setelah halaman web dimuat dan dianalisis, scraper menggunakan metode perangkat lunak untuk mendeteksi dan mengekstrak semua data dari halaman tersebut atau sesuai dengan kriteria yang telah ditentukan.

Pada akhirnya, web scraper mengeluarkan semua data yang dikumpulkan dalam format terstruktur – tabel JSON, CSV, XML atau Excel.

Untuk apa pengikisan web digunakan?

Pengikisan web adalah alat yang ampuh dengan banyak kasus penggunaan. Bergantung pada jenis data yang Anda perlukan dan sifat proyek Anda, web scraping dapat digunakan dengan berbagai cara untuk mengumpulkan informasi dari situs web dan sumber online lainnya.

Ilmuwan data dapat menggunakan web scraper untuk mengumpulkan kumpulan data besar untuk pembelajaran mesin atau analisis statistik. Pengembang web mungkin ingin mengambil konten dari situs pihak ketiga untuk ditampilkan di halaman mereka sendiri, sementara pemasar dapat menggunakannya untuk mengekstrak data harga dari pesaing untuk tujuan perbandingan.

Apa pun industri yang Anda geluti, kemungkinan besar ada aplikasi web scraping yang dapat membantu menyederhanakan proses dan membuat hidup lebih mudah.

Mari kita lihat beberapa kasus penggunaan paling umum untuk web scraping:

Riset pasar

Dalam hal riset pasar, web scraping dapat digunakan untuk mengumpulkan informasi tentang produk pesaing, strategi penetapan harga, ulasan, atau konten relevan lainnya yang dapat membantu Anda lebih memahami industri Anda. Ini juga membantu mengumpulkan informasi tentang calon pelanggan dengan mengekstraksi email atau nomor telepon untuk tujuan kontak lebih lanjut. Dengan mengotomatiskan proses pengumpulan data dari berbagai sumber secara bersamaan, teknologi ini mempermudah perusahaan untuk mendapatkan wawasan terkini tentang industri mereka dan membuat keputusan yang tepat mengenai strategi mereka.

Generasi pemimpin

Perusahaan juga sering menggunakan web scraper sebagai bagian dari proses perolehan prospek. Dengan mengumpulkan informasi kontak secara otomatis seperti alamat email atau nomor telepon dari berbagai situs web, perusahaan dapat membuat daftar calon pelanggan potensial yang dapat mereka targetkan dengan kampanye pemasaran atau upaya penjualan dengan lebih efektif daripada sebelumnya. Hal ini meningkatkan efisiensi sekaligus mengurangi biaya yang terkait dengan perolehan timbal karena tidak perlu menggunakan sumber daya manusia untuk menjaga semuanya berjalan dengan baik.

Kecerdasan harga

Pengikisan web memungkinkan Anda mengumpulkan deskripsi produk dan data harga dari seluruh internet untuk membuat keputusan eCommerce yang lebih baik. Hal ini memungkinkan Anda dengan cepat bereaksi terhadap perubahan harga umum dan mengoptimalkan perubahan harga Anda sendiri. Misalnya, untuk mengungguli pesaing di pasar negara berkembang sekaligus menurunkan harga di negara lain. Anda dapat memantau tren pembelian, menganalisis strategi pemasaran pesaing, dan mematuhi MAP dan peraturan penetapan harga lainnya.

Keuangan dan investasi

Perusahaan keuangan dan investasi menggunakan data untuk membuat keputusan investasi. Pengikisan web memungkinkan Anda menganalisis kondisi pasar keuangan saat ini, melacak tren yang muncul dan menganalisis dampaknya, serta memantau berita yang berdampak pada saham dan perekonomian. Scraping memungkinkan Anda menganalisis dokumen perusahaan dan memantau opini publik tentang industri.

Properti

Pencakar web memungkinkan agen dan pialang real estat dengan mudah mengumpulkan daftar terperinci dari berbagai situs web hanya dalam hitungan menit. Hal ini memungkinkan mereka untuk mengikuti pasar yang terus berubah dan tetap mengikuti tren perumahan tanpa harus menghabiskan waktu berjam-jam menjelajahi setiap situs web satu per satu. Selain itu, ini memastikan bahwa semua listing real estat yang relevan dicatat secara akurat dan efisien, sehingga memudahkan agen/broker untuk membuat keputusan penting tentang investasi atau portofolio mereka lebih cepat dari sebelumnya.

Baca selengkapnya: Manfaat Web Scraping untuk Real Estat

Berita dan konten terkini

Pengikisan web memungkinkan Anda melacak tren terkini terkait urusan global dan regional atau artikel berita untuk meresponsnya secara tepat waktu. Mereka dapat menganalisis reaksi masyarakat terhadap tren, membuat keputusan investasi atau pembelian, memantau pesaing, dan menjalankan kampanye yang ditargetkan, seperti kampanye politik.

pemantauan seo

Web scraping dapat digunakan untuk memantau peringkat situs web pada halaman hasil mesin pencari (SERP). Hal ini memungkinkan bisnis untuk melacak kemajuan mereka dalam hasil pencarian organik dan mengoptimalkan konten mereka. Selain itu, web scraper dapat digunakan untuk memindai SERP untuk situs web pesaing, sehingga memungkinkan bisnis tetap mengikuti aktivitas pesaing mereka. Dengan API SERP Google kami, bisnis dapat dengan mudah menyederhanakan proses ini tanpa menghabiskan waktu mengembangkan perayap khusus atau mengkhawatirkan batas kecepatan dan masalah lain yang terkait dengan proses perayapan manual.

Pembelajaran mesin

Pengikisan web dapat mengumpulkan data tentang perilaku masyarakat dan pola komunikasi Internet untuk kemudian menggunakan informasi tersebut untuk proyek pembelajaran mesin, melatih model prediktif, dan mengoptimalkan model NLP.

Analisis sentimen konsumen

Penuh dengan beragam pendapat tentang produk dan isu-isu sosial, media sosial scraping memungkinkan Anda melacak sentimen konsumen dan memahami nilai-nilai dan keinginan audiens yang Anda iklankan dan tawarkan produk Anda. Data yang dikumpulkan berguna baik dalam pengembangan proyek baru maupun perbaikan proyek yang sudah ada.

Pemantauan merek

Merek yang kuat membedakan produk Anda dari pesaing dan menginspirasi kepercayaan konsumen. Menganalisis penyebutan merek memberikan wawasan tentang persepsi Anda saat ini dan bagaimana Anda dapat menyesuaikan layanan pelanggan dan strategi pemasaran untuk meningkatkan reputasi dan kesadaran Anda.

Apakah data pengikisan web legal?

Pengikisan web ada di mana-mana baik di bisnis kecil maupun besar dan sudah menjadi bagian dari model bisnis banyak perusahaan. Namun demikian, legalitas yang terlibat sangatlah kompleks. Pengikisan web umumnya tidak ilegal di mana pun di dunia, namun masalah muncul ketika orang tidak menghormati hak kekayaan intelektual dan mengumpulkan informasi pribadi dan materi berhak cipta. Saat Anda mengumpulkan informasi, Anda harus memastikan bahwa aktivitas Anda mematuhi hukum.

Baca selengkapnya: Aspek Hukum dan Etika Web Scraping

Kesimpulan dan temuan

Singkatnya, web scraping adalah teknik ampuh yang memungkinkan Anda mengekstrak data berharga dari situs web dengan cepat dan akurat. Ini menawarkan banyak manfaat di berbagai industri, termasuk riset pasar, perolehan prospek, informasi harga, analisis keuangan dan investasi, analisis real estat, dan pemantauan sentimen konsumen di media sosial.

Terlepas dari kelebihannya, perlu diingat bahwa ada aspek hukum yang harus diperhatikan saat menggunakan teknologi ini. Selalu pastikan bahwa aktivitas Anda mematuhi kebijakan privasi serta syarat dan ketentuan pemilik situs web.

Secara keseluruhan, bila digunakan dengan benar, web scraping dapat menambah nilai signifikan pada proses bisnis apa pun dengan memungkinkan pengambilan keputusan yang lebih baik berdasarkan wawasan tepat yang diperoleh dari kumpulan data relevan yang dikumpulkan melalui proses otomatis.