Mit dem richtigen Tool kann es einfach sein, konsistente Google SERP-Daten im großen Maßstab (Millionen von Suchanfragen) zu erhalten.

Da es jedoch so viele Optionen gibt, kann es schwierig sein, sich für eine zu entscheiden.

Um Ihnen die Entscheidung zu erleichtern, haben wir die sieben besten APIs für Google SERP Scraping aufgelistet. Wir haben Dinge berücksichtigt wie:

- Reaktionszeit

- Datenqualität

- Zuverlässigkeit

- Skalierbarkeit

- Zusatzfunktionen

- Preisgestaltung

So können Sie sicher sein, dass Sie nur die besten Optionen sehen.

TL;DR: ScraperAPI bietet die umfassendsten Tools zum Scrapen von Google SERP, einschließlich eines Endpunkts für strukturierte Daten, um JSON-Daten aus jeder Abfrage zum günstigsten Preis abzurufen.

- ScraperAPI – Beste Google SERP API zum Sammeln strukturierter JSON-Daten mit einem einfachen API-Aufruf

- SERP API – API mit der größten Auswahl an Suchmaschinen

- DataForSEO – Robuste Lösung zum Aufbau interner Marketingtools

- OxyLabs – Spezialisiertes Proxy-Management-System

- SerpStack – Tolle Option für kleine Projekte

- Zenserp – Zweitschnellste Reaktionszeiten

- Apify – Shop mit vorgefertigten Scrapern, auch für Google SERP

1. ScraperAPI (Beste Google SERP API)

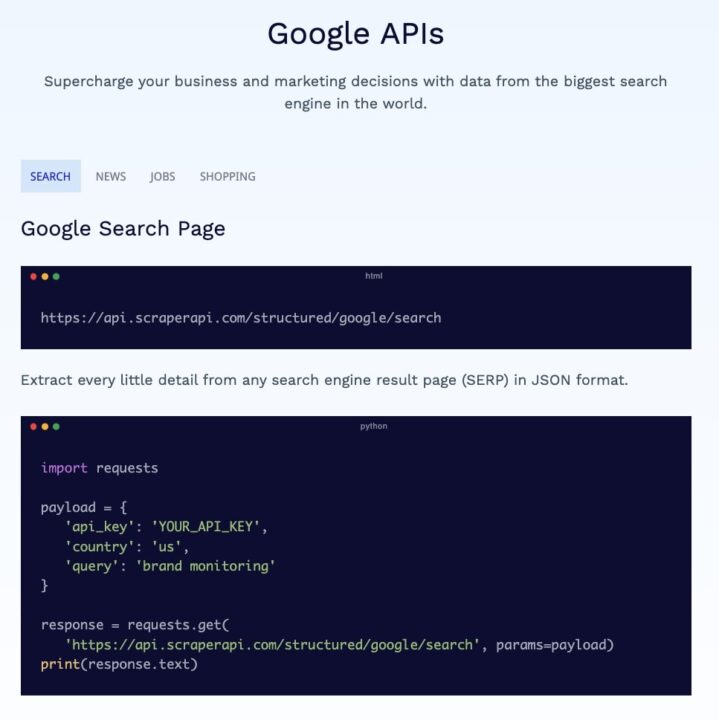

ScraperAPI ist eine fortschrittliche Web-Scraping-Lösung mit einem robusten Satz an Tools, die für die konsistente Erfassung von Webdaten auf Unternehmensebene entwickelt wurden.

Im Gegensatz zu anderen Tools in dieser Liste bietet ScraperAPI zahlreiche Vorteile für Ingenieure und Datenteams:

- Ein Pool von über 40 Millionen IP-Adressen – einschließlich Rechenzentrums-, Privat- und Mobil-Proxys – in über 50 Ländern

- Intelligentes IP-Rotationssystem zur Gewährleistung einer Erfolgsquote von 99,99 %

- CAPTCHA-Verwaltung

- JavaScript-Rendering

- Einfach zu verwendende Endpunkte für strukturierte Daten zum Sammeln von JSON-Daten von Domänen wie Google und Amazon

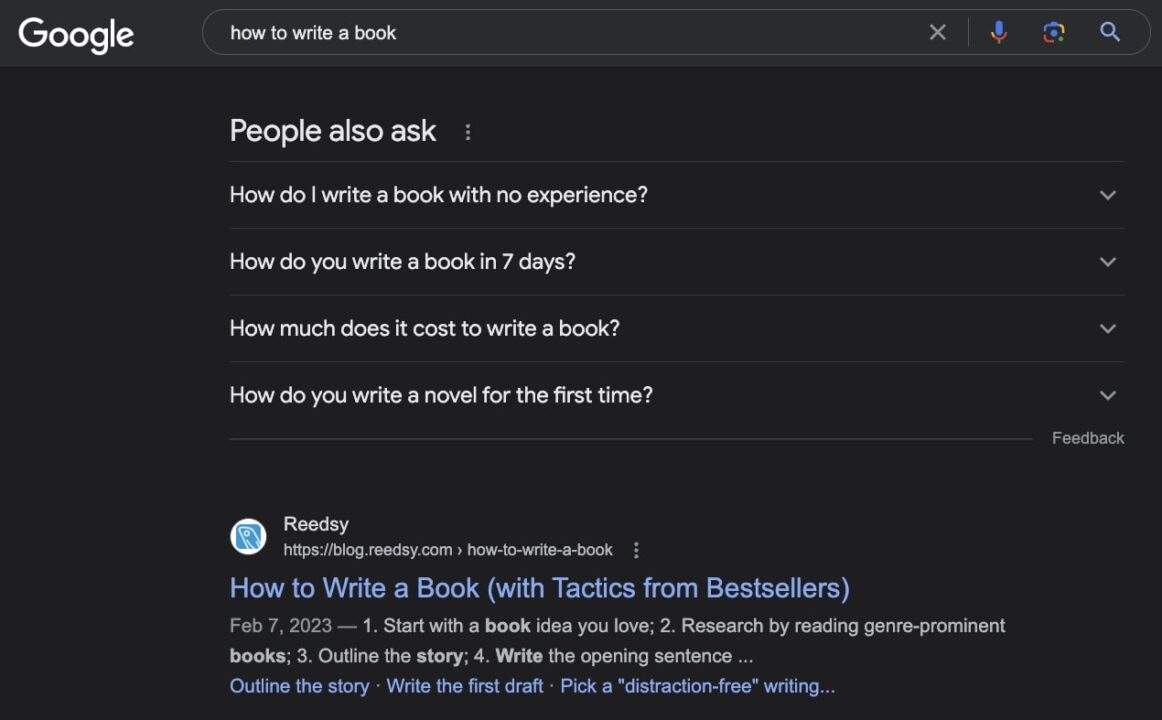

Mit der Google SERP-API können Sie jedes Google-Suchergebnis mit einem einfachen API-Aufruf in strukturierte JSON-Daten umwandeln.

Dies umdrehen:

Das mögen:

"related_questions": (

{

"question": "How do I write a book with no experience?How do I write a book with no experience?",

"position": 1

},

{

"question": "How much does it cost to wrote a book?How much does it cost to wrote a book?",

"position": 2

},

{

"question": "How do you write a book in 7 days?How do you write a book in 7 days?",

"position": 3

},

{

"question": "How do you write a book from scratch?How do you write a book from scratch?",

"position": 4

}

)

Wenn Sie Ihre Anfrage über den Google SERP-Endpunkt von ScraperAPI senden, wird Folgendes erreicht:

- Nutzen Sie maschinelles Lernen und jahrelange statistische Analysen, um alle Anti-Scraping-Mechanismen zu umgehen, die Ihnen in den Weg gestellt werden

- Analysieren Sie die Antwort und organisieren Sie jeden relevanten Datenpunkt in einer JSON-Struktur

- Ermöglichen Ihnen die Erfassung lokalisierter Daten mithilfe von Geotargeting

- Sparen Sie Hunderte von Entwicklungs- und Wartungsstunden

Darüber hinaus können Sie die Standard-API verwenden und den Roh-HTML-Code abrufen. Sie haben die volle Kontrolle darüber, welche Daten Sie erhalten und wie Sie diese erhalten.

Erfahren Sie in unserem einfach zu befolgenden Tutorial, wie Sie die Endpunkte für strukturierte Daten von ScraperAPI verwenden, oder starten Sie kostenlos mit 5.000 API-Credits.

Vorteile:

- Die günstigste und skalierbarste Option auf der Liste

- Bietet einfach zu handhabende JSON-Daten mit nur einer Suchabfrage

- Robustes Web-Scraping-Toolkit

- Großzügiger kostenloser Plan mit 5.000 API-Credits

- Zusätzliche strukturierte Datenendpunkte für Google Shopping, Google Jobs und Google News

- Multi-Threads und Geotargeting sind in jedem Plan enthalten

Nachteile:

- Bietet keine zusätzlichen Endpunkte für andere Suchmaschinen

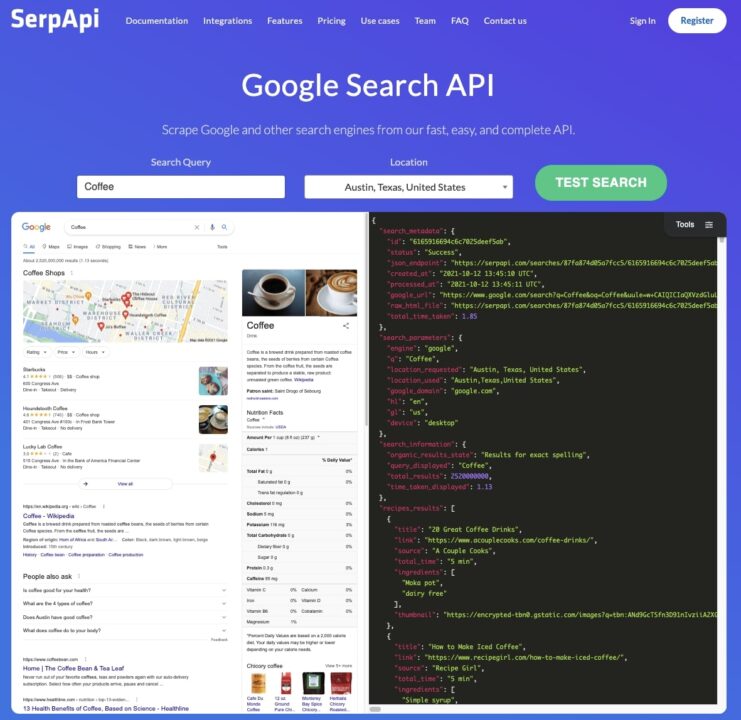

2. SERP API (Hauptauswahl an Endpunkten)

Wie der Name schon sagt, handelt es sich bei der SERP API um ein Web-Scraping-Tool, das speziell zum Sammeln von Daten von Suchmaschinen entwickelt wurde. Die Endpunkte sind schnell und haben eine Erfolgsquote von nahezu 100 %.

Wenn es um Vielfalt geht, verfügt die SERP API über die längste Liste strukturierter Datenendpunkte, darunter:

- Google-Such-API

- Google Maps-API

- Google Jobs-API

- Bing-Such-API

- YouTube-API

- eBay-API

- Und mehr…

Allerdings bietet es ein breites Spektrum an Endpunkten und einen beträchtlichen Preis.

Obwohl es mit einem großzügigen Plan von 50 $/Monat für 5.000 Google-Suchanfragen beginnt, steigen die Preise für die folgenden Stufen schnell an – was die Skalierung auf große Datenmengen ziemlich kostspielig macht.

Um etwas Kontext zu haben: Der Einsteigerplan von ScraperAPI für 49 $/Monat würde Ihnen 4.000 Suchvorgänge und 1.000 Suchvorgänge unter der SERP-API ermöglichen.

Auf der zweiten Stufe bietet SERP API jedoch 15.000 Google-Suchanfragen für 130 $/Monat, während ScraperAPI Ihnen 40.000 Google-Suchanfragen für 149 $/Monat bietet.

Der Unterschied zwischen Preis und bereitgestellter Datenmenge verdreifacht sich in späteren höheren Plänen.

Vorteile:

- Größte Auswahl an Endpunkten zum Sammeln von Daten von Suchmaschinen

- Einfach zu bedienen und umzusetzen

- Großzügiger Einstiegspreis

Nachteile:

- Für große Projekte zu teuer

3. DataForSEO (entwickelt für Marketingteams)

DataForSEO ist eine Suchmaschinen-API, die speziell für digitale Vermarkter entwickelt wurde, die ihre eigenen internen SEO-Tools erstellen möchten, anstatt für ihre SEO-Daten auf Tools wie SEMRush, Ahrefs und MOZ angewiesen zu sein.

Sie haben benutzerdefinierte APIs für verschiedene Datenprobleme entwickelt, die ein digitaler Vermarkter möglicherweise lösen möchte:

- Suchmaschinen-API

- Google Ads-API

- Google Trends-API

- Verkehrsanalyse-API

- On-Page-API

- Google Shopping-API

Im Gegensatz zu den vorherigen Lösungen verwendet DataForSEO ein Pay-As-You-Go-Zahlungssystem, das sich hervorragend für diejenigen eignet, die nicht hundertprozentig sicher sind, wie viele API-Anfragen sie jeden Monat stellen müssen.

Allerdings werden die Tools beim Scraping von SERP-Daten in großem Maßstab auch erheblich teurer.

Der größte Nachteil besteht darin, dass die Reaktionsgeschwindigkeit je nach Preisschild unterschiedlich ist. Für günstigere Preise müssten Sie also längere Wartezeiten haben – ganz zu schweigen davon, dass die garantierte Antwortzeit tatsächlich 45 Minuten nach der post()-Anfrage beträgt.

Vorteile:

- Speziell für Marketingteams entwickelt

- Tolle Sammlung von Suchmaschinen-Endpunkten

Nachteile:

- Teuer, wenn man in großem Maßstab kratzt

- Anstelle einer konstanten Reaktionsgeschwindigkeit sind höhere Geschwindigkeiten mit einem höheren Preis verbunden

- Insgesamt lange Reaktionszeiten

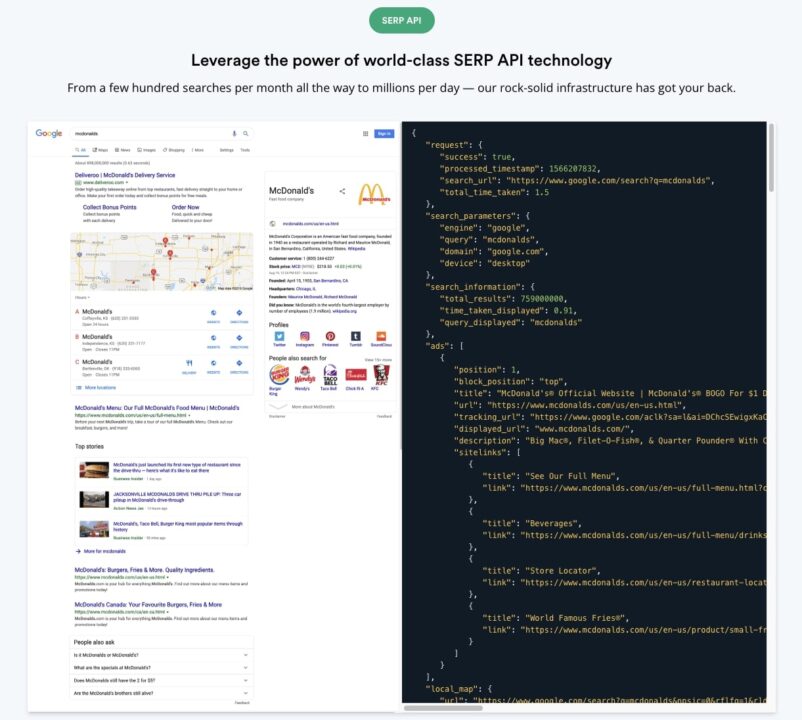

4. OxyLabs (Alternativer Proxy-Manager)

Die SERP-API von OxyLabs bietet eine 100-prozentige Erfolgsquote und eine benutzerfreundliche API, ideal für alle, die schnell und qualitativ hochwertige Suchmaschinendaten von Google, Bing, Baidu und Yandex benötigen.

Ähnlich wie ScraperAPI bietet es auch eine Reihe von Tools zum Scrapen jeder gewünschten URL sowie verschiedene Web-Scraping-Tools.

Der einzige Nachteil sind die hohen Kosten. Es beginnt mit einem großzügigen Startplan von 49 $/Monat für 17.500 Ergebnisse, wird aber bei späteren Plänen teurer

Außerdem gibt es keine klare Definition dessen, was als Ergebnis zählt. Die meisten Tools geben beispielsweise die Anzahl der Google-Suchanfragen an, die Sie erhalten. Dieses kleine Detail kann für Neulinge irreführend sein.

Vorteile:

- 100 % Erfolgsquote

- Hochwertige Proxys und Proxy-Manager

- Nach Erreichen von 1 Million Ergebnissen nähert es sich dem Preis von ScraperAPI an

Nachteile:

- Verfügt nicht über den gleichen Funktionsumfang wie andere Lösungen

- Vages Preismodell

5. Serpstack (großartige Option für kleine Projekte)

Serpstack ist eine weitere großartige Suchmaschinen-API-Option für diejenigen, die nur Daten benötigen. Das Team von SerpStack hat eine voll funktionsfähige API entwickelt, die Folgendes extrahieren kann:

- Google-Suchergebnisse

- Google Bilder

- Google-Videos

- Google Nachrichten

- Google Shopping

Und senden Sie die Daten entweder im JSON- oder CSV-Format an Sie zurück. Sie verfügen über eine umfangreiche Dokumentation, sodass sie sehr einfach zu verwenden und in Ihre aktuellen Datenfeeds zu integrieren ist.

Im Vergleich zu anderen Tools in der Liste weist es eine sehr ähnliche Preisstruktur auf: von 29,99 $/Monat für 5.000 Google-Suchanfragen bis zu 199,99 $/Monat für 50.000 Suchanfragen – zu diesem Zeitpunkt ist es günstiger als SERP API (für das 250 $/Monat berechnet werden). 30.000 Suchanfragen).

Vorteile:

- Gute Funktionalität und tolle Dokumentation.

Nachteile:

6. Zenserp (zweitschnellste Reaktionszeit)

Wenn Sie auf der Suche nach Geschwindigkeit sind, ist Zenserp eine großartige Option für Sie. Sie haben große Anstrengungen unternommen, um sicherzustellen, dass sie die Daten so schnell wie möglich zurückgeben, ohne Kompromisse bei der Datenqualität einzugehen.

Darüber hinaus bietet die API selbst eine ganze Reihe von Funktionen, die es Ihnen ermöglichen, alle Arten von SERP-Daten zu crawlen, einschließlich organischer, bezahlter, Antwortbox-, Featured Snippet-, Top-Story-, lokaler Karten usw.

Auch die Dokumentation ist sehr gut, was eine schnelle Inbetriebnahme sehr einfach macht.

Was die Preise angeht, wird Zenserp mit zunehmender Skalierung recht teuer und liegt bei 399 US-Dollar/Monat für 120.000 Google-Suchanfragen, was 100 US-Dollar/Monat mehr ist, als ScraperAPI für die gleiche Datenmenge verlangt.

Vorteile:

- Sehr schnelle API mit vielen Funktionen.

Nachteile:

- Für große Projekte zu teuer.

7. Apify (Shop für vorgefertigte Schaber)

Apify ist ein großartiger Marktplatz/Shop, um vorgefertigte Schaber zu kaufen. Es gibt viele verschiedene Lösungen, darunter einen vollwertigen Google Search Scraper.

Ihre Preisgestaltung ist komplexer als die der oben aufgeführten reinen API-Optionen, da sie ihre Dienste nach „Akteuren“ und „Anfragen“ bewerten, aber im Allgemeinen bieten sie im Vergleich zu einigen anderen teureren Optionen ein gutes Preis-Leistungs-Verhältnis.

Vorteile:

- Große Auswahl an vorgefertigten Schabern für viele Schabeanforderungen

Nachteile:

- Die Preisgestaltung ist verwirrend

- Ihr Such-Scraper verfügt nicht über den gleichen Funktionsumfang wie einige der anderen Optionen

- Am besten geeignet für kleine Projekte

Zusammenfassung

Jede einzelne der in diesem Artikel aufgeführten Lösungen bietet nachweislich eine nahezu 100-prozentige Erfolgsquote, eine breite Palette zuverlässiger Suchmaschinen-Endpunkte und eine geeignete Infrastruktur für Skalierbarkeit.

Beim Sammeln von Daten aus Millionen von Suchergebnissen sind jedoch Faktoren wie Preis, Benutzerfreundlichkeit und Transparenz entscheidende Variablen, die es zu berücksichtigen gilt.

Von allen Tools in der Liste ist ScraperAPI bei weitem das am einfachsten zu verwendende – da Sie jedes Google SERP mit nur einer get()-Anfrage in strukturierte JSON-Daten umwandeln können – und dasjenige, das die größte Datenmenge zum niedrigsten Preis bietet.

Sofern Sie nicht bestimmte Suchmaschinen wie DuckDuckGo, Baidu oder Yandex durchsuchen möchten, ist ScraperAPI die beste Wahl für Ihr Projekt.

Testen Sie ScraperAPI kostenlos und beginnen Sie in wenigen Minuten mit der Erfassung von Google-Daten.

Bis zum nächsten Mal, viel Spaß beim Schaben!

Häufig gestellte Fragen

Warum Google kratzen?

Google verarbeitet rund 8,5 Milliarden Suchanfragen pro Tag und hat einen herausragenden Marktanteil von 93 % in der Suchmaschinenbranche, was es zu einer Goldgrube an Informationen macht. Diese Daten können zur Überwachung von Wettbewerbern, zum Reputationsmanagement, zum Aufbau von SEO-Tools oder zur Unterstützung von SEO-Kampagnen, zum Aufbau von Lead-Listen und vielem mehr verwendet werden.

Ist es legal, Google-Suchergebnisse zu löschen?

Ja, das Scrapen von Google-Suchergebnissen ist völlig legal, da dies in den Bereich öffentlich verfügbarer Daten fällt. Um jedoch nicht durch die Anti-Scraping-Mechanismen von Google blockiert zu werden, müssen Sie eine Web-Scraping-Lösung wie ScraperAPI verwenden.