Pengikisan email melibatkan penggalian alamat email secara otomatis dari berbagai sumber, seperti situs web, direktori perusahaan, atau media sosial. Pemilihan sumber data bergantung pada bagaimana data akan digunakan.

Pada artikel ini, kami menjajaki kemungkinan mengumpulkan daftar situs web dari Google SERP atau Google Maps dan kemudian mengekstrak data email dari situs web tersebut. Untuk menyederhanakan proses pengumpulan data dari website, kami menggunakan berbagai API dan layanan integrasi seperti Zapier dan Make.com.

Daftar Isi

Beginilah cara kerja pengikisan email

Untuk menghapus alamat email dari situs web, Anda harus terlebih dahulu menentukan daftar situs web yang ingin Anda hapus alamat emailnya. Kemudian Anda perlu merayapi semua situs web atau halaman ini (jika Anda mencari di media sosial) dan mengekstrak alamat emailnya. Proses ini dapat digunakan untuk membuat database untuk berbagai tujuan, mulai dari kampanye pemasaran digital hingga perolehan prospek dan CRM.

Dalam tutorial ini, Anda akan mempelajari cara menghapus tautan dari situs web secara otomatis menggunakan Google SERP API dan Google Maps API. Kami juga menunjukkan cara menyimpan data dalam file CSV. Jika Anda sudah memiliki daftar sumber daya yang ingin Anda ekstrak datanya, Anda juga dapat mengonfigurasi pengikisan situs web ini. Berikut langkah-langkah untuk mengikis alamat email dari situs web:

- Tentukan daftar situs web tempat Anda ingin mengekstrak alamat email. Ini dapat dilakukan secara manual atau menggunakan bot, ekstensi Chrome, atau alat pengikis lainnya.

- Gunakan alat pengikis web untuk merayapi situs web di daftar Anda. Alat ini mengekstrak alamat email dari situs web.

- Simpan alamat email dalam database atau file. Hal ini memudahkan untuk mengakses data nantinya.

Untuk membuat pengikisan lebih komprehensif, Anda juga dapat mengekstrak data tambahan seperti nomor telepon, harga, atau alamat saat mengambil tautan dari Google Maps. Kami akan mendemonstrasikan semua contoh ini dalam praktik di bawah. Kami juga akan memberikan contoh penggunaan integrasi bagi mereka yang tidak terbiasa dengan pemrograman, dan kami akan mengembangkan skrip Python bagi mereka yang ingin menyesuaikan skrip mereka untuk kemudian diintegrasikan ke dalam program mereka.

Kasus penggunaan dan aplikasi praktis

Seperti disebutkan sebelumnya, pengumpulan email adalah strategi menghasilkan prospek yang berharga yang dapat membantu perusahaan mengidentifikasi pelanggan potensial dengan cepat dan efisien. Berikut ini beberapa contoh bagaimana Anda dapat menggunakan alamat email yang telah Anda hapus dari situs web:

- Kampanye pemasaran. Anda dapat menggunakan alamat email untuk mengirim kampanye pemasaran SEO (email dingin) ke calon pelanggan.

- Generasi pemimpin. Anda dapat menggunakan alamat email untuk menghasilkan prospek bagi bisnis Anda.

- Anda dapat menggunakan alamat email untuk meneliti audiens.

Sumber pengumpulan alamat email harus ditentukan berdasarkan tujuan penggunaan data. Karena alamat email biasanya dikumpulkan untuk menghasilkan prospek, kami menggunakan sumber yang paling relevan untuk tujuan ini, seperti: B. Hasil pencarian kata kunci dan Google Maps.

Pengikisan email dalam praktiknya

Mari kita bicara tentang cara praktis untuk mengikis alamat email. Kami telah membahas berbagai cara untuk mengikis alamat email dari Google Maps, jadi kami akan fokus pada proses pengumpulan tautan ke sumber daya dari SERP Google dan merayapi situs web secara berurutan untuk mengumpulkan alamat email. Kami sedang mempertimbangkan opsi berikut untuk mengumpulkan alamat email:

- Menggunakan pencakar tanpa kode yang sudah dibuat sebelumnya. Metode ini tidak memerlukan pengetahuan pemrograman apa pun dan pengambilan alamat email sepenuhnya otomatis.

- Penggunaan layanan integrasi. Metode ini memerlukan pengaturan parameter dan integrasi. Opsi ini mencakup penggunaan layanan seperti Make.com dan Zapier.

- Bangun ekstraktor email Anda. Hal ini memerlukan pengetahuan pemrograman karena proses pengikisan dan pemrosesan data diatur dalam skrip terpisah.

Di bawah ini kita akan membahas masing-masing opsi tersebut, dimulai dengan yang paling sederhana, yang tidak memerlukan keterampilan tambahan, dan diakhiri dengan menulis scraper terpisah berdasarkan berbagai API untuk menyederhanakan prosesnya.

Scraper tanpa kode untuk email bisnis

Menggunakan scraper tanpa kode bawaan adalah cara paling sederhana namun paling rumit untuk mengumpulkan alamat email. Karena alat canggih yang sudah jadi memungkinkan Anda mengekstrak data hanya jika sumber daya yang alat tersebut dikembangkan pada awalnya menyediakan data tentang alamat email perusahaan atau pengguna.

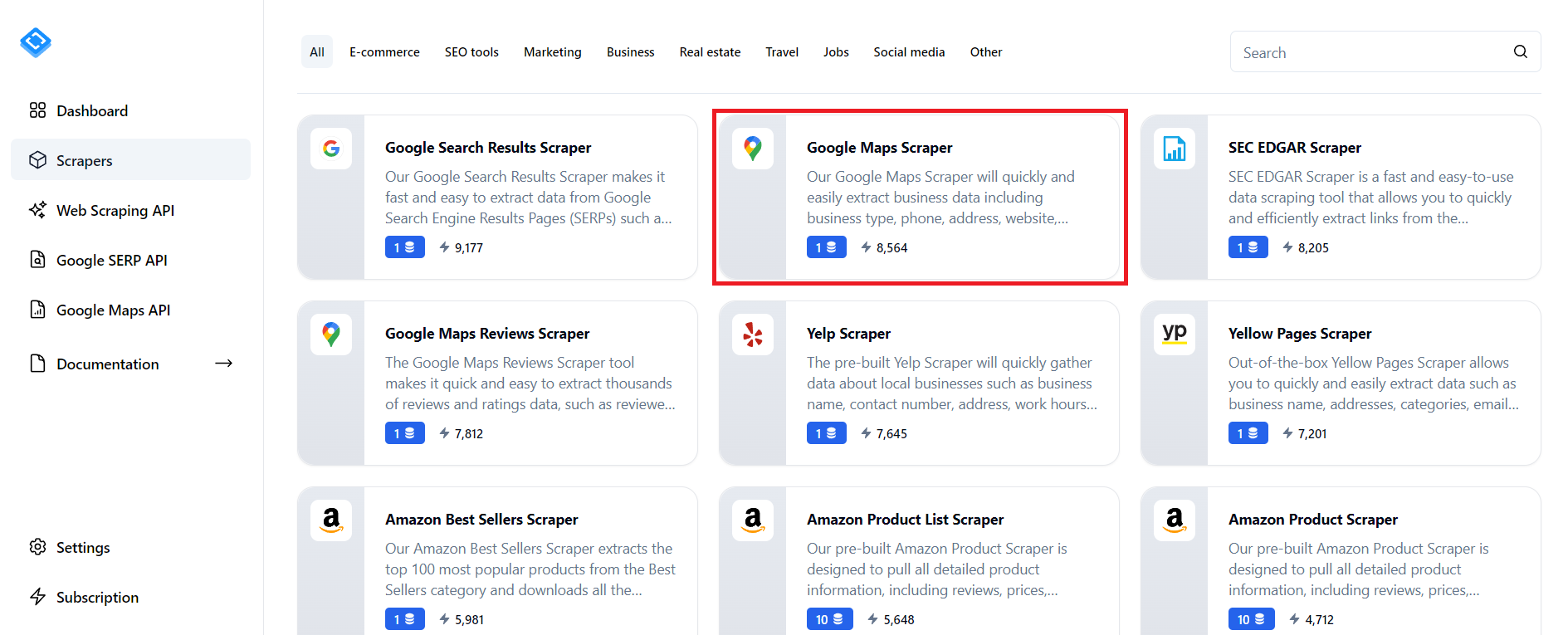

Salah satu sumber daya tersebut adalah Google Maps, yang tidak hanya menyediakan data tentang suatu tempat tetapi juga informasi kontaknya, termasuk alamat email. Untuk mendapatkan alamat email dari Google Maps dengan cepat, masuk ke situs web Scrape-It.Cloud dan buka bagian scraper yang sudah jadi.

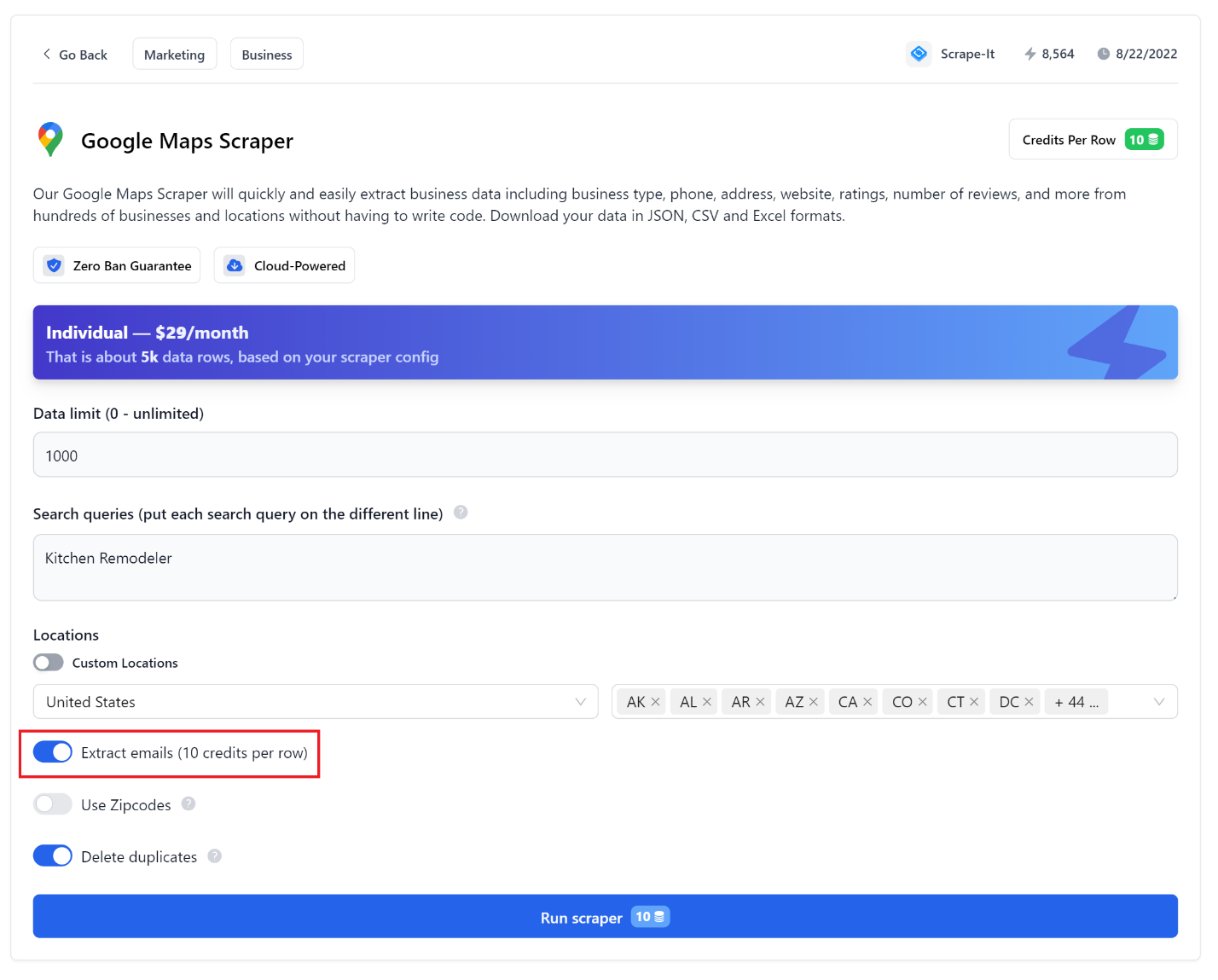

Kemudian temukan Google Maps Scraper dan konfigurasikan parameter yang diperlukan sesuai kebutuhan Anda. Pastikan untuk mencentang kotak untuk mengumpulkan alamat email.

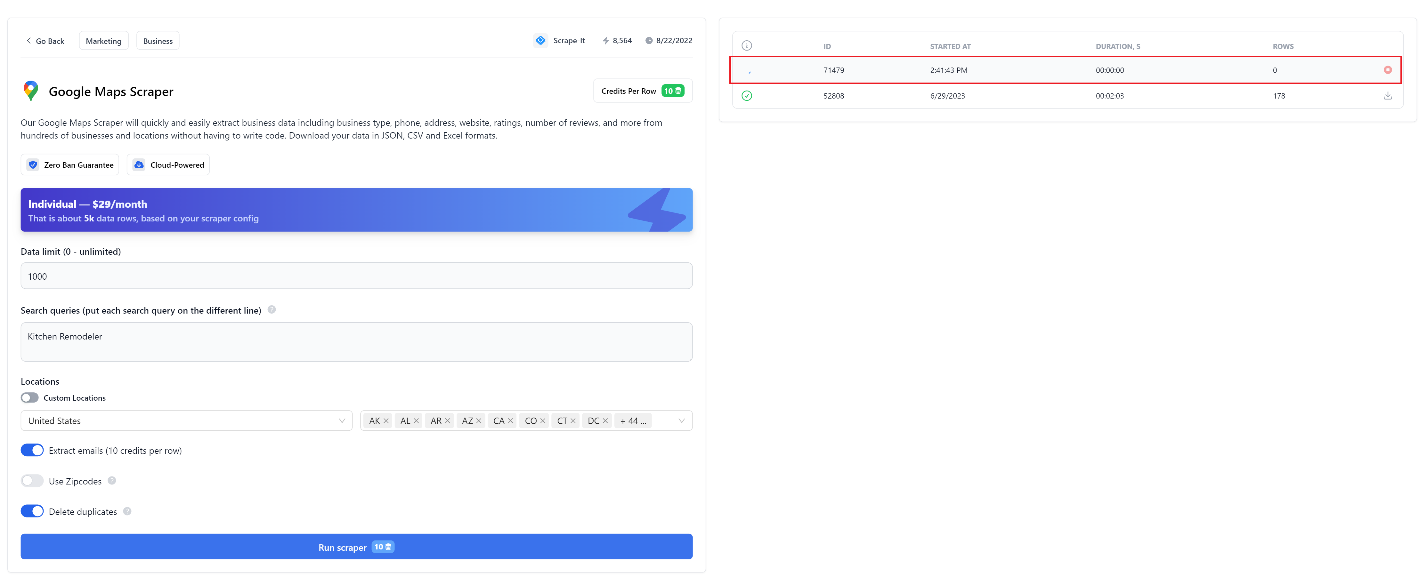

Selanjutnya klik tombol “Start Scraping” dan tunggu hingga pengumpulan data selesai.

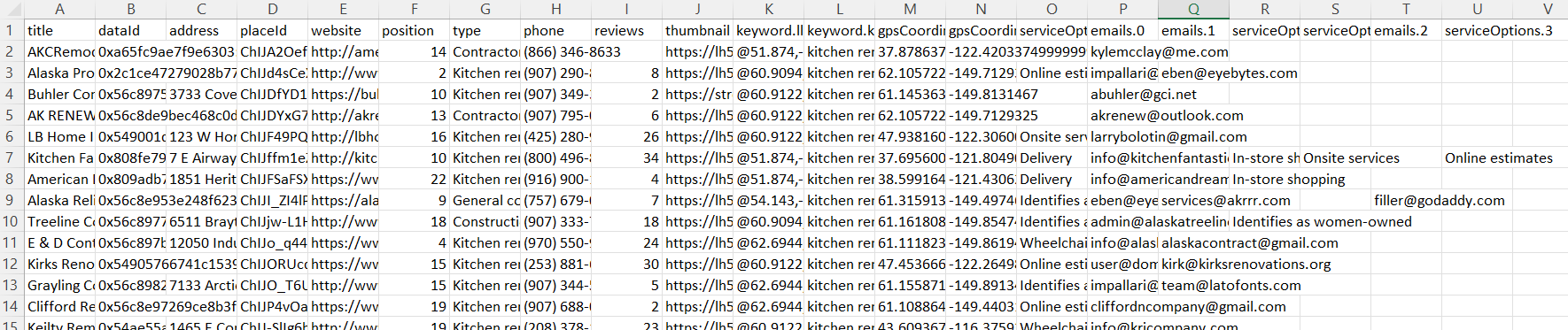

Setelah pengumpulan data selesai, Anda dapat mengunduh file data dalam format yang mudah digunakan. Misalnya, data CSV terlihat seperti ini:

Semua parameter mudah disesuaikan dan intuitif, tetapi penjelasan lebih rinci tentang parameter dapat ditemukan di artikel kami sebelumnya.

Mengekstrak email dengan Zapier dan Web Scraping API

Salah satu layanan integrasi terpopuler saat ini adalah Zapier. Apa itu dan bagaimana cara menggunakannya sudah kami tulis secara detail, jadi kami tidak akan membahas secara detail kelebihan, kekurangan dan prinsip bekerja dengan layanan ini. Mari kita menyusun algoritme untuk Zap masa depan dan melanjutkan implementasinya:

- Dapatkan kata kunci dari Google Sheets yang akan digunakan untuk mencari situs target untuk dirayapi lebih lanjut. Misalnya, Anda dapat mengubah langkah ini untuk memberi Anda tautan, lalu langsung ke langkah 3. Ini mungkin cocok jika Anda sudah memiliki daftar situs web tempat Anda perlu mengumpulkan alamat email.

- Kumpulkan tautan ke situs web berdasarkan kata kunci menggunakan Scrape-It.Cloud SERP API.

- Telusuri situs web yang tautannya telah diperoleh dan ekstrak email dari setiap situs web menggunakan API web scraping.

- Masukkan data yang diperoleh ke dalam lembar tabel lainnya.

Seperti yang Anda lihat dari algoritme, kami akan menggunakan berbagai API Scrape-It.Cloud untuk menyederhanakan proses pengikisan data. Untuk menggunakannya, yang perlu Anda lakukan hanyalah masuk ke situs web dan mendapatkan kunci API di akun Anda.

Untuk menyederhanakannya, kita dapat membaginya menjadi dua zaps terpisah. Yang pertama menangkap daftar situs web untuk kata kunci tertentu dari SERP Google. Zap kedua merayapi situs web yang sudah dikumpulkan dan mengekstrak alamat emailnya. Jika Anda sudah memiliki daftar website yang Anda butuhkan, Anda dapat melompat ke Zap kedua.

Kikis daftar situs web

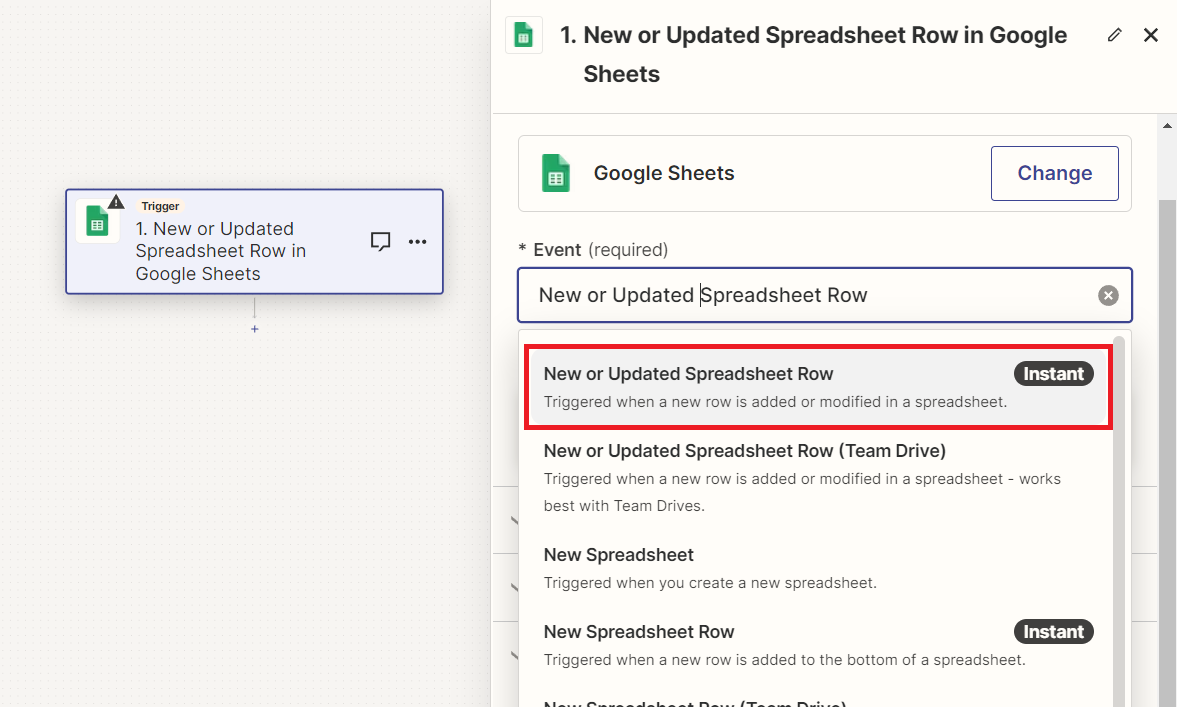

Sekarang mari kembali ke Zapier dan membuat Zap baru. Kami menggunakan penambahan atau pembaruan baris di Google Spreadsheet sebagai pemicu.

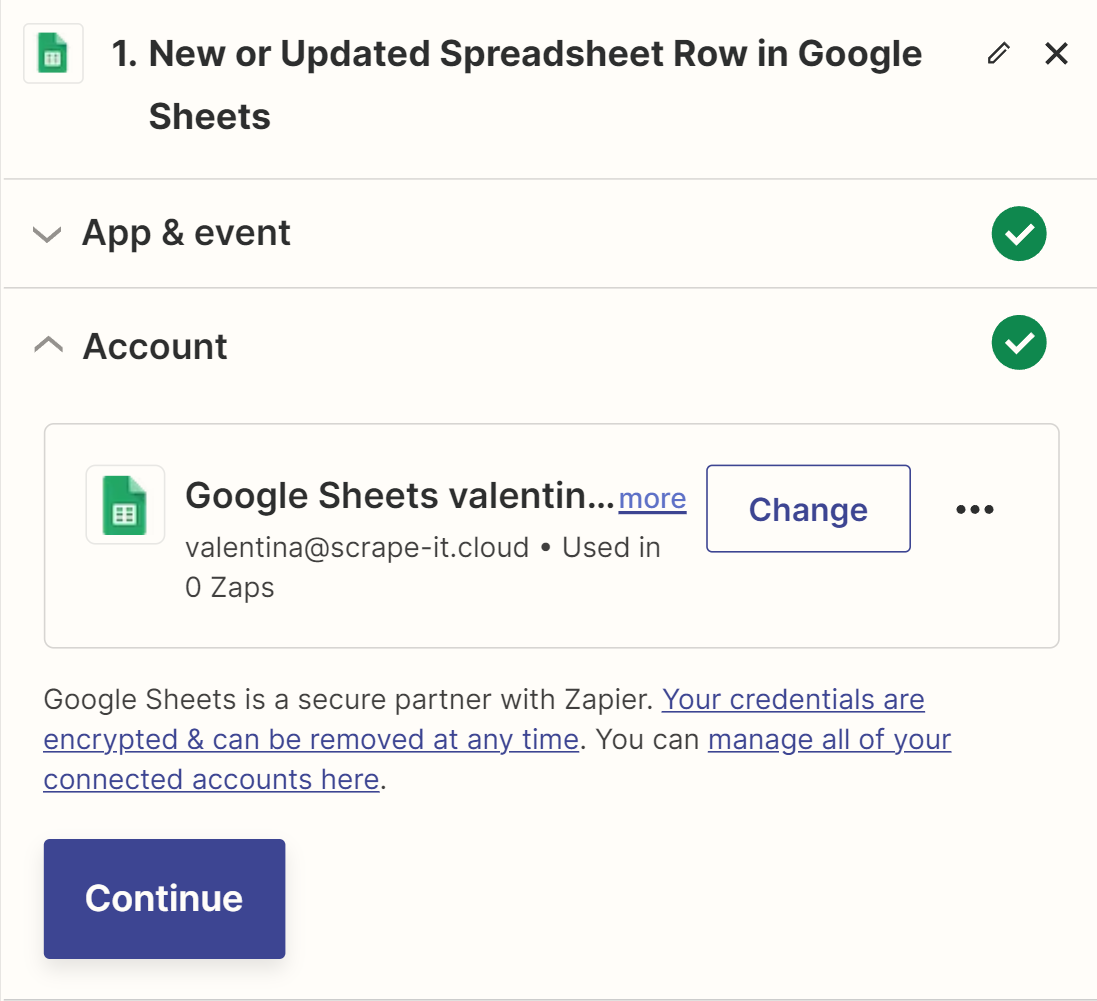

Selanjutnya, masuk ke akun Google Anda, yang berisi dokumen dengan spreadsheet untuk menyimpan data.

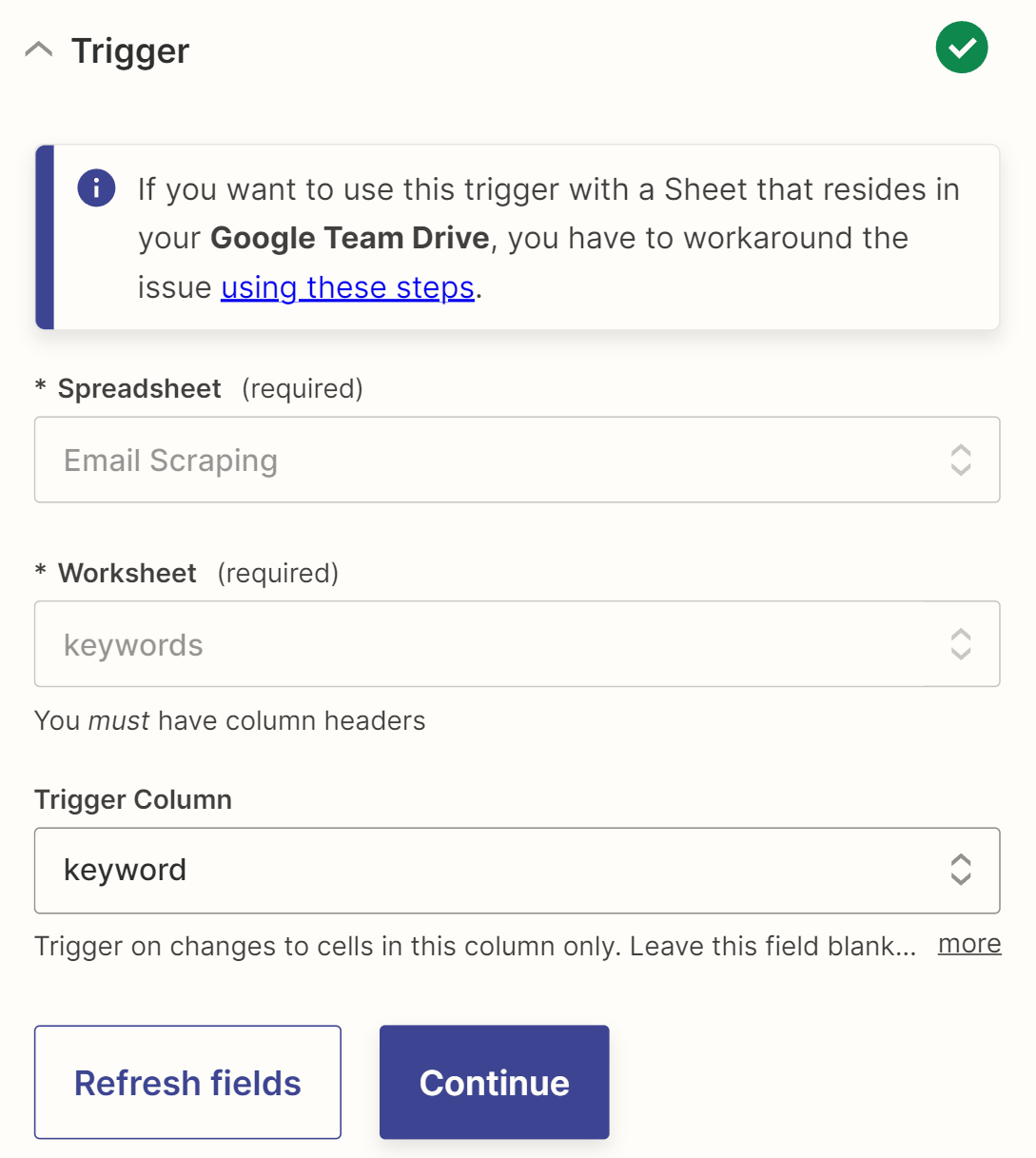

Buat file Google Sheet dengan dua lembar: Kata Kunci (dengan kolom kata kunci tempat Anda mencatat kata kunci untuk mencari situs web target) dan Daftar Email (dengan kolom tautan, judul, dan email untuk penyimpanan data situs web dan email). Kemudian hubungkan sheet ini sebagai trigger dan tandai kolom tempat penyimpanan kata kunci sebagai kolom tracking.

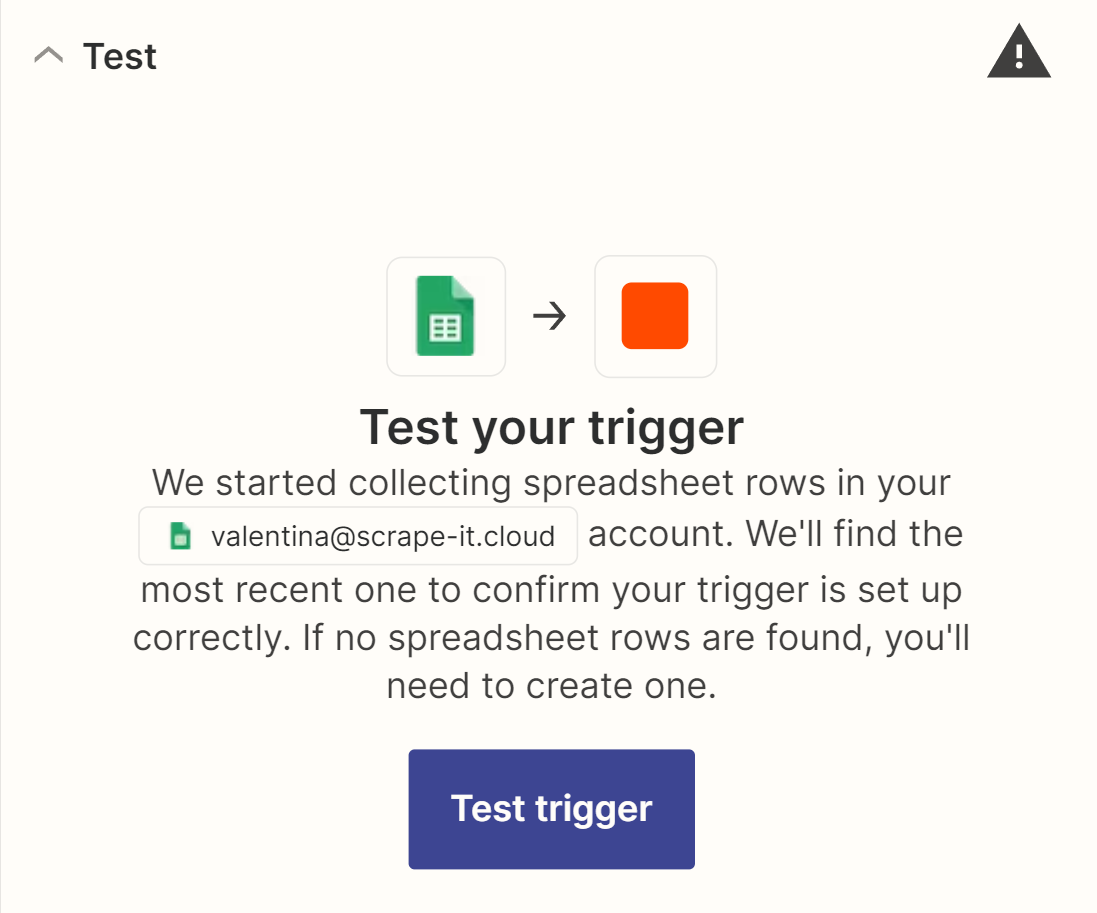

Sebelum melanjutkan ke langkah berikutnya, pastikan pemicunya berfungsi dengan baik.

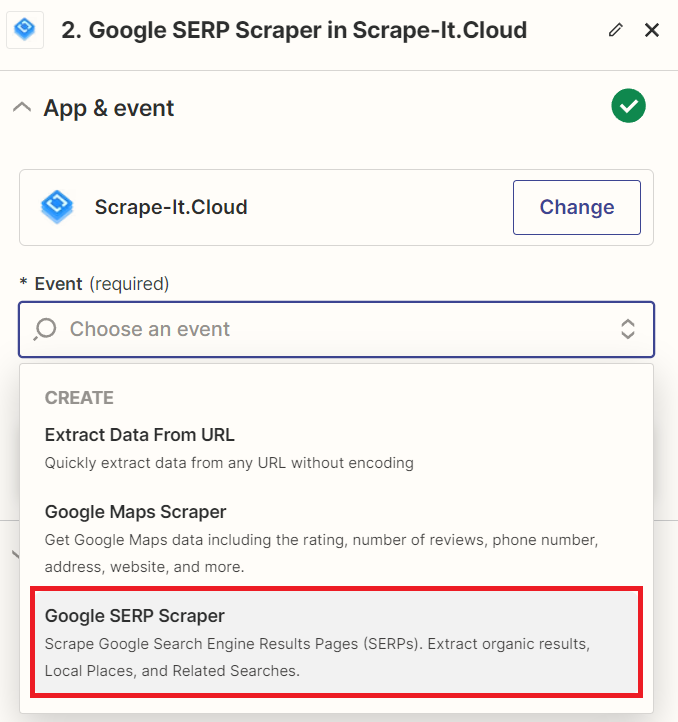

Untuk melakukannya, tambahkan data ke kolom kata kunci dan jalankan pengujian pemicu. Jika data ditemukan dan diambil, pemicunya berfungsi dengan baik. Anda kemudian dapat melanjutkan ke tindakan berikutnya. Untuk melakukan ini, temukan integrasi Scrape-It.Cloud dan pilih tindakan SERP Google.

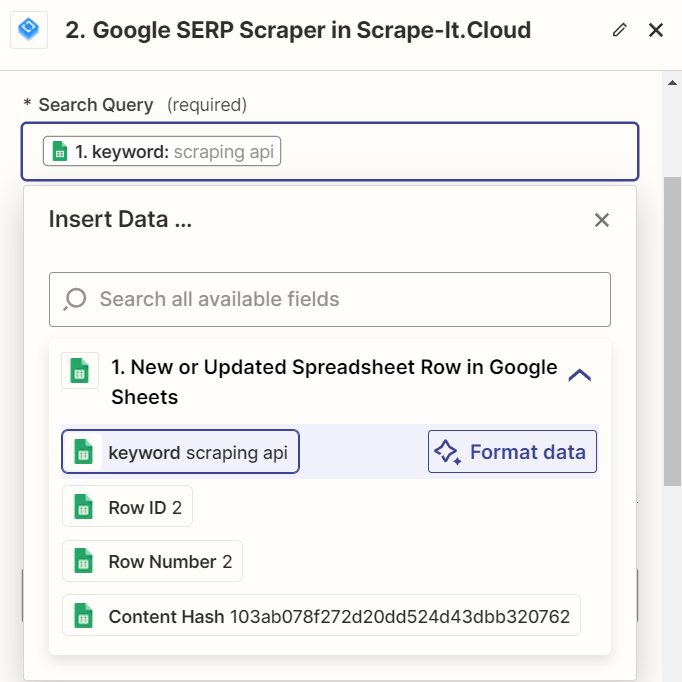

Untuk menghubungkan akun Scrape-It.Cloud Anda, masuk dengan kunci API Anda dan buka halaman pengaturan. Di bidang “Permintaan pencarian”, masukkan kata kunci dari tabel. Anda dapat menyesuaikan parameter lainnya, termasuk pengaturan bahasa dan lokasi, sesuai kebutuhan. Untuk informasi selengkapnya tentang semua parameter yang tersedia, lihat dokumentasi resmi.

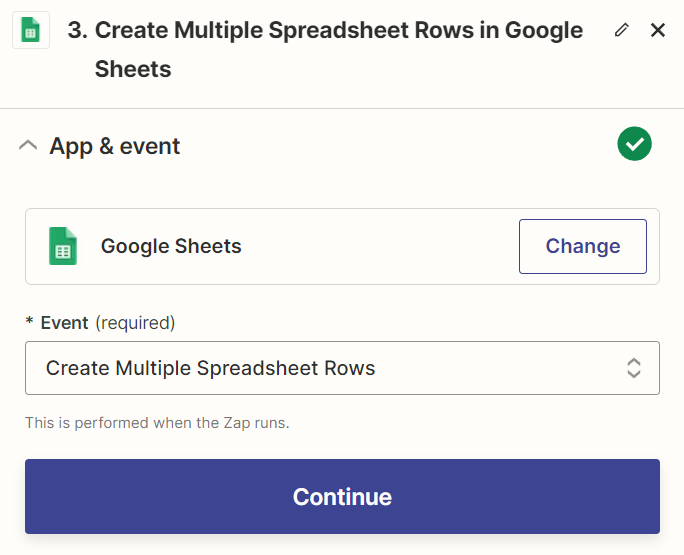

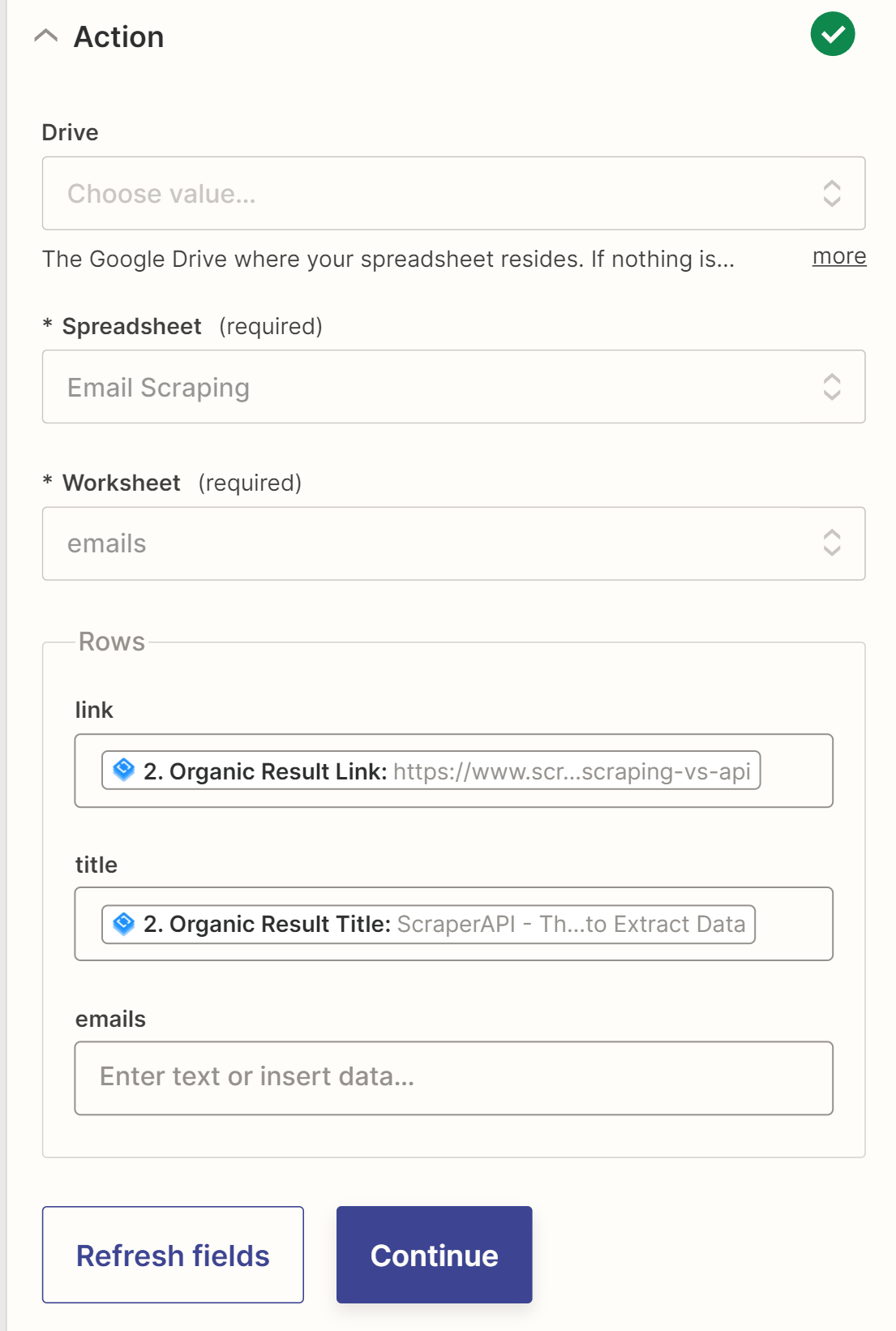

Sebelum melanjutkan ke langkah berikutnya, periksa fungsionalitas tindakan tersebut. Langkah terakhir pada Zap ini adalah menyimpan data pada sheet terpisah di Google Sheet yang sama.

Zapier tidak mendukung loop, yang kami perlukan, jadi kami tidak dapat langsung memproses datanya. Sebagai gantinya, kami menyimpan tautan dan nama situs web di lembar baru dan memprosesnya di Zap berikutnya.

Mari simpan Zap yang baru kita buat dan buat yang baru.

Hapus email dari situs web

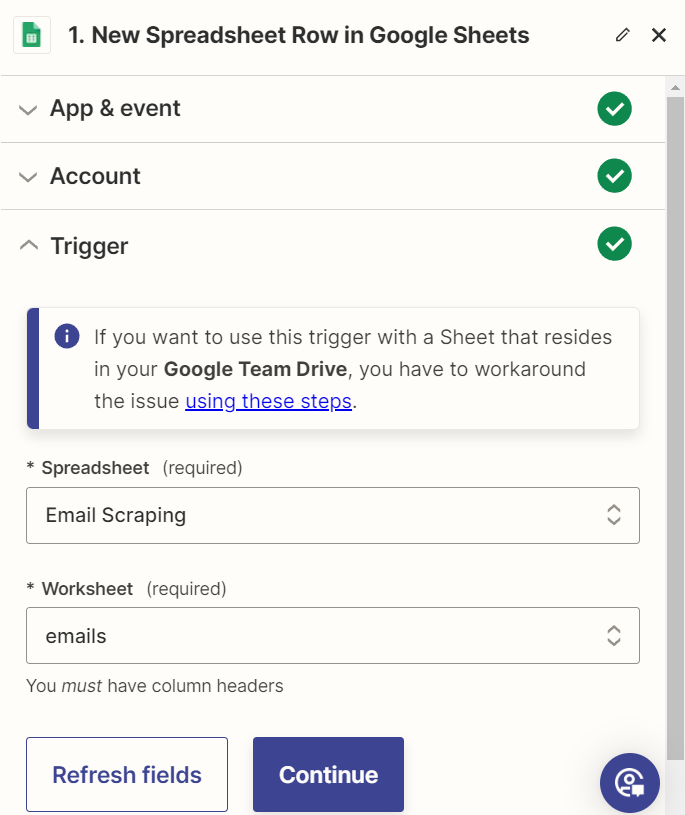

Pertama, mari tambahkan pemicu yang mengaktifkan Zap kita. Dalam kasus kita, kita perlu melacak kemunculan baris baru di Google Sheet dan kemudian memprosesnya.

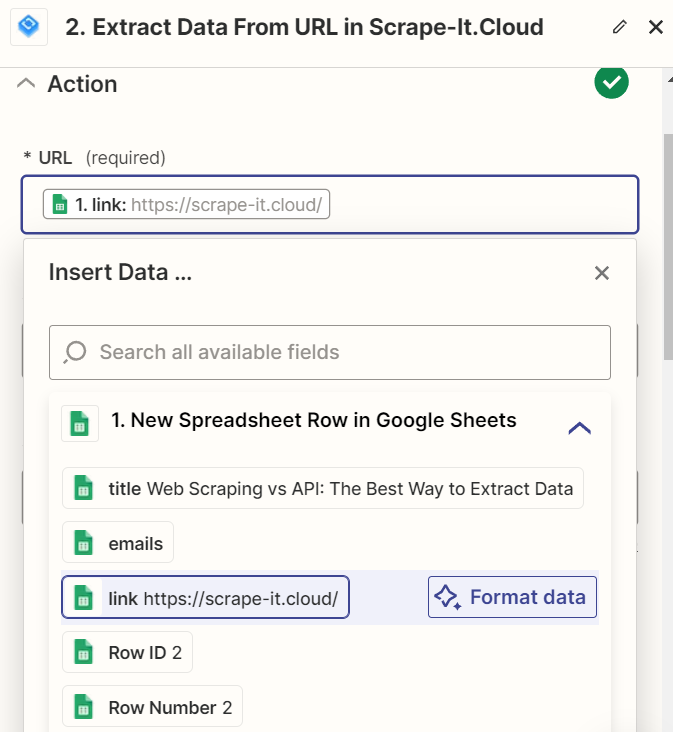

Oleh karena itu, setelah mendeteksi baris baru di tabel email, kami memanggil tindakan “Scrape-It.Cloud”. Kita perlu mengekstrak data dari website menggunakan URL untuk mengambil alamat email dari website menggunakan link yang kita kumpulkan sebelumnya.

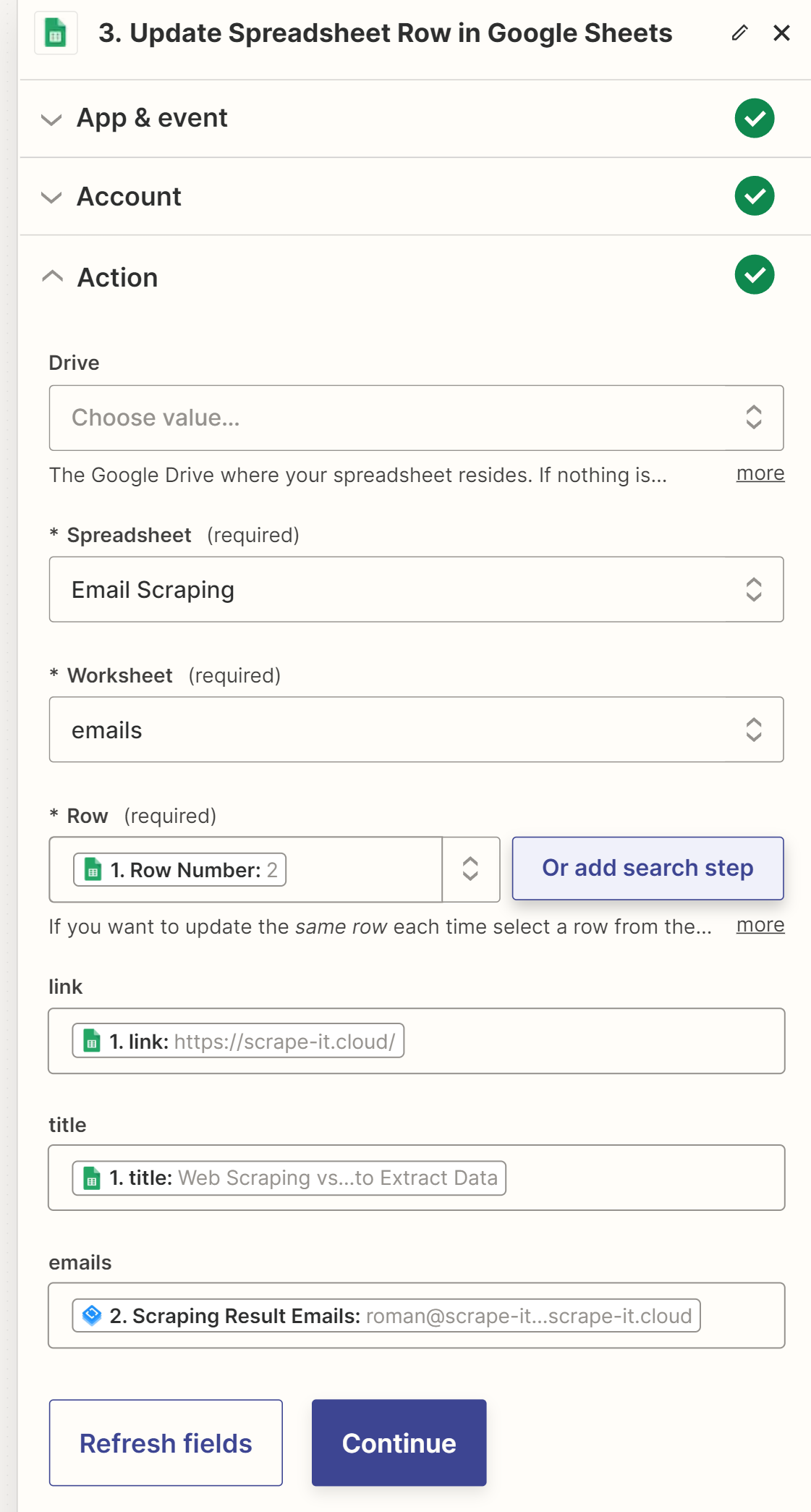

Untuk menyelesaikan proses ini kita harus memperbarui baris tabel yang kita terima di pemicu. Nomor baris diteruskan sebagai parameter ke pemicu. Kita dapat menggunakannya untuk mengidentifikasi baris yang akan diperbarui. Tetapkan nilai untuk semua sel di baris, termasuk email yang dikumpulkan.

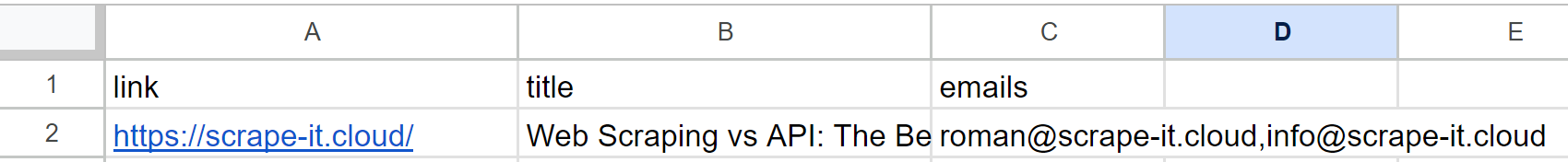

Setelah pengujian, tabel yang awalnya kita buat akan berisi data yang diperbarui:

Seperti yang disebutkan, Anda tidak harus menggunakan Zap pertama. Anda dapat menggunakan daftar situs web yang diperoleh melalui cara lain. Selain itu, Anda dapat menyesuaikan Zap lebih lanjut sesuai kebutuhan untuk menyimpan informasi tambahan atau mengatur pengiriman email ke alamat email yang dikumpulkan menggunakan integrasi Gmail.

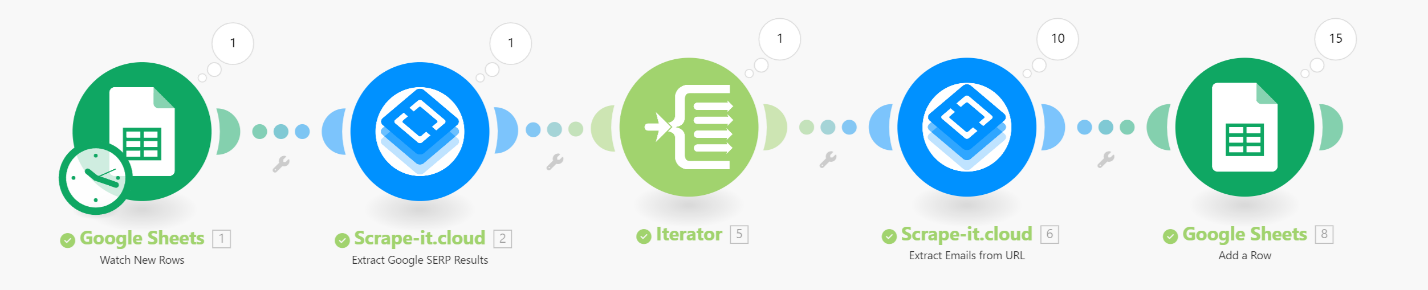

Layanan integrasi populer lainnya adalah Make.com, sebelumnya dikenal sebagai Integromat. Oleh karena itu, sekarang kami menggunakan algoritma yang sama seperti pada contoh sebelumnya, tetapi mengimplementasikannya menggunakan layanan Make.com. Selain itu, ini mendukung fungsi pemrosesan data yang lebih luas dan kami akan dapat memproses semua tautan yang diterima dalam satu skenario.

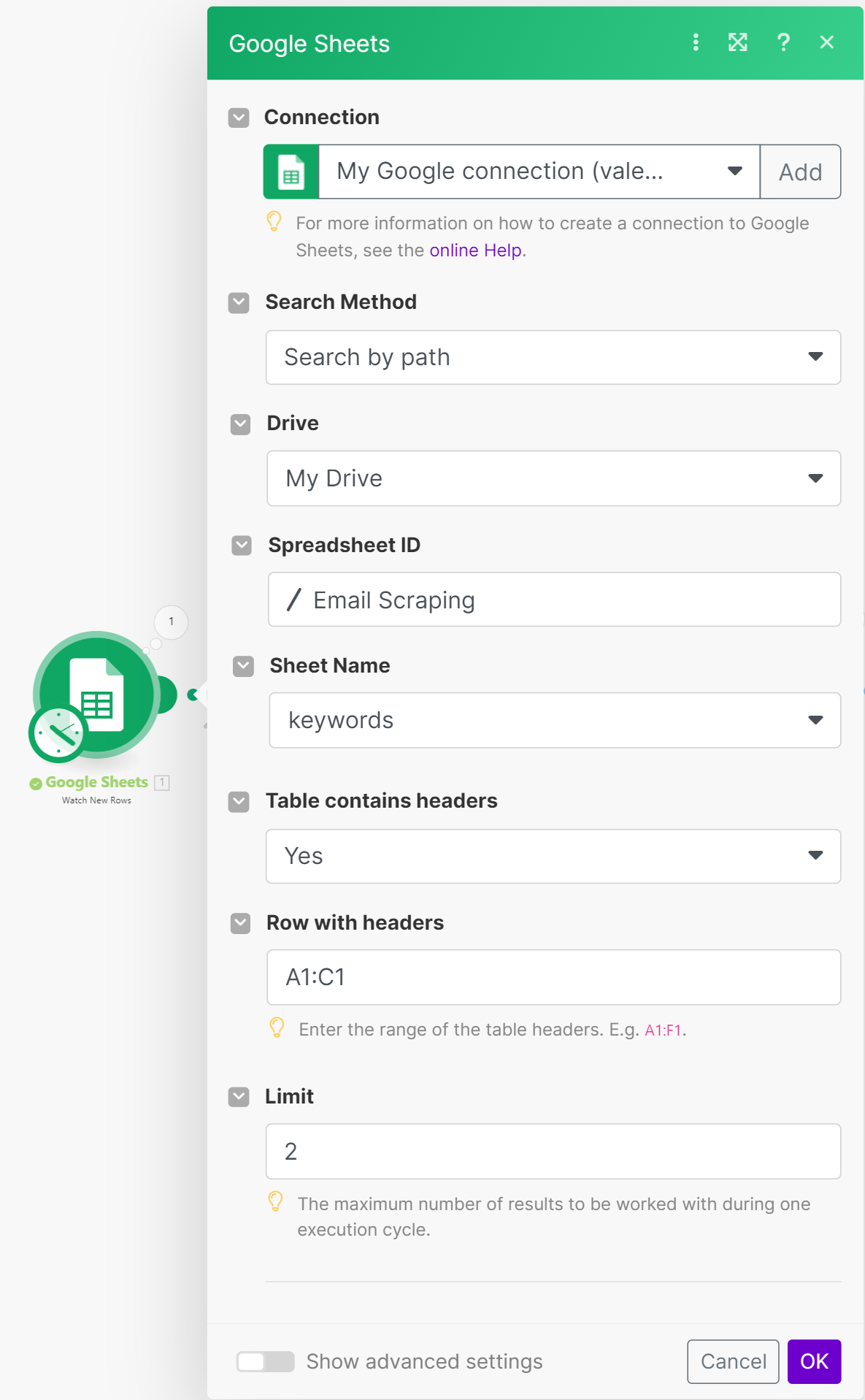

Pertama, masuk dan buat skenario baru. Langkah pertama adalah mendapatkan baris baru dari spreadsheet Google Sheets yang berisi daftar kata kunci website yang kita cari. Untuk melakukan ini, pilih tindakan baru dan cari integrasi Google Sheets dan metode untuk mencari baris baru. Kami menggunakan tabel yang sama seperti pada contoh sebelumnya.

Sesuaikan batas garis sesuai keinginan Anda. Jika Anda sudah memiliki link website, Anda dapat melompat ke bagian pemrosesan link.

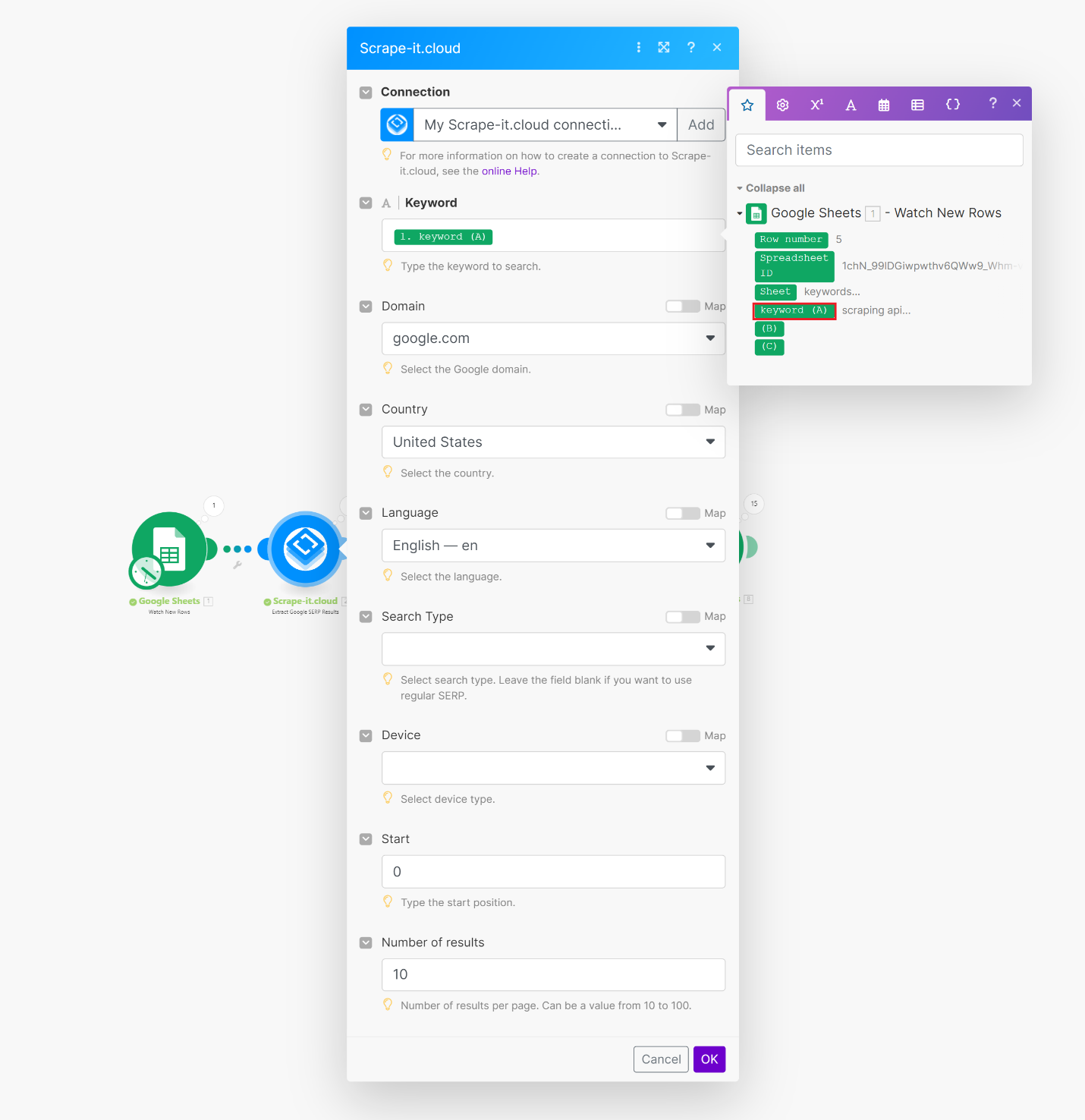

Tambahkan tindakan berikut dan temukan integrasi Scrape-It.Cloud. Kami membutuhkan metode untuk mengekstrak data dari hasil SERP Google. Di kolom Kata Kunci, masukkan nilai dari langkah sebelumnya. Anda juga dapat menyesuaikan bahasa, jumlah hasil, dan pelokalan.

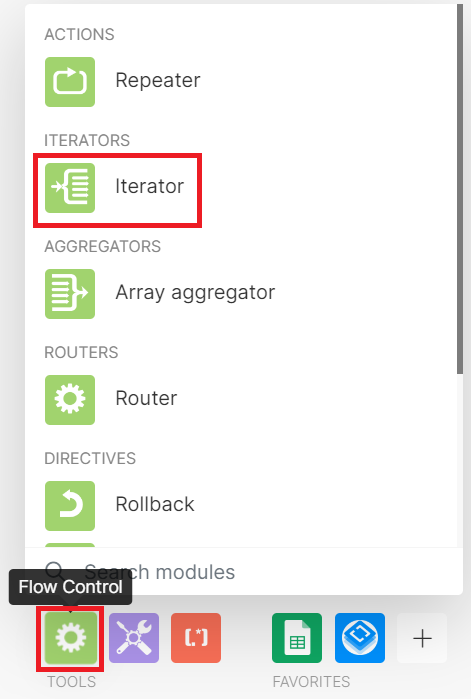

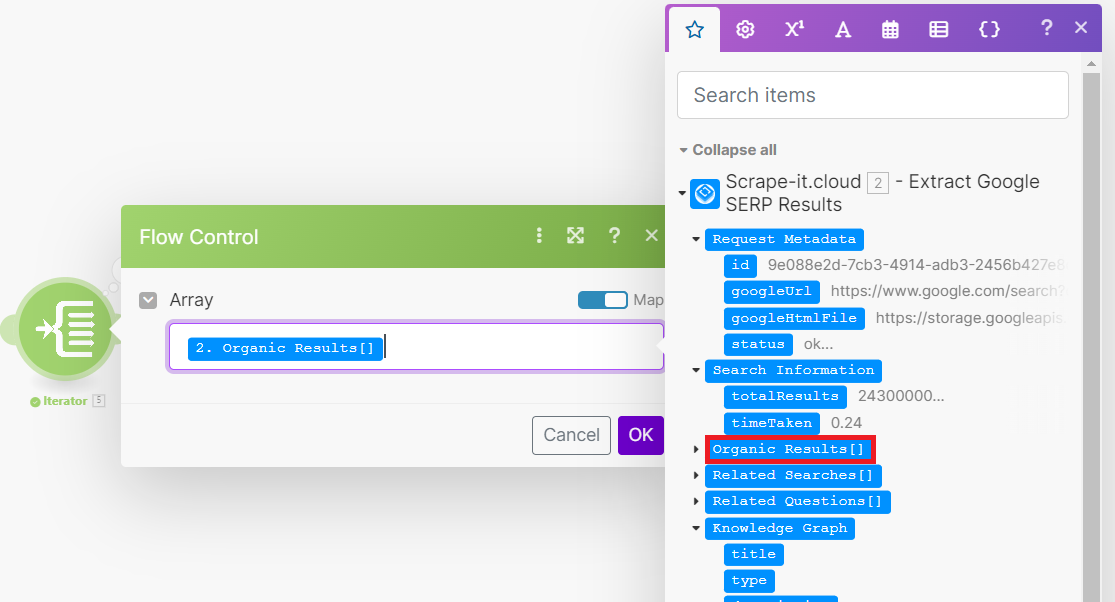

Sekarang kita memiliki daftar situs web dari hasil pencarian, kita perlu memeriksa semuanya dan mengumpulkan alamat email perusahaan dari masing-masing situs. Untuk melakukan ini kita akan menggunakan iterator, yang dapat ditemukan di menu App Flow di bagian bawah layar.

Iterator adalah objek yang memungkinkan Anda mengakses dan memproses setiap elemen struktur data secara berurutan. Dengan kata lain, ini bekerja seperti perulangan dalam pemrograman. Untuk tugas kita hanya perlu mengolah hasil organiknya saja. Data lain yang dikembalikan oleh Google SERP API tidak diperlukan.

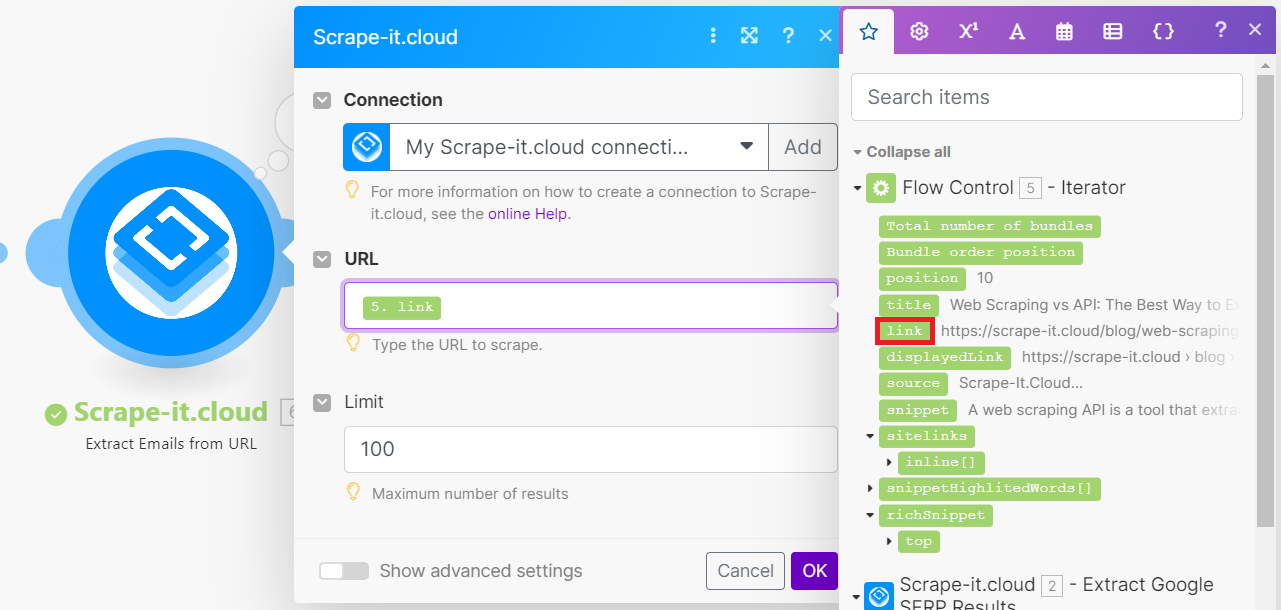

Sekarang mari kita gunakan metode Scrape-It.Cloud yang lain: mengambil daftar alamat email dari URL situs web. Untuk melakukan ini, kami meneruskan tautan dari iterasi saat ini ke metode pengikisan email.

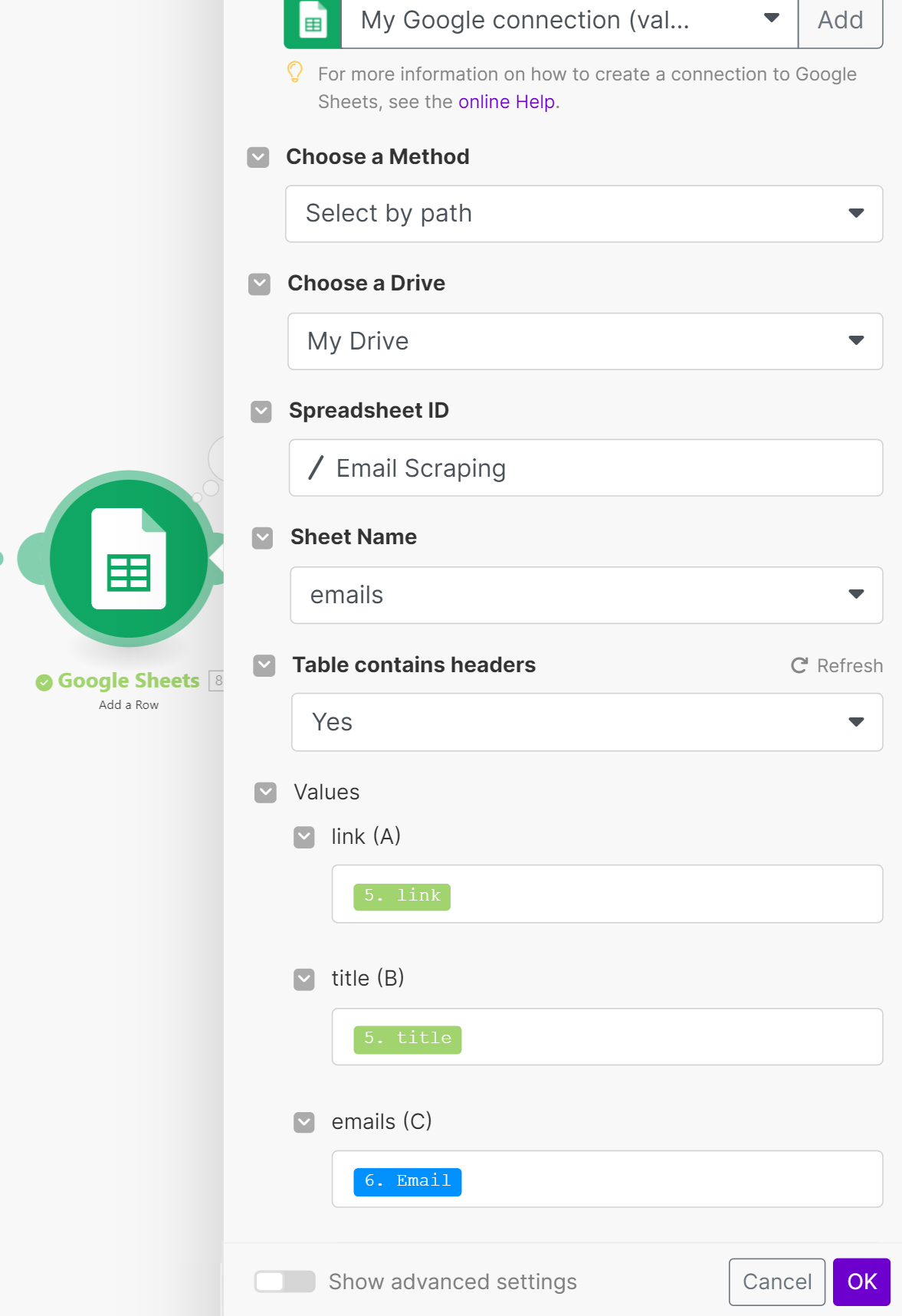

Langkah terakhir adalah mengimpor semua data yang dikumpulkan ke Google Sheets. Jika perlu, Anda dapat mengelompokkan data yang dikumpulkan terlebih dahulu menggunakan fungsi iterator terbalik, agregator array. Alternatifnya, Anda cukup mengimpor semua data ke dalam lembar berisi alamat email.

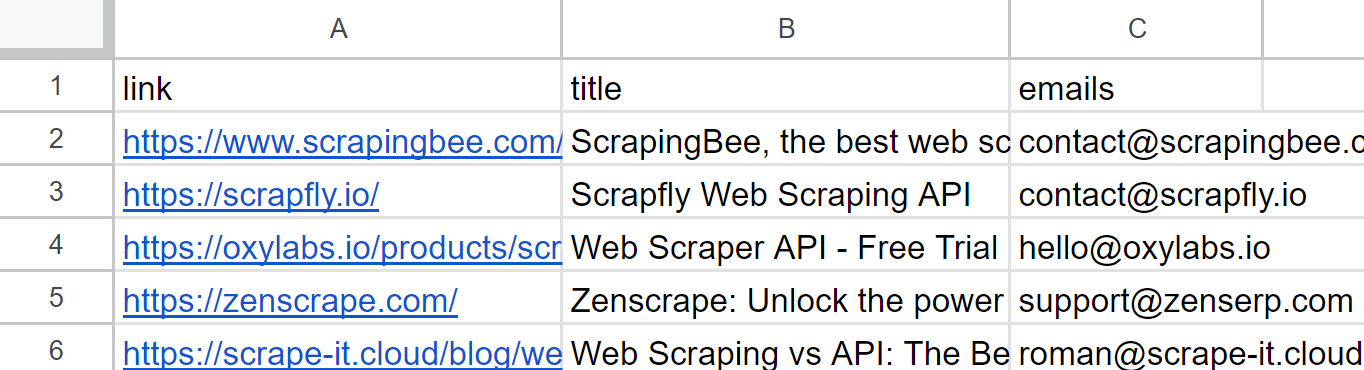

Mari jalankan skenario yang dihasilkan dan lihat hasilnya.

Setelah menyelesaikan tugas, periksa spreadsheet Google Sheets:

Berdasarkan pengalaman kami, Make.com menawarkan fitur pemrosesan data yang lebih luas daripada Zapier, termasuk kemampuan untuk bekerja dengan array dan variabel. Hal ini menjadikan Make.com pilihan yang lebih baik bagi pengguna yang perlu melakukan tugas pemrosesan data yang kompleks.

Pengikisan email berbasis Python

Sekarang kita telah menganalisis algoritma untuk membuat skrip seperti itu, mari kita implementasikan versi serupa, tetapi sepenuhnya mandiri, tanpa menggunakan layanan integrasi. Kami menggunakan Python karena ini adalah salah satu bahasa pemrograman termudah dan terpopuler untuk scraping.

Untuk menyederhanakan proses scraping, kami juga menggunakan API Scrape-It.Cloud karena kami lebih mementingkan cara kami memproses data yang kami kumpulkan daripada cara kami mengumpulkannya. Namun, Anda dapat memodifikasi sendiri skripnya untuk mengumpulkan data secara mandiri tanpa menggunakan API. Sebelumnya kami menulis tentang cara mengikis situs web apa pun dengan Python dan cara mengikis Google SERP dengan Python.

Kami memberi Anda skrip terakhir di Colab Research. Jika Anda bingung atau mengalami masalah, Anda cukup menyalin versi final kami. Jadi mari kita mulai menulis naskahnya. Pertama, impor perpustakaan yang kita gunakan untuk membuat permintaan, bekerja dengan respons JSON, dan memproses/menyimpan data:

import requests

import json

import pandas as pdSelanjutnya, kami mendeklarasikan variabel untuk menyimpan parameter yang diubah atau digunakan kembali, seperti kunci API Scrape-It.Cloud atau kata kunci untuk mencari situs web yang relevan di SERP Google.

api_key = 'YOUR-API-KEY

keyword = 'scraping api'Sesuaikan isi dan header permintaan di masa mendatang. Anda dapat mengubah bahasa atau lokalisasi dan banyak lagi. Untuk daftar lengkap parameter yang tersedia, lihat dokumentasi resmi.

params_serp = {

'q': keyword,

'filter': 1,

'domain': 'google.com',

'gl': 'us',

'hl': 'en',

'deviceType': 'desktop'

}

url_serp = "https://api.scrape-it.cloud/scrape/google"

url_scrape = "https://api.scrape-it.cloud/scrape"

headers_serp = {'x-api-key': api_key}

headers_scrape = {

'x-api-key': api_key,

'Content-Type': 'application/json'

}Buat permintaan ke Google SERP API dan parsing respons JSON untuk diproses lebih lanjut.

response_serp = requests.get(url_serp, params=params_serp, headers=headers_serp)

data_serp = response_serp.json()Ekstrak tautan dari respons JSON yang diterima.

links = (result('link') for result in data_serp.get('organicResults', ()))Buat variabel untuk menyimpan pemetaan alamat link-email dan buat loop untuk mengulangi semua link yang diterima.

data = ()

for link in links:Buat isi permintaan untuk API pengikisan web untuk mengekstrak alamat email dari tautan saat ini.

payload_scrape = json.dumps({

"url": link,

"js_rendering": True,

"extract_emails": True

})Buat permintaan API dan parsing respons JSON.

response_scrape = requests.post(url_scrape, headers=headers_scrape, data=payload_scrape)

json_response_scrape = response_scrape.json()Ekstrak email dari respons dan tambahkan ke data variabel yang dibuat sebelumnya.

emails = json_response_scrape.get("scrapingResult", {}).get("emails", ())

data.append({"link": link, "emails": emails})Terakhir, buat DataFrame dari data yang dikumpulkan dan simpan ke file CSV.

df = pd.DataFrame(data)

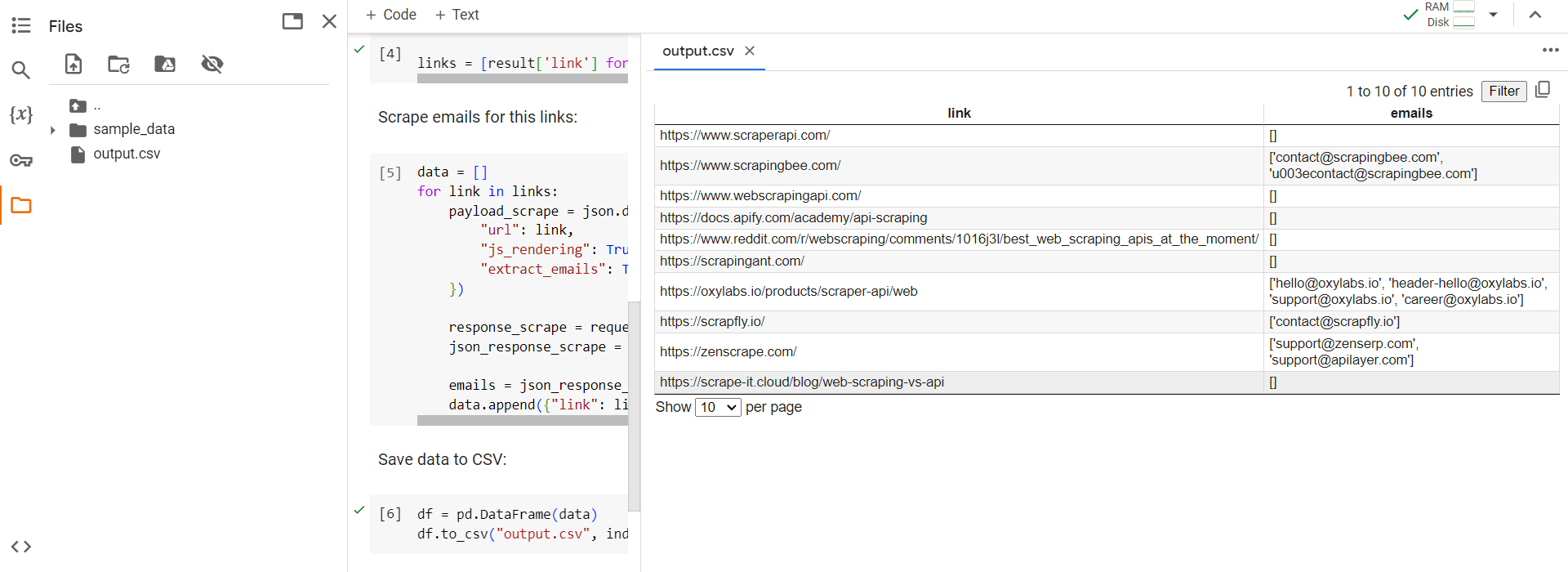

df.to_csv("output.csv", index=False)Untuk menguji skrip, kami menjalankannya langsung di Colab Research dan memeriksa file keluaran yang dihasilkan.

Seperti yang Anda lihat dari contoh, skrip mengumpulkan semua email yang tersedia dan menyimpannya dalam file CSV atau Excel yang nyaman. Anda dapat mengembangkan skrip lebih lanjut untuk, misalnya, menggunakan file Anda dengan daftar tautan ke situs web yang alamat emailnya perlu Anda ekstrak daripada mencari situs web di SERP Google.

Praktik terbaik pengikisan email

Untuk membuat pengikisan email lebih produktif, penting untuk mengikuti beberapa aturan dan rekomendasi. Beberapa dari rekomendasi ini dimaksudkan untuk meningkatkan kualitas pengikisan, misalnya. B. menggunakan proxy, pemecah CAPTCHA, atau layanan pengikisan atau API khusus. Rekomendasi lainnya khusus untuk pengumpulan email yang efektif, yang dapat membantu Anda mengumpulkan alamat email yang lebih banyak dan berkualitas lebih tinggi dari bisnis dan individu.

Berikut adalah beberapa rekomendasi khusus untuk pengumpulan email yang efektif:

- Melakukan pemeriksaan kualitas data. Setelah mengumpulkan data, filter dan bersihkan dengan hati-hati untuk menghapus alamat email yang tidak valid atau ketinggalan jaman. Anda dapat menggunakan layanan validasi email khusus untuk memverifikasi alamat email sebelum menambahkannya ke database atau file Anda.

- Tetapkan batas jumlah permintaan. Batasi jumlah permintaan yang Anda buat ke situs web untuk menghindari pemblokiran atau kelebihan beban server. Anda dapat menggunakan penundaan antar permintaan untuk mengurangi beban Anda.

- Pertimbangkan untuk menerapkan pencadangan data. Buat cadangan data yang Anda kumpulkan untuk memastikannya tidak hilang.

- Perbarui data Anda secara berkala. Perbarui data yang Anda kumpulkan secara berkala untuk menghindari penggunaan alamat yang sudah ketinggalan zaman. Hal ini sangat penting jika Anda menggunakan data untuk kampanye pemasaran email dan promosi penjualan.

Selain itu, penting untuk dicatat bahwa saat mengumpulkan alamat email, yang terbaik adalah menggunakan sumber terpercaya yang telah disediakan secara eksplisit oleh pengguna. Untuk pengguna individu, ini juga bisa berupa platform media sosial seperti LinkedIn. Sebaiknya bisnis mengekstrak data dari halaman kontak atau beranda situs web mereka.

Legalitas Pengikisan Email

Dalam kebanyakan kasus, mengumpulkan alamat email dari sumber data publik untuk tujuan pribadi, kecuali untuk berbagi data dengan pihak ketiga, adalah sah. Misalnya, mengumpulkan informasi kontak perusahaan dari sumber informasi publik untuk tujuan penelitian adalah sah selama tidak bertentangan dengan kebijakan perusahaan.

Namun, segalanya menjadi sedikit lebih rumit dengan alamat email masing-masing pengguna, karena alamat email tersebut tidak dapat digunakan tanpa persetujuan tertulis dari pengguna. Misalnya, kepatuhan terhadap GDPR (Peraturan Perlindungan Data Umum) sangat penting ketika menangani data warga negara Eropa.

Untuk menghindari masalah di masa depan, pahami kebijakan situs dan ikuti peraturannya sebelum mengumpulkan data. Selain itu, pastikan penggunaan data Anda sesuai dengan tujuan awalnya dan tidak melanggar hukum.

Diploma

Pada artikel ini, kami membahas beberapa cara untuk mengumpulkan alamat email, cocok untuk mereka yang tidak pandai pemrograman dan mereka yang ingin membuat dan menggunakan skrip mereka sendiri. Selain itu, kami melihat contoh pembuatan skrip pengumpulan data pada dua platform integrasi populer, Zapier dan Make.com.

Selain contoh praktis yang kami berikan, kami juga memberikan rekomendasi yang dapat membantu Anda mengembangkan lebih lanjut otomatisasi pengumpulan alamat email di masa mendatang. Wawasan dari bagian legalitas akan membantu Anda mengumpulkan data yang Anda perlukan tanpa melanggar peraturan privasi.