Beim E-Mail-Scraping werden E-Mail-Adressen automatisch aus verschiedenen Quellen extrahiert, beispielsweise aus Websites, Unternehmensverzeichnissen oder sozialen Medien. Die Wahl der Datenquelle hängt davon ab, wie die Daten verwendet werden.

In diesem Artikel untersuchen wir die Möglichkeit, eine Liste von Websites aus Google SERP oder Google Maps zu sammeln und dann E-Mail-Daten von diesen Websites zu extrahieren. Um den Prozess der Datenerfassung von Websites zu vereinfachen, nutzen wir verschiedene API- und Integrationsdienste wie Zapier und Make.com.

So funktioniert E-Mail-Scraping

Um E-Mail-Adressen von Websites zu entfernen, müssen Sie zunächst eine Liste der Websites definieren, von denen Sie E-Mail-Adressen entfernen möchten. Anschließend müssen Sie alle diese Websites oder Seiten (wenn Sie soziale Medien durchsuchen) crawlen und die E-Mail-Adressen extrahieren. Mit diesem Prozess können Datenbanken für verschiedene Zwecke erstellt werden, von digitalen Marketingkampagnen bis hin zur Lead-Generierung und CRM.

In diesem Tutorial erfahren Sie, wie Sie mithilfe der Google SERP API und der Google Maps API automatisch Links von Websites entfernen. Außerdem zeigen wir, wie man die Daten in einer CSV-Datei speichert. Wenn Sie bereits über eine Liste von Ressourcen verfügen, aus denen Sie Daten extrahieren möchten, können Sie auch das Scraping dieser Websites konfigurieren. Hier sind die Schritte zum Scrapen von E-Mail-Adressen von Websites:

- Definieren Sie eine Liste von Websites, von denen Sie E-Mail-Adressen extrahieren möchten. Dies kann manuell oder mithilfe von Bots, Chrome-Erweiterungen oder anderen Scraping-Tools erfolgen.

- Verwenden Sie ein Web-Scraping-Tool, um die Websites in Ihrer Liste zu crawlen. Das Tool extrahiert die E-Mail-Adressen von den Websites.

- Speichern Sie die E-Mail-Adressen in einer Datenbank oder einer Datei. Dies erleichtert den späteren Zugriff auf die Daten.

Um das Scraping umfassender zu gestalten, können Sie beim Scraping von Links aus Google Maps außerdem zusätzliche Daten wie Telefonnummern, Preise oder Adressen extrahieren. Alle diese Beispiele werden wir im Folgenden in der Praxis demonstrieren. Wir werden auch Beispiele für die Verwendung von Integrationen für diejenigen bereitstellen, die mit der Programmierung nicht vertraut sind, und wir werden ein Python-Skript für diejenigen entwickeln, die ihr Skript für die spätere Integration in ihr Programm anpassen möchten.

Anwendungsfälle und praktische Anwendungen

Wie bereits erwähnt, ist E-Mail-Scraping eine wertvolle Strategie zur Lead-Generierung, die Unternehmen dabei helfen kann, potenzielle Kunden schnell und effizient zu identifizieren. Hier sind einige Beispiele dafür, wie Sie E-Mail-Adressen verwenden können, die Sie von Websites entfernt haben:

- Marketing-Kampagnen. Sie können E-Mail-Adressen verwenden, um SEO-Marketingkampagnen (Cold-E-Mail) an potenzielle Kunden zu senden.

- Lead-Generierung. Sie können E-Mail-Adressen verwenden, um Leads für Ihr Unternehmen zu generieren.

- Sie können E-Mail-Adressen verwenden, um eine Zielgruppe zu recherchieren.

Die Quelle der E-Mail-Adresserfassung sollte auf der Grundlage der beabsichtigten Verwendung der Daten bestimmt werden. Da E-Mail-Adressen typischerweise zur Lead-Generierung erfasst werden, nutzen wir zu diesem Zweck die relevantesten Quellen, wie z. B. Suchergebnisse für Schlüsselwörter und Google Maps.

E-Mail-Scraping in der Praxis

Lassen Sie uns über praktische Möglichkeiten zum Scrapen von E-Mail-Adressen sprechen. Wir haben bereits verschiedene Möglichkeiten zum Scrapen von E-Mail-Adressen aus Google Maps besprochen, daher konzentrieren wir uns auf den Prozess des Sammelns von Links zu Ressourcen von Google SERP und dem sequentiellen Crawlen von Websites, um E-Mail-Adressen zu sammeln. Wir prüfen die folgenden Optionen zum Sammeln von E-Mail-Adressen:

- Verwendung vorgefertigter No-Code-Scraper. Für diese Methode sind keine Programmierkenntnisse erforderlich und die Erfassung der E-Mail-Adressen erfolgt vollständig automatisiert.

- Nutzung von Integrationsdiensten. Diese Methode erfordert das Einrichten von Parametern und Integrationen. Diese Option umfasst die Nutzung von Diensten wie Make.com und Zapier.

- Erstellen Sie Ihren E-Mail-Extraktor. Dies erfordert Programmierkenntnisse, da der Scraping- und Datenverarbeitungsprozess in einem separaten Skript eingerichtet wird.

Im Folgenden besprechen wir jede dieser Optionen, beginnend mit der einfachsten, die keine zusätzlichen Fähigkeiten erfordert, und enden mit dem Schreiben eines separaten Scrapers auf Basis verschiedener APIs, um den Prozess zu vereinfachen.

No-Code-Scraper für geschäftliche E-Mails

Die Verwendung eines vorgefertigten No-Code-Scraper ist die einfachste und zugleich komplexeste Möglichkeit, E-Mail-Adressen zu sammeln. Denn mit einem vorgefertigten leistungsstarken Tool können Sie nur dann Daten extrahieren, wenn die Ressource, für die das Tool entwickelt wurde, zunächst Daten über die E-Mail-Adressen von Unternehmen oder Nutzern bereitstellt.

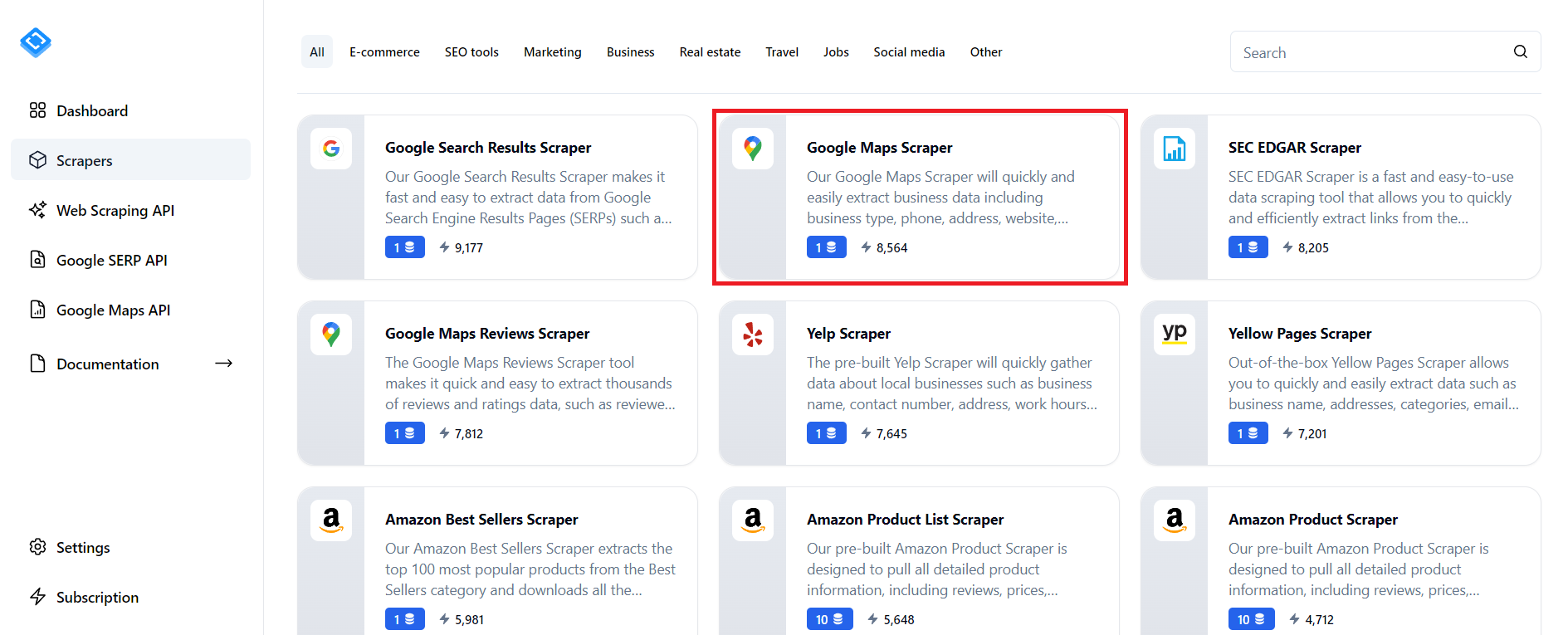

Eine solche Ressource ist Google Maps, das nicht nur Daten zu Orten, sondern auch deren Kontaktinformationen, einschließlich E-Mail-Adressen, bereitstellt. Um schnell E-Mail-Adressen von Google Maps zu erhalten, melden Sie sich auf der Scrape-It.Cloud-Website an und gehen Sie zum Abschnitt mit vorgefertigten Scrapern.

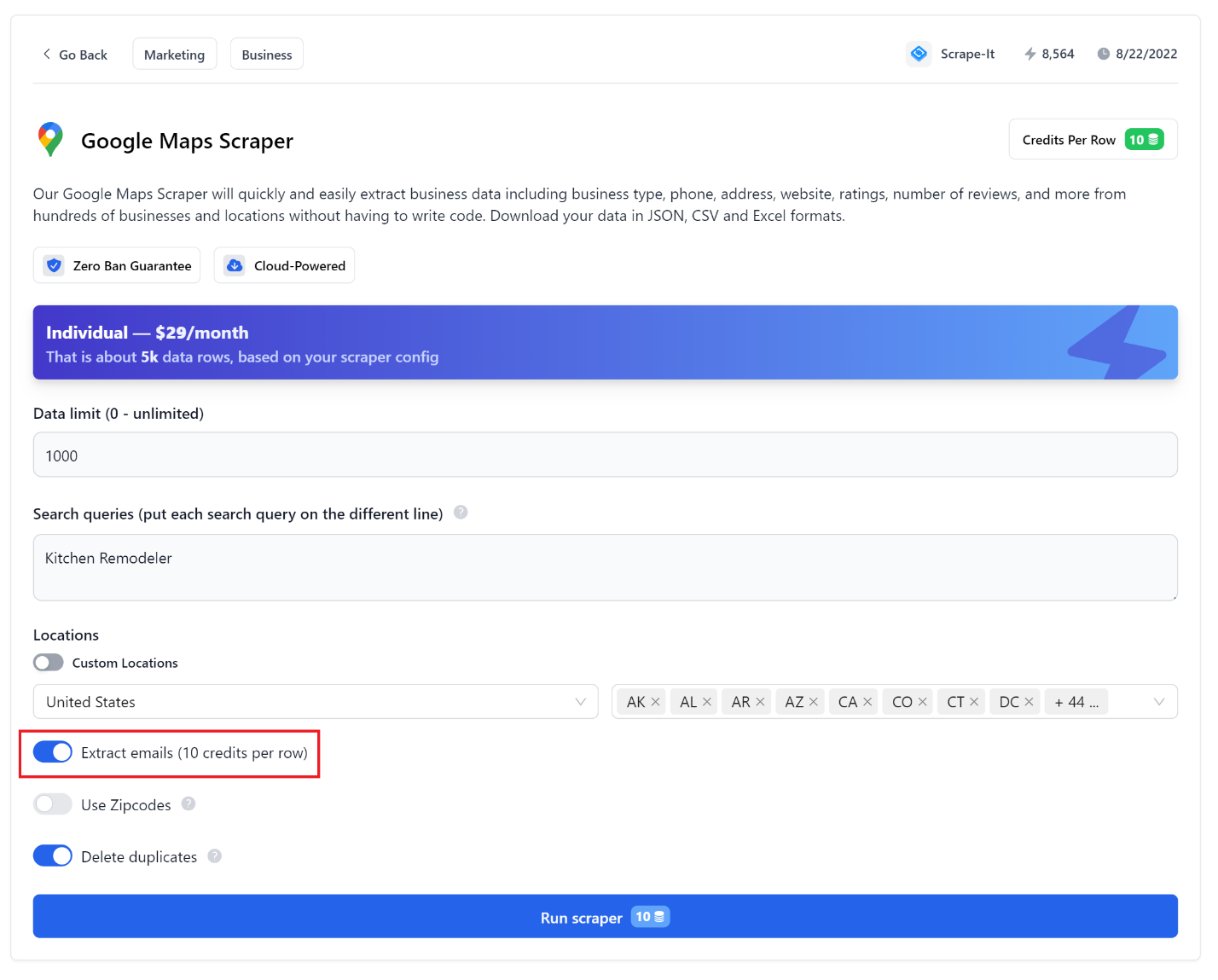

Suchen Sie dann den Google Maps Scraper und konfigurieren Sie die notwendigen Parameter entsprechend Ihren Anforderungen. Aktivieren Sie unbedingt das Kontrollkästchen zum Sammeln von E-Mail-Adressen.

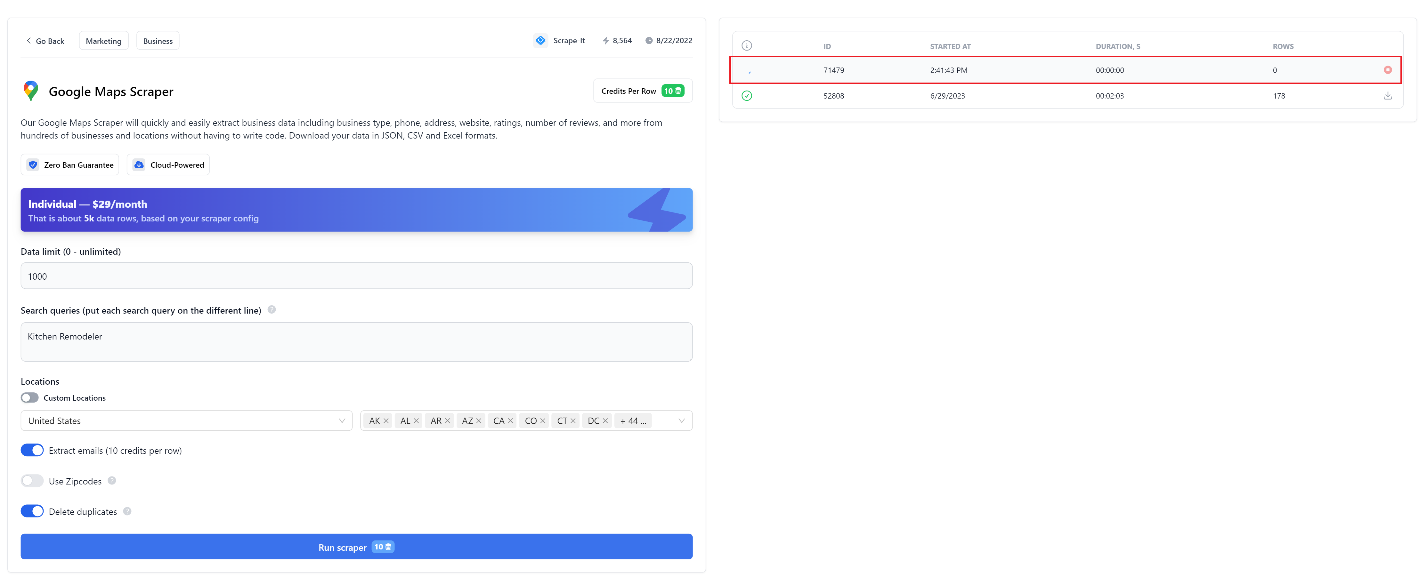

Klicken Sie anschließend auf die Schaltfläche „Scraping starten“ und warten Sie, bis die Datenerfassung abgeschlossen ist.

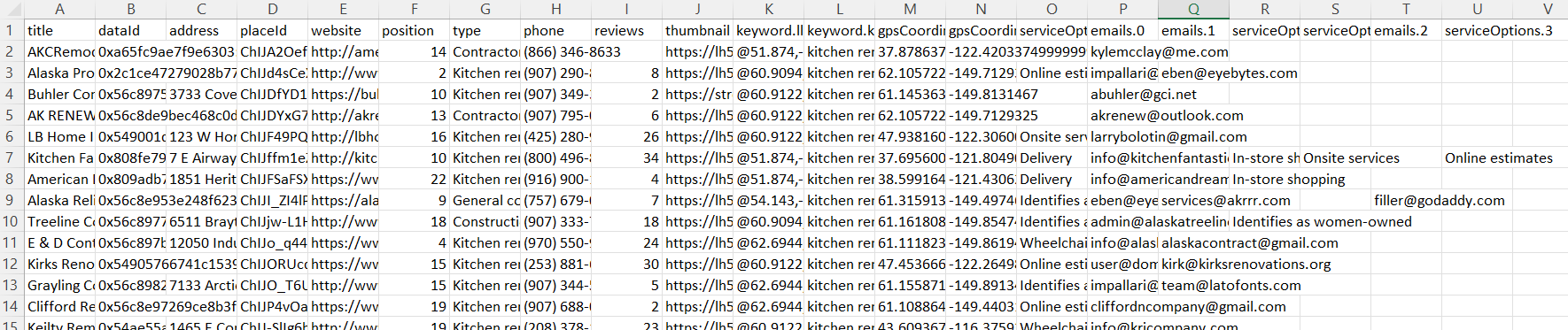

Sobald die Datenerfassung abgeschlossen ist, können Sie die Datendatei in einem praktischen Format herunterladen. CSV-Daten sehen beispielsweise etwa so aus:

Alle Parameter sind einfach einstellbar und intuitiv, eine detailliertere Beschreibung der Parameter finden Sie jedoch in unserem vorherigen Artikel.

Extrahieren von E-Mails mit Zapier und Web Scraping API

Einer der beliebtesten Integrationsdienste ist heute Zapier. Wir haben bereits ausführlich darüber geschrieben, was es ist und wie man es nutzt, daher werden wir nicht im Detail auf die Vor- und Nachteile und Prinzipien der Arbeit mit diesem Dienst eingehen. Lassen Sie uns den Algorithmus für den zukünftigen Zap zusammenstellen und mit seiner Implementierung fortfahren:

- Holen Sie sich das Schlüsselwort aus Google Sheets, das für die Suche nach Zielwebsites zum weiteren Crawlen verwendet wird. Sie können diesen Schritt beispielsweise so ändern, dass Sie einen Link erhalten, und dann direkt mit Schritt 3 fortfahren. Dies kann geeignet sein, wenn Sie bereits über eine Liste von Websites verfügen, von denen Sie E-Mail-Adressen sammeln müssen.

- Sammeln Sie mithilfe der Scrape-It.Cloud SERP-API Links zu Websites nach Schlüsselwörtern.

- Durchsuchen Sie die Websites, für die Links erhalten wurden, und extrahieren Sie E-Mails von jeder Website mithilfe der Web-Scraping-API.

- Tragen Sie die erhaltenen Daten in ein anderes Blatt der Tabelle ein.

Wie Sie dem Algorithmus entnehmen können, werden wir verschiedene Scrape-It.Cloud-APIs verwenden, um den Prozess des Scrapings von Daten zu vereinfachen. Um sie zu nutzen, müssen Sie sich lediglich auf der Website anmelden und einen API-Schlüssel in Ihrem Konto erhalten.

Zur Vereinfachung können wir dies in zwei separate Zaps aufteilen. Der erste erfasst eine Liste von Websites für ein bestimmtes Schlüsselwort von Google SERP. Der zweite Zap crawlt die bereits gesammelten Websites und extrahiert ihre E-Mail-Adressen. Wenn Sie bereits über eine Liste der benötigten Websites verfügen, können Sie zum zweiten Zap springen.

Scrape-Liste der Websites

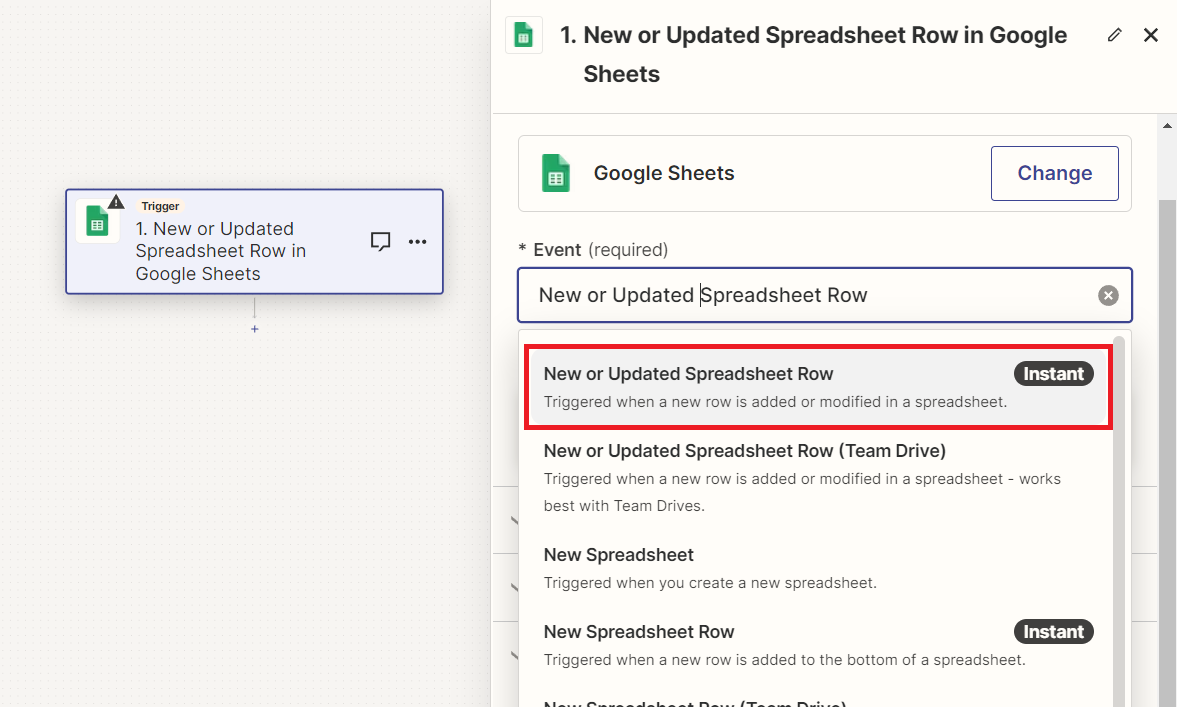

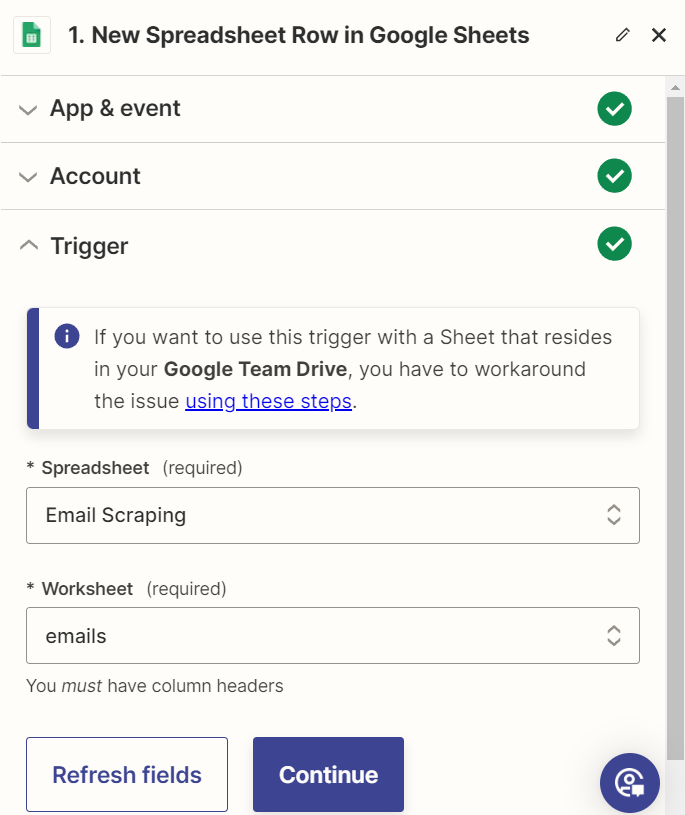

Kehren wir nun zu Zapier zurück und erstellen einen neuen Zap. Als Auslöser verwenden wir das Hinzufügen oder Aktualisieren einer Zeile in Google Sheets.

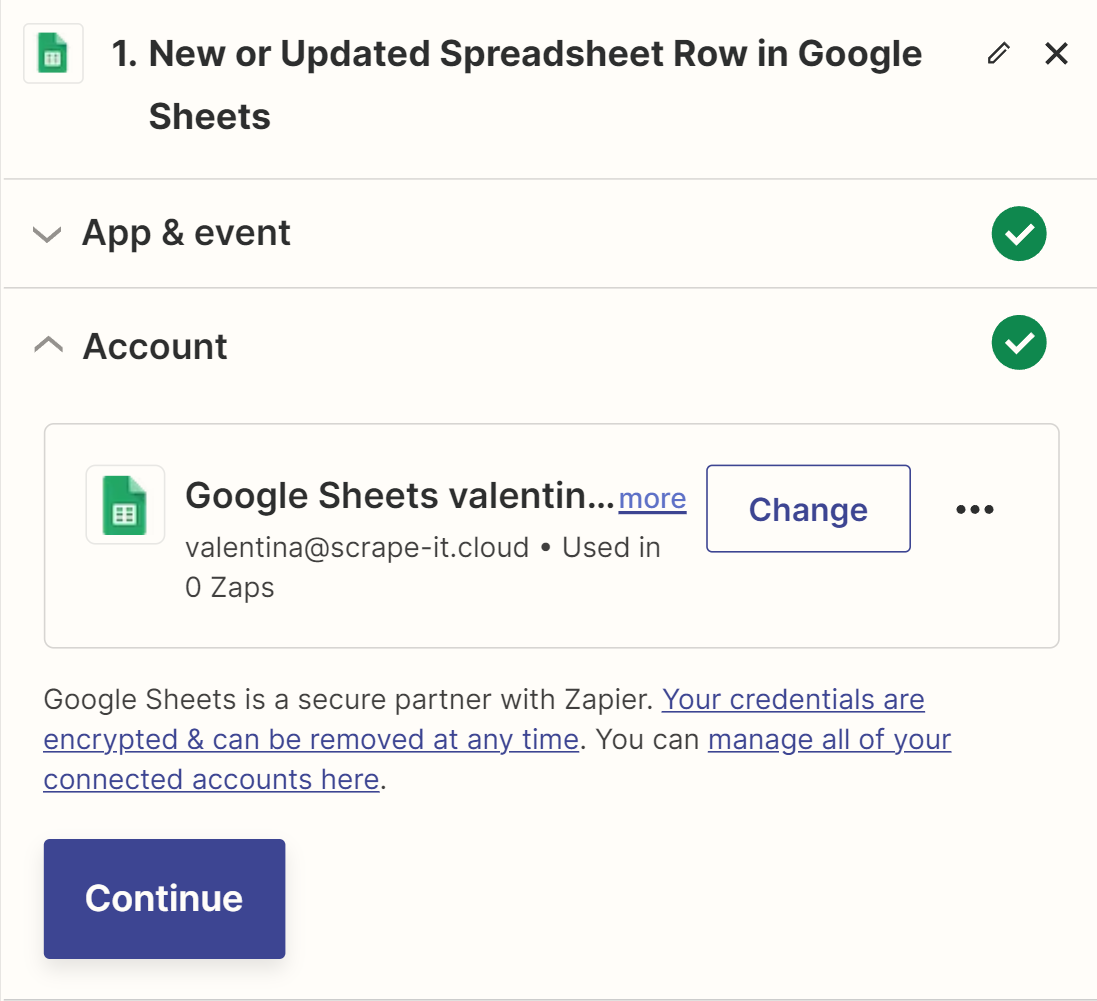

Melden Sie sich als Nächstes bei Ihrem Google-Konto an, das ein Dokument mit einer Tabelle zum Speichern der Daten enthält.

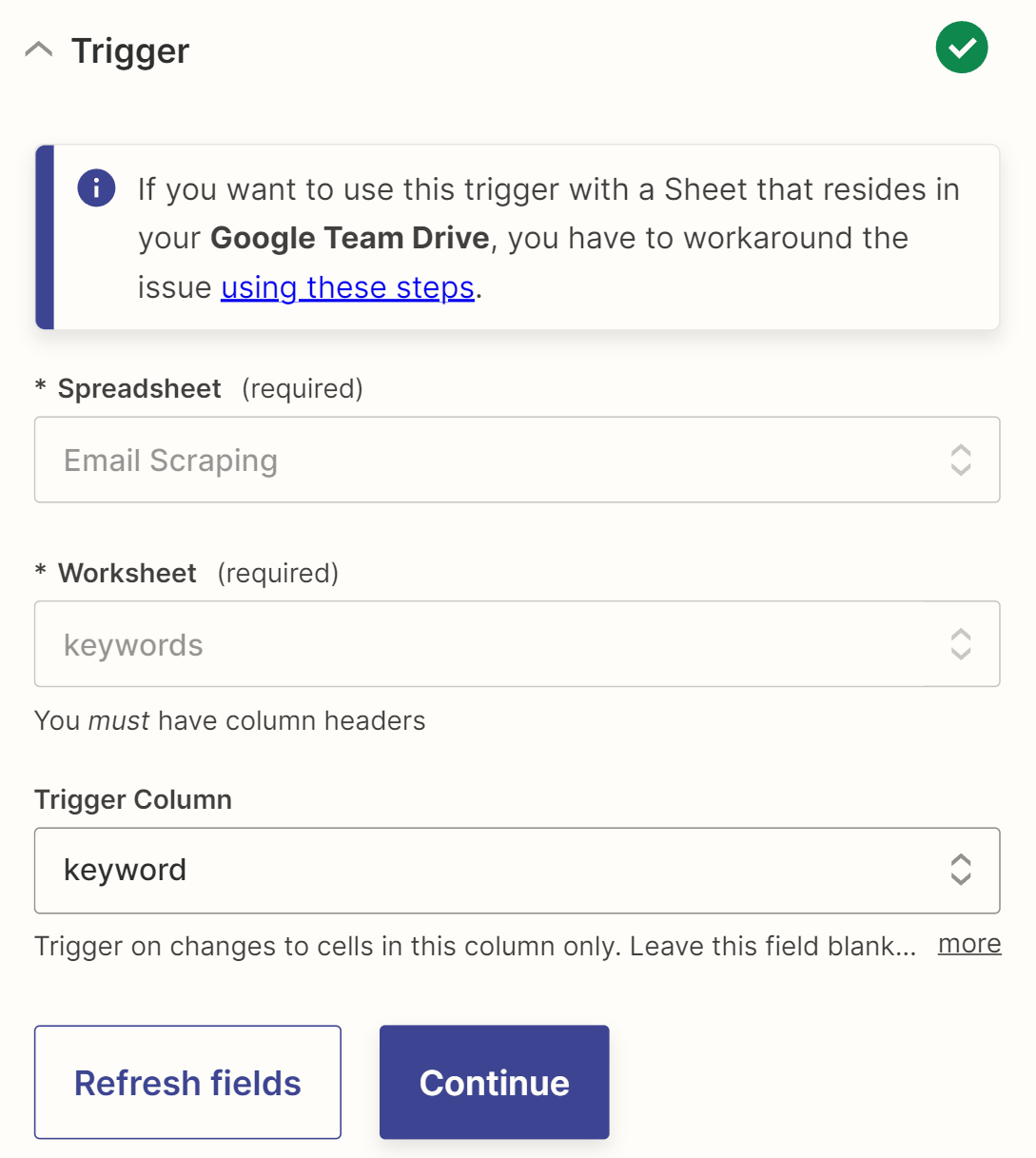

Erstellen Sie eine Google Sheet-Datei mit zwei Blättern: Schlüsselwörter (mit einer Schlüsselwortspalte, in der Sie Schlüsselwörter für die Suche nach Zielwebsites aufzeichnen) und eine E-Mail-Liste (mit Link-, Titel- und E-Mail-Spalten zum Speichern von Website- und E-Mail-Daten). Verbinden Sie dann dieses Blatt als Auslöser und markieren Sie die Spalte, in der die Schlüsselwörter gespeichert werden, als Tracking-Spalte.

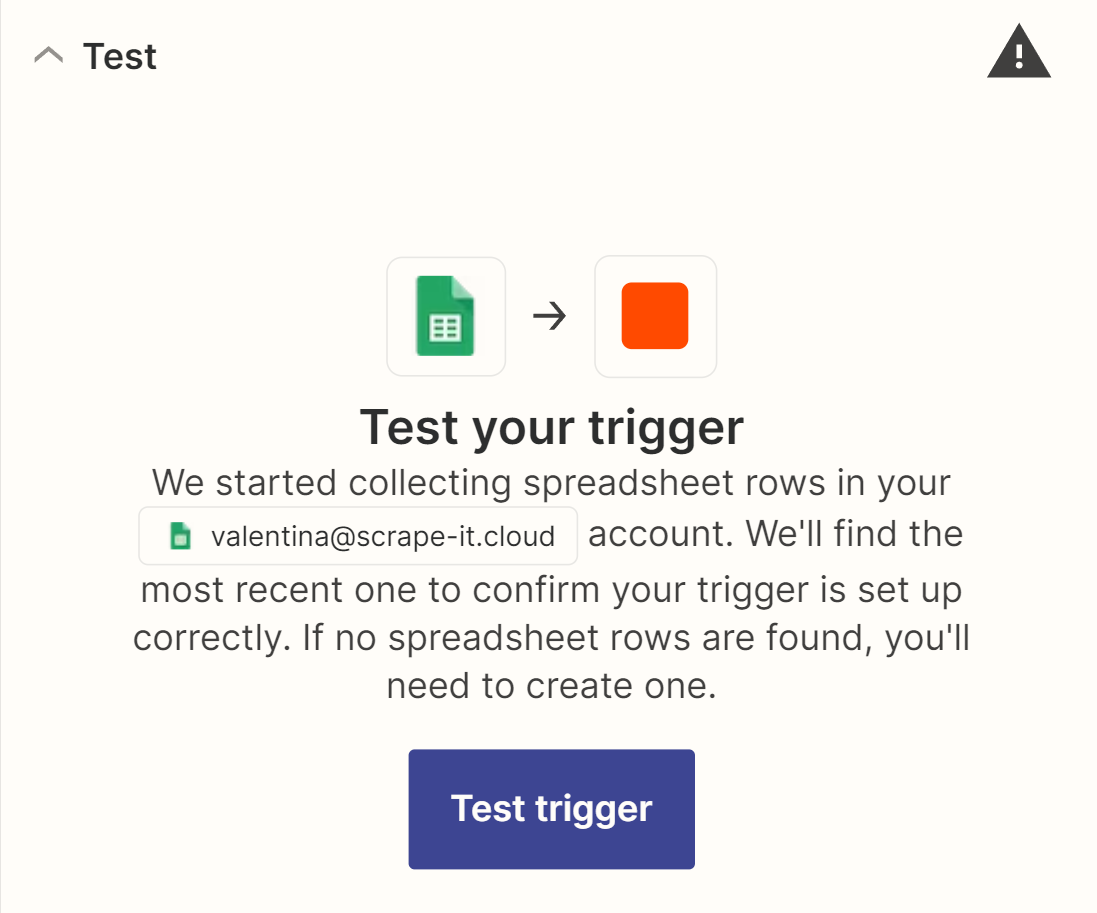

Bevor Sie mit dem nächsten Schritt fortfahren, stellen Sie sicher, dass der Auslöser ordnungsgemäß funktioniert.

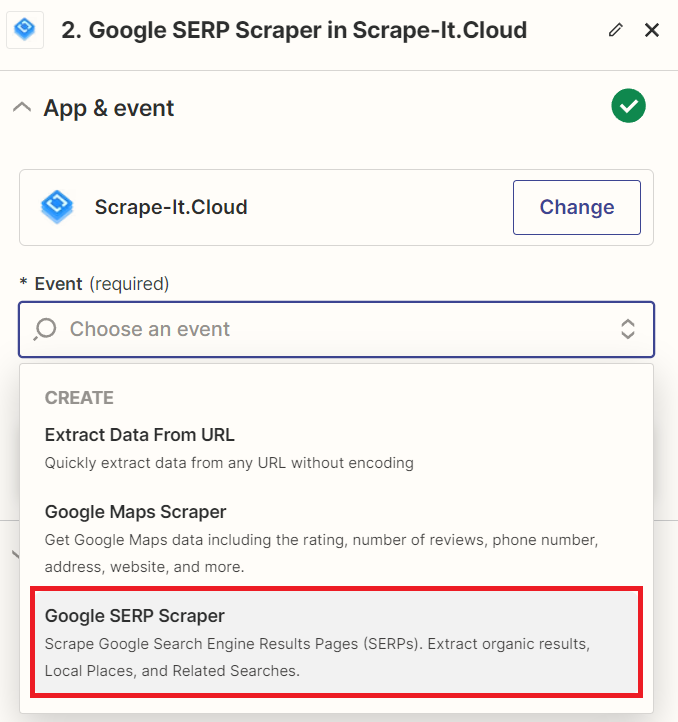

Fügen Sie dazu Daten zur Schlüsselwortspalte hinzu und führen Sie den Triggertest durch. Wenn die Daten gefunden und abgerufen werden, funktioniert der Trigger ordnungsgemäß. Anschließend können Sie mit der nächsten Aktion fortfahren. Suchen Sie dazu die Scrape-It.Cloud-Integration und wählen Sie die Google SERP-Aktion aus.

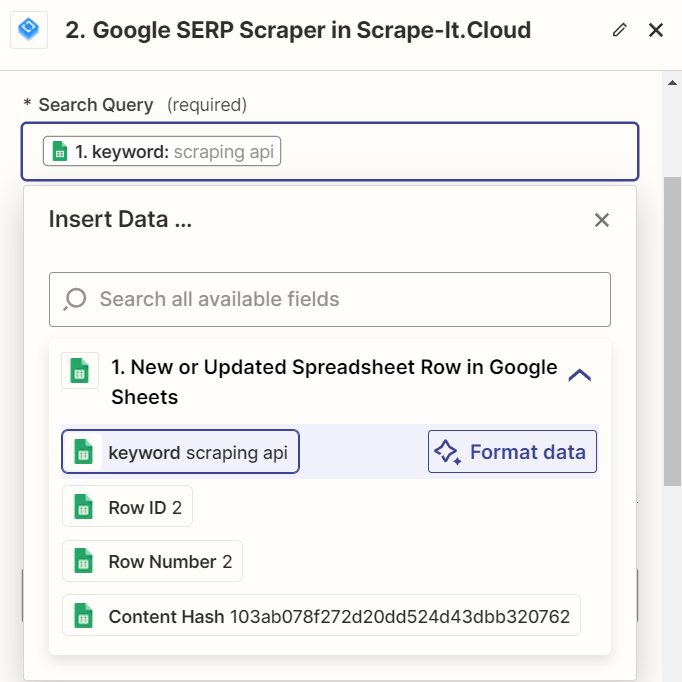

Um Ihr Scrape-It.Cloud-Konto zu verbinden, melden Sie sich mit Ihrem API-Schlüssel an und gehen Sie zur Einstellungsseite. Geben Sie im Feld „Suchanfrage“ die Schlüsselwörter aus der Tabelle ein. Sie können die restlichen Parameter, einschließlich Sprach- und Standorteinstellungen, nach Bedarf anpassen. Weitere Informationen zu allen verfügbaren Parametern finden Sie in der offiziellen Dokumentation.

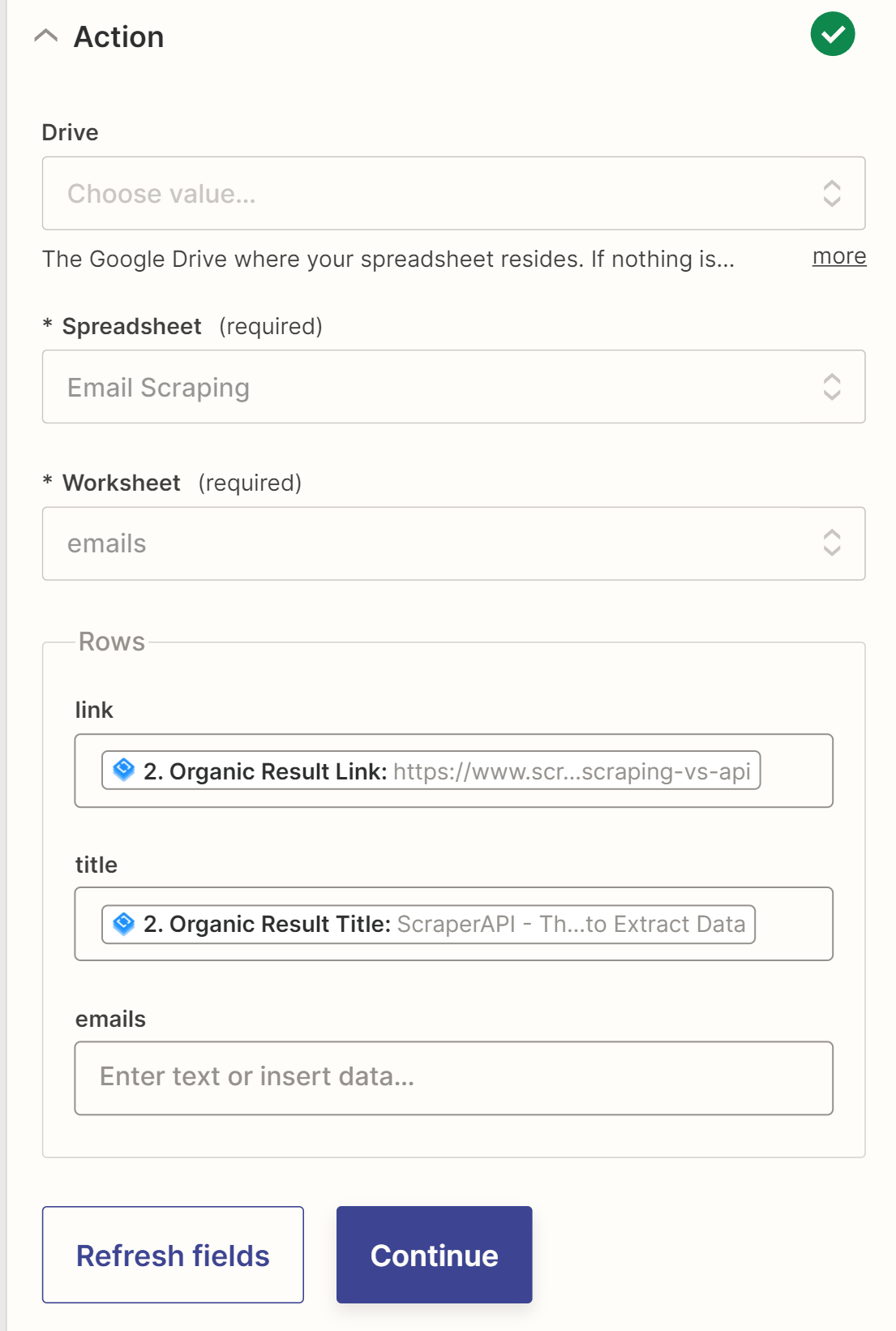

Bevor Sie mit dem nächsten Schritt fortfahren, überprüfen Sie die Funktionalität der Aktion. Der letzte Schritt in diesem Zap besteht darin, die Daten in einem separaten Blatt im selben Google Sheet zu speichern.

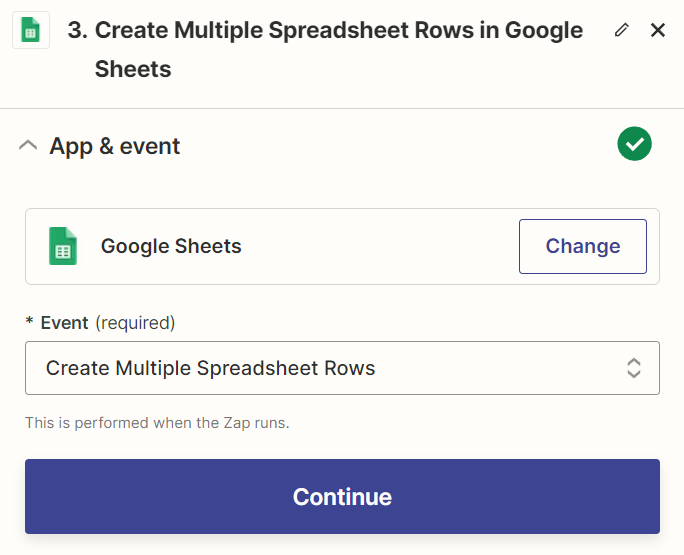

Zapier unterstützt keine Schleifen, die wir benötigen, daher können wir die Daten nicht sofort verarbeiten. Stattdessen speichern wir die Links und Website-Namen in einem neuen Blatt und verarbeiten sie in einem nachfolgenden Zap.

Speichern wir den Zap, den wir gerade erstellt haben, und erstellen wir einen neuen.

Entfernen Sie E-Mails von Websites

Zunächst fügen wir einen Auslöser hinzu, der unseren Zap aktiviert. In unserem Fall müssen wir das Erscheinen neuer Zeilen in einem Google Sheet verfolgen und sie dann verarbeiten.

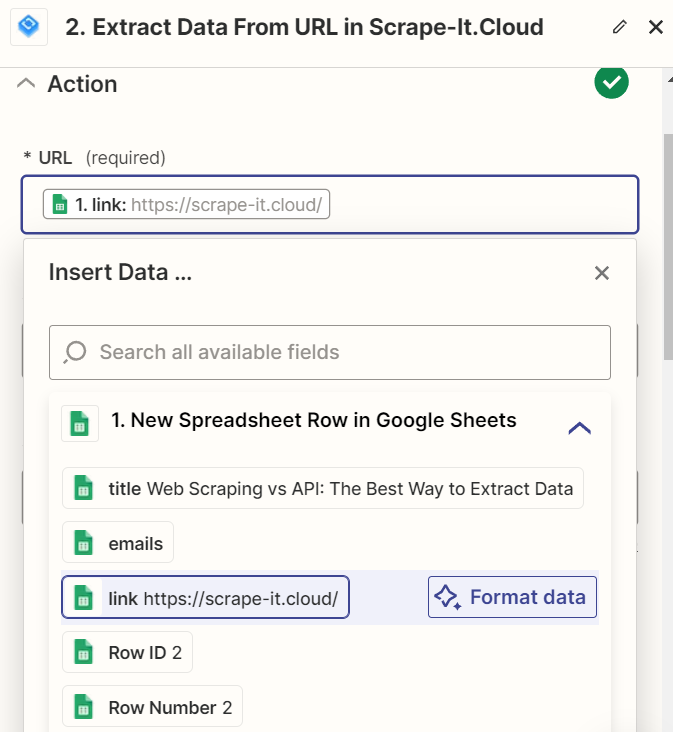

Nachdem wir eine neue Zeile in der E-Mail-Tabelle erkannt haben, rufen wir daher die Aktion „Scrape-It.Cloud“ auf. Wir müssen mithilfe der URL Daten von der Website extrahieren, um mithilfe der zuvor gesammelten Links E-Mail-Adressen von der Website abzurufen.

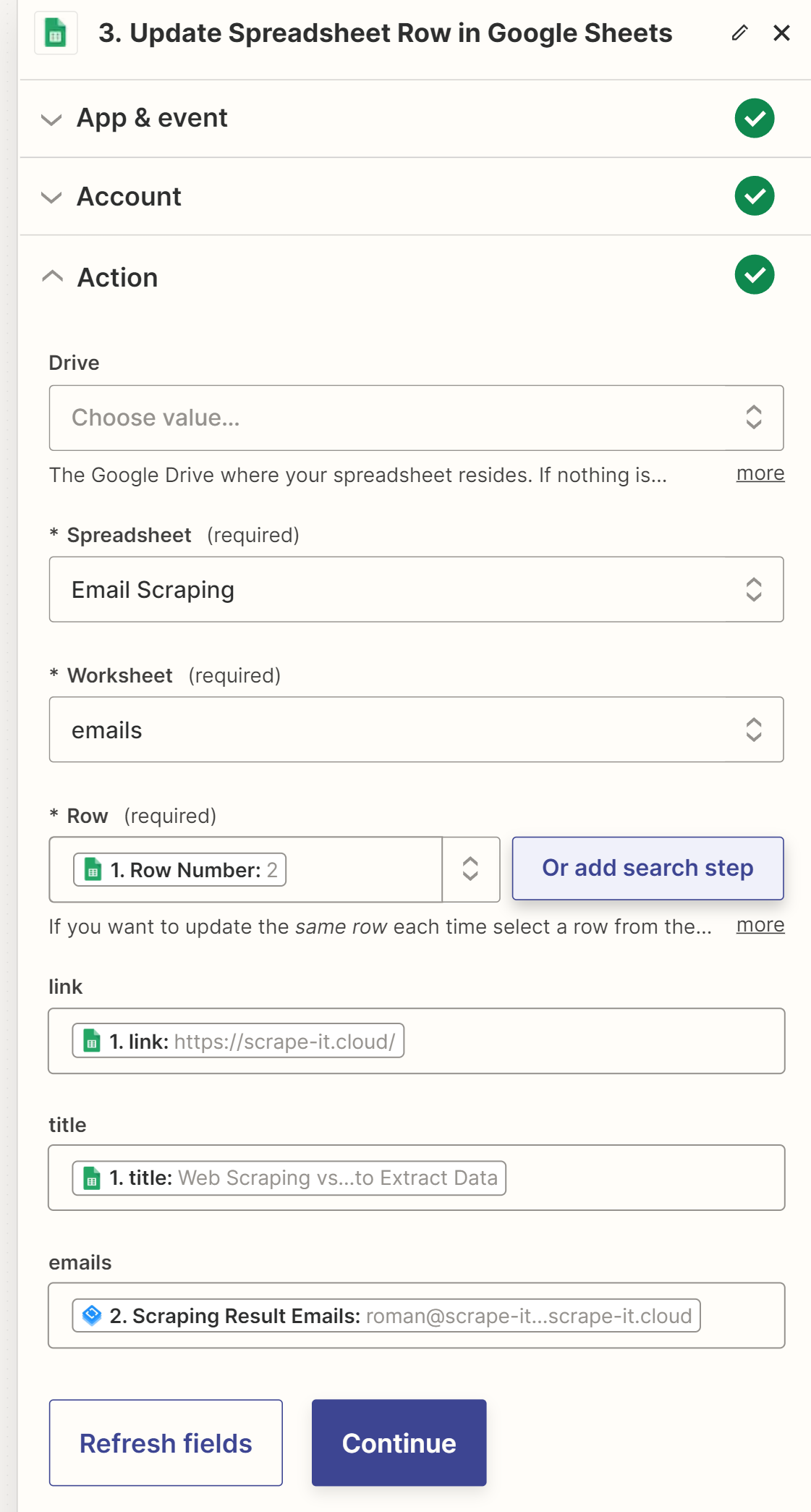

Um den Vorgang abzuschließen, sollten wir die Tabellenzeile aktualisieren, die wir im Trigger erhalten haben. Die Zeilennummer wird als Parameter an den Trigger übergeben. Wir können es verwenden, um die zu aktualisierende Zeile zu identifizieren. Legen Sie die Werte für alle Zellen in der Zeile fest, einschließlich der gesammelten E-Mails.

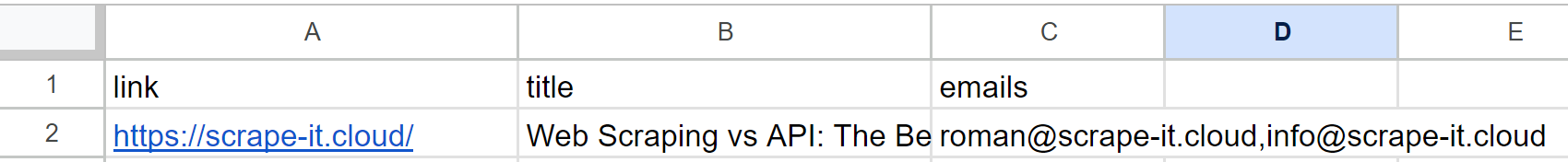

Nach dem Test enthält die ursprünglich von uns erstellte Tabelle aktualisierte Daten:

Wie bereits erwähnt, müssen Sie nicht den ersten Zap verwenden. Sie können eine Liste von Websites, die Sie auf andere Weise erhalten haben, verwenden. Darüber hinaus können Sie den Zap nach Bedarf weiter anpassen, um zusätzliche Informationen zu speichern oder die E-Mail-Zustellung an die gesammelten E-Mail-Adressen mithilfe der Gmail-Integration einzurichten.

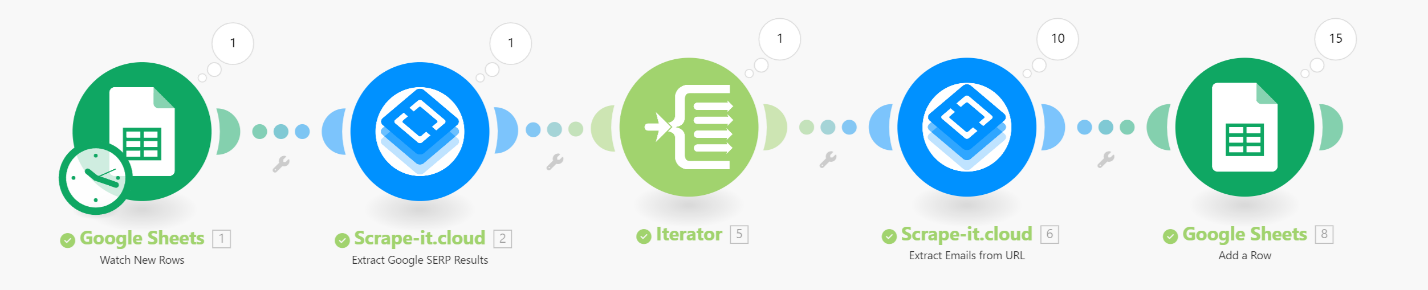

Ein weiterer beliebter Integrationsdienst ist Make.com, früher bekannt als Integromat. Daher verwenden wir jetzt denselben Algorithmus wie im vorherigen Beispiel, implementieren ihn jedoch mithilfe des Make.com-Dienstes. Darüber hinaus unterstützt es ein breiteres Spektrum an Datenverarbeitungsfunktionen und wir werden in der Lage sein, alle empfangenen Links in einem einzigen Szenario zu verarbeiten.

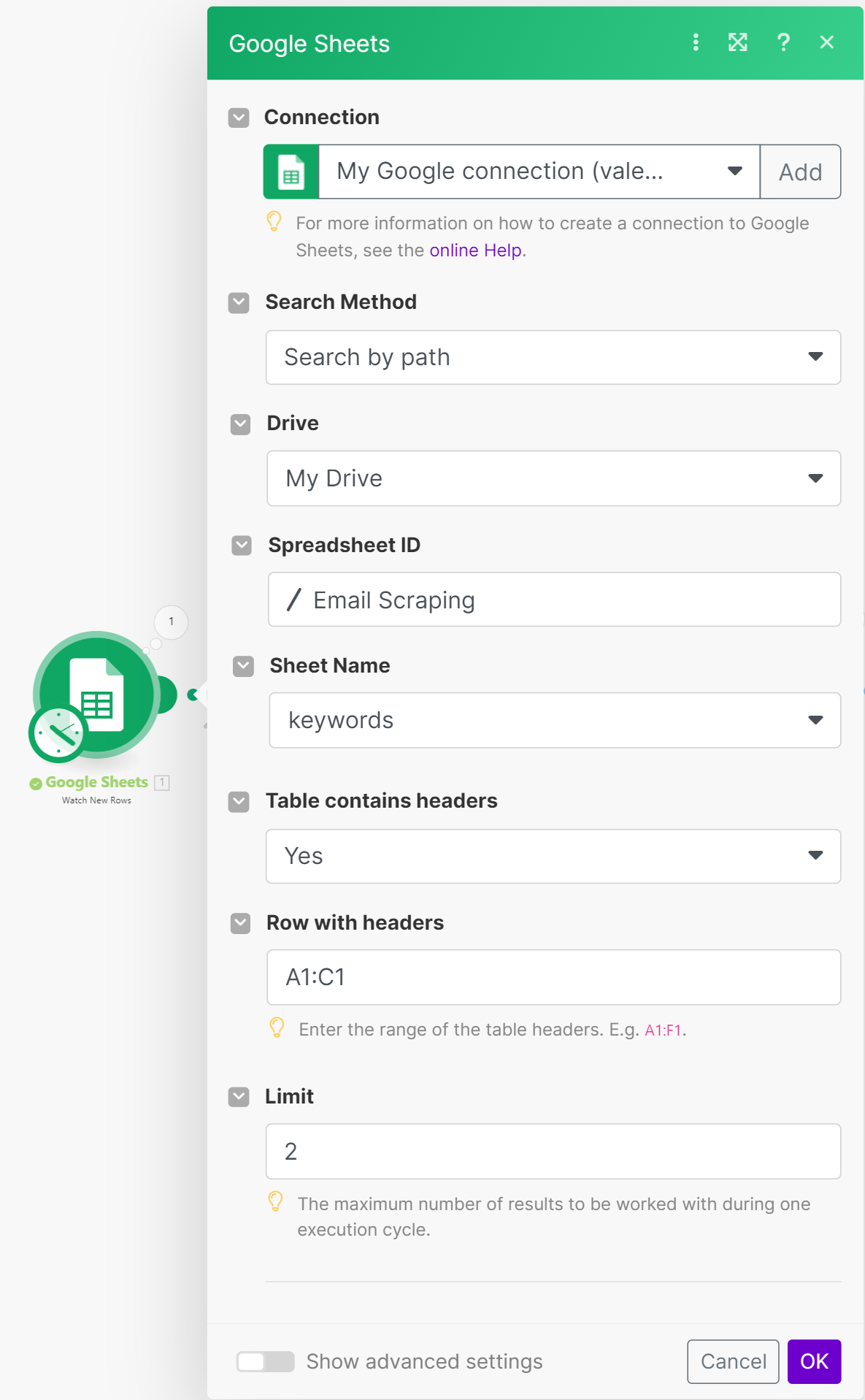

Melden Sie sich zunächst an und erstellen Sie ein neues Szenario. Der erste Schritt besteht darin, neue Zeilen aus der Google Sheets-Tabelle abzurufen, die eine Liste von Schlüsselwörtern enthalten, nach denen wir nach Websites suchen. Wählen Sie dazu eine neue Aktion aus und suchen Sie nach den Google Sheets-Integrationen und der Methode zum Suchen nach neuen Zeilen. Wir verwenden dieselbe Tabelle wie im vorherigen Beispiel.

Passen Sie die Zeilenbegrenzung nach Ihren Wünschen an. Wenn Sie bereits Website-Links haben, können Sie zum Abschnitt zur Linkverarbeitung springen.

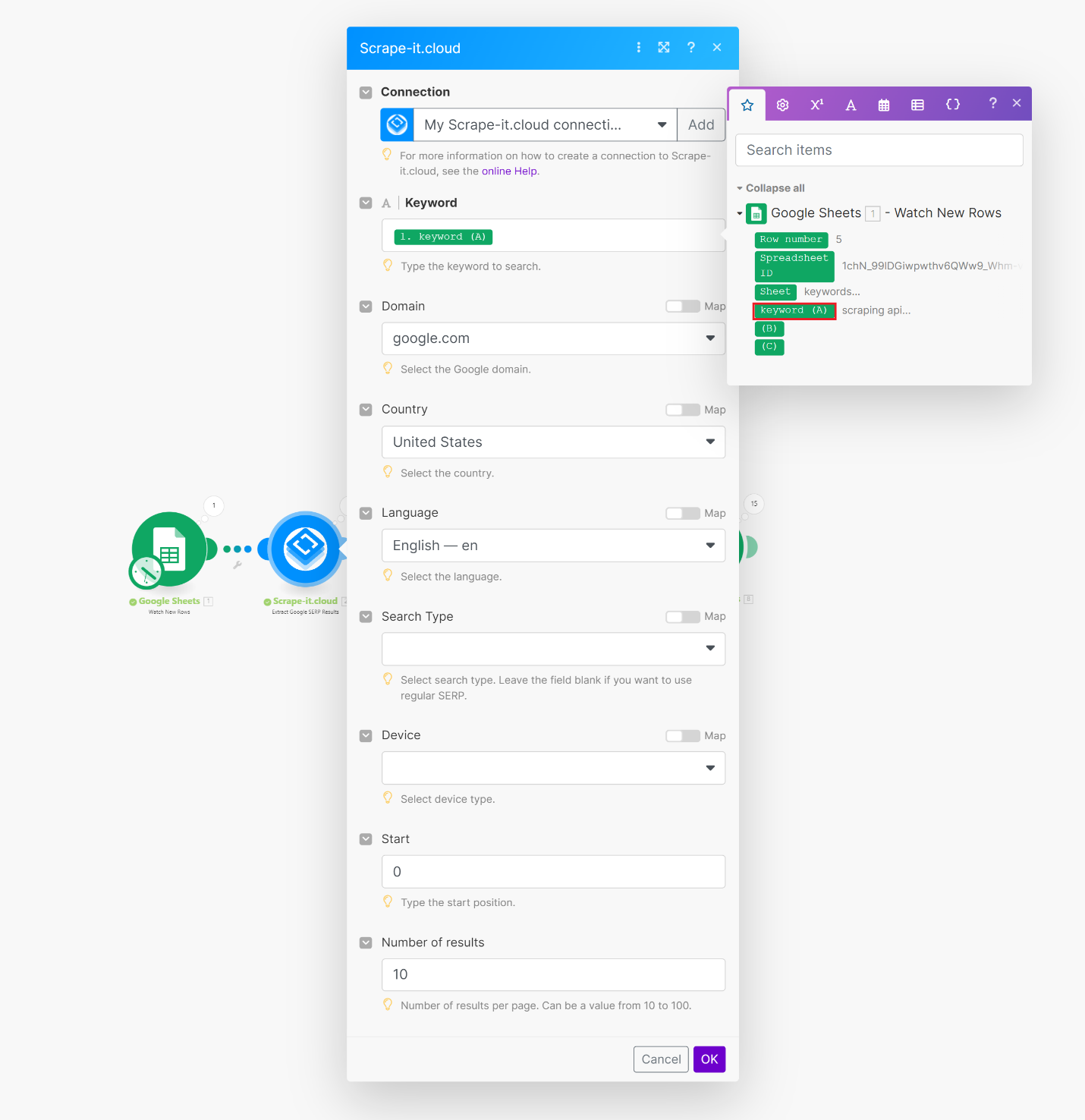

Fügen Sie die folgende Aktion hinzu und suchen Sie die Scrape-It.Cloud-Integration. Wir benötigen die Methode zum Extrahieren von Daten aus Google SERP-Ergebnissen. Geben Sie im Feld Schlüsselwort den Wert aus dem vorherigen Schritt ein. Sie können auch die Sprache, die Anzahl der Ergebnisse und die Lokalisierung anpassen.

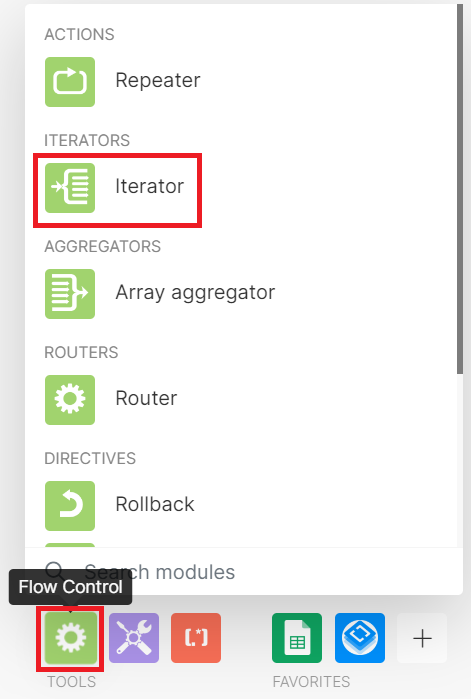

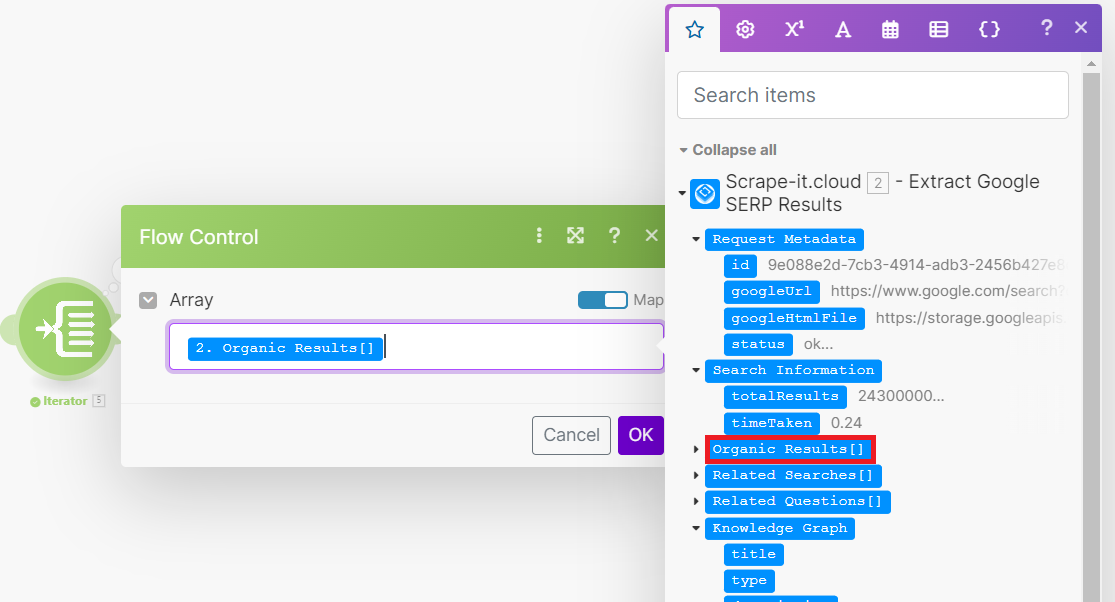

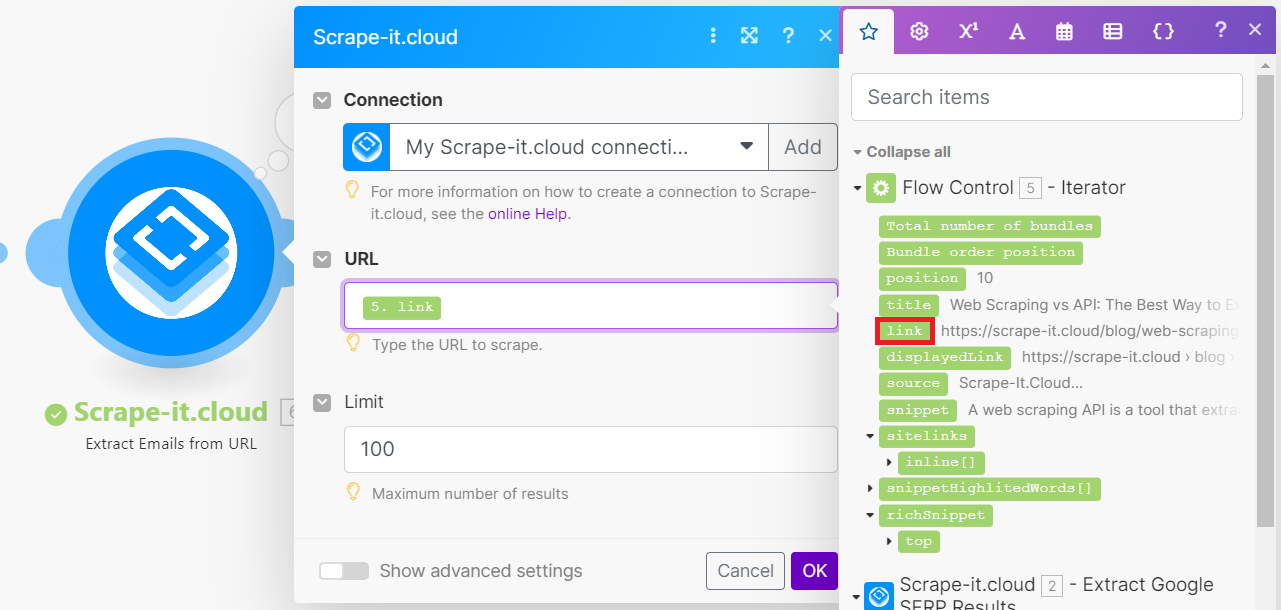

Da wir nun eine Liste von Websites aus den Suchergebnissen haben, müssen wir sie alle durchgehen und von jeder die E-Mail-Adresse des Unternehmens erfassen. Dazu verwenden wir einen Iterator, der im App Flow-Menü am unteren Bildschirmrand zu finden ist.

Ein Iterator ist ein Objekt, mit dem Sie nacheinander auf jedes Element einer Datenstruktur zugreifen und es verarbeiten können. Mit anderen Worten: Es funktioniert wie eine Schleife in der Programmierung. Für unsere Aufgabe müssen wir nur die organischen Ergebnisse verarbeiten. Die anderen von der Google SERP API zurückgegebenen Daten sind nicht erforderlich.

Lassen Sie uns nun eine andere Scrape-It.Cloud-Methode verwenden: das Abrufen einer Liste von E-Mail-Adressen von einer Website-URL. Dazu übergeben wir den Link von der aktuellen Iteration an die E-Mail-Scraping-Methode.

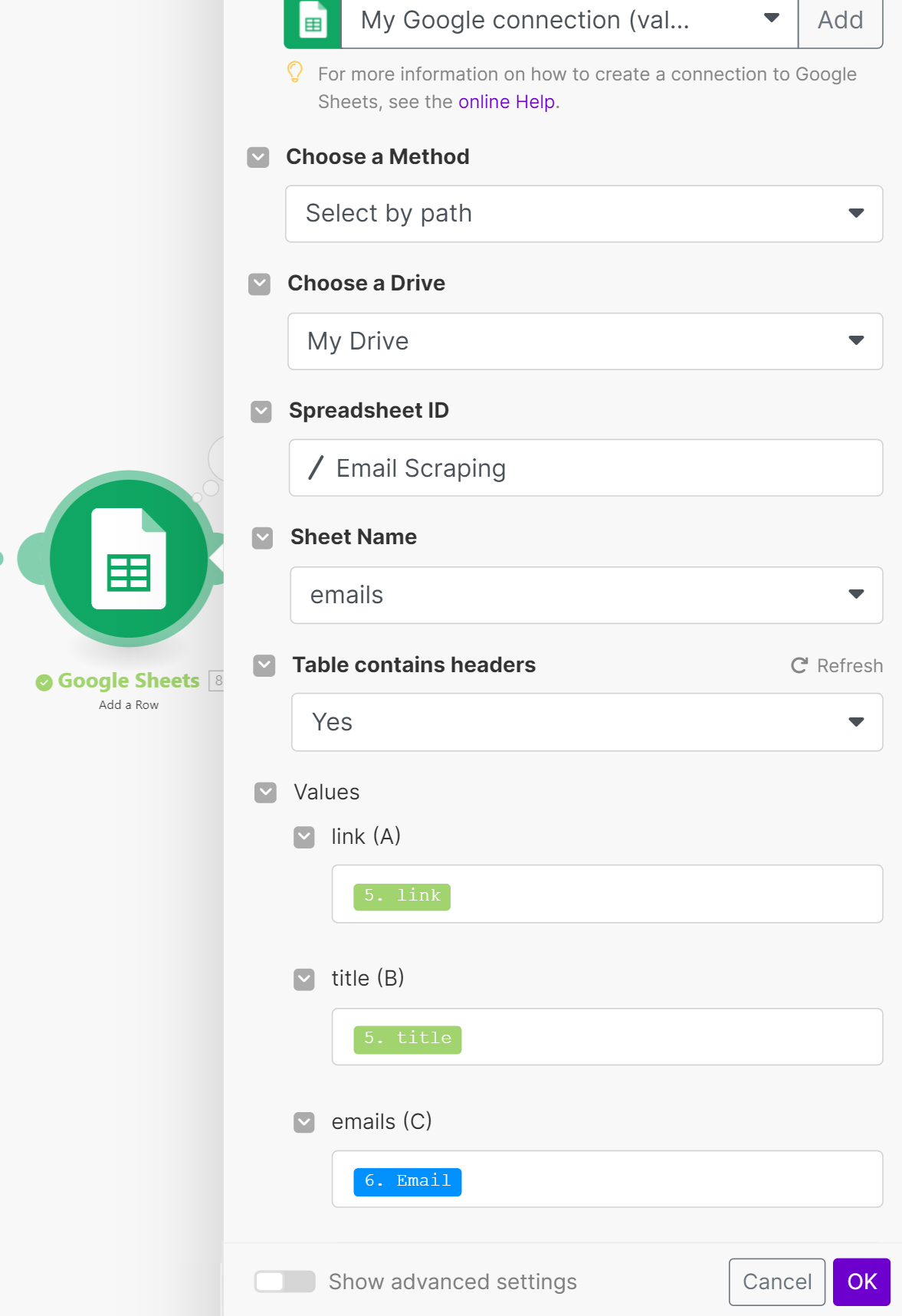

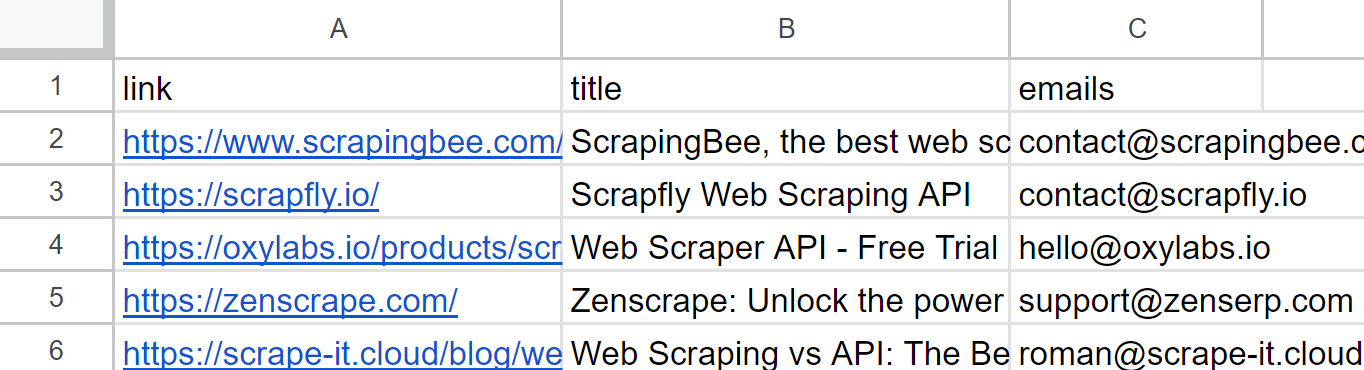

Der letzte Schritt besteht darin, alle gesammelten Daten in Google Sheets zu importieren. Bei Bedarf können Sie die gesammelten Daten mithilfe einer Reverse-Iterator-Funktion, einem Array-Aggregator, vorgruppieren. Alternativ können Sie auch einfach alle Daten in ein Blatt mit E-Mail-Adressen importieren.

Lassen Sie uns das resultierende Szenario ausführen und uns das Ergebnis ansehen.

Überprüfen Sie nach Abschluss der Aufgabe die Google Sheets-Tabelle:

Basierend auf unserer Erfahrung bietet Make.com ein breiteres Spektrum an Datenverarbeitungsfunktionen als Zapier, einschließlich der Möglichkeit, mit Arrays und Variablen zu arbeiten. Dies macht Make.com zu einer besseren Wahl für Benutzer, die komplexe Datenverarbeitungsaufgaben ausführen müssen.

Python-basiertes E-Mail-Scraping

Nachdem wir nun den Algorithmus zum Erstellen eines solchen Skripts analysiert haben, implementieren wir eine ähnliche Version, jedoch völlig unabhängig, ohne Integrationsdienste zu verwenden. Wir verwenden Python, weil es eine der einfachsten und beliebtesten Programmiersprachen für Scraping ist.

Um den Scraping-Prozess zu vereinfachen, verwenden wir auch die Scrape-It.Cloud-APIs, da uns die Verarbeitung der von uns erfassten Daten wichtiger ist als die Art und Weise, wie wir sie erfassen. Sie können die Skripte jedoch selbst ändern, um Daten unabhängig zu sammeln, ohne die API zu verwenden. Zuvor haben wir darüber geschrieben, wie man jede Website in Python kratzt und wie man Google SERP in Python kratzt.

Wir stellen Ihnen das endgültige Skript in Colab Research zur Verfügung. Wenn Sie verwirrt sind oder Probleme haben, können Sie einfach unsere endgültige Version kopieren. Beginnen wir also mit dem Schreiben des Drehbuchs. Importieren Sie zunächst die Bibliotheken, die wir verwenden, um Anfragen zu stellen, mit JSON-Antworten zu arbeiten und Daten zu verarbeiten bzw. zu speichern:

import requests

import json

import pandas as pdAls nächstes deklarieren wir Variablen, um sich ändernde oder mehrfach verwendete Parameter zu speichern, wie zum Beispiel den Scrape-It.Cloud-API-Schlüssel oder das Schlüsselwort für die Suche nach relevanten Websites in Google SERP.

api_key = 'YOUR-API-KEY

keyword = 'scraping api'Passen Sie den Text und die Header zukünftiger Anfragen an. Sie können die Sprache oder Lokalisierung und mehr ändern. Eine vollständige Liste der verfügbaren Parameter finden Sie in der offiziellen Dokumentation.

params_serp = {

'q': keyword,

'filter': 1,

'domain': 'google.com',

'gl': 'us',

'hl': 'en',

'deviceType': 'desktop'

}

url_serp = "https://api.scrape-it.cloud/scrape/google"

url_scrape = "https://api.scrape-it.cloud/scrape"

headers_serp = {'x-api-key': api_key}

headers_scrape = {

'x-api-key': api_key,

'Content-Type': 'application/json'

}Stellen Sie eine Anfrage an die Google SERP API und analysieren Sie die JSON-Antwort zur weiteren Verarbeitung.

response_serp = requests.get(url_serp, params=params_serp, headers=headers_serp)

data_serp = response_serp.json()Extrahieren Sie Links aus der empfangenen JSON-Antwort.

links = (result('link') for result in data_serp.get('organicResults', ()))Erstellen Sie eine Variable zum Speichern der Link-E-Mail-Adressenzuordnungen und erstellen Sie eine Schleife, um alle empfangenen Links zu durchlaufen.

data = ()

for link in links:Erstellen Sie einen Anforderungstext für eine Web Scraping API, um E-Mail-Adressen aus dem aktuellen Link zu extrahieren.

payload_scrape = json.dumps({

"url": link,

"js_rendering": True,

"extract_emails": True

})Stellen Sie eine API-Anfrage und analysieren Sie die JSON-Antwort.

response_scrape = requests.post(url_scrape, headers=headers_scrape, data=payload_scrape)

json_response_scrape = response_scrape.json()Extrahieren Sie die E-Mails aus der Antwort und fügen Sie sie den zuvor erstellten variablen Daten hinzu.

emails = json_response_scrape.get("scrapingResult", {}).get("emails", ())

data.append({"link": link, "emails": emails})Erstellen Sie abschließend einen DataFrame aus den gesammelten Daten und speichern Sie ihn in einer CSV-Datei.

df = pd.DataFrame(data)

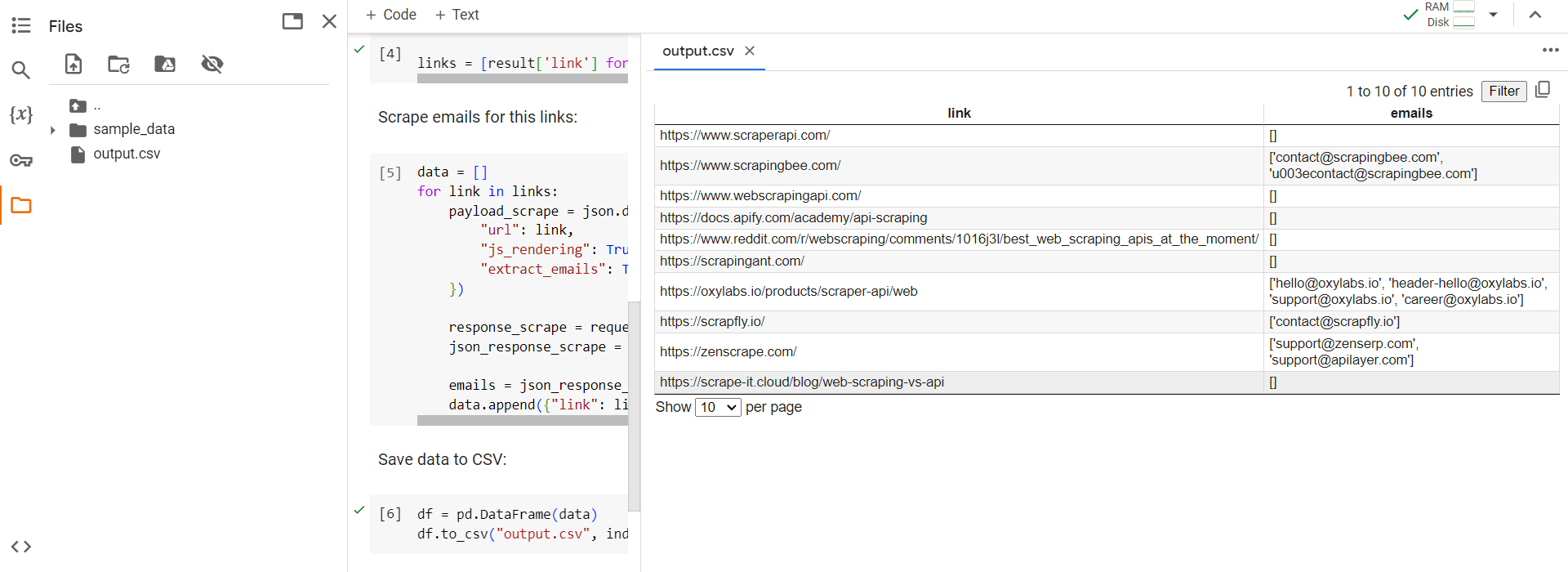

df.to_csv("output.csv", index=False)Um das Skript zu testen, führen wir es direkt in Colab Research aus und überprüfen die generierte Ausgabedatei.

Wie Sie dem Beispiel entnehmen können, sammelt das Skript alle verfügbaren E-Mails und speichert sie in einer praktischen CSV- oder Excel-Datei. Sie können das Skript weiterentwickeln, um beispielsweise Ihre Datei mit einer Liste von Links zu Websites zu verwenden, von denen Sie E-Mail-Adressen extrahieren müssen, anstatt in Google SERP nach Websites zu suchen.

Best Practices für E-Mail-Scraping

Um das E-Mail-Scraping produktiver zu gestalten, ist es wichtig, einige Regeln und Empfehlungen zu befolgen. Einige dieser Empfehlungen dienen der Verbesserung der Scraping-Qualität, z. B. der Verwendung von Proxys, CAPTCHA-Lösern oder dedizierten Scraping-Diensten oder APIs. Andere Empfehlungen beziehen sich speziell auf die effektive E-Mail-Sammlung, die Ihnen dabei helfen kann, mehr und qualitativ hochwertigere E-Mail-Adressen von Unternehmen und Privatpersonen zu sammeln.

Hier sind einige konkrete Empfehlungen für eine effektive E-Mail-Sammlung:

- Führen Sie Datenqualitätsprüfungen durch. Filtern und bereinigen Sie die Daten nach dem Sammeln sorgfältig, um ungültige oder veraltete E-Mail-Adressen zu entfernen. Sie können einen speziellen E-Mail-Validierungsdienst verwenden, um E-Mail-Adressen zu überprüfen, bevor Sie sie Ihrer Datenbank oder Datei hinzufügen.

- Legen Sie ein Limit für die Anzahl der Anfragen fest. Begrenzen Sie die Anzahl Ihrer Anfragen an Websites, um eine Blockierung oder eine Überlastung der Server zu vermeiden. Sie können Verzögerungen zwischen Anfragen nutzen, um Ihre Last zu reduzieren.

- Erwägen Sie die Implementierung einer Datensicherung. Erstellen Sie Backups Ihrer gesammelten Daten, um sicherzustellen, dass diese nicht verloren gehen.

- Aktualisieren Sie Ihre Daten regelmäßig. Aktualisieren Sie Ihre erfassten Daten regelmäßig, um die Verwendung veralteter Adressen zu vermeiden. Dies ist besonders wichtig, wenn Sie die Daten für E-Mail-Marketingkampagnen und zur Verkaufsförderung verwenden.

Darüber hinaus ist es wichtig zu beachten, dass es beim Sammeln von E-Mail-Adressen am besten ist, zuverlässige Quellen zu nutzen, die Benutzer explizit angegeben haben. Für einzelne Nutzer können dies auch Social-Media-Plattformen wie LinkedIn sein. Für Unternehmen ist es am besten, Daten von den Kontaktseiten oder Homepages ihrer Website zu extrahieren.

Die Rechtmäßigkeit des E-Mail-Scrapings

In den meisten Fällen ist das Sammeln von E-Mail-Adressen aus öffentlichen Datenquellen für persönliche Zwecke, mit Ausnahme der Weitergabe von Daten an Dritte, rechtmäßig. Beispielsweise ist das Sammeln von Kontaktinformationen von Unternehmen aus öffentlichen Informationsquellen zu Forschungszwecken legal, sofern dies nicht im Widerspruch zu den Unternehmensrichtlinien steht.

Etwas komplizierter ist es jedoch bei den E-Mail-Adressen einzelner Nutzer, da diese nicht ohne die ausdrückliche Einwilligung des Nutzers verwendet werden dürfen. Beispielsweise ist die Einhaltung der DSGVO (Datenschutz-Grundverordnung) besonders wichtig, wenn mit den Daten europäischer Bürger gearbeitet wird.

Um zukünftige Probleme zu vermeiden, machen Sie sich vor der Datenerfassung mit den Richtlinien der Website vertraut und befolgen Sie deren Regeln. Stellen Sie außerdem sicher, dass Ihre Verwendung der Daten ihrem ursprünglichen Zweck entspricht und nicht gegen das Gesetz verstößt.

Abschluss

In diesem Artikel haben wir verschiedene Möglichkeiten zum Sammeln von E-Mail-Adressen untersucht, die sowohl für diejenigen geeignet sind, die nicht sehr gut im Programmieren sind, als auch für diejenigen, die ihr eigenes Skript erstellen und verwenden möchten. Darüber hinaus haben wir uns Beispiele für die Erstellung von Skripten zur Datenerfassung auf zwei beliebten Integrationsplattformen, Zapier und Make.com, angesehen.

Zusätzlich zu den praktischen Beispielen, die wir bereitgestellt haben, haben wir auch Empfehlungen gegeben, die Ihnen dabei helfen können, die Automatisierung Ihrer E-Mail-Adresserfassung in Zukunft weiterzuentwickeln. Die Erkenntnisse aus dem Abschnitt zur Legalität helfen Ihnen dabei, die erforderlichen Daten zu sammeln, ohne gegen Datenschutzbestimmungen zu verstoßen.