Periklanan berbayar (PPC) adalah bidang yang sangat kompetitif yang membutuhkan taktik cerdas agar berhasil. Seiring dengan semakin matangnya saluran periklanan ini dan biaya iklan yang terus meningkat secara signifikan, kami semakin fokus pada data.

Mengikis data periklanan dapat membantu pemasar memahami pelanggan mereka dan bagaimana mereka berinteraksi dengan layanan mereka. Hal ini juga dapat membantu mereka memahami strategi pesaing dan menemukan celah yang hilang.

Pada artikel ini kami menyoroti hal itu Pengikisan web adalah pendekatan terukur untuk penelitian PPC, pencarian calon pembeli, dan analisis tren umum. Kami akan menunjukkan cara membuat pengikis data Google Ads sehingga Anda dapat bersaing secara online dengan aman - tanpa membebani tim (atau dompet Anda).

Daftar Isi

Mengapa mengekstrak data Google Ads?

Terkait iklan berbayar, mengetahui di mana dan bagaimana pesaing Anda muncul di hasil penelusuran Google adalah cara yang bagus untuk memengaruhi strategi Anda. Dengan menggunakan web scraper terlebih dahulu, Anda dapat mengekstrak data Google Ads dari jutaan penelusuran hanya dalam beberapa jam - sesuatu yang tidak mungkin dilakukan secara manual.

Anda kemudian dapat menggunakan data Google Ads yang dikumpulkan ini untuk meningkatkan strategi PPC Anda seperti yang tercantum di bawah.

Pahami posisi pemasaran pesaing Anda melalui judul dan deskripsi

Google Ads pada dasarnya adalah iklan teks. Mereka mengandalkan salinannya untuk menarik pengguna agar mengklik link tersebut. Dengan kata lain, pesaing Anda sangat menekankan kata-kata dalam judul dan deskripsi iklan mereka.

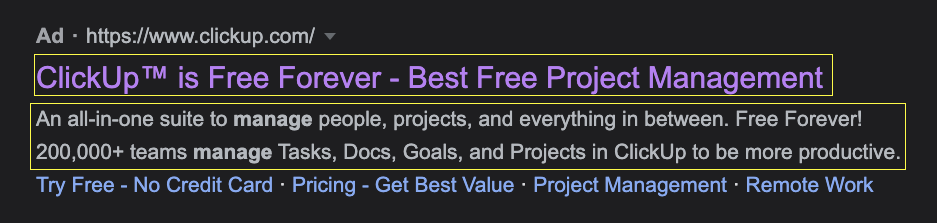

Misalnya, jika Anda mencari perangkat lunak manajemen proyek, Anda akan menemukan iklan ClickUp berikut:

Hanya dengan membaca salinannya, Anda dapat melihat bahwa ada banyak penekanan pada penawaran gratis mereka - bahkan menggunakan tautan situs untuk membangun "tanpa kartu kredit", yang memberi kita petunjuk tentang pesan promosi mereka.

Dengan menskalakan proses ekstraksi data ini ke semua kata kunci terkait, kini Anda dapat membuat database lengkap berisi judul dan deskripsi iklan pesaing Anda untuk setiap kata kunci yang relevan. Gunakan untuk membuat peta yang jelas yang memungkinkan Anda untuk:

- Bedakan penawaran dan solusi Anda dari pesaing dengan menunjukkan merek unik dan USP Anda melalui teks.

- Tingkatkan penawaran pesaing untuk menarik klik dari calon pelanggan

- Identifikasi kata kunci yang relevan dengan teks iklan lemah yang dapat meyakinkan Anda

Dapatkan gambaran umum tentang biaya PPC pesaing Anda berdasarkan frekuensi kemunculannya di SERP

Mengetahui (bahkan kira-kira) pengeluaran iklan pesaing memungkinkan Anda merencanakan dan menyajikan rencana kerja yang jelas dengan mempertimbangkan persaingan dan anggaran. Mengetahui seberapa banyak pesaing Anda berinvestasi dalam kampanye PPC mereka memungkinkan Anda untuk:

- Prediksikan berapa banyak perusahaan Anda perlu berinvestasi untuk bersaing di SERP, membantu Anda menjual strategi Anda dengan lebih baik kepada pemangku kepentingan

- Jika kami menambahkan posisi iklan ke dalam campuran, Anda dapat mengetahui kata kunci mana yang kinerjanya lebih unggul dari pesaing Anda dan menggunakan biaya BPK rata-rata untuk menemukan tempat yang akan lebih hemat biaya untuk bersaing.

- Jika Anda menjalankan biro iklan, Anda dapat menggunakan data iklan untuk menskalakan anggaran iklan klien Anda dan menunjukkan alasan spesifik untuk anggaran yang Anda usulkan

- Kategorikan investasi periklanan pesaing Anda berdasarkan lokasi (misalnya negara), kata kunci dan maksud pencarian, serta tahap perjalanan pembeli – hanya untuk menyebutkan beberapa kategori

Untuk melangkah lebih jauh, Anda dapat mengatur web scraper Anda untuk memindai SERP secara teratur guna memperbarui informasi ini dan mendeteksi perubahan strategi atau menghasilkan tren dari berbagai pesaing.

Identifikasi dan analisis halaman arahan pesaing Anda dengan mengikuti tautan iklan mereka

Halaman arahan adalah tenaga penjualan di balik periklanan, dan Anda dapat belajar banyak tentang pesaing Anda dengan menganalisis salinan, struktur, dan penawaran halaman arahan mereka.

Anda dapat membuat pengikis web yang mengekstrak informasi iklan dan kemudian mengikuti setiap tautan yang terkait dengan iklan untuk memindai judul halaman arahan, konten, deskripsi meta, judul meta, gambar, video, dll. dan membuat tampilan sekilas dari iklan untuk buat seluruh kampanye PPC yang mereka terapkan. Sebagai imbalannya, Anda dapat menemukan celah dalam pemasaran mereka, menawarkan peluang, mengembangkan ide konten, dan menyalurkan ide untuk meluncurkan kampanye Anda.

Cari tahu siapa pesaing utama Anda untuk kata kunci tertentu

Bukan hanya pesaing terkenal Anda yang berinvestasi di PPC dan Google Ads. Dengan mengumpulkan data iklan dalam skala besar, Anda dapat dengan cepat mengidentifikasi perusahaan yang bersaing untuk kata kunci yang sama dengan yang Anda cari. Hal ini sangat berguna jika perusahaan Anda ingin memasuki pasar geografis baru.

Dengan membuat scraper Google Ads, Anda dapat mengumpulkan sejumlah besar data iklan untuk mengidentifikasi pemain lokal utama dan tingkat persaingan yang Anda hadapi untuk mendapatkan pangsa pasar.

Cara Mengekstrak Data Google Ads dari Halaman Hasil Pencarian Menggunakan Scrapy

Ada banyak alat pengikis Google yang dapat berguna dalam menggores beberapa permintaan pencarian. Namun, jika Anda ingin mengirim jutaan permintaan scraping, Anda memerlukan solusi yang lebih canggih seperti ScraperAPI.

API kami melakukan semua pekerjaan berat dalam rotasi IP, memilih header yang tepat, dan mengubah geolokasi permintaan Anda - sehingga Anda bisa mendapatkan data iklan dari mana saja. Selain itu, ia memiliki parser otomatis yang dibuat khusus untuk Google, jadi Anda tidak perlu khawatir tentang penyeleksi atau perubahan pada platform Google di masa mendatang.

Untuk proyek ini, kami menggunakan ScraperAPI untuk menangani kerumitan ini dan Scrapy untuk membuat skrip.

Catatan: Jika Anda belum pernah menggunakan Scrapy sebelumnya, lihat panduan pemula Scrapy kami yang mencakup semua dasar-dasarnya.

1. Menyiapkan proyek ekstraksi web Google Ads kami

Untuk memulai, Anda perlu membuat lingkungan virtual untuk menginstal Scrapy. Buka terminal Anda, navigasikan ke desktop (atau di mana pun Anda ingin membuat proyek) dan gunakan perintah berikut:

python -m venv g-ad-tutorial

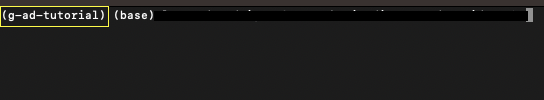

Anda akan melihat bahwa folder baru telah dibuat. Ini adalah lingkungan virtual Anda; Untuk mengaktifkannya – di Mac – gunakan perintah berikut:

source g-ad-tutorial/bin/activate

Saat aktif, nama VENV Anda akan muncul sebagai berikut:

Selanjutnya, buat proyek baru di VENV Anda:

cd g-ad-tutorial

>pip3 install scrapy

scrapy startproject g_ad_scraper

...dan buka dengan VScode atau editor kode favorit Anda. Di folder spiders, buat file Python Anda. Dalam kasus kami, kami menamainya g_adscraper.py, namun Anda dapat menamainya sesuka Anda.

Untuk menyelesaikan konfigurasi proyek, tambahkan cuplikan kode berikut untuk mengimpor semua dependensi yang diperlukan:

import scrapy

from urllib.parse import urlencode

from urllib.parse import urlparse

#ScraperAPI autoparser will return data in JSON format

import json

API_KEY='YOUR_API_KEY'

Catatan: Ingatlah untuk menambahkan kunci API Anda ke variabel API_KEY. Anda dapat membuat akun ScraperAPI gratis di sini.

2. Membuat URL pencarian Google

Google menerapkan struktur URL standar dan dapat dikueri yang dapat kita gunakan jika kita memahami parameternya. Itu selalu dimulai dengan “http://www.google.com/search?” dan dari sana kita dapat menambahkan beberapa parameter untuk menentukan apa yang kita inginkan. Untuk proyek ini kami hanya akan fokus pada dua di antaranya:

Jika Anda pernah menggunakan operator penelusuran sebelumnya, Anda sudah familiar dengannya. Jika tidak, berikut adalah daftar lengkap operator pencarian yang bisa Anda gunakan.

Sekarang mari kita buat fungsi pertama kita dan buat permintaan pencarian target kita:

defcreate_google_url(query, site=''):

google_dict = {'q': query}

if site :

web = urlparse(site).netloc

google_dict('as_sitesearch') = web

return 'http://www.google.com/search?' + urlencode(google_dict)

return 'http://www.google.com/search?' + urlencode(google_dict)

Kita akan menyetel kueri kita nanti di skrip, jadi mari kita mulai dengan menetapkan kueri ke parameter q - ini juga akan memudahkan Anda melakukan perubahan.

Catatan penting

Saat mengambil hasil organik, kami akan menggunakan parameter “num” untuk memungkinkan Google menampilkan jumlah maksimum hasil per kueri (saat ini 100 hasil per halaman). Namun, iklan Google disajikan berdasarkan halaman demi halaman dan tidak dipengaruhi oleh jumlah hasil pada halaman kemunculannya.

Dengan kata lain, parameter ini tidak perlu digunakan karena kita hanya membutuhkan data iklan saja. Jika kami menginginkan lebih banyak “hasil iklan” untuk satu kata kunci, kami sebenarnya ingin mengirimkan lebih banyak permintaan – bukan lebih sedikit – untuk mengekstrak lebih banyak iklan dari setiap halaman dari 10 hasil.

3. Menggunakan ScraperAPI dengan Scrapy

Untuk menggunakan fitur ScraperAPI, kita perlu mengirimkan permintaan melalui server ScraperAPI. Untuk melakukan ini kita perlu menggunakan payload dan kode URL untuk membuat struktur dan kemudian menggunakannya bersama dengan query Google yang baru saja kita buat.

Mari tambahkan logika berikut sebelum fungsi create_google_url() kita:

def get_url ( url ):

payload = { 'api_key' : API_KEY , 'url' : url , 'autoparse' : 'true' , 'country_code' : 'us' }

proxy_url = 'http://api.scraperapi.com/?' + urlencode ( payload )

return proxy_url

Di dalam payload kita dapat mengatur berbagai komponen untuk ScraperAPI:

- Yang pertama tentu saja API key kita yang sudah kita setting di atas

- URL adalah URL target yang harus diurai oleh ScraperAPI. Kami membuat URL ini menggunakan fungsi “create_google_url()”.

- Kami menyetel penguraian otomatis ke true sehingga ScraperAPI tahu untuk mengirimkan data JSON kepada kami

- Terakhir, kami menunjukkan bahwa kami ingin mengirim semua permintaan dari alamat IP AS

Dan itu saja, kami siap menulis laba-laba kami!

4. Membuat laba-laba khusus

Untuk menjalankan skrip kita, kita perlu mengikis seekor laba-laba (juga disebut kelas). Di Scrapy kita dapat membuat spider sebanyak yang kita inginkan dalam satu proyek, membuatnya lebih mudah untuk mengelola proyek besar yang memerlukan scraping beberapa situs web.

Kita perlu mengizinkan titik akhir ScraperAPI karena permintaan kita masuk ke server dan ScraperAPI mengambil respons dari kueri target.

class GoogleAdSpider(scrapy.Spider):

name = 'adsy'

allowed_domains = ('api.scraperapi.com')

custom_settings = {'LOG_LEVEL': 'INFO',

'CONCURRENT_REQUESTS_PER_DOMAIN': 10,

'RETRY_TIMES': 5}

Kami juga mengonfigurasi beberapa pengaturan khusus yang ada di Scrapy. Yang terpenting, kami mengonfigurasi permintaan serentak dan jumlah upaya maksimum.

Jika Anda ingin mempelajari lebih lanjut tentang pengaturan khusus ini, Scrapy telah mendokumentasikannya dengan sangat baik.

5. Mengirim permintaan HTTP

Scrapy membuatnya sangat mudah untuk mengirim permintaan kita menggunakan metode scrapy.Request(), tetapi untuk mengirim permintaan kita perlu menyetel URL terlebih dahulu dan untuk itu kita memerlukan serangkaian kueri.

Pada langkah ini, tim Anda perlu memutuskan kata kunci mana yang penting bagi bisnis Anda. Ini biasanya dilakukan oleh tim PPC, manajer pemasaran, atau tim SEO Anda.

Untuk bersenang-senang, katakanlah kita adalah perusahaan perangkat lunak manajemen proyek dan kita ingin melihat iklan apa yang ditampilkan untuk sepuluh kata kunci berikut:

- Perangkat lunak manajemen proyek

- Aplikasi manajemen proyek

- perangkat lunak manajemen proyek terbaik

- Perangkat lunak manajemen tugas

- Alat manajemen proyek

- Perbandingan perangkat lunak manajemen proyek

- Perencanaan dan manajemen proyek

- perangkat lunak manajemen proyek yang tangkas

- Pelacak proyek

- Manajemen proyek untuk pengembangan perangkat lunak

Kita dapat menggunakan alat SEO untuk mengidentifikasi istilah-istilah ini berdasarkan cakupan dan kesulitannya, atau mencari di Google dengan kata kunci awal lalu mengekstrak dan menavigasi ke tautan ke semua istilah terkait.

Jika Anda ingin melakukan cara ini, kami telah membuat panduan untuk menggores hasil organik Google dengan Scrapy yang dapat Anda periksa.

Sekarang mari kita mulai membuat fungsi kita menggunakan query berikut:

def start_requests(self):

queries = (

'project+management+software',

'best+project+management+software',

'project+management+tools',

'project+planning+management',

'project+tracker',

'project+management+app',

'task+management+software',

'comparing+project+management+software',

'agile+project+management+software'

)

Perhatikan bahwa kami mengganti semua spasi dengan tanda plus (+). Ini adalah bagian dari struktur standar Google, jadi perhatikan baik-baik.

Terus gimana? Setelah kami memiliki permintaan pencarian, sekarang kami dapat membuat permintaan pencarian Google. Seperti yang dapat Anda bayangkan, kami ingin membuat URL berbeda untuk setiap kueri. Untuk melakukan ini, kita dapat mengulang daftar dan meneruskan masing-masing ke fungsi create_google_url() kita:

for query in queries:

url = create_google_url(query)

Dan dalam loop yang sama, kita meneruskan URL baru ke fungsi get_url(), jadi teruskan sebagai parameter dan buat metode ScraperAPI yang lengkap.

yield scrapy.Request(get_url(url), callback=self.parse)

6. Mengekstrak Data Google Ads dari ScraperAPI Auto Parser

Setelah ScraperAPI mengirimkan permintaan ke Google, data JSON dikembalikan. Di JSON ini kita dapat menemukan semua elemen penting dari halaman hasil pencarian.

Berikut contoh lengkap respon dari parser otomatis Google. Agar tetap ringkas, mari fokus pada data iklan:

"ads": (

{

"position": 1,

"block_position": "top",

"title": "7 Best VPN Services for 2019 | Unlimited Worldwide Access",

"link": "https://www.vpnmentor.com/greatvpn/",

"displayed_link": "www.vpnmentor.com/Best-VPN/For-2019",

"tracking_link": "https://www.googleadservices.com/pagead/aclk?sa=L&ai=DChcSEwjphbjWlprlAhUHyN4KHR9YC10YABAAGgJ3Yg&ohost=www.google.ca&cid=CAASE-Roa2AtpPVJRsK0-RiAG_RCb3U&sig=AOD64_0dARmaWACDb7wQ5rCwGfAERVWsdg&q=&ved=2ahUKEwj9gLPWlprlAhUztHEKHdnCBBwQ0Qx6BAgSEAE&adurl=",

"description": "Our Best VPN for Streaming Online, Find Your Ideal VPN and Stream Anywhere",

"sitelinks": ()

},

{

"position": 2,

"block_position": "top",

"title": "Top 10 Best VPN Egypt | Super Fast VPNs for 2019",

"link": "https://www.top10vpn.com/top10/free-trials/",

"displayed_link": "www.top10vpn.com/Best-VPN/Egypt",

"tracking_link": "https://www.googleadservices.com/pagead/aclk?sa=L&ai=DChcSEwjphbjWlprlAhUHyN4KHR9YC10YABABGgJ3Yg&ohost=www.google.ca&cid=CAASE-Roa2AtpPVJRsK0-RiAG_RCb3U&sig=AOD64_3hbcS-4qdyR_QK0mSCy2UJb61xiw&q=&ved=2ahUKEwj9gLPWlprlAhUztHEKHdnCBBwQ0Qx6BAgTEAE&adurl=",

"description": "Enjoy Unrestricted Access to the Internet. Compare Now & Find the Perfect VPN. Stay Safe & Private Online with a VPN. Access Your Websites & Apps from Anywhere. 24/7 Support. Free Trials. Coupons. Instant Setup. Strong Encryption. Fast Speeds. Beat Censorship.",

"sitelinks": ()

}

)

Semua data ada di objek iklan. Jadi jika kita mengulang semua elemen dalam objek, kita dapat memilih semua elemen yang kita perlukan.

Mari kita dapatkan judul, deskripsi, display_link dan link. Agar lebih bermanfaat, kita juga mendapatkan nilai query_deplayed dari objek search_information.

"search_information": {

"total_results": 338000000,

"time_taken_displayed": 0.47,

"query_displayed": "vpn"

}

Dengan cara ini kami melacak asal kueri dari setiap iklan dalam daftar.

def parse(self, response):

all_data = json.loads(response.text)

keyword = all_data('search_information')('query_displayed')

Setelah memuat data JSON ke dalam variabel all_data, kita dapat menggunakannya untuk menavigasi respons dan mengambil elemen query_displayed. Kita dapat melakukan hal yang sama untuk data iklan lainnya dalam satu lingkaran:

for ads in all_data('ads'):

title = ads('title')

description = ads('description')

displayed_link = ads('displayed_link')

link = ads('link')

Dengan kata lain, kami menetapkan setiap elemen dalam objek JSON “ads” ke variabel “ads” dan kemudian memilih setiap elemen untuk mengekstrak nilainya.

Terakhir, kami mengatur setiap rangkaian atribut ke dalam objek iklan dan menayangkannya - selalu dalam loop:

ad = {

'keyword': keyword,'title': title, 'description': description, 'Displayed Link': displayed_link, 'Link': link

}

yield ad

Sekarang kita memiliki elemen tampilan untuk setiap iterasi loop yang menyimpan semua data secara terorganisir.

7. Jalankan Spider dan ekspor data ke file JSON

Jika Anda telah mengikuti kami sejauh ini, inilah tampilan skrip Python Anda:

import scrapy

from urllib.parse import urlencode

from urllib.parse import urlparse

import json

API_KEY = 'your_api_key'

#constructing the ScraperAPI method

def get_url(url):

payload = {'api_key': API_KEY, 'url': url, 'autoparse': 'true', 'country_code': 'us'}

proxy_url = 'http://api.scraperapi.com/?' + urlencode(payload)

return proxy_url

#building the Google search query

def create_google_url(query, site=''):

google_dict = {'q': query, 'num': 10, }

if site:

web = urlparse(site).netloc

google_dict('as_sitesearch') = web

return 'http://www.google.com/search?' + urlencode(google_dict)

return 'http://www.google.com/search?' + urlencode(google_dict)

class GoogleAdSpider(scrapy.Spider):

name = 'adsy'

allowed_domains = ('api.scraperapi.com')

custom_settings = {'ROBOTSTXT_OBEY': False, 'LOG_LEVEL': 'INFO',

'CONCURRENT_REQUESTS_PER_DOMAIN': 10,

'RETRY_TIMES': 5}

#sending the requests

def start_requests(self):

queries = (

'project+management+sotware',

'best+project+management+software',

'project+management+tools',

'project+planning+&+management',

'project+tracker',

'project+management+app',

'task+management+software',

'comparing+project+management+software',

'agile+project+management+software'

)

for query in queries:

#constructing the Google search query

url = create_google_url(query)

#adding the url to ScraperAPI endpoint

yield scrapy.Request(get_url(url), callback=self.parse)

def parse(self, response):

all_data = json.loads(response.text)

#grabbing the keyword for organization

keyword = all_data('search_information')('query_displayed')

#lopping through each item inside the ads object

for ads in all_data('ads'):

title = ads('title')

description = ads('description')

displayed_link = ads('displayed_link')

link = ads('link')

ad = {

'keyword': keyword,'title': title, 'description': description, 'Displayed Link': displayed_link, 'Link': link

}

yield ad

Ingat: Agar ini berfungsi, Anda perlu menambahkan kunci API Anda.

Untuk menjalankan spider Anda dan mengekspor semua data ke file JSON, gunakan perintah…

scrapy runspider g_adscraper.py -o ad_data.json

…dan voila! Kami cukup memindai 48 iklan dalam 34 detik dan menambahkan semuanya ke file JSON.

Jika Anda belum menjalankannya, kami akan menunjukkan beberapa contoh dari file yang ingin Anda buat:

{

"keyword": "comparing+project+management+software",

"title": "10 Best Project Management - Side-by-Side Comparison (2022)",

"description": "Compare the Best Project Management Software. Plan, Track, Organize, and Manage Your Time. Powerful, Flexible Project Management for Any Team. Task Management & Custom...",

"Displayed Link": "https://www.consumervoice.org/top-software/project-manager",

"Link": "https://www.consumervoice.org/top-project-management-software"

},

{

"keyword": "project+management+sotware",

"title": "Project Management Software - Plan, Track, Collaborate",

"description": "Plan projects, track progress, and collaborate with your team. Sign up for free!",

"Displayed Link": "https://www.zoho.com/",

"Link": "https://www.zoho.com/projects/"

},

{

"keyword": "task+management+software",

"title": "10 Best Task Management Tools - 10 Best Task Management App",

"description": "The Comfort Of a Simple Task Management Software Is Priceless. Apply Today & Save! Team Tasks Management Made Oh-So Easy! Get Your Work Going with These Great...",

"Displayed Link": "https://www.top10.com/task_management/special_offer",

"Link": "https://www.top10.com/project-management/task-manager-comparison"

},

Catatan: Jika Anda ingin membuat elemen kata kunci lebih bersih, Anda bisa menggunakannya .replace() Caranya sebagai berikut:

keyword = all_data('search_information')('query_displayed').replace("+", " ")

Ganti tanda tambah (+) secara efektif dengan spasi.

{

"keyword": "best project management software",

"title": "Project Management Software - Plan, Track, Execute, Report",

"description": "Plan projects, track progress, and collaborate with your team. Sign up for free! Get work done on time, all the time. Start with 2 projects free today! Simplify complex tasks.",

"Displayed Link": "https://www.zoho.com/projects",

"Link": "https://www.zoho.com/projects/"

}

Fokus untuk menghilangkan iklan di halaman pertama Google

Iklan yang berbeda muncul di setiap halaman di baris SERP kueri. Jadi sebaiknya ikuti tautan ini untuk setiap kueri dan ekstrak semua data yang Anda bisa.

Meskipun hal ini mungkin ada manfaatnya, kenyataannya hanya sebagian kecil lalu lintas yang berakhir di halaman 2 dan hampir tidak ada klik yang berakhir di halaman 3. Coba pikirkan kapan terakhir kali Anda mengklik halaman 2.

ScraperAPI memberi Anda tautan berikut di dalam objek ('pagination')('nextPageUrl'). Namun, ini lebih disarankan untuk menggores hasil penelusuran organik, penelusuran terkait, dan juga kolom pertanyaan orang.

Kami menyarankan penelusuran halaman 1 untuk setiap variasi kata kunci untuk data Google Ads.

Skalakan proyek pengikisan web Google Anda

Anda telah melakukannya dengan baik sejauh ini! Kami harap Anda mempelajari sesuatu dari tutorial web scraping Google Ads ini dan berharap dapat melihat apa yang Anda capai dengannya.

Jika Anda tidak tahu apa yang harus dilakukan selanjutnya, Anda dapat menskalakan proyek ini dengan membuat daftar kata kunci yang lebih panjang. Kami merekomendasikan penggunaan alat seperti Answer the Public untuk membuat daftar kata kunci yang relevan dan membiarkan skrip Anda membaca pertanyaan dari sana.

Untuk pemantauan terus-menerus, Anda juga dapat menyetel scraper Google Ads untuk mengirimkan permintaan baru setiap kali Anda memperbarui tabel dengan kata kunci baru.

Jika Anda ingin berinvestasi di PPC tetapi dalam bahasa berbeda, Anda juga dapat membuat spider baru dan mengubah parameter country_code di payload. Hal ini berguna, misalnya, jika Anda ingin menampilkan iklan di berbagai negara dengan bahasa yang sama (misalnya Inggris, AS, Kanada, dll.).

Selama Anda tetap terbuka terhadap berbagai kemungkinan, Anda akan menemukan lebih banyak cara untuk mengumpulkan data lebih cepat dan menggunakannya untuk membuat kampanye positif ROI.

Jika Anda ingin mempelajari lebih lanjut tentang pemasaran dan web scraping, kami telah menguraikan semua cara web scraping dapat membantu Anda membuat keputusan pemasaran yang lebih baik.

Tertarik menggunakan ScraperAPI untuk mendukung kebutuhan ekstraksi data Anda? Daftar hari ini dan dapatkan uji coba gratis 7 hari!

Sampai jumpa lagi, selamat menggores!