Im aktuellen Zeitalter von Big Data sammelt und analysiert jedes erfolgreiche Unternehmen täglich riesige Datenmengen. Alle ihre wichtigen Entscheidungen basieren auf den Erkenntnissen dieser Analyse Qualitätsdaten ist das Fundament.

Eines der wichtigsten Merkmale von Qualitätsdaten ist ihre Qualität KonsistenzDies ist der Fall, wenn entsprechende Datenfelder in allen Datensätzen vom gleichen Typ und in einem Standardformat sind. Diese Konsistenz wird erreicht durch Datennormalisierung — ein Prozess, der den unternehmensweiten Erfolg sichert und verbessert.

Was ist Datennormalisierung?

Wenn Sie bei Google nach Web Scraping suchen, wird es am häufigsten als eine Technologie definiert, die es Ihnen ermöglicht, Webdaten zu extrahieren und sie in einem strukturierten Format darzustellen. Bei der Big-Data-Normalisierung handelt es sich um den Prozess, der diese unstrukturierten Daten in einem Format organisiert und nachfolgende Arbeitsabläufe effizienter macht.

Im Allgemeinen bezieht es sich auf die Entwicklung konsistenter und sauberer Daten. Sein Hauptziel besteht darin, Redundanzen und Anomalien zu reduzieren und zu beseitigen und die Daten so zu organisieren, dass sie bei korrekter Verarbeitung über alle Datensätze und Felder hinweg konsistent und standardisiert sind.

Benötigen Sie eine Datennormalisierung?

Einfach gesagt – Ja! Jedes datengesteuerte Unternehmen, das erfolgreich sein und wachsen möchte, muss es regelmäßig in seinen Arbeitsablauf integrieren. Durch die Beseitigung von Fehlern und Anomalien werden die normalerweise komplizierten Informationsanalysen vereinfacht. Das Ergebnis ist ein gut geöltes und funktionierendes System voller hochwertiger, zuverlässiger und nutzbarer Daten.

Da die Datennormalisierung Ihre Arbeitsabläufe und Teams effizienter macht, können Sie mehr Ressourcen für die Verbesserung Ihrer Datenextraktionsfunktionen bereitstellen. Dadurch erhalten Sie mehr Qualitätsdaten in Ihr System und erhalten bessere Einblicke in wichtige Aspekte, sodass Sie risikoärmere, datengestützte Entscheidungen treffen können. Letztendlich sehen Sie erhebliche Verbesserungen in der Art und Weise, wie Ihr Unternehmen geführt wird.

Verwandte Lektüre:

Wie es funktioniert

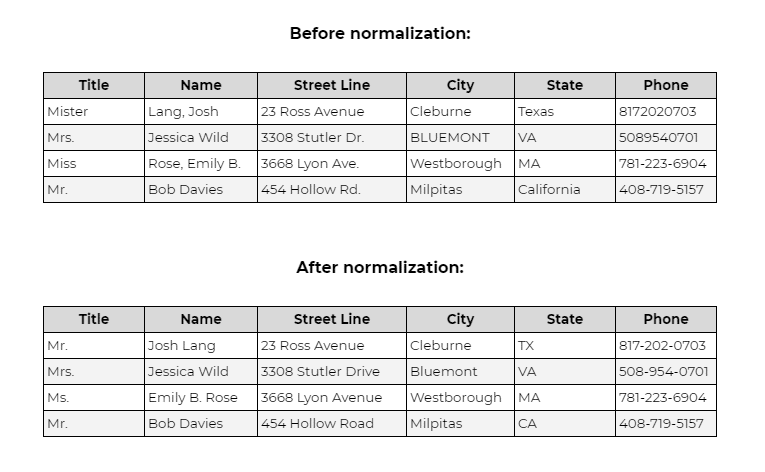

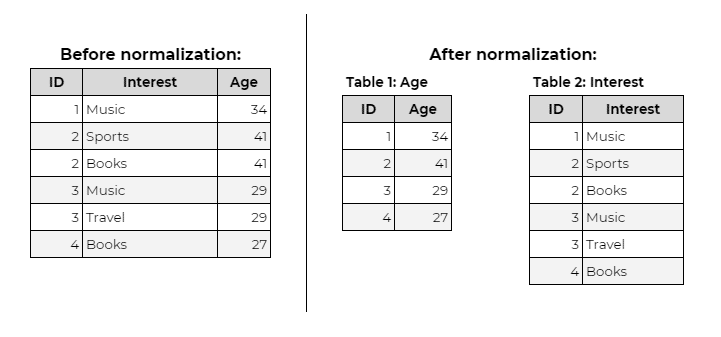

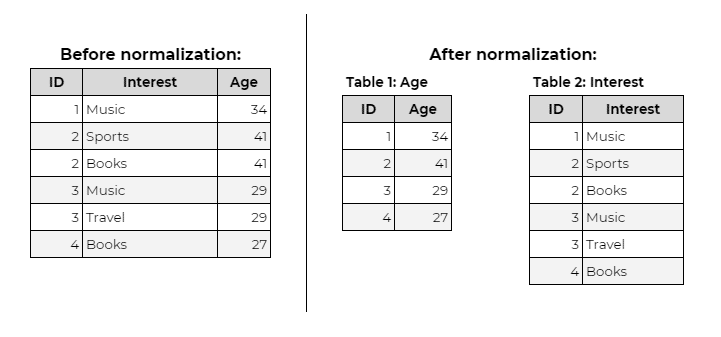

Die Grundidee der Datennormalisierung besteht darin, ein Standardformat für Datenfelder in allen Datensätzen zu erstellen. Hier ist ein Beispiel eines Datensatzes vorher und nachher:

Abgesehen von dieser grundlegenden Standardisierung haben Datennormalisierungsexperten fünf „Normalformen“ definiert. Jede Regel ordnet jeden Entitätstyp basierend auf den Komplexitätsstufen einer Zahlenkategorie zu.

Der Einfachheit halber betrachten wir die Grundlagen der drei häufigsten Formen: 1NF, 2NF Und 3NF – in diesem Beitrag.

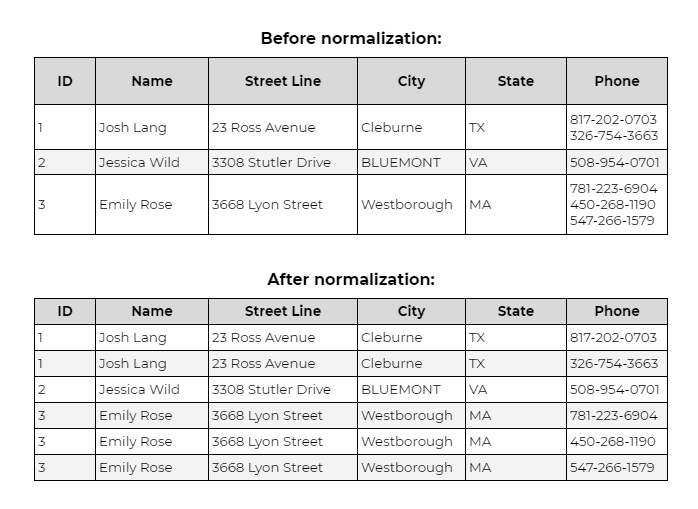

Erste Normalform (1NF)

In der ersten Normalform muss jede Zelle einen einzelnen Wert haben und jeder Datensatz muss eindeutig sein. Dadurch wird sichergestellt, dass es keine doppelten Einträge gibt.

Zweite Normalform (2NF)

Damit Daten die 2NF-Regel erfüllen, müssen sie zunächst alle 1NF-Anforderungen erfüllen. Dann darf es nur einen „Primärschlüssel“ haben (ID im Beispiel unten), für die alle Teilmengen der Daten in verschiedenen Tabellen abgelegt werden. Beziehungen zwischen Entitäten können über „Fremdschlüssel“ erstellt werden.

Dritte Normalform (3NF)

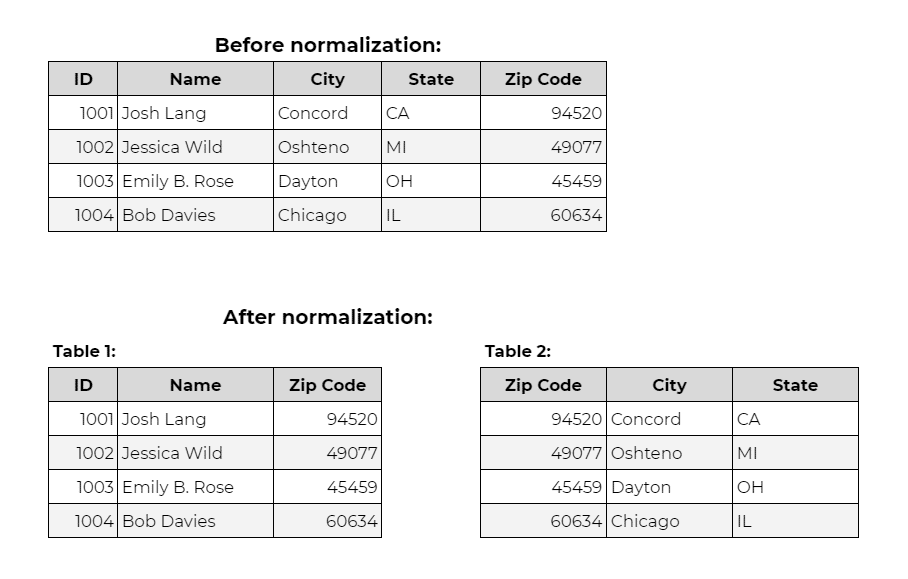

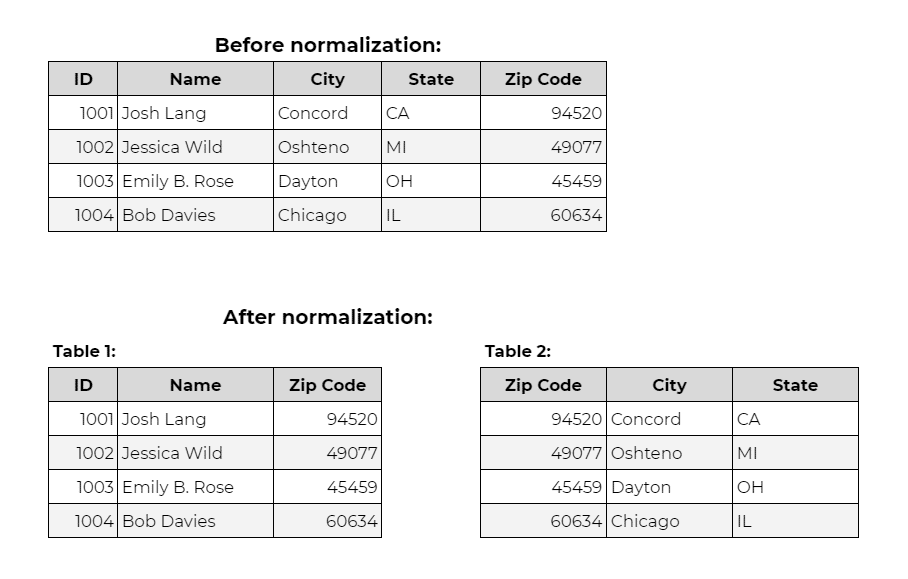

Bei der 3NF-Regel sollten die Daten zunächst alle 2NF-Bedingungen erfüllen. Dann sollte es nur vom Primärschlüssel abhängig sein (ID). Bei einer Änderung des Primärschlüssels. Anschließend müssen alle zugehörigen und betroffenen Daten in eine neue Tabelle verschoben werden.

Wenn Sie eine ausführlichere Erklärung der Normalformen wünschen, finden Sie diese hier.

Vorteile der Datennormalisierung

Zusätzlich zu den oben genannten Vorzügen sind die folgenden weiteren wichtigen Vorteile der Normalisierung von Daten:

Verbesserte Konsistenz

Bei der Datennormalisierung werden alle Ihre Daten und Informationen an einem einzigen Ort gespeichert. Dies verringert die Möglichkeit inkonsistenter Daten. Dies wiederum verbessert die Qualität Ihres Datensatzes und stärkt so Ihre Grundlagen, sodass Teams unnötige Risiken bei der Entscheidungsfindung vermeiden können.

Effizientere Datenanalyse

In Datenbanken, die mit Informationen aller Art vollgestopft sind, können Duplikate entfernt und unstrukturierte Datensätze organisiert werden. Dadurch wird alles unnötige Durcheinander beseitigt und Platz frei, um die Verarbeitungsleistung drastisch zu verbessern.

Dadurch werden alle wichtigen Systeme schneller geladen und laufen reibungsloser und schneller, sodass Analysten mehr Daten verarbeiten und analysieren und wertvollere Erkenntnisse als je zuvor gewinnen können.

Bessere und schnellere datengesteuerte Entscheidungen

Dank der Normalisierung verarbeiten Teams und Analysesysteme mehr Daten mit immer höherer Effizienz. Da bereits strukturierte Daten verfügbar sind, verbringen sie darüber hinaus kaum oder gar keine Zeit damit, Daten zu ändern und zu organisieren. Solche Datensätze lassen sich leicht analysieren, sodass Sie viel schneller zu aussagekräftigeren und aufschlussreicheren Schlussfolgerungen gelangen und so wertvolle Zeit und Ressourcen sparen.

Verbesserte Lead-Segmentierung

Die Lead-Segmentierung ist eine der effektivsten Methoden, um Ihr Geschäft auszubauen, und die Normalisierung vereinfacht sie um ein Vielfaches. Es ist einfacher, Ihre Leads nach Branchen, Berufsbezeichnungen oder anderen Attributen zu segmentieren. Sie sind dann in der Lage, spezifische Kampagnen zu erstellen und Erlebnisse basierend auf den spezifischen Bedürfnissen jedes Zielsegments anzupassen.

Da Daten für Unternehmen und Marken auf der ganzen Welt immer wertvoller werden, ist es unerlässlich, ihrer Qualität Priorität einzuräumen, um dauerhafte Vorteile zu erzielen. Durch die Normalisierung wird die Konsistenz aller Ihrer Datensätze sichergestellt, sodass alle in Ihrem Unternehmen auf dem gleichen Stand sind und nahtlos zum Erreichen des gemeinsamen Ziels übergehen können.

Daher sollte die Datennormalisierung nicht nur eine der Optionen oder Tools sein, die Ihnen zur Verfügung stehen, sondern einer der ersten Prozesse, die Sie einsetzen, um Ihr Unternehmen auf die nächste Ebene zu bringen.

Über Grepsr

Bei Grepsr sind wir stets bestrebt, unseren Kunden Daten von höchster Qualität bereitzustellen. Die grundlegenden Aspekte der Datennormalisierung – Deduplizierung, Standardisierung usw. – sind immer die ersten Teile unseres Qualitätssicherungsprozesses. Die von uns bereitgestellten Datensätze sind daher sofort zuverlässig und umsetzbar, sodass Sie schnell Erkenntnisse gewinnen und den Weg für anhaltenden Erfolg einschlagen können.