Apa yang terlintas di benak saya ketika memikirkan seorang detektif?

Pikiran yang tajam, tatapan tajam yang tidak melewatkan apa pun, hidung panjang yang mancung, pipa rokok yang selalu menempel di mulutnya, dan pencarian kebenaran yang tak kenal lelah.

Seorang pria yang terkenal karena kemampuan investigasinya yang luar biasa.

Ya kamu benar. Itu Sherlock Holmes!

Holmes mendapatkan ketenaran karena kemampuannya memecahkan misteri kompleks menggunakan pikiran analitis dan penelitian ekstensifnya.

Bagaimana jika saya memberi tahu Anda bahwa RPA (Otomasi Proses Robot) adalah Sherlock Holmes dalam lanskap digital?

Izinkan saya menjelaskan caranya.

Sama seperti Sherlock Holmes yang sangat jeli terhadap detail, dengan cermat memilah-milah petunjuk yang tampaknya acak, RPA unggul dalam memeriksa data web dalam jumlah besar.

Ia dapat mendeteksi pola tersembunyi dan ketidakkonsistenan dalam data, seperti halnya seorang detektif mengungkap petunjuk halus yang mengarah pada kebenaran yang lebih besar.

Mirip dengan bagaimana Holmes tidak membuang waktu untuk tugas-tugas kasar, RPA mengotomatiskan tindakan berulang seperti mengklik dan menggulir halaman web, memungkinkan Anda fokus pada gambaran yang lebih besar - wawasan berharga yang tersembunyi dalam data.

Sama seperti Sherlock Holmes menavigasi jalan-jalan sibuk di London, bot RPA melintasi struktur situs web yang kompleks.

Struktur ini, sering kali dirancang untuk interaksi manusia, memerlukan tindakan seperti menggulir dan mengklik - tugas yang dilakukan RPA dengan sempurna dengan meniru perilaku manusia melalui elemen GUI.

Anggap saja ini sebagai cara RPA melacak tersangka digital yang tepat. Terakhir, setelah data yang relevan teridentifikasi, para detektif digital ini dengan hati-hati mengekstraksi dan menyimpannya untuk analisis lebih lanjut – kunci untuk mengekstraksi wawasan berharga dan membentuk keputusan bisnis strategis.

Pelajari lebih lanjut tentang cara RPA untuk otomatisasi Pengikisan web fungsi:

Daftar Isi

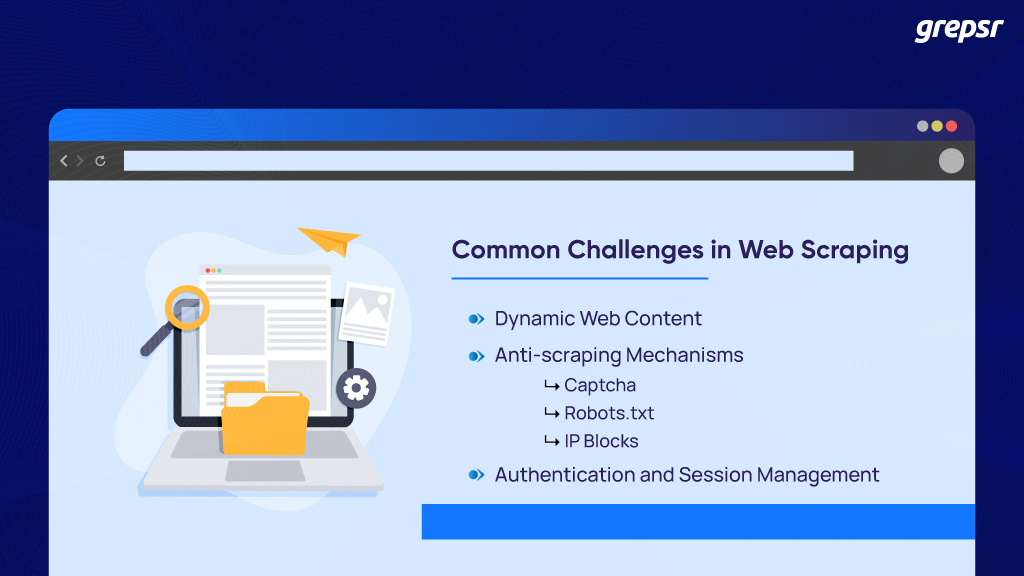

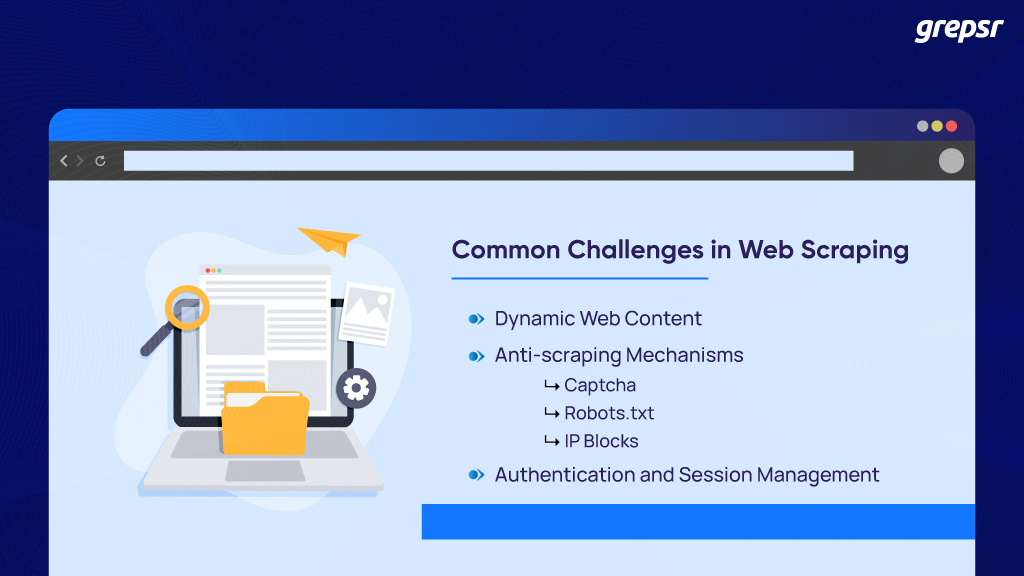

Apa tantangan paling umum dalam web scraping?

Dari banyaknya data mentah yang tidak terstruktur, mengekstraksi data penting dalam format terstruktur dari sumber web publik dikenal sebagai web scraping.

Namun, tantangan umum yang dihadapi dalam proses pengikisan data tidak dapat dihindari.

Konten web dinamis:

Saat menjelajahi Internet, Anda menemukan dua jenis halaman.

Satu yang menampilkan konten statis kepada semua pengunjung dan satu lagi dengan konten dinamis yang disesuaikan dengan masing-masing individu.

Bayangkan Amazon, di mana setiap kali Anda masuk, halamannya disesuaikan dengan data historis dan pencarian terbaru Anda.

Seringkali, mereka mengandalkan tindakan pengguna seperti menggulir, mengklik, dan berpindah ke halaman berikutnya.

Untuk web scraping tradisional, hal ini menimbulkan tantangan untuk ekstraksi data yang akurat dan konsisten karena mereka diprogram untuk mengikis elemen HTML statis.

Tindakan anti-goresan:

Situs web menggunakan mekanisme anti-scraping yang ketat untuk mencegah spam dan penyalahgunaan.

Mereka cukup cerdas untuk mendeteksi keberadaan bot dan memblokir kinerja robotik mereka yang dapat mengganggu server.

Beberapa upaya untuk mencegah laba-laba (web crawler) adalah:

- CAPTCHA: Ini adalah sistem keamanan situs web yang paling umum, populer dan efektif.

Kotak centang lama “Saya bukan robot”, memilih gambar dengan lampu lalu lintas, mengonfigurasi frasa teks yang terdistorsi, dll.

Ini adalah penjaga gerbang yang menyaring tindakan robot dengan melakukan analisis risiko terhadap pengguna.

Setelah aktivitas mencurigakan terdeteksi, CAPTCHA membatasi akses Anda ke situs web dan memastikan informasi aman.

- Robots.txt: File robots.txt memberi tahu crawler URL mana yang dapat mereka akses dalam situs web tertentu.

Ini menentukan batas perayapan untuk menghindari membebani situs secara berlebihan dengan permintaan yang menyebabkan kemacetan jaringan. Jadi, sebelum Anda mulai menjalankan bot scraper, file robots.txt, persyaratan layanan, dan kebijakan privasi situs web merupakan elemen penting yang perlu Anda periksa terlebih dahulu.

Jika Anda bertanya-tanya mengapa, merekalah yang mengizinkan atau menolak akses ke konten tertentu yang perlu Anda hapus dari URL.

- Pemblokiran IP: Teknik pemblokiran IP atau larangan IP adalah mekanisme yang digunakan situs web untuk menentukan alamat IP asal permintaan.

Jika ditemukan bahwa alamat IP yang sama sering digunakan untuk permintaan, maka disimpulkan bahwa itu adalah web scraper dengan niat jahat yang mencoba mengakses dan mengekstrak data yang dilindungi.

Jadi, jika Anda menjadi korban perburuan ini, Anda akan dilarang mengakses situs ini untuk sementara atau permanen, apalagi data Anda dihapus.

Otentikasi dan manajemen sesi:

Banyak situs web memerlukan kredensial login dan ingin Anda menerima cookie sesi untuk menelusuri kontennya. Anda mungkin bertanya-tanya mengapa.

Alasan sederhana mereka melakukan ini adalah karena mereka ingin mengingat Anda. Mereka ada untuk meningkatkan pengalaman online Anda melalui personalisasi dan kunjungan situs web yang nyaman.

Sebagai pengguna yang mencari jawaban dan solusi atas pertanyaan tertentu di internet, ini adalah hal paling keren yang pernah ada.

Namun, dengan web scraping, metode autentikasi dan manajemen sesi ini menimbulkan hambatan besar terhadap efisiensi.

Mengisi formulir login dengan kredensial yang valid agar autentikasi berhasil hanya untuk mencapai konten yang diperlukan untuk setiap sesi dapat mempersulit proses pengikisan.

Mengirimkan permintaan HTTP beberapa kali untuk konten yang sama semakin memperburuk masalah. Hal ini meningkatkan upaya ekstraksi data dan menyebabkan kontraproduktifitas.

Masih banyak masalah lain seperti jebakan honeypot, sidik jari browser, perubahan struktur situs web, skalabilitas, dan masalah hukum. Meskipun tidak semua tantangan ini dapat diatasi dan diselesaikan dengan mudah, RPA membantu mengatasi beberapa tantangan tersebut.

Ada beberapa solusi untuk mengatasinya dengan RPA

Integrasi teknologi RPA merupakan pengubah permainan dalam web scraping karena menggunakan robot perangkat lunak yang melakukan tugas-tugas yang memerlukan bantuan manusia. Proses ekstraksi data menjadi lebih lancar dari sebelumnya dengan sedikit atau tanpa gangguan.

Menangani situs web dinamis dengan RPA:

Konten halaman web dinamis yang disebutkan di atas memerlukan interaksi pengguna dengan antarmuka seperti menggulir dan mengklik tombol “Tampilkan lebih banyak” dan “Buka halaman berikutnya”.

Berurusan dengan elemen GUI ini membosankan karena menunda proses ekstraksi data.

Namun dengan otomatisasi proses robotik, bot yang diprogram dapat menangani elemen dengan berinteraksi dengannya seperti pengguna sebenarnya.

Mereka menggunakan teknik seperti XPath, pemilih CSS, atau atribut elemen untuk memungkinkan bot menemukan elemen dinamis.

Selain itu, Anda dapat mengintegrasikan browser tanpa kepala seperti Puppeteer untuk merender dan menjalankan JavaScript di halaman web. Hal ini memungkinkan bot mengekstrak data dari konten situs web yang dihasilkan secara dinamis yang memerlukan interaksi pengguna.

Oleh karena itu, situs web dinamis pengikisan web lebih mudah dengan bot RPA.

Mengatasi mekanisme captcha dan anti scraping :

Ada beberapa layanan pihak ketiga gratis dan berbayar yang dapat membantu Anda memecahkan CAPTCHA. Bot RPA dapat mengirimkan permintaan CAPTCHA tersebut ke layanan ini menggunakan API.

Solusi lainnya adalah dengan menyimulasikan perilaku penelusuran yang mirip manusia, seperti penundaan acak antar permintaan. Menghilangkan pembatasan dengan membatasi jumlah permintaan per menit dapat diintegrasikan untuk menghindari terpicunya batas kecepatan dan perlindungan anti-bot.

Bot juga merotasi alamat IP menggunakan proxy untuk menghindari blok IP. Selain itu, hal ini mencerminkan perilaku penjelajahan pengguna yang berbeda dan mengurangi risiko deteksi.

Oleh karena itu, untuk mengatasi mekanisme anti-scraping, RPA menggabungkan rotasi proxy, penundaan acak, pembatasan permintaan, dan layanan penyelesaian captcha.

Kelola otentikasi dan manajemen sesi:

Seperti disebutkan sebelumnya, Anda dapat membayangkan bahwa mengisi formulir dan login untuk memeriksa website setiap kali permintaan pengumpulan data dibuat tidak efisien.

Namun, bot RPA hadir untuk menyelamatkan hari dengan mengotomatiskan proses login dengan memasukkan kredensial login ke formulir situs web.

Mereka berinteraksi secara mulus dengan elemen GUI seperti kotak teks dan tombol yang mengharuskan pengguna untuk memasukkan dan mengirimkan rincian mereka (biasanya nama pengguna dan kata sandi) untuk akses LENGKAP ke situs web (ya, bahkan area terlarang di situs web).

Setelah proses autentikasi selesai, saatnya mengelola cookie sesi.

Bot memastikan bahwa cookie sesi ini ditangkap dan dikelola selama proses pengikisan otomatis.

Mereka juga secara otomatis mengautentikasi ulang, mencegah sesi berakhir dan memiliki akses berkelanjutan hingga proses ekstraksi data selesai.

Jadi, Anda tidak perlu khawatir tentang kesalahan autentikasi karena bot RPA menerapkan mekanisme penanganan kesalahan dan pemulihan yang kuat untuk autentikasi dan waktu sesi.

Pembungkus:

Sama seperti Sherlock Holmes yang tidak akan membiarkan kasusnya setengah terselesaikan, RPA memastikan bahwa semua data berharga diekstraksi dengan hati-hati.

Dengan mengotomatiskan tugas web scraping, RPA membebaskan Anda untuk fokus pada rahasia sebenarnya – menafsirkan data dan membuat keputusan strategis.

Jadi kenakan topi penguntit rusa Anda, jalankan alat RPA Anda, dan anggap Grepsr sebagai Watson terpercaya Anda.

Dengan keahliannya dalam web scraping yang terintegrasi dengan RPA, Grepsr dapat menjadi bagian hilang yang Anda perlukan untuk mengungkap wawasan tersembunyi di seluruh web yang luas. Bersiaplah untuk membawa perusahaan Anda menuju kesuksesan!