Was fällt Ihnen ein, wenn ich an einen Detektiv denke?

Ein scharfer Verstand, ein durchdringender Blick, dem nichts entgeht, eine scharfe lange Nase, eine Rauchpfeife, die immer in seinem Mund ruht, und ein unermüdliches Streben nach der Wahrheit.

Ein Mann, der sich durch seine herausragenden Ermittlungsfähigkeiten auszeichnet.

Ja, du hast Recht. Es ist Sherlock Holmes!

Holmes erntet Ruhm für seine Fähigkeit, mithilfe seines analytischen Verstandes und umfangreicher Recherchen komplizierte Rätsel zu lösen.

Was wäre, wenn ich Ihnen sagen würde, dass (Robotic Process Automation) RPA der Sherlock Holmes der digitalen Landschaft ist?

Lassen Sie mich erklären, wie.

Genau wie Sherlock Holmes mit seinem scharfen Blick fürs Detail, der akribisch scheinbar zufällige Hinweise durchforstet, zeichnet sich RPA durch die Untersuchung großer Mengen an Webdaten aus.

Es kann verborgene Muster und Inkonsistenzen in Daten erkennen, genau wie ein Detektiv subtile Hinweise aufdeckt, die auf eine größere Wahrheit hinweisen.

Ähnlich wie Holmes keine Zeit mit untergeordneten Aufgaben verschwenden würde, automatisiert RPA sich wiederholende Aktionen wie das Klicken und Scrollen durch Webseiten, sodass Sie sich auf das Gesamtbild konzentrieren können – die wertvollen Erkenntnisse, die in den Daten verborgen sind.

So wie Sherlock Holmes durch die geschäftigen Straßen Londons navigiert, durchqueren RPA-Bots komplexe Website-Strukturen.

Diese Strukturen, die oft für die menschliche Interaktion konzipiert sind, erfordern Aktionen wie Scrollen und Klicken – eine Aufgabe, die RPA fehlerfrei ausführt, indem es menschliches Verhalten durch GUI-Elemente nachahmt.

Betrachten Sie es als die Art und Weise, wie RPA die richtigen digitalen Verdächtigen aufspürt. Sobald die relevanten Daten identifiziert sind, extrahieren diese digitalen Detektive sie schließlich sorgfältig und speichern sie zur weiteren Analyse – der Schlüssel zur Gewinnung wertvoller Erkenntnisse und zur Bildung strategischer Geschäftsentscheidungen.

Erfahren Sie mehr darüber, wie RPA für automatisiertes Web Scraping funktioniert:

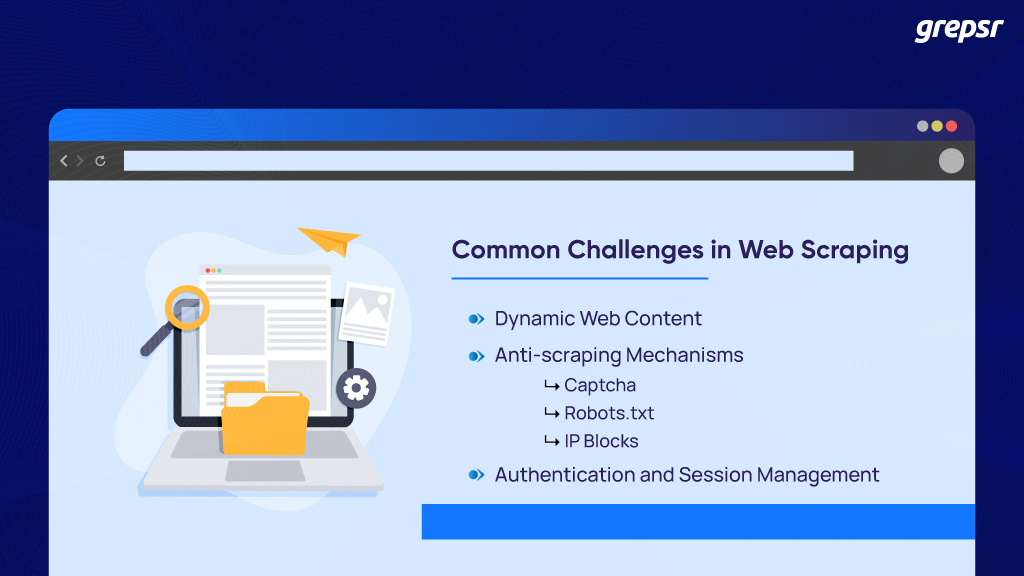

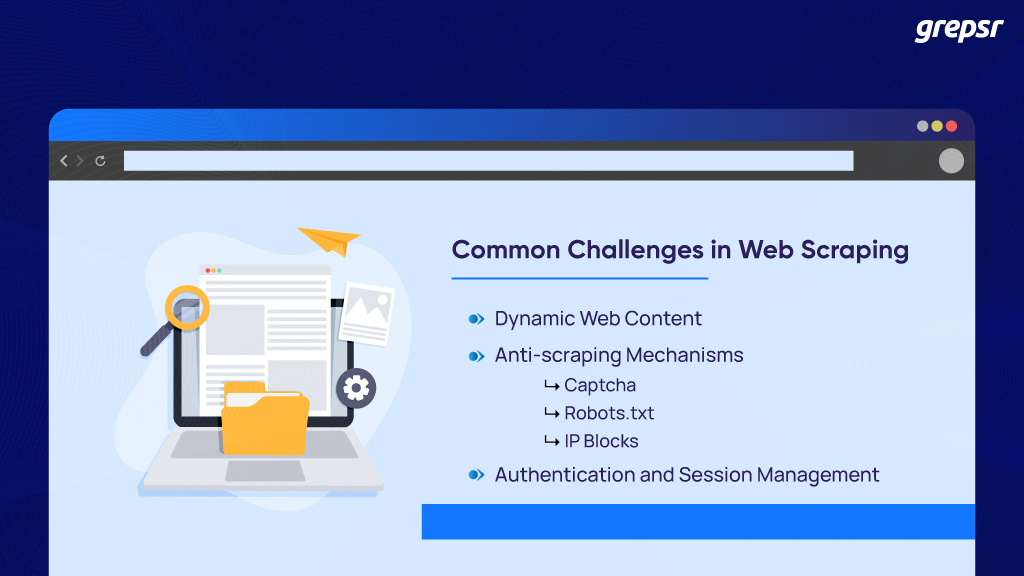

Was sind die häufigsten Herausforderungen beim Web Scraping?

Aus der Überfülle an unstrukturierten Rohdaten wird das Extrahieren wichtiger Daten in einem strukturierten Format aus öffentlichen Webquellen als Web Scraping bezeichnet.

Allerdings ist es unvermeidlich, dass man beim Data-Scraping-Prozess auf häufige Herausforderungen stößt.

Dynamischer Webinhalt:

Beim Surfen im Internet stoßen Sie auf zwei Arten von Seiten.

Eines, das allen Besuchern statische Inhalte anzeigt, und ein anderes mit dynamischen Inhalten, die auf jeden Einzelnen zugeschnitten sind.

Denken Sie an Amazon, wo die Seite jedes Mal, wenn Sie sich anmelden, mit historischen Daten und Ihren letzten Suchanfragen angepasst wird.

Meistens verlassen sie sich auf Benutzeraktionen wie Scrollen, Klicken und Wechseln zur nächsten Seite.

Für das traditionelle Web-Scraping stellt dies eine Herausforderung für die genaue und konsistente Datenextraktion dar, da sie so programmiert sind, dass sie statische HTML-Elemente scrapen.

Anti-Scraping-Maßnahmen:

Websites setzen strenge Anti-Scraping-Mechanismen ein, um Spam und Missbrauch zu verhindern.

Sie sind intelligent genug, um die Anwesenheit von Bots zu erkennen und deren Roboterleistungen zu blockieren, die den Server stören könnten.

Einige der Maßnahmen zur Verhinderung von Spidern (Webcrawlern) sind:

- CAPTCHA: Dies ist das gebräuchlichste, beliebteste und effektivste System zur Website-Sicherheit.

Das alte Kontrollkästchen „Ich bin kein Roboter“, das Auswählen von Bildern mit Ampeln, das Konfigurieren verzerrter Textphrasen usw.

Dies sind die Gatekeeper, die Roboterhandlungen aussondern, indem sie eine Risikoanalyse des Benutzers durchführen.

Sobald verdächtige Aktivitäten festgestellt werden, schränkt CAPTCHA Ihren Zugriff auf die Website ein und stellt sicher, dass die Informationen sicher sind.

- Robots.txt: Robots.txt-Dateien teilen den Crawlern mit, auf welche URLs sie innerhalb einer bestimmten Website zugreifen können.

Darin wird das Crawling-Limit angegeben, um eine Überlastung der Site mit Anfragen zu vermeiden, die zu einer Überlastung des Netzwerks führen. Bevor Sie also mit der Ausführung der Scraper-Bots beginnen, sind die robots.txt-Dateien, die Nutzungsbedingungen und die Datenschutzrichtlinie der Website wichtige Elemente, die Sie vorher überprüfen müssen.

Wenn Sie sich fragen, warum: Sie sind diejenigen, die den Zugriff auf die spezifischen Inhalte erlauben oder verweigern, die Sie aus den URLs entfernen müssen.

- IP-Blockierung: IP-Blockierungstechniken oder IP-Verbote sind Mechanismen, mit denen Websites die IP-Adressen ermitteln, von denen die Anfragen stammen.

Wenn festgestellt wird, dass häufig dieselbe IP-Adresse für Anfragen verwendet wird, kommt man zu dem Schluss, dass es sich um einen Web Scraper mit böswilliger Absicht handelt, der versucht, auf die geschützten Daten zuzugreifen und diese zu extrahieren.

Wenn Sie also dieser Jagd zum Opfer fallen, wird Ihnen der Zugriff auf diese Website entweder vorübergehend oder dauerhaft untersagt, geschweige denn deren Daten gelöscht.

Authentifizierung und Sitzungsverwaltung:

Viele Websites erfordern Anmeldeinformationen und möchten, dass Sie Sitzungscookies akzeptieren, um deren Inhalte durchsuchen zu können. Sie haben sich wahrscheinlich gefragt, warum.

Der einfache Grund, warum sie das tun, ist, dass sie sich an dich erinnern wollen. Sie sind dazu da, Ihr Online-Erlebnis durch Personalisierung und bequeme Website-Besuche zu verbessern.

Als Benutzer, der im Internet nach Antworten und Lösungen für bestimmte Fragen sucht, ist das das Coolste überhaupt.

Beim Web Scraping hingegen stellt dieses Verfahren zur Authentifizierung und Sitzungsverwaltung ein umständliches Hindernis für die Effizienz dar.

Das Ausfüllen von Anmeldeformularen mit gültigen Anmeldeinformationen für eine erfolgreiche Authentifizierung, nur um den benötigten Inhalt für jede Sitzung zu erreichen, kann den Scraping-Prozess erschweren.

Das mehrfache Senden von HTTP-Anfragen für denselben Inhalt verschlimmert das Problem zusätzlich. Dies verlängert den Datenextraktionsaufwand und führt zu Kontraproduktivität.

Es gibt viele andere Probleme wie Honeypot-Fallen, Browser-Fingerprinting, Änderungen der Website-Struktur, Skalierbarkeit und rechtliche Probleme. Auch wenn nicht alle dieser Herausforderungen einfach angegangen und gelöst werden können, hilft RPA bei der Bewältigung einiger dieser Herausforderungen.

Es gibt nur wenige Lösungen, um sie mit RPA zu überwinden

Die Integration der RPA-Technologie ist beim Web Scraping bahnbrechend, da sie Software-Roboter einsetzt, die Aufgaben ausführen, die menschliche Hilfe erfordern. Der Datenextraktionsprozess verläuft reibungsloser als je zuvor und weist nur geringe bis gar keine Unterbrechungen auf.

Umgang mit dynamischen Webseiten mit RPA:

Der oben erwähnte dynamische Webseiteninhalt erfordert eine Benutzerinteraktion mit der Benutzeroberfläche wie Scrollen und Klicken auf die Schaltflächen „Mehr anzeigen“ und „Zur nächsten Seite gehen“.

Der Umgang mit diesen GUI-Elementen ist mühsam, da sie den Datenextraktionsprozess verzögern.

Aber mit der robotergestützten Prozessautomatisierung können die programmierten Bots mit den Elementen umgehen, indem sie wie ein echter Benutzer mit ihnen interagieren.

Sie verwenden Techniken wie XPath, CSS-Selektoren oder Elementattribute, um Bots das Auffinden der dynamischen Elemente zu ermöglichen.

Darüber hinaus können Sie Headless-Browser wie Puppeteer integrieren, um JavaScript auf der Webseite zu rendern und auszuführen. Auf diese Weise können Bots Daten aus den dynamisch generierten Inhalten von Websites extrahieren, die eine Benutzerinteraktion erfordern.

Daher ist das Web-Scraping dynamischer Webseiten mit RPA-Bots einfacher.

Captcha- und Anti-Scraping-Mechanismen überwinden:

Es gibt mehrere kostenlose und kostenpflichtige Dienste von Drittanbietern, die Ihnen beim Lösen von CAPTCHAs helfen können. RPA-Bots können mithilfe von APIs solche CAPTCHA-Anfragen an diese Dienste senden.

Eine andere Lösung besteht darin, menschenähnliches Surfverhalten zu simulieren, beispielsweise zufällige Verzögerungen zwischen Anfragen. Eine Drosselung des Scrapings durch Begrenzung der Anzahl der Anfragen pro Minute kann integriert werden, um das Auslösen des Ratenlimits und der Anti-Bot-Sicherheiten zu vermeiden.

Ebenso rotieren die Bots IP-Adressen mithilfe von Proxys, um IP-Blockaden zu vermeiden. Darüber hinaus wird dadurch das unterschiedliche Surfverhalten der Nutzer abgebildet und das Entdeckungsrisiko verringert.

Um Anti-Scraping-Mechanismen zu überwinden, kombiniert RPA daher Proxy-Rotation, zufällige Verzögerungen, Anforderungsdrosselung und Captcha-Lösungsdienste.

Authentifizierung und Sitzungsverwaltung verwalten:

Wie bereits erwähnt, können Sie sich vorstellen, dass das Ausfüllen von Formularen und das Anmelden zur Überprüfung der Website bei jeder Anfrage für die Datenerfassung ineffizient ist.

Dennoch sind RPA-Bots da, um den Tag zu retten, indem sie den Anmeldevorgang automatisieren, indem sie Anmeldeinformationen in Website-Formulare eingeben.

Sie interagieren nahtlos mit GUI-Elementen wie Textfeldern und Schaltflächen, bei denen ein Benutzer seine Daten (meistens Benutzername und Passwort) eingeben und für VOLLSTÄNDIGEN Zugriff auf die Website (ja, sogar die eingeschränkten Bereiche der Website) übermitteln muss.

Sobald der Authentifizierungsprozess abgeschlossen ist, ist es an der Zeit, Sitzungscookies zu verwalten.

Bots stellen sicher, dass diese Sitzungscookies während des gesamten automatisierten Scraping-Prozesses erfasst und verwaltet werden.

Sie authentifizieren sich außerdem automatisch erneut, verhindern so den Ablauf der Sitzung und haben kontinuierlichen Zugriff, bis der Datenextraktionsprozess abgeschlossen ist.

Sie müssen sich also keine Gedanken über Authentifizierungsfehler machen, da RPA-Bots robuste Fehlerbehandlungs- und Wiederherstellungsmechanismen für die Authentifizierung und die Sitzungszeit implementieren.

Einwickeln:

So wie Sherlock Holmes einen Fall nicht halb gelöst lassen würde, stellt RPA sicher, dass alle wertvollen Daten sorgfältig extrahiert werden.

Durch die Automatisierung von Web-Scraping-Aufgaben gibt Ihnen RPA die Freiheit, sich auf die wirklichen Geheimnisse zu konzentrieren – die Interpretation der Daten und das Treffen strategischer Entscheidungen.

Setzen Sie also Ihren Deerstalker-Hut auf, starten Sie Ihre RPA-Tools und betrachten Sie Grepsr als Ihren vertrauenswürdigen Watson.

Mit seiner Expertise im RPA-integrierten Web-Scraping kann Grepsr das fehlende Element sein, das Sie brauchen, um verborgene Erkenntnisse im riesigen Web aufzudecken. Machen Sie sich bereit, Ihr Unternehmen auf die Erfolgsspur zu führen!