Herausforderungen beim groß angelegten Amazon Scraping

Wie jedes andere Unternehmen versucht Amazon, die unbefugte Datenextraktion mithilfe fortschrittlicher Techniken zum Schutz seiner Daten zu verhindern. Zu diesen Techniken gehören:

1. IP-Blacklisting

Es besteht eine hohe Wahrscheinlichkeit, dass Sie beim Scraping mehrere Anfragen stellen müssen, um Daten für mehrere Seitentypen bei Amazon zu erhalten. Leider wird Amazon diese Aktion erkennen, Ihre IP-Adresse auf die schwarze Liste setzen und sperren, wenn verdächtige Aktivitäten vorliegen oder in kurzer Zeit zu viele Anfragen gestellt werden.

2. Ratenbegrenzung

Wenn Amazon feststellt, dass Ihre IP-Adresse innerhalb eines bestimmten Zeitraums zu viele Anfragen sendet, markiert es Ihre Adresse automatisch. Dies liegt daran, dass Sie die Anzahl der Anfragen, die Sie innerhalb eines Zeitraums stellen können, überschritten haben. Das Überschreiten dieser Grenzwerte führt zu Verzögerungen oder vorübergehenden Sperrungen beim Zugriff auf ihre Website.

3. CAPTCHA-Systeme

Beim Besuch einiger Websites ist Ihnen möglicherweise ein Popup aufgefallen, in dem Sie aufgefordert werden, zu beweisen, dass Sie ein Mensch sind. Die meisten davon werden CAPTCHAs genannt. Amazon verwendet CAPTCHAs, um zu überprüfen, ob es sich bei Besuchern um Menschen handelt, und um Bot-ähnliche Aktivitäten zu verhindern. Diese Prüfungen erhöhen die Komplexität und erschweren es Bots, Daten erfolgreich zu durchsuchen.

Auch wenn Ihnen einige Herausforderungen einfach erscheinen mögen, ist es doch ein ziemlich schwieriges Unterfangen, das Verhalten einer Person beim Auflösen des CAPTCHAs nachzuahmen und die CAPTCHA-Herausforderung selbst programmgesteuert zu lösen.

4. Auf maschinellem Lernen basierende Bot-Erkennung

Damit Amazon einen Bot erfolgreich erkennen kann, nutzt es maschinelles Lernen, um Benutzerverhaltensmuster zu analysieren und so zwischen Menschen und Bots zu unterscheiden. Sobald eine ungewöhnliche Aktivität erkannt wird, wird der Bot automatisch daran gehindert, Daten zu extrahieren.

Warum benötigen Sie Proxys, um Amazon im großen Stil zu durchsuchen?

Um in großem Umfang erfolgreich Daten von Amazon zu extrahieren, benötigen Sie entweder einen Proxy oder ein spezielles Scraping-Tool.

Ein Proxy ist ein Vermittler zwischen Ihrem Gerät und dem Internet. Es funktioniert, indem es Ihre Anfragen über seine eigene IP-Adresse an die Website sendet, die Sie besuchen möchten. Wenn die Website antwortet, sendet der Proxy die Daten an Sie zurück.

Proxys spielen eine wichtige Rolle bei der Gewährleistung des kontinuierlichen Zugriffs auf Daten, indem sie Ihre wahre IP-Adresse verschleiern und einer Erkennung entgehen. Speziell, Wohn-Proxys sind für diesen Zweck effektiv, da sie sich in den regulären Datenverkehr integrieren, indem sie IP-Adressen verwenden, die von den Internetdienstanbietern (ISPs) echten Benutzern zugewiesen werden. Dies macht es für Amazon schwieriger, sie zu erkennen und zu blockieren, was eine bessere Datenextraktion ermöglicht.

Natürlich benötigen Sie mehr als eine IP-Adresse. Der beste Ansatz besteht darin, rotierende private Proxys zu verwenden, um die Arbeitslast auf Tausende oder sogar Millionen von IPs zu verteilen, wodurch es für die Bot-Blocker von Amazon schwieriger wird, Ihren Scraper zu identifizieren.

Top-Proxy-Anbieter für groß angelegtes Amazon Scraping

Um die fünf besten Proxy-Anbieter für großvolumiges Amazon-Scraping auszuwählen, haben wir uns entschieden, folgende Faktoren zu berücksichtigen:

- Spezifische Tools und Funktionen, die auf das Scraping von Amazon ausgerichtet sind

- Umgehungsmöglichkeiten

- Bewertungsergebnisse (G2 oder Trustpilot)

- Preise

Bevor wir uns näher mit den einzelnen Proxy-Anbietern befassen, hier ein kurzer Überblick für alle, die es eilig haben:

| Anbieter | Proxy-Typ | Poolgröße | Erfolgsquote | Verfahren | Preise | Zusätzliche Funktionen | Bewertungen |

| ScraperAPI | Vollständiges Scraping-Tool (Wohnbereich/Mobil/Rechenzentrum) | 40M+ | 99 %+ | Automatisiert | $/erfolgreiche Anfrage | CAPTCHA-Verwaltung, maschinelles Lernen (ML) | G2 – 4,27 Trustpilot – 4.7 |

| ProxyRack | Wohnen/Rechenzentrum | 2M+ | 96 % | Handbuch | 5 $/GB | Unbegrenzte Bandbreite, einfache Einrichtung | G2 – Null Trustpilot – 3.9 |

| ProxyLite | Wohnen/Rechenzentrum | 72M+ | 95 % | Handbuch | 1,20 $/GB | Erschwingliche Preise | G2 – Null Trustpilot – 4.6 |

| Soax | Wohnen | 151M+ | 99 % | Handbuch | 2,2 $/GB | Bereinigen Sie den IP-Pool | G2 – 4.8 Trustpilot – 4.7 |

| SmartProxy | Wohnen/Rechenzentrum | 65M+ | 99,99 % | Handbuch | 2,2 $/GB | Chrome-Proxy-Erweiterung | G2 – 4.6 Trustpilot – 4.6 |

| ProxyEmpire | Wohnen/Rechenzentrum | 100 Mio.+ | 99,9 % | Handbuch | 3 $/GB | Über 9,5 Millionen IPs | G2 – 5,0 Trustpilot – 4.7 |

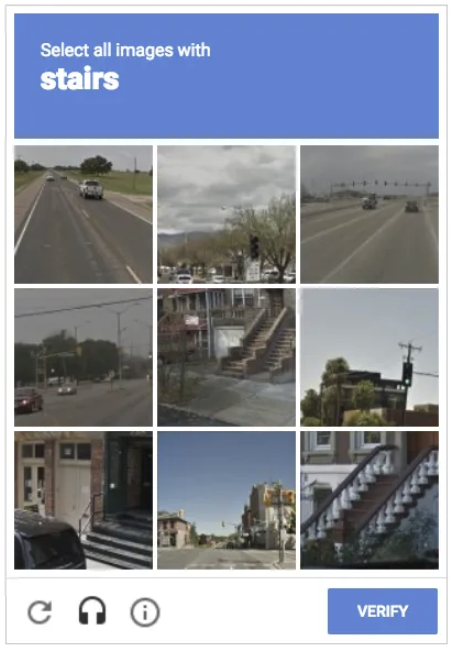

1. ScraperAPI (beste Proxys und Tools für große Amazon-Scraping-Projekte)

Um Amazon in großem Umfang effektiv zu durchsuchen, benötigen Sie ein automatisiertes All-in-One-Tool, da es Ihnen Zeit spart und es Ihnen ermöglicht, sich auf andere Aufgaben zu konzentrieren. Hier zeichnet sich ScraperAPI aus.

ScraperAPI ist ein All-in-One-Web-Scraping-Tool, das entwickelt wurde, um die Komplexität des Scrapings von Websites wie Amazon in großem Umfang mit minimalem Setup zu bewältigen. Im Gegensatz zu anderen Proxy-Diensten geht ScraperAPI noch einen Schritt weiter, indem es den gesamten Scraping-Prozess automatisiert, sodass Sie die Infrastruktur nicht selbst verwalten müssen.

ScraperAPI zeichnet sich aus zwei wichtigen Gründen als Top-Proxy-Anbieter für groß angelegtes Amazon-Scraping aus:

1. Dedizierte Amazon-Endpunkte für strukturierte Daten (SDEs)

Die Amazon SDEs von ScraperAPI sind dedizierte Endpunkte, die dazu dienen, Amazon-Produkt-, Such- und Rezensionsseiten in gebrauchsfertige JSON- oder CSV-Dateien umzuwandeln.

Mit einem einzigen API-Aufruf können Sie Details abrufen wie:

- Produktdetails wie Name, Preis, Anzahl der Bewertungen usw.

- Versandinformationen

- Suchrankings

- Produktsuchen

- Produktbewertungen

- Mehrere Angebote für dasselbe Produkt,

Und noch mehr, indem Sie zusammen mit Ihrer GET-Anfrage eine Suchanfrage oder eine Produkt-ID (basierend auf der von Ihnen verwendeten SDE) einreichen.

Möchten Sie unseren Amazon-Endpunkt testen? Erstellen Sie ein kostenloses ScraperAPI-Konto, um Zugriff auf Ihren API-Schlüssel zu erhalten, und kopieren Sie den folgenden Codeausschnitt, um ScraperAPI in Aktion zu sehen:

import requests

import json

payload = {

'api_key': 'YOUR_API_KEY', #add your API key here

'query': 'drawing pencils',

'country': 'us'

}

#send your request to scraperapi

response = requests.get(

'https://api.scraperapi.com/structured/amazon/search', params=payload)

products = response.json()

#export the JSON response to a file

with open('amazon-products.json', 'w') as f:

json.dump(products, f)

2. DataPipeline Amazon Scraping-Planer

DataPipeline ist der integrierte Scraping-Planer von ScraperAPI. Es ermöglicht Ihnen, den gesamten Scraping-Prozess von Anfang bis Ende mithilfe einer visuellen Schnittstelle oder dedizierter DataPipeline-Endpunkte zu automatisieren. Mit diesen Endpunkten können Sie Hunderte von Scraping-Projekten programmgesteuert erstellen, planen und verwalten, ohne sich bei Ihrem Dashboard anmelden zu müssen.

Was dieses Tool noch besser macht, ist seine Integration mit den Amazon SDEs von ScraperAPI. Mit diesen Tools können Sie wiederkehrende Amazon-Scraping-Jobs einrichten, um Produktseiten, Suchergebnisse, Produktbewertungen und mehr zu überwachen, ohne Hunderte von Stunden in den Aufbau oder die Wartung komplexer Infrastrukturen und Parser zu investieren.

Sie können auf Ihre extrahierten Daten in Formaten wie JSON, CSV oder über Webhooks zugreifen und so die Integration in Ihr Projekt vereinfachen.

Hauptmerkmale

- Maschinelles Lernen: ScraperAPI nutzt maschinelles Lernen und statistische Analysen, um den besten Proxy pro Anfrage auszuwählen, Header und Cookies zu generieren, die mit der IP-Adresse übereinstimmen und andere Komplexitäten bewältigen, um eine hohe Erfolgsquote sicherzustellen.

- Captcha-Handhabung und Umgehung von Anti-Bot-Mechanismen: ScraperAPI verarbeitet CAPTCHAs automatisch, indem es deren Auslösung verhindert – indem es Anfragen wiederholt, die eine CAPTCHA-Herausforderung auslösen – und die Anti-Bot-Mechanismen von Amazon ohne zusätzliche Konfigurationen umgeht.

- Geo-Targeting: ScraperAPI unterstützt geografisch ausgerichtete Proxys, sodass Sie auf regionalspezifische Amazon-Daten zugreifen und Benutzeranfragen von verschiedenen geografischen Standorten aus simulieren können.

- JS-Rendering: Ermöglicht das Scraping von Websites mit dynamischen Inhalten durch Rendering von JavaScript, um vollständig geladene Seiten zu erfassen. Seit neuestem bietet es auch die Möglichkeit, mithilfe von Rendering-Anweisungssätzen mit dynamischen Websites zu interagieren.

- Automatisierte Wiederholungsversuche: Automatische Wiederholung fehlgeschlagener Anfragen, um hohe Erfolgsraten zu gewährleisten und manuelle Eingriffe zu reduzieren.

- Premium-Proxy-Pool: Nutzt einen hochwertigen Pool von Privat-, Mobil- und Rechenzentrums-Proxys für maximale Zuverlässigkeit und geringere Entdeckungschancen.

- Desktop- und mobile Benutzeragenten: Ermöglicht Ihnen den Wechsel zwischen Desktop- und mobilen Benutzeragenten und ahmt das Surfverhalten in der realen Welt nach, um eine genauere Datenextraktion zu ermöglichen.

Preise

ScraperAPI verwendet ein unkompliziertes Preismodell, das auf erfolgreichen Anfragen basiert und im Vergleich zu Anbietern, die nach Bandbreite oder GB abrechnen, mehr Vorhersehbarkeit und Skalierbarkeit bietet.

Die Anzahl der verbrauchten Credits hängt von der Domain, dem Schutzniveau der Website und den spezifischen Parametern ab, die Sie in Ihrer Anfrage angeben.

Im Fall von Amazon, einer E-Commerce-Plattform, berechnet ScraperAPI 5 API-Credits pro erfolgreicher Anfrage, sodass Sie ganz einfach die Anzahl der Seiten berechnen können, die Sie mit Ihrem Plan scrapen können:

| Planen | Preise | API-Credits | Erfolgreiche Amazon-Anfragen |

| Kostenlose Testversion (7 – Tage) | – | 5000 | 1.000 |

| Hobby | 49 $ | 100.000 | 20.000 |

| Start-up | 149 $ | 1.000.000 | 200.000 |

| Geschäft | 299 $ | 3.000.000 | 600.000 |

| Unternehmen | Brauch | Brauch | Brauch |

Notiz: Besuchen Sie die Seite „Credits und Anfragen“ von ScraperAPI, um die Credit-Nutzung im Detail zu sehen.

2. ProxyRack (zuverlässige, schnelle und hochwertige Proxys)

ProxyRack ist ein zuverlässiger Proxy-Anbieter, der Ihnen eine Reihe von Proxy-Diensten, einschließlich Privat- und Rechenzentrums-Proxys, zur Verfügung stellt, was es zu einer guten Option zum Scrapen großer Datenmengen von Websites wie Amazon macht. Es stellt nicht nur Proxys für das Scraping bereit; Es bietet auch Proxys für verschiedene Branchen und Anwendungsfälle, wie zum Beispiel:

- Spielen

- Anzeigenüberprüfung

- Mehrfachanmeldung

- SEO-Überwachung

- Preisaggregation und -vergleich

Diese breite Anwendbarkeit macht ProxyRack zu einer flexiblen Lösung für einfache und komplexe Scraping-Aufgaben in allen Branchen.

Hauptmerkmale

- Ungemessene Bandbreite: ProxyRock ermöglicht eine uneingeschränkte Datennutzung ohne Bandbreitenbeschränkungen und eignet sich daher ideal für das Scraping großer Mengen.

- Proxys für Privathaushalte und Rechenzentren: Im Gegensatz zu anderen Proxys bietet Ihnen ProxyRack die Flexibilität, zwischen privaten (besser für die Anonymität) und Rechenzentrums-Proxys (schneller > 0,6 Sekunden, günstiger) zu wählen.

- Geo-Targeting: Das Geo-Targeting von ProxyRack wäre nützlich, wenn Ihre Aufgabe es erfordert, Daten von einem bestimmten Standort zu extrahieren.

- Rotierende Proxys: ProxyRack bietet Ihnen einen großen Pool von über 2 Millionen IPs an 140 Standorten, ideal für groß angelegte Datenextraktion und Crawling

- Flexible Preispläne: ProxyRack bietet Ihnen eine Reihe von Preisoptionen basierend auf Bandbreite, Anzahl der Ports oder gleichzeitigen Threads, was es sowohl für kleine als auch große Projekte praktisch macht.

Preise

Wenn Sie flexible Proxy-Dienste mit hoher Bandbreite und gleichzeitigen Threads benötigen, insbesondere für die Ausrichtung auf Amazon von mehreren geografischen Standorten aus, ist ProxyRack die kostengünstigste Option – nur übertroffen von den Angeboten von ScraperAPI.

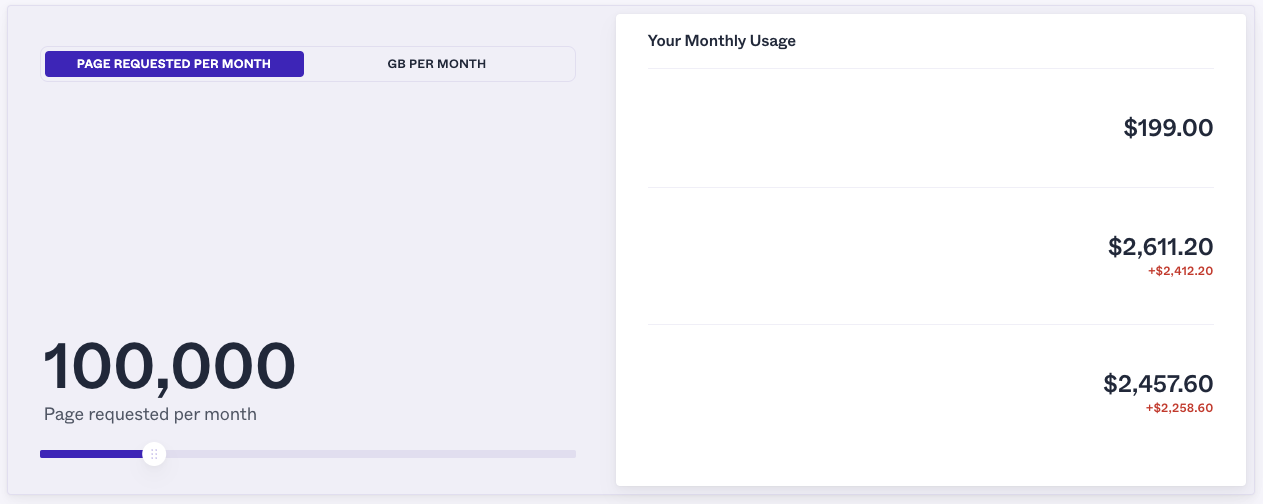

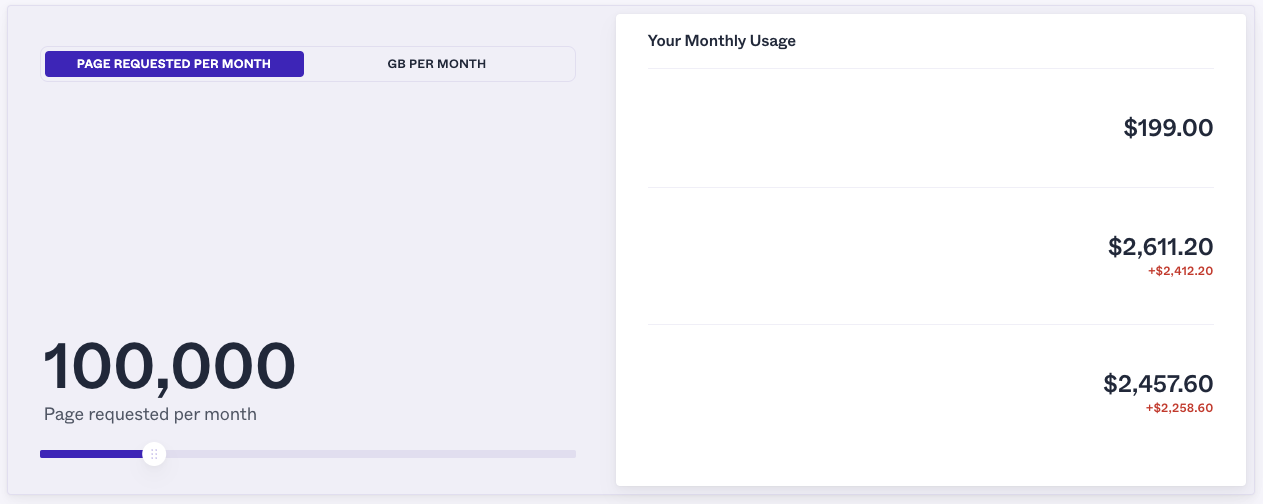

Obwohl es in vielen Fällen schwierig ist, Preismodelle pro Nutzung zu vergleichen, bietet ProxyRack ein einfaches Tool zur Berechnung der Kosten für die Verwendung von Privat-Proxys in Ihrem Projekt.

Das Tool springt jedoch von 100.000 Anfragen auf 1 Million Anfragen, sodass wir im Bereich von 100.000 erfolgreichen Anfragen bleiben müssen.

Wenn Sie ProxyRack verwenden, zahlen Sie 199 US-Dollar pro Monat für das Scrapen von bis zu 100.000 Seiten, während Sie mit dem ScraperAPI-Plan für 149 US-Dollar pro Monat bis zu 200.000 Amazon-Seiten scrapen können.

Notiz: Dies ist lediglich eine Schätzung, die auf dem Tool von ProRack basiert. Es ist jedoch nicht klar, was die anderen beiden Zahlen (2.611 $ und 2.457 $) bedeuten, da sie in der Dokumentation nicht erwähnt werden.

3. ProxyLite (wettbewerbsfähige Preise und anpassbare Pläne)

Ein weiterer Proxy-Anbieter, den Sie in Betracht ziehen sollten, wenn Sie versuchen, Daten von Amazon zu extrahieren, ist ProxyLite, ein kommerzieller Privat- und Static (ISP) Residential-Proxy-Anbieter, der Datenschutz und Leistung in den Vordergrund stellt. Es gewährleistet Anonymität und reduziert das Verbotsrisiko, was es ideal für sichere und zuverlässige Webaktivitäten macht.

Merkmale

- Wohn-Proxys: ProxyLite bietet Ihnen Zugriff auf einen großen Pool privater IP-Adressen, bietet hohe Anonymität und reduziert das Entdeckungsrisiko.

- Statische Wohn-Proxys: Möglicherweise sind Sie auf Aufgaben gestoßen, die stabile und langfristige IPs erfordern. Die statischen ProxyLite-Proxys für Privathaushalte versorgen Sie mit konsistenten IP-Adressen aus Heimnetzwerken, die statisch bleiben, und ermöglichen Ihnen das mühelose Scrapen von Daten.

- Globale IP-Abdeckung: Mit ProxyLite haben Sie Zugriff auf ein Netzwerk von über 72 Millionen IP-Adressen an verschiedenen Standorten weltweit und verbessern so die geografische Vielfalt und den Zugriff auf öffentliche Daten.

- Einfache Integration: ProxyLite stellt Ihnen gebrauchsfertige Endpunkte und APIs zur Verfügung, die den Integrationsprozess mit vorhandenen Systemen und Anwendungen vereinfachen.

Preise

Das ProxyLite-Preismodell basiert auf der Datennutzung (GB). Dies macht es für Großprojekte wie Amazon Scraping teurer als ScraperAPI.

| Planen | Preise |

| Wohn-Proxy | Ab 4 $ pro Monat (1,20 $/GB) |

| ISP-Proxy | Ab 5,50 $/IP |

| Unbegrenzte Wohn-Proxys | Ab 68,79 $ pro Tag |

4. Soax (sauberer Wohn-Proxy-Pool)

Soax ist ein Proxy-Anbieter mit verschiedenen Proxy-Typen, darunter Privat-, Mobil-, Rechenzentrums- und US-ISP-Proxys. Soax-Rechenzentrums-Proxys bieten große Vorteile in Bezug auf Geschwindigkeit, Betriebszeit und Skalierbarkeit und eignen sich daher für groß angelegtes Amazon-Scraping.

Merkmale

- Bereinigen Sie den Wohn-Proxy-Pool: Mit Soax erhalten Sie Zugriff auf einen ständig aktualisierten Pool privater IPs, wodurch eine hohe Anonymität gewährleistet und das Risiko von Sperren oder Sperren verringert wird.

- US-ISP-Proxy: Für Projekte, bei denen Sie eine IP über einen längeren Zeitraum verwenden müssen, bietet Soax zuverlässige statische IPs von in den USA ansässigen ISPs für konsistente und vertrauenswürdige Verbindungen.

- Mobile Proxys: Soax stellt Ihnen mobile Proxys zur Verfügung, die über echte mobile IPs rotieren, um echten mobilen Datenverkehr zu simulieren, ideal für standortspezifische Aufgaben.

- Rechenzentrums-Proxys: Schnelle und kostengünstige Proxys für Aufgaben, die eine schnelle und effiziente Datenextraktion erfordern.

- Web-Unlocker: Mit Soax Web Unlocker wird das Umgehen von CAPTCHAs und anderen Anti-Bot-Maßnahmen zum Kinderspiel und ermöglicht den uneingeschränkten Zugriff selbst auf die am besten geschützten Websites – allerdings bietet es keine dedizierten Endpunkte für Amazon.

Preise

Die fortschrittlichen Anti-Scraping-Systeme von Amazon machen es Scrapern schwer, Daten in großem Umfang mithilfe von Rechenzentrums-Proxys zu sammeln, da diese leicht identifizierbar sind und Ihr Scraper blockiert wird.

Bedenken Sie bei großen Amazon-Projekten, dass Sie hauptsächlich mit privaten und mobilen Proxys arbeiten müssen (wobei Sie standardmäßig mobile Proxys verwenden müssen, um Mehrausgaben zu vermeiden).

In diesem Szenario macht die intelligente Proxy-Rotation von ScraperAPI die Nutzung erschwinglicher und benutzerfreundlicher, da der gesamte Prozess für Sie automatisiert wird und die feste Struktur von 5 API-Credits pro erfolgreicher Anfrage beibehalten wird.

Hier ist die Kostenaufschlüsselung für die Wohnpläne von Soax:

| Planen | Verkehr | Preise/Monat |

| Wohnen 15 | 15 GB | 99 $ |

| Wohnen 29 | 29 GB | 179 $ |

| Wohnen 65 | 65 GB | 369 $ |

| Wohnen 15 | 150 GB | 739 $ |

6. SmartProxy (Kundensupport rund um die Uhr)

Ein weiterer idealer Proxy für das Scraping von Amazon ist SmartProxy, dank seiner E-Commerce-Scraping-API, die Proxys mit einem Web-Scraper und -Parser integriert und so eine hohe Erfolgsquote beim effizienten Extrahieren von Produktdaten, Preisen und Bewertungen gewährleistet.

Merkmale

- Proxys für Privathaushalte und Rechenzentren: Wie jeder gute Proxy bietet SmartProxy einen riesigen Pool an Privat-IPs und Rechenzentrums-Proxys für zuverlässiges, nicht erkennbares Scraping über verschiedene Websites hinweg, einschließlich E-Commerce-Plattformen.

- Kundensupport rund um die Uhr: Im Gegensatz zu Mitbewerbern bietet SmartProxy rund um die Uhr kostenlosen Kundensupport, der Sie bei allen Proxy-Problemen unterstützt, selbst wenn Sie das günstigste Paket abonnieren.

- Unbegrenzte Verbindungen und Threads: Sie können eine unbegrenzte Anzahl gleichzeitiger Verbindungen und Threads ausführen, was es ideal für große Scraping-Projekte macht.

- E-Commerce-Scraping-API: Die SmartProxy-API ist speziell auf das Scraping großer Websites wie Amazon zugeschnitten und kombiniert Web-Scraper und Parser mit Proxy-Management, um eine hohe Erfolgsquote zu gewährleisten.

- Rotierende Proxys: SmartProxy bietet Ihnen eine automatische IP-Rotation, die es Ihnen ermöglicht, mehrere Anfragen von verschiedenen IPs zu senden und so Blockaden und Drosselung beim Scraping zu verhindern.

Preise

Das Preismodell von SmartProxy ist relativ wettbewerbsfähig, insbesondere für Privat-Proxys, mit mehreren Plänen für unterschiedliche Datennutzungsniveaus.

Beispielsweise ist die Pay-As-You-Go-Preisgestaltung für Privat-Proxys flexibel, wenn Sie Proxys auf Abruf und ohne langfristige Bindung benötigen.

Allerdings verfügt die E-Commerce-API von SmartProxy über eine sehr klare Preisstruktur, die auf 1.000 Anfragen basiert und nur für erfolgreiche Anfragen bezahlt wird:

| Planen | Kosten/1.000 Anfragen | Preise/Monat |

| 15.000 Anfragen | 2 $ | 30 $ |

| 50.000 Anfragen | 1,60 $ | 80 $ |

| 100.000 Anfragen | 1,40 $ | 140 $ |

| 250.000 Anfragen | 1,20 $ | 300 $ |

Wie Sie sehen, wird SmartProxy ab 250.000 Anfragen pro Monat teurer als ScraperAPI – mit dem Sie bis zu 600.000 Amazon-Seiten für 299 US-Dollar durchsuchen können. Diese Lücke würde sich nur vergrößern, je größer das Projekt ist.

Dennoch ist es eine gute Wahl für Unternehmen, die an kleinen Projekten arbeiten.

7. ProxyEmpire (ermöglicht den Rollover ungenutzter Daten)

Ein weiterer erwähnenswerter Top-Proxy für groß angelegtes Amazon-Scraping ist ProxyEmpire. Es verfügt über eine unterschiedliche Auswahl an Proxys, darunter rotierende Proxys für Privathaushalte, statische Proxys für Privathaushalte und mobile Proxys, die für eine Vielzahl von Datenerfassungsaufgaben konzipiert sind.

Ihre rotierenden Privat-Proxys erstrecken sich über 170 Länder mit einem großen IP-Pool und hohen Erfolgsquoten, wodurch sie sich für Aufgaben wie Web Scraping, Preisüberwachung und SEO eignen.

Sie bieten auch dedizierte mobile Proxys für spezifische Anforderungen und Rechenzentrums-Proxys für kostengünstige, einfache Aufgaben – obwohl diese nicht für große Amazon-Scraping-Projekte geeignet sind.

Merkmale

ProxyEmpire bietet mehrere wichtige Funktionen, die auf verschiedene Online-Aktivitäten zugeschnitten sind, wie Web Scraping, Anzeigenüberprüfung und Preisüberwachung. Hier sind seine Hauptmerkmale:

- Rotierende Wohn-Proxys: ProxyEmpire bietet über 9 Millionen rotierende Privat-IPs in mehr als 170 Ländern mit geografisch präzisen Targeting-Optionen nach Land, Region, Stadt oder ISP und ist damit ideal für Aufgaben, die ein hohes Maß an Lokalisierung erfordern.

- Statische Wohn-Proxys: ProxyEmpire verfügt über statische Privat-Proxys, die in über 20 Ländern verfügbar sind, was sie ideal macht, wenn Sie eine dedizierte, stabile Privat-IP für eine längere Nutzung benötigen.

- Rotierende mobile Proxys: ProxyEmpire bietet über 5 Millionen mobile IPs mit 4G- und 5G-Optionen und bietet eine genaue Ausrichtung auf Mobilfunkanbieter für mehr Flexibilität bei Aufgaben wie der Anzeigenüberprüfung und der Automatisierung sozialer Medien.

- Rotierende Rechenzentrums-Proxys: ProxyEmpire bietet Ihnen eine budgetfreundliche Lösung für einfachere Scraping-Aufgaben mit über 40.000 IPs in mehr als 10 Ländern.

Preise

Genau wie andere Proxy-Dienste bietet ProxyEmpire eine Reihe von Preisplänen für private und mobile Proxys, basierend auf GB und Bandbreitennutzung. Ein einzigartiges Merkmal von ProxyEmpire ist die Rollover-Bandbreitenfunktion, die es ermöglicht, ungenutzte Daten in den nächsten Abrechnungszyklus zu übertragen, was einen Mehrwert für Benutzer mit schwankendem Datenbedarf darstellt.

| Planen | Preise |

| Rotierende Wohn-Proxies | Ab 3 $/GB |

| Statische Wohn-Proxys | Ab 2 $/IP und 3 $/GB |

| Rotierende mobile Proxys | Ab 8 $/GB |

| Dedizierte mobile Proxys | Ab 125 $/Monat |

| Rotierende Rechenzentrums-Proxys | Ab 0,35 $ pro GB |

Notiz: Für große Amazon-Scrapings sollten Sie es verwenden rotierende Wohn-Proxys mit rotierende mobile Proxys als Standard bei mehreren fehlgeschlagenen Anfragen.

Auswahl der richtigen Proxys für groß angelegtes Amazon Scraping

Die Auswahl des richtigen Proxys für ein Projekt wie groß angelegtes Amazon-Scraping ist wichtig, da Sie dadurch Zeit sparen und Ihre Aufgabe erleichtern können. Hier sind einige wichtige Merkmale, auf die Sie achten sollten, um die richtige Entscheidung zu treffen:

- Größe und Rotation des Proxy-Pools: Ihr Proxy sollte die IP-Adressen automatisch und regelmäßig wechseln. Durch IP-Rotationen können Sie das Entdeckungsrisiko minimieren und sicherstellen, dass Sie die Ratengrenzen einhalten. Bei einem großen Pool stehen Ihnen mehr Proxy-Optionen zum Rotieren zur Verfügung, sodass Sie bessere Chancen haben, Erkennungssysteme zu umgehen.

- CAPTCHA-Behandlung: Beim Scraping von Amazon muss ein guter Proxy oder ein gutes Scraping-Tool das Auslösen von Captchas vermeiden, um eine reibungslose Datenextraktion zu gewährleisten. ScraperAPI verarbeitet Captchas, indem es automatisch verhindert, dass Captchas überhaupt angezeigt werden.

- Anforderungswiederholungen: Bei vorübergehenden Blockaden oder Fehlern sollte Ihr Proxy in der Lage sein, fehlgeschlagene Anfragen erneut zu versuchen. Auf diese Weise können Sie ein kontinuierliches und zuverlässiges Scraping von Site-Daten durchführen.

- Erfolgsquote und Geschwindigkeit: Die ideale Proxy-Lösung sollte eine hohe Erfolgsquote bei Anfragen bieten und gleichzeitig Ausfallzeiten minimieren. Schnelle Proxys sorgen für eine effiziente Datenextraktion ohne unnötige Verzögerungen. Dies ist bei Großprojekten umso wichtiger, da eine kleine Verzögerung in der Größenordnung von Millionen von Anfragen zu Stunden oder sogar Tagen verlorener Zeit führen kann.

- Preismodelle: Proxy-Anbieter bieten unterschiedliche Preismodelle an, z. B. Abrechnung pro GB oder erfolgreiche Anfrage. Die richtige Wahl hängt vom Umfang Ihres Scraping-Projekts ab, wobei die Preisgestaltung pro erfolgreicher Anfrage oft zu einer besseren Kostenvorhersehbarkeit bei Großbetrieben führt.

- Geolokalisierungsunterstützung: Wenn Sie versuchen, standortspezifische Daten zu extrahieren, benötigen Sie einen Proxy mit Geolokalisierungsfunktionen, der Ihnen den Zugriff auf regionalspezifische Amazon-Daten ermöglicht. Wenn Sie beispielsweise die Produktpreise von Mitbewerbern in mehreren Ländern vergleichen möchten.

- Zusätzliche Funktionen: Eine gute Proxy-Lösung sollte erweiterte Funktionen wie integrierte CAPTCHA-Lösung, Sitzungsverwaltung und benutzerfreundliche Proxy-Verwaltungstools bieten. Diese Funktionen sorgen für einen reibungsloseren und effizienteren Schabeprozess mit minimalem manuellen Eingriff.

Der einfache Teil besteht darin, zu verstehen, welchen Bedarf Sie an diesen Funktionen haben. Beim Aufbau werden die Dinge für Sie komplex und zeitaufwändig. Sie können Zeit und Stress sparen, indem Sie ein bereits entwickeltes Tool wie ScapperAPI mit allen Funktionen verwenden, die Sie zum mühelosen Scrapen von Amazon im Allgemeinen benötigen.

Erstellen Sie zunächst ein kostenloses ScraperAPI-Konto, um auf Ihren API-Schlüssel zuzugreifen und 5.000 API-Credits für eine siebentägige Testversion zu erhalten, die beginnen kann, wann immer Sie dazu bereit sind.

Zusammenfassung: Warum ScraperAPI die beste Lösung für Amazon Web Scraping ist

ScraperAPI ist die beste Lösung für das Scraping von Amazon, da es den gesamten Scraping-Prozess durch die Bereitstellung eines vollständigen, automatisierten Pakets vereinfacht.

Im Gegensatz zu anderen Proxy-Diensten, bei denen Sie eine komplexe Scraping-Infrastruktur verwalten müssen, übernimmt ScraperAPI alles, sodass Sie sich auf die Datenextraktion konzentrieren können, ohne sich über technische Komplexität Gedanken machen zu müssen.

Lassen Sie uns auf die Hauptgründe eingehen, warum Sie ScraperAPI für Ihr nächstes Projekt in Betracht ziehen sollten:

1. Erfolgsquote und Zuverlässigkeit

ScraperAPI bietet aufgrund seiner erweiterten Funktionen eine der höchsten Erfolgsraten in der Branche. Durch die automatische Rotation von Proxys, die Verwaltung von CAPTCHA-Herausforderungen und die Wiederholung fehlgeschlagener Anfragen gewährleistet ScraperAPI eine unterbrechungsfreie Amazon-Datenextraktion.

2. Kosteneffizienz für Großbetriebe

ScraperAPI verfügt über ein einfaches Preismodell, das pro erfolgreicher Anfrage und nicht pro GB abrechnet, wodurch sich die Kosten einfach verwalten und prognostizieren lassen. Sie müssen sich keine Sorgen über Bandbreitennutzung oder unerwartete Kosten machen. Die vorhersehbaren Preise von ScraperAPI ermöglichen eine bessere Budgetplanung und Skalierbarkeit ohne Kompromisse bei der Leistung.

3. Automatisiert den gesamten Prozess

Neben Wiederholungsversuchen, CAPTCHAs und IP-Rotation optimiert ScraperAPI das Amazon-Scraping weiter, indem es dank seiner strukturierten Amazon-Datenendpunkte (SDEs) die Notwendigkeit reduziert, komplexe Parser zu erstellen und zu warten. Mit diesen Endpunkten können Sie Amazon-Daten im JSON- oder CSV-Format sammeln und so die Zeit für die Datenbereinigung verkürzen.

Gleichzeitig erleichtert der integrierte Planer (DataPipeline) die Planung und Verwaltung wiederkehrender Scraping-Jobs in wenigen Minuten, sodass Sie benutzerdefinierte Intervalle festlegen können.

4. Optimierung des maschinellen Lernens

ScraperAPI nutzt maschinelles Lernen, um die Scraping-Effizienz durch die Analyse und Optimierung jeder Anfrage zu verbessern. Es passt Proxys, Header, Cookies und Wiederholungsversuche basierend auf Echtzeitbedingungen an, um die Erfolgsraten zu maximieren und die Erkennung zu minimieren. Die maschinelle Lernfähigkeit von ScraperAPI sorgt für eine effiziente Ressourcennutzung, verringert das Risiko einer Blockierung und erhöht die Geschwindigkeit der Datenerfassung.

5. Komplettlösung

ScraperAPI bietet eine vollständige Scraping-Infrastruktur. Im Gegensatz zu typischen Proxy-Anbietern verwaltet ScraperAPI automatisch alle Aspekte des Scraping-Prozesses, einschließlich Proxy-Rotation, CAPTCHA-Lösung, erneute Anforderungsversuche, Benutzer-Agent-Verwaltung, Parsing und mehr, sodass Sie Amazon in großem Umfang scrapen können, ohne dass komplexe Setups oder Drittanbieter erforderlich sind -Party-Tools.