Durch die Straffung Ihrer Datenerfassungs- und Lieferprozesse können Sie die Vorgänge Ihres Teams verändern. Die Integration von Schäfer in Zapier entsperren leistungsstarke Workflow -Automatisierung, die den manuellen Aufwand verringert und die Effizienz erhöht. Mit diesem Setup können Sie Daten kratzen und die Ergebnisse direkt in Tools wie Google Sheets, Slack oder sogar Ihren CRM leiten, ohne komplexe Code für jeden Schritt zu schreiben.

In diesem Artikel werde ich Sie durch:

- Einrichten von Schaferapi und Zapier

- Automatisieren von Webflows mit Web -Scraps, um Zeit und Ressourcen zu sparen

- Beispiele in realer Welt, die praktische Anwendungsfälle dieser Integration zeigen

Am Ende haben Sie ein solides Verständnis für die Automatisierung von sich wiederholenden Datenaufgaben und befähigen Ihr Team, sich auf das zu konzentrieren, was am wichtigsten ist.

Bereit? Fangen wir an!

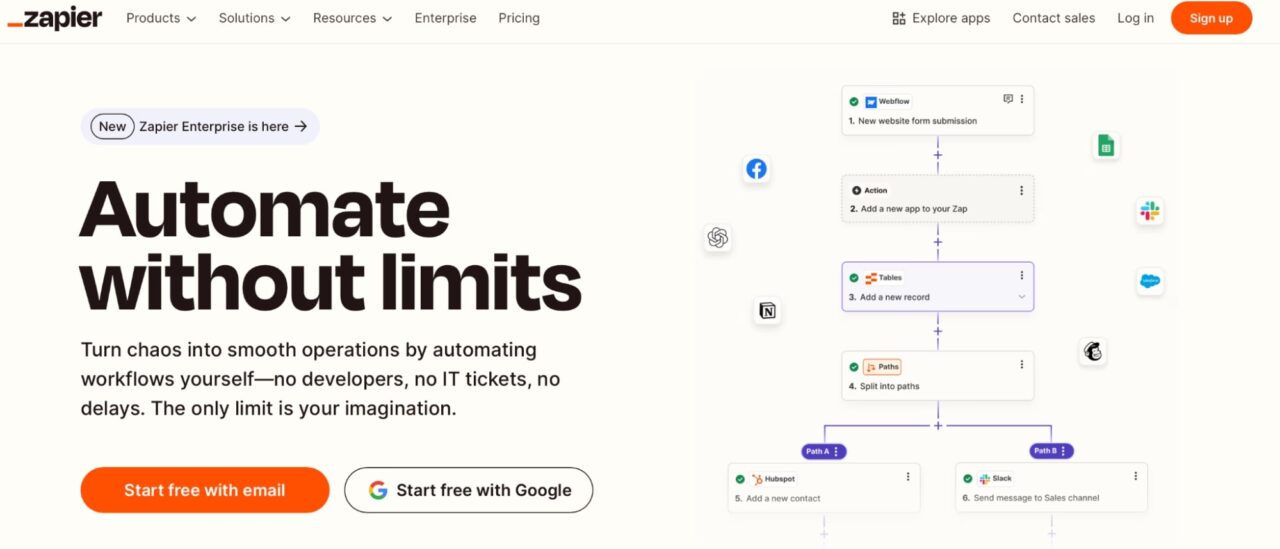

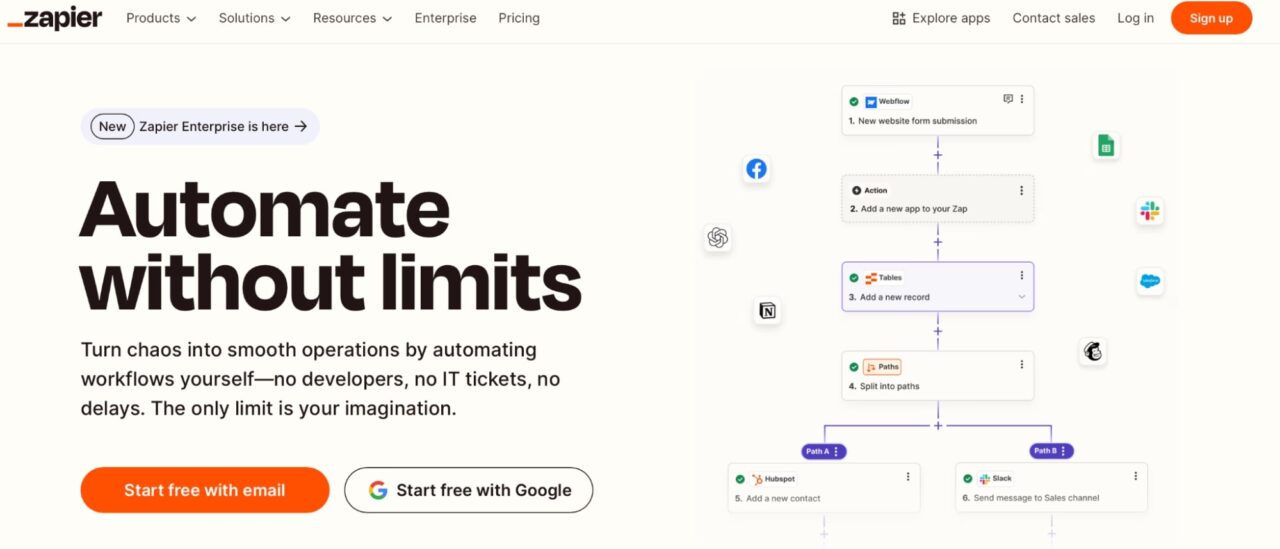

Was ist Zapier?

Zapier ist ein Automatisierungswerkzeug, das verschiedene Apps und Dienste verbindet, mit denen sie zusammenarbeiten können, ohne dass Codierungskenntnisse erforderlich sind. Es arbeitet mit einem Auslöser- und Aktions -Workflow, der als Zaps bezeichnet wird.

- A Auslösen ist eine Veranstaltung in einer App, die den Workflow startet.

- Ein Aktion Ist die Aufgabe, die Zapier als Reaktion auf den Auslöser ausgeführt wird.

Sie können beispielsweise ein ZAP erstellen, um neue Zeilen in einem Google -Blatt (Trigger) zu überwachen und diese Daten automatisch an Scraperapi zur Verarbeitung (Aktion) zu senden.

Scraperapi verbessert diesen Vorgang, indem es als Rückgrat für die Datenextraktion in Workflows fungiert. Durch das Verbinden von Scraperapi mit Automatisierungswerkzeugen wie Zapier integrieren Sie Web -Scraping -Aufgaben ohne manuelle Eingriff in Ihre automatisierten Workflows.

Zum Beispiel:

- Wenn eine neue Zeile zu einem Google -Blatt (Trigger) hinzugefügt wird, sendet Zapier die Daten der Zeile wie eine URL oder Parameter an Scraperapi (Aktion).

- Scraperapi verarbeitet dann die Anforderung, umgeht den Bot -Schutz und die Rückgabe der erforderlichen Daten in einem strukturierten Format.

- Diese Ausgabe wird an eine andere App gesendet, z. B. Slack, GoogleSheet oder ein Berichtstool, der den Zyklus abschließt.

Durch die Integration von Scraperapi in Zapier können Sie sich wiederholende Krabbungsaufgaben automatisieren, menschliches Fehler reduzieren und sich auf die Datenanalyse und Entscheidungsfindung anstelle der manuellen Datenerfassung konzentrieren.

Werkzeuge, die Sie benötigen (Voraussetzungen)

Um diesem Tutorial zu folgen, stellen Sie sicher, dass Sie Folgendes haben:

- Python installiert: Installieren Sie Python 3.x auf Ihrem Computer, wenn Sie es noch nicht haben. Sie benötigen auch einen Texteditor oder eine ide wie Vs Code oder Pycharm Code schreiben und ausführen.

- Grundlegendes Web -Scraping -Wissen: Ein allgemeines Verständnis von Web -Scraping und APIs hilft Ihnen dabei, das Beste aus diesem Leitfaden herauszuholen.

Während des Tutorials richten Sie auch Folgendes ein:

- Scraperapi -Konto: Sie erstellen ein kostenloses Scraperapi -Konto, um Daten zu verarbeiten.

- Zapier -Konto: Sie richten ein Zapier -Konto ein, um Workflows zu automatisieren und Tools nahtlos zu integrieren.

Sobald Sie bereit sind, lassen Sie uns eintauchen!

Integration von Schäfer in Zapier

Um Ihnen zu zeigen, wie einfach es ist, Scraperapi in Zapier zu integrieren, werden wir Reddit -Posts als Beispiel kratzen.

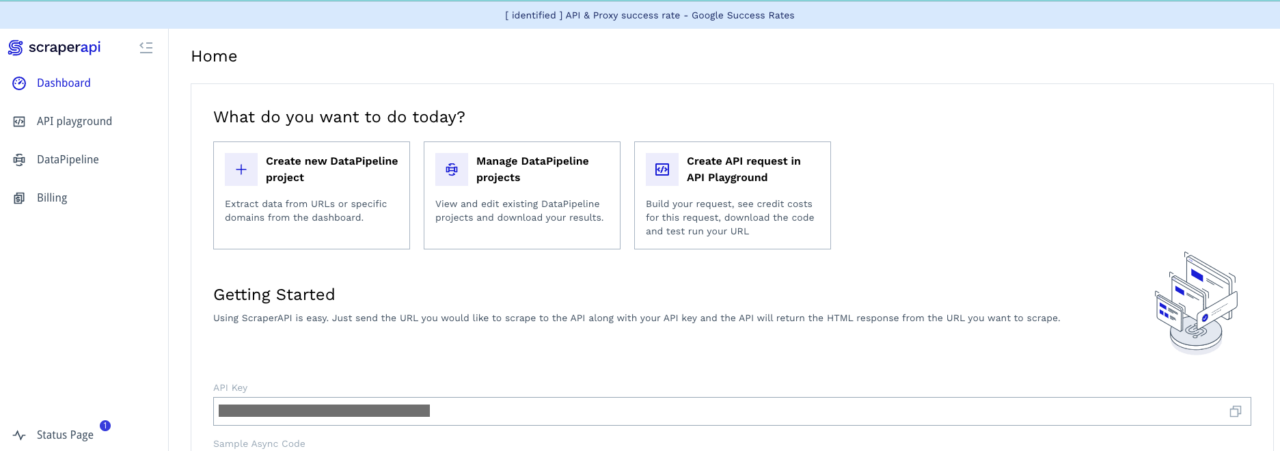

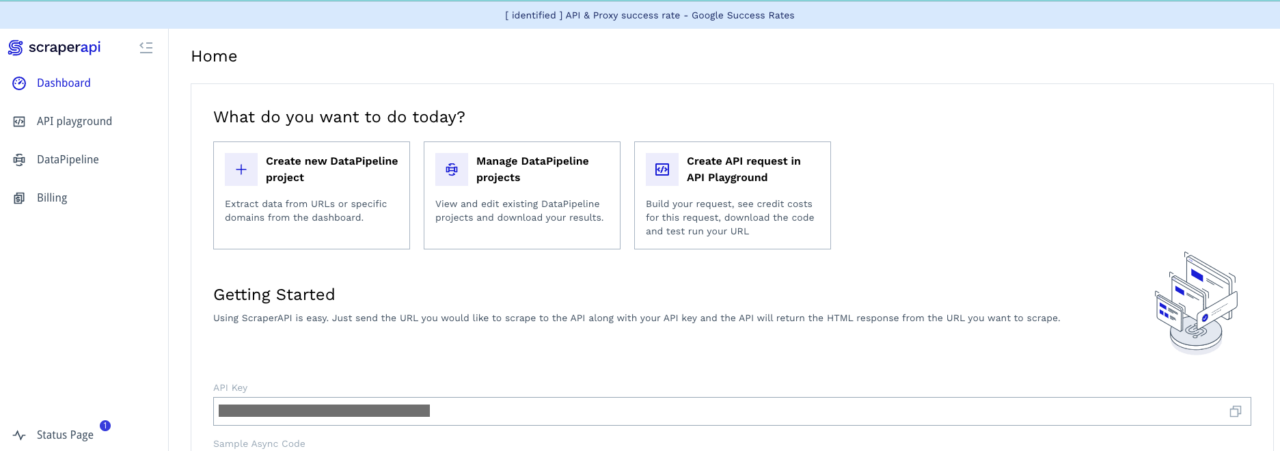

Schritt 1: Einrichten von Scraperapi

So erstellen Sie ein Schaferapi -Konto:

- Besuchen Sie die Scraperapi -Website und erstellen Sie ein kostenloses Konto.

- Greifen Sie nach der Registrierung über Ihre API -Taste aus dem Dashboard zu. Sie erhalten 5.000 kostenlose API-Gutschriften für eine sieben Tage Testversion.

- Bestätigen Sie Ihren API -Schlüssel und testen Sie Credits, um sicherzustellen, dass alles zur Integration bereit ist.

Damit ist es Zeit, unser Skript zu schreiben.

Schritt 2: Erstellen Sie die Flask -App

Wir werden diesen Leitfaden auf den Artikel „So kratzen Sie Reddit -Webdaten mit Python ab“ auf, in dem ich Schakerapi verwendet habe, um Reddit -Daten zu kratzen. Nehmen wir diesmal weiter, indem wir das Skript in eine Flask -App konvertieren, die die abgekratzten Daten im CSV -Format zurückgibt.

Notiz: Wenn Sie mit Web Scraping nicht vertraut sind, ist dies übrigens eine großartige Ressource, um loszulegen 😉

Hier ist eine direkte Erklärung der Flask-App:

- Route:

/scrape_postslöst den Scraping -Prozess aus. - Integration von Schakerapi: Die App holt Daten von Reddit mit dem Scraperapi ab.

- Datenverarbeitung: Extrahierte Beiträge werden mit BeautifulSoup analysiert und als CSV -Datei gespeichert.

- Antwort: Die App gibt die CSV -Datei an den Client zurück.

import os

from flask import Flask, request, jsonify, send_file

import json

import csv

from datetime import datetime

import requests

from bs4 import BeautifulSoup

app = Flask(__name__)

# ScraperAPI Key

scraper_api_key = 'YOUR_API_KEY'

# Route to scrape Reddit posts

@app.route('/scrape_posts', methods=('GET'))

def scrape_posts():

try:

reddit_query = "https://www.reddit.com/t/valheim/"

scraper_api_url = f'http://api.scraperapi.com/?api_key={scraper_api_key}&url={reddit_query}'

response = requests.get(scraper_api_url)

# Parse response content

soup = BeautifulSoup(response.content, 'html.parser')

articles = soup.find_all('article', class_='m-0')

parsed_posts = ()

for article in articles:

post = article.find('shreddit-post')

if post:

post_title = post.get('post-title', 'N/A')

post_permalink = post.get('permalink', 'N/A')

content_href = post.get('content-href', 'N/A')

comment_count = post.get('comment-count', 'N/A')

score = post.get('score', 'N/A')

author_id = post.get('author-id', 'N/A')

author_name = post.get('author', 'N/A')

subreddit_id = post.get('subreddit-id', 'N/A')

post_id = post.get('id', 'N/A')

subreddit_name = post.get('subreddit-prefixed-name', 'N/A')

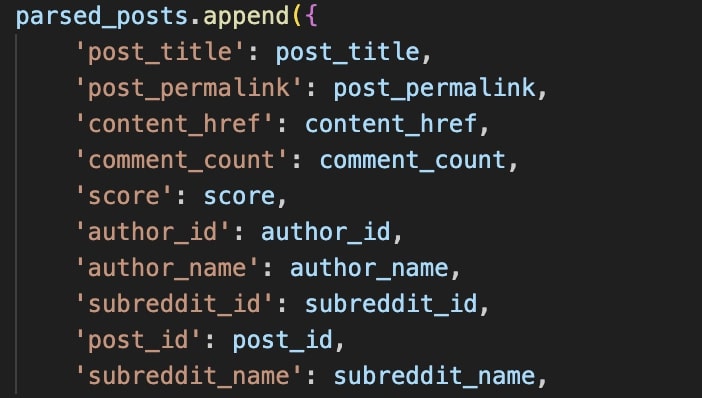

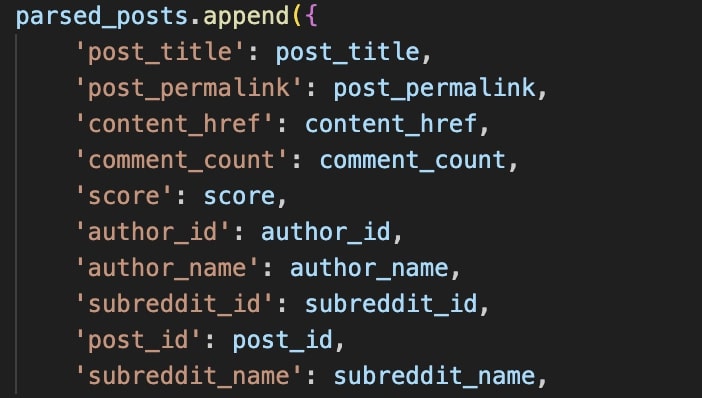

parsed_posts.append({

'post_title': post_title,

'post_permalink': post_permalink,

'content_href': content_href,

'comment_count': comment_count,

'score': score,

'author_id': author_id,

'author_name': author_name,

'subreddit_id': subreddit_id,

'post_id': post_id,

'subreddit_name': subreddit_name,

})

# Save to a CSV file

if parsed_posts:

csv_file_path = os.path.join(os.getcwd(), 'parsed_posts.csv')

# Write the CSV file

with open(csv_file_path, mode='w', newline='', encoding='utf-8') as csv_file:

fieldnames = parsed_posts(0).keys()

csv_writer = csv.DictWriter(csv_file, fieldnames=fieldnames)

csv_writer.writeheader()

csv_writer.writerows(parsed_posts)

# Return the CSV file as a response

return send_file(csv_file_path, mimetype='text/csv', as_attachment=True, download_name='parsed_posts.csv')

else:

return jsonify({"message": "No posts found to save"}), 200

except Exception as e:

return jsonify({"error": str(e)}), 500

if __name__ == '__main__':

app.run(port=5000)

Schritt 3: hosten die Flask -App

Zapier benötigt eine öffentlich zugängliche URL für die App. Das Hosting Ihrer Flask -App stellt sicher, dass sie immer verfügbar ist.

Hosting -Optionen:

- Pythonanywhere: Anfängerfreundlich mit kostenlosen und bezahlten Ebenen.

- Heroku: Flexibel und unterstützt Python -Apps.

- Machen: Einfache Einrichtung für Flask -Anwendungen.

Folgen Sie ihren offiziellen Führern, um Ihre Flask -App einzusetzen und die öffentliche URL zu erhalten. Für den Zweck dieses Artikels habe ich verwendet Pythonanywhere.

Kopieren und speichern Sie die öffentliche URL Ihrer App, da Sie sie während der Integration verwenden.

Schritt 4: Erstellen Sie einen Workflow (ZAP) in Zapier

Um diesen Workflow zu erstellen, stellen Sie sicher, dass Ihre Python -App funktioniert und Sie über ein aktives Zapier -Konto verfügen. Melden Sie sich in Ihrem Zapier -Konto an und beginnen wir !!!

1. Wählen Sie eine Trigger -App aus

- Klicken Sie in Ihrem Zapier -Dashboard in der oberen rechten Ecke auf die Schaltfläche Erstellen und wählen Sie den automatisierten ZAP -Workflow aus, um Ihren Workflow zu erstellen.

Sie sollten wie dieses ein Dashboard sehen:

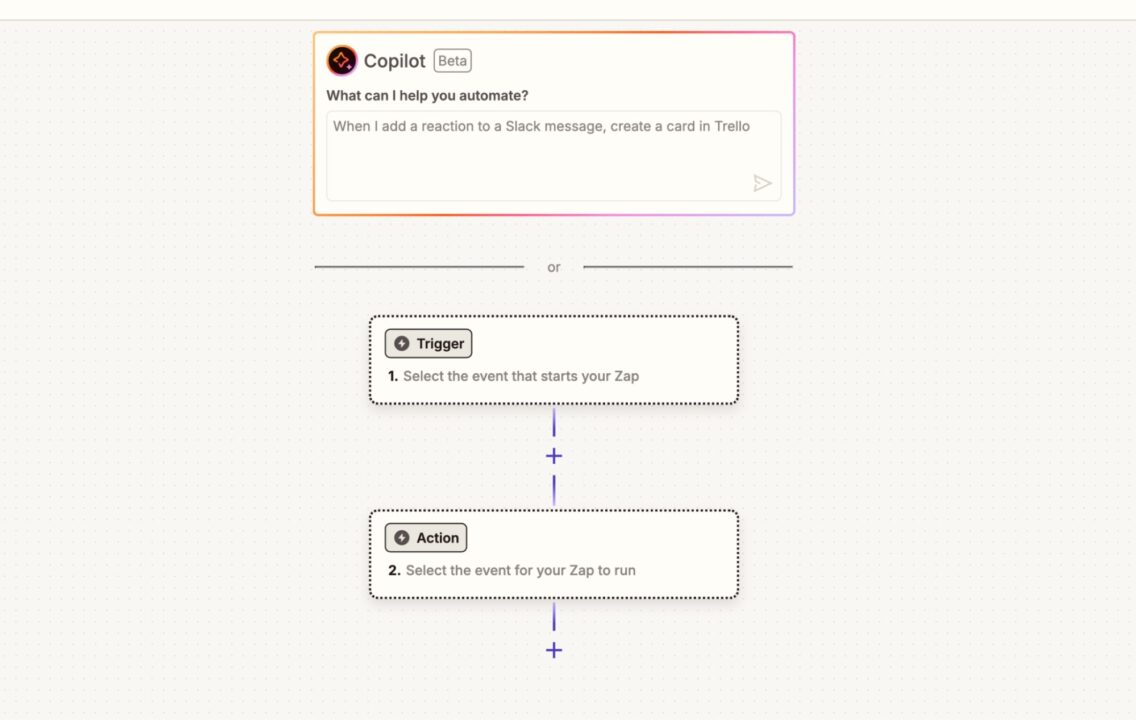

- Klicken Sie auf die Schaltfläche Trigger und wählen Sie Webhooks aus

- Wählen Sie Catch Hook als Triggerereignis aus

- Klicken Sie auf fort und testen Sie Ihren Abzug

Wenn Ihr Zapier -Trigger nicht funktioniert, können Sie ihn manuell testen, indem Sie eine Anfrage aus dem Webhook -Endpunkt Ihrer Python -App senden oder den Code überall ausführen und die Quittung in Zapier überprüfen.

import requests

webhook_url = "Your Zapier Webhook URL"

#Your Column Header

data = {

"csv_content": "post_title,post_permalink,content_href,comment_count,score author_id,author_name,subreddit_id,post_id,subreddit_name"

}

response = requests.post(webhook_url, json=data)

print(response.status_code)

print(response.text)

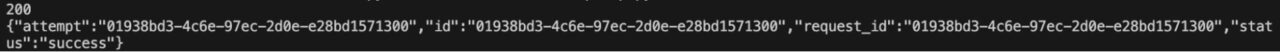

Wenn alles funktioniert, sollten Sie den Erfolg wie folgt sehen:

Gehen Sie zurück und testen Sie Ihren Auslöser erneut, und es sollte perfekt funktionieren.

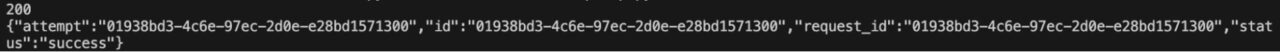

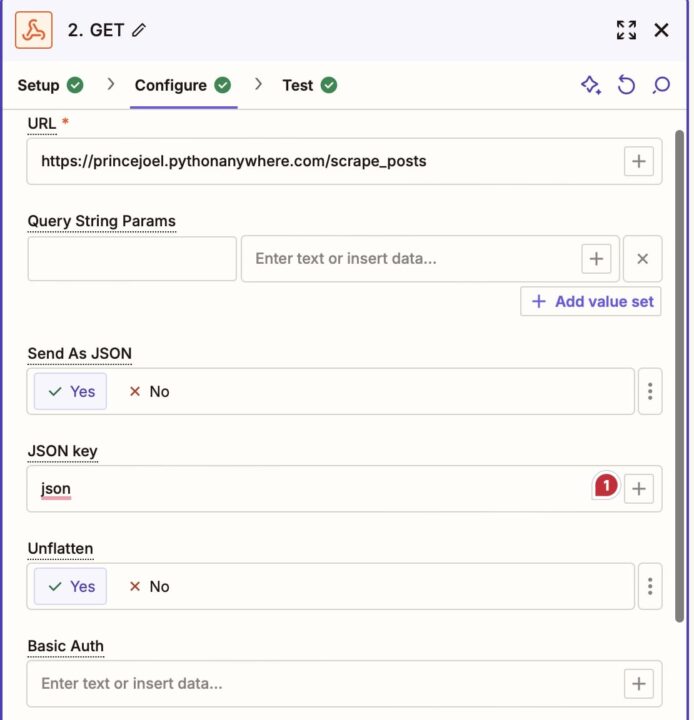

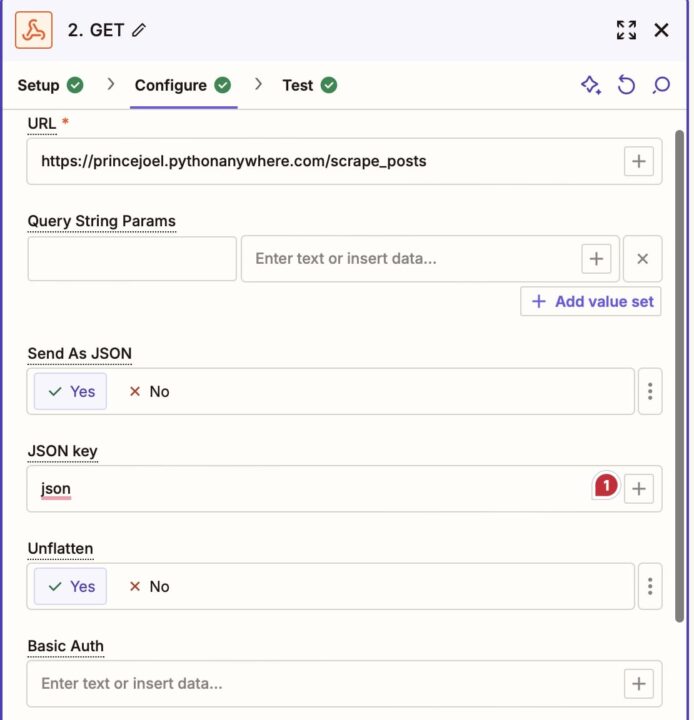

2. Konfigurieren Sie Scraperapi als Aktions -App

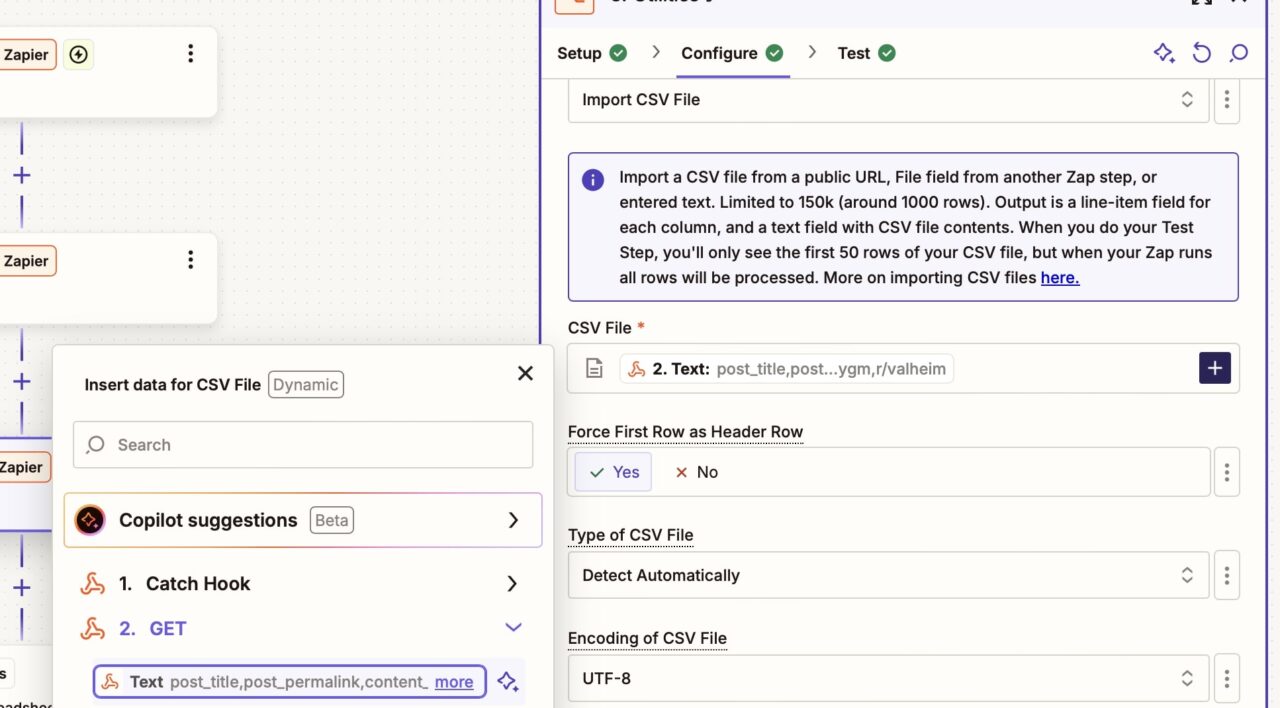

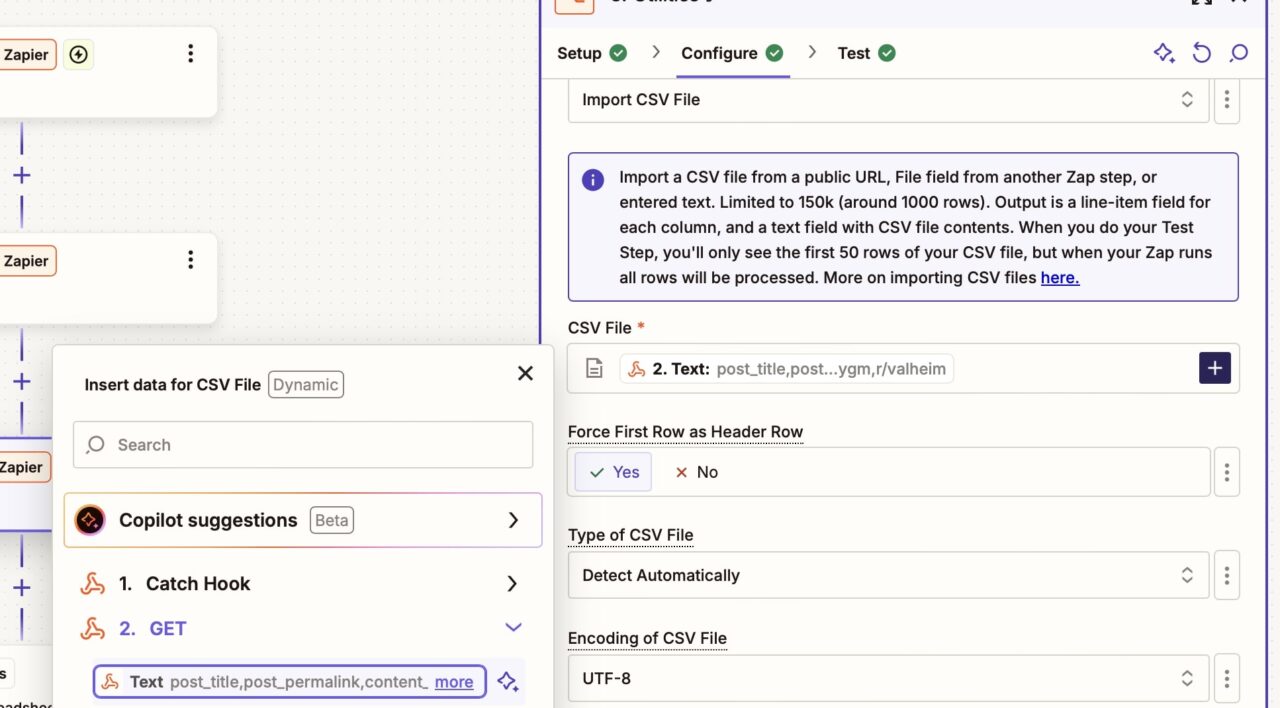

- Klicken Sie auf die Aktionstaste und wählen Sie Webhooks aus

- Wählen Sie die Anfrage als Aktionsereignis erhalten

- Klicken Sie auf Konfigurieren und betreten Sie Ihre gehostete Python -App -URL in dem bereitgestellten Raum. Sie können die anderen Parameter ignorieren oder ausfüllen, wie im Bild unten zu sehen ist.

- Klicken Sie auf Prüfen und testen Sie Ihre Aktion. Es sollte perfekt funktionieren und Sie werden eine grüne Zecke sehen.

Nachdem Sie Ihren Workflow ausgelöst und Daten mit Schakerapi durch Aufrufen Ihrer Aktion ausgelöst haben, ist es an der Zeit, Ihre Daten auszugeben, damit keine Entwickler problemlos darauf zugreifen können.

Sie können Ihre Daten über verschiedene Kanäle wie Google Sheets, Slack, Begriff usw. ausgeben. Für diesen Leitfaden geben wir unsere abgekratzten Daten in Google Sheets aus. Sie können dies tun, indem Sie zwei weitere Schritte erstellen:

- A Formatierer von Zapier, um die CSV -Daten zu analysieren und

- A Google -Blätter Aktion zum Senden der abgekratzten Daten an Ihre Google -Blätter

3. analysieren Sie die CSV -Daten

- Klicken Sie auf das Plus -Symbol, um eine Aktion hinzuzufügen

- Klicken Sie auf die Aktion Schaltfläche und auswählen Formatierer

- Wählen Versorgungsunternehmen Als Ihr Aktionsereignis

- Gehen Sie zu Konfigurieren und geben Sie Ihre CSV -Datei ein. Klicken Sie dazu auf das Plus -Symbol, wählen Sie ERHALTENund wählen Sie die Textdatei aus, die Ihre abgekratzten Daten sind.

- Klicken Sie auf Weiter und testen Sie Ihre Formatierer

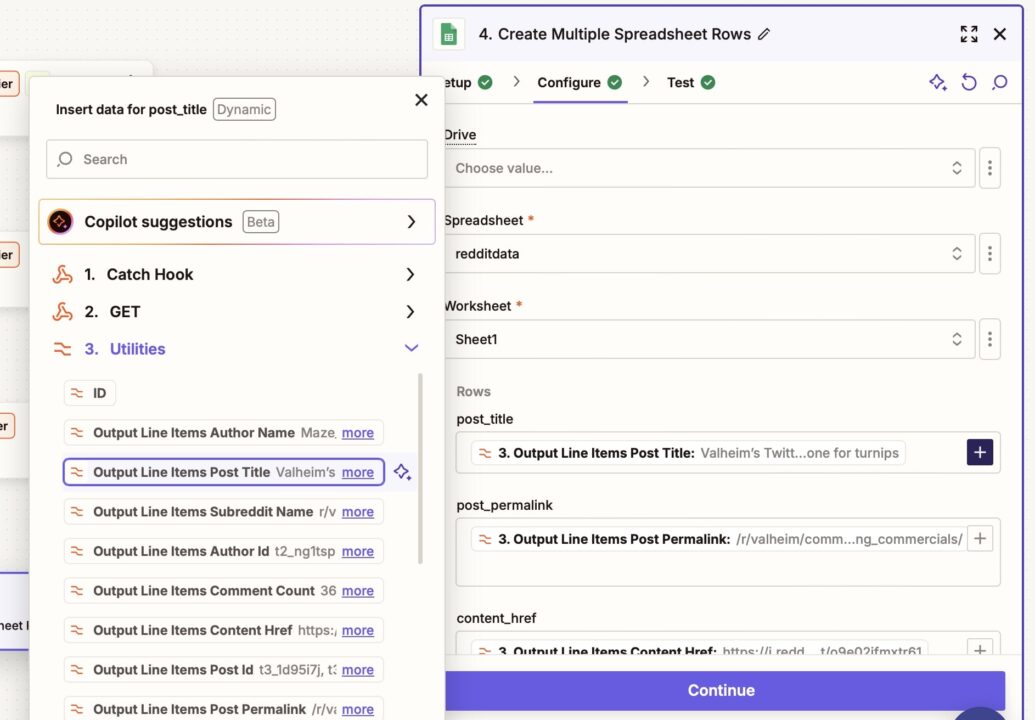

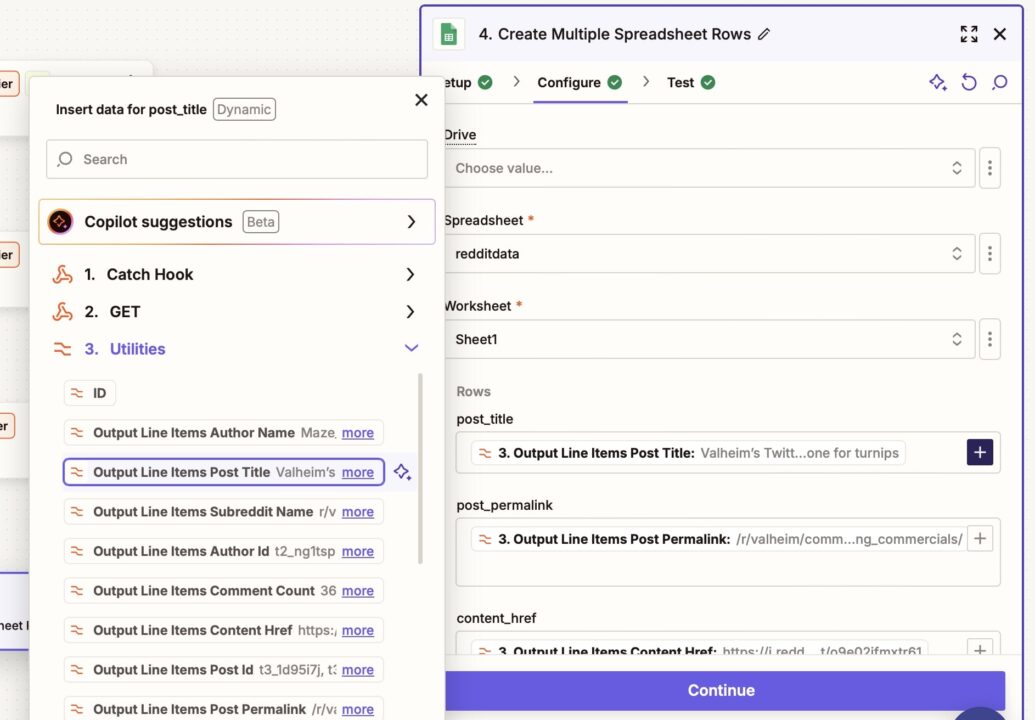

4. Wählen Sie Ausgabe App:

Es ist Zeit, die abgekratzten Daten automatisch an Google Sheets zu senden, um eine einfache Zugänglichkeit zu erhalten:

- Klicken Sie auf das Plus -Symbol, um eine Aktion hinzuzufügen

- Klicken Sie auf die Aktion Schaltfläche und auswählen Google -Blätter

- Wählen Erstellen Sie 'Mehrere Tabellenzeilen' Als Ihr Aktionsereignis

- Fügen Sie Ihre hinzu Google -Blätter Konto

- Geh zu deinem Google -BlätterErstellen Sie ein leeres Blatt, kennzeichnen Sie entsprechend und geben Sie die Header -Parameter ein. Es sollte mit der Anzahl der abgeschlichenen Spalten entsprechen.

- Kehren Sie danach zu Ihrem Zapier zurück und konfigurieren Sie Ihre Google -Blätter.

- Ordnen Sie Ihre ab Kalkulationstabelle zu dem Neue Tabelle Sie haben gerade erstellt und das Blatt ausgewählt, das Sie verwenden möchten

- Zeichnen Sie Ihre Zeilen entsprechend ab, indem Sie auf das Plus -Symbol rechts klicken. Klicken Sie auf Versorgungsunternehmen und zeichnen Sie jede Ausgabe in die richtige Zeile ab.

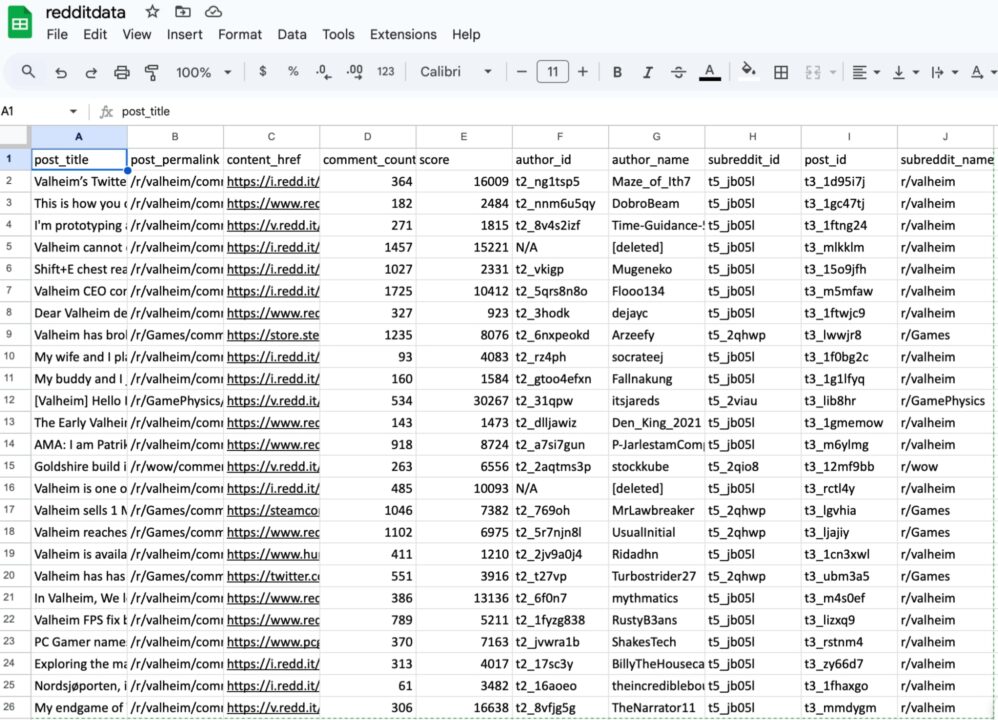

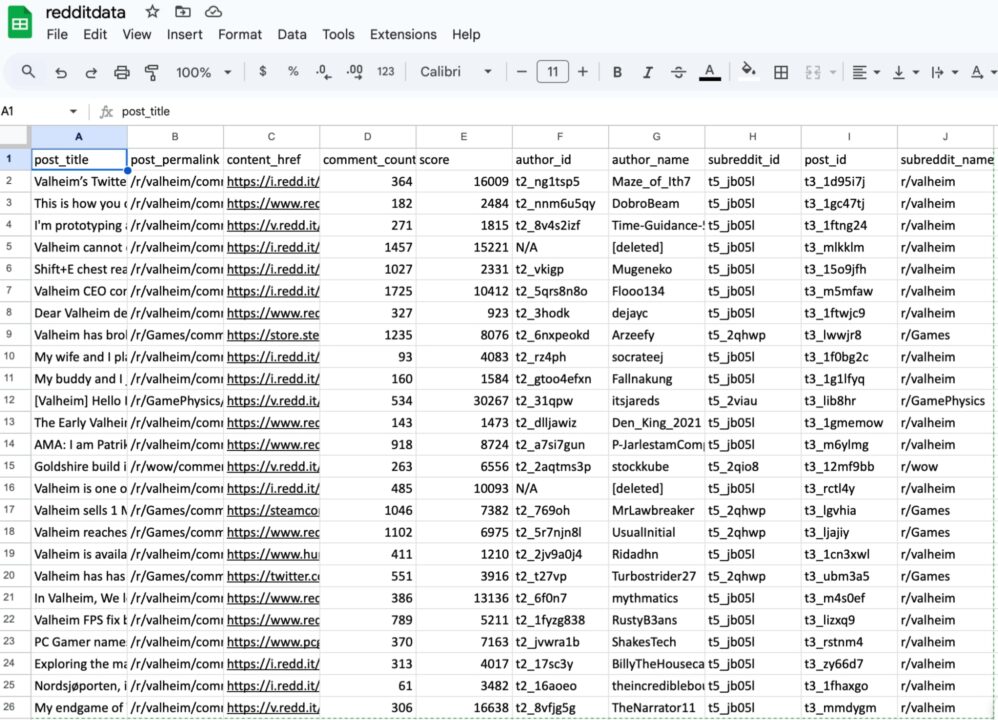

- Klicken Sie auf Weiter und testen Sie Ihre Aktion. Ihre abgekratzten Daten sollten automatisch in Ihrem Google -Blatt angezeigt werden.

Schritt 5: Testen und finde den Workflow ab

Führen Sie die gesamte Zap Workflow, um sicherzustellen, dass alles wie erwartet funktioniert. Sie können nach Bedarf zusätzliche Schritte hinzufügen, z. B. das Senden von Benachrichtigungen.

So sollten die extrahierten Daten in Ihren Google -Blättern aussehen. Dies macht Daten für Ihr Team leicht zugänglich.

Dieses Projekt zeigt, wie Scraperapi in andere Tools integriert werden kann. Sie können es für größere Projekte skalieren und Ihre Daten mit nur wenigen Klicks mit Zapier aktualisieren. Dieser Ansatz reduziert sich wiederholende Aufgaben und erhöht die Zugänglichkeit der Daten, sodass Datenfachleute Erkenntnisse extrahieren und schnell eine bessere Entscheidungsfindung vorantreiben können.

Anwendungsfälle für Schakera- + Zapier -Integration

Bevor Sie gehen, finden Sie hier einige potenzielle Anwendungsfälle für diese Integration, um Ihre Ideen zum Fließen zu bringen:

1. Scraping Reddit -Beiträge und senden Sie sie an Google Sheets

Objektiv: Automatisieren Sie den Prozess des Sammelns wertvoller Reddit -Diskussionen, Erkenntnisse und Leads aus bestimmten Subreddits und senden Sie die extrahierten Daten an Google Sheets zur Verfolgung, Analyse und Zusammenarbeit.

Wie es funktioniert:

1. Datenerfassung über Scraperapi

- Scraperapi extrahiert Reddit -Beiträge aus gezielten Subreddits und sammelt Details wie:

- Posttitel – Die Überschrift des Reddit -Posts.

- Post -URL – Direkter Link zum Beitrag als einfache Referenz.

- Kommentarzahl – Anzahl der Kommentare zum Beitrag.

- Punktzahl – Die Aufpackungen auf dem Posten, die als Popularitätsindikator dienen können.

- Autoreninfo – Benutzername der Person, die den Beitrag erstellt hat.

- Subreddit -Name – Name des Subreddits, in dem der Posten gefunden wurde.

2. Datenübertragung über Zapier

- Sobald Scraperapi die Daten kratzt, a Zapier Webhook wird ausgelöst, um die extrahierten Postdaten zu senden.

- Zapier -Formatierer Pariert die vom Scraperapi Webhook empfangenen CSV- oder JSON -Daten.

3.. Export auf Google -Blätter exportieren

- Zapiers Google Sheets Aktion Erstellt oder aktualisiert Zeilen in einer bestimmten Tabelle.

- Jede Zeile repräsentiert einen einzelnen Reddit -Beitrag mit Spalten für den Titel nach dem Titel, die Post -URL, die Kommentarzahl, die Punktzahl, der Autor und den Namen von Subreddit.

Vorteile:

- Einfach Reddit -Daten in Google Sheets anzeigen, zu analysieren und zu verfolgen.

- Automatisieren Sie alles vom Schaber bis zum Exportieren ohne manuelle Datenbehandlung.

- Teams können auf Live -Google Sheets -Daten für Strategie, Analyse und Berichterstattung zugreifen und sie verwenden.

- Beseitigt die Notwendigkeit manueller Datenkratzen und Aktualisierungen von Blättern.

2. sammeln automatisch E-Commerce-Produktpreise und speichern Sie sie in Google Sheets

Objektiv: Überwachen Sie die Preise für Wettbewerber oder verfolgen dynamische Produktpreise von E-Commerce-Plattformen wie Amazon oder Shopify.

Wie es funktioniert:

- Scraperapi kratzt Produktdaten, einschließlich Namen, Preise, Verfügbarkeit und URLs.

- Die abgekratzten Daten werden an einen Zapier -Webhook gesendet.

- Zapier überträgt die Daten in Google Sheets, aktualisiert Zeilen in Echtzeit oder füge neue hinzu.

Notiz: Sie können auch eine Tabelle erstellen, in der Produkt -URLs an Scraperapi gesendet werden und einen neuen Schickzyklus dynamisch auslösen.

Vorteile:

- Automatisiert die Preisverfolgung, um aktuelle Markteinblicke zu gewährleisten.

- Beseitigt die manuelle Dateneingabe.

3.. Senden von Scraped Leads zu einem CRM wie HubSpot

Objektiv: Automatisieren Sie die Lead -Generierung, indem Sie Geschäftsverzeichnisse, soziale Medien oder Überprüfungsplattformen (z. B. LinkedIn, Yelp) abkratzen.

Wie es funktioniert:

- Scraperapi sammelt Lead -Details (z. B. Namen, E -Mails, Unternehmensdetails und Websites).

- Daten werden an Zapier gesendet, das Kontakte in HubSpot erstellt oder aktualisiert.

Vorteile:

- Ermöglicht eine nahtlose Leitförderung, indem CRM-Daten vorbestimmt werden.

- Reduziert die manuelle Anstrengung beim Import und Sortieren von Leads.

4. Warnteams durch Slack über neue abgekratzte Erkenntnisse aufmerksam

Objektiv: Liefern Sie kritische Kratzdaten in Echtzeit an Teams.

Wie es funktioniert:

- Scraperapi extrahiert Daten wie Kundenfeedback, Markttrends oder Aktualisierungen des Wettbewerbers.

- Zapier sendet Benachrichtigungen an bestimmte Slack -Kanäle.

Vorteile:

- Stellt sicher, dass die Teams über zeitempfindliche Erkenntnisse ohne Verzögerungen aufmerksam gemacht werden.

- Zentralisiert Kommunikation und Zusammenarbeit.

Einpacken

Diese Anleitung lieferte eine Schritt-für-Schritt-Thrombough zur Integration von Schaferapi in Zapier, um die Datenerfassung und Workflow-Prozesse zu automatisieren. Hier ist, was wir behandelt haben:

- Einrichten der Integration: Konfigurieren von Scraperapi und Zapier so nahtlos funktionieren.

- Bauarbeitsabläufe: Kratzen Sie Daten von Websites und geben Sie sie direkt in Tools wie Google Sheets, Slack oder CRMS weiter.

- Anwendungsfälle realer Welt: Wir haben praktische Anwendungen untersucht, die Ihre Vorgänge effizienter machen, von Preisverfolgung bis hin zu Lead -Generierung- und Teambenachrichtigungen.

Als wir diese Reise in die Workflow -Automatisierung abschließen, hoffen wir, dass Sie inspiriert sind, die Kraft von Schakerapi und Zapier zu nutzen, um sich wiederholende Aufgaben zu vereinfachen, Zeit zu sparen und die Produktivität zu verbessern.

Denken Sie daran, dass Automatisierung nicht nur ein Tool ist, sondern eine Strategie für den Erfolg der Skalierung.

Bis zum nächsten Mal glücklich zu automatisieren!