Die Web-Datenextraktion großer Datenmengen ist mit internen Funktionen nahezu unmöglich. Erfahren Sie, warum Sie einen externen Datenanbieter benötigen.

Wenn Sie jemals einige Datenpunkte von einer bestimmten Website zur späteren Analyse in Ihre Tabelle kopiert haben, haben Sie vermutlich Web Scraping durchgeführt. Aber das ist eine wirklich rudimentäre Art und Weise, es zu tun.

Wenn die Dinge etwas mühsam werden, können Sie sich jederzeit dafür entscheiden, einen Crawler zu bauen und ihn die Arbeit für Sie erledigen zu lassen. Was ist also eigentlich der Sinn eines externen Datenanbieters? Sollten wir diesen Artikel ruhen lassen und uns besseren Dingen zuwenden?

Natürlich nicht. Der Aufbau eines Crawlers ist der einfachste Teil der Webdatenextraktion. Wenn die Projektanforderungen steigen und die schiere Datenmenge eine ernsthafte Herausforderung darstellt, stoßen Sie auf unüberwindbare Hürden.

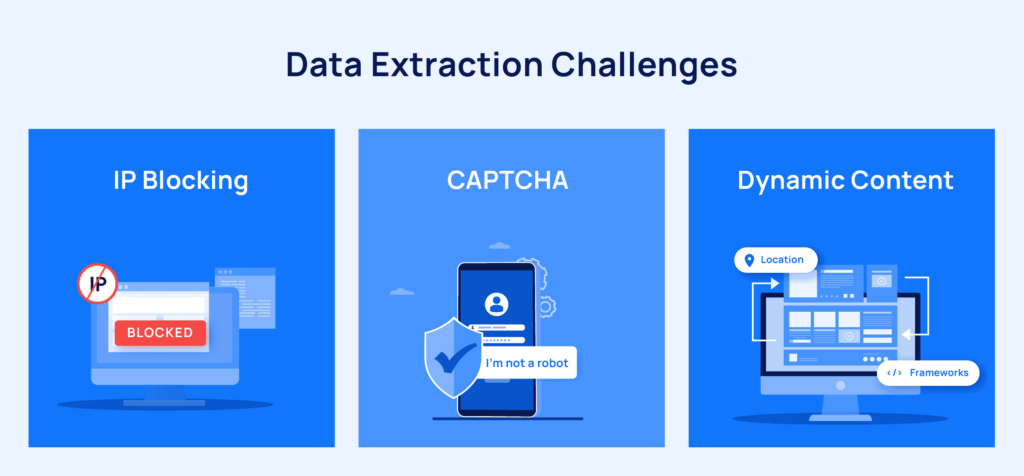

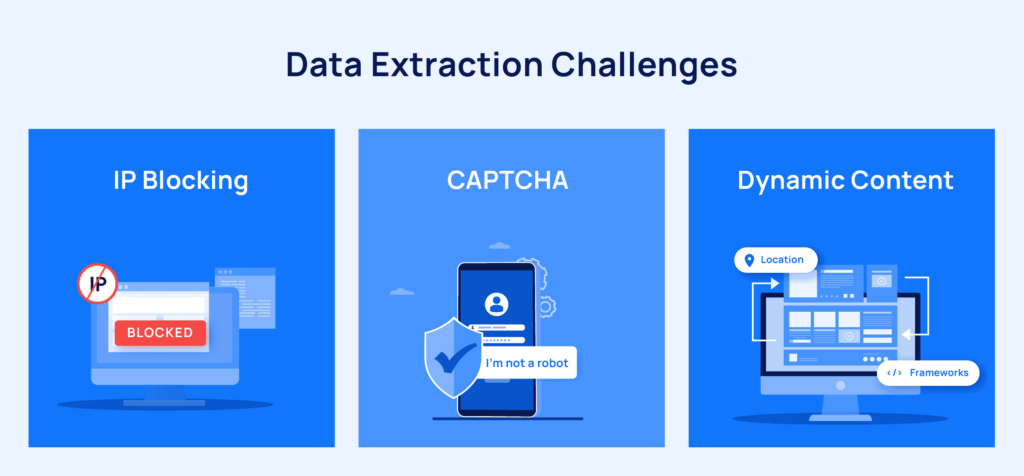

Zunächst könnten Sie einige unauslöschliche Aspekte des Jobs berücksichtigen, z Captcha-Lösungangehen dynamischer Inhaltund Automatisierung Proxy-Rotation.

Wenn Sie die folgenden verräterischen Anzeichen bemerken, ist es an der Zeit, Ihre Webdatenanforderungen auszulagern.

1. Wenn die Datenextraktion nicht Ihr Hauptangebot ist

Das haben wir immer wieder erlebt. Unternehmen messen dem Web Scraping nur sehr geringe Bedeutung bei und stellen dieser Aufgabe nur wenige Ressourcen zur Verfügung. Während das Projekt Fahrt aufnimmt, entwickelt sich die Datenextraktion zu einer großen Operation, für die sich die Gründer definitiv nicht angemeldet haben.

Sie kommen bedrängt zu uns und sehnen sich fast nach einer Ruhepause.

Externe Datenanbieter wie Grepsr extrahieren Tausende von Webseiten parallel und organisieren sie in einem übersichtlichen maschinenlesbaren Format. Es ist nicht allzu weit hergeholt, zu dem Schluss zu kommen, dass Ihr Engineering-Team und Ihre Ressourcen anderswo besser genutzt werden, wenn die Web-Datenextraktion nicht das Kernangebot Ihres Unternehmens ist.

2. Wenn Sie Daten im großen Maßstab benötigen

Wie bereits erwähnt, ist die Einrichtung des Crawlers der einfachste Teil des Datenextraktionsprozesses. Je größer der Umfang des Projekts, desto chaotischer wird es.

Änderungen an Website-Strukturen, Anti-Bot-Mechanismen und der unter den oben genannten Umständen durchaus berechtigte Bedarf an Qualitätsdaten erschweren die Arbeit jedes Datenerfassungsteams.

Websites nehmen häufig Änderungen an ihren Strukturen vor. Beispielsweise ermöglicht die AJAX-Entwicklungstechnik einer Website, Inhalte dynamisch zu aktualisieren. Das verzögerte Laden von Bildern und das unendliche Scrollen machen es den Verbrauchern leicht, mehr Daten anzuzeigen, behindern jedoch die Arbeit des Scrapers.

Darüber hinaus erhöht die Feindseligkeit vieler Quellwebsites gegenüber Bots die Sorge des Scraping-Teams, da all dies die Qualität der Daten gefährdet.

Verwaltete Datenerfassungsdienste wie Grepsr befassen sich täglich mit Problemen wie diesen. Wenn Sie also Ihren Datenextraktionsprozess skalieren möchten, ist die Entscheidung für einen externen Datenanbieter von entscheidender Bedeutung.

3. Wenn Sie nicht über ausreichende technische Ressourcen verfügen

Große Datenmengen gehen automatisch mit großen Problemmengen einher. High-End-Server, Proxy-Dienste, Ingenieure, Softwaretools und so weiter. Ein Datenextraktionsteam benötigt eine Fülle von Ressourcen, um sicherzustellen, dass ein qualitativ hochwertiger Datenfeed in Ihr System gelangt. Und nichts davon ist billig.

Darüber hinaus reißt die Einstellung, Schulung und Ausstattung von zusätzlichem Personal mit Ressourcen nicht nur ein Loch in Ihre Tasche, sondern lenkt Ihre Aufmerksamkeit auch von Ihrem Kerngeschäft ab.

Die Frage ist: Sind Sie bereit, diese Kosten zu tragen?

4. Wenn Sie innerhalb einer Frist Qualitätsdaten benötigen

Die Wankelmütigkeit von Websites und ihre Entschlossenheit, Bots zu blockieren, bringen die Web-Scraper in eine schlechte Lage. Vor allem, wenn Sie nicht über die Ressourcen und Fähigkeiten verfügen, um diese wiederkehrenden Probleme zu umgehen.

Wenn Sie regelmäßig qualitativ hochwertige Daten benötigen, können Sie sich bei der Bereitstellung nicht auf DIY-Techniken verlassen. Die Gewährleistung hochwertiger Daten erfordert sowohl automatisierte als auch manuelle Qualitätssicherungsprozesse.

Wenn Sie jemals in einem Datenextraktionsunternehmen gearbeitet haben, wissen Sie, wie häufig die Crawler ausfallen. Oft arbeiten Ingenieure rund um die Uhr daran, diese Raupenketten zu reparieren und wieder auf Kurs zu bringen.

Wenn Ihr gesamter Geschäftsbetrieb auf Qualitätsdaten basiert, die in regelmäßigen Abständen extrahiert werden, sollten Sie ernsthaft über einen zuverlässigen Datenanbieter nachdenken, der die Crawler auch auf komplexen Websites einrichten und warten kann. Es gibt kaum eine andere Möglichkeit, qualitativ hochwertige Daten in großem Maßstab zu nutzen.

5. Wenn Ihr Webdatenbedarf saisonabhängig ist

Nicht alle Unternehmen benötigen ständig Daten. Angenommen, Ihr Unternehmen hat einen begrenzten Datenbedarf. Sie verwenden Daten nur für die Entwicklung eines neuen Produkts, die Messung von Markttrends während einer bestimmten Jahreszeit und die Analyse der Konkurrenz in einem bestimmten Segment für ein bestimmtes Projekt.

In solchen Situationen besteht die beste Vorgehensweise darin, Ihre Datenextraktionsprojekte auszulagern, wenn die Anforderungen auftauchen.

Angesichts des Zeit- und Geldaufwands, der für die Überwindung der Hürden bei der Datenextraktion erforderlich ist, empfehlen wir Ihnen, mit einem externen Datenanbieter zusammenzuarbeiten, der sich um Ihre Webdatenanforderungen kümmert.

Daten-Neulinge sind oft verwirrt über den schieren Umfang, in dem wir Daten extrahieren. Einmal kam ein Einzelhandelsanalyseunternehmen zu uns, um Daten zu sehr spezifischen Anforderungen zu erhalten. Sie benötigten die Produktpreise einiger ihrer Konkurrenten auf Amazon. Es war eine Freude, ihnen zu zeigen, dass wir solche Daten nicht nur von Amazon, sondern auch von eBay, Walmart und praktisch jeder E-Commerce-Website da draußen extrahieren können. Bei jeder Frequenz. In jedem Maßstab.

Grepsr verfügt über umfassende Erfahrung bei der Erfassung von Webdaten in großem Maßstab für Unternehmen, die diese benötigen. Im Laufe der Jahre haben wir fortschrittliche Techniken erlernt und perfektioniert, um Daten selbst aus den problematischsten Websites zu extrahieren.

Wenn es für Sie an der Zeit ist, zu skalieren, wissen Sie jetzt, wen Sie anrufen müssen.