Wie können Personalvermittler vom Web Scraping profitieren?

Die Suche nach den Talenten, die Sie für Ihr Unternehmen benötigen, ist für den Erfolg von entscheidender Bedeutung, kann jedoch zeitaufwändig und mühsam sein. Es gibt viele Agenturen und Mitarbeiter zu finden und viele Datenbanken zu durchsuchen. Glücklicherweise können Schaber einen Teil der Arbeit automatisieren.

Die Data-Scraping-Technik ist eine zeitsparende und kostengünstige Möglichkeit, die relevantesten Stellenausschreibungen zu finden. Auch für einzelne Arbeitssuchende ist es eine gute Möglichkeit, alle benötigten Informationen über ein Unternehmen oder eine Institution zu erhalten.

Unternehmen und Institutionen nutzen diese Methode auch, um zu ermitteln, welche Stellen auf dem Arbeitsmarkt gefragt sind, welche Fähigkeiten benötigt werden, wie viel Gehalt potenziellen Kandidaten geboten werden sollte usw.

Der Web-Scraping-Dienst hilft dabei, Informationen aus verschiedenen Quellen wie sozialen Medien, Jobbörsen oder anderen Websites zu extrahieren. Die extrahierten Daten können anschließend mit verschiedenen Analysetools analysiert werden, um herauszufinden, welcher Personentyp für die Stelle am besten geeignet wäre. Die ständige Datenanalyse ist ein grundlegender Prozess, der dabei hilft, Entscheidungen zu treffen und die Effizienz des Unternehmens zu verbessern.

Mit Web-Scraping-Tools können Sie schnell und effizient suchen:

- Neue Angestellte;

- Unternehmen, die in Zielbranchen tätig sind;

- Spezifische Objekte, die Sie interessieren.

Im letzten Fall können die Kriterien spezifisch sein. Mithilfe von Web Scraping lässt sich beispielsweise leicht eine Liste aller potenziellen Mitarbeiter finden, die in New York leben, über mehr als fünf Jahre Berufserfahrung verfügen und derzeit auf Jobsuche sind.

Nehmen wir an, Sie müssen einen C++-Entwickler mit zehn Jahren Erfahrung, einem Portfolio und mehreren Projekten auf GitHub finden und aktiv auf der Suche nach einem Job sein.

Dazu müssen Sie zunächst alle potenziellen Mitarbeiter finden, die derzeit arbeitslos sind. Hierfür eignen sich die Dienste Monster, Indeed und LinkedIn. Suchergebnisse können mit einem Scraper gecrawlt und in praktischen Tabellen zusammengefasst werden, die später bequem analysiert werden können. Nehmen wir an, wir interessierten uns nur für den Nachnamen, den Profillink, die Berufserfahrung, die aktuelle Jobverfügbarkeit und den GitHub-Link.

Sobald die Tabelle nach Berufserfahrung, Jobverfügbarkeit und GitHub-Link gefiltert ist, können Sie mit dem Analyseteil der Projekte fortfahren. Dazu müssen Sie den Links aller Benutzer folgen und Daten zu ihren Projekten sammeln. Dies reicht aus, um zu verstehen, wofür eine Person interessiert ist, wie hoch ihre Kenntnisse und Fähigkeiten sind und welche Sprachen sie schreiben kann.

Und das Beste daran ist, dass alle diese Informationen automatisch abgerufen werden können. Und wenn Sie bereits über solche Daten verfügen, können Sie viel über einen Mitarbeiter erfahren.

Suchen Sie nach den qualifiziertesten Kandidaten

Bevor Sie diese Informationen erhalten, müssen Sie entscheiden, wie Sie sie erhalten. Es gibt verschiedene Möglichkeiten, solche Daten automatisch zu erhalten:

- Kauf fertiger Basen nach bestimmten Kriterien. Allerdings ist zu bedenken, dass man solche Datenbanken oft kaufen muss und es nicht immer Garantien für die hohe Qualität oder Vollständigkeit gibt.

- Die Verwendung vorgefertigter Schabewerkzeuge. Diese Option ist günstiger als die vorherige und ermöglicht es Ihnen zu entscheiden, welche Daten gescrapt werden sollen, sie ist jedoch nicht flexibel. Daher funktionieren sie möglicherweise nicht auf Websites mit komplexen Strukturen.

- Entwicklung einer neuen Datenerfassungsanwendung von Grund auf. Dann müssen Sie jedoch verschiedene Maßnahmen gegen IP-Blockaden ergreifen, nach Proxys suchen, Captcha-Lösungsdienste anbinden und vieles mehr.

- Erstellen Sie eine interne Infrastruktur zum Sammeln von Daten mithilfe von Web-Scraping-APIs, die dabei helfen, alle für Web-Scraping typischen Probleme zu bewältigen, die wir im vorherigen Absatz aufgeführt haben.

Es lohnt sich, ihre Vor- und Nachteile zu verstehen, um zu entscheiden, welche Option geeignet ist. Der Kauf neuer Basen ist die einfachste und teuerste Option. Darüber hinaus sind Sie nicht derjenige, der Zugriff auf die empfangenen Daten hat, sondern diese auch bereitstellt. Ihre Daten können also mehr als einmal weiterverkauft werden. Darüber hinaus wird dann ihre Relevanz in Frage gestellt.

Die Verwendung vorgefertigter Schabewerkzeuge ist, wie oben erwähnt, ein billigeres, aber weniger flexibles Werkzeug. In der Regel ist es nicht immer bequem, Daten nur in der von den Entwicklern bereitgestellten Form zu erhalten.

Sammeln Sie automatisch Daten zum Arbeitsmarkt

Web Scraping ist der beste Weg, um in Echtzeit Zugang zum Arbeitsmarkt zu erhalten. Es ist schnell, effizient und liefert Ihnen alle Daten, die Sie sich nur wünschen können.

- 1.000 kostenlose API-Credits

- Keine Kreditkarte benötigt

- 30-Tage-Testversion

Die Entwicklung Ihrer Anwendung ist eine gute Lösung, aber nur für Personen mit umfassenden Programmierkenntnissen oder für Mitarbeiter aus Programmierern und Analysten. Der Vorteil besteht jedoch darin, dass die Anwendung von niemandem abhängig ist. Dann stellt sich zwar das Problem der Umgehung von Sperren.

Und die letzte Option ist die Schaffung einer internen Job-Scraping-Infrastruktur. Es ist optimal und ermöglicht es Ihnen, zu geringen Kosten aktuelle Daten zu erhalten, ohne sich um Proxys und Blockierungen kümmern zu müssen.

Die ersten beiden Optionen bedürfen keiner ausführlichen Erklärung. Zum dritten haben wir einige Artikel:

- Eine Einführung in das Scraping von Websites mit Axios und Cheerio

- Web Scraping mit C#

- Web Scraping mit Python: Von den Grundlagen bis zur Praxis

- Web Scraping mit Selenium Python

Daher konzentrieren wir uns in diesem Artikel auf die letzte Option.

Sammeln von HR-Daten mit der Web Scraping API

Um die Web-Scraping-API zu nutzen, registrieren Sie sich für unseren Service. Danach erhalten Sie 1000 kostenlose API-Credits, die Sie einen Monat lang zum Testen nutzen können.

Um zu verstehen, wie Anfragen funktionieren und wie man sie zusammenstellt, verwenden wir einen speziellen Builder. Mithilfe der Felder auf der rechten Seite des Fensters können Sie die Abfrage anpassen und anschließend die resultierende Abfrage ausführen. Lassen Sie uns Daten von Indeed Find-Jobs abrufen.

Wir verwenden zum Beispiel die Abfrage „Entwickler“. Fügen Sie im Feld „URL“ einen Link zur Suchergebnisseite ein. Wenn Sie den Scraper jetzt ausführen, erhalten Sie den Quellcode der Seite, der weiter verarbeitet werden muss, um die gewünschten Daten zu extrahieren.

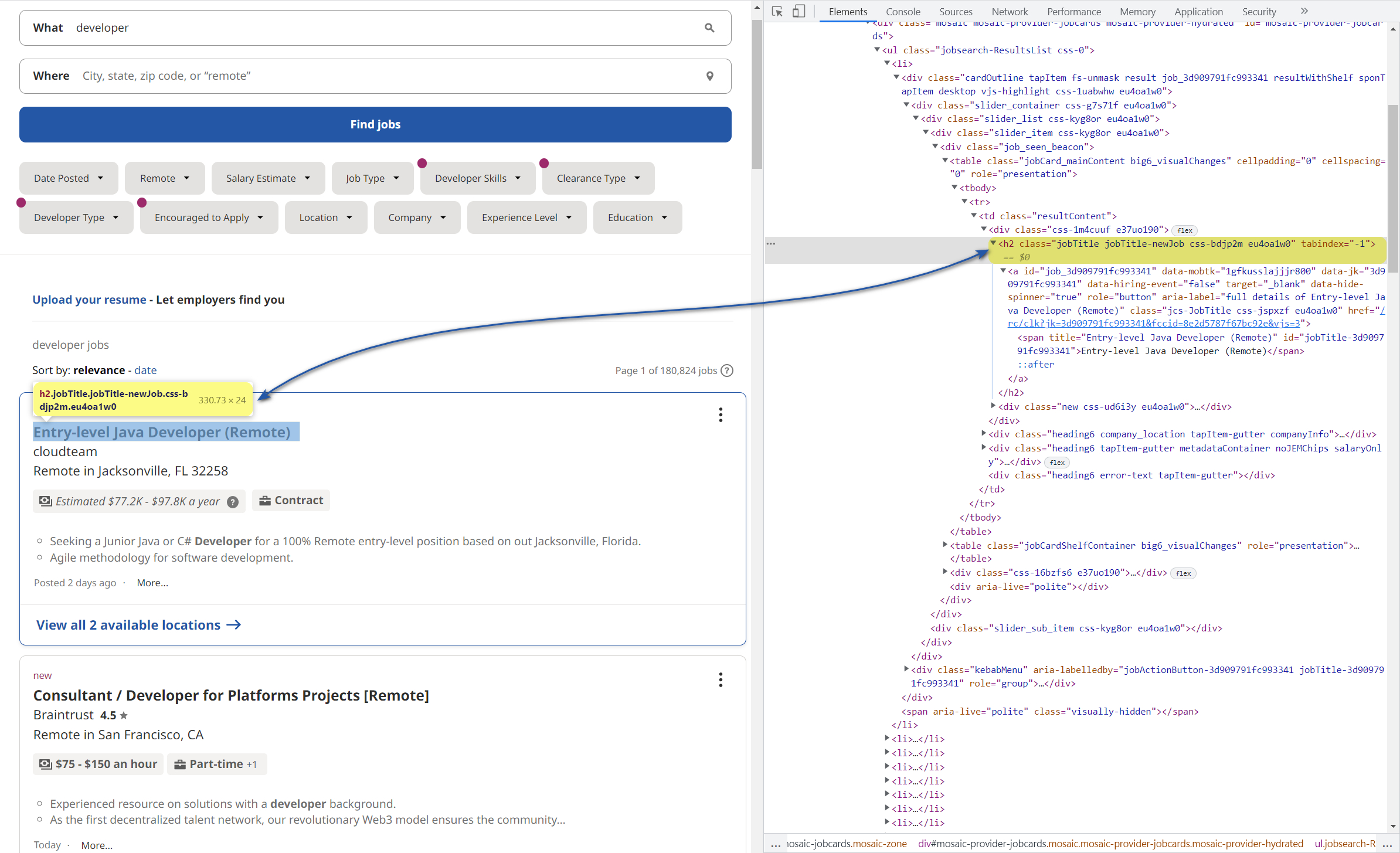

Um die benötigten Daten sofort im JSON-Format zu erhalten, nutzen Sie „Extraction Rules“. Gehen Sie dazu auf die Website der Indeed-Ergebnisseite und erkunden Sie sie. Gehen Sie dazu zu DevTools (F12) und wählen Sie einen beliebigen Titel aus, um dessen Code zu erhalten.

Klicken Sie anschließend mit der rechten Maustaste auf das Element im Codefeld und kopieren Sie seinen Selektor. In unserem Fall sieht der Selektor für Berufsbezeichnungen so aus:

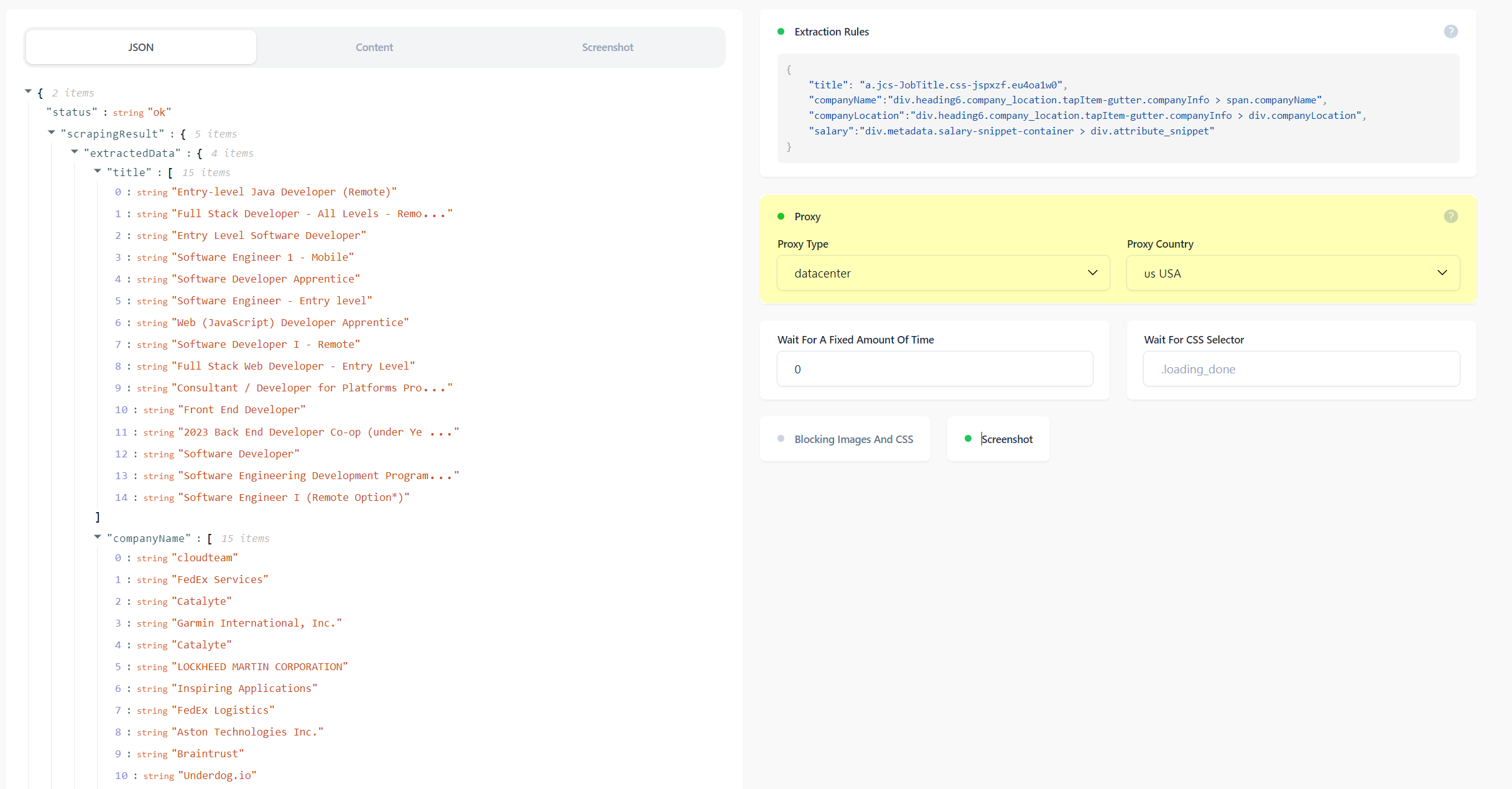

a.jcs-JobTitle.css-jspxzf.eu4oa1w0Wenn Sie nun den resultierenden Selektor in Extraktionsregeln einfügen, ist das Ergebnis der Abfrage viel besser:

Ebenso können Sie auf Recruiting-Websites absolut alle wertvollen Daten erhalten, die die Suche nach potenziellen Mitarbeitern erleichtern. Mithilfe der folgenden Regel können Sie beispielsweise Berufsbezeichnungen, Firmennamen, Standorte und Gehälter abrufen.

{

"title": "a.jcs-JobTitle.css-jspxzf.eu4oa1w0",

"companyName":"div.heading6.company_location.tapItem-gutter.companyInfo > span.companyName",

"companyLocation":"div.heading6.company_location.tapItem-gutter.companyInfo > div.companyLocation",

"salary":"div.metadata.salary-snippet-container > div.attribute_snippet"

}Stellen Sie Anfragen über Proxys und rotieren Sie diese nach Bedarf

Wenn Sie beim Erstellen Ihres Scrapers darauf achten müssen, wie Sie einen Pool von IP-Proxys sammeln und deren Änderung konfigurieren, reicht es bei Verwendung der API aus, die entsprechende Funktion zu aktivieren:

Es gibt zwei Arten von Proxys: Resident- und Rechenzentrums-Proxys. Ihr Hauptunterschied besteht darin, dass private Proxys von Anbietern bereitgestellt werden, Rechenzentren jedoch nicht. Es ist erwähnenswert, dass die Nachfrage nach Rechenzentrums-Proxys hoch ist.

Im Allgemeinen ermöglichen Ihnen Proxys, dass die Site nicht Ihren Computer, sondern einen anderen Computer aus dem angegebenen Land erkennt.

Ein weiteres Problem, das geäußert wurde, sind Captchas. Um sie zu vermeiden, werden Headless-Browser eingesetzt und zu ihrer Lösung spezielle Dienste eingesetzt. Dieses Problem kann jedoch auch vergessen werden, wenn die API verwendet wird.

Fazit und Erkenntnisse

Web Scraping für Personalvermittler ist das ultimative Tool, um schnell und effizient die besten Mitarbeiter zu finden. Es hilft Ihnen dabei, alles zu tun, von der Suche nach qualifizierten Kandidaten in wenigen Minuten bis hin zum Herausfiltern der Kandidaten, die in die engere Auswahl kommen, bis hin zum perfekten Kandidaten für Sie. Natürlich spart der Kauf einer vorgefertigten Basis Zeit, aber die Erstellung Ihrer API-basierten Infrastruktur ist eine einfache, flexible und funktionsreiche Lösung zum Sammeln von HR-Daten mit Web Scraping.

Darüber hinaus reicht es aus, alles einmal einzurichten und zu erledigen, und dann können Sie ähnliche Daten automatisch erhalten. Um sich davon zu überzeugen, reicht es aus, es einmal auszuprobieren, und Sie können es kostenlos tun.