Python und JavaScript sind die beliebtesten Programmiersprachen für Web Scraping. In diesem Artikel gehen wir auf die Stärken und Schwächen beider Sprachen ein und vergleichen sie. Wir untersuchen spezifische Anwendungsfälle, in denen JavaScript oder Python für Ihre Web Scraping-Projekte besser geeignet sein könnten.

Wenn Sie daran interessiert sind, andere Programmiersprachen für Web Scraping zu lernen, empfehlen wir Ihnen, unseren Artikel über die besten Sprachen für Web Scraping zu lesen. Darin diskutieren wir die Vor- und Nachteile der einzelnen Sprachen und liefern grundlegende Beispiele für Scraper in Aktion.

JavaScript für Web Scraping

JavaScript ist die am häufigsten verwendete Sprache in der Webentwicklung und hat spezifische Stärken und Schwächen beim Extrahieren von Daten aus Websites. Die Fähigkeit, problemlos mit dynamischen Inhalten zu interagieren, verschafft ihr einen großen Vorteil.

In diesem Abschnitt sehen wir uns beliebte JavaScript-Bibliotheken an, die für Web Scraping verwendet werden, und untersuchen ihre Funktionen und wie sie bei der Datenextraktion helfen. Wir besprechen auch die Vorteile und Herausforderungen der Verwendung von JavaScript.

Anschließend vergleichen wir JavaScript mit Python und untersuchen, wie gut Python für Web Scraping funktioniert und wie sich sein Ansatz von dem von JavaScript unterscheidet.

Beliebte Bibliotheken und Tools

In unserem vorherigen Artikel haben wir uns die sechs wichtigsten JavaScript- und Node.js-Bibliotheken für Web Scraping angesehen, einschließlich ihrer Vor- und Nachteile sowie Codebeispiele. In diesem Artikel konzentrieren wir uns auf die drei beliebtesten: Axios, Cheerio und Puppeteer. Die anderen Bibliotheken sind weniger verbreitet und wiederholen, was diese drei können.

Axios und Cheerio werden beim Web Scraping normalerweise zusammen verwendet. Axios eignet sich hervorragend für Anfragen an eine Website und Cheerio hilft Ihnen beim Parsen und Bearbeiten der zurückgegebenen Daten. Sie sind einfach zu verwenden und eignen sich gut für einfache Scraping-Aufgaben.

Lassen Sie uns dies anhand einer Demo-Website demonstrieren. Wir erstellen ein einfaches Skript, um wichtige Produktinformationen von einer Seite abzurufen.

const axios = require('axios');

const cheerio = require('cheerio');

const url="https://demo.opencart.com/";

axios.get(url).then(response => {

const $ = cheerio.load(response.data);

const products = ();

$('.product-thumb').each((index, element) => {

const product = {

title: $(element).find('.description h4 a').text().trim(),

description: $(element).find('.description p').text().trim(),

price: $(element).find('.price .price-new').text().trim(),

tax: $(element).find('.price .price-tax').text().trim(),

image: $(element).find('.image img').attr('src'),

link: $(element).find('.description h4 a').attr('href'),

};

products.push(product);

});

console.log(products);

}).catch(error => {

console.error('Error:', error);

});Wie Sie sehen, können Sie mit diesen Bibliotheken schnell Daten aus relativ einfachen Websites extrahieren. Allerdings können sie keine dynamischen Inhalte verarbeiten. Um tiefer in diese beiden Bibliotheken einzutauchen, lesen Sie unseren Artikel über Web Scraping mit Axios und Cheerio.

Eine weitere nützliche JavaScript-Bibliothek zum Scraping ist Puppeteer. Im Gegensatz zu den anderen ist Puppeteer ein All-in-One-Tool und benötigt keine zusätzlichen Tools. Sie können damit einen Browser öffnen, Seiten besuchen und Benutzeraktionen simulieren.

Da Puppeteer dynamische Inhalte verarbeiten kann, die von JavaScript geladen werden, ist es eine gute Wahl. Aktualisieren wir das vorherige Beispiel, um Puppeteer zu verwenden:

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://demo.opencart.com/', { waitUntil: 'networkidle2' });

const products = await page.evaluate(() => {

const productElements = document.querySelectorAll('.product-thumb');

const products = ();

productElements.forEach(element => {

const product = {

title: element.querySelector('.description h4 a').innerText.trim(),

description: element.querySelector('.description p').innerText.trim(),

price: element.querySelector('.price .price-new').innerText.trim(),

tax: element.querySelector('.price .price-tax').innerText.trim(),

image: element.querySelector('.image img').src,

link: element.querySelector('.description h4 a').href

};

products.push(product);

});

return products;

});

console.log(products);

await browser.close();

})();Mit diesem Code können wir Daten zuverlässig aus Webseiten extrahieren. Er startet einen Webtreiber, besucht die gewünschte Seite, wartet, bis sie vollständig geladen ist, und sammelt dann effizient die benötigten Informationen. Diese Methode verhindert Fehler, die durch den Versuch entstehen, Daten zu extrahieren, bevor sie vollständig geladen sind.

Vorteile der Verwendung von JavaScript

JavaScript eignet sich hervorragend für Web Scraping, da Sie damit Daten direkt auf der Clientseite erfassen können. Das bedeutet, dass Sie direkt im Browser arbeiten können. Dies ist besonders nützlich für den Umgang mit dynamischen Webseiten, deren Inhalt sich häufig ändert. Mit JavaScript können Sie Skripte auf der Seite ausführen, die Sie scrapen.

Node.js ist eine weitere Option. Damit können Sie JavaScript auf der Serverseite ausführen, was beim Scraping sehr nützlich sein kann. Darüber hinaus ist JavaScript aufgrund seiner Fähigkeit, mehrere Aufgaben gleichzeitig zu verarbeiten (asynchrone Vorgänge), effizient für die schnelle Erfassung großer Datenmengen.

Nachteile der Verwendung von JavaScript

JavaScript hat jedoch einige Nachteile. Es kann für Anfänger komplizierter zu erlernen sein als Sprachen wie Python. Diese Komplexität kann den Entwicklungsprozess erschweren.

Obwohl es viele JavaScript-Bibliotheken zum Scraping gibt, sind die Tools zur Verarbeitung und Analyse von Daten möglicherweise weniger umfangreich. Außerdem kann die Erstellung spezieller Tools, wie etwa zur Verarbeitung von PDFs, zusätzliche Arbeit und benutzerdefinierte Lösungen erfordern.

Python für Web Scraping

Python ist in den letzten Jahren zu einer sehr beliebten Option für Web Scraping geworden. Es ist für seine Benutzerfreundlichkeit bekannt und verfügt über viele Bibliotheken und Tools, die Entwicklern bei der Arbeit an verschiedenen datenbezogenen Projekten helfen. Seine klare und unkomplizierte Syntax hat es zu einem Favoriten in der Web Scraping-Community gemacht.

Beliebte Bibliotheken und Tools

Python verfügt über zahlreiche Bibliotheken und Tools zum Extrahieren, Verarbeiten und Analysieren von Daten. Vergleichen wir dies mit den JavaScript-Bibliotheken, die wir uns zuvor angesehen haben. Die wichtigsten Python-Tools zum Scraping von Daten sind Requests, BeautifulSoup, Selenium und das Scrapy-Framework.

Es gibt noch weitere Python-Bibliotheken zum Scraping, wir konzentrieren uns jedoch auf diese beliebten. Beispiele für all diese wichtigen Python-Scraping-Tools haben wir bereits in anderen Artikeln behandelt.

Requests und BeautifulSoup sind besonders einfach für Anfänger und werden häufig verwendet. Sie vereinfachen das Senden von Anfragen an Websites und verarbeiten das zurückgegebene HTML. Sie funktionieren ähnlich wie Axios und Cheerio von JavaScript und bieten Ihnen effektive Tools für das Web Scraping.

import requests

from bs4 import BeautifulSoup

url="https://demo.opencart.com/"

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

products = ()

for product in soup.find_all('div', class_='product-thumb'):

title = product.find('h4').text.strip()

description = product.find('p').text.strip()

price = product.find('span', class_='price-new').text.strip()

tax = product.find('span', class_='price-tax').text.strip()

image = product.find('img')('src')

link = product.find('h4').find('a')('href')

products.append({

'title': title,

'description': description,

'price': price,

'tax': tax,

'image': image,

'link': link

})

print(products)Im Gegensatz zu JavaScript wird dieses Python-Skript standardmäßig synchron ausgeführt. Um es asynchron zu machen, sollten Sie die Bibliothek aiohttp anstelle von Requests verwenden. Die Bibliothek aiohttp arbeitet mit asyncio zusammen, um asynchrone Anfragen zu ermöglichen.

Es gibt einige Optionen für Webtreiber und Browserautomatisierung in Python. Die beliebtesten sind Pyppeteer, ein Wrapper für Puppeteer, und Selenium. Selenium wird in Python häufiger verwendet, hat eine größere Community und eine bessere Dokumentation. Wir verwenden Selenium also als Beispiel.

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.chrome.service import Service

from selenium.webdriver.chrome.options import Options

from webdriver_manager.chrome import ChromeDriverManager

chrome_options = Options()

chrome_options.add_argument('--headless')

chrome_options.add_argument('--disable-gpu')

driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()), options=chrome_options)

url="https://demo.opencart.com/"

driver.get(url)

products = ()

product_elements = driver.find_elements(By.CLASS_NAME, 'product-thumb')

for product in product_elements:

title = product.find_element(By.CSS_SELECTOR, '.description h4 a').text.strip()

description = product.find_element(By.CSS_SELECTOR, '.description p').text.strip()

price = product.find_element(By.CSS_SELECTOR, '.price .price-new').text.strip()

tax = product.find_element(By.CSS_SELECTOR, '.price .price-tax').text.strip()

image = product.find_element(By.CSS_SELECTOR, '.image img').get_attribute('src')

link = product.find_element(By.CSS_SELECTOR, '.description h4 a').get_attribute('href')

products.append({

'title': title,

'description': description,

'price': price,

'tax': tax,

'image': image,

'link': link

})

driver.quit()

print(products)Weitere Informationen zum Web Scraping finden Sie in unserem anderen Artikel mit einer vollständigen Anleitung zur Verwendung von Selenium mit Python.

Betrachten wir auch das Scrapy-Framework. Es eignet sich hervorragend zum Erstellen umfangreicher Web-Scraper und zum Sammeln großer Datenmengen. Scrapy ist leistungsstark und effizient, aber die Einrichtung kann schwierig sein, daher wird es in einem weiteren Artikel über Scraping mit Scrapy ausführlich beschrieben.

Obwohl Python über mehr Web Scraping-Bibliotheken als JavaScript verfügt, bieten viele dieser Bibliotheken ähnliche Funktionen.

Vorteile der Verwendung von Python

Python ist in den letzten Jahren äußerst populär geworden, da es über viele tolle Funktionen verfügt. Es ist leicht zu erlernen und zu verwenden, was es zu einer guten Wahl für Anfänger und erfahrene Programmierer macht. Python verfügt über viele Bibliotheken und Tools, die bei vielen Aufgaben hilfreich sein können.

Eine der größten Stärken von Python ist seine Fähigkeit, an datenbasierten Projekten zu arbeiten. Egal, ob Sie Daten sammeln, verarbeiten oder analysieren, Python bietet leistungsstarke Tools, mit denen Sie die Arbeit effizient erledigen können. Dies macht es zur ersten Wahl für datenbezogene Projekte.

Da so viele Leute Python verwenden, gibt es eine große und aktive Benutzer-Community. Diese Community kann bei der Arbeit an Projekten wie Web Scrapern oder anderen Tools sehr hilfreich sein. Wenn Sie auf Probleme stoßen, ist es einfach, Lösungen zu finden oder Ratschläge von anderen Python-Entwicklern zu erhalten.

Nachteile der Verwendung von Python

Ein Nachteil der Verwendung von Python für das Datenscraping besteht darin, dass es oft als synchron angesehen wird, was bedeutet, dass es Aufgaben einzeln nacheinander verarbeitet. Dies kann es langsamer machen, wenn Sie viele Anfragen gleichzeitig bearbeiten müssen. Andererseits ist JavaScript, insbesondere Node.js, darauf ausgelegt, asynchrone Vorgänge effizient zu verarbeiten, wodurch es sich besser für Szenarien mit mehreren gleichzeitigen Anfragen eignet.

Darüber hinaus verfügt Python im Allgemeinen über weniger integrierte Tools zur Interaktion mit dynamischen Inhalten als JavaScript. Die Funktionen von JavaScript, wie sie beispielsweise von Browser-Automatisierungstools wie Puppeteer bereitgestellt werden, können besonders nützlich sein, um Daten von Websites zu extrahieren, deren Inhalte häufig aktualisiert werden.

Trotz dieser Einschränkungen bleibt Python eine beliebte und effektive Wahl für das Web Scraping. Es verfügt über eine Reihe leistungsstarker Bibliotheken, die das Extrahieren von Daten aus Websites vereinfachen

Vergleich von JavaScript und Python für Web Scraping

Bevor wir uns in einen detaillierten Vergleich von JavaScript und Python vertiefen, beginnen wir mit einer einfachen Tabelle, um die Hauptmerkmale der beiden Programmiersprachen hervorzuheben:

|

Aspekt |

JavaScript (Node.js) |

Python |

|---|---|---|

|

Hauptbibliotheken |

– Achsen |

– Anfragen |

|

– Knoten abrufen |

– aiohttp |

|

|

– Puppenspieler |

– Schöne Suppe |

|

|

– Tschüß |

– Kratzbürtig |

|

|

– Anfrage (veraltet) |

– Selen |

|

|

Parallelität |

– Native Unterstützung mit async/await |

– Native Unterstützung mit asyncio |

|

– Versprechen |

– aiohttp für asynchrone Anfragen |

|

|

– Effizient mit Puppeteer für Headless Browsing |

– concurrent.futures für Multithreading |

|

|

Benutzerfreundlichkeit |

– Moderne asynchrone Syntax ist einfach für Parallelität zu verwenden |

– BeautifulSoup ist benutzerfreundlich für HTML-Parsing |

|

– Cheerio für leichtes HTML-Parsing |

– Scrapy bietet ein voll funktionsfähiges Scraping-Framework |

|

|

Leistung |

– Generell schnell mit Puppeteer und nativer asynchroner Unterstützung |

– Asynchrone Unterstützung mit aiohttp ist effizient |

|

– Geeignet für die effiziente Bearbeitung mehrerer gleichzeitiger Anfragen |

– Scrapy ist für großflächiges Scraping optimiert |

|

|

Umgang mit JavaScript |

– Hervorragende Unterstützung durch Puppenspieler und Dramatiker |

– Erfordert Selenium oder Headless-Browser wie Splash für JavaScript-lastige Websites |

|

– Kann dynamische Inhalte und interaktive Elemente verarbeiten |

||

|

Gemeinschaft und Ökosystem |

– Große Community mit vielen modernen Tools |

– Umfangreiches Ökosystem mit einer Vielzahl von Scraping-Bibliotheken und Frameworks |

|

– Umfangreiche Bibliotheken für Web Scraping und Automatisierung |

– Starke Unterstützung durch die Community |

|

|

Lernkurve |

– Möglicherweise ist das Erlernen asynchroner Programmiermuster erforderlich |

– Im Allgemeinen unkompliziert für Anfänger |

|

– Bibliotheken wie Puppeteer können eine steilere Lernkurve haben |

– Scrapy kann bei Großprojekten komplex sein |

|

|

Fehlerbehandlung |

– Promises und async/await bieten robuste Fehlerbehandlungsmechanismen |

– Ausnahmen und asynchrone Fehlerbehandlung mit aiohttp und Anfragen werden gut unterstützt |

|

Unterstützung für Headless Browsing |

– Hervorragende Unterstützung durch Puppenspieler, Dramatiker |

– Selenium oder externe Tools für Headless Browsing erforderlich |

Wie in der Tabelle gezeigt, ist es schwer zu sagen, welche Programmiersprache sich am besten zum Datenscraping eignet. Unserer Erfahrung nach ist die effektivste Sprache zum Datenscraping normalerweise die, die Sie bereits gut beherrschen. Wenn Sie mit einer Sprache vertraut sind, können Sie effizienter programmieren, Probleme schneller beheben und insgesamt bessere Ergebnisse erzielen.

Benutzerfreundlichkeit

Das Erstellen und Verwenden von Skripten kann einfacher oder schwieriger sein, je nachdem, welche Programmiersprachen Sie bereits beherrschen. Wenn Sie beispielsweise durch die Arbeit an Websites mit JavaScript vertraut sind, ist es für Sie kein Problem, einen Web Scraper mit JavaScript zu erstellen. Unsere ausführliche Anleitung führt Sie durch die Schritte zum Erstellen eines Scrapers mit JavaScript oder Node.js und zeigt Ihnen, wie Sie ihn ausführen.

Das Erlernen von JavaScript kann für das Web Scraping sehr hilfreich sein, sogar für Python-Entwickler. Manchmal müssen Sie möglicherweise JavaScript-Snippets in Ihr Haupt-Python-Skript einbinden, um Aufgaben wie das Scrollen durch Seiten oder das Klicken auf Schaltflächen zu erledigen.

Wenn Sie hingegen neu in der Programmierung sind und mit Web Scraping beginnen möchten, ist Python eine gute Wahl. Es ist im Allgemeinen einfacher zu erlernen als andere Programmiersprachen. Unser Tutorial führt Sie in Python und Web Scraping ein, einschließlich praktischer Beispiele unter Verwendung beliebter Bibliotheken.

Popularität

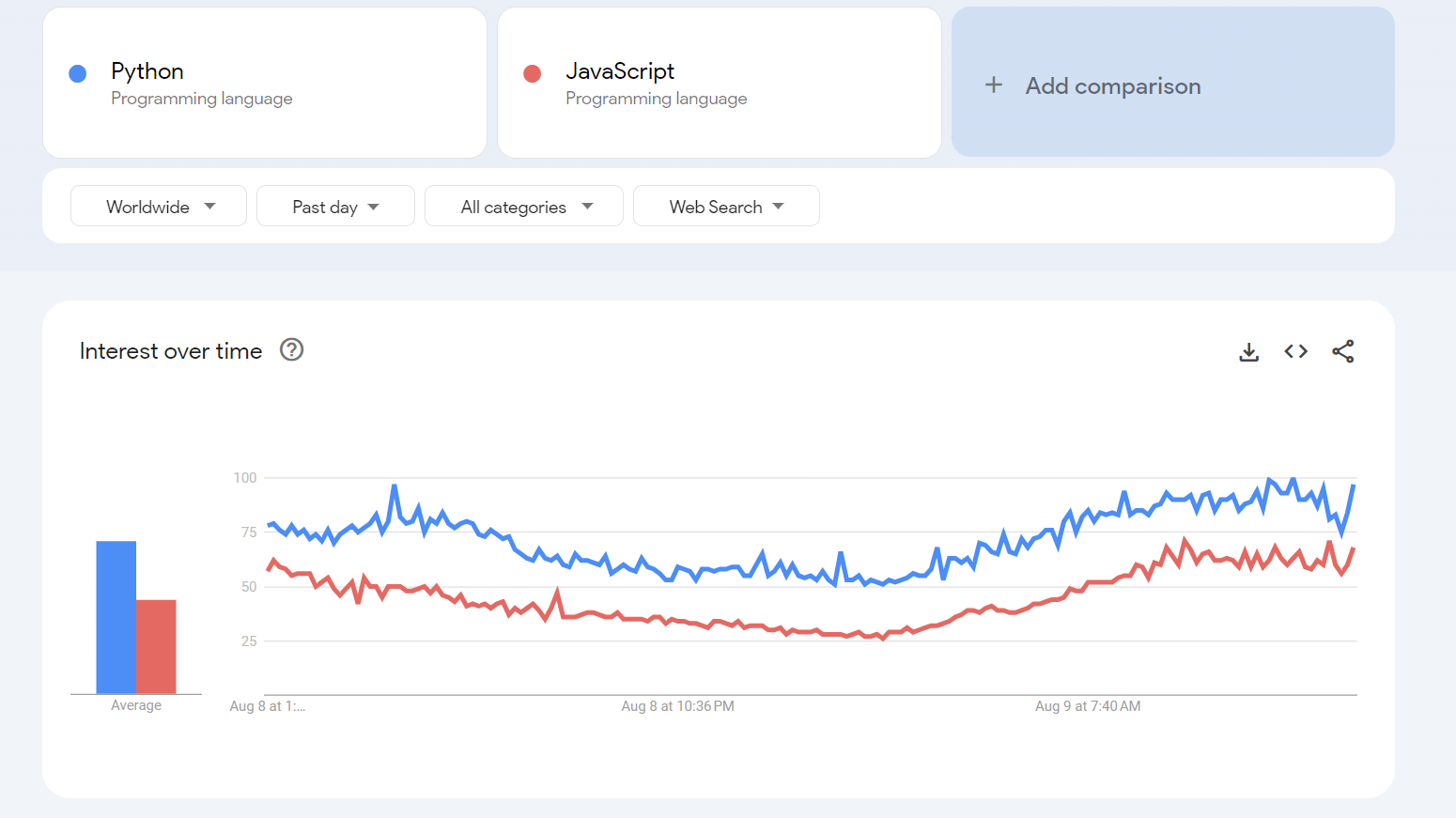

Die Popularität einer Programmiersprache kann je nach Messmethode variieren. In diesem Abschnitt sehen wir uns anhand einiger objektiver Datenquellen an, wie beliebt JavaScript und Python sind.

Ein nützliches Tool für diese Analyse ist Google Trends. Google Trends zeigt, wie oft Menschen im Laufe der Zeit nach Begriffen wie „JavaScript“ und „Python“ suchen. Sie können die Suche anpassen, um sich auf bestimmte Regionen und Zeiträume zu konzentrieren, um ein klareres Bild davon zu erhalten, wie sich das Interesse an diesen Sprachen ändert.

Auf diese Weise können wir erkennen, nach welchen Sprachen häufiger gesucht wird, und Trends hinsichtlich ihrer Beliebtheit erkennen.

Wie in der Grafik dargestellt, deuten die Daten der Plattform darauf hin, dass Python beliebter ist. Wie bereits erwähnt, liefert das Verlassen auf Daten aus einer einzigen Quelle jedoch möglicherweise kein vollständiges Bild. Gehen wir daher für eine breitere Perspektive zur nächsten Plattform über.

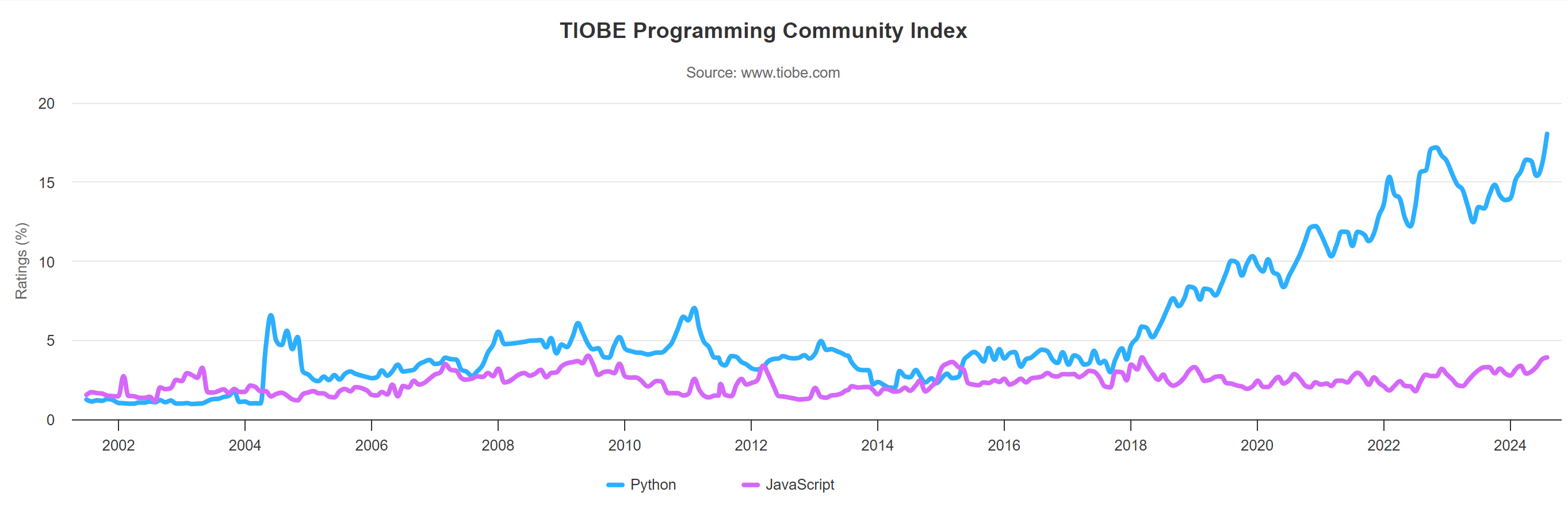

Der nächste Dienst, der häufig zur Bewertung der Popularität von Programmiersprachen verwendet wird, ist Tiobe. Tiobes Rankings basieren auf der Anzahl der Suchanfragen zu verschiedenen Programmiersprachen in großen Suchmaschinen wie Google, Bing, Yahoo, Wikipedia, Amazon und anderen. Diese Methode hilft dabei, einen umfassenderen Überblick darüber zu erhalten, wie häufig Programmiersprachen online gesucht und diskutiert werden, und bietet so ein besseres Verständnis ihrer allgemeinen Popularität.

Dieser Index wird monatlich aktualisiert und zeigt die Programmiersprachentrends der letzten 20 Jahre. Laut dem Tiobe-Index für August 2024 ist Python derzeit die beliebteste Programmiersprache, während JavaScript auf Platz sechs liegt.

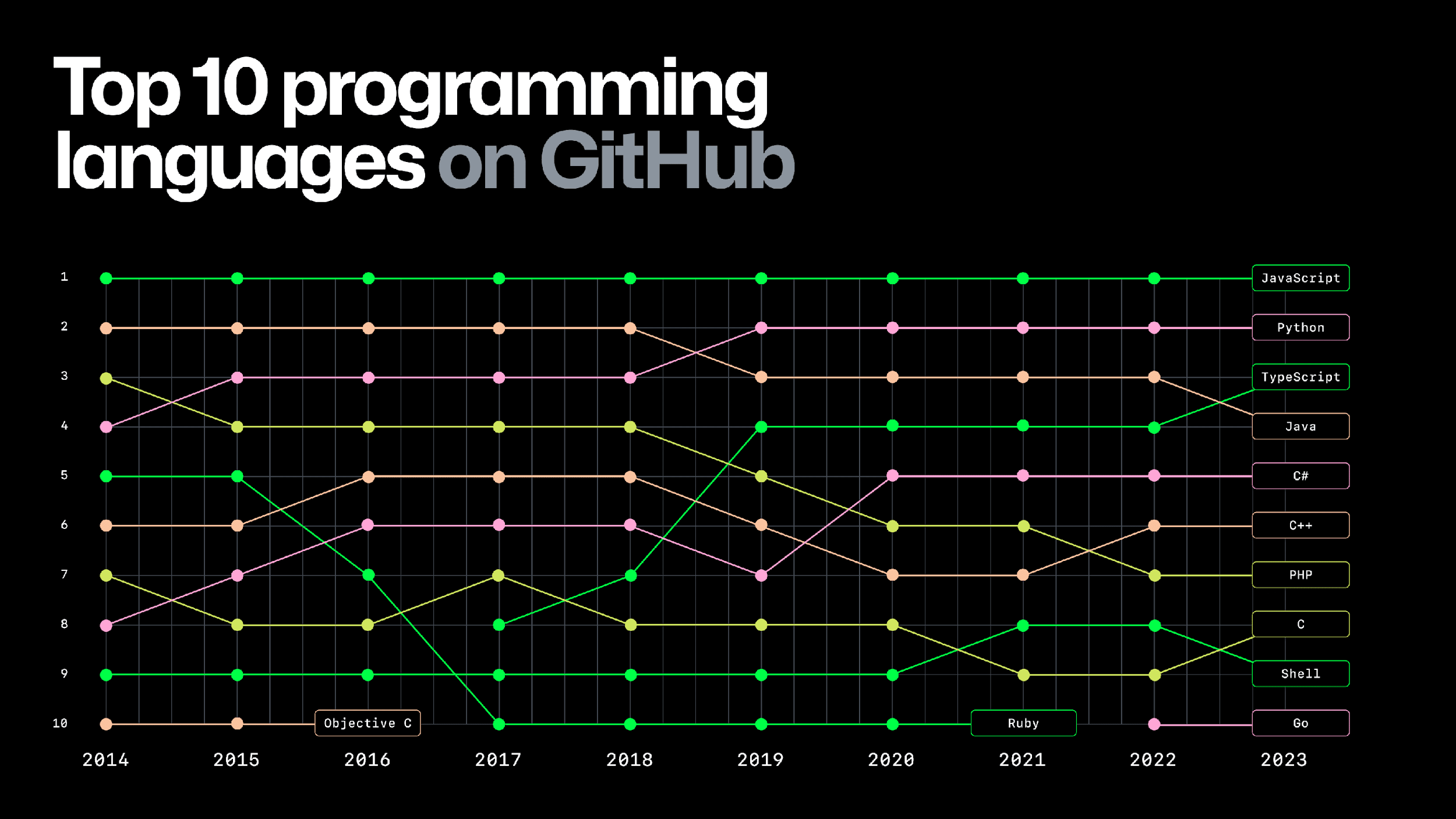

Zum Schluss schauen wir uns noch GitHub Octoverse an, das ich für eine sehr zuverlässige und detaillierte Quelle halte. GitHub Octoverse bietet Einblicke in die Anzahl der Projekte auf GitHub, der weltweit größten Plattform zum Hosten von Code. Es enthält auch Informationen darüber, welche Programmiersprachen in aktiven Projekten am häufigsten verwendet werden.

Diesen Daten zufolge ist JavaScript auf GitHub beliebter, da es in vielen Projekten verwendet wird. JavaScript ist in dieser Hinsicht seit 2014 führend. Obwohl Python sehr beliebt ist, ist es daher noch zu früh, es insgesamt als beliebteste Programmiersprache zu bezeichnen.

Leistung

Die Bewertung der Leistung und Effizienz von Skripten, die in verschiedenen Programmiersprachen geschrieben wurden, kann subjektiv sein. Um ein klareres Bild zu erhalten, schreiben wir zwei asynchrone Skripte: JavaScript und Python. Beide Skripte rufen wiederholt eine Demo-Website ab (10 Mal), messen, wie lange jede Anforderung dauert, und berechnen dann die durchschnittliche und die gesamte benötigte Zeit.

Bevor wir uns in die Codebeispiele vertiefen, ist es wichtig zu verstehen, warum es sinnvoll ist, verschiedene Sprachen auf diese Weise zu vergleichen. Das Ausführen identischer Skripte auf derselben Maschine, mit ähnlichen Tools und unter denselben Bedingungen ermöglicht eine faire Bewertung der Sprachleistung bei bestimmten Aufgaben:

- Web Scraping und Belastungstests. Wir können sehen, welche Sprache viele Anfragen besser verarbeitet, indem wir dasselbe Skript sowohl in JavaScript als auch in Python ausführen. Dies ist nützlich für Aufgaben wie Web Scraping oder das Testen der Leistung einer Website unter hoher Belastung.

- Asynchrone und parallele Programmierung. Verschiedene Sprachen behandeln asynchrone Aufgaben unterschiedlich. Ein Vergleich hilft uns zu verstehen, wie gut jede Sprache gleichzeitig ausgeführte Aufgaben bewältigt und welche Auswirkungen dies auf die Leistung hat.

- Entwicklung, Wartung und Skalierbarkeit. Neben der Geschwindigkeit möchten wir auch wissen, wie einfach es ist, in jeder Sprache Skripte zu schreiben, zu warten und zu skalieren. Einige Sprachen sind möglicherweise benutzerfreundlicher oder besser für die Skalierung von Projekten geeignet.

- Sprachunterschiede lernen und verstehen. Wir können die einzigartigen Merkmale, Stärken und Schwächen jeder Sprache verstehen, indem wir praktische Beispiele vergleichen. Dies hilft uns zu sehen, wie verschiedene Sprachen ähnliche Probleme angehen.

Durch das Testen von Skripten unter kontrollierten Bedingungen können wir herausfinden, welche Sprache unseren Anforderungen am besten entspricht. Außerdem können wir so bessere Entscheidungen hinsichtlich Entwicklung und Optimierung treffen.

In unserem Fall können Ihnen diese Tests dabei helfen, herauszufinden, mit welcher Sprache Sie besser arbeiten können. Lassen Sie uns das JavaScript-Skript verfeinern, das wir zuvor verwendet haben:

const axios = require('axios');

const { performance } = require('perf_hooks');

const url="https://demo.opencart.com";

async function fetch() {

const startTime = performance.now();

await axios.get(url);

const endTime = performance.now();

return endTime - startTime;

}

async function runScraper() {

const requestPromises = Array.from({ length: 10 }, () => fetch());

const times = await Promise.all(requestPromises);

return times;

}

async function main() {

const startTime = performance.now();

const requestTimes = await runScraper();

const totalExecutionTime = performance.now() - startTime;

const sumOfRequestTimes = requestTimes.reduce((a, b) => a + b, 0);

const averageRequestTime = sumOfRequestTimes / requestTimes.length;

console.log(`Total Execution Time: ${totalExecutionTime / 1000} seconds`);

console.log(`Average Request Time: ${averageRequestTime / 1000} seconds`);

}

main().catch(console.error);Passen wir nun das zuvor besprochene Python-Skript an. Wir müssen die Bibliothek requests durch aiohttp und asyncio ersetzen, damit unser Programm asynchron ausgeführt werden kann. In Bezug auf die Funktionalität replizieren wir das JavaScript-Skript:

import aiohttp

import asyncio

import time

url="https://demo.opencart.com"

async def fetch(session, url):

start_time = time.time()

async with session.get(url) as response:

await response.text()

end_time = time.time()

return end_time - start_time

async def run_scraper():

async with aiohttp.ClientSession() as session:

tasks = (fetch(session, url) for _ in range(5))

times = await asyncio.gather(*tasks)

return times

async def main():

start_time = time.time()

request_times = await run_scraper()

total_execution_time = time.time() - start_time

average_request_time = sum(request_times) / len(request_times)

print(f"Total Execution Time: {total_execution_time} seconds")

print(f"Average Request Time: {average_request_time} seconds")

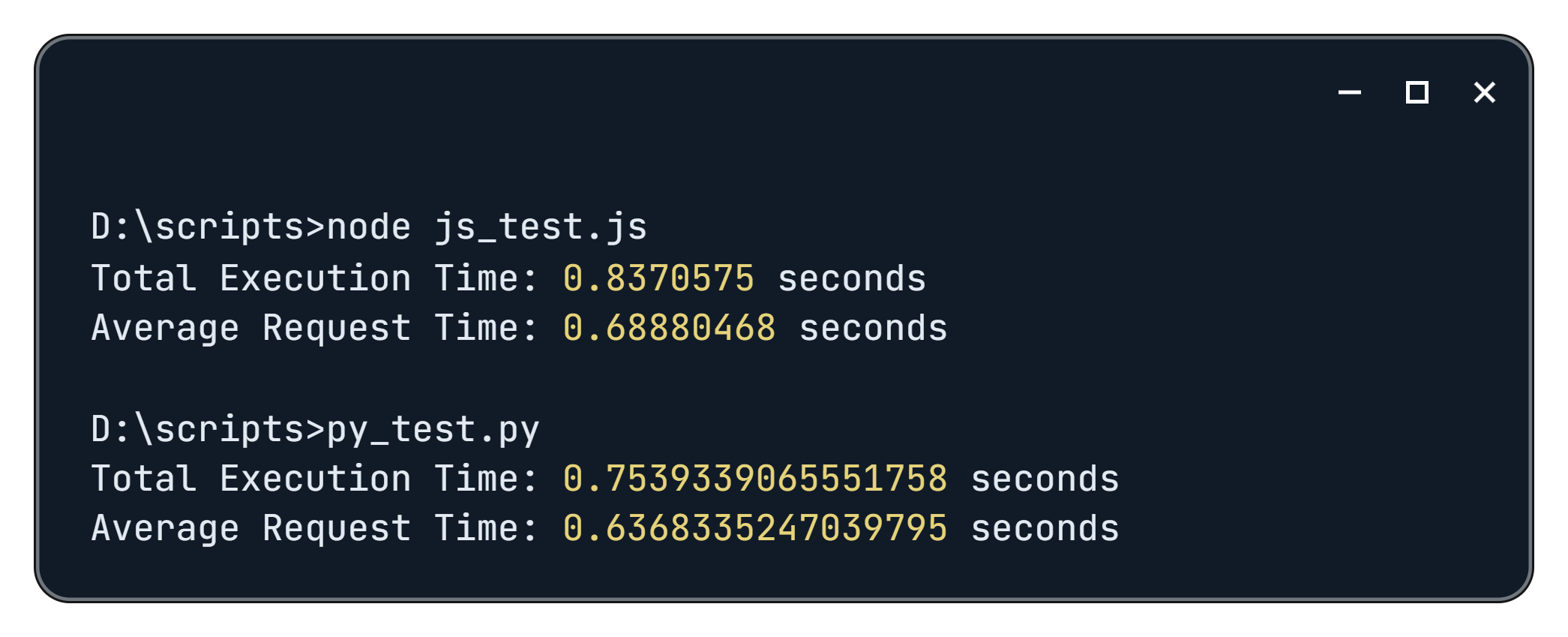

asyncio.run(main())Bei der Ausführung erhalten wir die folgenden Ergebnisse:

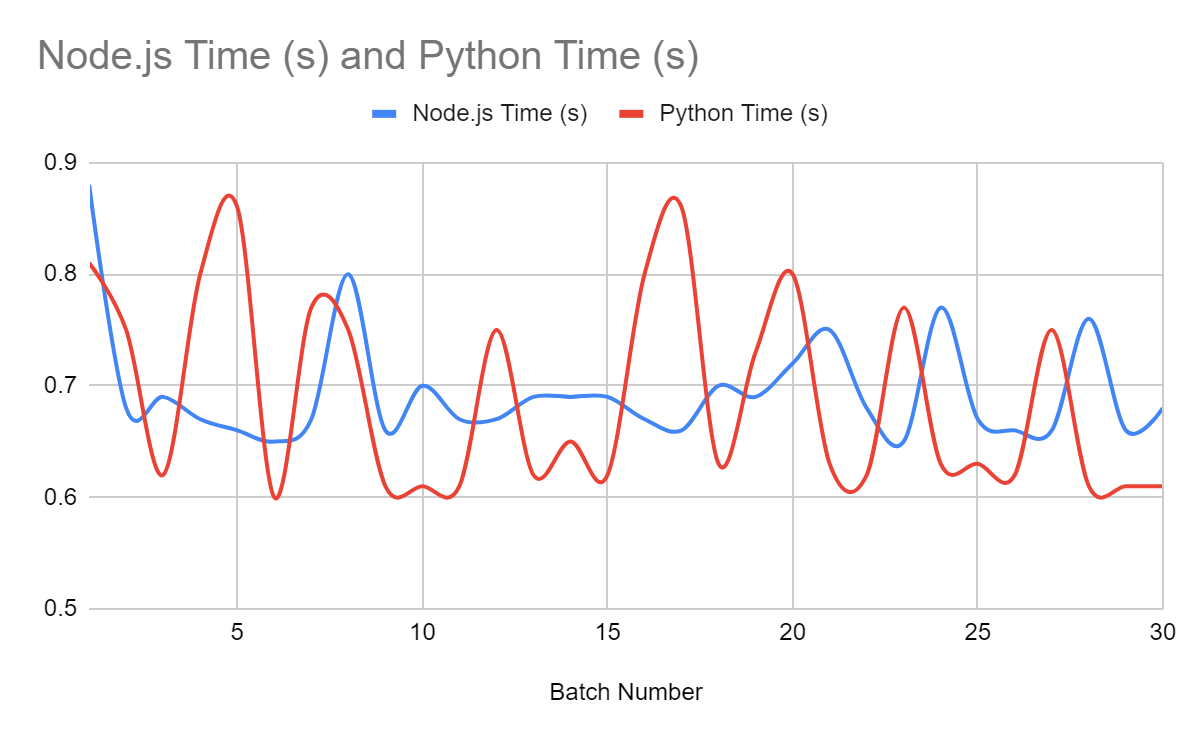

Lassen Sie uns keine Schlussfolgerungen auf der Grundlage eines einzigen Testlaufs ziehen. Wir führen das Skript 30 Mal in einer Schleife aus, um zuverlässigere Ergebnisse zu erhalten. Auf diese Weise sammeln wir genügend Daten für eine bessere Analyse.

Die Grafik zeigt, dass Python und JavaScript beim Web Scraping ähnliche Ergebnisse liefern. Das bedeutet, dass die Wahl der Programmiersprache beim Erstellen eines Web Scrapers möglicherweise nicht sehr wichtig ist. Beide Sprachen schneiden bei dieser Aufgabe gleich gut ab.

Fazit und Erkenntnisse

Bei der Auswahl einer Programmiersprache für Web Scraping hängt Ihre Entscheidung weitgehend von Ihrer Vertrautheit mit der Sprache und den Projektanforderungen ab. Wenn Sie Python beherrschen, fällt es Ihnen möglicherweise leichter, einen effizienteren Scraper zu schreiben als mit JavaScript, obwohl JavaScript seine Vorteile hat. Wenn Sie neu in der Programmierung sind, ist es wichtig, die Stärken und Schwächen jeder Sprache zu berücksichtigen, um die beste Lösung für Ihr Projekt zu finden.

Wann Sie JavaScript wählen sollten

JavaScript ist die beste Wahl, wenn:

- Sie sind bereits mit JavaScript vertraut.

- Sie müssen den Scraper in ein JavaScript-basiertes Projekt integrieren.

- Ihr Projekt enthält Elemente, die für ihre ordnungsgemäße Funktion JavaScript erfordern.

Wenn Sie beispielsweise eine Browsererweiterung erstellen, die Daten von Webseiten erfassen muss, ist JavaScript eine geeignete Wahl, da es direkt in der Browserumgebung ausgeführt wird. Das Gleiche gilt, wenn Sie ein Tool für Google Sheets entwickeln, das eine vereinfachte Version von JavaScript namens Google Apps Script verwendet, um mit Tabellendaten zu interagieren und sie zu bearbeiten.

Wann Sie sich für Python entscheiden sollten

Python ist die beste Wahl, wenn:

- Sie sind bereits mit Python vertraut.

- Es ist Ihre erste Programmiersprache.

- Sie möchten die Daten nicht nur erfassen, sondern diese im selben Skript auch analysieren und verarbeiten?

Python eignet sich hervorragend für Projekte, die Datenanalyse und maschinelles Lernen beinhalten, und ist daher ideal für Aufgaben, bei denen große Datensätze verarbeitet und interpretiert werden müssen. Seine umfangreichen Bibliotheken und Tools machen es zu einer leistungsstarken Option für das effiziente Scraping und Analysieren von Daten.