Jedes Unternehmen muss regelmäßig eine Geschäftsanalyse durchführen. Zu diesem Zweck müssen Ihre Daten strukturiert und zuverlässig sein. Eine der besten Techniken zum Sammeln von Informationen ist das Data Scraping. Es gibt Ihnen die Möglichkeit, Details über Markttrends, Wettbewerber und vieles mehr zu extrahieren.

Heute möchten wir mehr über Business-Intelligence-Tools sprechen. Wir besprechen, welche Vorteile Ihnen die Integration von Web-Scraping-Daten bieten kann. Lesen Sie weiter und erfahren Sie, wie all dies die Qualität Ihrer Entscheidungen beeinflussen kann.

Zunächst möchten wir erklären, was Business-Intelligence-Tools sind. Sie bieten Ihnen die Möglichkeit, Daten zu analysieren und zu visualisieren. Mit seiner Hilfe können Sie Ihre Entscheidungen strategischer gestalten.

Im Kern, Business Intelligence bezieht sich auf unterschiedliche Prozesse und Technologien. Sie unterstützen Sie bei der Sammlung und Präsentation von Informationen aller Art. Mit BI können Sie diese in aussagekräftige Erkenntnisse umwandeln. Nachfolgend haben wir einige seiner Schlüsselkomponenten zusammengestellt.

Datenintegration

Dieser Vorgang hängt von der Integration von Daten aus unterschiedlichen Quellen. Diese beinhalten

- Datenbanken

- Tabellenkalkulationen

- Externe Plattformen usw

Durch diese Integration können Sie ein einheitliches und zugängliches Repository für eine vollständige Analyse erstellen.

Analyse

Die Fähigkeit, diese Informationen richtig zu analysieren, ist für BI von zentraler Bedeutung. Erweiterte Analysefunktionen ermöglichen es Ihnen, Trends zu erkunden und Muster zu erkennen. Sie können dafür verschiedene Techniken verwenden, z

- statistische Analyse

- Data-Mining

- Prädiktive Modellierung

Visualisierung

Visualisierungsinstrumente kann Ihnen dabei helfen, komplexe Datensätze in leicht verständliche Visuals umzuwandeln. Elemente wie Diagramme, Grafiken und interaktive Dashboards können Ihre Präsentationen verbessern. Dadurch wird es für Sie einfacher, diese Informationen zu interpretieren und darauf zu reagieren.

Berichterstattung

BI-Instrumente Berichte erstellen die KPIs und andere wichtige Kennzahlen darstellen. Dieses automatisierte Reporting gibt Ihnen die Möglichkeit, sofort auf relevante Details zuzugreifen. So können Sie schneller auf veränderte Umstände reagieren.

Dashboarding

Eine weitere wichtige Komponente ist dynamische Dashboards. Sie können Ihnen Live-Schnappschüsse Ihres Auftritts liefern. Sie ermöglichen es Ihnen, unterschiedliche Tendenzen zu überwachen und Ziele zu verfolgen. Dadurch erhalten Sie einen vollständigen Überblick über alle Ihre Geschäftsabläufe.

Abfragen und Berichten

Außerdem ermöglichen Ihnen diese Tools die Interaktion mit Daten über Abfrage- und Berichtsfunktionen. Mit diesen Funktionen können Sie

- Extrahieren Sie spezifische Details

- Erstellen Sie Ad-hoc-Berichte

- Passen Sie die Analysen individuell an

Metadaten Enthält Details zur Quelle, zum Format und zum Kontext der Daten. Die ordnungsgemäße Verwaltung ist für BI wirklich wichtig. Dadurch wird sichergestellt, dass die von Ihnen analysierten Informationen korrekt und konsistent sind.

Lagerung

Sie benötigen außerdem eine zentrales Repository zum Speichern und verwalten Sie große Datenmengen, die Sie gesammelt haben. Eine ordnungsgemäße Lagerhaltung ermöglicht es Ihnen, Daten jederzeit abzurufen. Es unterstützt alle Ihre Analyseprozesse.

Einige davon möchten wir auch erwähnen beliebte BI-Tools. Diese sind

- Tableau

- Power BI

- QlikView

- Schauer

- Mikrostrategie

- Sisense

- Domo und mehr…

Prinzipien des Web Scraping

Wie bereits erwähnt, ist die Datenanalyse für jedes Unternehmen äußerst wertvoll. Eine der besten Möglichkeiten, es zu extrahieren, ist Web-Scraping. Wir möchten erklären, wie Sie diese Technik umsetzen können.

Identifizieren Sie Datenquellen

Zuallererst müssen Sie Bestimmen Sie die spezifischen Websites und Online-Quellen aus denen Sie Informationen extrahieren können. Sie können zum Beispiel verwenden

- Websites von Mitbewerbern

- Social-Media-Plattformen

- Branchenforen und mehr…

Website-Struktur verstehen

Dann musst du die Struktur verstehen der Zielstandorte. Sie müssen die Prinzipien von HTML-, CSS- oder JavaScript-Elementen kennen. Dadurch können Sie die gewünschten Informationen finden und abrufen.

Beachten Sie die Nutzungsbedingungen

Denken Sie daran, dass es notwendig ist sich an ethische und rechtliche Erwägungen halten. Auf Websites gibt es eine „robots.txt“-Datei. Es kann Ihnen Richtlinien zum Web-Crawling geben.

Der nächste Schritt besteht darin Wählen Sie die richtigen Web-Scraping-Instrumente. Einige der beliebtesten Alternativen sind

- Schöne Suppe

- Scrapy

- Grepsr

- Selen usw.

Behandeln Sie dynamische Inhalte

Bedenken Sie, dass viele moderne Websites dynamische Inhalte verwenden, die über JavaScript geladen werden. Mit solchen Elementen muss man umgehen können.

Reinigung und Validierung

Wir möchten darauf hinweisen, dass Web-Scraping-Daten Inkonsistenzen oder Fehler enthalten können. Also musst du Bereinigen und validieren Sie alle Informationen. Auf diese Weise werden die Ergebnisse Ihrer Übungen zuverlässiger.

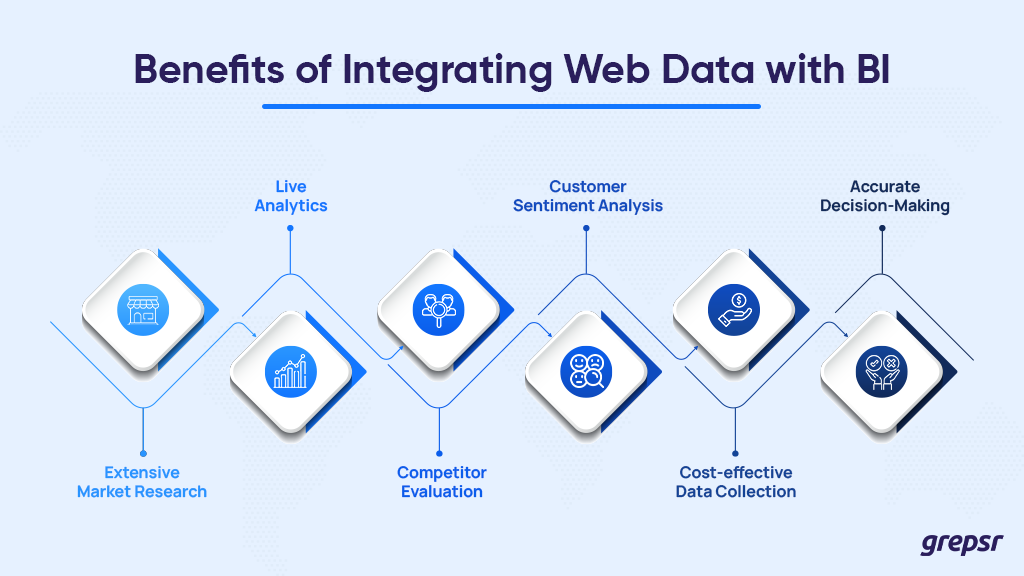

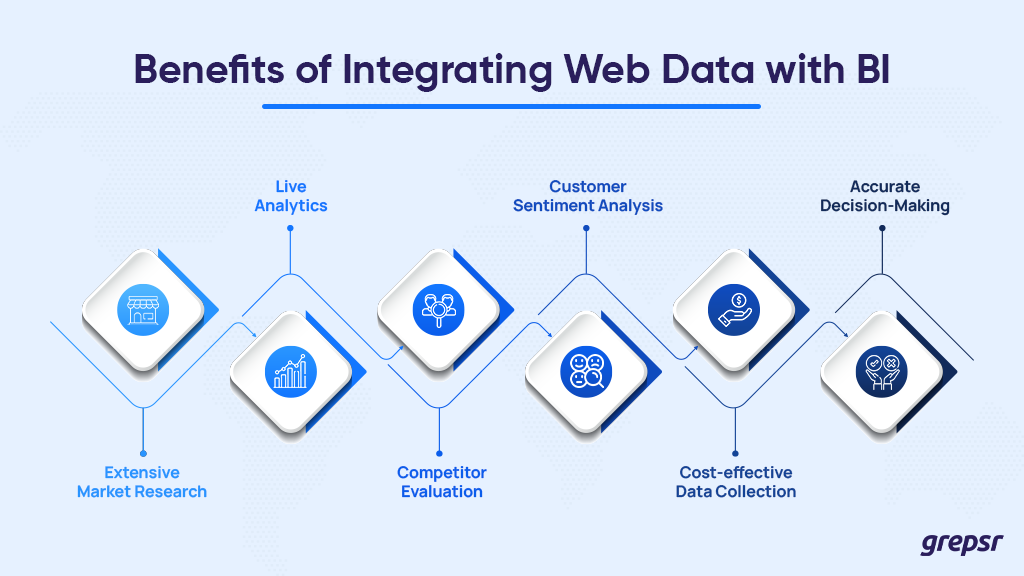

Sie können Web-Scraping-Daten in Ihre BI integrieren. Wie Sie das machen können, erklären wir Ihnen im Folgenden. Hier möchten wir einige Vorteile erwähnen, die es Ihnen bieten kann.

Schritt-für-Schritt-Anleitung zur Integration

Wir haben bereits festgestellt, dass Web Scraping für Sie von großem Nutzen sein kann. Dieser Prozess kann die Fähigkeiten Ihrer BI-Tools verbessern. Nachfolgend haben wir die Schritte zur Integration dieses Verfahrens zusammengestellt.

Definieren Sie Ziele und Umfang

Zuerst muss man es klar sagen skizzieren Sie die Ziele dieser Integration. Identifizieren Sie die spezifischen Datenquellen, die Sie verwenden möchten. Wir haben einige der oben genannten Optionen erwähnt. Anschließend müssen Sie den Umfang der Informationen bestimmen, die Sie extrahieren möchten.

Wählen Sie die richtigen Web-Scraping-Instrumente

Als nächstes müssen Sie Wählen Sie ein zuverlässiges Werkzeug das mit Ihren Zielen übereinstimmt. Es stehen verschiedene Optionen zur Verfügung. Einige davon eignen sich eher für komplexe Aufgaben. Stellen Sie sicher, dass das gewählte Instrument die von Ihnen erwartete Datenmenge verarbeiten kann. Achten Sie auch auf das Format, um das es sich handelt.

Erfahren Sie mehr über die Nutzungsbedingungen und rechtlichen Auswirkungen

Das sollten Sie gründlich tun Lesen Sie die Nutzungsbedingungen jeder Site, bevor Sie Daten extrahieren. Beachten Sie die rechtlichen Auswirkungen dieses Verfahrens. Beispielsweise müssen Sie auf Urheberrechtsgesetze und Datenschutzbestimmungen achten.

Colin McDermott, SEO-Leiter bei Whop, rät: „Jeder, der über Scraping im Namen eines Unternehmens nachdenkt, sollte stets die Gerichtsbarkeit berücksichtigen, in der er und die Website, die er für Scraping in Betracht zieht, ansässig sind, sowie alle anwendbaren Gesetze, die möglicherweise gelten.“ In den USA sind einige Gerichte der Ansicht, dass unbefugtes Schaben manchmal unter die CFAA-Vorschriften fallen kann. Wenn Sie also die Erlaubnis zum Scrapen der Website erhalten können, ist das natürlich immer vorzuziehen.“

Dann müssen Sie einen systematischen Ansatz zur Extraktion entwickeln. Einige der Schritte können sein

- Identifizieren von HTML-Elementen

- Automatisierte Skripte einrichten

- Handhabung der Paginierung für große Datensätze usw.

Denken Sie daran, Ihre Prozesse regelmäßig zu testen und zu verfeinern, um die Genauigkeit aufrechtzuerhalten.

Daten bereinigen und validieren

Wie bereits erwähnt, können Rohdaten Ungenauigkeiten oder Fehler aufweisen. Sie müssen es überprüfen und validieren, um zu bestätigen, dass es vertrauenswürdig ist. Stellen Sie sicher, dass Sie fehlende oder doppelte Punkte ansprechen. Außerdem müssen Sie Formate standardisieren und mit Ausreißern umgehen.

Informationen für BI-Kompatibilität transformieren

Als nächstes müssen Sie die gesammelten Informationen in ein strukturiertes und kompatibles Format konvertieren. Stellen Sie sicher, dass es den Anforderungen Ihrer Plattform entspricht. Einige Maßnahmen, die Sie ergreifen können, sind:

- Anhäufung

- Filtern

- Bereicherung usw.

Dann, Wählen Sie ein BI-Instrument das den Bedürfnissen Ihrer Organisation entspricht. Wir haben oben einige Alternativen vorgeschlagen. Stellen Sie sicher, dass es die Formate und Quellen unterstützt, die Sie durch Web Scraping erhalten haben. Denken Sie daran, dass es für die Integration über die richtigen Konnektoren oder APIs verfügen muss.

Richten Sie eine Integrationspipeline ein

Außerdem müssen Sie eine Pipeline erstellen, die Ihre Daten mit dem ausgewählten Tool verbindet. Zum Beispiel können Sie

- Richten Sie geplante Updates ein

- Nutzen Sie sofortige Integration

- Verwalten Sie Datenaktualisierungen und mehr …

Implementieren Sie Sicherheitsmaßnahmen

Es ist wirklich wichtig einen angemessenen Schutz gewährleisten. Sie können beispielsweise Verschlüsselung oder Zugriffskontrollen verwenden. Es hilft Ihnen, sensible Informationen zu schützen. Stellen Sie sicher, dass Sie die rechtlichen und ethischen Normen einhalten.

Überwachen und iterieren

Du musst Überwachen Sie die Daten regelmäßig nachdem Sie die Integration abgeschlossen haben. Implementieren Sie Feedbackschleifen, wie z. B. das Versenden regelmäßiger Feedbackformulare, um alle Prozesse zu verfeinern. Stellen Sie außerdem sicher, dass Sie über alle Änderungen in der Website-Struktur auf dem Laufenden bleiben.

Herausforderungen

Auch wenn diese Einbindung sehr hilfreich sein kann, kann es dennoch zu einigen Schwierigkeiten kommen. Sie müssen über verschiedene Herausforderungen Bescheid wissen, denen Sie möglicherweise gegenüberstehen. Einige davon haben wir unten zusammengestellt.

Datenqualität und Genauigkeit

Diese Art von Daten kann in der Qualität variieren. Möglicherweise müssen Sie mit bestimmten Ungenauigkeiten umgehen. Wie bereits erwähnt, ist eine Validierung ein Muss. Es kann jedoch schwierig sein, die Präzision aufrechtzuerhalten.

Änderungen der Website-Struktur

Websites unterliegen häufig Änderungen im Layout oder in den Datenpräsentationsmethoden. Diese Änderungen können Ihre vorhandenen Web-Scraping-Skripte stören. Es kann zu unterschiedlichen Fehlern kommen. Um dies zu vermeiden, müssen Sie regelmäßig einige Anpassungen vornehmen.

Anti-Scraping-Maßnahmen

Einige Webseiten nutzen diese Maßnahmen zum Schutz ihrer Daten. Möglicherweise benötigen Sie einige fortgeschrittene Techniken und Instrumente, um diese Hindernisse zu überwinden. Dies kann Ihren Web-Scraping-Prozess erheblich komplizierter machen.

Volumen und Skalierbarkeit

Wenn Sie Ihre Bemühungen skalieren, kann es schwierig sein, viele Daten zu verwalten. Möglicherweise müssen Sie mehr in zusätzliche Infrastruktur und Optimierungsstrategien investieren.

Integrationskomplexität

Wie bereits erwähnt, können diese Daten in verschiedenen Formen vorliegen. BI-Tools haben oft spezifische Anforderungen. Daher kann ihre Kombination eine komplexe Aufgabe sein. Der Standardisierungsprozess kann ziemlich schwierig und zeitaufwändig sein.

Abhängigkeit von Websites Dritter

Bedenken Sie, dass Web Scraping grundsätzlich von der Stabilität der Websites Dritter abhängt. Änderungen ihrer Richtlinien, Schließungen oder Ausfallzeiten können Ihre Bemühungen beeinträchtigen.

Abschluss

Es besteht kein Zweifel, dass für jedes Unternehmen eine regelmäßige Geschäftsanalyse notwendig ist. Hierfür stehen unterschiedliche Instrumente und Verfahren zur Verfügung. Unter ihnen stechen Business-Intelligence-Tools hervor. Sie vereinfachen den Analyseprozess und ermöglichen es Ihnen, einige bemerkenswerte Punkte zu untersuchen.

Web-Scraping-Daten können die Kapazitäten dieser Tools noch weiter steigern. Denken Sie also darüber nach, es in Ihre BI-Strategien zu integrieren. Dies kann zu genaueren und strategischeren Entscheidungen führen. Sie müssen jedoch bedenken, dass es auf Ihrem Weg einige Schwierigkeiten geben kann. Sie müssen über alle Änderungen und alle gesetzlichen Anforderungen auf dem Laufenden bleiben.

Wir hoffen, dass Sie unseren Leitfaden hilfreich fanden. Zögern Sie nicht, neue Kombinationen auszuprobieren. Diese Integration kann für Sie in vielerlei Hinsicht von Vorteil sein.