Verloren in einer Bibliothek epischen Ausmaßes suchen Sie verzweifelt nach dem Schlüssel, der Ihr nächstes Kapitel aufschließt.

Berge von Informationen umgeben Sie, und das Finden des entscheidenden Teils fühlt sich an, als würde man nach der Nadel im Heuhaufen suchen.

Vor diesem Hintergrund ist Web Scraping unerlässlich, um Daten aus den riesigen Informationsmengen im World Wide Web zu sammeln. Aber das ist noch nicht alles – die Datenextraktion ist nur die Spitze des Eisbergs. Das Ziel besteht darin, über saubere, relevante und aussagekräftige Daten zu verfügen, die Ihnen einen Mehrwert bieten können.

Sie können die Bedeutung der Datenqualität erkennen, wenn Sie sich Erkenntnisse wie die von Gartner ansehen, die besagt, dass schlechte Datenqualität Unternehmen durchschnittlich 12,9 Millionen US-Dollar kostet. Bei der Sicherstellung der Datenqualität kommt der Prozess „Extrahieren, Transformieren, Laden“ (ETL) ins Spiel.

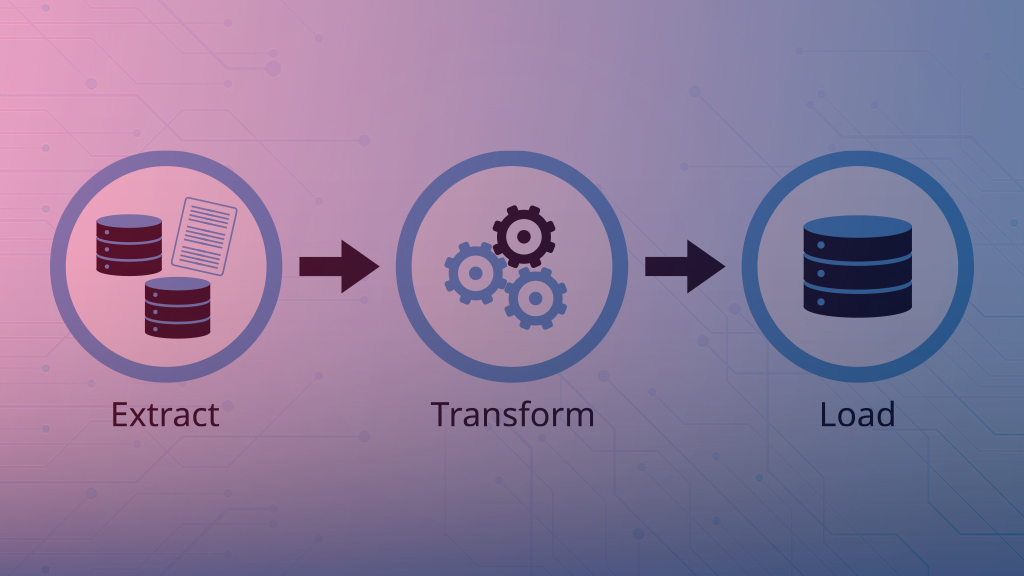

Extract, Transform, Load (ETL) ist ein dreistufiger Prozess, der mit der Datenextraktion aus mehreren Quellen beginnt. Nach der Datenextraktion transformieren Sie sie entsprechend den Geschäftsanforderungen.

Im dritten Schritt laden Sie die transformierten Daten in eine Ausgabedatenbank oder ein Data Warehouse. Infolgedessen hostet die Ausgabedatenbank oder das Data Warehouse konsistente Daten, die für die Analyse zuverlässig sind.

Extrakt: Dies ist die erste Phase, in der Sie Daten aus verschiedenen Quellen extrahieren. Ein treffendes Beispiel ist Web Scraping durch Bots, die auf den riesigen digitalen Online-Inhalten operieren.

Verwandeln: Dies ist die zweite Phase, in der Sie die im Staging gesammelten Daten zur Verarbeitung zusammenfassen. Die Verarbeitung umfasst das Bereinigen, den Umgang mit fehlenden Werten, das Entfernen von Duplikaten, das Definieren der Datenintegrität, das Transformieren von Datentypen usw.

Abhängig von den Geschäftsanforderungen können Sie aus den vorhandenen Daten spezifische Kennzahlen ableiten. Diese Metriken ermöglichen eine einfachere, schnellere und aussagekräftigere Berichterstattung und Analyse. Die Transformationsphase ist von entscheidender Bedeutung, da sie die Daten verarbeitet, um sie in eine für die Analyse relevante Form zu bringen. Im Fall von Daten aus Web Scraping ist es von enormem Wert – mehr zu diesem Thema später.

Belastung: Dies ist die dritte Phase, in der Sie die transformierten Daten in eine Datenbank, einen Data Mart, ein Data Warehouse oder ein anderes Speichersystem laden. Es ist wichtig, über das richtige Datenbankdesign zu verfügen, um die Daten für einen einfachen Abruf und eine aussagekräftige Analyse zu speichern.

Sie können sich vorstellen, wie ineffizient und unzuverlässig die Datenanalysen wären, wenn Sie die oben genannten 3 Phasen nicht ordnungsgemäß durchführen. Das Fehlen eines geeigneten ETL könnte ein echtes Problem sein. Wenn ETL jedoch richtig und rechtzeitig angegangen wird, stellt es eine zentrale Informationsquelle für das Unternehmen dar.

Warum ist ETL für die Verarbeitung von Daten aus Web Scraping unerlässlich?

Web Scraping ist unerlässlich, kann jedoch oft zu einem Dump mit unstrukturierten Rohinformationen führen, die möglicherweise von geringem Nutzen sind. Ein gut konzipierter ETL-Prozess stellt sicher, dass die Daten verarbeitet und in eine aussagekräftige Quelle für Erkenntnisse umgewandelt werden:

- Datenintegration: ETL integriert Daten aus verschiedenen Quellen und Prozessen und wandelt die Daten in eine konsistente Form um. Beim Web Scraping können Sie Daten von mehreren Websites abrufen lassen. Durch die ordnungsgemäße Datenintegration wird sichergestellt, dass die Daten vereinheitlicht sind und inkonsistente Definitionen ausgeschlossen werden.

- Datenqualität: Das Internet kann ungenaue und irreführende Daten liefern. Ein sorgfältig ausgearbeitetes ETL-Design bereinigt Inkonsistenzen, entfernt Duplikate und verarbeitet fehlende Daten, um eine hohe Qualität sicherzustellen.

- Automatisierung im Maßstab: Sie können den gesamten Prozess des Extrahierens, Transformierens und Ladens automatisieren. Automatisierung ermöglicht saubere, zuverlässige Daten im großen Maßstab, kontinuierlich und effizient. Die Geschäftsbeteiligten müssen nicht stunden- und tagelang warten, wenn die ETL-Pipelines automatisiert sind, um einen konstanten Datenzufluss zu bewältigen.

- Erweiterte Analysen: ETL wandelt die Eingabedaten in ein strukturiertes Format um, das die Nutzung durch Abfragen, Berichte, erweiterte Analysen oder Modelle für maschinelles Lernen erleichtert.

Wie ETL das Chaos behebt

Um etwas tiefer zu gehen: Daten aus Web Scraping sind aufgrund ihrer Beschaffenheit fehleranfällig. Durch Web Scraping gewonnene Daten sind unstrukturiert, und die Rolle von ETL bei der Verarbeitung solcher Daten ist von entscheidender Bedeutung:

- Suboptimaler Website-Code: Die meisten Entwickler programmieren Websites nicht gut, was zu Problemen beim Web Scraping führt. Beispielsweise kann das Auslesen von Daten aus schlechtem HTML-Code zu ungenauen und irreführenden Szenarien führen. Die Transformationsphase von ETL kümmert sich darum, indem sie die Daten in einen genauen und konsistenten Zustand bringt.

- Dynamisches Laden von Inhalten: Websites verwenden häufig dynamisches Laden von Inhalten, was es für Web-Scraper schwierig machen kann, alle relevanten Daten zu sammeln. ETL-Prozesse können dies bewältigen, indem sie dynamische Inhalte entsprechend transformieren

- Textverarbeitung: Das Extrahieren von Informationen aus unstrukturiertem Text wie Blogs und Artikeln kann eine Herausforderung sein. Moderne ETL-Skripte, die mit NLP-Funktionen (Natural Language Processing) ausgestattet sind, können Textdaten analysieren und verarbeiten, sodass sie für zuverlässige Analysen geeignet sind.

Wie richtet man ETL für Web Scraping ein?

Wir haben ausführlich über die Notwendigkeit von ETL gesprochen, um beim Data Scraping fruchtbare Ergebnisse zu erzielen. Wie richten Sie den richtigen ETL-Prozess für Web Scraping ein? Lassen Sie uns kurz darauf eingehen. Im Folgenden sind die wichtigsten Schritte aufgeführt, die Sie möglicherweise ergreifen sollten, um den ordnungsgemäßen ETL-Prozess in Gang zu bringen:

1) Anforderungen definieren: Bestimmen Sie die Websites oder Webseiten, von denen Sie Daten extrahieren möchten. Legen Sie eine Strategie für die Datenformate fest, die Sie extrahieren möchten, für die Transformationsverfahren unter Berücksichtigung der Geschäftsregeln, für die Ausgabedatenformate und für das Design der Zieldatenbank.

2) Toolset/Technologie-Stack identifizieren: Identifizieren Sie die Technologien und Tools, die für jede der drei Phasen in ETL erforderlich sind. Sie könnten beispielsweise Selenium für die Datenextraktion, Python für die Datentransformation und MySQL für das Ziel-Data-Warehouse wählen.

3) Sorgen Sie für eine reibungslose Ausführung:

- Nutzen Sie Web-Scraping-Bibliotheken für die Datenextraktion, indem Sie HTTP-Anfragen senden, HTML analysieren und relevante Informationen extrahieren. Halten Sie sich an die Allgemeinen Geschäftsbedingungen der Website, um bei der Datenextraktion rechtliche und ethische Aspekte einzuhalten.

- Transformieren Sie Daten, einschließlich Konvertieren von Datentypen, Umbenennen von Spalten, Umgang mit fehlenden Werten, Erstellen abgeleiteter Daten basierend auf Geschäftsanforderungen usw.

- Laden Sie die Daten mithilfe optimaler Abfragen in die Zieldatenbank oder das Data Warehouse. Die optimalen Abfragen bieten schnelle Antworten für Benutzer, die nach Berichten und Analysen suchen.

4) Automatisierung des ETL-Prozesses: Automatisieren Sie den ETL-Prozess in geplanten Abständen mit Tools wie Apache Airflow.

5) Überwachung und Verfeinerung: Überwachen Sie den ETL-Prozess auf Fehler und Probleme und protokollieren Sie solche Vorfälle. Beheben Sie die Fehler und Probleme, um den ETL-Prozess robuster zu machen

Zusammenfassend lässt sich sagen, dass Sie einen gut durchdachten ETL-Prozess und eine nahtlose Ausführung benötigen, um beim Web Scraping gute Ergebnisse zu erzielen. Im Vergleich zum Nutzen zuverlässiger Daten zur Entscheidungsunterstützung stellen die Kosten minderwertiger Daten eine große Kluft dar, die ETL benötigt, um diese Lücke zu schließen und die bestmöglichen Ergebnisse zu erzielen.