TL;DR: Die besten Proxys für die KI-Datenerfassung im Ranking

Bevor wir uns näher mit den einzelnen Proxy-Anbietern befassen, hier ein kurzer Überblick für alle, die es eilig haben:

| Proxy-Anbieter | Preis | Bewertung (Trustpilot) | Geotargeting | Standort |

| ScraperAPI | Ab 49 $ | 4,7/5 | Ja | Weltweit |

| ProxyEmpire | Ab 25 $ | 4,7/5 | Ja | Über 170 Länder |

| NetNut | Ab 84 $ | 4,6/5 | Ja | Mehrere Standorte |

| IPRoyal | 1,57 $/Proxy | 4,6/5 | Ja | Über 50 Länder |

| SOAX | Ab 49 $ | 4,4/5 | Ja | Mehrere Standorte |

| Webshare | 7 $/GB | 4.1/5 | Ja | Mehrere Standorte |

| SmartProxy | Ab 7 $/GB | 3,7/5 | Ja | Über 195 Standorte |

1. ScraperAPI (beste Proxys für KI-Daten-Scraping)

ScraperAPI zeichnet sich als vollständige Web-Scraping-Lösung aus, die speziell für die Bewältigung der Komplexität sowohl des statischen als auch des dynamischen Content-Scrapings entwickelt wurde.

Durch die Nutzung von maschinellem Lernen rotieren IP-Adressen intelligent und stellen so sicher, dass Anfragen jederzeit über den effizientesten Proxy weitergeleitet werden. Dieser Ansatz ist für die KI-Datenerfassung von entscheidender Bedeutung, da er Ausfallzeiten minimiert und die Erfolgsraten beim Scraping von Daten maximiert.

Die Fähigkeit von ScraperAPI, statische und dynamische Inhalte zu verarbeiten, sowie seine strukturierten Datenendpunkte für gängige Plattformen machen es ideal für das Training von KI-Modellen, die auf verschiedenen Datenquellen basieren.

Bewertung (Trustpilot): 4,7/5

Hauptmerkmale

- Intelligenter Proxy und Header-Rotation: ScraperAPI nutzt maschinelles Lernen, um die Proxy-Rotation zu optimieren und sicherzustellen, dass Anfragen effizient bearbeitet werden.

- Intelligentes JavaScript-Rendering: Rendert JavaScript-lastige Seiten und ermöglicht so ein nahtloses Scraping dynamischer Inhalte.

- Strukturierte Datenendpunkte für beliebte Websites: Vorkonfigurierte Endpunkte machen das Scraping von großen, gefragten Websites einfacher, sparen Zeit beim Parsen und erhalten wichtige Informationen im JSON- oder CSV-Format.

- DataPipeline: Ermöglicht Benutzern die Automatisierung wiederkehrender Scraping-Aufgaben und verbessert so die Workflow-Effizienz für die laufende Datenerfassung.

- Geotargeting für alle Standorte: ScraperAPI unterstützt präzises geografisches Targeting, was eine lokalisierte Datenerfassung für KI-Modelle ermöglicht, die unterschiedliche regionale Datensätze benötigen.

- Erweiterte CAPTCHA-Verarbeitung: ScraperAPI verarbeitet CAPTCHA-Herausforderungen automatisch und reduziert so den Bedarf an manuellen Eingriffen.

Für und Wider

| Vorteile | Nachteile |

| Ultra-Premium-Proxys | Einige Einschränkungen bei Free-Tarif-Plänen (Anzahl der API-Credits) |

| Effizientes IP-Rotationssystem basierend auf maschinellem Lernen | Geotargeting in den USA und Großbritannien für kleinere Pläne |

| Starke Unterstützung für dynamisches Content-Scraping | |

| Sehr einfach zu bedienen | |

| Automatische Handhabung von Wiederholungsversuchen | |

| CAPTCHA-Verwaltung | |

| Unterstützung für skalierbare Automatisierung durch DataPipeline. | |

| Bereitstellung von Webhook-Daten | |

| API-Spielplatz | |

| Transparente Projektpreise | |

| Exklusive API-Endpunkte |

Preisaufschlüsselung

ScraperAPI bietet flexible Preise basierend auf der Anzahl der API-Credits, die erst nach einer erfolgreichen Anfrage abgezogen werden, und nicht pro GB oder Bandbreite, wie bei anderen Web-Scraping-Tools.

Die Anzahl der verbrauchten Credits hängt von der Domain, dem Schutzniveau der Website und den spezifischen Parametern ab, die Sie in Ihrer Anfrage angeben. Allerdings sind diese API-Kreditkosten fest und gut dokumentiert.

Beispielsweise beinhaltet der niedrigste Plan von ScraperAPI, der 49 US-Dollar kostet, 1.000.000 API-Credits, was Folgendes entspricht:

- 1.000.000 erfolgreich gescrapte Seiten (1 API-Credit pro Anfrage)

- 200.000 erfolgreich gescrapte E-Commerce-Seiten (5 API-Credits pro Anfrage)

- 40.000 erfolgreich gescrapte SERP-Seiten (25 API-Credits pro Anfrage)

Hier ist eine Aufschlüsselung des Preismodells von ScraperAPI:

| Planen | Preise | API-Credits |

| Kostenlose Testversion (7 – Tage) | Frei | 5000 |

| Hobby | 49 $ | 100.000 |

| Start-up | 149 $ | 1.000.000 |

| Geschäft | 299 $ | 3.000.000 |

| Unternehmen | 299 $ + | 3.000.000 + |

Besuchen Sie die Seite „Credits und Anfragen“ von ScraperAPI, um die Credit-Nutzung im Detail zu sehen.

2. ProxyEmpire (vielseitige Preise)

ProxyEmpire ist ein vielseitiger Proxy-Anbieter, der für seinen umfangreichen globalen Proxy-Pool bekannt ist und sowohl private als auch mobile IPs anbietet. Diese große IP-Vielfalt macht es perfekt für Unternehmen, die Daten von mehreren geografischen Standorten benötigen, und ermöglicht eine präzise Datenerfassung über verschiedene Regionen hinweg.

ProxyEmpire konzentriert sich auf Flexibilität und ermöglicht Benutzern den Kauf von Bandbreite nach Bedarf. Dies macht es zu einer großartigen Wahl für KI-Entwickler, die Kontrolle über ihre Proxy-Nutzung benötigen, ohne hohe Vorabkosten in Kauf nehmen zu müssen.

Bewertung (Trustpilot): 4,7/5

Hauptmerkmale

- Über 170 Länder und über 9.500.000 weltweit saubere IP-Adressen

- Geotargeting

- CAPTCHA-Verwaltung

- Verschiedene Proxy-Typen

- Dedizierter Support

Für und Wider

| Vorteile | Nachteile |

| Großer globaler IP-Pool | Für Benutzer mit hoher Nutzung können sich die Preise summieren |

| Flexible Preispläne basierend auf der Bandbreitennutzung | weniger Anpassungsmöglichkeiten im Vergleich zu Mitbewerbern |

| Starke Geotargeting-Fähigkeiten | |

| Robuste CAPTCHA-Verwaltungsfunktionen |

Preisaufschlüsselung

ProxyEmpire bietet ein flexibles Preismodell, das es Benutzern ermöglicht, Proxys basierend auf der Bandbreite zu erwerben. Allerdings ist es im Vergleich zu ScraperAPI und anderen Konkurrenten teurer, wobei die Pläne bei 45 $ für 5 GB beginnen. Dennoch bietet die Pay-as-you-go-Option von ProxyEmpire Flexibilität und ist somit eine geeignete Wahl für diejenigen, die sich lieber nicht auf langfristige Pläne festlegen möchten.

| Stellvertreter | Preis |

| Rotierendes Wohnen | Ab 40 $ |

| Statisches Wohnen | Ab 40 $ |

| Rotierendes Mobil | Ab 50 $ |

| Spezielles Mobiltelefon | Ab 125 $ |

| Rotierendes Rechenzentrum | Ab 25 $ |

Für 49 US-Dollar pro Monat ist ScraperAPI besser in der Lage, komplexe, dynamische Inhalte mit automatischen Wiederholungsversuchen und auf maschinellem Lernen basierender IP-Rotation zu verarbeiten, was ProxyEmpire fehlt. ScraperAPI automatisiert auch die CAPTCHA-Verarbeitung nahtloser und ist somit eine geeignetere Option zum Extrahieren von Daten für die KI-Entwicklung.

3. NetNut (am besten für ISP-basierte Hochgeschwindigkeits-Proxys geeignet)

NetNut ist ein reiner Proxy-Anbieter, der mit anderen Scraping-Tools wie Selenium verwendet werden kann. Es bietet direkte Routen über ISPs und gewährleistet so eine konsistente Hochgeschwindigkeitsleistung und höhere Zuverlässigkeit. Dies macht es zu einer bevorzugten Option für groß angelegte KI-Datenerfassungsaufgaben, bei denen Geschwindigkeit und Stabilität entscheidend sind.

Insbesondere für diejenigen, die große Datensätze sammeln, ist die Zuverlässigkeit statischer IPs ohne häufige Rotation ein entscheidender Vorteil für die Datenkonsistenz.

Bewertung (Trustpilot): 4,6/5

Hauptmerkmale

- Direkte ISP-Konnektivität

- Geo-Targeting

- Echtzeit-Nutzungs-Dashboard

- Hochgeschwindigkeitsleistung

- Geotargeting für alle Standorte

Für und Wider

| Vorteile | Nachteile |

| Schnelle statische Proxys, die direkt von ISPs bezogen werden | Hohe Preise |

| Optimiert für die Datenerfassung im großen Maßstab | Die günstigsten Tarife beinhalten keinen Live-Support. Nur E-Mail |

| Kostenlose Testversion | Die kostenlose Testversion dauert nur eine Woche |

| Hervorragend geeignet zum Scrapen dynamischer Inhalte und zum Umgehen von CAPTCHAs | |

| Starke Geotargeting-Funktionen |

Preisaufschlüsselung

NetNut arbeitet mit einem Abonnementmodell, das auf der Bandbreitennutzung basiert und bei 300 US-Dollar für 20 GB monatliche Daten beginnt. Seine Preisgestaltung sticht im mittleren bis Premium-Bereich heraus, was durch seine direkten ISP-Verbindungen und seine Konsistenz gerechtfertigt ist.

Der höhere Preis bietet ein gutes Preis-Leistungs-Verhältnis für große Projekte, die Stabilität benötigen, für kleinere Teams oder Projekte kann es jedoch einschränkend wirken. Mit zunehmender Nutzung werden die Kosten pro GB wettbewerbsfähiger.

Allerdings könnte das Fehlen kleinerer, erschwinglicherer Tarife für Gelegenheitsnutzer ein Nachteil für diejenigen sein, die gerade erst mit der KI-Datenerfassung beginnen.

| Stellvertreter | Preis/Monat |

| Wohn-Proxies | Ab 84 $ |

| Statische Wohn-Proxys | Ab 84 $ |

| Rechenzentrums-Proxys | Ab 90 $ |

| Mobile Proxys | Ab 84 $ |

Erwähnenswert ist auch, dass NetNut sich bei statischen ISP-Verbindungen auszeichnet, sodass Alternativen wie ScraperAPI eine bessere Option für Projekte sind, die eine IP-Rotation in großem Maßstab erfordern.

ScraperAPI ist deutlich günstiger als NetNut und daher eine bessere Wahl für kleinere Teams, Start-ups und mittelständische Unternehmen, die ihre Kosten im Griff haben möchten, ohne auf Funktionen zu verzichten. ScraperAPI beginnt bei 49 US-Dollar pro Monat für 200.000 erfolgreiche API-Anfragen und ist damit deutlich zugänglicher als NetNuts 300 US-Dollar für einen 20-GB-Bandbreitenplan.

Für größere Unternehmen oder KI-Entwickler, die umfangreichere Vorgänge benötigen, lässt sich ScraperAPI gut skalieren, mit Optionen für unbegrenzte Bandbreitenpläne ab 200 $/Monat. Der niedrigere Einstiegspunkt ermöglicht es Unternehmen, klein anzufangen und ihre Nutzung im Laufe der Zeit zu steigern und die Kosten nach Bedarf anzupassen, während NetNut eine größere Vorabverpflichtung erfordert.

4. IPRoyal (Vertreter aus ethischen Quellen für Wohnimmobilien)

IPRoyal zeichnet sich dadurch aus, dass es ethisch einwandfreie Proxys für Wohnimmobilien anbietet. Dies ist ein entscheidender Gesichtspunkt, wenn Sie Wert auf Compliance und Transparenz bei der Datenerfassung legen. Dieser Proxy-Anbieter stellt sicher, dass alle privaten IPs von echten Benutzern stammen, die der Weitergabe ihrer IPs zustimmen. Seine Proxys sind äußerst zuverlässig und eignen sich daher ideal für das Training von KI-Modellen, insbesondere wenn reale Daten erforderlich sind.

Bewertung (Trustpilot): 4,6/5

Hauptmerkmale

- Exklusiver Proxy-Pool

- Über 34 Millionen ethische Proxy-Netzwerke

- SOCKS5 unterstützt

- Ausrichtung auf Städte/Bundesstaaten

- API-Zugriff

Für und Wider

| Vorteile | Nachteile |

| Ethisch beschaffte, echte Privat-IPs | Teuer für Großprojekte |

| Der Datenverkehr läuft nie ab | |

| Pay-as-you-go-Plan | |

| Nahtlose Proxy-Integration | |

| SOCKS5 unterstützt |

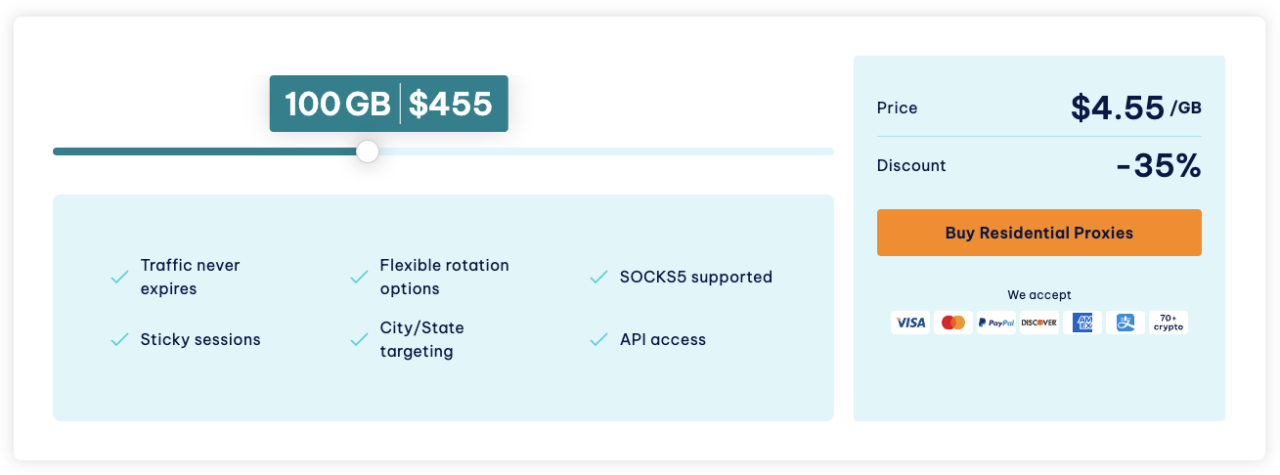

Preisaufschlüsselung

IPRoyal verfügt über ein wettbewerbsfähiges und unkompliziertes Preismodell. Privat-Proxys beginnen bei 7 US-Dollar pro GB, was für Unternehmen attraktiv ist, die der ethischen Datenerfassung Priorität einräumen, ohne Abstriche bei der Leistung zu machen. Der Preis für den Dienst wird pro GB und Proxy berechnet, abhängig vom Proxy-Typ, den Sie verwenden möchten.

Was IPRoyal von anderen Diensten unterscheidet, ist der nicht ablaufende Datenverkehr. Mit anderen Worten: Sobald Sie die Datenverkehrsmenge (z. B. 100 GB) gekauft haben, können Sie sie nutzen, wann immer Sie möchten. In den meisten Fällen ist keine monatliche Verpflichtung erforderlich.

| Stellvertreter | Preis |

| Wohnen | 1 GB 7 $ |

| Mobile | 130 $/Monat |

| Rechenzentrum | 1,57 $/Proxy |

| ISP | 1,80 $/Proxy |

| Unternehmen | Brauch |

5. SOAX (am besten für eine detaillierte Kontrolle der IP-Rotation geeignet)

SOAX zeichnet sich dadurch aus granulare Kontrolle über IPssodass Sie Proxys bis hin zu bestimmten Sitzungen und IP-Adressen verwalten können. Dies macht es ideal für KI-Datenerfassungsprojekte, die Präzision erfordern, wie z. B. das Scrapen lokalisierter Daten oder die Handhabung komplexer Webagenten. Sein sauberer Proxy-Pool sorgt in Kombination mit seinen rotierenden privaten und mobilen IPs für hohe Erfolgsraten, selbst bei anspruchsvollen Zielen wie geografisch eingeschränkten oder CAPTCHA-geschützten Websites.

Bewertung (Trustpilot): 4,4/5

Hauptmerkmale

- Anpassbare Proxy-Optionen

- Privatkunden, US-ISP, Rechenzentren und mobile IPs

- Granulare Kontrolle über die IP-Rotation

- Echtzeit-Leistungsüberwachung

- Weltweite IP-Abdeckung

Für und Wider

| Vorteile | Nachteile |

| Umfangreicher, weltweit stabiler IP-Pool | Keine kostenlose Testversion |

| Exzellenter Kundensupport | Für Projekte mit großer Bandbreite nicht kosteneffektiv |

| Hohes Maß an Kontrolle über Proxys und Sitzungsverwaltung | |

| Hervorragende Erfolgsraten beim Umgang mit geoblockten und CAPTCHA-geschützten Websites. |

Preisaufschlüsselung

SOAX verwendet ein verkehrsbasiertes Preismodell, bei dem Sie auf Basis der Datenmenge bezahlen, die Sie extrahieren möchten, gemessen in Gigabyte (GB). Dieses Modell kann bei Projekten, bei denen viele Inhalte heruntergeladen werden müssen (z. B. Bilder, Videos oder multimediale Seiten), teuer werden. Dennoch kann dies ein geeignetes Preismodell für Teams ohne konsistente Web-Scraping-Arbeitslast sein.

| Planen | Preis/Monat |

| Wohn-Proxy | 99 $ |

| Mobiler Proxy | 99 $ |

| US-ISP-Proxy | 99 $ |

| Rechenzentrums-Proxy (gemeinsam genutzt) | 49 $ |

6. Webshare (Beste budgetfreundliche Proxy-Lösung)

Webshare ist ein preisgünstiger Proxy-Anbieter, der ein solides Gleichgewicht aus Geschwindigkeit, Zuverlässigkeit und Anonymität bietet und somit eine erste Wahl ist, wenn Sie erschwingliche und dennoch effektive Proxys benötigen. Dieser Anbieter richtet sich an Startups, kleinere Unternehmen und KI-Entwickler, die mit knapperen Budgets arbeiten, aber dennoch hochwertige Proxys für ihre Datenerfassungsanforderungen benötigen.

Es ist dafür bekannt, eine große Anzahl von Proxys zu einem erschwinglichen Preis bereitzustellen, ohne zu große Kompromisse bei der Leistung einzugehen. Obwohl Webshare nicht so funktionsreich ist wie einige Premium-Konkurrenten, bietet es für den Preis eine solide Leistung.

Bewertung (Trustpilot): 4.1/5

Hauptmerkmale

- Über 30 Mio. private IPs

- Anpassbares Dashboard

- Schnelle und effiziente Proxys

- Verfügbar in 195 Ländern

- Erschwingliche Preise

Für und Wider

| Vorteile | Nachteile |

| Budgetfreundlich, je nach Proxy-Typ | Weniger erweiterte Funktionen für große Unternehmen |

| Bietet eine gute Balance zwischen Geschwindigkeit und Anonymität | Im Vergleich zu Premium-Anbietern kann es bei hoher Auslastung zu Leistungseinbußen kommen |

| Große Proxy-Auswahl | |

| Einfach zu verwenden für kleine bis mittlere Betriebe |

Preisaufschlüsselung

Webshare ist einer der günstigsten Proxy-Server-Anbieter auf dieser Liste und bietet kostenlosen Zugriff auf 10 Proxys zum Testen. Für größere Datenerfassungsanforderungen erhöhen sich die Preise, bleiben aber im Vergleich zu anderen Anbietern wettbewerbsfähig niedrig, was Webshare zu einer herausragenden Option für preisbewusste Benutzer macht, die nicht die erweiterten Funktionen teurerer Mitbewerber benötigen.

| Stellvertreter | Preis |

| Wohn-Proxy | 7 $/GB |

| Statischer Wohn-Proxy | 6 $/Monat für 20 Proxys |

| Proxyserver | 2,99 $ für 100 Proxys |

| Verifizierter Proxy | 0,6 $/GB, 150 $/Monat |

Obwohl Webshare günstiger ist, kann die anforderungsbasierte Preisgestaltung von ScraperAPI für diejenigen günstiger sein, die umfangreichere Datenmengen oder dynamische Inhalte effizient durchsuchen müssen. ScraperAPI bietet erweiterte Funktionen wie IP-Rotation durch maschinelles Lernen und eine bessere Handhabung komplexer Inhalte, während Webshare einfacher ist und sich besser für leichte Aufgaben eignet.

7. SmartProxy (Große private Proxy-Pools)

SmartProxy ist ein äußerst vertrauenswürdiger Proxy-Anbieter, der für sein umfangreiches Proxy-Netzwerk für Privatanwender bekannt ist und über 40 Millionen IPs anbietet. Das benutzerfreundliche Dashboard und die APIs erleichtern kleinen und großen Unternehmen die Arbeit.

Was SmartProxy auszeichnet, ist sein Fokus auf private Proxys, die für Websites schwer zu erkennen und zu blockieren sind. Dies macht es ideal für die Umgehung von Geobeschränkungen, CAPTCHAs und anderen Anti-Bot-Mechanismen und stellt sicher, dass KI-Modelle weltweit auf Daten zugreifen können, ohne IP-Blockierung.

Bewertung (Trustpilot): 3,7/5

Hauptmerkmale

- Großer Pool an Wohn-Proxys

- Rotierende und Sticky-Sessions

- Weltweite Abdeckung

- Hervorragende API-Integration

- Umgehen Sie CAPTCHAs und geografische Beschränkungen

- Benutzerfreundliches Dashboard

- Unbegrenzte gleichzeitige Sitzungen

- Bereit zur Verwendung der API

Für und Wider

| Vorteile | Nachteile |

| Riesiger privater Proxy-Pool, der es schwierig macht, Scraping-Aktivitäten zu erkennen | Bandbreitenbeschränkungen können bei groß angelegtem Scraping teuer werden |

| Gut für die meisten Web-Scraping-Anwendungsfälle | |

| Hochgeschwindigkeitsleistung mit minimaler Ausfallzeit. | |

| Ausrichtung auf Länder, Städte und Postleitzahlen | |

| Gebrauchsfertige Scraper-API | |

| HTTP(S)- und SOCKS5-Unterstützung | |

| Bietet Kundensupport rund um die Uhr | |

| Bietet eine Pay-as-you-go-Option |

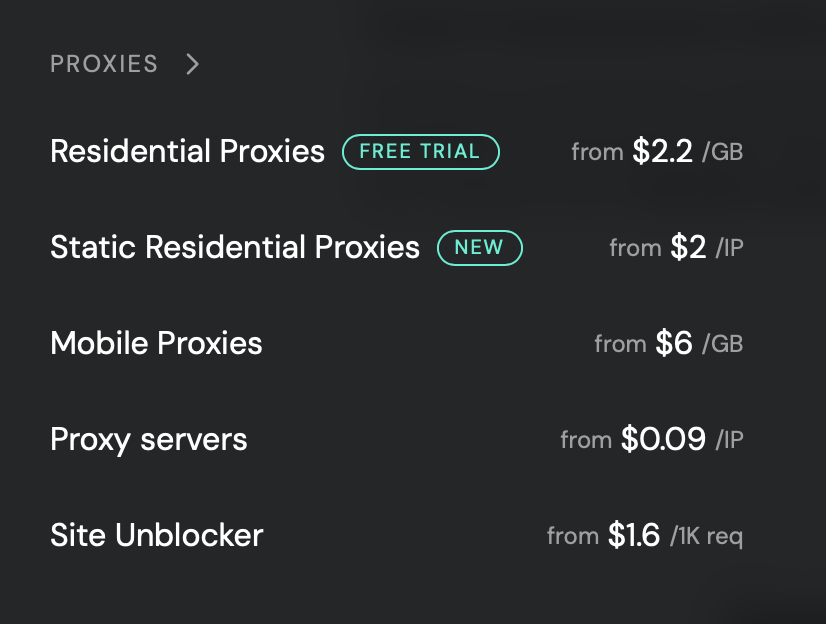

Preisaufschlüsselung

SmartProxy arbeitet auf a bandbreitenbasiertes PreismodellDas bedeutet, dass Sie je nach übertragenem Datenvolumen bezahlen. Dies kann teuer werden, wenn Ihre Scraping-Aktivitäten einen hohen Datenverbrauch erfordern (z. B. das Herunterladen großer Mengen an Multimedia-Inhalten oder das Scrapen zahlreicher Seiten).

Wenn Sie dennoch nach umfangreichen Proxy-Pools für Privathaushalte suchen, bietet ScraperAPI über 70 Millionen Privat-Proxys in mehr als 150 Ländern, was Ihnen noch mehr Geotargeting-Optionen und einen größeren Pool für die IP-Rotation bietet.

Warum Proxys für die Datenerfassung für das KI-Training wichtig sind

Das Sammeln von Daten für das KI-Training bringt mehrere Herausforderungen mit sich. Websites verwenden häufig Techniken wie

- IP-Blockierung,

- Geobeschränkungen

- CAPTCHAs

Um nur einige zu nennen: Um die automatisierte Datenerfassung zu verhindern. Diese Hindernisse behindern die Datenerfassung erheblich und erschweren den Zugriff auf die großen, vielfältigen Datensätze, die für KI-Modelle benötigt werden.

Proxys helfen, diese Herausforderungen zu meistern, indem sie eine Möglichkeit bieten

- IP-Adressen rotieren, wodurch IP-Blockierung verhindert wird

- Geobeschränkungen umgehen

- CAPTCHA-Systeme umgehen

Mit dem richtigen Proxy können KI-Entwickler Daten aus verschiedenen Regionen sammeln, dynamische Inhalte extrahieren und hohe Erfolgsraten aufrechterhalten, während sie gleichzeitig die Erkennung durch Anti-Bot-Systeme vermeiden.

Über technische Hürden hinaus stellen Proxys auch sicher, dass die gesammelten Daten:

- zuverlässig

- vielfältig

- skalierbar

Für das KI-Training ist es wichtig, Daten aus mehreren Quellen ohne Duplikate oder Fehler zu sammeln. Proxys machen dies möglich, indem sie einen nahtlosen Zugriff auf Daten von verschiedenen geografischen Standorten ermöglichen und durchgängig qualitativ hochwertige Daten liefern. Dadurch können KI-Modelle aus einem breiteren Spektrum an Eingaben lernen und so ihre Genauigkeit und Leistung in der Praxis verbessern.

Hauptmerkmale effektiver Proxys für KI-Webagenten

- Skalierbarkeit und Bandbreite

- IP-Diversität (geografische und private/mobile Proxys)

- Geschwindigkeit und geringe Latenz

- Umgehen von CAPTCHAs und Anti-Bot-Systemen

- Geotargeting

- Zuverlässigkeit und Verfügbarkeit

- Ethische Überlegungen (Vermeidung von Datenmissbrauch, Compliance)

Warum Sie ScraperAPI verwenden sollten

ScraperAPI bietet eine bessere Automatisierung und erweiterte Scraping-Funktionen für die KI-Datenerfassung zu einem kostengünstigeren Preis für große oder komplexe Scraping-Projekte. Darüber hinaus machen seine erweiterten Funktionen wie asynchrones Scraping und integrierte Planungsoptionen ScraperAPI zum umfassendsten Tool auf der Liste.

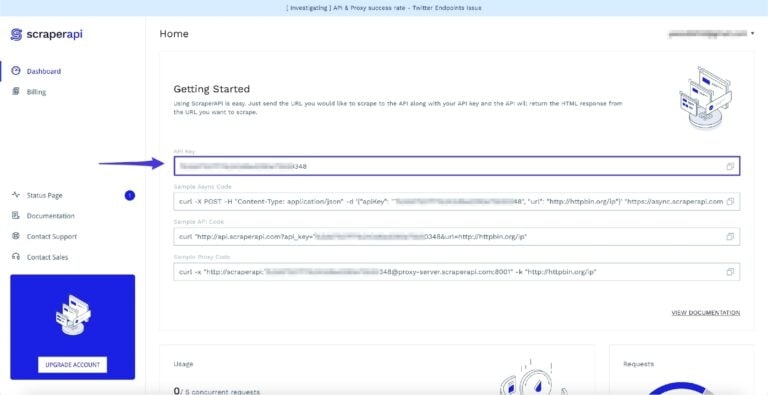

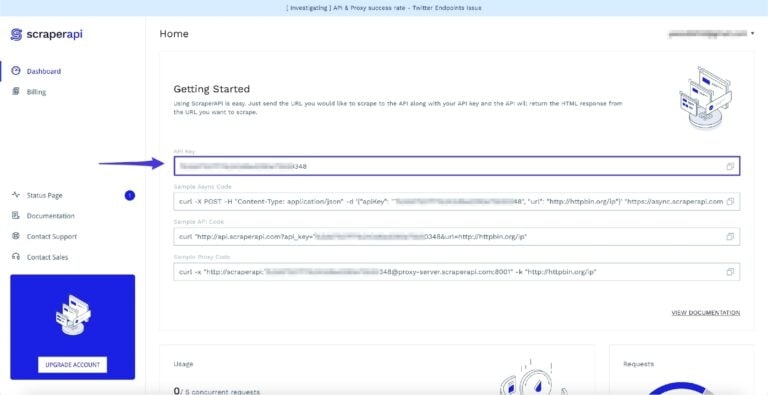

Allein in Bezug auf Proxys bietet ScraperAPI einen Proxy-Pool von über 150 Millionen Proxys, einschließlich Proxys für Privatanwender und Mobilgeräte, sowie ein einzigartiges intelligentes IP-Rotationssystem, das auf maschinellem Lernen und statistischer Analyse basiert. Dieses System generiert passende Header und Cookies pro Anfrage und gibt Ihnen die volle Kontrolle über Sitzungen. Der Einstieg ist so einfach wie die Erstellung eines kostenlosen ScraperAPI-Kontos, um auf Ihren API-Schlüssel zuzugreifen und Ihre Anfrage über unsere Scraping-API oder einen unserer strukturierten Datenendpunkte zu senden .

Mit Ihrem kostenlosen Konto erhalten Sie 5.000 API-Credits für eine siebentägige Testversion, die beginnen kann, wann immer Sie dazu bereit sind.

Einpacken

Bei der KI-Datenerfassung sind Proxys unerlässlich, um den Zugriff auf große, vielfältige Datensätze ohne Unterbrechungen durch IP-Blockierung, Geobeschränkungen und CAPTCHAs sicherzustellen. Jeder Proxy-Anbieter hat seine Stärken, aber die richtige Wahl hängt von Ihren spezifischen Anforderungen ab, einschließlich IP-Vielfalt, Automatisierung, Preisgestaltung und dem Umfang der Daten, die Sie durchsuchen müssen.

Durch die Verwendung des richtigen Proxy-Dienstes können Sie vielfältige, zuverlässige und skalierbare Daten sammeln, die für das Training präziser KI-Modelle unerlässlich sind.