Wussten Sie, dass es in einer Welt, die von Informationen überschwemmt wird, wie die Suche nach der Nadel im Heuhaufen ist, die Rohdaten aus dem Internet zu verstehen? Wenn man jedoch den Silberstreif am Horizont betrachtet, kann das dynamische Duo – ETL und Web Scraping – das Chaos unbegrenzter, unstrukturierter Daten in Klarheit bringen und Sinn ergeben.

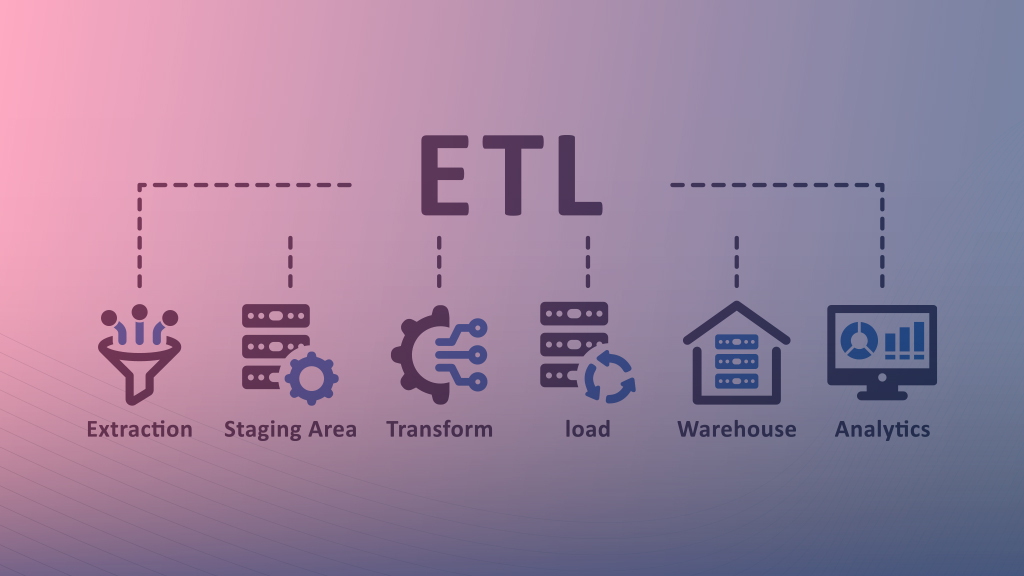

ETL ist die Abkürzung für „Extrahieren, Transformieren und Laden“ und bezeichnet einen Datenintegrationsprozess. Wie der Name schon sagt, werden Daten aus mehreren Quellen extrahiert, transformiert und in ein System geladen.

Lassen Sie uns nun näher auf die Synergie mit Web Scraping eingehen.

Beim Web Scraping werden verwertbare Daten von Websites und Webseiten zur Analyse gesammelt, um datengesteuerte Initiativen zu fördern.

Beim Web-Scraping-Prozess geht es um das Extrahieren, Umwandeln und Laden von Daten von Websites in lesbare Dateien.

Daher ist ETL ein wesentlicher Schritt beim Web Scraping, um Daten aus der riesigen Fläche des Webs nahtlos zu sammeln und zu organisieren.

ETL in einfachen Worten verstehen

Um Extraktion, Transformation und Laden umfassender zu verstehen, geben wir Ihnen eine einfache Spielzeugkiste-Analogie.

Extrahieren: So einfach es auch klingt, Extrahieren bezieht sich auf das Erfassen von Informationen. Angenommen, Sie haben eine riesige Kiste voller Spielzeugautos. Das Auswählen bestimmter Autos aus dieser Box ist Extrahieren.

Transformieren: Transformieren bedeutet, die Spielzeuge anders zu verändern oder zu organisieren, als sie ursprünglich waren. Nehmen wir an, Sie möchten, dass alle Ihre Autospielzeuge nach ihren Farben sortiert werden. Die roten Autos sind also zusammen, die blauen sind zusammen und so weiter.

Laden: Nachdem Sie die Autospielzeuge schließlich nach Farben sortiert haben, legen Sie sie in separate Behälter, wo sie an den dafür vorgesehenen Plätzen stehen.

Nachdem Sie das nun verstanden haben, ist es beim Web Scraping ganz ähnlich.

Auszug: Stellen Sie sich wie im Beispiel Spielzeugautos bestimmte Informationen von einer Website vor. Beim Extrahieren im Web Scraping werden Daten von einer Website gesammelt, beispielsweise das Abrufen aller Produkttitel von Parfüms von der Amazon-Suchergebnisseite.

Transformieren: Nachdem Sie alle Titel gesammelt haben, möchten Sie sie alphabetisch ordnen. Bei der Transformation im Web Scraping ändert sich nun das Format oder die Struktur der Daten. In diesem Fall werden die gesammelten Daten also in einer alphabetischen Reihenfolge angeordnet.

Laden: Schließlich müssen die transformierten Daten irgendwo gespeichert werden, wo wir sie bei Bedarf finden können. Beim Laden im Web Scraping wird die organisierte Datendatei an einem Ort für die spätere Verwendung, beispielsweise für die Analyse, gespeichert.

Beim ETL-Data-Scraping werden also Daten von einer bestimmten Webseite abgerufen, die Daten im erforderlichen Format sortiert und gespeichert, sodass Sie leicht darauf zugreifen und sie für die Entscheidungsfindung verwenden können.

Web Scraping ist eine Lösung, die automatisch durch Websites navigiert und relevante Daten in großem Maßstab extrahiert. Die Daten werden in einem bevorzugten Dateityp gespeichert und für die Bewerbung und fundierte Entscheidungsfindung genutzt.

Der Prozess wird mit einer HTTP-Anfrage an eine gewünschte Website eingeleitet und daraus können Sie den HTML-Inhalt der spezifischen Webseite extrahieren.

Der HTML-Inhalt wird nun analysiert (d. h. eine Datei oder ein Datensatz wird so aufgeteilt, dass er leicht bearbeitet und gespeichert werden kann), um genau die erforderlichen Elemente zu speichern.

Nachdem Sie die Daten analysiert und analysiert haben, werden die extrahierten Datenfelder zur weiteren Analyse und Integration in verschiedenen Formaten wie CSV, JSON oder Excel gespeichert.

Diese Datensätze haben verschiedene Anwendungsfälle, um Marktdynamiken aufzudecken.

Preisüberwachung

Web Scraping ist eine große Hilfe bei der Preisüberwachung. Als Einzelhändler auf einer E-Commerce-Plattform wie Amazon ist es nahezu unmöglich, Tausende von Produktpreisen Ihrer Konkurrenten einzusehen und Änderungen manuell zu überwachen.

Darüber hinaus können Sie mit einem Web-Scraping-Dienst Daten aus Preisdetails wie aktuellen Preisen, Listenpreisen, Rabatten und Sparprozentsätzen extrahieren.

Der Extraktions-, Transformations- und Ladeprozess wird hier implementiert. Zuerst beim Abrufen der relevanten Datenfelder von der Plattform. Anschließend erfolgt die Kuratierung und Reinigung, um Konsistenz und Genauigkeit sicherzustellen. Schließlich laden Sie es in eine Datenbank oder planen es so, dass es in bestimmten Intervallen ausgeführt wird.

Effiziente Ressourcenallokation

Anhand von Point of Interest (POI) oder geografischen Dateneinblicken können Sie durch effiziente Ressourcenzuweisung bessere Entscheidungen für Ihr Unternehmen treffen.

Angenommen, Sie sind ein Online-Händler, dessen Lagerbestand an Kühlschränken aufgebraucht ist. Jetzt müssen Sie den genauen Zeitpunkt kennen, zu dem die Route vergleichsweise weniger ausgelastet ist und es einfacher ist, den Bestand bequem und zu einem festen Zeitpunkt zu liefern.

Der ETL-Prozess extrahiert Geodaten, kategorisiert sie nach geschäftigen und überfüllten Zeiten und präsentiert sie zur Analyse und Entscheidungsfindung. Dies hilft bei der Bestandsverwaltung und der Kundenzufriedenheit.

Marktforschung

Web Scraping ist für die Durchführung von Marktforschungen für jede Branche unerlässlich. Sie können Daten von Konkurrenz-Websites, Branchenforen, Social-Media-Plattformen, Bewertungsseiten und mehr extrahieren. Der legale Zugang zu Daten besteht darin, nur öffentlich zugängliche Informationen zu sammeln.

Die Datenpunkte werden transformiert, indem doppelte Werte entfernt, Fehler behoben und mit Genauigkeit validiert werden.

Analysieren Sie für die Marktforschung Daten zu Marktbedingungen, Wettbewerbsstrategien, Leistung und Kundenpräferenzen, um nützliche Erkenntnisse zu gewinnen. Damit können Sie datengesteuerte Strategien und Entscheidungen für Ihre Geschäftsentwicklung umsetzen.

Lead-Generierung

Web Scraping hilft Unternehmen dabei, Leads für den Vertrieb zu generieren und Kandidaten für die Personalbeschaffung auf verschiedenen Ebenen zu finden. Sie können die Lead-Generierung verbessern, indem Sie Web Scraping verwenden, um auf hochwertige Lead-Datenbanken zuzugreifen.

Die Informationen des Leads, wie Name, Position, Ausbildung und Karriere, werden in das JSON-, CSV- oder Excel-Format konvertiert. Sie können den Lead mit einer geeigneten Strategie ansprechen, damit er sich in einen Kunden verwandeln kann.

Es besteht jedoch eine hohe Wahrscheinlichkeit, dass es zu Datenschutzbedenken kommen könnte. Dies liegt daran, dass Menschen natürlich vorsichtig sind, wenn ihre privaten Kontaktinformationen von Plattformen wie LinkedIn extrahiert werden.

Um die Sicherheit und Privatsphäre der Menschen zu gewährleisten, dürfen durch Web Scraping nur die öffentlich zugänglichen Daten erfasst werden, damit ihre Kontakte nicht für Spam und Belästigung missbraucht werden.

Schlussbemerkung

Zusammenfassend lässt sich sagen, dass die Synergie zwischen ETL-Datenprozessen (Extract, Transform, Load) und Web Scraping ein leistungsstarkes Toolkit für die Navigation durch das riesige Informationsmeer im Internet darstellt.

Von der Initiierung von HTTP-Anfragen über das Parsen von HTML-Inhalten bis hin zum Speichern von Daten in verschiedenen Formaten wie CSV, JSON oder Excel erleichtert Web Scraping die Umwandlung von Rohinformationen in umsetzbare Erkenntnisse.

Verbessern Sie Ihre Datenstrategie mit Grepsrs jahrzehntelanger Erfahrung im Web Scraping! Passen Sie unsere Lösungen an Ihre sich verändernden Geschäftsanforderungen an. Nutzen Sie das Potenzial verwertbarer Daten und beginnen Sie noch heute mit der Erstellung von Skripten für Ihre datengesteuerte Erfolgsgeschichte. Passen Sie sich nicht nur an – gedeihen Sie mit Grepsr.