Starten Sie Ihr Web-Scraping-Projekt und suchen Sie nach der besten Web-Scraping-API, die derzeit auf dem Markt erhältlich ist? Ich habe die besten auf der Grundlage persönlicher Erfahrungen zusammengestellt, um Ihnen den Stress beim Suchen und Vergleichen der wichtigsten Funktionen zu ersparen.

In diesem Artikel habe ich acht Top-Player auf dem Web-Scraping-API-Markt verglichen und ihre Vor- und Nachteile, Top-Funktionen und Preismodelle hervorgehoben. Nach der Lektüre können Sie den besten Kandidaten für Ihr Projekt auswählen.

1. Beste Web-Scraping-API – ScraperAPI

ScraperAPI ist auch im Jahr 2024 weiterhin die erste Wahl. Es bietet eine ideale Mischung aus wettbewerbsfähigen Preisen, umfassenden Funktionen und benutzerfreundlichem Design und eignet sich daher perfekt für die Datenextraktion großer Mengen und gelegentliche oder asynchrone Scraping-Aufgaben.

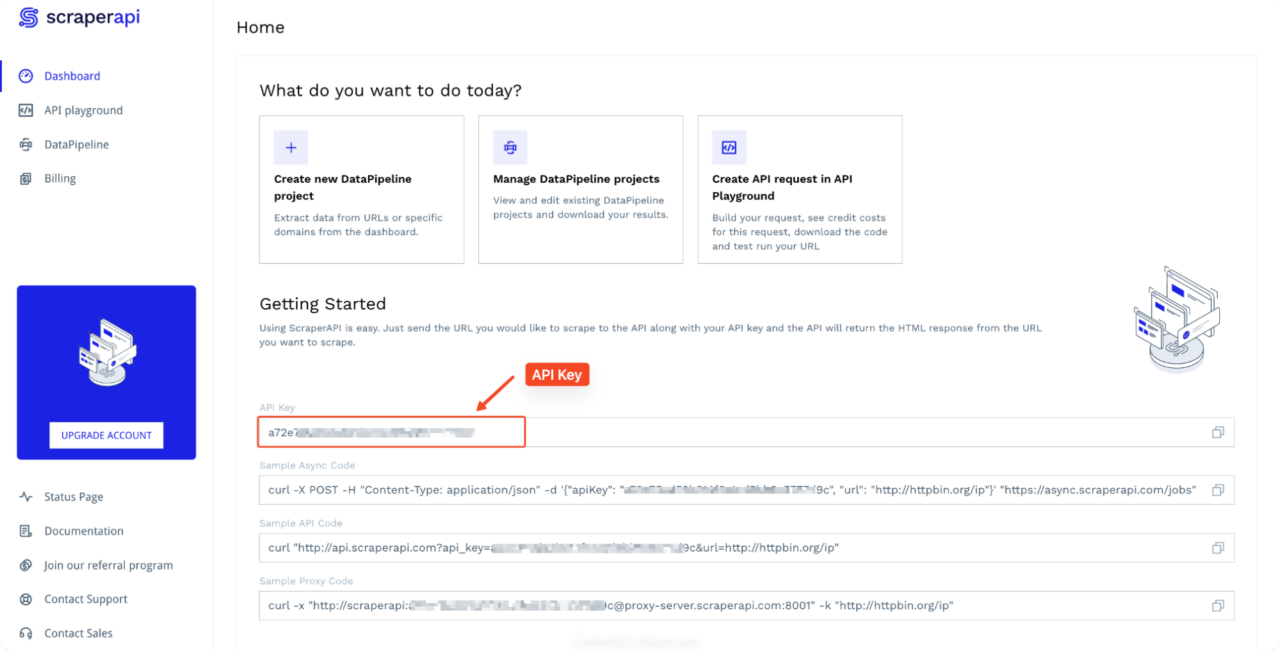

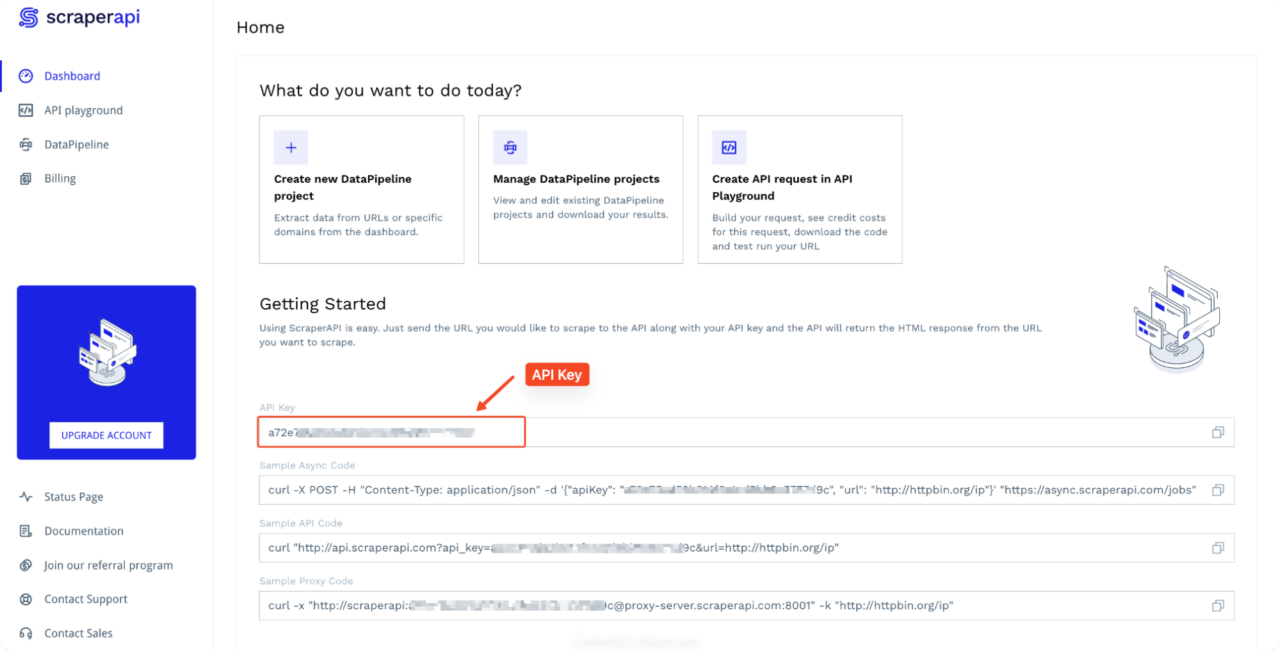

Auch der Einstieg in ScraperAPI ist sehr einfach. Alles, was Benutzer benötigen, ist ein API-Schlüssel und eine URL, um mit dem Scraping zu beginnen.

Für wen ist das?

ScraperAPI ist ideal für Entwickler, Datenwissenschaftler und Unternehmen, die eine robuste und skalierbare Lösung für Web Scraping benötigen. Aufgrund seiner einfachen Integration ist es auch eine optimale Wahl für Entwickler und Unternehmen, die sich einfach nur anschließen und Daten abrufen möchten, ohne sich mit einer Menge Spaghetti-Code herumschlagen zu müssen.

Warum sollten Sie es verwenden?

ScraperAPI konzentriert sich auf die Bereitstellung eines leistungsstarken automatisierten Scraping-Erlebnisses mit minimalem Overhead. Es bietet Funktionen wie automatisch rotierende Premium-Proxys, Bot-Blocker-Umgehung und CAPTCHA-Verwaltung mit einer beeindruckenden Erfolgsquote von nahezu 100 %.

Die API von ScraperAPI wurde entwickelt, um umfangreiche Datenextraktionsaufgaben effizient zu bewältigen. Es bietet Benutzern einen schnellen und zuverlässigen Zugriff auf Webdaten. Mit erweiterten JavaScript-Rendering-Anweisungen können Sie ihn jetzt als Headless-Browser verwenden, um mit Webseiten zu interagieren und dynamische Websites zu scannen.

Hauptmerkmale

- Intelligentes Proxy-Rotationssystem mit über 150 Millionen IPs in Privat-, Rechenzentrums- und Mobilfunknetzen

- Branchenführende Erfolgsraten mit integrierter CAPTCHA-Verwaltung

- Dynamisches Rendering

- Ultra-Premium-Proxys

- Präzises Geotargeting für über 150 Länder

- Bereitstellung von Webhook-Daten

- Strukturierte Datenendpunkte für große Standorte

- Automatisierung mit DataPipeline

- Technischer Support rund um die Uhr und umfassende Dokumentation

Für und Wider

| Vorteile | Nachteile |

| Umfangreiche Dokumentation und Codebeispiele | Keine PAYG-Preise |

| Kostengünstige und vorhersehbare Preisgestaltung | Begrenztes Geotargeting in den unteren Ebenen |

| Einfache und benutzerfreundliche API | |

| Transparente Preise mit kostenlosem Plan | |

| JSON- und CSV-Ausgabeformate | |

| Integrierte Planungsfunktionen | |

| API-Spielplatz zum Testen | |

| Erweiterte Geotargeting-Optionen und Premium-Proxys | |

| Bereitstellung von Webhook-Daten | |

| Erweiterte JS-Rendering-Funktionen |

Überprüfen Sie die Aggregatorbewertungen

- Trustpilot-Bewertung – 4,7

- Capterra-Bewertung – 4,8

„Ausgezeichneter Service und Zuverlässigkeit

Ich verwende ScraperAPI seit mehreren Monaten und es hat meine Daten-Scraping-Anforderungen grundlegend verändert. Die API ist unglaublich zuverlässig und verarbeitet eine große Anzahl von Anfragen ohne Probleme. Die Geschwindigkeit und Genauigkeit sind erstklassig und es hat meinen Arbeitsablauf erheblich verbessert. Sehr zu empfehlen!“

– – Capterra-Rezension

Preise

Das ScraperAPI-Preismodell ist leicht verständlich und erschwinglich, da Ihnen die Kosten pro erfolgreicher Anfrage und nicht pro GB oder Bandbreite wie bei anderen Web-Scraping-Tools berechnet werden.

Beispielsweise erhebt ScraperAPI Gebühren 5 API-Credits pro erfolgreicher Anfrage an E-Commerce-Domains wie Amazon und Walmart, sodass Sie ganz einfach die Anzahl der Seiten berechnen können, die Sie mit Ihrem Plan durchsuchen können.

Notiz: Besuchen Sie die Seite „Credits und Anfragen“ von ScraperAPI, um die Credit-Nutzung im Detail zu sehen.

Hier ist eine Aufschlüsselung des Preismodells von ScraperAPI:

| Planen | Preise | API-Credits |

| Kostenlose Testversion (7 – Tage) | Frei | 5000 |

| Hobby | 49 $ | 1.000.00 |

| Start-up | 149 $ | 1.000.000 |

| Geschäft | 299 $ | 3.000.000 |

| Unternehmen | 299 $ + | 3.000.000 + |

ScraperAPI bietet eine spezielle kostenlose Testversion von 5.000 API Credits (begrenzt auf 7 Tage) und wechseln zu ihrem kostenlosen Standardplan von 1.000 API cüberarbeitet anschließend. Mit dieser großzügigen Testversion können Sie den Service gründlich testen, bevor Sie sich für einen kostenpflichtigen Plan entscheiden.

Andere Web Scraping-APIs

Schauen wir uns nun eine Auswahl anderer Top-Web-Scraping-APIs an, die im Jahr 2024 verfügbar sind. Diese Optionen bieten verschiedene Funktionen für unterschiedliche Anforderungen. Hier sind sieben bemerkenswerte Alternativen für Ihre Datenextraktionsprojekte.

2. Helle Daten

Bright Data ist eine auf Web-Datenerfassung und Proxy-Dienste spezialisierte Plattform, die verschiedene Web-Scraping-Lösungen wie eine Web-Scraper-API, einen Web-Unblocker, einen Scraping-Browser, Datensätze und Proxys anbietet. Ihr Proxy-Netzwerk umfasst Rechenzentrums-, ISP-, Privat- und Mobil-Proxys und richtet sich sowohl an Unternehmen als auch an einzelne Benutzer.

Von allen in diesem Artikel erwähnten Scraping-Anbietern richtet sich Bright Data am direktesten an Kunden mit erheblichem Scraping-Bedarf und große Unternehmen. Dies zeigt sich in den monatlichen Plänen, die bei 499 US-Dollar beginnen und nur wenige Zwischenoptionen bieten, obwohl eine Pay-as-you-go-Option verfügbar ist.

Für wen ist das?

Bright Data ist für Unternehmen und große Organisationen konzipiert, die gebrauchsfertige Datensätze oder komplexe Web-Scraping-Konfigurationen benötigen, allerdings mit einem hohen Preis.

Warum sollten Sie es verwenden?

Sie sollten Bright Data verwenden, wenn Sie eine hochgradig anpassbare und skalierbare Plattform mit einem riesigen Proxy-Netzwerk benötigen. Allerdings sind diese mit einem hohen Preis verbunden, was bedeutet, dass Bright Data möglicherweise übertrieben ist, wenn Sie nur an leichten Scraping-Aufgaben arbeiten.

Hauptmerkmale

- Riesiges Proxy-Netzwerk (über 72 Millionen private, mobile und Rechenzentrums-IPs)

- Web Scraping-IDE für die benutzerdefinierte Scraper-Entwicklung

- Gebrauchsfertige Web-Scraping-Vorlagen

- Support rund um die Uhr

- Datensatz-Marktplatz

- Browser-Erweiterung

- Erweitertes Geo-Targeting

Für und Wider

| Vorteile | Nachteile |

| Riesiger Proxy-Pool | Teuer (beginnt bei 500 $/Monat mit möglichen zusätzlichen Bandbreitenkosten) |

| Bietet gebrauchsfertige Datensätze | Komplexe Preisstruktur |

| Support auf Unternehmensniveau | Technisch komplex |

Preise

BrightData erfüllt die meisten Kriterien, aber der Preis ist ziemlich hoch. Jetzt gibt es zwar eine günstigere Abonnementoption, aber wir haben den Abonnementpreis ausgewählt, der am besten zum Guthaben der anderen Dienste in diesem Leitfaden passt, weshalb sie zu einem höheren Preis angeboten werden.

Bright Data bietet mehrere Abonnementpläne für seine API an:

- Wachstum: 499 $ pro Monat.

- Geschäft: 999 $ pro Monat.

- Prämie: 1999 $ pro Monat

Sie bieten auch ein Pay-as-you-go-Modell an, das sicherstellt, dass Kunden nur für die Dauer und die Ressourcen zahlen, die sie nutzen.

Notiz: Erhalten Sie mehr für weniger. Entdecken Sie, wie ScraperAPI im Vergleich zu BrightData abschneidet.

3. Oxylabs

Oxylabs ist ein weltweit führender Anbieter von Data-Scraping-Lösungen und hochwertigen Proxys für die groß angelegte Web-Datenextraktion. Der Dienst bietet auch andere fortschrittliche Lösungen, wie eine solide Reihe von Scraping-APIs, die zum Scraping von E-Commerce-, Reise-, Unterhaltungs- und anderen Websites verwendet werden können, sowie eine entwicklerfreundliche Web-Unblocker-Lösung.

Oxylabs bietet außerdem gebrauchsfertige Codebeispiele und Unterstützung für mehrere Sprachen, über 100 Mio. Proxys für Privathaushalte, einen KI-gestützten Web-Unblocker, einen Proxy-Manager, mobile Proxys und mehr.

Für wen ist das?

Oxylabs ist auf Unternehmen und Unternehmenskunden zugeschnitten, die umfangreiches Web Scraping benötigen und Wert auf hochwertige Proxy-Dienste legen.

Warum sollten Sie es verwenden?

Nutzen Sie Oxylabs, wenn Sie Unternehmenslösungen mit erweiterten Funktionen benötigen.

Hauptmerkmale

- Umfangreiches Proxy-Netzwerk

- Integrierter Planer

- Erweiterte Antiblockierfunktionen

- Dynamische Inhaltsverarbeitung

- Spezialisierte Tools für SERP, E-Commerce und mehr.

- E-Commerce-Datensätze

Für und Wider

| Vorteile | Nachteile |

| Benutzerfreundliche Benutzeroberfläche | Die Einrichtung kann komplex sein |

| 195 Standorte | Es ist teuer, Ihre API-Anfrage mit der automatischen Proxy-Rotation zu steigern |

| Tolle Unterstützung | Begrenzte Parsing-Optionen |

| PAYG-Preise | Ein kleinerer IP-Pool |

Preise

Ihre SERP Scraper API, E-Commerce Scraper API und Web Scraper API haben alle das gleiche Preisschema:

Regulär

- Kostenlose Testversion: Kostenlose 7-Tage-Testversion – begrenzt auf 5000 Ergebnisse – keine Kreditkarte erforderlich

- Mikro: 49 $ + MwSt., monatliche Abrechnung (2,80 $/1.000 Ergebnisse)

- Anlasser: 99 $ + MwSt., monatliche Abrechnung (2,60 $/1.000 Ergebnisse)

- Fortschrittlich: 249 $ + MwSt., monatliche Abrechnung (2,40 $/1.000 Ergebnisse)

Unternehmen

- Wagen: 499 $ + MwSt., monatliche Abrechnung (2,20 $/1.000 Ergebnisse)

- Geschäft: 999 $ + MwSt., monatliche Abrechnung (1,90 $/1.000 Ergebnisse)

- Unternehmen: 2.000 $ + MwSt., monatliche Abrechnung (1,60 $/1.000 Ergebnisse)

- Brauch +: 10.000 $ + monatliche Abrechnung mit MwSt. (Benutzerdefinierter Preis/Ergebnisse)

Notiz: Mit ScraperAPI können Sie im Durchschnitt bis zu fünfmal mehr Daten scrapen als mit Oxylabs. Entdecken Sie, wie ScraperAPI im Vergleich zu Oxylabs abschneidet.

4. ScrapingBee

ScrapingBee ist eine hocheffiziente Web-Scraping-API, die die Datenextraktion von Websites vereinfacht. Es übernimmt sowohl die Proxy-Verwaltung als auch Headless-Browser-Interaktionen für Benutzer.

ScrapingBee ist mit erweiterten Scraping-Funktionen wie Geotargeting, CAPTCHA-Lösung und JavaScript-Szenarien vorinstalliert (die es Benutzern ermöglichen, benutzerdefinierte JavaScript-Snippets als Teil ihres Scraping-Prozesses auszuführen). Es unterstützt auch JSON als primäres Exportformat.

Für wen ist das?

ScrapingBee ist perfekt für Entwickler und kleine Unternehmen, die eine unkomplizierte und entwicklerfreundliche Web-Scraping-API benötigen.

Warum sollten Sie es verwenden?

Es wird Entwicklern empfohlen, die eine einfache Lösung zum Extrahieren von Daten suchen. Dennoch kann es für Entwickler mit fortgeschrittenen Web-Scraping-Kenntnissen eine Einschränkung darstellen, da sie nur begrenzte Kontrolle über den gesamten Datenextraktionsprozess haben.

Hauptmerkmale

- Proxy-Modus

- Unterstützt JavaScript-Rendering und Headless-Browser

- Großer Proxy-Pool

- Exzellenter Kundensupport

- Eingebaute Antiblockiermechanismen

- Gute Dokumentation

Für und Wider

| Vorteile | Nachteile |

| Einfache Integration | Eingeschränkte erweiterte Funktionen |

| Erschwingliche Pläne | Keine ausgetrockneten E-Commerce-Endpunkte |

| Gute Dokumentation | Kleinerer Proxy-Pool (im Vergleich zu größeren Anbietern) |

| Eingeschränkte kostenlose Testversion |

Preise

ScrapingBee hat vier Abonnementpläne:

- Frei: 1000 kostenlose API-Aufrufe.

- Freiberuflich: 49 $ pro Monat (150.000 API-Credits).

- Start-up: 99 $ pro Monat (1.000.000 API-Credits).

- Geschäft: 249 $ pro Monat (3.000.000 API-Credits).

- Business+: 599 $+ pro Monat (8.000.000+ API-Credits).

Notiz: Entdecken Sie, wie ScraperAPI im Vergleich zu ScrapingBee abschneidet.

5. Apifizieren

Apify ist eine Web-Scraping- und Automatisierungsplattform, die es Benutzern ermöglicht, Daten von Websites zu extrahieren, Arbeitsabläufe zu automatisieren und benutzerdefinierte API-Runner (Akteure) zu erstellen. Damit können Entwickler problemlos Web Scraper, Crawler und andere Automatisierungsworkflows erstellen und ausführen, ohne sich um die Infrastrukturverwaltung kümmern zu müssen.

Für wen ist das?

Apify ist ideal für Entwickler, die eine flexible Plattform für benutzerdefinierte Web-Scraping- und Automatisierungsaufgaben benötigen. Während es sich eher an Entwickler richtet, die ihre Web-Scraper anpassen möchten, ist es eine ausgezeichnete Wahl für Unternehmen, die ihre Datenerfassungs-Workflows automatisieren möchten.

Warum sollten Sie es verwenden?

Verwenden Sie Apify, wenn Sie eine vielseitige Lösung benötigen, die sowohl vorgefertigte als auch benutzerdefinierte Scraping-Tools unterstützt.

Hauptmerkmale

- Akteure (vorgefertigte und benutzerdefinierte Skripte für verschiedene Scraping-Aufgaben)

- Apify SDK

- Proxy-Dienste

- Cloud-Speicher

Für und Wider

| Vorteile | Nachteile |

| Anpassung und Erweiterbarkeit | Steile Lernkurve |

| Workflow-Automatisierung | Es können sich schnell Kosten anhäufen |

| Möglichkeit, Ihre eigenen Schauspieler zu erstellen, zu hosten und zu monetarisieren | Die auf Recheneinheiten basierende Preisgestaltung kann komplex sein |

| Community-Unterstützung (aktive Community und gemeinsame Akteure) |

Preise

Apify bietet monatliche Prepaid-Nutzungspläne auf den folgenden Stufen an:

- Kostenlos: 0 $ pro Monat (dann zahlen Sie nach Bedarf).

- Starter: 49 $ pro Monat (dann zahlen Sie nach Bedarf).

- Umfang: 499 $ pro Monat (dann nutzungsbasierte Bezahlung).

- Geschäftlich: 999 $ pro Monat (dann zahlen Sie nach Bedarf).

- Unternehmen: Benutzerdefiniert

6. Zenrows

ZenRows ist eine leistungsstarke Web-Scraping-API, die Anti-Bot-Blocker elegant handhabt und eine hochwertige Inhaltsextraktion bietet. Seine API übernimmt die gesamte Anti-Bot-Umgehung mit robusten Funktionen wie rotierenden Proxys, Headless-Browsern, dem Lösen von CAPTCHAs und mehr.

Für wen ist das?

ZenRows eignet sich für Benutzer, die eine einfache und unkomplizierte Web-Scraping-Lösung suchen. Es ist ideal für Einzelpersonen und kleine Unternehmen mit mäßigem Scraping-Bedarf, die Wert auf Benutzerfreundlichkeit gegenüber erweiterten Funktionen legen.

Warum sollten Sie es verwenden?

Sie sollten ZenRows verwenden, wenn Sie ein problemloses Tool zum Extrahieren von Daten ohne komplexe Konfigurationen benötigen. Seine benutzerfreundliche Oberfläche und die unkomplizierte API machen es auch für diejenigen zugänglich, die möglicherweise nicht über umfassende technische Kenntnisse verfügen.

Es ist jedoch wichtig zu beachten, dass die Kosten im Verhältnis zu den angebotenen Dienstleistungen deutlich höher ausfallen können, wenn Ihre Scraping-Anforderungen steigen. Für Großprojekte oder anspruchsvolle Scraping-Anforderungen finden Sie woanders möglicherweise kostengünstigere Lösungen.

Hauptmerkmale

- Erweiterte Umgehung der Anti-Bot-Erkennung

- Integriertes JavaScript-Rendering

- Einsteigerfreundliche Dokumentation

- Rotierende Proxys und IP-Management

- Rotation des Benutzeragenten

- Hochwertiger Kundensupport

Für und Wider

| Vorteile | Nachteile |

| Scraping-Browser | Hohe Kosten |

| Mehrsprachige Unterstützung | Für Skalierbarkeit schlecht geeignet |

| Javascript-Rendering | Weniger Standorte |

| KI-gestützte Scraping-Plattform |

Preise

Die Preise für Zenrows beginnen bei 69 $ pro Monat. Sie haben vier Abonnementpläne:

- Entwickler: 69 $ pro Monat

- Start-up: 129 $ pro Monat

- Geschäft: 299 $ pro Monat

- Unternehmen: Brauch

7. Smartproxy

Smartproxy ist ein vertrauenswürdiger Proxy-Anbieter, der eine Reihe spezialisierter APIs anbietet, darunter Social Media Scraping, SERP Scraping und E-Commerce Scraping APIs, die auf verschiedene Anwendungsfälle zugeschnitten sind.

Darüber hinaus werden Privat-, Rechenzentrums- und ISP-Proxys als separate Dienste bereitgestellt. Die API bietet Anti-Bot-Umgehung, Proxy-Rotation und unterstützt JavaScript-Rendering.

Für wen ist das?

Smartproxy ist ideal für Unternehmen, Entwickler und Datenanalysten, die zuverlässige und skalierbare Proxy-Lösungen für Web-Scraping-Aufgaben benötigen, insbesondere solche, die sich auf Social-Media-Plattformen konzentrieren.

Warum sollten Sie es verwenden?

Sie sollten Smartproxy verwenden, wenn Sie nach hochwertigen Proxys in Verbindung mit speziellen Scraping-APIs suchen, die die Datenextraktion von verschiedenen Websites vereinfachen. Seine Funktionen helfen Ihnen, Anti-Bot-Maßnahmen zu umgehen, Proxy-Rotationen zu verwalten und JavaScript-lastige Websites zu verwalten.

Hauptmerkmale

- Automatische Proxy-Rotation

- Großer Proxy-Pool

- JavaScript-Rendering

- GuterKundensupport:

- API-Spielplatz

Für und Wider

| Vorteile | Nachteile |

| Benutzerfreundlich | Begrenzte erweiterte Funktionen |

| Globales Proxy-Netzwerk | Teuer im Maßstab |

| Kostenlose Testversion verfügbar |

Preise

Smartproxy bietet eine 7-tägige kostenlose Testversion mit 1.000 Anfragen, sodass Benutzer die Funktionalität der API testen können, bevor sie sich für einen kostenpflichtigen Plan entscheiden.

- Kostenlose Testversion: Kostenlose 7-Tage-Testversion – begrenzt auf 1000 Ergebnisse

- Stufe 1: 30 $ monatlich in Rechnung gestellt (2,0 $/1.000 Ergebnisse – 15.000 Anfragen)

- Stufe 2: 80 $ monatlich in Rechnung gestellt (1,6 $/1.000 Ergebnisse – 50.000 Anfragen)

- Stufe 3: 140 $ monatlich in Rechnung gestellt (1,40 $/1.000 Ergebnisse – 100.000 Anfragen)

- Stufe 4: 300 $ monatlich in Rechnung gestellt (1,2 $/1.000 Ergebnisse – 250.000 Anfragen)

8. WebScrapingAPI

WebScrapingAPI verwaltet die automatische Proxy-Umschaltung, CAPTCHA-Lösung und JavaScript-Rendering, ohne Sie zu verlangsamen. Es enthält anpassbare Header und Geo-Targeting-Funktionen und eignet sich daher gut zum Scrapen von E-Commerce-Produkten, Nachrichtenartikeln oder Rezensionen.

Für wen ist das?

WebScrapingAPI eignet sich für Einzelpersonen, Entwickler und kleine Unternehmen, die eine erschwingliche und unkomplizierte Scraping-Lösung suchen.

Warum sollten Sie es verwenden?

Sie sollten WebScrapingAPI aufgrund seiner Einfachheit, Geschwindigkeit und Kosteneffizienz verwenden.

Hauptmerkmale

- Automatische Proxy-Rotation

- CAPTCHA-Lösung

- JavaScript-Rendering

Für und Wider

| Vorteile | Nachteile |

| Ideal zum Scrapen von JavaScript-lastigen Inhalten | Weniger skalierbar |

| Schnell und effizient | Eingeschränkte erweiterte Funktionen |

| Gute Unterstützung |

Preise

Für dieses Tool fallen für verschiedene API-Pläne separate Gebühren an:

- Versuch: 5000 kostenlose API-Aufrufe.

- Anlasser: 19 $ pro Monat (700 API-Aufrufe).

- Basic: 49 $ pro Monat (20.000 API-Aufrufe).

- Standard: 99 $ pro Monat (45.000 API-Aufrufe).

Beste Web-Scraping-APIs im Vergleich (Übersicht)

Hier ist ein kurzer Vergleich der oben aufgeführten Top-Web-Scraping-APIs:

| ScraperAPI | BrightData | Oxylabs | ScrapingBee | Apify | ZenRows | Smartproxy | WebScrapingAPI | |

| Am besten für | Insgesamt das Beste | Lösungen der Enterprise-Klasse | Großprojekte | Entwicklerfreundlich | Anpassbare Arbeitsabläufe | Einfach zu bedienen | Tolle Proxy-Abdeckung | Budgetfreundliche Wahl |

| Preise | Ab 49 $/Monat | Pay-as-you-go (Abonnement beginnt bei 499 $/Monat) | Ab 49 $/Monat | Ab 49 $/Monat | Ab 49 $/Monat | Beginnt bei 69 $/Monat | Beginnt bei 30 $/Monat | Beginnt bei 19 $/Monat |

| Benutzerfreundlichkeit | ⭐⭐⭐⭐⭐ | ⭐⭐⭐☆ ☆ | ⭐⭐⭐⭐☆ | ⭐⭐⭐⭐☆ | ⭐⭐⭐⭐☆ | ⭐⭐⭐⭐☆ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐☆ |

| Erfolgsquote | 99,9 % | 95 % | 99 % | 98 % | 98 % | 98,7 % | 99,5 % | 98 % |

| Parallelität | 20 | 10 | 5 | 32 | 10 | – | 10 | |

| Kostenlose Wiederholungsversuche | Ja | NEIN | NEIN | Ja | Ja | Ja | Ja | Ja |

| Scraping-Job-Scheduler | Integrierter Planer und O-Code-Tools ✅ | No-Code-Werkzeuge ✅ | Integrierter Planer für API-Aufrufe. ✅ | ❌Nein | Integrierter Zeitplaner ✅ | ❌Nein | ❌Nein | ❌Nein |

| Ultra-Premium-Proxys | Ja ✅ | ❌Nein | Ja ✅ | ❌Nein | ❌Nein | Ja ✅ | ❌Nein | ❌Nein |

| Webhook-Unterstützung | Ja ✅ | ❌Nein | ❌Nein | ❌Nein | Ja ✅ | ❌Nein | ❌Nein | ❌Nein |

ScraperAPI zeichnet sich aufgrund seiner hohen Erfolgsquote, seines robusten Proxy-Managements und seiner Benutzerfreundlichkeit als die beste Web-Scraping-API insgesamt aus und ist somit ideal für Entwickler und Unternehmen mit umfangreichen Datenextraktionsanforderungen. BrightData Und Oxylabs richten sich mit umfangreichen Proxy-Pools und Premium-Funktionen an Projekte auf Unternehmensebene, sind allerdings mit höheren Preisen verbunden.

ScrapingBee ist die budgetfreundliche Wahl und bietet Integration ohne Code und CAPTCHA-Lösungsfunktionen, jedoch mit begrenzten Parallelitätsoptionen. In der Zwischenzeit, Apify Und ZenRows eignen sich hervorragend für Benutzer, die anpassbare Arbeitsabläufe oder erweiterte Anti-Bot-Maßnahmen suchen, und eignen sich daher für mittlere bis große Projekte.

SmartProxy Und WebScrapingAPI bieten benutzerfreundliche Lösungen zu wettbewerbsfähigen Preisen, die auf kleinere oder unkomplizierte Schabeaufgaben ausgerichtet sind.

Was ist eine Web Scraping API?

Wenn Sie noch nie von einer Web-Scraping-API gehört haben, handelt es sich im Wesentlichen um eine API, die Sie mit einer URL aufrufen, die Sie scrapen möchten, und die API gibt dann den Inhalt der Seite unter der URL zurück.

In der Regel sind Web-Scraping-APIs in der Lage, JavaScript zu rendern, Cloudflare zu umgehen, private Proxys zu verwenden usw. Daher ist es möglich, Websites zu scrapen, die sonst mit normalen Ansätzen wie Bare-HTTP-Clients oder Headless nur sehr schwer (oder sogar unmöglich) zu scrapen wären Browser.

Warum benötigen Sie eine Scraping-API?

Eine Web-Scraping-API automatisiert die Web-Datenextraktion für verschiedene Zwecke, darunter Markenüberwachung, Preisinformationen, Finanzdatenerfassung, Anzeigenverifizierung, Marktforschung, SEO- und SEM-Optimierung, Konkurrenzüberwachung und Bewertungsüberwachung.

Notiz: Schauen Sie sich die fünf wichtigsten Anwendungsfälle von Scraping-APIs anhand von Beispielen an.

Am wichtigsten ist jedoch, dass Scraping-APIs die notwendige Infrastruktur und Funktionalität bereitstellen, um Anti-Scraping-Maßnahmen zu umgehen und Ihnen Zugriff auf die Daten zu ermöglichen, die Sie interessieren.

Dinge, die Sie bei der Auswahl einer Scraping-API beachten sollten

Bei der Auswahl einer Web-Scraping-API für Ihr Projekt müssen mehrere entscheidende Faktoren sorgfältig abgewogen werden, um sicherzustellen, dass Sie die richtige Lösung für Ihre spezifischen Anforderungen auswählen:

- Dokumentation und SDKs: Stellen Sie sicher, dass die API eine klare Dokumentation bereitstellt und wichtige Programmiersprachen wie Python, Java und PHP für eine nahtlose Integration unterstützt.

- Datenerfassung in Echtzeit: Wenn Sie aktuelle Daten benötigen, suchen Sie nach APIs, die Funktionen zur Datenerfassung in Echtzeit bieten. Zum Beispiel, ScraperAPI bietet DataPipeline für die Planung wiederkehrender Scraping-Jobs und die Überwachung von Daten in Echtzeit.

- Preismodelle und Grenzen: Bewerten Sie unbedingt Preismodelle, Parallelitätsgrenzen und Erfolgsquoten, um eine kostengünstige Lösung zu finden, die zu Ihrem Budget passt und Ihren Datenanforderungen entspricht.

- Skalierbarkeit: Überlegen Sie, ob die API große Projekte bewältigen kann und über das Potenzial für Skalierbarkeit verfügt, wenn Ihr Datenbedarf wächst.

- Geschwindigkeit und Effizienz: Bewerten Sie, wie schnell das Tool Daten scannen kann. Effiziente APIs sparen Zeit und Ressourcen, insbesondere bei der Verarbeitung großer Datenmengen.

- Spezialisierte Funktions: Wenn Sie spezielle Anforderungen haben, wie SERP oder E-Commerce-Scraping, suchen Sie nach APIs, die spezielle Endpunkte bieten. ScraperAPI bietet strukturierte Datenendpunkte (SDEs), um komplexe HTML-Seiten in strukturierte JSON- oder CSV-Daten umzuwandeln. Dies ist besonders nützlich, um große Websites wie Amazon, Walmart und die Google-Suche zu durchsuchen.

So verwenden Sie eine Scraper-API für die Datenerfassung

Die Verwendung einer Scraper-API vereinfacht die Datenextraktion durch die Bewältigung technischer Herausforderungen wie Proxy-Verwaltung, CAPTCHA-Lösung und JavaScript-Rendering. ScraperAPI erleichtert die effiziente Erfassung von Webdaten, ohne Einschränkungen der Infrastruktur und mit einer beeindruckenden Erfolgsquote von 99,9 %.

Verwendung der Scraping-API von ScraperAPI

Die Verwendung von ScraperAPI ist einfach. Senden Sie einfach die URL, die Sie scrapen möchten, zusammen mit Ihrem API-Schlüssel an die API, und die API gibt die HTML-Antwort von der URL zurück, die Sie scrapen möchten.

ScraperAPI verwendet API-Schlüssel zur Authentifizierung von Anfragen. Um die API nutzen zu können, müssen Sie sich für ein Konto anmelden und bei jeder Anfrage Ihren eindeutigen API-Schlüssel angeben.

Sie können Ihre bevorzugte Programmiersprache verwenden, um Anfragen an den Endpunkt von ScraperAPI zu stellen. In diesem Handbuch verwenden wir Python mit Requests, aber ScraperAPI unterstützt viele Programmiersprachen. Geben Sie dann Ihren API-Schlüssel und die Ziel-URL an, von der Sie Daten extrahieren möchten.

import requests

payload = {'api_key': 'APIKEY', 'url': 'https://httpbin.org/ip'}

r = requests.get('https://api.scraperapi.com', params=payload)

print(r.text)

Um zusätzliche Parameter wie Javascript-Rendering und Geolokalisierung mit ScraperAPI zu verwenden, fügen Sie diese einfach der Nutzlast hinzu.

payload = {

'api_key': API_KEY,

'url': url,

'render': 'true',

'country_code': 'us'

}

Notiz: Detaillierte Anleitungen und Codebeispiele finden Sie in der ScraperAPI-Dokumentation.

Verwendung der erweiterten Funktionen von ScraperAPI

Für komplexere Scraping-Aufgaben bietet ScraperAPI erweiterte Funktionen wie das Rendern dynamischer Inhalte und die Extraktion strukturierter Daten.

Anweisungen zum JavaScript-Rendering

ScraperAPI ermöglicht Ihnen mit seinem Render-Befehlssatz das Scrapen von JavaScript-lastigen Websites. Dies ist besonders nützlich für die Interaktion mit dynamischen Inhalten, unendlichem Scrollen oder Seiten, die eine Benutzerinteraktion erfordern.

Um durch eine Webseite zu scrollen und alle dynamischen Inhalte mit ScraperAPI zu laden, richten Sie einen Befehlssatz ein:

import json

config = ({

"type": "loop",

"for": 3,

"instructions": (

{

"type": "scroll",

"direction": "y",

"value": "bottom"

},

{

"type": "wait",

"value": 5

}

)

})

config_json = json.dumps(config)

headers = {

'x-sapi-api_key': 'YOUR_API_KEY',

'x-sapi-render': 'true',

'x-sapi-instruction_set': config_json

}

Dieser Befehlssatz scrollt dreimal zum Ende der Seite und wartet zwischen jedem Scrollen fünf Sekunden, um sicherzustellen, dass der gesamte Inhalt vollständig geladen ist, bevor der Scraping durchgeführt wird.

Notiz: Erfahren Sie mehr über das Scraping dynamischer Inhalte mit ScraperAPI.

Strukturierte Datenextraktion (SDE)

Die Structured Data Endpoints (SDEs) von ScraperAPI wandeln HTML in strukturierte Formate wie JSON um und erleichtern so das Extrahieren bestimmter Datenpunkte. Sie können beispielsweise Amazon SDE verwenden, um Produktdetails effizient abzurufen:

import requests

import json

API_KEY = "YOUR_SCRAPER_API_KEY"

QUERY = "Sauvage Dior"

payload = {'api_key': API_KEY, 'query': QUERY, 'country': 'us'}

response = requests.get('https://api.scraperapi.com/structured/amazon/search', params=payload)

data = response.json()

with open('amazon_results.json', 'w') as json_file:

json.dump(data, json_file, indent=4)

print("Results have been stored in amazon_results.json")

Dieser Code verwendet die Amazon SDE von ScraperAPI, um nach „Sauvage Dior“ zu suchen und strukturierte Produktdaten im JSON-Format zurückzugeben.

Notiz: Weitere Informationen zu den strukturierten Datenendpunkten (SDEs) von ScraperAPI und Informationen zu den Datentypen, die Sie extrahieren können, finden Sie in der SDEs-Dokumentation.

Wenn Sie bereit sind, eine Web-Scraping-API auszuprobieren, warum beginnen Sie nicht mit ScraperAPI? ScraperAPI bietet eine Komplettlösung, um alle Anti-Bot-Maßnahmen zu umgehen und jede Website in großem Umfang zu scannen, ohne blockiert zu werden.

Testen Sie ScraperAPI noch heute kostenlos. Keine Kreditkarte erforderlich!