Verwendung von SEO-Proxys für Kampagnen mit mehreren Standorten

Wenn Benutzer Unternehmen ganz oben in den Suchergebnissen finden, ist die Wahrscheinlichkeit, dass sie auf deren Links klicken, höher als bei Unternehmen auf niedrigeren Rängen. Tatsächlich sinken die Klickraten (CTR), je niedriger der Rang einer Seite:

- Das erste Ergebnis beträgt 39,8 %

- Das zweite Ergebnis beträgt 18,7 %

- Das dritte Ergebnis beträgt 10,2 %.

Die Optimierung für SERP erfordert tiefe Einblicke in das Suchverhalten, lokale und standortübergreifende Suchtrends, Konkurrenzanalysen und mehr. Durch das Sammeln von SERP-Daten für mehrere Standorte können Unternehmen:

- Verfolgen Sie regionale Keyword-Trends: Erfahren Sie, welche Keywords an bestimmten Standorten im Trend liegen, um Ihre Inhalte und SEO-Strategien für neue Märkte zu optimieren.

- Beobachten Sie die Konkurrenz: Durchsuchen Sie die SERPs, um zu sehen, wie lokale Konkurrenten abschneiden und welche Taktiken sie anwenden.

- Passen Sie Marketingkampagnen an: Passen Sie Ihre Inhalte und Werbemaßnahmen basierend auf regionalspezifischem Suchverhalten und -präferenzen an.

- Für lokales SEO optimieren: So können Sie sich an einzigartige Marktanforderungen anpassen.

TL;DR: Beste rotierende SEO-Proxys für Kampagnen mit mehreren Standorten

Für diejenigen, die es eilig haben, finden Sie hier einen vollständigen Überblick über unsere Top-Auswahl der besten rotierenden SEO-Proxy-Anbieter zum Sammeln von SERP-Daten in großem Umfang:

| Proxy-Anbieter | Bewertungen | Ranglisten | Der Preis beginnt bei |

| ScraperAPI | 4.7 | #1 | 49 $/Monat |

| BrightData | 4.6 | #2 | 499 $ zzgl. MwSt./Monat |

| Oxylabs | 4.5 | #3 | 49 $/Monat |

| SOAX | 4.6 | #4 | Individuelle Preise |

| Smartproxy | 4.6 | #5 | 30 $ + MwSt./Monat |

| NetNut | 4.6 | #7 | 1080 $/Monat |

| Webshare | 4.2 | #8 | 2,99 $/Monat |

| Infatica | 4.3 | #9 | 25 $/Monat |

Top 10 SEO-Proxy-Anbieter für Multi-Location-Kampagnen

1. ScraperAPI

ScraperAPI ist ein umfassendes und vielseitiges SEO-Scraping-Tool, das für die Abwicklung groß angelegter Kampagnen an mehreren Standorten entwickelt wurde. Mit der Google Search API von ScraperAPI können Nutzer zielgerichtete Daten aus der Google-Suche sammeln, darunter Keyword-Rankings, Anzeigen von Mitbewerbern, Jobdaten und Echtzeit-SERP-Daten wie „Personen fragen auch“-Felder, verwandte Suchanfragen und Videos.

- ScraperAPI-Google-Endpunkte erhalten Daten, die in strukturiertes JSON geparst werden, was sie ideal für detaillierte SEO-Analysen und Kampagnenmanagement macht.

- Der integrierte Scheduler von ScraperAPI ermöglicht es Unternehmen, rund um die Uhr Daten per Autopilot zu scannen und dabei die visuelle Benutzeroberfläche oder dedizierte Endpunkte für eine präzise Planung zu nutzen.

- Async Scraper erhöht Ihre Scraping-Geschwindigkeit, indem es Millionen von Anfragen gleichzeitig zulässt und gleichzeitig Google Search Endpoints mit besseren Erfolgsraten verwendet.

Mit Zugriff auf über 40 Millionen IP-Adressen in über 50 Ländern können Sie mit ScraperAPI hochgradig zielgerichtete geospezifische SERP-Daten in verschiedenen Sprachen erhalten. Dies maximiert die SEO-Leistung über mehrere Regionen hinweg und ermöglicht Ihnen Einblicke außerhalb Ihres Heimatmarktes.

Hauptmerkmale

- Pool von über 40 Millionen IP-Adressen in über 50 Ländern

- Spezielle Google-Such-API

- Unterstützt JSON- und CSV-Datenexporte

- Geotargeting zum Scrapen lokalisierter SEO-Daten in mehreren Sprachen

- CAPTCHA-Verwaltung und automatische Wiederholungsversuche

- Intelligente Proxy-Rotation und Anti-Scraping-Mechanismus

- 99,9 % Betriebszeit mit unbegrenzter Bandbreite

- Planungsoptionen zur Automatisierung umfangreicher Scraping-Aufgaben

- Desktop- und mobile Benutzeragenten unterstützen gerätespezifische Daten

Bewertungen: 4.7

Für und Wider

| Vorteile | Nachteile |

| Nahezu 100 % Erfolgsquote für Google-Domains | Stellt derzeit nur Endpunkte für Google-Domänen bereit |

| Erweiterte Anti-Bot-Erkennung und CAPTCHA-Lösung | |

| Gibt SERP-Daten in JSON und CSV zurück | |

| Anpassbare Parameter zum Sammeln präziser SERP-Daten | |

| Lokalisierte Suchdaten in verschiedenen Sprachen aus über 50 Ländern |

Preise

ScraperAPI bietet deutlich mehr Wert, insbesondere bei Scraping-Aufgaben mit hohem Volumen. Der ScraperAPI-Geschäftsplan für 299 US-Dollar pro Monat bietet Zugriff auf 3 Millionen API-Credits, mehr als andere Anbieter bei gleichen oder niedrigeren Kosten.

Darüber hinaus bietet ScraperAPI erweiterte Planungsfunktionen, CAPTCHA-Verwaltung und vollständiges Geotargeting ohne zusätzliche Kosten, was es zur besten Option für umfassende und effiziente Scraping-Lösungen im großen Maßstab macht. Greifen Sie in allen unseren Plänen auf Tools wie Async Scraper, Structured Data Endpoint und DataPipeline zu.

| Planen | Preis | # API-Credits | SERP-Seiten entfernt* |

| Hobby | 49 $ | 100.000 | 4000 |

| Start-up | 149 $ | 1.000.000 | 40.000 |

| Geschäft | 299 $ | 3.000.000 | 120.000 |

| Unternehmen | Brauch | >3.000.000 | Brauch |

*Anfragen an Google-Domains kosten 25 API-Credits.

2. BrightData

Die BrightData SERP API filtert Suchmaschinenergebnisse von Google, Bing, Yahoo und anderen. Seine SERP-API wandelt rohe HTML-Daten in strukturierte Felder wie Rankings, Links, Beschreibungen und Bewertungen um. Es unterstützt Geo-Targeting auf Stadtebene, um lokalisierte Suchdaten aus 195 Ländern zu sammeln und so SEO-Kampagnen an mehreren Standorten zu fördern.

BrightData ist jedoch teurer und erfordert im Vergleich zu anderen Tools in dieser Liste, insbesondere ScraperAPI, einen erheblichen Lernaufwand.

Hauptmerkmale

- Über 195 Geostandorte mit Targeting auf Stadtebene

- Strukturierte Datenausgaben

- Erweiterte Parsing-Funktionen

- 99,9 % Erfolgsquote mit automatischen Wiederholungsversuchen und CAPTCHA-Lösung

- Pay-as-you-go-Option

Bewertungen: 4.6

Für und Wider

| Vorteile | Nachteile |

| Bietet SERP-Daten von allen großen Suchmaschinen | Höhere Kosten für Anfragen mit hohem Volumen im Vergleich zu anderen Optionen |

| Zielt auf SERPs auf Stadtebene für eine hyperlokale Datenerfassung ab | Erfordert zusätzliche Einrichtung, um erweiterte Funktionen wie asynchrone Anforderungen und benutzerdefinierte Parameter zu verwenden |

| Unbegrenzte gleichzeitige Anfragen | Die Lernkurve für die API-Integration bei der Abwicklung komplexer SEO-Kampagnen |

| Erweitertes Parsen |

Preise

Während das Pay-as-you-go-Preismodell bei 3 $/1.000 Datensätze beginnt, sind die Business- und Premium-Modelle mit 999 $ bzw. 1999 $/Monat extrem teuer, was es kostspielig macht, wenn Sie große Mengen an SERP-Daten extrahieren müssen. Außerdem beginnt der Wachstumsplan bei 499 $/Monat.

Das sind 499 US-Dollar, wobei jeder 1.000-Datensatz 2,55 US-Dollar kostet. ScraperAPI bietet für 299 $/Monat 1.000 erfolgreiche Datensätze für 2,49 $.

| ScraperAPI-Geschäftsplan | BrightData-Geschäftsplan |

| 2,49 $/1.000 Datensätze | 2,55 $/1.000 Datensätze |

| Alles Geotargeting | Weltweite Geoverteilung |

| JS-Rendering | – |

| Automatische CAPTCHA-Verarbeitung | – |

| Automatische IP-Rotation | Sie müssen es mit ihrem Proxy-Manager konfigurieren |

| 299 $/Monat | 499 $/Monat |

3. Oxylabs

Die Oxylabs SERP Scraper API kratzt Suchmaschinen wie Google, Bing, Baidu und Yandex. Oxylabs bietet Geo-Targeting auf Stadtebene in 195 Ländern und zeichnet sich durch seine Fähigkeit aus, Gebiete mithilfe von Koordinaten mit ML-gesteuertem Proxy-Management anzuvisieren.

Wie andere führende Lösungen bietet Oxylabs Ausgaben in rohem HTML, geparstem JSON oder CSV zum Sammeln verschiedener SERP-Funktionen, einschließlich hervorgehobener Snippets und verwandter Suchen.

Genau wie BrightData sind seine erweiterten Funktionen teurer und erfordern eine steilere Lernkurve, was es für diejenigen schwierig macht, die eine einfache Bedienung einer detaillierten Kontrolle vorziehen.

Hauptmerkmale

- Geo-Targeting in über 195 Ländern

- Proxy-Verwaltung mit ML-gesteuerter Proxy-Auswahl

- Unterstützung für Headless-Browser

- KI-gesteuerte Umgehung von Fingerabdrücken

- CAPTCHA-Verwaltung und automatische Wiederholungsversuche

Bewertungen: 4.5

Für und Wider

| Vorteile | Nachteile |

| Bietet eine Erfolgsquote von über 99 % beim Abrufen von Suchdaten | Kein Spielplatz zum Testen von Konfigurationen vor der vollständigen Bereitstellung |

| Geo-Targeting auf Koordinatenebene | Die Lernkurve für die Integration komplexer SEO-Kampagnen |

| ML-gesteuerte IP-Auswahl und -Rotation | Dedizierte Parser sind auf Google beschränkt und beschränken das JSON-Format auf bestimmte Suchmaschinen |

| Automatisierte Planung und benutzerdefinierte Parsing-Logik |

Preise

Der erweiterte Plan von Oxylabs kostet 249 $/Monat. Obwohl dies etwas kosteneffektiv erscheinen mag, liefert Oxylabs zu diesem Preis nur 104.000 Ergebnisse, während Sie mit ScraperAPI (299 $/Monat) 120.000 erfolgreiche Ergebnisse erhalten. Im Vergleich dazu sind die zusätzlichen 50 US-Dollar hier durch bessere und zuverlässigere Ergebnisse gerechtfertigt.

Standardmäßig hat ScraperAPI eine Ratenbegrenzung von 100; In Oxylabs sind es nur 30. Mit ScraperAPI können Benutzer also mehrere API-Anfragen gleichzeitig stellen, was für die Verbesserung der Geschwindigkeit und Effizienz der Datenextraktion wichtig ist.

| ScraperAPI-Geschäftsplan | Oxylabs-Geschäftsplan |

| 3.000.000 API-Credits | N / A |

| 120.000 erfolgreiche Ergebnisse | 104.000 Ergebnisse |

| 100 gleichzeitige Threads | 30 gleichzeitige Threads |

| Alles Geotargeting | Weltweite Geoverteilung |

| Ultra-Premium-Proxys | – |

4. SOAX

Die SOAX SERP API erfasst Daten von Suchmaschinen wie Google, Bing, Yahoo, Naver, Yandex, DuckDuckGo und Baidu in JSON- und HTML-Formaten.

Mit 191 Millionen IPs an 195 Standorten und Geo-Targeting-Optionen für die Datenerfassung auf Länder-, Stadt- und ASN-Ebene ist SOAX in der Lage, Scraping-Anforderungen mit hohem Datenverkehr effizient zu bewältigen.

Ein Nachteil besteht darin, dass Sie sich für die Nutzung des Dienstes auf einen monatlichen Plan festlegen müssen. Zum Testen steht keine kostenlose Testversion oder Demo zur Verfügung.

Hauptmerkmale

- Geo-Targeting an 195 Standorten

- Extrahieren Sie Daten aus allen Markup-Punkten oder wählen Sie bestimmte Elemente und Tags aus

- Headless Scraping für JavaScript-lastige Seiten

- Integrierte Browser-Fingerprint-Technologie zur Nachahmung des echten Benutzerverkehrs

- Automatische Proxy-Rotation mit CAPTCHA-Umgehung

- JSON- und HTML-Ausgabeformate

- Nahezu 100 % Erfolgsquote und 99,95 % Verfügbarkeit

Bewertungen: 4.6

Für und Wider

| Vorteile | Nachteile |

| Detailliertes Geo-Targeting für | Höherer Startpreis im Vergleich zu einigen Mitbewerbern |

| Schnellste Reaktionszeit | Keine Pay-as-you-go-Option |

| Benutzerfreundliche Oberfläche | Nutzungsstatistiken sind grundlegend |

| Flexible Scraping-Optionen für mehrere Suchmaschinen |

Preise

Sie müssen sich an den Vertrieb wenden, um Preise für ein SERP-Datenextraktionsprojekt zu erfahren, da dieser auf seiner Website keine Preisinformationen für seine API anbietet.

5. Smartproxy

Die Smartproxy SERP Scraping API sammelt Daten von Suchmaschinenplattformen wie Google, Bing, Baidu und Yandex. Es zeichnet sich durch seine Playground-Funktion aus, die es Benutzern ermöglicht, Konfigurationen vor der Bereitstellung zu testen – ähnlich wie bei ScraperAPI.

Wie andere in dieser Liste ermöglicht Smartproxy auch Geo-Targeting auf Länder-, Stadt- und Koordinatenebene von über 195 Standorten.

Hauptmerkmale

- Geo-Targeting von über 195 Standorten

- JSON-, HTML- und Tabellenformatausgaben

- Erfolgsquote von über 90 %

- Spielplatz zum Testen von Konfigurationen vor der vollständigen Bereitstellung

- Integrierte Browser-Fingerabdrücke zur Bekämpfung der Anti-Bot-Technologie

- Integrierte Proxy-Rotation zur Vermeidung von CAPTCHAs oder IP-Blockierungen

Bewertungen: 4.6

Für und Wider

| Vorteile | Nachteile |

| Benutzerfreundliche Oberfläche mit Testspielplatz | Nicht zum Scrapen großer Datenmengen geeignet |

| Niedrigerer Einstiegspreis, was es für kleine Projekte kostengünstig macht | |

| Eingebauter Planer |

Preise

Die Preise für Smartproxy beginnen bei 300 US-Dollar/Monat für 250.000 Anfragen, was es ideal für diejenigen macht, die weniger Anfragen bearbeiten und mit einem begrenzten Budget arbeiten müssen.

Wenn Sie große Mengen an Anfragen bearbeiten oder erweiterte Funktionen wie JS-Rendering und CAPTCHA-Verarbeitung benötigen, bietet ScraperAPI das beste Gleichgewicht zwischen Funktionen und Kosten. Es ist für Großoperationen günstiger als BrightData und bietet mehr Funktionen als Smartproxy.

| Anbieter | Preise pro 1.000 Anfragen | Monatliche Kosten (Anfang) |

| ScraperAPI | 2,49 $/1.000 Anfragen | 299 $/Monat |

| BrightData | 2,55 $/1.000 Anfragen | 499 $/Monat |

| Smartproxy | 1,20 $ – 2,00 $/1.000 Anfragen | 300 $ für 250.000 Anfragen |

6. NetNut

Mit der SERP Scraper API für Google von NetNut können Sie SERP-Daten aus jeder Suchmaschine extrahieren.

Mit über 200 ISP-Partnern und 100 Milliarden monatlich weitergeleiteten Anfragen bietet NetNut ein umfangreiches Netzwerk mit granularem Geo-Targeting bis auf Stadt- und Landesebene mit Unterstützung verschiedener Sprachen.

Wie bei ScraperAPI und anderen Anbietern zahlen Sie hier nur für erfolgreiche Anfragen. Der größte Nachteil ist jedoch der hohe Preis, der für die meisten Unternehmen nicht akzeptabel ist.

Hauptmerkmale

- Targeting auf Stadt-/Landesebene von über 200 ISP-Partnern

- Benutzerfreundliches Dashboard für Proxy-Verwaltung, Analysen und anpassbare Einstellungen

- Automatisieren Sie den Abruf und die Analyse von SERP-Daten

- Integrierte Proxy-Rotation zur Verhinderung von IP-Blockaden

- Gibt JSON- und HTML-Formate zurück

- Testen Sie API-Konfigurationen und Proxy-Einstellungen vor der Live-Bereitstellung

Bewertungen: 4.6

Für und Wider

| Vorteile | Nachteile |

| Zahlen Sie nur für erfolgreiche Anfragen | Keine Unterstützung für asynchrone Anfragen, die umfangreiche Vorgänge verlangsamen können |

| Integrierte Proxy-Rotation | |

| Ermöglicht Tests vor der Bereitstellung | |

| Benutzerfreundliches Dashboard für einfache Einrichtung und Verwaltung |

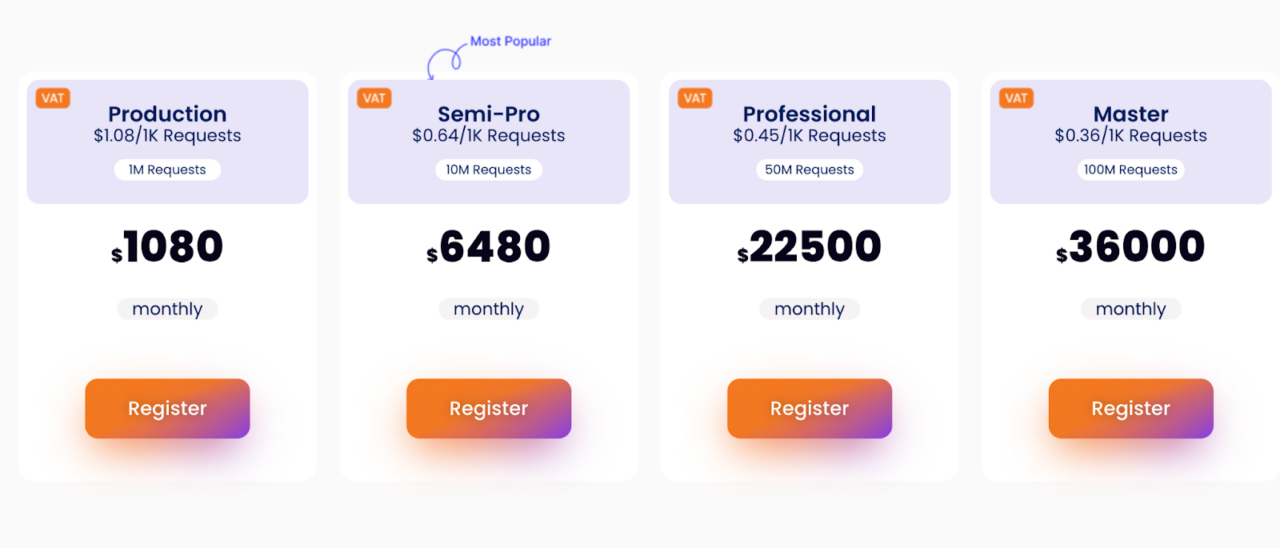

Preise

Die Preise von NetNut beginnen bei 1080 $/Monat für 1 Million Anfragen, was 1,08 $/1.000 Anfragen entspricht; Der hohe Einstiegspreis macht es für kleinere Unternehmen oder Projekte weniger zugänglich.

Im Gegensatz dazu bietet ScraperAPI einen flexibleren Ansatz. Der niedrigere Einstiegspreis von 299 US-Dollar pro Monat für 3 Millionen API-Credits macht es zu einer günstigeren Lösung für kleine bis mittelgroße Projekte. Wenn Sie mehr als 3 Mio. API-Credits benötigen, erhalten Sie einen individuellen Unternehmensplan. Das bedeutet, dass der Preis pro 1 Million Anfragen stark reduziert wird und Sie damit ein besseres Angebot erhalten als bei den meisten anderen Tools – einschließlich NetNut.

Dazu gehören auch ein dedizierter Account Manager, über 100 gleichzeitige Threads und ein Slack-Supportkanal für eine schnelle Fehlerbehebung.

ScraperAPI bietet mehr Flexibilität und Erschwinglichkeit für kleinere Projekte und bietet gleichzeitig Zugriff auf Premium-Funktionen wie automatische CAPTCHA-Verarbeitung und Proxy-Rotation.

7. Infatica

Infatica SERP Scraper extrahiert Daten von Google, Bing, Yahoo und anderen Suchmaschinen. Wie ScraperAPI bietet auch der SERP Scraper von Infatica anpassbare Abfragen und ermöglicht Benutzern die Anwendung von Filtern, das Festlegen von Parametern und die Verwendung von Proxys, um eine genauere Datenextraktion sicherzustellen.

Trotz dieser Funktionen fällt Infatica zurück, da es im Vergleich zur Konkurrenz an einer umfassenderen globalen Abdeckung und zusätzlichen erweiterten Funktionen wie asynchronen Anfragen mangelt. Benutzer beschweren sich auch über die steile Lernkurve von Infatica aufgrund der weniger klaren Dokumentation.

Hauptmerkmale

- Vermeiden Sie IP-Verbote und CAPTCHAs mit Proxy-Rotation

- Greifen Sie auf dynamische Webinhalte zu

- Benutzerdefinierte Header und Sitzungen zur Nachahmung jedes Browsers oder Geräts

- Speichern Sie Daten in den Formaten CSV, XLSX und JSON

- HTTP/SOCKS-Protokolle für erhöhte Sicherheit

Bewertungen: 4.3

Für und Wider

| Vorteile | Nachteile |

| Anpassbare Abfragen und Filteroptionen | Ein kleinerer Pool von nur 10 Millionen IPs, der zu häufigeren Blockierungen durch Websites führen kann |

| Ermöglicht das Scrapen dynamischer Webinhalte durch JavaScript-Rendering | Eine mangelhafte Dokumentation führt zu einer schwierigen Einrichtung und Nutzung und erfordert zusätzliche Ressourcen |

| Benutzerdefinierte Header und Sitzungen |

Preise

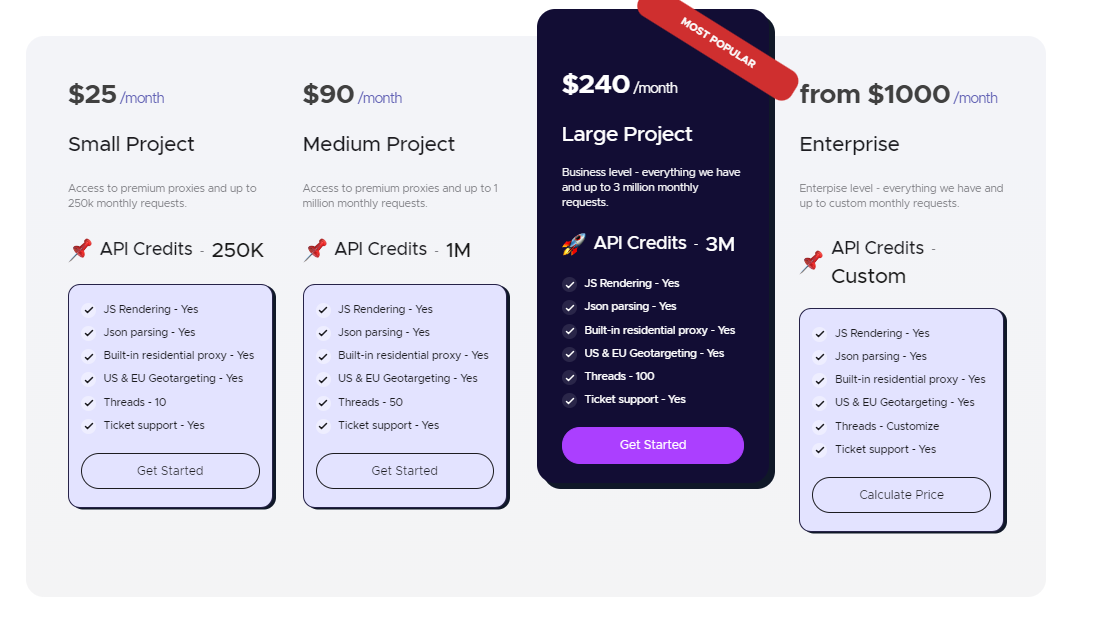

Während Infatica für 240 US-Dollar pro Monat wesentliche Scraping-Funktionen bietet, ist das begrenzte Geotargeting, das nur in den USA und der EU verfügbar ist, ein großer Nachteil.

| Planen | Preis | # API-Credits | SERP-Seiten entfernt* |

| Klein | 25 $/Monat | 250.000 | 12.500 |

| Medium | 90 $/Monat | 1.000.000 | 50.000 |

| Groß | 240 $/Monat | 3.000.000 | 150.000 |

| Unternehmen | Ab 1000 $/Monat | Brauch | Brauch |

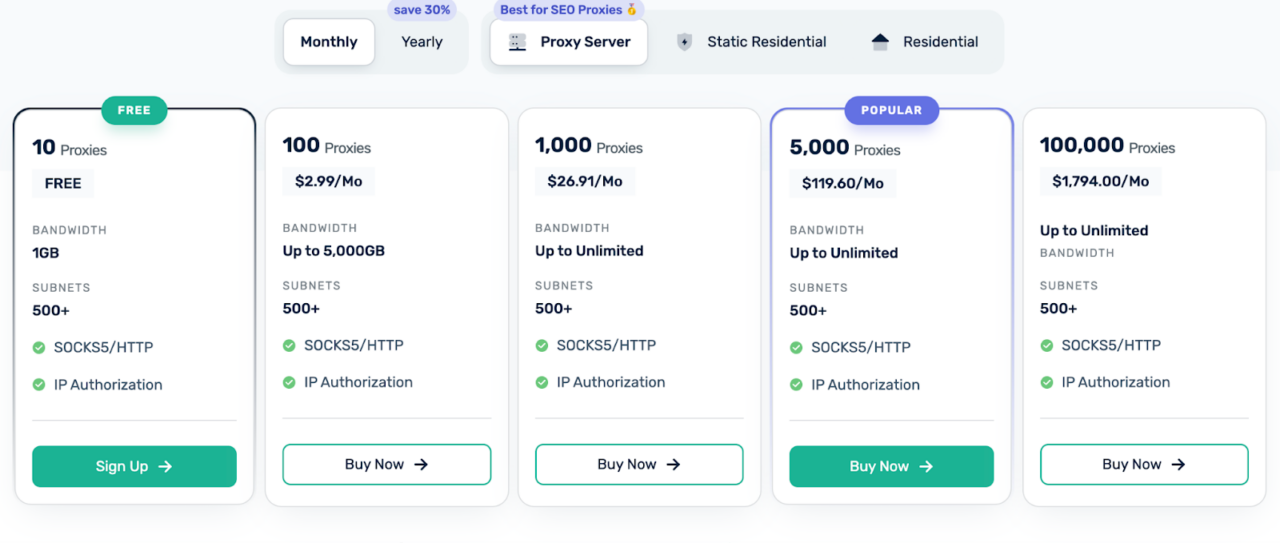

8. Webshare

Webshare ist ein relativ neuer, aber wachsender Akteur auf dem Proxy-Markt. Obwohl es keine besondere Funktion zum Scrapen von SERP-Daten bietet, könnten seine Premium-Proxys (insbesondere Privat-Proxys) eine gute Wahl sein, wenn Sie ausschließlich nach einem Proxy-Pool suchen.

Hauptmerkmale

- Weltweite Abdeckung in über 50 Ländern

- Flexible Preisgestaltung mit kostenlosem Plan (10 Proxys) und Self-Service-Plattform

- SOCKS5- und HTTP(S)-Protokolle

- Geotargeting

Bewertungen: 4.2

Für und Wider

| Vorteile | Nachteile |

| Flexible Preisgestaltung mit einer kostenlosen Option zum Einstieg | Keine dedizierte SERP Scraper API |

| Einsteigerfreundliche Plattform mit einfachen, umfangreichen Self-Service-Funktionen | Keine Genauigkeit auf Stadt-, Bundesland- oder ASN-Ebene |

| Sichere Protokolle (SOCKS5, HTTP(S)) gewährleisten den Datenschutz | Kein 24/7-Kundensupport |

Preise

Webshare basiert auf einem bandbreitenbasierten Preismodell, bei dem die Kosten davon abhängen, wie viele Daten Sie beim Scraping verbrauchen. Dies kann unvorhersehbar sein, insbesondere bei Projekten, bei denen Scraping zu großen Datenmengen führt oder erfolglose Anfragen möglicherweise Bandbreite verbrauchen, ohne wertvolle Informationen zurückzugeben.

Die Preise für ScraperAPI bleiben gleich, sodass Sie Ihre Datenpipelines ohne Überraschungen in Ihrer Rechnung skalieren können.

| Vergleich | ScraperAPI | Webshare |

| Preismodell | Zahlen Sie pro erfolgreicher Anfrage | Bezahlen Sie pro verbrauchter Bandbreite |

| Kostenkontrolle | Sehr vorhersehbar | Aufgrund der Bandbreite unvorhersehbar |

| Fehlgeschlagene Anfragen | Keine Gebühr für fehlgeschlagene Anfragen | Durch Ausfälle wird Bandbreite verschwendet |

| CAPTCHA-Verwaltung | Automatisch (minimiert fehlgeschlagene Kratzer) | Erfordert manuelle Einrichtung |

| Ideal für | Große SERP-Scraping-Projekte und Unternehmensteams | Teams, die einen Proxy-Pool ohne zusätzliche Funktionen suchen |

Abschluss

Wir hoffen, dass dieser Vergleich der besten rotierenden SEO-Proxys Ihnen bei der Auswahl des richtigen Tools für Ihre SEO-Kampagnen mit mehreren Standorten hilft. Egal, ob Sie budgetfreundliche Optionen bevorzugen oder erweiterte Funktionen benötigen, es gibt eine Lösung, die Ihren Anforderungen entspricht. Für präziseres und automatisiertes Scraping mit minimalem Setup bleibt ScraperAPI die erste Wahl für strukturierte Daten und erweiterte Funktionen.

Benötigen Sie mehr als 120.000 Suchergebnisse pro Monat? Kontaktieren Sie unser Vertriebsteam für einen maßgeschneiderten Unternehmensplan und genießen Sie alle Vorteile:

- Über 100 gleichzeitige Threads

- Dedizierter Account Manager

- Spezieller Slack-Supportkanal