Airbnb ist eine Online-Plattform zur Buchung von Unterkünften, die es Menschen ermöglicht, ihre Häuser, Wohnungen, Zimmer oder andere Arten von Unterkünften für kurzfristige Aufenthalte zu vermieten oder zu leasen. Es ermöglicht Reisenden, verschiedene Unterkunftsmöglichkeiten in verschiedenen Teilen der Welt zu finden, darunter Hotels, Apartments und Ferienhäuser.

Benutzer können verfügbare Optionen durchsuchen, Bewertungen von anderen Gästen lesen, Unterkünfte buchen und Gastgeber direkt über die Plattform kontaktieren. Mithilfe von Scrapern können Sie Informationen zu Objekten, Rezensionen und Bewertungen, Gastgebern, Buchungen und Verfügbarkeiten erhalten.

Solche Informationen über verfügbare Immobilien können nicht nur für begeisterte Reisende und häufige Geschäftsreisende nützlich sein, sondern auch für Immobilienmakler und Privatinvestoren, die andere Immobilien in der Umgebung nutzen können, um zu verstehen, welche Annehmlichkeiten und Preise Wettbewerber anbieten, um ihre Angebote zu entwickeln.

In diesem Artikel besprechen wir die Methoden der Datenerfassung von Airbnb, die sowohl von denjenigen verwendet werden können, die nur die Daten abrufen möchten, als auch von denen, die lediglich die Datenerfassung automatisieren und Python-basierte Lösungen mit unterschiedlichen Ansätzen entwickeln möchten.

Scraping vs. Verwendung einer API: Die Optionen verstehen

Beim Sammeln von Daten von einer Website ist die offizielle API die erste zu berücksichtigende Option. Diese Methode bietet normalerweise vollständigen Datenzugriff, ohne dass Workarounds erforderlich sind. Obwohl APIs möglicherweise nicht alle Daten bereitstellen, bevorzugen Entwickler im Allgemeinen deren Verwendung.

Scraper werden verwendet, wenn eine offizielle API nicht verfügbar oder unpraktisch ist. In diesem Fall kann ein Entwickler einen Scraper in einer beliebigen Programmiersprache erstellen, um die erforderlichen Daten automatisch zu sammeln. In diesem Abschnitt werden die Vor- und Nachteile der Erstellung eines Python-Scrapers, der Airbnb-API und ihrer Alternativen erläutert.

Vor- und Nachteile von Airbnb Scraping

Bevor Sie sich mit der Skriptentwicklung befassen, ist es wichtig, die Vor- und Nachteile des Scrapings von Airbnb zu verstehen. Für Ihre Bequemlichkeit haben wir eine umfassende Tabelle zusammengestellt, in der die wichtigsten Überlegungen zusammengefasst sind:

|

Vorteile von Airbnb Scraping |

Nachteile von Airbnb Scraping |

|---|---|

|

1. Flexibilität: Kann beliebige Daten aus Airbnb-Einträgen extrahieren. |

1. Instabilität: Website-Änderungen können Scraping-Skripte beschädigen. |

|

2. Anpassung: Möglichkeit, die Datenextraktion an spezifische Anforderungen anzupassen. |

2. Stabilität: Scraping ist im Vergleich zur Verwendung einer API möglicherweise weniger stabil, da es durch Website-Änderungen und -Updates beeinträchtigt werden kann. |

|

3. Unabhängigkeit: Kein Vertrauen auf die API-Verfügbarkeit oder -Einschränkungen von Airbnb. |

3. Technische Komplexität: Scraping erfordert Programmierkenntnisse und Wartung. |

|

4. Kosteneffizienz: Scraping kann im Vergleich zu API-Zugriffsgebühren kosteneffizient sein. |

4. Tarifbeschränkungen: Beim Scraping können von Airbnb auferlegte Tarifbeschränkungen gelten, die sich auf die Geschwindigkeit des Datenabrufs auswirken. |

|

5. Zugriff auf versteckte Daten: Kann auf Daten zugreifen, die nicht über die Airbnb-API offengelegt werden. |

5. Risiko der Blockierung: Airbnb kann den Zugriff oder die IP-Adressen einschränken. |

|

6. Echtzeitdaten: Kann die neuesten Daten direkt von der Website abrufen. |

6. Captcha- und Bot-Erkennung: Airbnb kann Maßnahmen ergreifen, um Scraping-Aktivitäten zu erkennen. |

Hier erhalten Sie einen ausgewogenen Überblick über die Vor- und Nachteile des Scrapings von Daten aus Airbnb-Einträgen. Sie sollten diese Faktoren sorgfältig berücksichtigen, wenn Sie entscheiden, ob Sie Daten von Airbnb extrahieren oder alternative Methoden für den Datenzugriff prüfen möchten.

Erkundung von Alternativen: Airbnb-API und Lösungen von Drittanbietern

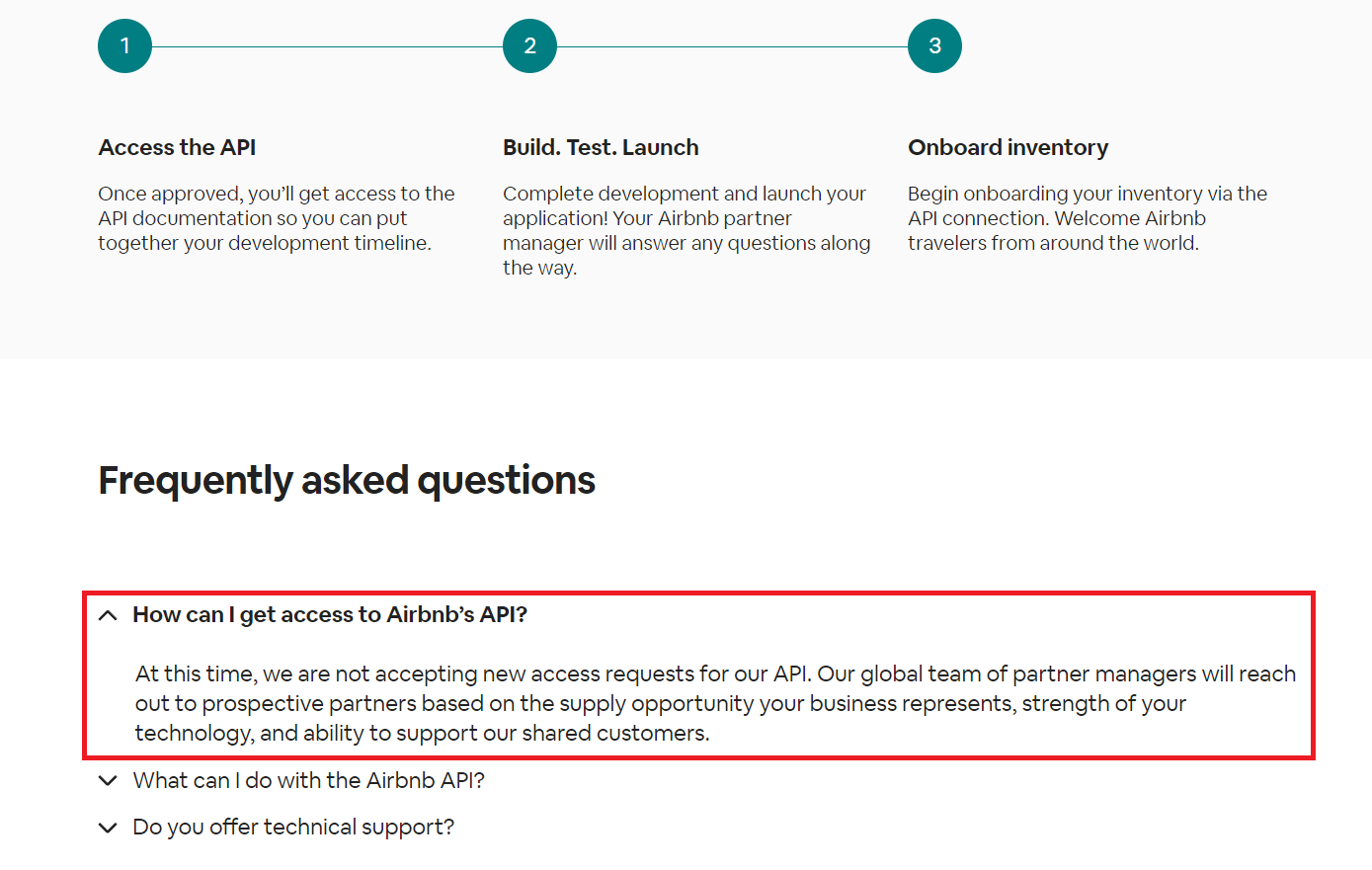

Wie bereits erwähnt, ist der einfachste Weg, Daten aus dem Dienst abzurufen, die offizielle API, und Airbnb verfügt über eine solche. Es ist jedoch unwahrscheinlich, dass der Einsatz erfolgreich sein wird. Wenn Sie die offizielle Airbnb-API-Seite aufrufen, finden Sie im FAQ-Bereich die folgenden Informationen:

Die offizielle API ist also keine Option, aber wir haben eine alternative Lösung. Um den Prozess des Datenabrufs von Airbnb zu vereinfachen, können Sie Dienste von Drittanbietern nutzen, um die Daten zu sammeln. Wenn Sie lediglich einen vorgefertigten Datensatz benötigen, müssen Sie keine Skripte schreiben. Stattdessen können Sie unseren Airbnb-No-Code-Scraper verwenden.

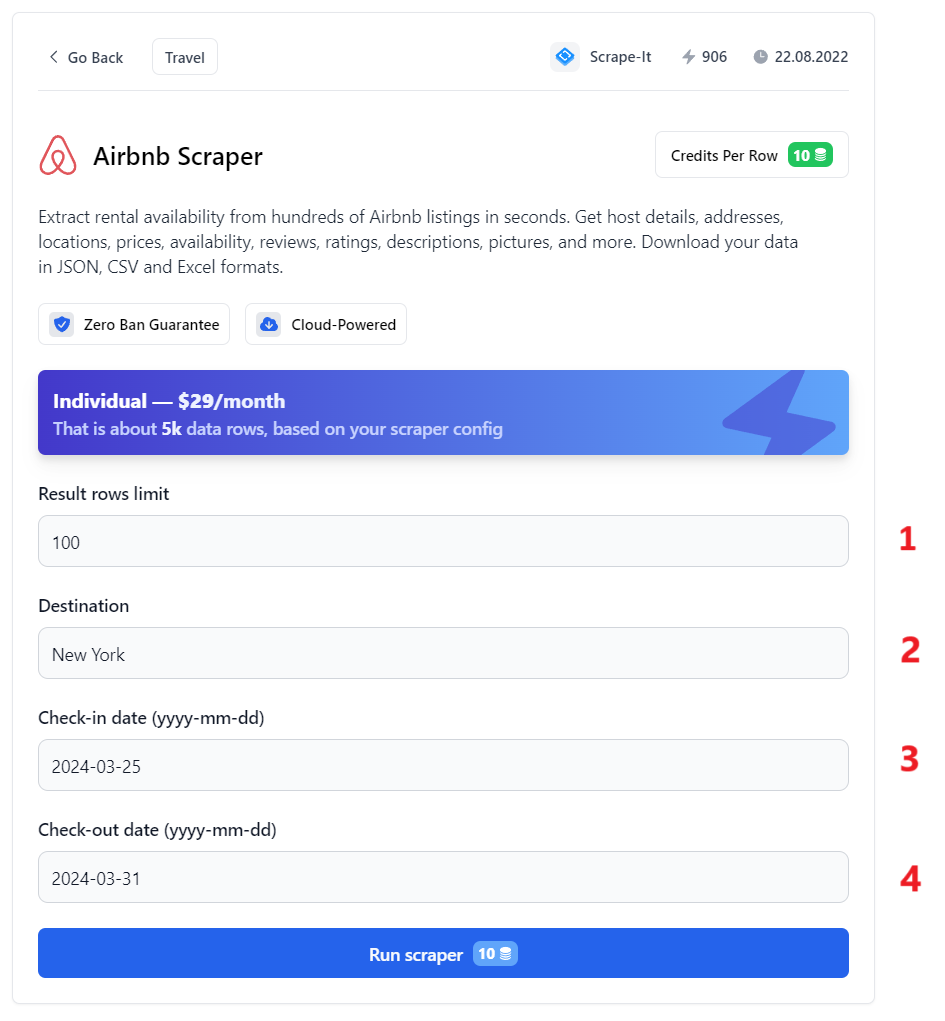

Um Daten zu erhalten, müssen Sie nur die notwendigsten Parameter angeben:

- Ergebniszeilenlimit. Geben Sie die Anzahl der Ergebniszeilen ein, die Sie erhalten möchten.

- Ziel. Geben Sie die Stadt oder den Ort ein, in dem Sie Angebote finden möchten.

- Check-in Datum. Geben Sie das Check-in-Datum im Format ein

yyyy-mm-dd. - Überprüfe das Datum. Geben Sie das Check-out-Datum im gleichen Format ein.

Nachdem Sie alle erforderlichen Parameter angegeben haben, klicken Sie auf die Schaltfläche „Run Scraper“, um den Datenerfassungsprozess zu starten. Wenn der Vorgang abgeschlossen ist, können Sie die Daten im JSON-, CSV- oder XLSX-Format auf der rechten Seite des Bildschirms herunterladen.

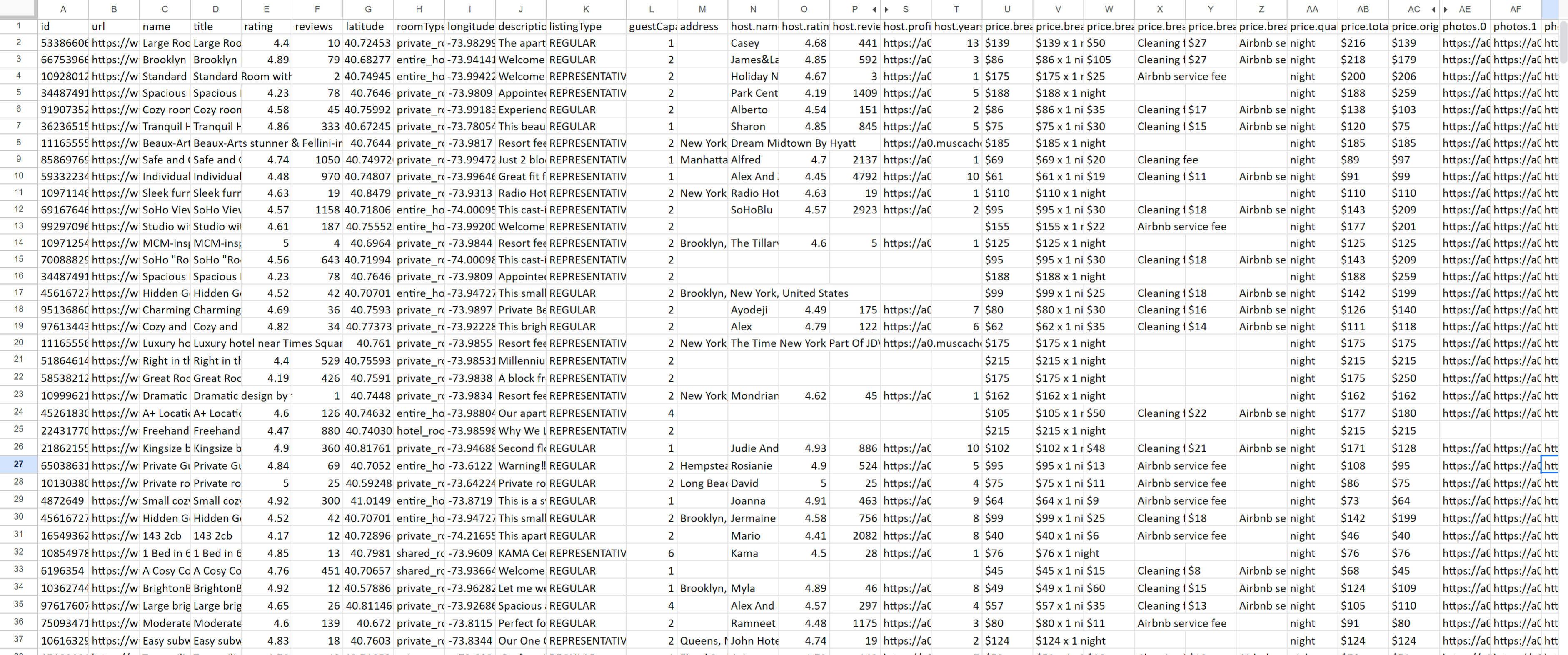

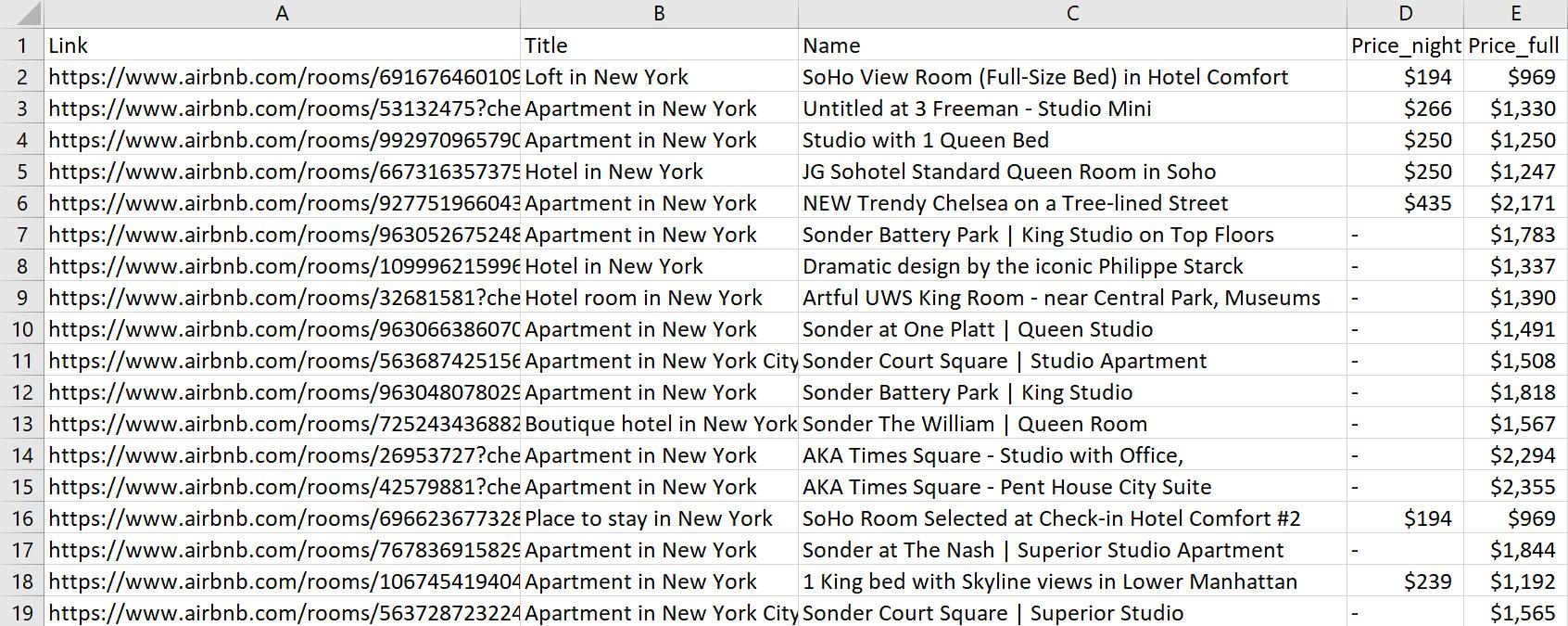

Beispiel für die Daten, die Sie erhalten:

Diese Option ist möglicherweise praktischer, wenn Sie nur die Daten abrufen müssen. Wenn Sie jedoch eine eigene Anwendung erstellen möchten, die ständig aktuelle Daten erhält, verraten wir Ihnen im Folgenden, wie das geht.

Scrapen Sie Einträge mithilfe der inoffiziellen Airbnb-API

Beginnen wir mit der einfacheren Option, die Airbnb-API von HasData zu verwenden, um Eintragsdaten abzurufen und sie mit Python zu analysieren. Diese API gibt eine JSON-Antwort im folgenden Format zurück:

- requestMetadata

- id

- status

- url

- properties (array of objects)

- id

- url

- title

- name

- roomType

- listingType

- latitude

- longitude

- photos (array of URLs)

- rating

- reviews

- badges

- price

- originalPrice

- discountedPrice

- qualifier

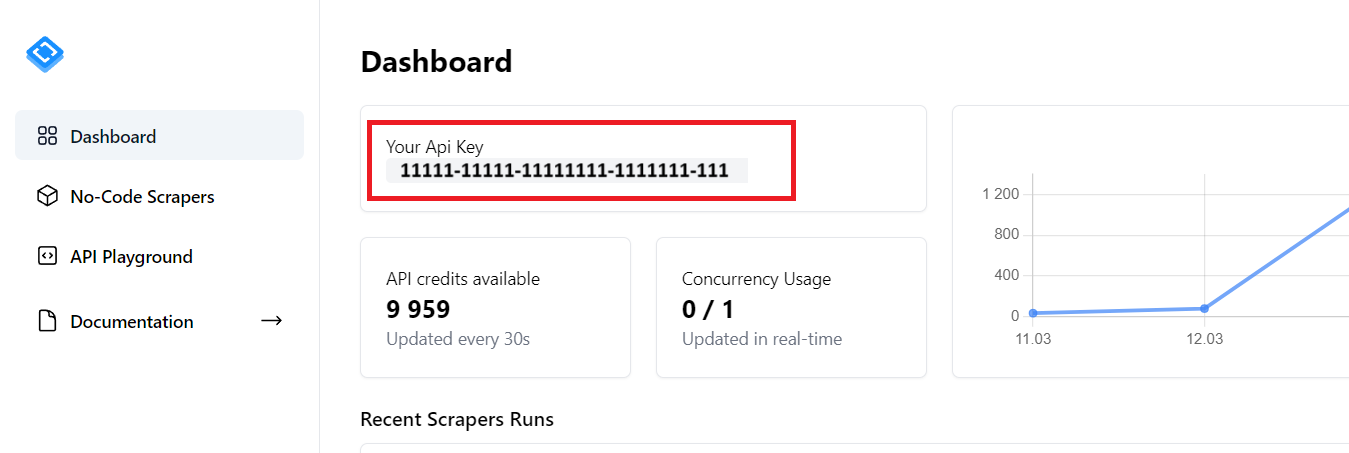

- breakdown Um es zu nutzen, melden Sie sich an und kopieren Sie Ihren persönlichen API-Schlüssel:

Fahren wir mit dem Bau des Schabers fort. Wenn Sie das resultierende Skript erhalten möchten, gehen Sie zum Google Colaboratory.

Bevor wir beginnen, stellen Sie bitte sicher, dass Sie Python 3.10 oder höher installiert haben. Dies ist eine Voraussetzung für alle Skripte, die wir verwenden werden. Um die erforderlichen Bibliotheken zu installieren, öffnen Sie eine Eingabeaufforderung oder ein Terminal und führen Sie die folgenden Befehle aus:

pip install requests pandasErstellen Sie ein neues Projekt und importieren Sie die Bibliotheken:

import requests

import jsonLegen Sie Ihre Suchparameter fest, um Einträge zu durchsuchen:

location = "New York"

check_in = "2024-03-28"

check_out = "2024-03-30"Geben Sie einen Anforderungsheader mit Ihrem HasData-API-Schlüssel an:

headers = {

'x-api-key': 'YOUR-API-KEY'

}Erstellen Sie eine URL mit den zuvor angegebenen Parametern:

url = f"https://api.scrape-it.cloud/scrape/airbnb/listing?&location={location}&checkIn={check_in}&checkOut={check_out}"Eine Anfrage stellen:

response = requests.get(url, headers=headers)Schauen wir mal, ob wir eine positive Antwort erhalten haben. Wenn ja, speichern wir die Daten im JSON-Format. Andernfalls wird eine Fehlermeldung angezeigt:

if response.status_code == 200:

data = response.json()

with open('airbnb_listing.json', 'w') as json_file:

json.dump(data, json_file)

print("Saved to 'airbnb_listing.json'")

else:

print(f"Error: {response.status_code}")Als Ergebnis erhalten wir ein JSON-Objekt:

{

"requestMetadata": {

"id": "a9b4c918-0d73-447d-bc29-009035e4efcc",

"status": "ok",

"url": "https://www.airbnb.com/s/New%20York/homes?checkin=2024-03-28&checkout=2024-03-30"

},

"properties": (

{

"id": "691676460109271194",

"url": "https://www.airbnb.com/rooms/691676460109271194",

"title": "Loft in New York",

"name": "SoHo View Room (Full-Size Bed) in Hotel Comfort",

"roomType": "entire_home",

"listingType": "REPRESENTATIVE",

"latitude": 40.71806,

"longitude": -74.00095,

"photos": (

"https://a0.muscache.com/im/pictures/prohost-api/Hosting-691676460109271194/original/82824443-8970-4061-94bd-4524d6caee3c.jpeg?im_w=720", "https://a0.muscache.com/im/pictures/miso/Hosting-691676460109271194/original/1818d3a5-8578-4a59-a9b7-63786541f7d5.jpeg?im_w=720"

),

"rating": 4.56,

"reviews": 1175,

"badges": (

),

"price": {

"originalPrice": "$210",

"discountedPrice": "$157",

"qualifier": "night",

"breakdown": (

)

}

},

... (other listings)

)Durch die Verwendung der Airbnb-API erhalten Sie nicht nur schnell alle erforderlichen Daten, sondern können auch mögliche Blockierungen vermeiden, Ihren Code vereinfachen und sich auf die Datenanalyse statt auf die Datenerfassung konzentrieren.

Scrapen Sie Airbnb-Immobiliendaten mit der API

Sie können die Airbnb-API auch verwenden, um Daten nicht nur über die Suche, sondern auch für bestimmte Unterkünfte abzurufen. Dadurch erhalten Sie detailliertere Informationen.

Lassen Sie uns einen anderen Endpunkt verwenden und unser Skript leicht modifizieren, um ein Array vordefinierter Eigenschaften zu durchlaufen. Ein fertiges Skript finden Sie in Google Colaboratory.

Der Anfang des Skripts bleibt gleich:

import requests

import jsonErstellen Sie dann eine Variable zum Speichern von Daten:

data_list = ()Dies ist notwendig, um am Ende alle Daten in einer einzigen Datei zu speichern. Sie müssen außerdem den HasData-API-Schlüssel und die Links zu den Eigenschaften angeben, die Sie durchsuchen möchten:

properties=("https://www.airbnb.com/rooms/946842435422127304", "https://www.airbnb.com/rooms/49662898")

headers = {

'x-api-key': 'YOUR-API-KEY'

}Gehen Sie durch die Links:

for property in properties:Senden Sie die Anfrage an die API:

url = f"https://api.scrape-it.cloud/scrape/airbnb/property?url={property}"

response = requests.get(url, headers=headers)Verarbeiten Sie die Antwort, wenn sie erfolgreich war:

if response.status_code == 200:

data = response.json()An diesem Punkt können wir entweder:

- Speichern Sie die Daten für die aktuelle Eigenschaft in einer separaten Datei.

- Fügen Sie es einer Variablen hinzu, damit wir nach dem Durchlaufen aller Links alle Daten in einer einzigen JSON-Datei speichern können.

Um die Daten in einer separaten Datei zu speichern, verwenden Sie den folgenden Code:

with open(f'airbnb_property_{data("property")("id")}.json', 'w') as json_file:

json.dump(data, json_file)Um die Daten zur späteren Verwendung zu speichern, speichern Sie sie in einer Variablen:

data_list.append(data('property'))Auf diese Weise durchläuft Ihr Skript alle Links und speichert detaillierte Daten für jedes Angebot. Um eine endgültige Datei mit allen Daten zu erhalten, verwenden Sie den folgenden Code:

with open('airbnb_properties.json', 'w') as json_file:

json.dump(data_list, json_file)Der Code, den Sie jetzt haben, ist funktionsfähig, aber es gibt einige Möglichkeiten, ihn in Zukunft zu verbessern und die Daten nicht in JSON, sondern in einem bequemeren Format zu speichern. Alternativ können Sie die Möglichkeit hinzufügen, eine Liste von URLs aus einer Datei anstelle einer Variablen abzurufen.

Scrapen Sie Airbnb mit dem Headless Browser

Wenn Sie den anspruchsvolleren Weg gehen und Ihren eigenen Scraper schreiben möchten, benötigen Sie einen Headless-Browser. Dadurch wird das Verhalten eines Benutzers nachgeahmt und Sie können auf der Seite navigieren und Daten sammeln.

Scraping ohne API ist schwierig, da der Inhalt von Airbnb dynamisch generiert wird. Der Versuch, einfache Anfragen zu verwenden, um Daten von der Seite abzurufen, wird nicht funktionieren. Wenn Sie es jedoch selbst ausprobieren möchten, haben wir auf Google Collaboratory ein Skript bereitgestellt, mit dem Sie versuchen können, die Seite mit Requests, BeautifulSoup oder Scrapy zu scrapen und den resultierenden HTML-Code in einer Datei zu speichern. Das Ergebnis wird recht anschaulich sein:

Daher werden wir diese Option nicht in Betracht ziehen und stattdessen zu einer effektiveren Lösung übergehen: der Verwendung eines Headless-Browsers und der Selenium-Bibliothek.

Notwendige Bibliotheken installieren

Wir benötigen nur zwei Bibliotheken, um einen Web Scraper zu erstellen: Selenium und Pandas. Installieren wir sie mit dem Paketmanager:

pip install selenium pandasFür Selenium müssen Sie möglicherweise auch den Webtreiber separat herunterladen und installieren. Dies ist jedoch in den neuesten Versionen nicht erforderlich. Wenn Sie noch keine Headless-Browser verwendet haben, finden Sie in unserem Blog einen Artikel zum Scraping mit Selenium.

Die Website-Struktur von Airbnb verstehen

Bevor wir beginnen, ist es erwähnenswert, dass Sie das fertige Skript auch in Google Collaboratory finden. Sie können es herunterladen und auf Ihrem eigenen PC ausführen, da Google die Ausführung von Web Driver in Colab Research nicht zulässt.

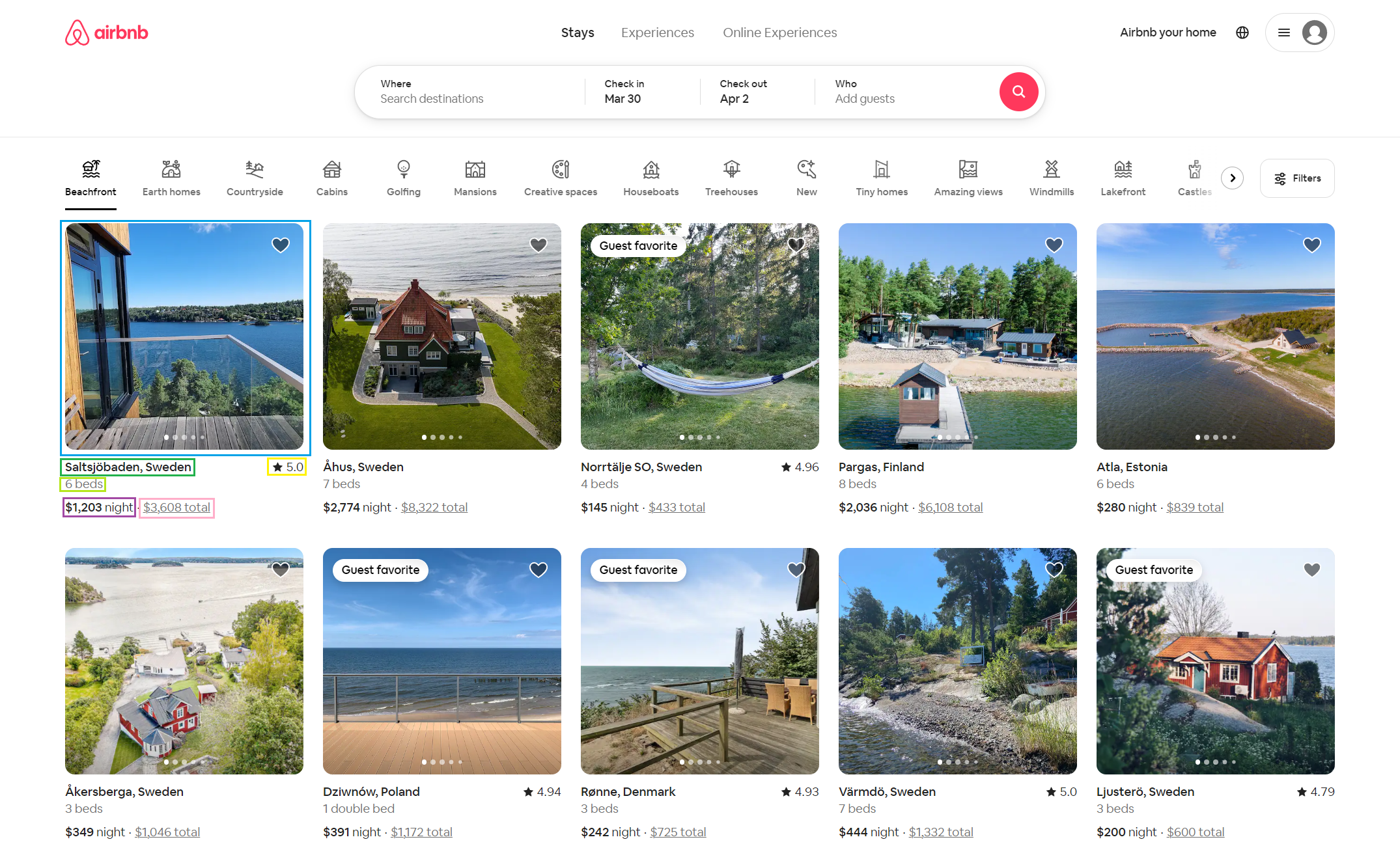

Gehen wir nun zur Airbnb-Website, geben die Suchparameter für Unterkünfte an und sehen, welche Daten wir extrahieren können:

Wenn wir also Daten von der Airbnb-Suchseite extrahieren, erhalten wir die folgenden Informationen:

- Eigentums Titel.

- Anzahl der Räume.

- Preis. Airbnb erstattet den Preis für eine Nacht und die angegebene Anzahl Tage.

- Bewertung. Dieser Parameter ist nicht für alle Einträge verfügbar und sollte beim Scraping berücksichtigt werden.

Das nächste, worauf Sie achten sollten, ist der Link. Im Allgemeinen sieht die Anfrage, die wir zuvor gestellt haben, wie folgt aus:

https://www.airbnb.com/?tab_id=home_tab&refinement_paths%5B%5D=%2Fhomes&search_mode=flex_destinations_search&flexible_trip_lengths%5B%5D=one_week&monthly_start_date=2024-04-01&monthly_length=3&monthly_end_date=2024-07-01&category_tag=Tag%3A789&price_filter_input_type=0&channel=EXPLORE&date_picker_type=calendar&checkin=2024-03-30&checkout=2024-04-02&source=structured_search_input_header&search_type=filter_changeOder dieses Formular für den angegebenen Standort:

https://www.airbnb.com/s/New-York--United-States/homes?tab_id=home_tab&refinement_paths%5B%5D=%2Fhomes&flexible_trip_lengths%5B%5D=one_week&monthly_start_date=2024-04-01&monthly_length=3&monthly_end_date=2024-07-01&price_filter_input_type=0&channel=EXPLORE&date_picker_type=calendar&checkin=2024-03-30&checkout=2024-04-02&source=structured_search_input_header&search_type=autocomplete_click&price_filter_num_nights=3&query=New%20York%2C%20United%20States&place_id=ChIJOwE7_GTtwokRFq0uOwLSE9gLassen Sie uns die wichtigsten Einstellungen identifizieren, die wir später ändern werden:

- Standort. Hier möchten Sie suchen, z. B. „New-York–United-States“.

search_mode: Es ist der Suchmodus. „flex_destinations_search“ bedeutet flexible Suche nach Zielen.checkin: Check-in Datum. Wenn es beispielsweise „28.03.2024“ ist, bedeutet es den 28. März 2024.checkout: Überprüfe das Datum. Wenn es „2024-04-02“ ist, ist es der 2. April 2024.source: Quelle der Suche. „structured_search_input_header“ gibt die Suche über den strukturierten Eingabeheader an.

Diese Einstellungen reichen aus, um einen funktionierenden Link zum Scrapen zu erstellen.

Öffnen Sie nun Ihren bevorzugten Texteditor oder Ihre bevorzugte IDE und erstellen Sie eine neue Datei mit der Erweiterung .py. Denken Sie daran, dass Sie für die Skripte in diesem Tutorial Python 3.10 oder höher benötigen.

Fügen Sie oben in Ihrem Skript Importanweisungen für die Bibliotheken hinzu, die Sie verwenden werden:

import pandas as pd

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.chrome.service import Service

from selenium.webdriver.chrome.options import Options

from selenium.webdriver.support.ui import WebDriverWait

from selenium.webdriver.support import expected_conditions as ECStellen Sie dann die gewünschten Parameter ein:

city = str("New York").replace(' ', '-')

country = str("United States").replace(' ', '-')

checkin = "2024-03-28" #yyyy-mm-dd

checkout = "2024-04-02"

Configure the web driver settings and parameters, and then launch it:

service = Service('C:\driver\chromedriver.exe')

service.start()

options = Options()

options.headless = True

driver = webdriver.Chrome(service=service, options=options)Um zu verhindern, dass Fehler die Programmausführung unterbrechen, verwenden wir a try Block. Dadurch kann Ihr Code Fehler überspringen und weiter ausführen:

try:Erstellen Sie dann die Anforderungs-URL:

base_url="https://www.airbnb.com/s/"

query = f"{city}--{country}/homes"

url = f"{base_url}{query}?checkin={checkin}&checkout={checkout}&source=structured_search_input_header"Gehen Sie über den Link:

driver.get(url)Und warten Sie auf ein Werbeelement:

WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.CSS_SELECTOR, '(data-testid="card-container")')))Holen Sie sich alle Eigenschaften auf der Seite:

listings = driver.find_elements(By.CSS_SELECTOR, '(data-testid="card-container")')Bevor wir in eine Datei schreiben, müssen wir die Daten irgendwo speichern. Erstellen wir hierfür eine Variable:

data = ()Gehen Sie alle Anzeigen auf der Seite durch und sammeln Sie die erforderlichen Daten:

for listing in listings:

href = listing.find_element(By.TAG_NAME, 'a').get_attribute('href')

title = listing.find_element(By.CSS_SELECTOR, '(data-testid="listing-card-title")').text.strip()

name = listing.find_element(By.CSS_SELECTOR, '(data-testid="listing-card-name")').text.strip()

subtitle = listing.find_element(By.CSS_SELECTOR, '(data-testid="listing-card-subtitle")>span').text.strip()

price_night = listing.find_element(By.CSS_SELECTOR, 'span._1y74zjx').text.strip().split(" ") if listing.find_elements(By.CSS_SELECTOR, 'span._1y74zjx') else '-'

price_full = listing.find_element(By.CSS_SELECTOR, 'div._10d7v0r').text.strip().split(" ") if listing.find_elements(By.CSS_SELECTOR, 'div._10d7v0r') else '-'

data.append({'Link': href, 'Title': title, 'Name': name, 'Subtitle': subtitle, 'Price_night': price_night, 'Price_full': price_full})Schließen Sie abschließend den Webdriver:

finally:

driver.quit()Dies ist von entscheidender Bedeutung, denn wenn Sie dies vergessen, wird der WebDriver nicht automatisch geschlossen und läuft im Hintergrund weiter.

Airbnb-Daten speichern

Zuvor haben wir die Pandas-Bibliothek importiert, die eine bequeme Möglichkeit bietet, mit in DataFrames gespeicherten Tabellendaten zu arbeiten. Wir haben uns für diese Bibliothek entschieden, weil sie das Speichern von Daten in den gängigsten Formaten unterstützt, darunter CSV, JSON, XLSX und sogar Datenbanken.

Um es zu verwenden, erstellen wir einen DataFrame aus unseren gesammelten Daten:

df = pd.DataFrame(data)Und speichern Sie die Daten in jedem geeigneten Format:

df.to_csv(f'airbnb_{city}_{country}_listings.csv', index=False)

df.to_json(f'airbnb_{city}_{country}_listings.json', orient="records")

df.to_sql('listings', conn, index=False, if_exists="replace")

df.to_excel(f'airbnb_{city}_{country}_listings.xlsx', index=False)Das Ergebnis:

Zusätzlich zu den oben besprochenen Optionen unterstützt Pandas viele weitere, die Sie in der offiziellen Dokumentation finden.

Airbnb-Scraping-Herausforderungen

Beim Scrapen von Airbnb ist es wichtig zu bedenken, dass Airbnb gemäß den Nutzungsbedingungen das Scrapen seiner Website ohne deren ausdrückliche Erlaubnis verbietet. Die Verwendung automatisierter Scraping-Tools ohne Erlaubnis kann zur Blockierung Ihrer IP-Adresse oder Ihres Kontos führen. Um dies zu vermeiden, können Sie eine Scraping-API verwenden oder einen Proxy in Ihr Skript integrieren.

Eine weitere Herausforderung besteht darin, die Website-Struktur regelmäßig zu aktualisieren. Wenn Airbnb die Struktur seiner Website ändert, kann das Scraping unbrauchbar werden, da Ihre Skripte aufgrund von Änderungen im HTML- oder CSS-Markup möglicherweise nicht mehr funktionieren. In solchen Fällen sollten Sie Ihre Skripte aktualisieren, um sie an die neue Website-Struktur anzupassen.

Hier sind einige zusätzliche Punkte, die Sie berücksichtigen sollten:

- Verwenden Sie eine Scraping-API. Dies ist der sicherste und zuverlässigste Weg, Airbnb-Inserate zu durchsuchen.

- Verwenden Sie einen Proxy. Dies kann dazu beitragen, Ihre IP-Adresse zu verbergen und einer Erkennung durch Airbnb zu entgehen.

- BWir sind bereit, Ihre Skripte regelmäßig zu aktualisieren. Airbnb aktualisiert seine Website regelmäßig, daher müssen Sie darauf vorbereitet sein, Ihre Skripte entsprechend zu aktualisieren.

Wenn Sie diese Tipps befolgen, können Sie Airbnb-Daten sicher und effektiv scrapen.

Fazit und Erkenntnisse

Mit den Daten, die Sie über Web Scraping von Airbnb sammeln, können Sie den Immobilienmarkt effektiver analysieren. Sie können Ihre eigenen Preisvergleichsdienste oder Empfehlungssysteme erstellen und diese Daten in Ihren Marketingstrategien und Anzeigen verwenden. Unternehmen und Unternehmer können diese Daten beispielsweise für gezielte Marketing- und Werbekampagnen nutzen, die sich an Zielgruppen richten, die an der Vermietung von Immobilien interessiert sind.

In diesem Artikel haben wir den Prozess des Web-Scrapings von Daten des beliebten Online-Unterkunftsdienstes Airbnb besprochen und Beispiele für vorgefertigte Skripte bereitgestellt. Wir haben die Vor- und Nachteile des Data Scraping im Vergleich zur Verwendung von APIs besprochen. Wir haben auch alternative Methoden zur Datenbeschaffung untersucht, einschließlich der Verwendung der Airbnb-API und von Lösungen von Drittanbietern.

Wenn Sie diese Daten nicht mit Python sammeln möchten, eignen sich andere Programmiersprachen für Web Scraping. Beispielsweise können JavaScript (unter Verwendung der Puppeteer-Bibliothek), Ruby (unter Verwendung der Nokogiri-Bibliothek) und Go (unter Verwendung der Colly-Bibliothek) gute Alternativen sein. Darüber hinaus können Sie einen vorgefertigten No-Code-Scraper von Airbnb verwenden, der eine Benutzeroberfläche zum Scrapen von Daten ohne Codierung bietet.