Im digitalen Zeitalter ist es für Unternehmen, E-Commerce-Forscher und Entscheidungsträger von entscheidender Bedeutung, wertvolle Erkenntnisse aus den riesigen Datenmengen im Internet zu gewinnen. Web Scraping, das Extrahieren von Daten von Websites, ist seit einiger Zeit eine gängige Praxis.

In letzter Zeit hat der Einsatz von KI in verschiedenen Branchen an Bedeutung gewonnen und bestimmte Aktivitäten bereits verbessert und optimiert. In diesem Artikel wird erläutert, wie KI beim Web Scraping, bei der Datenverarbeitung und bei der Analyse eingesetzt werden kann.

Traditionelle Web-Scraping-Techniken

Wir haben dem Scraping bereits viele Artikel gewidmet, von Beschreibungen dessen, was es ist, bis hin zu Scraping-Anleitungen in verschiedenen Programmiersprachen. Unser Blog enthält Artikel zum Scraping in Python, NodeJS, C# und anderen Programmiersprachen und sogar zum Scraping von Websites mit Google Sheets.

Wenn Sie mehr über Web Scraping erfahren möchten und erfahren möchten, wie Sie Scraping-Skripte für jede Website schreiben, sei es Zillow, Amazon, Google Maps oder etwas anderes, empfehlen wir Ihnen, sich die detaillierten Tutorials in unserem Blog anzusehen.

Wie kann künstliche Intelligenz beim Web Scraping eingesetzt werden?

Zunächst wurden auf künstlicher Intelligenz basierende Programme und Tools nur von großen Unternehmen eingesetzt. Der Grund dafür war die große Menge an Webdaten, die verarbeitet werden musste – auch wenn dies mit einem hohen Preis verbunden war. Aber mit den Fortschritten in der KI und der Technologie des maschinellen Lernens sind diese KI-Tools für jedermann zugänglicher geworden.

Um die Vorteile des Einsatzes von KI besser zu verstehen, schauen wir uns an, in welchen Bereichen sie von Nutzen sein können und wie sie dort eingesetzt werden können.

Dies sind jedoch nur einige der Bereiche und Einsatzmöglichkeiten von KI. Lassen Sie uns also mehr darüber sprechen, wo und wie KI von Nutzen sein kann.

KI-Anwendungen im Web Scraping für verschiedene Bereiche

Es gibt kaum einen Bereich, in dem KI nicht eingesetzt werden kann. Überall dort, wo Daten vorhanden sind, kann der Einsatz solcher Modelle von Nutzen sein.

Allerdings gibt es einige Bereiche, in denen sie am häufigsten eingesetzt werden:

- E-Commerce und Einzelhandel.

- Gesundheitswesen und Medizin.

- Finanzen und Banken.

- Herstellung und Lieferkette.

- Vermarktung und Werbung.

- Transport und Logistik.

- Bildung und E-Learning.

- Data Mining.

- Verarbeitung natürlicher Sprache (NLP).

- Internet-Sicherheit.

Einer der Vorteile der KI besteht darin, dass sie mithilfe von maschinellem Lernen auf beliebigen Daten trainiert werden kann. Das heißt, es gibt keine Bereiche, in denen Daten unangemessen wären. Jeder kann ein eng fokussiertes Modell erstellen, wenn er über die wissenschaftliche Entwicklung oder sein Geschäft spricht.

Möglichkeiten zur Integration von KI in verschiedene Arbeitsabläufe

Wenn wir uns genauer ansehen, wie Künstliche Intelligenz (KI) eingesetzt werden kann, wird deutlich, dass KI sich hervorragend für die Datenverarbeitung und -analyse eignet. In sozialen Medien wie LinkedIn kann KI beispielsweise dabei helfen, Leads zu generieren, Werbekampagnen zu planen und Ihre Konkurrenten zu analysieren. Im Finanzwesen kann KI aktuelle Veränderungen erkennen und zusammenfassende Marktanalysen erstellen.

Aber wenn es speziell um E-Commerce-Unternehmen geht, sind diese Vorteile noch bedeutender. Mithilfe von KI können Sie überwachen, was Ihre Konkurrenten tun, aus ihren Erfolgen lernen, ihre Best Practices auf Ihre Geschäftsabläufe anwenden und vieles mehr.

Bei Entwicklungs- oder Wartungsaufgaben wie der Suche nach zuverlässigen Proxy-Servern für jede Website, dem Sammeln relevanter Links oder der Unterstützung bei Web-Scraping-Aktivitäten besteht kein Zweifel daran, dass KI auch hier etwas Wertvolles zu bieten hat.

KI-gestütztes Data Scraping in Aktion

Da hochwertige KI-Modelle erst vor relativ kurzer Zeit auf den Markt kamen, möchten die meisten Benutzer lernen, wie man sie verwendet oder welche Funktionen sie haben. Schauen wir uns also genau an, wie Sie KI-Modelle für Scraping und Datenverarbeitung nutzen können, welche Regeln Sie beachten müssen und mit welchen Einschränkungen Sie konfrontiert werden.

Bevor wir jedoch zu Beispielen für die Verwendung von KI zum Scrapen und Verarbeiten von Daten übergehen, schauen wir uns an, wie Sie Eingabeaufforderungen erstellen, damit das KI-Modell Sie versteht. Zunächst müssen Sie bedenken, dass die Qualität des Ergebnisses ganz von Ihnen und der Formulierung der Aufgabe abhängt.

Es lohnt sich auch anzugeben, dass Sie Sprach-KI-Modelle wie ChatGPT (OpenAI) für Scraping und Datenerfassung benötigen. Beachten Sie aus eigener Erfahrung folgende Regeln, um ein gutes Ergebnis zu erzielen:

- Teilen Sie dem Modell mit, dass Sie zusätzliche Parameter angeben werden. Das KI-Modell muss eingerichtet werden, bevor Sie es verwenden. Sie können sagen: „Jetzt lege ich Bedingungen fest, die für die weitere Datenverarbeitung erfüllt sein müssen.“

- Als nächstes legen Sie die Parameter fest. Das KI-Modell weiß nicht, wie es sich verhalten soll. Wenn Sie möchten, dass es sich anders als „Standard“ verhält, geben Sie dies in der Eingabeaufforderung an. Wenn Sie beispielsweise in der Antwort kein komplexes Vokabular verwenden möchten, können Sie Folgendes angeben: „Vermeiden Sie die Verwendung komplexer Vokabeln“ oder „Verwenden Sie natürliche Sprache.“

- Geben Sie den Stil oder die Person an, von der Sie eine Antwort erhalten möchten. Zum Beispiel „Als Entwickler fungieren“ oder „den offiziellen Stil verwenden“.

- Wenn Sie einen kleinen Text verfassen möchten, der Ihren Schreibstil verwendet, geben Sie der KI ein Beispiel Ihres Textes und bitten Sie sie, sich den Stil zu merken und ihn in Zukunft zu verwenden: „Hier ist ein Beispiel meines Textes. Das möchte ich.“ Verwenden Sie als nächstes den gleichen Stil.

Nachdem Sie nun wissen, wie Sie Eingabeaufforderungen für ein KI-Modell erstellen, schauen wir uns Optionen dafür an, was und wie sie beim Scraping und bei der Datenextraktion verwendet werden können.

Daten-Scraping und -Verarbeitung

Und das erste, wofür Sie das Sprach-KI-Modell verwenden können, ist die Verarbeitung und Analyse von Text. Mit einem KI-Sprachmodell können Sie nahezu jede Textverarbeitungsaufgabe lösen. Sie können die KI beispielsweise bitten, die gewünschten Schlüsselwörter in Ihren Text einzufügen oder Stoppwörter zu entfernen. Der größte Vorteil besteht jedoch darin, dass es dem Sprachmodell egal ist, ob Sie einfachen Text oder Text bereitstellen, der Hypertext-Markup-Sprache oder etwas anderes verwendet, sodass Sie ihn als Web-Scraping-Tool verwenden können.

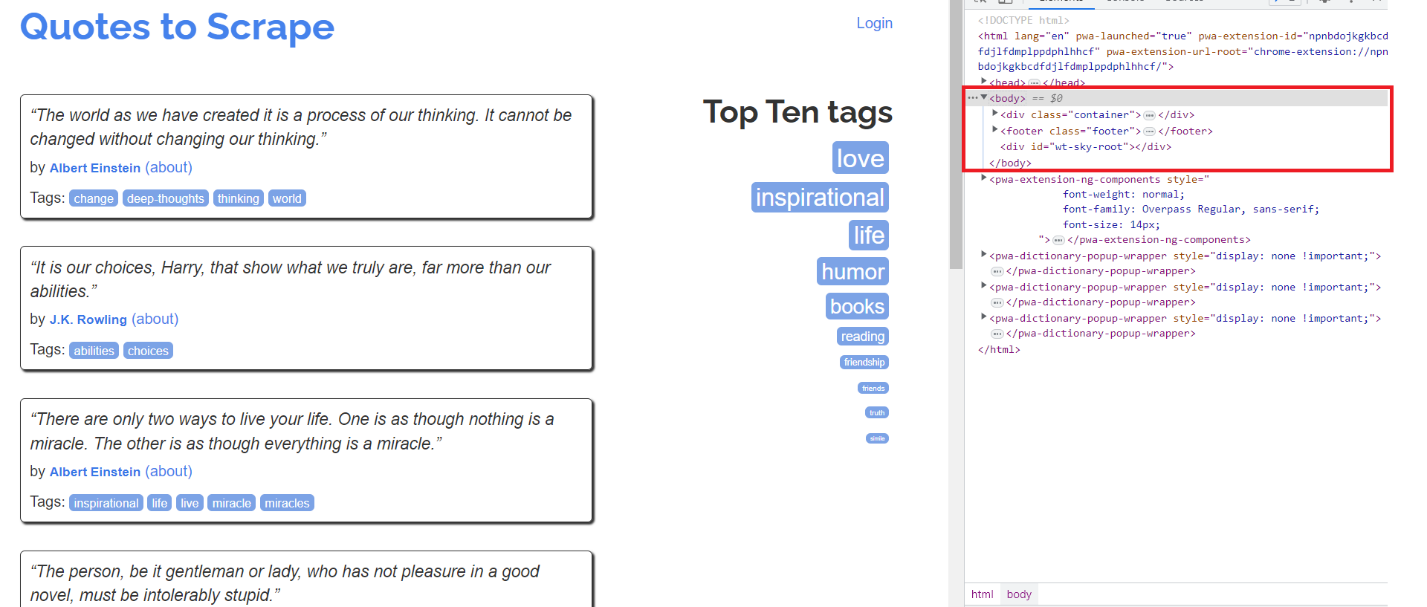

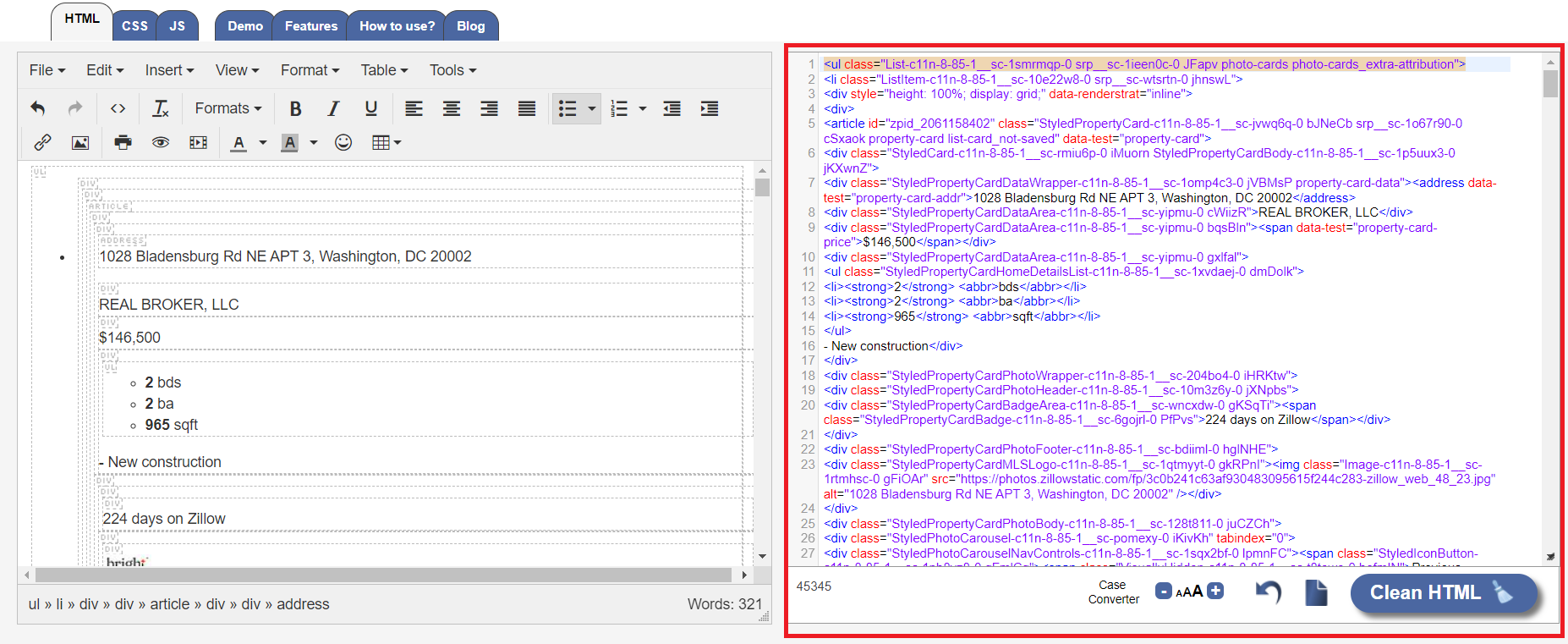

Mal sehen, wie das genutzt werden kann. Gehen wir zur Zitierseite und zu DevTools (drücken Sie F12). Alle Informationen auf der Seite werden auf allen Websites im Body-Tag angezeigt.

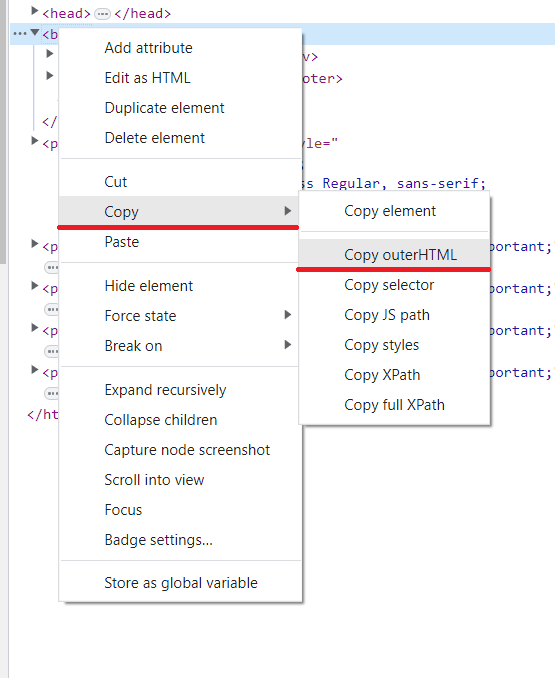

Um den Inhalt zu kopieren, klicken Sie mit der rechten Maustaste auf das Tag, dann „Kopieren“ und „outerHTML kopieren“.

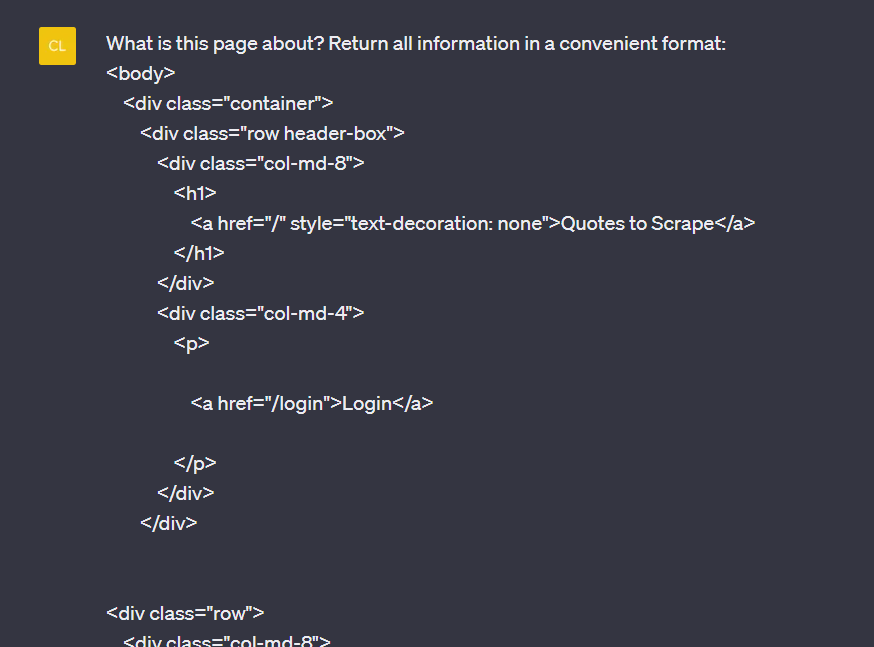

Gehen Sie dann zum Sprachmodell (wir verwenden ChatGPT) und bitten Sie um die Verarbeitung Ihrer Daten:

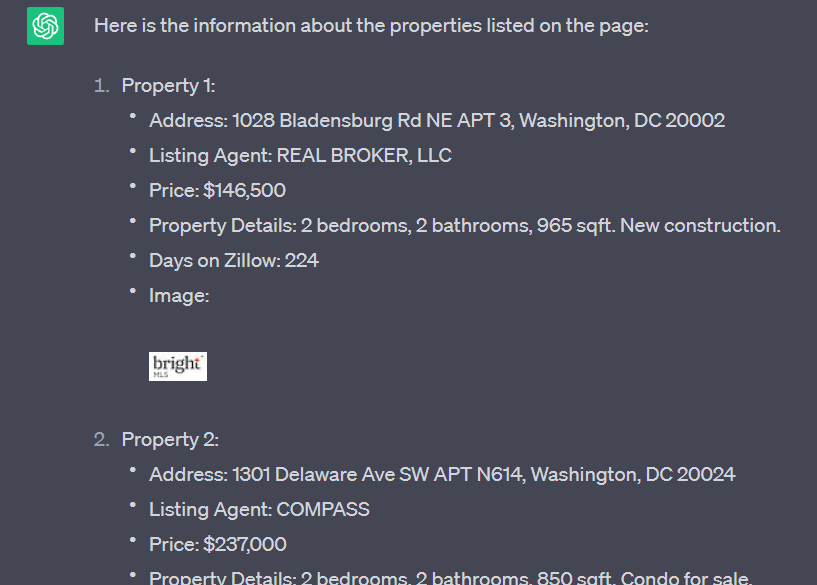

Als Ergebnis haben wir folgende Antwort erhalten, die wir im Folgenden präsentieren:

Wie Sie sehen, haben wir schnell die Informationen erhalten, die wir brauchten. Diese Methode weist jedoch viele Einschränkungen auf. Und einer davon ist die Länge der Abfrage. Solange der Seitencode klein ist, ist dies kein Problem. Wenn wir jedoch die Seite eines tatsächlichen Geschäfts verwenden und diese Methode verwenden, erhalten wir eine Fehlermeldung, die die Anzahl der Zeichen überschreitet.

Es gibt jedoch auch einen Weg, dies zu umgehen. Bei vielen Diensten können Sie die Struktur des HTML-Dokuments vorab verkleinern und unnötige Tags entfernen. Hierfür eignet sich beispielsweise der HTML-Cleaner.

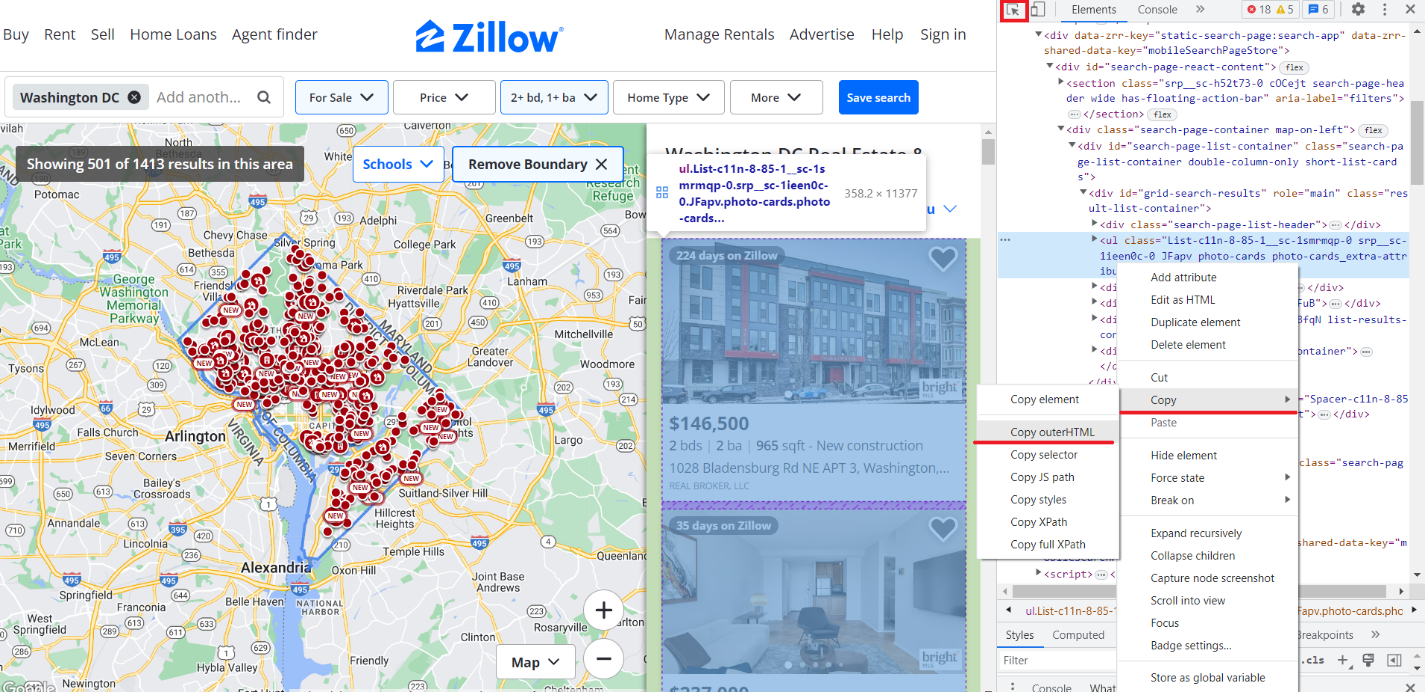

Mal sehen, wie es für Zillow aussehen würde. Wir haben bereits geschrieben, wie man Zillow in Python kratzt, und jetzt zeigen wir, wie man das mit dem Sprachmodell macht. Gehen Sie zur Site und legen Sie die erforderlichen Parameter fest, öffnen Sie dann DevTools und kopieren Sie den HTML-Code nur des Teils, der die Eigenschaftenliste enthält. Sie können zum Suchen den Zeiger (Strg+Umschalt+C) verwenden.

Gehen Sie dann zur HTML-Cleaner-Seite, um den Code zu bereinigen und ihn in das Codefeld einzufügen.

Bereinigen Sie den HTML-Code, kopieren Sie das Ergebnis, gehen Sie zu ChatGPT und führen Sie dieselbe Abfrage nach Anführungszeichen durch. Als Ergebnis erhalten wir das folgende Ergebnis einer solchen Datenextraktion:

So haben wir in wenigen Minuten und ohne großen Aufwand die Daten von der Seite zu allen Eigenschaften erhalten. Diese Methode hat mehrere Nachteile, auf die wir später noch eingehen werden.

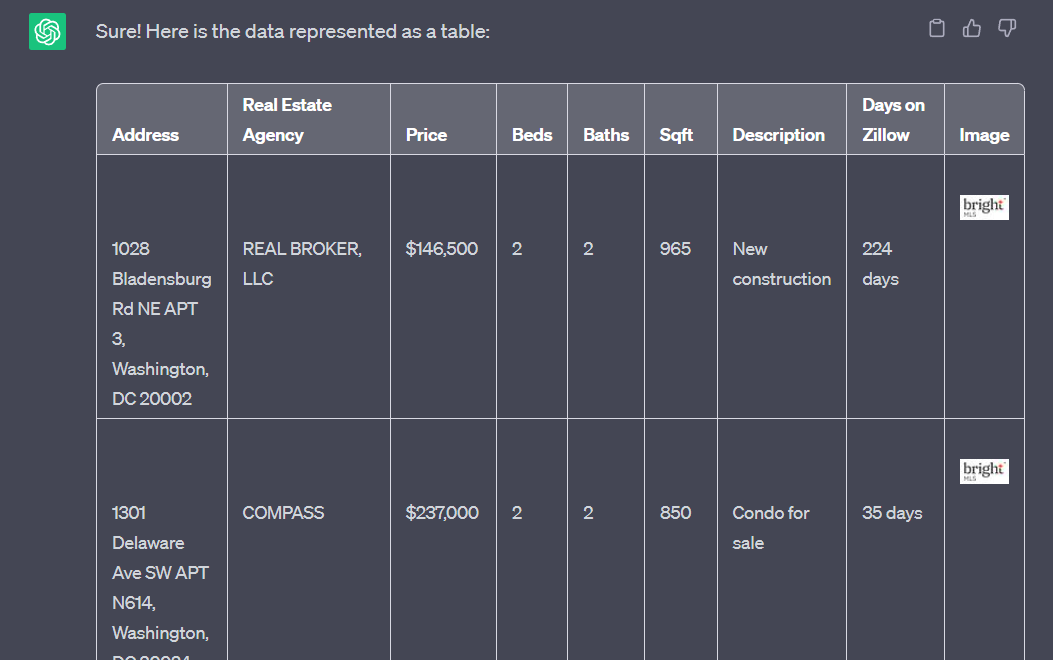

Datenvisualisierung

Hatten Sie schon einmal einen, bei dem Sie einen Text haben, ihn aber schnell auf einen Tisch legen müssen? Wenn ja, wissen Sie, dass KI helfen kann. Nehmen wir zunächst die zuvor bestellten Daten, die wir von Zillow erhalten haben, und bitten Sie darum, sie in Tabellenform an uns zurückzusenden:

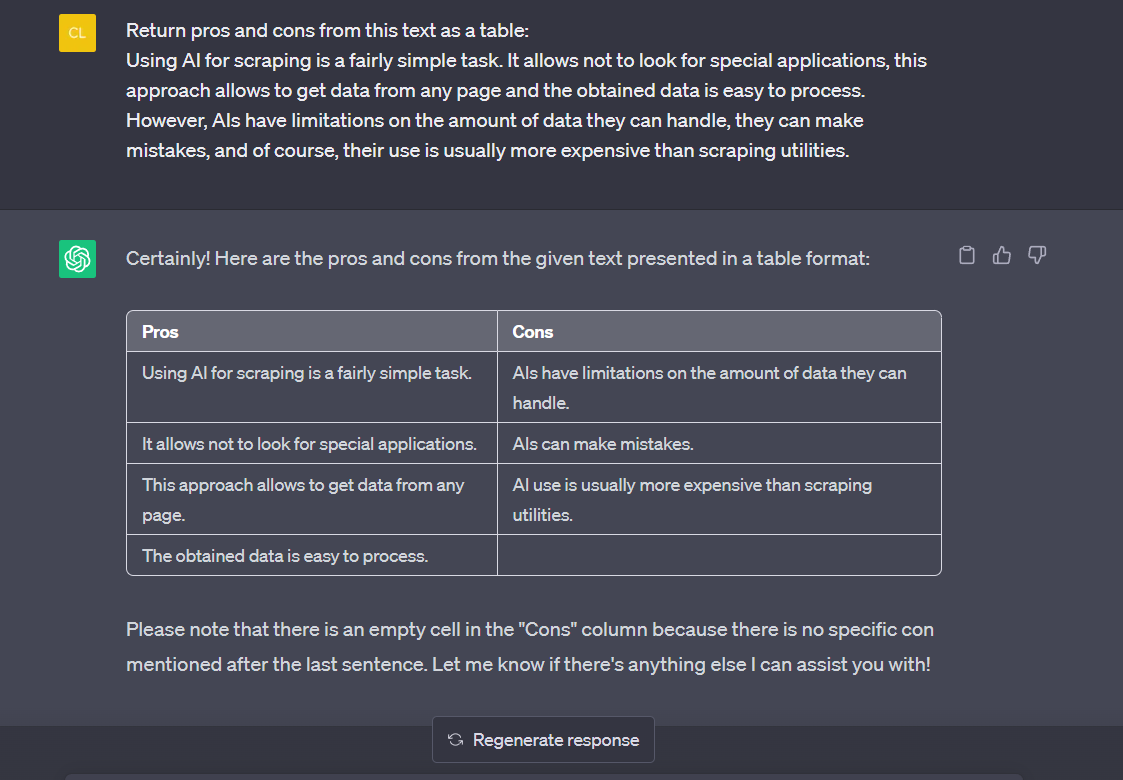

Aber es war einfach genug. Wir lieferten bereits strukturierte Daten, die einfach in eine Tabelle eingefügt werden konnten. Lassen Sie uns nun die Vor- und Nachteile der Verwendung von KI für das Scraping in Textform beschreiben und diese Daten in Tabellenform zurückfordern:

Wie Sie sehen, kann die KI auch dabei helfen.

Datenanalyse

Wie wir bereits gesehen haben, ist KI bei verschiedenen Textverarbeitungs-, Analyse- und anderen Aufgaben sehr gut.

Sie können ihm eine Reihe von Daten zur Verfügung stellen, die Ihnen bei der Analyse und beim Extrahieren von Informationen helfen. Unabhängig davon, ob Sie statistische Analysen durchführen, Visualisierungen erstellen oder Muster in Daten identifizieren müssen, kann es Ihnen bei verschiedenen Datenanalyseaufgaben helfen.

Mithilfe von KI können Sie wertvolle Einblicke in ein bestimmtes Produkt- oder Dienstleistungssegment gewinnen. Sie können feststellen, welche Produkte am beliebtesten sind, die leistungsstärksten Verkäufer identifizieren und erkennen, welche Produkte und Verkäufer geringere Umsätze erzielen. Wenn Sie diese Daten im Voraus verstehen, können Sie fundierte Entscheidungen zur Verbesserung Ihres Geschäfts treffen.

Außerdem kann KI Ihnen dabei helfen, Kundenfeedback schnell zu analysieren und so leichter zu erkennen, was ihnen gefällt und was nicht. Wenn Sie KI für Web Scraping verwenden, können Sie Einblicke in die Erfahrungen Ihrer Kunden gewinnen, die möglicherweise übersehen wurden. Sie können Muster in ihren Antworten erkennen und erfahren, wie Sie Ihre Dienstleistungen oder Produkte am besten verbessern können, um maximale Zufriedenheit zu erzielen.

Textklassifizierung

Das Sprachmodell kann Text in vordefinierte Kategorien oder Bezeichnungen klassifizieren. Dies kann für die Stimmungsanalyse, Themenklassifizierung, Spam-Erkennung oder Absichtserkennung nützlich sein.

Anerkennung benannter Entitäten (NER)

Mithilfe von KI lassen sich wesentliche Informationen aus Texten identifizieren und extrahieren. Diese Technologie ist hilfreich für Unternehmen, die die Seiten ihrer Konkurrenten analysieren möchten, und für Forscher, die nach kritischen Daten aus verschiedenen Quellen suchen. Benannte Entitäten wie Personennamen, Organisationsnamen, Standorte oder Daten können mithilfe von KI-Web-Scraping-Techniken identifiziert und extrahiert werden.

Stimmungsanalyse

Mithilfe von KI kann die Stimmung hinter dem Text ermittelt werden, beispielsweise aus Kundenrezensionen oder Social-Media-Beiträgen. Dies ist manuell viel schwieriger zu bewerkstelligen, als einfach die Bewertungen auf einer Marktplatz-Produktseite zu analysieren. Sprachmodelle kommen dieser Aufgabe zugute und liefern Erkenntnisse darüber, ob eine in Worten ausgedrückte Meinung positiv, negativ oder neutral ist.

Sprachübersetzung

Wir alle haben die Frustration der maschinellen Übersetzung erlebt – Wörter werden Wort für Wort übersetzt, der Kontext wird ignoriert und manchmal kann die Bedeutung verzerrt sein. Obwohl sich automatische Übersetzer in letzter Zeit verbessert haben, könnte KI eine zuverlässigere Lösung bieten.

KI-Modelle lernen aus zuvor gesammelten Daten in einer bestimmten Sprache und merken sich Muster und Standardphrasen, um die Bedeutung über einzelne Wörter hinaus zu interpretieren. Daher berücksichtigen Übersetzungen nicht nur wörtliche Definitionen, sondern berücksichtigen auch, wie sie in ihren breiteren Kontext passen, um eine bessere Genauigkeit zu erzielen.

Textgenerierung

KI ist mächtig, wenn es darum geht, Texte auf der Grundlage von Daten zu generieren. Angenommen, Sie haben eine Dienstleistung oder ein Produkt anzubieten. In diesem Fall kann Ihnen Web Scraping dabei helfen, Leads und Informationen von ihren Websites zu sammeln und diese Daten dann der KI zur Verfügung zu stellen, um die Erstellung maßgeschneiderter Briefe für jeden potenziellen Lead zu automatisieren. Sie können hochgradig personalisierte Angebote erstellen, die je nach Bedarf von Interesse und Nutzen sind – und das alles, ohne sie jemals handschriftlich verfassen zu müssen.

Scraping-Code-Generierung

Die Verwendung von ChatGPT zum Scraping kann eingeschränkt sein, aber die Verwendung von KI zum Erstellen von Scrapern oder Crawlern kann Ihnen dabei helfen, diese Einschränkungen zu überwinden. Möglicherweise benötigen Sie noch Hilfe bei anderen Problemen, z. B. beim Lösen von Captchas, der Verwendung von Proxys und der Vermeidung von Blockierungen oder JavaScript-Rendering. Glücklicherweise können verschiedene Anwendungsfälle, wie z. B. die Web-Scraping-API, Ihre Aufgaben erleichtern und zuverlässige Ergebnisse liefern.

Wir können zum Beispiel diese Eingabeaufforderung verwenden:

Write a scraper on Python to get data and save it to a table from the website quotes.toscrape.com with this structure:

<body>…</body>Das Ergebnis wird folgender Scraper sein, den wir, wie unsere Tests zeigen, sofort speichern und verwenden können:

import requests

from bs4 import BeautifulSoup

import pandas as pd

# Send a GET request to the website

url="http://quotes.toscrape.com"

response = requests.get(url)

# Create a BeautifulSoup object

soup = BeautifulSoup(response.text, 'html.parser')

# Find all the quote elements

quote_elements = soup.find_all('div', class_='quote')

# Initialize lists to store the extracted data

quotes = ()

authors = ()

tags = ()

# Extract data from each quote element

for quote in quote_elements:

# Extract the quote text

quote_text = quote.find('span', class_='text').text

quotes.append(quote_text)

# Extract the author name

author_name = quote.find('small', class_='author').text

authors.append(author_name)

# Extract the tags

tag_elements = quote.find_all('a', class_='tag')

tag_list = (tag.text for tag in tag_elements)

tags.append(tag_list)

# Create a DataFrame from the extracted data

data = {'Quote': quotes, 'Author': authors, 'Tags': tags}

df = pd.DataFrame(data)

# Save the DataFrame to a CSV file

df.to_csv('quotes.csv', index=False)Machen wir die gleiche Eingabeaufforderung, nur dass wir NodeJS anstelle von Python verwenden:

const axios = require('axios');

const cheerio = require('cheerio');

const fs = require('fs');

const ObjectsToCsv = require('objects-to-csv');

// Send a GET request to the website

const url="http://quotes.toscrape.com";

axios.get(url)

.then(response => {

// Load the HTML response into Cheerio

const $ = cheerio.load(response.data);

// Find all the quote elements

const quoteElements = $('.quote');

// Initialize arrays to store the extracted data

const quotes = ();

const authors = ();

const tags = ();

// Extract data from each quote element

quoteElements.each((index, element) => {

const quoteElement = $(element);

// Extract the quote text

const quoteText = quoteElement.find('.text').text().trim();

quotes.push(quoteText);

// Extract the author name

const authorName = quoteElement.find('.author').text().trim();

authors.push(authorName);

// Extract the tags

const tagElements = quoteElement.find('.tag');

const tagList = tagElements.toArray().map(tag => $(tag).text().trim());

tags.push(tagList);

});

// Create an array of objects with the extracted data

const data = quotes.map((quote, index) => {

return {

Quote: quote,

Author: authors(index),

Tags: tags(index)

};

});

// Convert the data array to CSV format

const csv = new ObjectsToCsv(data);

// Save the CSV file

csv.toDisk('quotes.csv', { append: false })

.then(() => {

console.log('Data successfully saved to quotes.csv');

})

.catch(err => {

console.error('Error saving data to quotes.csv:', err);

});

})

.catch(error => {

console.error('Error retrieving data:', error);

});Und für das letzte Beispiel verwenden wir die Programmiersprache R:

library(rvest)

library(writexl)

# Specify the URL of the website

url <- "http://quotes.toscrape.com"

# Send a GET request to the website and read the HTML content

page <- read_html(url)

# Extract the quote elements using CSS selectors

quote_elements <- page %>% html_nodes(".quote")

# Initialize empty vectors to store the extracted data

quotes <- character()

authors <- character()

tags <- list()

# Extract data from each quote element

for (quote_element in quote_elements) {

# Extract the quote text

quote <- quote_element %>% html_node(".text") %>% html_text() %>% trimws()

quotes <- c(quotes, quote)

# Extract the author name

author <- quote_element %>% html_node(".author") %>% html_text() %>% trimws()

authors <- c(authors, author)

# Extract the tags

tag_nodes <- quote_element %>% html_nodes(".tag")

tag_list <- tag_nodes %>% html_text() %>% trimws()

tags <- c(tags, list(tag_list))

}

# Create a data frame with the extracted data

data <- data.frame(Quote = quotes, Author = authors, Tags = tags, stringsAsFactors = FALSE)

# Specify the output file path

output_file <- "quotes.xlsx"

# Save the data frame to an Excel file

write_xlsx(data, path = output_file)

# Print a success message

cat("Data successfully saved to", output_file, "\n")

Wie wir sehen, können wir jede Programmiersprache verwenden und müssen lediglich die Umgebung richtig einrichten und vorbereiten.

Textzusammenfassung

KI ist auch ein großartiges Werkzeug, um lange Texte zu sichten und schnell zusammenzufassen. Wenn Sie beispielsweise eine Liste potenzieller Leads zusammengestellt haben, sich aber nicht sicher sind, welche an Ihrem Angebot interessiert sein könnten oder am besten zu Ihrem Unternehmen passen, kann KI helfen, indem sie große Mengen an Inhalten in kleineren Zusammenfassungen zusammenfasst, die das erfassen Kernpunkte und wesentliche Details.

Beantwortung von Fragen

Sie können nicht nur vorgefertigte Sprachmodelle verwenden. Mit Hilfe von maschinellem Lernen können Sie Ihre eigenen, auf Ihre Bedürfnisse zugeschnittenen Datensätze erstellen. Wenn Sie beispielsweise ein Unternehmen leiten und die Arbeitsbelastung der Mitarbeiter im technischen Support verringern möchten, könnte künstliche Intelligenz genau das Richtige für Sie sein.

Um ein effektives Modell für diesen Zweck zu trainieren, füttern Sie es einfach mit sachlichen Benutzeranfragen und Antworten von Personen in Kundendienstfunktionen. Sobald genügend Daten gesammelt und von KI-Algorithmen verarbeitet werden. Sie verfügen über ein leistungsstarkes Tool, mit dem Sie die meisten Fragen zu Ihrem Produkt schnell und genau beantworten können.

Datengesteuerte Entscheidungsfindung

Wenn Sie vor komplexen Entscheidungen stehen, können Sie Ihr Problem mit KI besprechen. Die KI kann Ihnen dabei helfen, verfügbare Daten zu analysieren, Erkenntnisse zu gewinnen und auf der Grundlage der bereitgestellten Informationen mögliche Vorgehensweisen vorzuschlagen.

Dies bedeutet jedoch nicht, dass Sie sich bei der Entscheidungsfindung ausschließlich auf die KI verlassen müssen. Es kann nur helfen und Optionen vorschlagen, aber Sie müssen entscheiden.

Herausforderungen beim Einsatz von KI

Web Scraping kann einige Herausforderungen mit sich bringen, vor allem wenn Sie für die Arbeit künstliche Intelligenz (KI) einsetzen. KI-Lösungen sind leistungsstarke Werkzeuge, deren Erfolg sorgfältig überlegt und umgesetzt werden muss. Abhängig von der Komplexität Ihrer Web-Scraping-Aufgabe bietet KI möglicherweise nur manchmal eine optimale Lösung und kann einige Herausforderungen mit sich bringen.

Längenbeschränkungen

Das erste Problem, mit dem Sie konfrontiert werden müssen, wenn Sie KI zum Verarbeiten oder Scrapen von Daten verwenden, ist die Beschränkung der Abfragelänge. Das beliebteste GPT-3.5-Modell hat beispielsweise ein maximales Token-Limit von 4096 Token pro Eingabe. Die Länge der Token variiert, im Durchschnitt entsprechen sie jedoch Wörtern oder Zeichen. Es ist wichtig zu beachten, dass die Eingabe, wenn sie diesen Token-Grenzwert überschreitet, gekürzt oder gekürzt werden muss, damit sie den Einschränkungen entspricht.

Preis

Werfen wir einen Blick auf die Verwendung der ChatGPT-API und der Scrape-It.Cloud-Web-Scraping-API, um herauszufinden, welche für das Scraping rentabler ist.

Werfen Sie zunächst einen Blick auf diese Forschung. Es untersuchte über eine Milliarde Webseiten und kam zu dem Schluss, dass die durchschnittliche Webseite 2 MB wiegt. Das heißt, 1 Zeichen ist 1 Byte. Wenn eine Webseite also 2 MB wiegt, enthält sie 1.048.576 Zeichen oder 157.286 Token.

Durch spezielle Dienste werden die Daten auf das für die Seitenverarbeitung in ChatGPT zulässige Maximum reduziert. In unserem Fall sind es nicht mehr als 4096 Token. Der Preis für 1000 Token beträgt 0,002 $. Das heißt, für das Scraping einer Seite verwenden wir 0,008 $.

Schauen wir uns nun den Preisplan für die Web-Scraping-API an. Die niedrigsten Kosten für einen Einzelplan betragen 30 US-Dollar pro Monat. Es umfasst 50.000 Credits oder 5.000 Anfragen. Vergleichen wir die Verwendung der Web-Scraping-API und der KI für Web-Scraping:

|

Name |

Startpreis |

Preis für 5.000 Anfragen |

|---|---|---|

|

Scrape-It.Cloud Web Scraping API |

30 $ pro 1 Monat |

30 $ |

|

ChatGPT-API |

5 $ pro 3 Monate |

40 $ |

Als Ergebnis unserer Tests haben wir jedoch festgestellt, dass Sie mit ChatGPT nicht in der Lage sein werden, Daten von allen Seiten abzurufen, da nicht alle Seiten auf die erforderliche Größe verkleinert werden können.

Arbeiten Sie mit externen Ressourcen

Leider ist KI-Webscraping nicht so einfach wie die einfache Eingabe eines Links. Sie müssen die Seitenstruktur berücksichtigen, die Sie durchsuchen möchten, und diese Informationen bereitstellen. Wenn Sie außerdem nach Daten suchen, die nach dem Trainingsdatum Ihres KI-Modells erstellt wurden, kann Ihnen das hier nicht weiterhelfen.

KI kann falsch liegen

KI kann auf der Grundlage der Trainingsdaten Antworten generieren, aber im Gegensatz zu Menschen kann KI nicht kritisch denken. Das bedeutet, dass die KI selbst dann, wenn ihre Antwort falsch ist, immer noch sehr zuversichtlich sein kann, was ihre Antwort angeht.

Fazit und Erkenntnisse

Unsere Ergebnisse zeigen, dass der Einsatz von KI für den Umgang mit Daten hilfreich sein kann. Solche Modelle leisten hervorragende Analyse- und Verarbeitungsunterstützung. Allerdings kann KI nur als Hilfsmittel eingesetzt werden, das auch der menschlichen Kontrolle bedarf.

KI-Modelle können durch komplexe Website-Strukturen navigieren, unstrukturierte Daten interpretieren und sich im Laufe der Zeit an Website-Änderungen anpassen. Mit ihrer Fähigkeit, große Datenmengen zu erlernen und zu verallgemeinern, öffnet KI die Tür für genauere, effizientere und skalierbarere Web-Scraping-Techniken.

Es eignet sich aber auch nicht für das Scraping großer Seiten, kann falsche Entscheidungen treffen, wenn es auf fragwürdigen Daten basiert, und weist mehrere Einschränkungen auf.