Pengikisan layar seharusnya mudah. Namun, seringkali tidak demikian. Jika Anda pernah menggunakan perangkat lunak ekstraksi data dan kemudian menghabiskan satu jam mempelajari/mengonfigurasi XPath dan RegEx, Anda pasti tahu betapa menjengkelkannya web scraping. Pengikisan web dapat.

Bahkan jika Anda berhasil mendapatkan datanya, akan memakan waktu lebih lama untuk menyusunnya dibandingkan membuat screen scraper berfungsi.

Ini adalah komunikasi ad hoc dan informasi yang secara inheren semi-terstruktur di web dan aturan terkait yang masih membuat web scraping, bisa kita katakan, sebagai “pengalaman yang kurang menyenangkan”.

Statistik pengikisan layar

Menurut sampel 20.000 proyek baru dibuat di Grepsr, sebanyak 45 % tidak berhasil diselesaikan.

Masalahnya bukan karena orang-orang tidak memahami produk Grepsr atau cara kerjanya. Mereka hanya ingin mendapatkan datanya terlebih dahulu dan kemudian memikirkan bagaimana menyusunnya atau membuatnya dapat digunakan. Hal ini mengakibatkan penundaan, peningkatan biaya, kesalahan migrasi data, dan masalah lainnya.

Bagaimana jika kita membalikkan masalahnyadan lebih tepatnya bertanya: Bagaimana ciri-ciri dari 55 proyek % yang berhasil diselesaikan dan bagaimana prosesnya?

Sekarang Anda mungkin sudah bisa menebak apa yang sedang kami maksud.

Ruang lingkup proyek. Dari 55 proyek % yang diselesaikan, hampir semuanya memiliki persyaratan yang jelas – baik input maupun outputnya.

Keuntungan merencanakan ruang lingkup proyek secara menyeluruh terlebih dahulu adalah hasil akhirnya seringkali jauh lebih baik. Karena ekspektasi – baik Anda maupun penyedia layanan – diklarifikasi dengan jelas dan sejak dini, sebelum pekerjaan selesai.

Biasanya ini adalah dokumen teks, sering disebut sebagai “ Deskripsi Proyekadalah salah satu komponen inti dari proyek yang sukses. Memilikinya sejak awal mungkin adalah hal paling penting yang dapat Anda lakukan untuk memastikan proyek web scraping Anda berjalan dengan lancar.

Pertanyaan kunci

Dengan mengingat hal itu, mari kita langsung ke inti tulisan ini.

Berikut empat pertanyaan penting untuk ditanyakan pada diri Anda saat merencanakan proyek web scraping Anda berikutnya:

- Apa kasus penggunaan bisnis di balik proyek ini? Apakah Anda memiliki persyaratan yang jelas?

- Sudahkah Anda mengidentifikasi sumber data utama dan kolom data target yang diperlukan?

- Apakah ini proses yang berkesinambungan atau hanya terjadi satu kali saja? Siapa yang akan melakukan perpindahan data dan bagaimana caranya? Bisakah itu diotomatisasi?

- Apakah ada persyaratan untuk membersihkan data, menjalankan aturan pada data sumber, atau pada data setelah dimuat ke sistem target?

Mari kita lihat masing-masing secara detail.

Apa kasus penggunaan bisnis di balik proyek ini? Apakah Anda memiliki persyaratan yang jelas?

Kami telah melihat perusahaan menyadari manfaat terbesar dari proyek data web ketika mereka memulai dengan tantangan dan sasaran bisnis, lalu dengan cepat mempersempitnya ke persyaratan yang jelas.

Di Grepsr kami membuat jenis kasus penggunaan bisnis berikut:

- Jalur yang lebih cepat menuju ROI dengan teknologi dan layanan

- Kemampuan untuk menunjukkan nilai dibandingkan sistem lokal

- Skalabilitas ke lebih banyak sumber data dan kasus penggunaan

Sasarannya mungkin jelas, tapi bagaimana Anda tahu kalau Anda sudah mencapainya? Penting untuk menentukan keberhasilan proyek data web Anda sebelum melanjutkan.

Di sinilah pentingnya mendefinisikan persyaratan dengan jelas.

Bayangkan jika ini bukan sekadar mendapatkan data baru dari sumber data. Namun data tersebut harus memenuhi kriteria tertentu - seperti apakah data tersebut sudah ada di sistem Anda atau belum, menggabungkan kolom yang diperlukan, dan terakhir mengatur data agar mengalir dengan lancar ke sistem Anda.

Salah satu pelanggan kami memiliki persyaratan serupa. Mereka menyadari sejak awal bahwa mereka memerlukan penyedia ekstraksi data yang dapat mengotomatiskan setiap langkah proses mulai dari pengambilan data baru hingga masuk ke sistem mereka (dan segala sesuatu di antaranya).

Dari perspektif perayapan, sepertinya banyak penyedia web scraping menawarkan layanan serupa untuk merayapi situs web, dan sepertinya penyedia tertentu tidak dapat melakukan sesuatu yang tidak dapat dilakukan oleh penyedia lain.

John MacDonald

Dengan persyaratan yang jelas, pelanggan kami menyadari bahwa mereka memerlukan fungsionalitas out-of-the-box yang tidak hanya melampaui apa yang ditawarkan di pasar.

Anda dapat membaca lebih lanjut tentang kisahnya di sini.

Sudahkah Anda mengidentifikasi sumber data utama dan kolom data target yang diperlukan?

Fase pertama dari proyek ekstraksi data web adalah ini Identifikasi dan jelajahi sistem sumber. Cara yang paling tepat untuk mengidentifikasi adalah dengan mengelompokkan data berdasarkan bidang data target.

Untuk proyek pengikisan layar pembuatan prospek, CRM Anda adalah sistem targetnya. Mengelompokkan data berdasarkan perusahaan, kontak, peran, dan informasi penting lainnya yang dapat diimpor ke CRM Anda adalah bidang data target Anda.

Pada tahap ini penting untuk menentukan data apa saja yang diperlukan dan di mana lokasinya, serta data apa saja yang redundan dan tidak diperlukan.

Sebaliknya, kesenjangan teridentifikasi jika sumber yang diidentifikasi pada awalnya tidak memuat semua data yang diperlukan untuk bidang data target. Dalam hal ini, Anda mungkin perlu menggabungkan data dari berbagai sumber untuk membuat kumpulan data dengan kumpulan data yang benar dan memenuhi kebutuhan sistem target.

Menggunakan beberapa sumber data Memungkinkan Anda menambahkan elemen lain Validasi data dan tingkat kepercayaan tertentu pada data Anda.

Pada akhir fase ini, Anda akan mengidentifikasi istilah pencarian, URL spesifik, dan halaman dalam sistem sumber ini dan mendokumentasikannya. Anda juga telah mengidentifikasi kesenjangan dalam data dan, jika memungkinkan, menyertakan sumber tambahan sebagai kompensasi.

Idealnya, Anda telah membagi data ke dalam kategori yang memungkinkan Anda mengerjakan tugas paralel yang dapat dikelola dan mungkin dilakukan.

Pertimbangkan hal berikut: Anda mungkin tidak membutuhkannya semuanya.

Seringkali naluri pertama adalah mengumpulkan data dalam jumlah besar dengan frekuensi tinggi, sementara kumpulan data sampel yang dibangun dengan baik mungkin merupakan satu-satunya hal yang Anda perlukan untuk menghasilkan wawasan yang dapat ditindaklanjuti.

Apakah ini proses yang berkesinambungan atau hanya terjadi satu kali saja? Siapa yang akan melakukan perpindahan data dan bagaimana caranya? Bisakah itu diotomatisasi?

Pilihan antara pengikisan layar berkelanjutan atau pengikisan data satu kali bergantung pada kasus penggunaan. Misalnya, goresan satu kali dapat digunakan untuk tujuan penelitian atau akademis – Ambil data, visualisasikan atau buat laporan, selesai!

Di sisi lain, kasus penggunaan continuous scrape dapat berupa mengotomatisasi dan memajukan bagian alur kerja atau aplikasi proses bisnis. Pertimbangkan proyek pemantauan harga di mana penting untuk menerima data langsung secara berkala untuk analisis dan perbandingan.

Idealnya, demo atau tur platform penyedia layanan Anda adalah awal yang baik. Yang harus Anda perhatikan adalah kemampuannya untuk mengotomatiskan perayapan yang sedang berlangsung Dan Mempersingkat proses pengumpulan data.

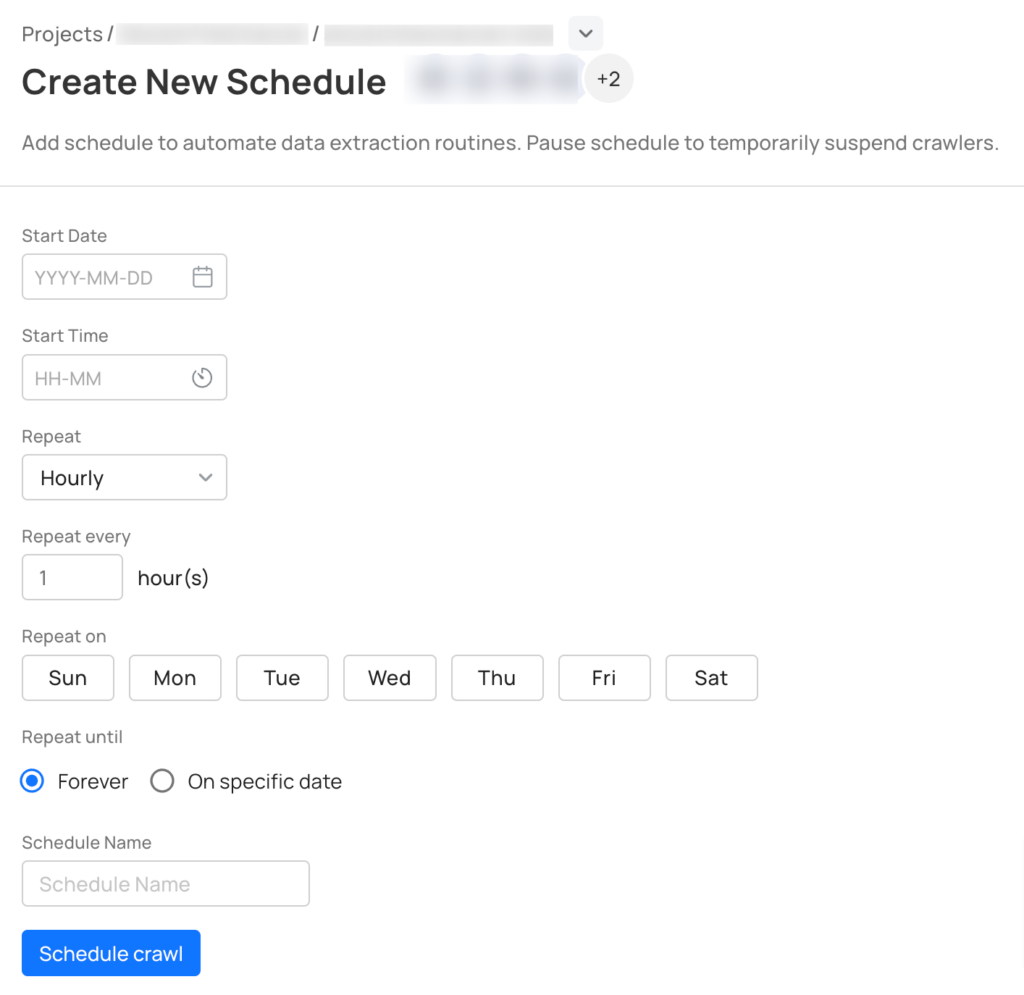

Di Grepsr kami menawarkan a Fungsi perencanaan Hal ini memungkinkan Anda mengantri perayapan terlebih dahulu, sama seperti Anda menjadwalkan rapat yang sedang berlangsung di Google Kalender Anda.

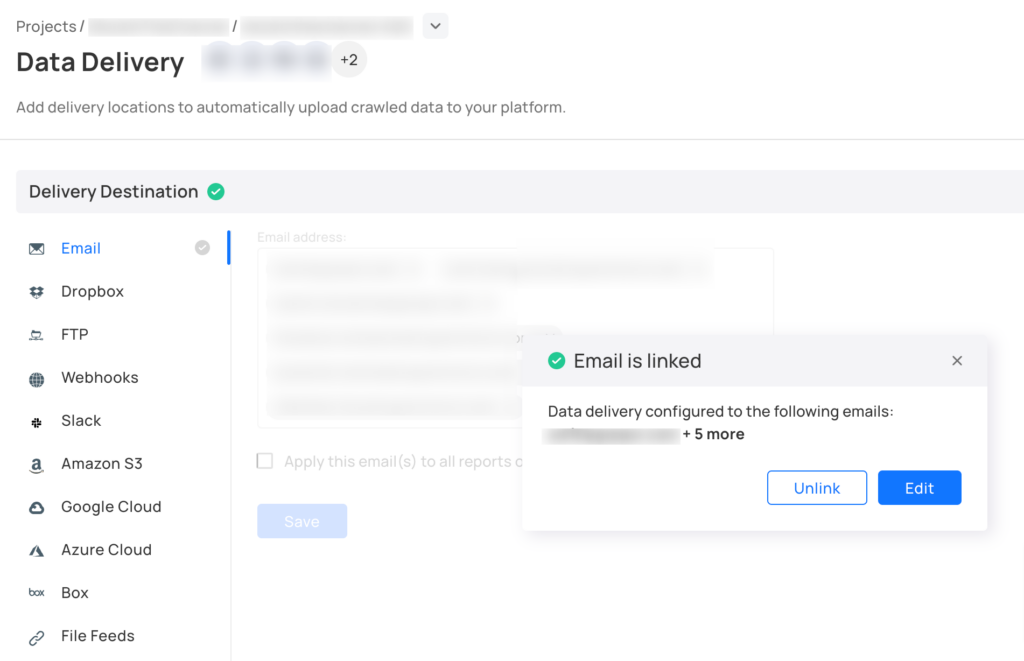

Dan setelah data lengkap diambil, sistem kami akan mengirimkan notifikasi untuk mendownload file. Alternatifnya, Anda dapat dengan mudah mentransfer data ke sistem Anda hampir secara real-time menggunakan alat canggih kami Lebah. Selain itu, Anda dapat menggunakan konektor data siap pakai kami dengan alat bisnis Anda sehari-hari.

Apakah ada persyaratan untuk membersihkan data, menjalankan aturan pada data sumber, atau pada data setelah dimuat ke target?

Sebagian besar proyek pengikisan layar gagal atau tertunda karena pertimbangan struktur data atau format keluaran selanjutnya. Memang benar, karena pertama-tama kami ingin mendapatkan datanya dan kemudian berpikir untuk membuatnya dapat digunakan.

Kami melakukan proyek beberapa bulan yang lalu di mana pelanggan lupa menyebutkan bahwa "alamat" yang dikembalikan harus sesuai dengan standarisasi alamat USPS, jika tidak, sistem mereka tidak akan mengimpor data. Terakhir, kami harus menggunakan API verifikasi alamat USPS, yang menyebabkan perubahan dalam anggaran proyek dan mengakibatkan penundaan.

Pada tahap ini, penting bagi Anda dan tim Anda untuk mengajukan pertanyaan seperti: Di mana datanya berakhir? Di spreadsheet, database, atau aplikasi analitik? Apakah pembersihan data diperlukan?

Coba kunci skema data terlebih dahulu. Jangan hanya fokus untuk mendapatkan data tanpa memikirkan struktur dan format yang perlu ada untuk integritas dan penyerapan data.

Diploma

Saat pertama kali memulai screen scraping, Anda sering kali harus terburu-buru memasukkan data ke dalam sistem agar Anda dapat menggunakannya. Keinginan untuk menggunakan data sangat besar, tetapi saya harap posting ini memberi Anda cukup alasan untuk meluangkan waktu sejenak untuk mempertimbangkan semua faktor yang diperlukan dan mempertimbangkan pentingnya menentukan ruang lingkup proyek scraping Anda pada tahap awal.