Apa itu API Pengikisan?

Scraping API adalah penyedia layanan web scraping yang membantu web scraping menghindari pemblokiran dengan melewati berbagai teknik anti-scraping yang diperkenalkan oleh situs web. Mereka menggunakan rotasi IP, penyelesaian CAPTCHA, dan teknik internal lainnya untuk memastikan bahwa halaman yang Anda minta diunduh untuk Anda.

Menggunakan API web scraping semudah mengirim permintaan API, terutama dengan ScraperAPI. Mereka dapat memproses data dalam jumlah besar dengan cepat dan efisien, memastikan Anda mendapatkan informasi yang Anda perlukan tanpa intervensi manual.

Fleksibilitasnya juga berarti mendukung bahasa pemrograman yang berbeda dan dapat dengan mudah diintegrasikan ke dalam alur kerja yang ada, memungkinkan Anda mengekstrak data dari situs web dengan mudah tanpa mengganggu proses yang ada.

7 Kasus Penggunaan untuk Web Scraping dalam SEO

Memperoleh data mesin pencari terkini sangat penting untuk inisiatif SEO. Ini menjadi dasar untuk memahami peringkat dan secara pragmatis dan efektif meningkatkan visibilitas merek di mesin pencari.

Mari kita lihat beberapa kasus penggunaan teratas dari SEO scraping:

1. Mengotomatiskan penelitian dan pemantauan kata kunci

Riset kata kunci adalah tulang punggung strategi SEO apa pun, jadi perhatian harus diberikan pada pemilihan dan kinerja kata kunci. Pengikisan SEO memungkinkan bisnis untuk mengotomatiskan proses pengumpulan peringkat kata kunci dan memantaunya dari waktu ke waktu. Hal ini menghemat waktu dan memberikan wawasan waktu nyata mengenai kinerja kata kunci berbagai pelanggan.

Di luar pelacakan kata kunci sederhana bisa Pengikisan web memungkinkan teknik yang lebih maju seperti analisis TF-IDF (Term Frekuensi-Invers Dokumen Frekuensi), yang mengukur seberapa sering sebuah kata muncul dalam dokumen relatif terhadap kelangkaannya dalam kumpulan data yang besar, membantu mengidentifikasi istilah-istilah penting dalam kumpulan konten .

Dengan mengintegrasikan model TF-IDF dengan data yang diambil, perusahaan dapat menyempurnakan strategi kata kunci mereka melampaui apa yang ditawarkan alat standar, sehingga mencapai pengoptimalan yang lebih efektif.

Jika Anda tidak tahu harus mulai dari mana, berikut beberapa panduan kami tentang riset kata kunci menggunakan web scraping:

2. Mengumpulkan data iklan dari kompetitor

Pengikisan web SEO memungkinkan Anda mengumpulkan data berharga tentang strategi periklanan pesaing. Informasi ini dapat membantu Anda memahami strategi SEO Anda dan mengidentifikasi kata kunci potensial untuk ditargetkan. Hal ini memungkinkan perusahaan untuk menyempurnakan strategi mereka dan mengidentifikasi peluang baru.

Ini akan membantu Anda melihat apakah pesaing Anda membeli iklan untuk kata kunci yang Anda minati, atau apakah peringkat mereka lebih tinggi secara organik - artinya mereka mendapatkan lebih banyak lalu lintas atau menyediakan (lebih banyak) konten berkualitas tinggi dari waktu ke waktu.

Dengan mengumpulkan data iklan pesaing, perusahaan dapat:

- Perkirakan investasi PPC pesaing berdasarkan frekuensi iklan di SERP: Hal ini membantu memprediksi anggaran, merencanakan strategi kompetitif, dan membenarkan usulan pengeluaran iklan kepada pelanggan atau pemangku kepentingan.

- Identifikasi dan analisis halaman arahan pesaing dengan mengikuti tautan iklan mereka: Dengan mengekstrak informasi iklan dan mengikuti setiap tautan iklan, Anda dapat menganalisis judul, konten, deskripsi meta, judul, gambar, dan video laman landas. Ini memberikan gambaran komprehensif tentang kampanye PPC Anda dan membantu Anda menemukan kesenjangan dalam pemasaran Anda, menghasilkan ide konten, dan mengembangkan saluran yang efektif untuk kampanye Anda.

- Cari tahu siapa pesaing utama Anda untuk kata kunci tertentu: Pesaing terkenal Anda bukanlah satu-satunya yang berinvestasi di PPC. Dengan mengumpulkan data iklan dalam skala besar, Anda dapat dengan cepat mengidentifikasi perusahaan lain yang bersaing untuk kata kunci yang sama. Hal ini sangat berguna ketika memasuki pasar geografis baru.

Dengan menggunakan data SEO, startup dapat membuat keputusan yang tepat mengenai penargetan kata kunci, penganggaran iklan, dan strategi PPC secara keseluruhan, yang pada akhirnya menghasilkan kampanye yang lebih efektif untuk klien mereka.

Untuk memulai, baca panduan kami untuk membaca iklan pesaing dan data konten dari Google Penelusuran.

3. Pantau cuplikan SERP

Fitur SERP adalah elemen unik pada halaman hasil pencarian Google yang melampaui listingan organik tradisional. Fitur-fitur ini dapat berdampak signifikan terhadap visibilitas situs web dan rasio klik-tayang. Oleh karena itu, Anda dapat mengoptimalkan konten Anda untuk visibilitas dan keterlibatan yang lebih baik dengan memantau cuplikan SERP.

Fitur SERP utama yang harus dipantau meliputi:

- Kutipan yang dipilih: Jawaban ringkas muncul di bagian atas hasil organik (posisi 0). Ini diambil dari situs web yang relevan dan dapat menghasilkan lalu lintas yang signifikan.

- Orang-orang juga bertanya: Pertanyaan dan jawaban terkait muncul di bawah hasil pencarian utama.

- Panel pengetahuan: Kotak informasi tentang entitas seperti orang, tempat, dan benda.

- Korsel video: Memutar kumpulan hasil video yang relevan dengan kueri penelusuran.

- Paket lokal: Peta dan daftar bisnis lokal yang relevan dengan permintaan pencarian.

- Paket gambar: Kisi gambar mini yang menyajikan gambar yang relevan secara visual.

- Cuplikan kaya: Informasi lanjutan seperti review, rating, dan bahan resep langsung di hasil pencarian.

Dengan menggunakan scraping API, Anda dapat mengekstrak data ini dan memantau keberhasilan pesaing dalam mengumpulkan data ini. Dengan melacak cuplikan ini, perusahaan dapat mengidentifikasi peluang untuk mengoptimalkan konten pelanggan mereka untuk visibilitas dan rasio klik-tayang yang lebih baik.

Kiat profesional:

Titik akhir Google Penelusuran ScraperAPI mengembalikan semua elemen ini dalam format JSON atau CSV, memungkinkan Anda memantau cuplikan SERP (atau hasil kaya) dengan mengirimkan daftar kata kunci melalui API. Untuk informasi selengkapnya, lihat dokumentasi endpoint terstruktur Google Penelusuran.

4. Gabungkan data SERP yang dilokalkan

Pencakar web dengan kemampuan penargetan geografis memungkinkan pengumpulan dan analisis data SERP yang dilokalkan. Dengan menyesuaikan kode negara atau parameter geolokasi, perusahaan dapat mengamati perbedaan peringkat dan hasil pencarian di berbagai wilayah. Ini juga memungkinkan Anda untuk:

- Kumpulkan data SERP dari berbagai negara dan wilayah

- Bandingkan hasil pencarian di lokasi berbeda

- Identifikasi faktor dan tren peringkat lokal

- Optimalkan konten untuk target geografis tertentu

ScraperAPI menyediakan titik akhir yang telah dikonfigurasi sebelumnya untuk situs web populer tertentu, termasuk Google Penelusuran. Pencakar Google ini dibuat dari awal untuk tim SEO dan pengembangan yang ingin mengumpulkan data SERP dari semua domain utama Google. Mereka menyediakan aliran data tanpa gangguan yang sempurna untuk pemantauan kata kunci hampir real-time.

Dengan titik akhir data terstruktur ScraperAPI Anda dapat:

- Kumpulkan data terstruktur dalam format JSON

- Sesuaikan kumpulan data Anda dengan parameter ekstensif

- Bekerja dengan data yang bersih untuk alur kerja yang lebih cepat

Mari kita segera mendemonstrasikan penggunaan Google SDE ScraperAPI untuk mengumpulkan data SERP yang dilokalkan. Kami membandingkan hasil pencarian untuk permintaan pencarian “sofa” di Amerika Serikat dan Inggris.

Jika Anda sudah familiar dengan ScraperAPI, salin dan jalankan kode ini. Jika tidak, buat akun ScraperAPI gratis untuk mengakses kunci API Anda dan gunakan cuplikan kode berikut.

Mari kita lihat dulu hasilnya untuk AS:

import requests

import json

APIKEY = "YOUR_API_KEY"

QUERY = "Sofa"

payload = {'api_key': APIKEY, 'query': QUERY, 'country_code': 'us'}

r = requests.get('https://api.scraperapi.com/structured/google/search', params=payload)

data = r.json()

with open('us_google_results.json', 'w') as json_file:

json.dump(data, json_file, indent=4)

print("Results have been stored in us_google_results.json")

Keluaran:

{

"position": 9,

"title": "Lifestyle Solutions Watford Sofa",

"thumbnail": "data:image/webp;base64,UklGRrIsAABXRUJQVlA4IKYsAACQow...",

"price": "$305.11",

"seller": "Home Depot",

"stars": 3.1,

"rating_num": 401

},

{

"position": 10,

"title": "Article Timber Olio Sofa",

"thumbnail": "data:image/webp;base64,UklGRtY1AABXRUJQVlA4IMo1AABwpI...",

"price": "$1,299.00",

"seller": "Article",

"stars": 4.3,

"rating_num": 280

},...

Sekarang ubah saja country_code Parameter dari 'us' Ke 'uk' Untuk mengambil hasil Inggris:

payload = {'api_key': APIKEY, 'query': QUERY, 'country_code': 'uk'}

r = requests.get('https://api.scraperapi.com/structured/google/search', params=payload)

data = r.json()

with open('uk_google_results.json', 'w') as json_file:

json.dump(data, json_file, indent=4)

print("Results have been stored in uk_google_results.json")

Keluaran:

catatan: Karena keterbatasan tempat, kami hanya menampilkan sebagian jawaban saja.

Dengan membandingkan us_google_results.json Dan uk_google_results.json File Anda akan melihat perbedaan dalam hasil pencarian, seperti:

- Berbagai situs peringkat teratas

- Perbedaan mata uang dalam hasil pembelian (USD vs. GBP)

- Nama atau deskripsi produk khusus wilayah

- Konten iklan yang dilokalkan

Perbedaan ini menyoroti pentingnya penargetan geografis dalam strategi SEO. Startup dapat memperoleh wawasan berharga tentang perbedaan hasil pencarian di berbagai wilayah, sehingga memungkinkan mereka menyesuaikan strategi dengan pasar geografis tertentu dan meningkatkan kinerja SEO global klien mereka.

5. Beri makan dasbor khusus

Pencakar web dapat digunakan untuk mengumpulkan data dalam jumlah besar yang dimasukkan ke dasbor khusus, menyediakan platform interaktif untuk analisis. Dengan mengintegrasikan data real-time ke dalam dashboard ini, perusahaan dapat menyajikan informasi kompleks dengan cara yang mudah diakses dan menarik secara visual.

Singkatnya, berikut adalah manfaat memberdayakan dasbor khusus dengan data bekas:

- Pembaruan peringkat waktu nyata: Perusahaan SEO dapat melacak peringkat kata kunci yang berfluktuasi, memungkinkan penyesuaian strategi secara instan. Data real-time memastikan bahwa Anda dan pelanggan Anda selalu mendapat informasi tentang posisi terkini dalam hasil pencarian.

- Grafik analisis kompetitif: Dasbor memudahkan untuk memvisualisasikan kinerja pelanggan Anda dibandingkan dengan pesaing di berbagai metrik SEO. Bagan dan grafik dapat menyoroti area di mana pelanggan Anda unggul atau memerlukan perbaikan.

- Tren kinerja kata kunci: Anda dapat memantau kinerja kata kunci tertentu dari waktu ke waktu. Garis tren dan data historis membantu mengidentifikasi kata kunci mana yang mengarahkan lalu lintas dan mana yang mungkin memerlukan pengoptimalan.

6. Buat alat khusus

Situs web Anda harus bertujuan untuk mendapatkan peringkat lima hasil teratas. Alat SEO memainkan peran penting dalam proses ini dengan membantu mengoptimalkan konten web Anda untuk memenuhi persyaratan mesin pencari, mengotomatiskan tugas, dan meningkatkan efisiensi.

Ada tiga kategori umum alat SEO:

- Alat kata kunci: Alat kata kunci seperti generator, penganalisis, dan monitor membantu Anda menemukan ide kata kunci baru, menganalisis daya saingnya, dan melacak kinerjanya dari waktu ke waktu.

- Alat tautan balik: Alat backlink memungkinkan Anda mencari peluang dengan memeriksa profil backlink dari situs web berperingkat teratas. Mereka juga membantu Anda memantau backlink yang ada untuk memastikan backlink tersebut tetap berharga dan tidak memengaruhi peringkat situs web Anda.

- Alat audit domain: Juga dikenal sebagai alat audit situs, alat ini memastikan bahwa situs web Anda baik secara teknis. Mereka membantu mengoptimalkan elemen seperti kecepatan situs web, waktu buka, daya tanggap, sertifikat keamanan (SSL), dan banyak lagi.

Cara sederhana namun efisien untuk membuat alat SEO khusus adalah dengan menggunakan API dari layanan yang ada seperti ScraperAPI. Dengan menyesuaikan API dengan kebutuhan spesifik Anda, Anda dapat mengembangkan alat tanpa harus memulai dari awal. Membangun alat SEO khusus melalui API masih memerlukan pengetahuan teknis, namun tidak serumit membangun alat Anda sendiri sepenuhnya.

7. Otomatiskan penelitian Google Trends

Google Trends adalah alat yang menampilkan tren. Ini tidak menunjukkan volume pencarian untuk kata kunci, namun menunjukkan tren ini dalam grafik yang diskalakan berdasarkan puncak minat tertinggi selama jangka waktu yang Anda tentukan.

Jadi mengapa mempersulit proses dengan membuat skrip? Seperti kebanyakan hal dalam web scraping, waktu dan skalabilitas adalah yang terpenting. Anda dapat memasukkan setiap kata kunci satu per satu dan melacak rentang waktu yang berbeda. Ini bagus sampai Anda memiliki daftar ratusan kata kunci.

Memeriksa masing-masing secara manual hanya membuang-buang waktu. Sebaliknya, Anda dapat dengan mudah mengotomatiskan pelaporan daftar kata kunci hanya dalam beberapa detik atau menit menggunakan scraping API.

Dengan menggunakan scraping API untuk mengotomatiskan pengumpulan data Google Trends, perusahaan dapat:

- Lacak topik yang sedang tren di industri pelanggan Anda

- Identifikasi tren musiman untuk perencanaan konten

- Bandingkan minat penelusuran di beberapa kata kunci

- Temukan pertanyaan dan topik terkait

Baca selengkapnya: Cara Menggaruk Google Trends

Menggunakan ScraperAPI untuk mengikis penelusuran Google dalam skala besar

ScraperAPI adalah API manajemen proxy dan solusi pengikisan web yang menangani segalanya mulai dari merotasi dan mengelola proxy hingga menangani CAPTCHA dan browser, percobaan ulang, dan sanitasi data sehingga permintaan kami tidak diblokir. Ini bagus untuk situs yang sulit dicari seperti Google.

Namun, apa yang membuat ScraperAPI sangat berguna untuk situs seperti Google adalah ia menyediakan fungsi penguraian otomatis secara gratis, sehingga menghilangkan kebutuhan untuk menulis dan memelihara parser Anda sendiri.

Sekarang mari kita lihat bagaimana kita dapat menggunakan ScraperAPI untuk mengumpulkan data dari 10 kata kunci berbeda menggunakan Titik Akhir Data Terstruktur (SDE) ScraperAPI untuk Google Penelusuran.

persyaratan

Langkah 1: Menyiapkan skrip dan menentukan kata kunci

Kita akan mulai dengan mengimpor perpustakaan yang diperlukan, menyiapkan kunci API, dan menentukan daftar kata kunci yang ingin kita cari.

import requests

import json

# Replace with your ScraperAPI key

api_key = 'Your_ScraperAPI_KEY'

# List of keywords to search

keywords = ('SEO tools', 'content marketing', 'link building', 'local SEO',

'technical SEO', 'keyword research', 'on-page SEO',

'off-page SEO', 'mobile SEO', 'voice search optimization')

base_url = 'https://api.scraperapi.com/structured/google/search'

Di sini kami mengimpor kueri dan pustaka JSON yang diperlukan, menyiapkan kunci ScraperAPI kami (yang harus Anda ganti dengan kunci sebenarnya), dan menentukan daftar kata kunci terkait SEO. Itu base_url Variabel berisi titik akhir untuk fungsi ekstraksi data Google Penelusuran ScraperAPI.

Langkah 2: Dapatkan data untuk setiap kata kunci

Sekarang kita menelusuri daftar kata kunci kita, mengirim permintaan ke ScraperAPI untuk masing-masing kata kunci, dan menyimpan hasilnya.

results = ()

for keyword in keywords:

params = {

'api_key': api_key,

'query': keyword,

'country': 'us'

}

response = requests.get(base_url, params=params)

if response.status_code == 200:

print(f"fetching data for '{keyword}'")

data = response.json()

results.append({

'keyword': keyword,

'organic_results': data.get('organic_results', ())

})

else:

print(f"Error fetching data for '{keyword}': {response.status_code}

Kode ini mengulang setiap kata kunci dalam daftar kami dan mengirimkan permintaan GET ke titik akhir ScraperAPI.

Jika permintaan berhasil (status code 200), ia mencetak pesan yang menunjukkan bahwa data untuk kata kunci sedang diambil. Kemudian ia mengekstrak 'organic_results' dari respons JSON dan menambahkannya ke daftar hasil kami bersama dengan kata kunci. Jika ada kesalahan, pesan kesalahan dengan kode status akan dicetak.

Langkah 3: Simpan hasilnya ke file JSON

Terakhir, kami menyimpan semua data yang dikumpulkan dalam file JSON untuk memudahkan analisis dan digunakan dalam aplikasi lain.

Kode ini membuka file baru bernama 'seo_search_results.json' dalam mode tulis dan menulis daftar hasil kami dalam format JSON, dengan indentasi 2 spasi untuk keterbacaan yang lebih baik. Terakhir, sebuah pesan akan dicetak yang mengonfirmasi bahwa hasilnya telah disimpan ke file.

Skrip lengkap

Berikut seluruh skrip yang dirangkum agar mudah disalin dan ditempel:

import requests

import json

# Replace with your ScraperAPI key

api_key = 'Your_ScraperAPI_KEY'

# List of keywords to search

keywords = ('SEO tools', 'content marketing', 'link building', 'local SEO',

'technical SEO', 'keyword research', 'on-page SEO',

'off-page SEO', 'mobile SEO', 'voice search optimization')

base_url = 'https://api.scraperapi.com/structured/google/search'

# Initialize a list to store results

results = ()

for keyword in keywords:

params = {

'api_key': api_key,

'query': keyword,

'country': 'us'

}

response = requests.get(base_url, params=params)

if response.status_code == 200:

print(f"Fetching data for '{keyword}'")

data = response.json()

results.append({

'keyword': keyword,

'organic_results': data.get('organic_results', ())

})

else:

print(f"Error fetching data for '{keyword}': {response.status_code}")

# Save results to a JSON file

with open('seo_search_results.json', 'w') as f:

json.dump(results, f, indent=2)

print("Search results saved to 'seo_search_results.json'")

Menggunakan antarmuka visual DataPipeline (kode rendah)

Bagi mereka yang lebih menyukai solusi kode rendah, DataPipeline ScraperAPI menyediakan antarmuka visual untuk menyiapkan tugas pengikisan tanpa harus menulis kode apa pun.

DataPipeline adalah perencana pengikisan bawaan ScraperAPI. Ini memungkinkan Anda untuk mengotomatiskan seluruh proses pengikisan dari awal hingga akhir. Integrasi alat ini dengan Google SDE ScraperAPI bahkan lebih baik. Alat-alat ini memungkinkan bisnis untuk menyiapkan pekerjaan pengumpulan kata kunci Google berulang untuk memantau hasil pencarian, membuat alat, dan dasbor umpan dengan data SERP pihak pertama tanpa menghabiskan ratusan jam untuk membangun atau memelihara infrastruktur dan parser yang kompleks.

Data yang diekstraksi dapat diakses dalam berbagai format termasuk JSON, CSV, atau webhook, sehingga memudahkan integrasi ke dalam proyek dan alur kerja Anda yang sudah ada.

Ayo gunakan Saluran data untuk melakukan tugas yang sama dengan lebih efisien dan lebih sedikit kode:

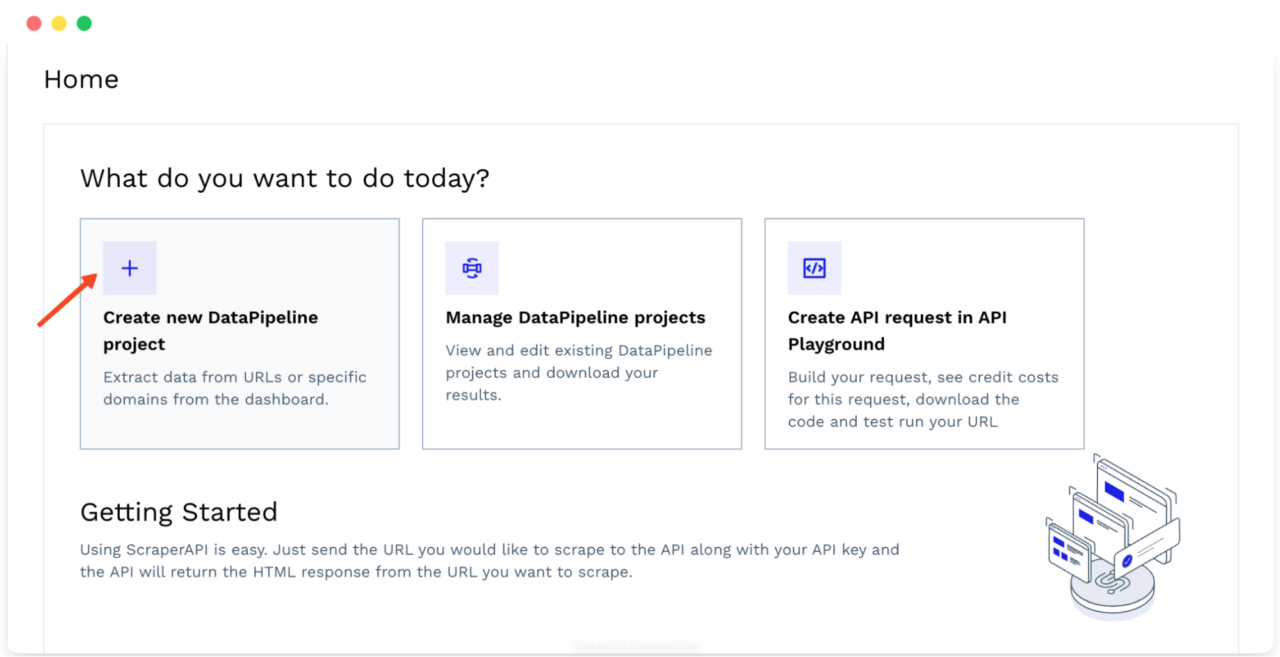

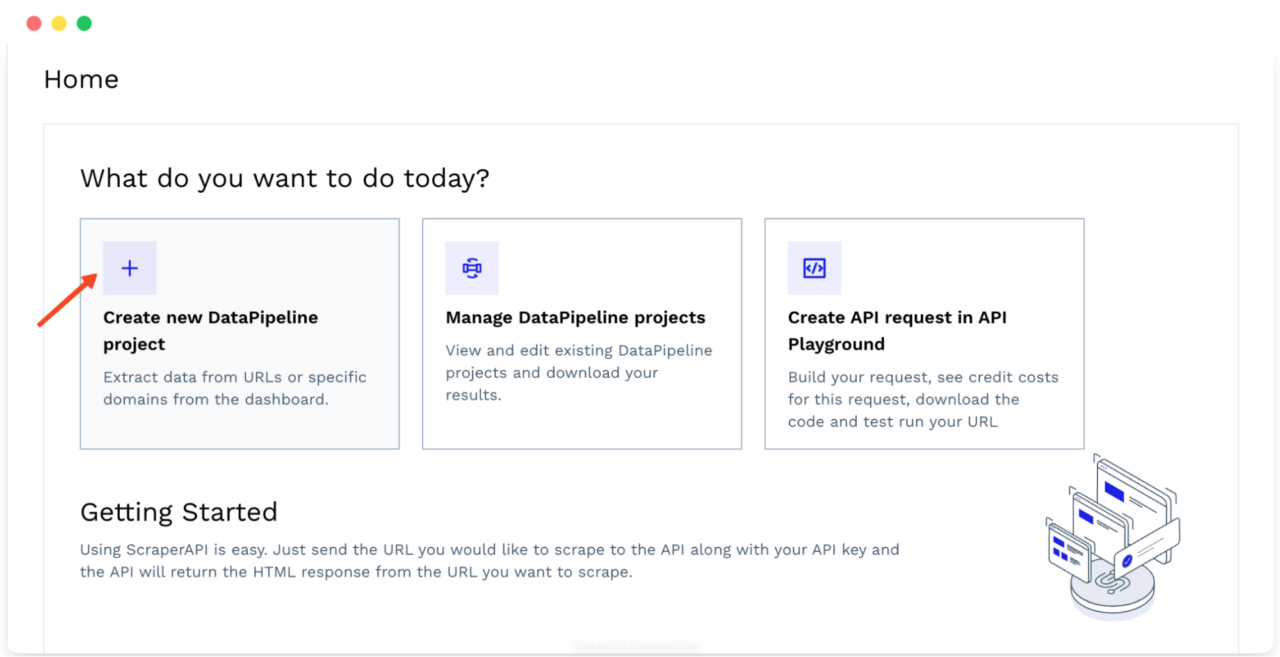

- Masuk ke akun ScraperAPI Anda dan klik “Buat proyek DataPipeline baru“. Ini adalah hub pusat Anda untuk mengelola semua tugas pengikisan Anda.

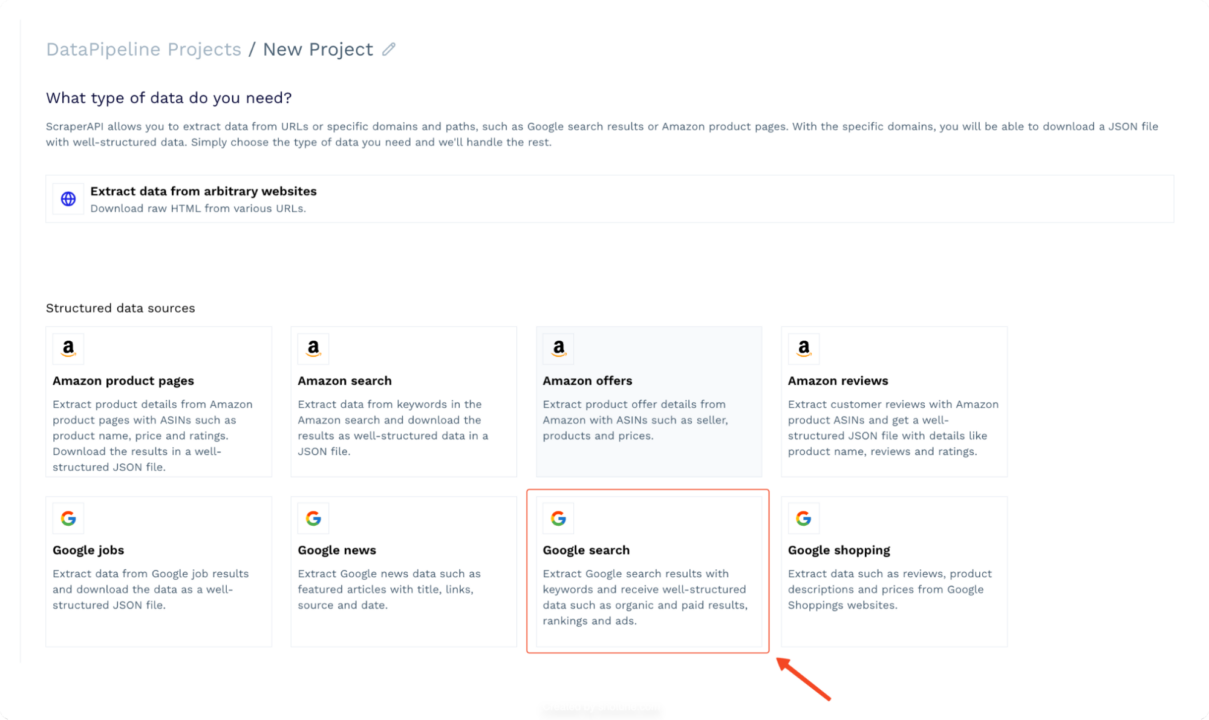

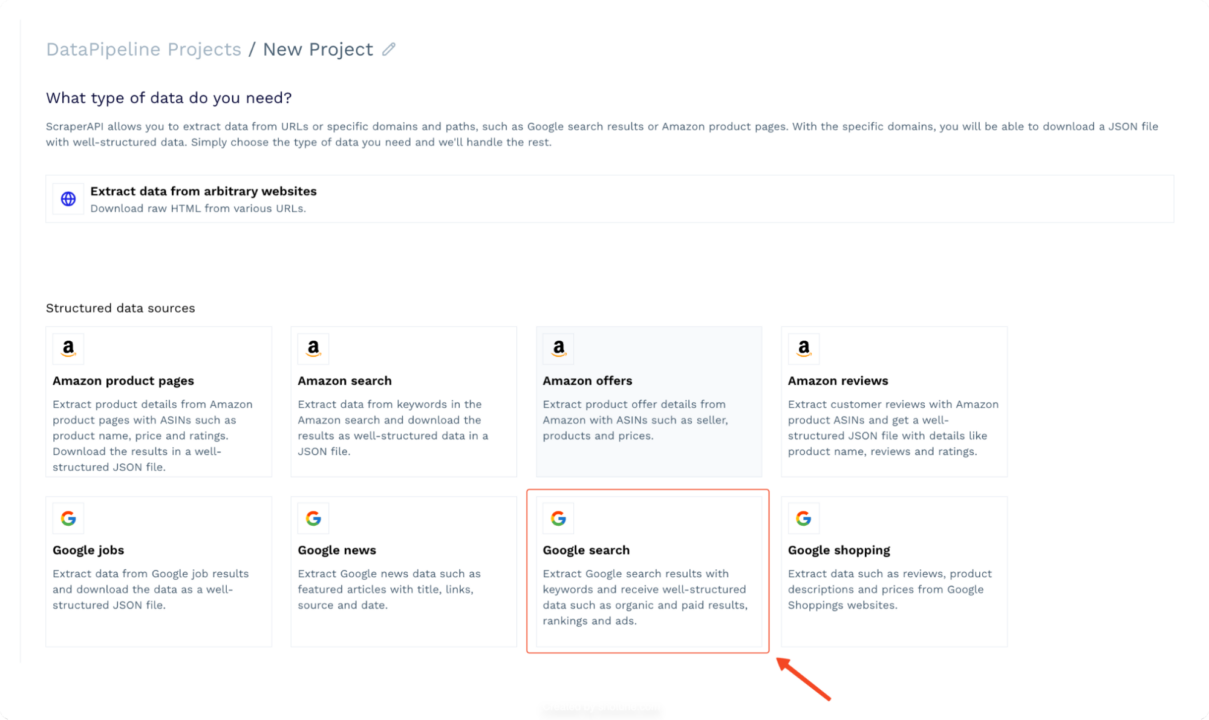

- Memilih "pencarian Google” ekstraktor dari daftar ekstraktor yang tersedia. Ekstraktor ini dirancang khusus untuk mengikis hasil pencarian Google dengan kata kunci.

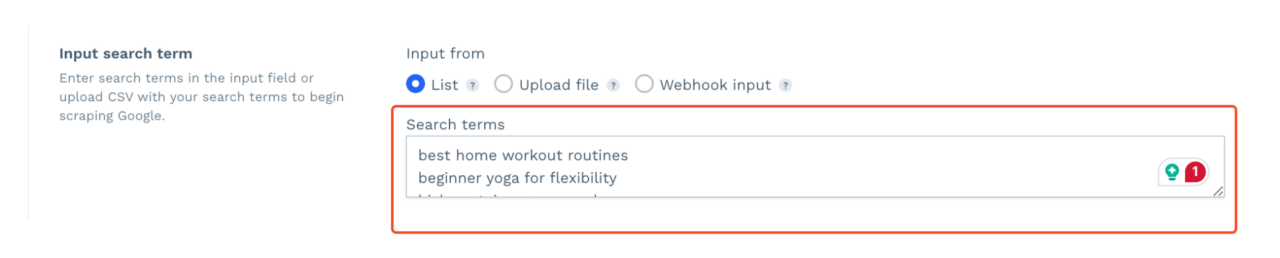

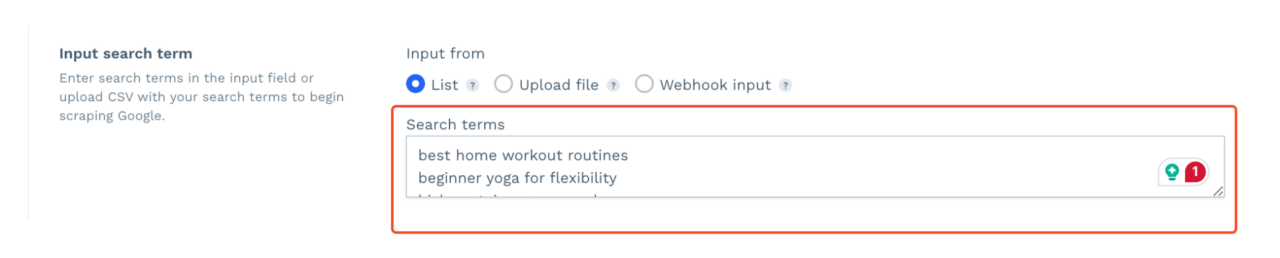

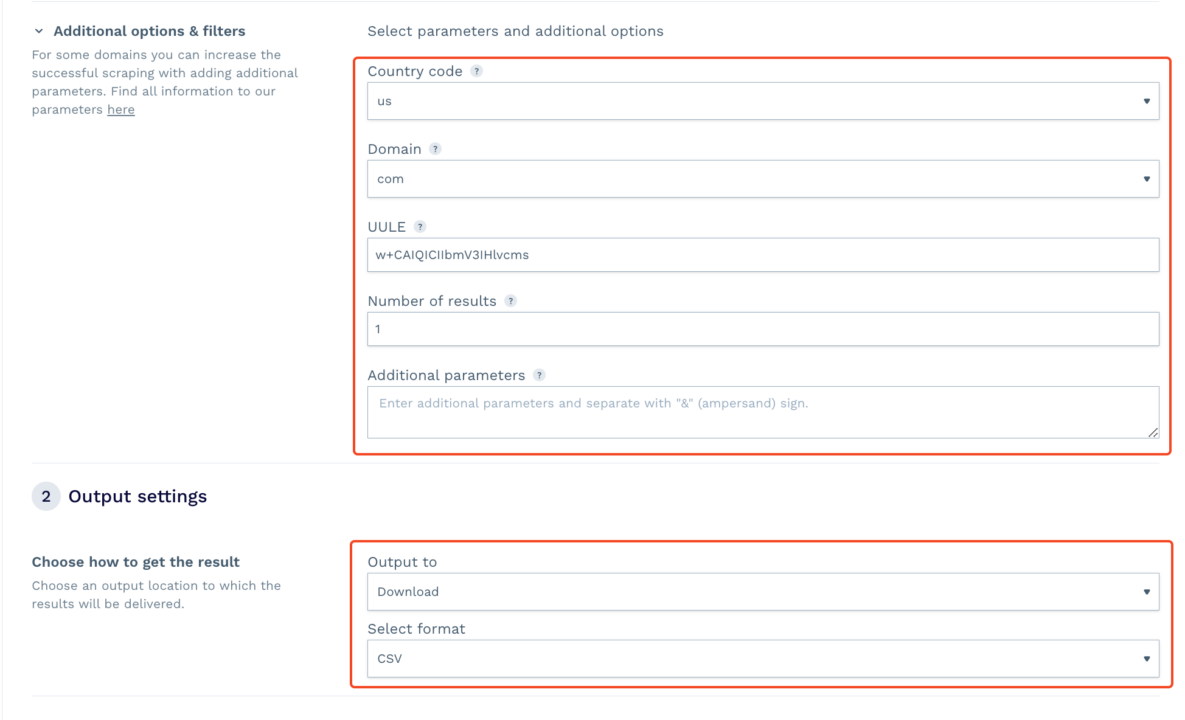

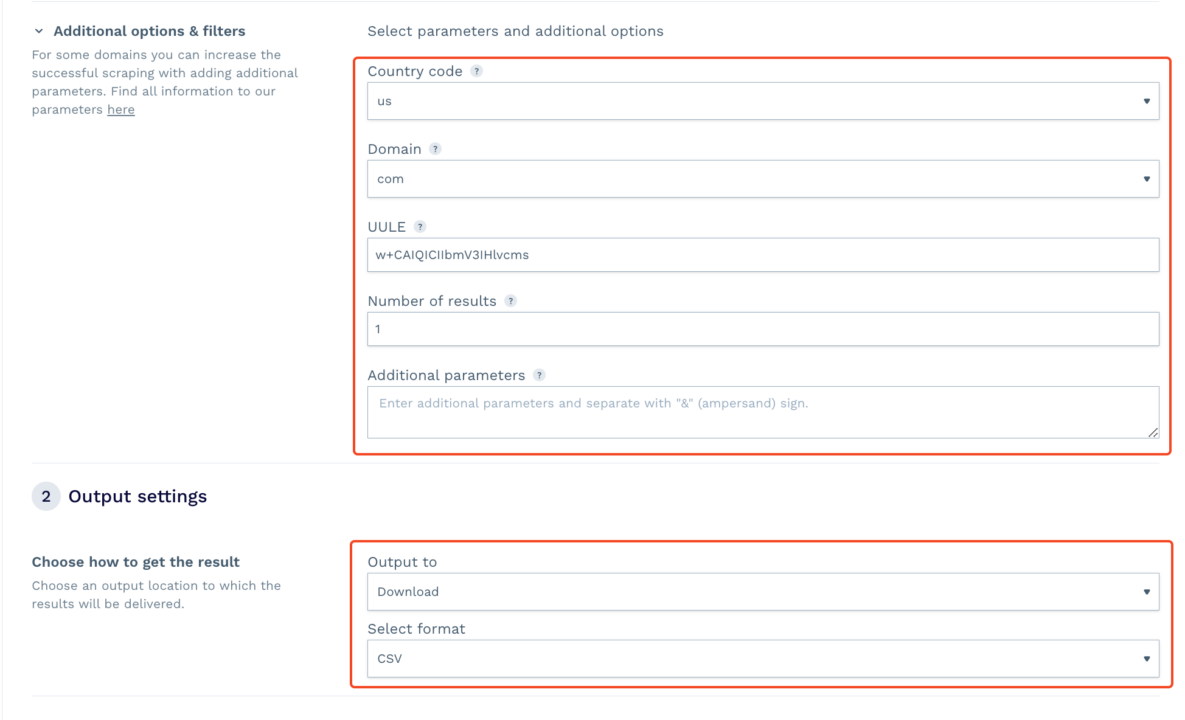

- Masukkan daftar kata kunci yang ingin Anda cari. Anda dapat mengunggah file CSV, menambahkan daftar dinamis melalui webhook, atau memasukkannya secara manual.

- Pilih tujuan penargetan geografis Anda, pilih domain, dan tetapkan pengaturan lainnya.

- Mulai tugas pengikisan. DataPipeline menangani sisanya. Setelah selesai, Anda dapat mengunduh file CSV atau JSON yang dihasilkan berisi data yang diretas. Saat Anda menambahkan webhook, Anda menerima data langsung di folder atau aplikasi yang Anda tentukan.

Kiat profesional:

Untuk pengguna teknis lainnya yang ingin memanfaatkan kemampuan penjadwalan DataPipeline, Anda dapat mengakses kemampuan yang sama melalui titik akhir khusus.

Hal ini memungkinkan Anda membuat dan mengelola ratusan proyek langsung dari basis kode Anda, menambahkan lapisan otomatisasi tambahan ke alur kerja Anda.

Ringkasan

Scraping API telah menjadi alat penting bagi perusahaan global dan lokal yang ingin mendapatkan keunggulan kompetitif di pasar yang ramai saat ini. Dengan mengintegrasikan alat-alat ini ke dalam alur kerja Anda, Anda dapat menghemat waktu, mengurangi upaya manual, dan fokus untuk memberikan hasil yang luar biasa bagi pelanggan Anda.

Apakah Anda memerlukan data SERP yang luas? Hubungi tim penjualan kami untuk memulai dengan paket khusus yang mencakup semua fitur premium, saluran dukungan khusus Slack, dan manajer akun khusus.