Pengikisan web Secara otomatis mengekstrak data terstruktur seperti harga, detail produk, atau metrik media sosial dari situs web.

Otomatisasi Proses Robot (RPA) berfokus pada otomatisasi tugas rutin dan berulang seperti entri data, pelaporan, atau manajemen file.

Ketika terintegrasi secara mulus melalui alat seperti webhook atau panggilan API, teknologi ini dapat meningkatkan efisiensi operasional perusahaan secara signifikan dengan menyederhanakan alur kerja berbasis data dan membebaskan sumber daya manusia untuk tugas-tugas bernilai lebih tinggi.

Apa itu RPA?

Kemajuannya bagus, tapi juga berantakan. Kita sering mendengar tentang ide-ide terobosan, namun perjalanan berulang, interaksi dari pintu ke pintu, dan kesulitan pengumpulan data jarang disorot.

Membangun produk hebat atau meluncurkan fitur baru sering kali melibatkan tugas yang membosankan dan berulang – pekerjaan yang penting namun belum tentu glamor.

Otomatisasi Proses Robot (RPA) adalah teknologi yang dirancang untuk menyederhanakan dan mengotomatiskan tugas-tugas berulang yang berbasis pemicu ini, sehingga menciptakan lebih banyak ruang untuk pemikiran kreatif dan inovasi.

Contoh tugas sehari-hari yang diotomatisasi dengan RPA:

Entri data:

Mentransfer data antar sistem, seperti memasukkan informasi dari email, formulir, atau spreadsheet ke dalam database atau sistem CRM.

Manajemen persediaan:

Perbarui tingkat inventaris secara otomatis, lacak pergerakan inventaris, dan buat pesanan berdasarkan ambang batas industri yang telah ditentukan.

Manajemen dokumen:

Salin file dari satu lokasi ke lokasi lain, atur data, dan kelola struktur file secara efisien.

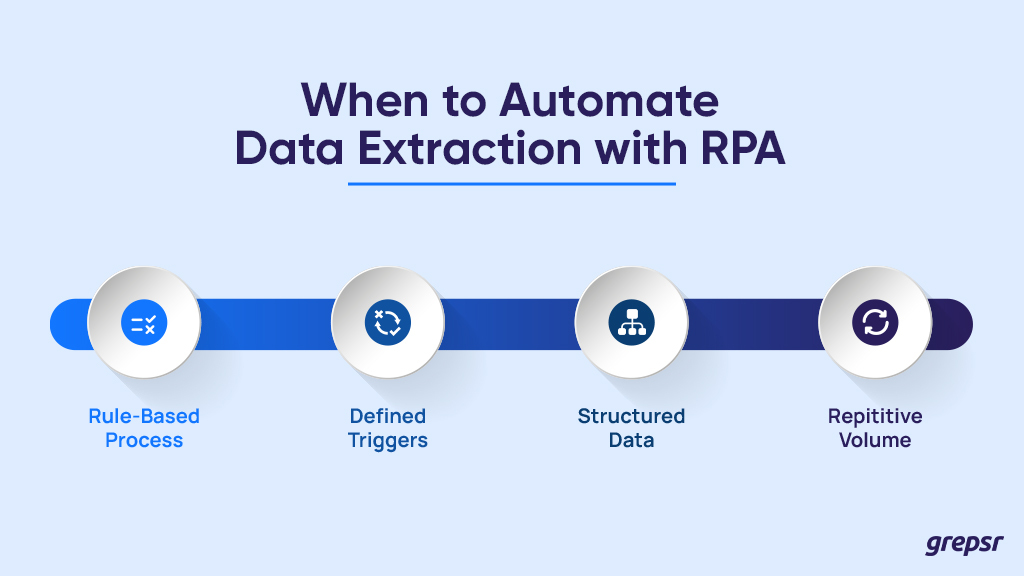

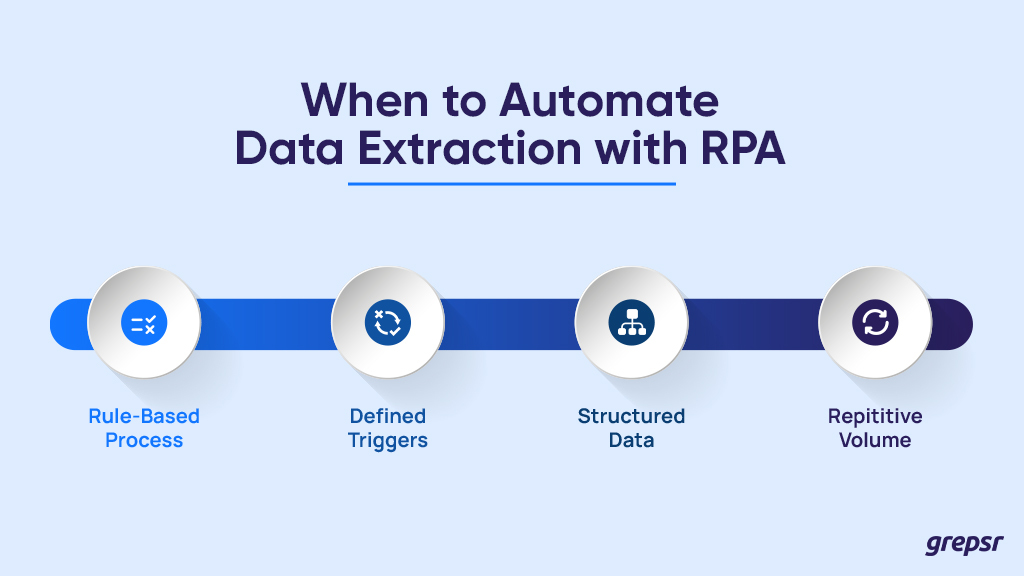

Mengotomatiskan ekstraksi data bisa sangat efisien, tetapi tidak semua proyek cocok untuk RPA. Berikut beberapa fitur utama yang menandakan saatnya memanggil asisten robot:

Proses berbasis aturan: Bisakah proses ekstraksi data dipecah menjadi langkah-langkah yang dapat diprediksi dengan aturan yang konsisten? Pikirkan tentang mengisi formulir, menavigasi halaman tertentu, dan mengekstrak data dari lokasi yang telah ditentukan.

Pemicu yang ditentukan: Apakah prosesnya memiliki titik awal yang jelas, seperti: Misalnya mengunggah file baru, slot waktu yang dijadwalkan, atau tindakan pengguna tertentu? Mengetahui kapan harus memulai akan memastikan bot RPA Anda aktif pada saat yang tepat.

Data terstruktur: Apakah data mengikuti format tetap, baik input maupun output? Spreadsheet yang konsisten, panggilan API, dan penyisipan database adalah mitra ideal untuk RPA.

Volume berulang: Apakah tugas ekstraksi data sering dilakukan dan berulang-ulang serta memerlukan data dalam jumlah besar? Semakin rutin dan ekstensif pekerjaannya, semakin besar manfaat otomatisasi.

Ingatlah bahwa selalu disarankan untuk menguji prosedur manual terlebih dahulu.

Pengujian manual berfungsi sebagai langkah persiapan mesin RPA. Mesin yang berjalan dengan lancar memerlukan persiapan yang tepat dan itulah sebabnya pengujian yang tepat memastikan ekstraksi data berjalan lancar.

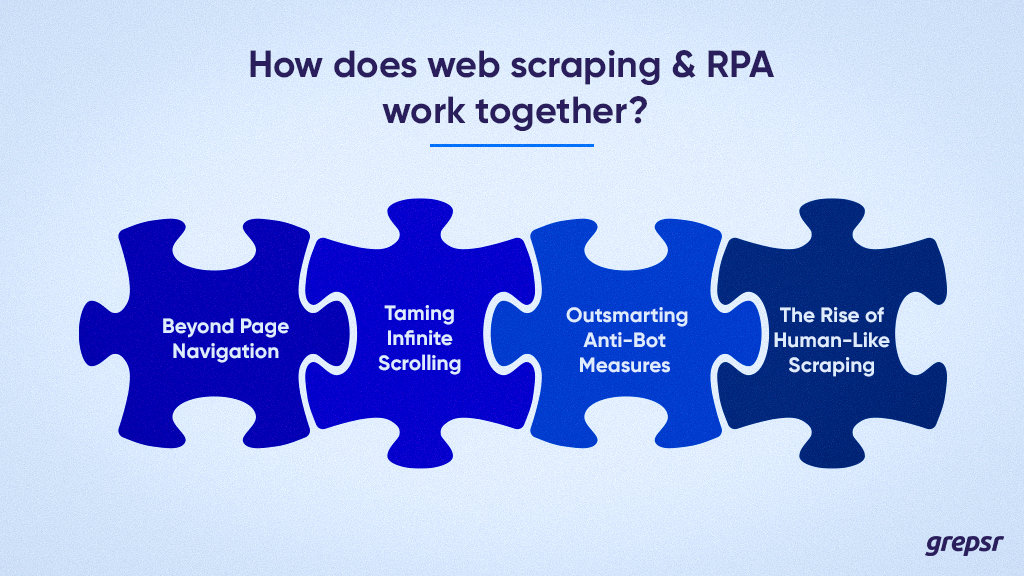

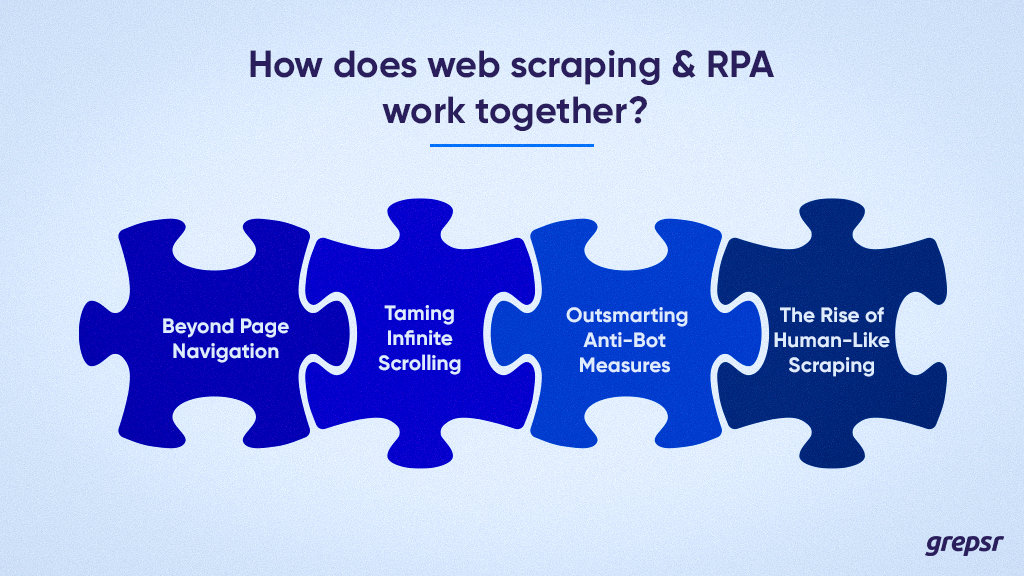

Bagaimana web scraping dan RPA bekerja sama?

Meskipun mantra "dapatkan data" mendasari setiap proyek web scraping, web scraping jarang hanya sekedar masalah mengidentifikasi URL situs web, menulis crawler yang belum sempurna, dan menunggu file CSV atau JSON yang tertata rapi. Skenario sederhana ini mengaburkan jaringan tantangan kompleks yang ditimbulkan oleh pengikisan modern.

Mari kita selidiki lebih dalam dan jelajahi kompleksitas sebenarnya yang muncul dalam skenario pengikisan di dunia nyata:

Di luar navigasi halaman: Perayap sederhana yang menavigasi halaman statis sudah ketinggalan zaman. Situs web saat ini sering kali memerlukan interaksi pengguna, seperti mengeklik menu tarik-turun atau menavigasi melalui tombol muat lebih banyak.

Berurusan dengan elemen dinamis memerlukan alat dan teknik canggih yang lebih dari sekadar crawler sederhana.

Menjinakkan Pengguliran Tak Terbatas: Situs web gulir tak terbatas menghadirkan tantangan unik. Alat pengikis harus secara dinamis mendeteksi dan memproses blok data baru saat dimuat untuk mencegah pengambilan data yang tidak lengkap atau tidak akurat.

Mengakali tindakan anti-bot: Ketika situs web menjadi lebih canggih dan menggunakan mekanisme deteksi bot, kebutuhan akan strategi pengikisan yang cerdas semakin meningkat.

Meniru perilaku manusia dan mematuhi protokol robots.txt sangat penting untuk menghindari deteksi dan memastikan keberhasilan ekstraksi data.

Bangkitnya Kecoa Antropomorfik: Mengembangkan tindakan anti-bot memerlukan teknik pengikisan yang meniru interaksi manusia dengan mulus. Ini sering kali merupakan alat canggih yang menggunakan teknik seperti rendering JavaScript dan kerangka otomatisasi browser.

Dimana RPA berperan

Mengatasi kompleksitas ini bisa menjadi hal yang sulit, terutama bagi ekstraktor data biasa.

Di sinilah Robotic Process Automation (RPA) dapat menjadi pengubah permainan Anda. Bot RPA dapat mengotomatiskan alur kerja yang kompleks, meniru interaksi pengguna, dan menangani elemen dinamis dengan mudah.

Anda dapat mengklik tombol, menelusuri halaman tanpa batas, dan menavigasi struktur situs web yang rumit, sehingga membebaskan Anda dari beban teknis.

Kebutuhan akan web scraping dan keahlian RPA

Karena situs web secara aktif berupaya mencegah bot, pemrograman crawler yang berperilaku autentik dan menghindari deteksi memerlukan keahlian tingkat tinggi.

Di sinilah layanan ekstraksi data terkelola seperti Grepsr berperan. Kami memiliki tim yang terampil dan peralatan canggih yang dilengkapi untuk mengatasi tantangan pengikisan yang paling rumit, memastikan pengumpulan data yang andal dan efisien.

Dengan memahami seluk-beluk web scraping modern dan memanfaatkan alat canggih seperti RPA, Anda dapat membuka potensi sebenarnya dari teknik ekstraksi data yang hebat ini.

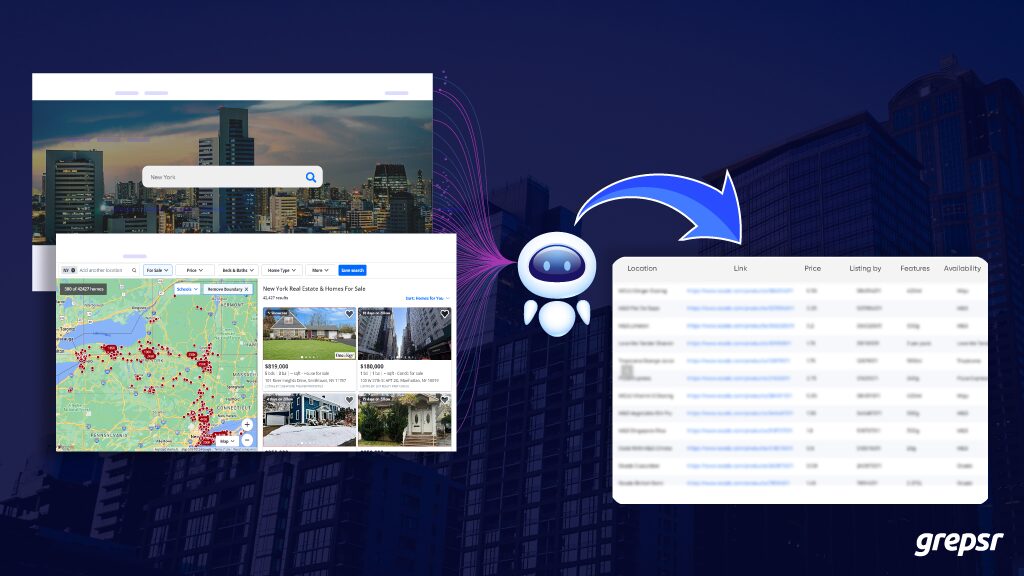

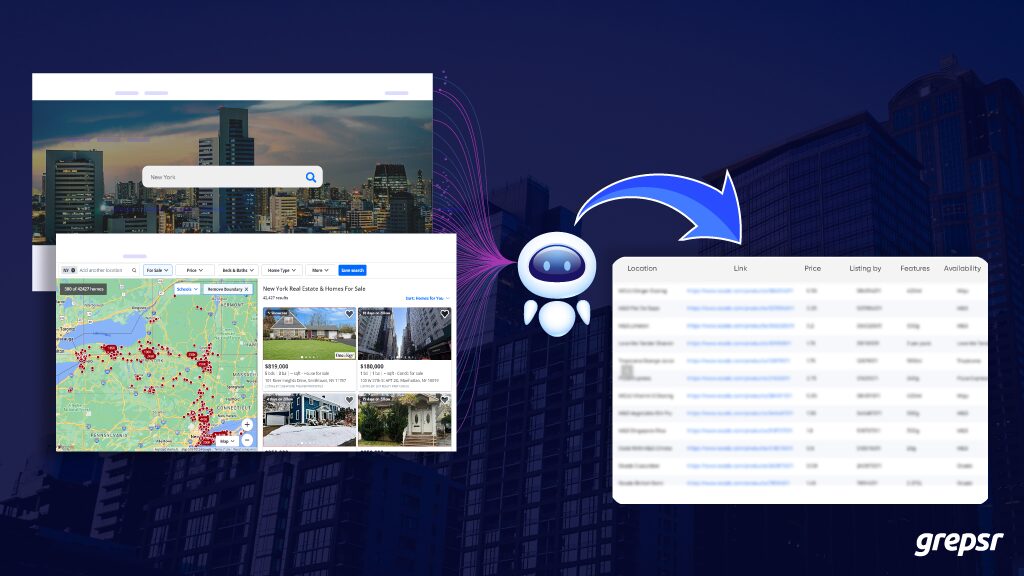

Kasus penggunaan untuk web scraping dan RPA: analisis pasar real estat

Latar belakang: Perusahaan investasi real estate, ABC Realty, ingin mengotomatiskan proses pengumpulan informasi tentang listing real estate dari Zillow untuk menganalisis tren pasar dan mengidentifikasi peluang investasi potensial.

Objektif: Otomatiskan ekstraksi detail daftar real estat, termasuk harga rumah, lokasi, dan fitur, dari Zillow untuk analisis pasar.

Navigasi bot RPA: Kembangkan bot RPA yang menavigasi ke situs web Zillow. Bot memasukkan kriteria pencarian tertentu seperti lokasi, jenis properti dan kisaran harga untuk mempersempit hasil pencarian.

Pengikisan web: Bot RPA mengidentifikasi tautan pertama ke daftar real estat di halaman hasil pencarian dan mengkliknya.

Pada halaman listing properti, bot mengumpulkan data relevan seperti harga properti, lokasi, ukuran, jumlah kamar tidur/kamar mandi dan fitur tambahan lainnya.

Pemrosesan dan penyimpanan data: Memproses data yang diambil untuk mengekstrak dan mengatur informasi yang relevan.

Simpan data listing properti yang dikumpulkan dalam format terstruktur (misalnya CSV, Excel, atau database) untuk analisis lebih lanjut atau integrasi ke dalam sistem internal ABC Realty.

Terkubur dalam data? Pengikisan web dan RPA dapat membantu Anda dalam hal ini

Apakah web penuh dengan informasi yang tidak berguna? Tidak dapat menemukan wawasan yang Anda perlukan? Apakah Anda kewalahan dengan entri data manual? Kami mengerti. Persaingannya cepat, Anda memerlukan keunggulan.

Pengikisan web dan RPA adalah alat Anda untuk menggali dan menggali data berharga.

Pengikisan mengambil apa yang Anda perlukan, sementara RPA mengotomatiskan pekerjaan rutin.

Memperkenalkan:

- Tren pasar dan informasi persaingan selalu ada di ujung jari Anda.

- Tidak ada lagi entri data tanpa akhir atau laporan panjang.

- Lebih banyak waktu untuk strategi dan keputusan yang mendorong pertumbuhan.

Kami menawarkan solusi bijaksana dan efisien yang disesuaikan untuk Anda.