Python dan JavaScript adalah bahasa pemrograman yang paling populer Pengikisan web. Pada artikel ini kita akan melihat kelebihan dan kekurangan kedua bahasa tersebut dan membandingkannya. Kami mengeksplorasi kasus penggunaan spesifik di mana JavaScript atau Python mungkin lebih cocok untuk proyek web scraping Anda.

Jika Anda tertarik mempelajari bahasa pemrograman lain untuk web scraping, kami sarankan Anda membaca artikel kami tentang bahasa terbaik untuk web scraping. Di dalamnya, kami membahas pro dan kontra dari setiap bahasa dan memberikan contoh dasar cara kerja scraper.

JavaScript untuk pengikisan web

JavaScript adalah bahasa yang paling umum digunakan dalam pengembangan web dan memiliki kekuatan dan kelemahan khusus saat mengekstraksi data dari situs web. Kemampuan untuk berinteraksi dengan mudah dengan konten dinamis memberikan keuntungan besar.

Di bagian ini, kita akan melihat pustaka JavaScript populer yang digunakan untuk web scraping dan menjelajahi fitur-fiturnya serta bagaimana pustaka tersebut membantu ekstraksi data. Kami juga membahas manfaat dan tantangan menggunakan JavaScript.

Kami kemudian akan membandingkan JavaScript dengan Python, memeriksa seberapa baik Python bekerja untuk web scraping dan bagaimana pendekatannya berbeda dari JavaScript.

Perpustakaan dan alat populer

Dalam artikel kami sebelumnya, kami melihat enam pustaka JavaScript dan Node.js teratas untuk web scraping, termasuk pro, kontra, dan contoh kodenya. Pada artikel ini, kita akan fokus pada tiga yang paling populer: Axios, Cheerio, dan Puppeteer. Perpustakaan lain kurang umum dan mengulangi apa yang dapat dilakukan ketiga perpustakaan tersebut.

Axios dan Cheerio biasanya digunakan bersama dalam web scraping. Axios sangat bagus untuk membuat kueri ke situs web, dan Cheerio membantu Anda mengurai dan mengedit data yang dikembalikan. Mereka mudah digunakan dan bekerja dengan baik untuk tugas pengikisan sederhana.

Mari kita tunjukkan ini dengan situs demo. Kami akan membuat skrip sederhana untuk mengambil informasi produk penting dari sebuah halaman.

const axios = require('axios');

const cheerio = require('cheerio');

const url="https://demo.opencart.com/";

axios.get(url).then(response => {

const $ = cheerio.load(response.data);

const products = ();

$('.product-thumb').each((index, element) => {

const product = {

title: $(element).find('.description h4 a').text().trim(),

description: $(element).find('.description p').text().trim(),

price: $(element).find('.price .price-new').text().trim(),

tax: $(element).find('.price .price-tax').text().trim(),

image: $(element).find('.image img').attr('src'),

link: $(element).find('.description h4 a').attr('href'),

};

products.push(product);

});

console.log(products);

}).catch(error => {

console.error('Error:', error);

});Seperti yang Anda lihat, perpustakaan ini memungkinkan Anda mengekstrak data dengan cepat dari situs web yang relatif sederhana. Namun, mereka tidak dapat memproses konten dinamis. Untuk mendalami kedua perpustakaan ini lebih dalam, lihat artikel kami tentang web scraping dengan Axios dan Cheerio.

Pustaka JavaScript lain yang berguna untuk scraping adalah Puppeteer. Berbeda dengan yang lain, Puppeteer merupakan alat serba guna dan tidak memerlukan alat tambahan apa pun. Anda dapat menggunakannya untuk membuka browser, mengunjungi halaman, dan mensimulasikan tindakan pengguna.

Karena Puppeteer dapat menangani konten dinamis yang dimuat oleh JavaScript, ini adalah pilihan yang baik. Mari perbarui contoh sebelumnya untuk menggunakan Dalang:

const puppeteer = require('puppeteer');

(async () => {

const browser = await puppeteer.launch();

const page = await browser.newPage();

await page.goto('https://demo.opencart.com/', { waitUntil: 'networkidle2' });

const products = await page.evaluate(() => {

const productElements = document.querySelectorAll('.product-thumb');

const products = ();

productElements.forEach(element => {

const product = {

title: element.querySelector('.description h4 a').innerText.trim(),

description: element.querySelector('.description p').innerText.trim(),

price: element.querySelector('.price .price-new').innerText.trim(),

tax: element.querySelector('.price .price-tax').innerText.trim(),

image: element.querySelector('.image img').src,

link: element.querySelector('.description h4 a').href

};

products.push(product);

});

return products;

});

console.log(products);

await browser.close();

})();Kode ini memungkinkan kami mengekstrak data dari situs web dengan andal. Ia meluncurkan driver web, mengunjungi halaman yang diinginkan, menunggu hingga memuat sepenuhnya, dan kemudian mengumpulkan informasi yang dibutuhkan secara efisien. Metode ini mencegah kesalahan yang disebabkan oleh upaya mengekstrak data sebelum data dimuat sepenuhnya.

Manfaat menggunakan JavaScript

JavaScript sangat bagus untuk web scraping karena memungkinkan Anda mengumpulkan data langsung di sisi klien. Artinya Anda bisa bekerja langsung di browser. Hal ini sangat berguna untuk menangani halaman web dinamis yang kontennya sering berubah. JavaScript memungkinkan Anda menjalankan skrip pada halaman yang Anda gores.

Node.js adalah pilihan lain. Ini memungkinkan Anda menjalankan JavaScript di sisi server, yang bisa sangat berguna saat melakukan scraping. Selain itu, kemampuan JavaScript untuk memproses banyak tugas secara bersamaan (operasi asinkron) membuatnya efisien dalam menyerap data dalam jumlah besar dengan cepat.

Kekurangan menggunakan JavaScript

Namun, JavaScript memiliki beberapa kelemahan. Bagi pemula, mempelajarinya mungkin lebih rumit daripada bahasa seperti Python. Kompleksitas ini dapat mempersulit proses pembangunan.

Meskipun ada banyak pustaka JavaScript untuk melakukan scraping, alat untuk memproses dan menganalisis data mungkin kurang ekstensif. Selain itu, membuat alat khusus, seperti untuk memproses PDF, mungkin memerlukan pekerjaan tambahan dan solusi khusus.

Python untuk pengikisan web

Python telah menjadi pilihan yang sangat populer untuk web scraping dalam beberapa tahun terakhir. Ia dikenal karena kemudahan penggunaannya dan memiliki banyak perpustakaan dan alat untuk membantu pengembang mengerjakan berbagai proyek terkait data. Sintaksnya yang jelas dan lugas menjadikannya favorit di komunitas web scraping.

Perpustakaan dan alat populer

Python memiliki banyak perpustakaan dan alat untuk mengekstraksi, memproses, dan menganalisis data. Mari kita bandingkan ini dengan perpustakaan JavaScript yang kita lihat sebelumnya. Alat Python utama untuk mengambil data adalah Requests, BeautifulSoup, Selenium, dan kerangka Scrapy.

Ada perpustakaan Python lain untuk scraping, tapi kami akan fokus pada perpustakaan populer ini. Kami telah membahas contoh semua alat pengikis Python yang penting ini di artikel lain.

Permintaan dan BeautifulSoup sangat mudah bagi pemula dan banyak digunakan. Mereka mempermudah pengiriman permintaan ke situs web dan memproses HTML yang dikembalikan. Mereka bekerja mirip dengan Axios dan Cheerio dari JavaScript dan memberi Anda alat yang efektif untuk web scraping.

import requests

from bs4 import BeautifulSoup

url="https://demo.opencart.com/"

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')

products = ()

for product in soup.find_all('div', class_='product-thumb'):

title = product.find('h4').text.strip()

description = product.find('p').text.strip()

price = product.find('span', class_='price-new').text.strip()

tax = product.find('span', class_='price-tax').text.strip()

image = product.find('img')('src')

link = product.find('h4').find('a')('href')

products.append({

'title': title,

'description': description,

'price': price,

'tax': tax,

'image': image,

'link': link

})

print(products)Tidak seperti JavaScript, skrip Python ini berjalan secara sinkron secara default. Untuk membuatnya asinkron, Anda harus menggunakan perpustakaan aiohttp, bukan Permintaan. Pustaka aiohttp bekerja dengan asyncio untuk mengaktifkan permintaan asinkron.

Ada beberapa opsi untuk driver web dan otomatisasi browser dengan Python. Yang paling populer adalah Pyppeteer, pembungkus Dalang, dan Selenium. Selenium lebih umum digunakan di Python, memiliki komunitas yang lebih besar, dan dokumentasi yang lebih baik. Jadi kami menggunakan Selenium sebagai contoh.

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.chrome.service import Service

from selenium.webdriver.chrome.options import Options

from webdriver_manager.chrome import ChromeDriverManager

chrome_options = Options()

chrome_options.add_argument('--headless')

chrome_options.add_argument('--disable-gpu')

driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()), options=chrome_options)

url="https://demo.opencart.com/"

driver.get(url)

products = ()

product_elements = driver.find_elements(By.CLASS_NAME, 'product-thumb')

for product in product_elements:

title = product.find_element(By.CSS_SELECTOR, '.description h4 a').text.strip()

description = product.find_element(By.CSS_SELECTOR, '.description p').text.strip()

price = product.find_element(By.CSS_SELECTOR, '.price .price-new').text.strip()

tax = product.find_element(By.CSS_SELECTOR, '.price .price-tax').text.strip()

image = product.find_element(By.CSS_SELECTOR, '.image img').get_attribute('src')

link = product.find_element(By.CSS_SELECTOR, '.description h4 a').get_attribute('href')

products.append({

'title': title,

'description': description,

'price': price,

'tax': tax,

'image': image,

'link': link

})

driver.quit()

print(products)Untuk informasi lebih lanjut tentang web scraping, lihat artikel kami yang lain dengan panduan lengkap tentang penggunaan Selenium dengan Python.

Mari kita pertimbangkan juga kerangka Scrapy. Ini bagus untuk membuat web scraper skala besar dan mengumpulkan data dalam jumlah besar. Scrapy sangat kuat dan efisien, tetapi pengaturannya mungkin sulit, sehingga dijelaskan secara rinci di artikel lain tentang scrapy dengan Scrapy.

Meskipun Python memiliki lebih banyak pustaka web scraping daripada JavaScript, banyak dari pustaka ini menyediakan fungsionalitas serupa.

Manfaat menggunakan Python

Python menjadi sangat populer dalam beberapa tahun terakhir karena memiliki banyak fitur hebat. Mudah dipelajari dan digunakan, menjadikannya pilihan yang baik untuk pemula dan pemrogram berpengalaman. Python memiliki banyak perpustakaan dan alat yang dapat membantu banyak tugas.

Salah satu kekuatan terbesar Python adalah kemampuannya mengerjakan proyek berbasis data. Baik Anda mengumpulkan, memproses, atau menganalisis data, Python menawarkan alat canggih untuk membantu Anda menyelesaikan pekerjaan secara efisien. Hal ini menjadikannya pilihan pertama untuk proyek terkait data.

Karena begitu banyak orang yang menggunakan Python, terdapat komunitas pengguna yang besar dan aktif. Komunitas ini bisa sangat membantu ketika mengerjakan proyek seperti web scraper atau alat lainnya. Jika Anda mengalami masalah, mudah untuk menemukan solusi atau mendapatkan saran dari pengembang Python lainnya.

Kekurangan menggunakan Python

Salah satu kelemahan menggunakan Python untuk pengumpulan data adalah sering kali dianggap sinkron, artinya ia memproses tugas satu per satu. Hal ini dapat memperlambat jika Anda harus memproses banyak permintaan sekaligus. Di sisi lain, JavaScript, khususnya Node.js, dirancang untuk menangani operasi asinkron secara efisien, sehingga lebih cocok untuk skenario dengan beberapa permintaan simultan.

Selain itu, Python umumnya memiliki lebih sedikit alat bawaan untuk berinteraksi dengan konten dinamis dibandingkan JavaScript. Kemampuan JavaScript, seperti yang disediakan oleh alat otomatisasi browser seperti Puppeteer, bisa sangat berguna untuk mengekstraksi data dari situs web yang kontennya sering diperbarui.

Terlepas dari keterbatasan ini, Python tetap menjadi pilihan yang populer dan efektif untuk web scraping. Ini memiliki serangkaian perpustakaan kuat yang memudahkan penggalian data dari situs web

Perbandingan JavaScript dan Python untuk web scraping

Sebelum kita mempelajari perbandingan mendetail antara JavaScript dan Python, mari kita mulai dengan tabel sederhana untuk menyoroti fitur utama dari kedua bahasa pemrograman tersebut:

|

aspek |

JavaScript (Node.js) |

ular piton |

|---|---|---|

|

Perpustakaan Utama |

- As |

– Pertanyaan |

|

– Ambil node |

– aiohttp |

|

|

– Dalang |

– Sup yang enak |

|

|

- Selamat tinggal |

– Menggaruk |

|

|

– Permintaan (tidak berlaku lagi) |

– Selenium |

|

|

paralelisme |

– Dukungan asli dengan async/menunggu |

– Dukungan asli dengan asyncio |

|

- Janji |

– aiohttp untuk permintaan asinkron |

|

|

– Efisien dengan Puppeteer untuk penjelajahan tanpa kepala |

– bersamaan.futures untuk multithreading |

|

|

keramahan pengguna |

– Sintaks asinkron modern mudah digunakan untuk konkurensi |

– BeautifulSoup mudah digunakan untuk penguraian HTML |

|

– Cheerio untuk penguraian HTML yang mudah |

– Scrapy menyediakan kerangka pengikisan yang berfungsi penuh |

|

|

Pertunjukan |

– Umumnya cepat dengan Dalang dan dukungan asinkron asli |

– Dukungan asinkron dengan aiohttp efisien |

|

– Cocok untuk memproses beberapa permintaan secara bersamaan secara efisien |

– Scrapy dioptimalkan untuk pengikisan skala besar |

|

|

Berurusan dengan JavaScript |

– Dukungan luar biasa dari dalang dan dramawan |

– Membutuhkan Selenium atau browser tanpa kepala seperti Splash untuk situs web yang banyak menggunakan JavaScript |

|

– Dapat menangani konten dinamis dan elemen interaktif |

||

|

Komunitas dan ekosistem |

– Komunitas besar dengan banyak alat modern |

– Ekosistem yang luas dengan beragam perpustakaan dan kerangka kerja |

|

– Perpustakaan yang luas untuk pengikisan dan otomatisasi web |

– Dukungan komunitas yang kuat |

|

|

Kurva belajar |

– Mempelajari pola pemrograman asinkron mungkin diperlukan |

– Umumnya mudah untuk pemula |

|

– Perpustakaan seperti Puppeteer mempunyai kurva pembelajaran yang lebih curam |

– Scrapy bisa jadi rumit untuk proyek besar |

|

|

Penanganan kesalahan |

– Janji dan async/await menyediakan mekanisme penanganan kesalahan yang kuat |

– Pengecualian dan penanganan kesalahan asinkron dengan aiohttp dan permintaan didukung dengan baik |

|

Dukungan untuk penjelajahan tanpa kepala |

– Dukungan luar biasa dari dalang, dramawan |

– Selenium atau alat eksternal diperlukan untuk penjelajahan tanpa kepala |

Seperti yang ditunjukkan pada tabel, sulit untuk mengatakan bahasa pemrograman mana yang terbaik untuk pengikisan data. Berdasarkan pengalaman kami, bahasa yang paling efektif untuk pengumpulan data biasanya adalah bahasa yang sudah Anda ketahui dengan baik. Jika Anda sudah familiar dengan suatu bahasa, Anda dapat membuat kode dengan lebih efisien, memecahkan masalah dengan lebih cepat, dan mencapai hasil yang lebih baik secara keseluruhan.

keramahan pengguna

Membuat dan menggunakan skrip bisa lebih mudah atau lebih sulit tergantung pada bahasa pemrograman mana yang sudah Anda ketahui. Misalnya, jika Anda terbiasa dengan JavaScript saat bekerja di situs web, Anda tidak akan mengalami masalah dalam membuat web scraper dengan JavaScript. Panduan terperinci kami akan memandu Anda melalui langkah-langkah membuat scraper dengan JavaScript atau Node.js dan menunjukkan cara menjalankannya.

Mempelajari JavaScript bisa sangat membantu untuk web scraping, bahkan untuk pengembang Python. Terkadang Anda mungkin perlu menyertakan cuplikan JavaScript di skrip Python utama Anda untuk menangani tugas seperti menggulir halaman atau mengklik tombol.

Di sisi lain, jika Anda baru mengenal pemrograman dan ingin memulai web scraping, Python adalah pilihan yang baik. Umumnya lebih mudah dipelajari dibandingkan bahasa pemrograman lainnya. Tutorial kami memperkenalkan Anda pada Python dan web scraping, termasuk contoh praktis menggunakan perpustakaan populer.

kepopuleran

Popularitas suatu bahasa pemrograman dapat bervariasi tergantung pada metode pengukurannya. Di bagian ini, kita akan melihat seberapa populer JavaScript dan Python menggunakan beberapa sumber data objektif.

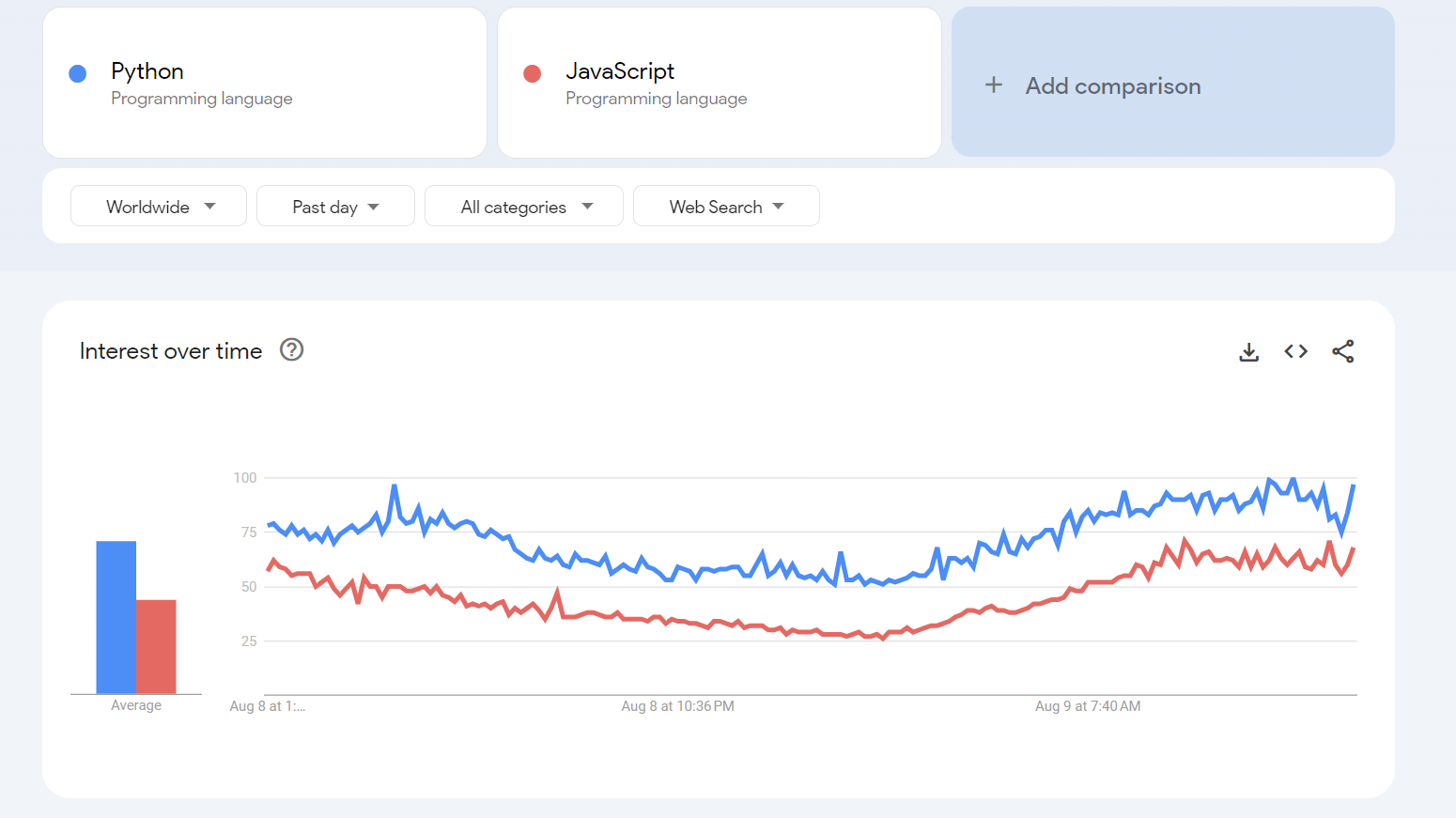

Alat yang berguna untuk analisis ini adalah Google Trends. Google Trends menunjukkan seberapa sering orang menelusuri istilah seperti “JavaScript” dan “Python” dari waktu ke waktu. Anda dapat menyesuaikan pencarian untuk fokus pada wilayah dan periode waktu tertentu untuk mendapatkan gambaran yang lebih jelas tentang perubahan minat terhadap bahasa-bahasa ini.

Hal ini memungkinkan kami melihat bahasa mana yang lebih sering dicari dan mengidentifikasi tren popularitasnya.

Seperti yang ditunjukkan pada grafik, data platform menunjukkan bahwa Python lebih populer. Namun, seperti disebutkan sebelumnya, mengandalkan data dari satu sumber saja mungkin tidak memberikan gambaran yang lengkap. Jadi mari beralih ke platform berikutnya untuk perspektif yang lebih luas.

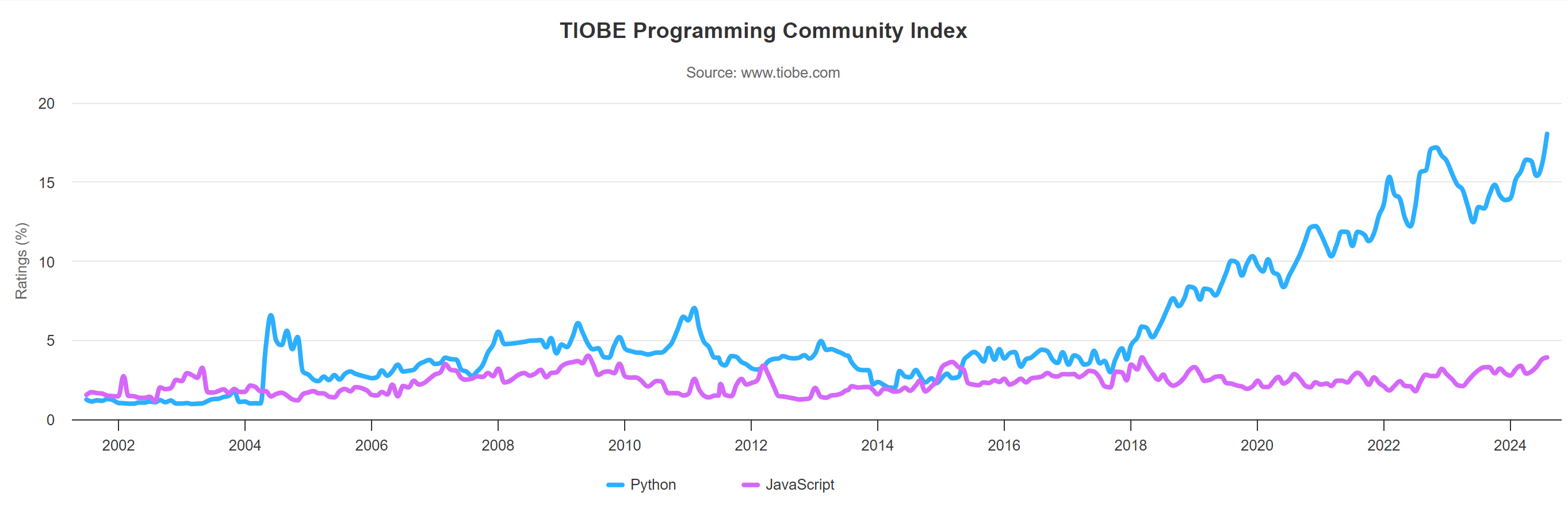

Layanan selanjutnya yang sering digunakan untuk mengevaluasi popularitas bahasa pemrograman adalah Tiobe. Pemeringkatan Tiobe didasarkan pada jumlah pencarian berbagai bahasa pemrograman di mesin pencari besar seperti Google, Bing, Yahoo, Wikipedia, Amazon dan lain-lain. Metode ini membantu memberikan gambaran yang lebih komprehensif tentang seberapa sering bahasa pemrograman dicari dan didiskusikan secara online, memberikan pemahaman yang lebih baik tentang popularitasnya secara keseluruhan.

Indeks ini diperbarui setiap bulan dan menunjukkan tren bahasa pemrograman selama 20 tahun terakhir. Menurut Indeks Tiobe Agustus 2024, Python saat ini menjadi bahasa pemrograman terpopuler, sedangkan JavaScript berada di peringkat keenam.

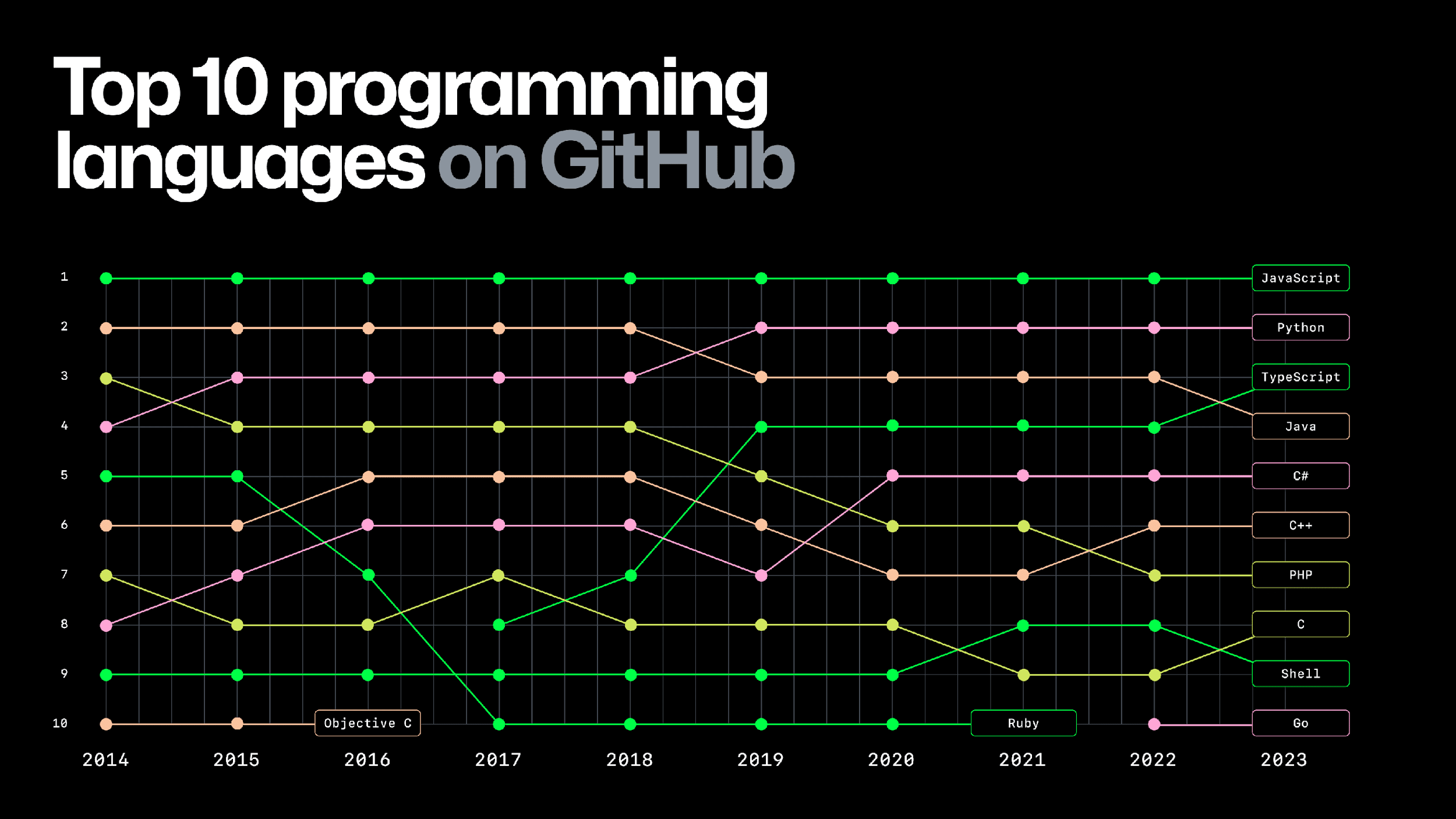

Terakhir, mari kita lihat GitHub Octoverse, yang menurut saya merupakan sumber yang sangat andal dan mendetail. GitHub Octoverse memberikan wawasan tentang jumlah proyek di GitHub, platform hosting kode terbesar di dunia. Ini juga berisi informasi tentang bahasa pemrograman mana yang paling sering digunakan dalam proyek aktif.

Menurut data ini, JavaScript lebih populer di GitHub karena digunakan di banyak proyek. JavaScript telah menjadi pemimpin dalam hal ini sejak tahun 2014. Oleh karena itu, meskipun Python sangat populer, masih terlalu dini untuk menyebutnya sebagai bahasa pemrograman terpopuler secara keseluruhan.

Pertunjukan

Mengevaluasi kinerja dan efisiensi skrip yang ditulis dalam bahasa pemrograman berbeda bisa bersifat subjektif. Untuk mendapatkan gambaran yang lebih jelas, mari tulis dua skrip asinkron: JavaScript dan Python. Kedua skrip berulang kali mengambil situs demo (10 kali), mengukur berapa lama waktu yang dibutuhkan untuk setiap permintaan, lalu menghitung rata-rata dan total waktu yang dibutuhkan.

Sebelum kita mempelajari contoh kode, penting untuk memahami mengapa masuk akal untuk membandingkan berbagai bahasa dengan cara ini. Menjalankan skrip yang identik pada mesin yang sama, dengan alat yang serupa, dan dalam kondisi yang sama memungkinkan penilaian yang adil terhadap kinerja bahasa pada tugas-tugas tertentu:

- Pengikisan web dan pengujian beban. Kita dapat melihat bahasa mana yang menangani banyak permintaan dengan lebih baik dengan menjalankan skrip yang sama dalam JavaScript dan Python. Ini berguna untuk tugas-tugas seperti web scraping atau menguji kinerja situs web di bawah beban berat.

- Pemrograman asinkron dan paralel. Bahasa yang berbeda memperlakukan tugas asinkron secara berbeda. Perbandingan membantu kita memahami seberapa baik setiap bahasa menangani tugas-tugas bersamaan dan apa dampaknya terhadap kinerja.

- Pengembangan, pemeliharaan, dan skalabilitas. Selain kecepatan, kami juga ingin mengetahui betapa mudahnya membuat skrip, memelihara, dan menskalakan dalam bahasa apa pun. Beberapa bahasa mungkin lebih ramah pengguna atau lebih cocok untuk menskalakan proyek.

- Pelajari dan pahami perbedaan bahasa. Kita dapat memahami karakteristik unik, kekuatan dan kelemahan masing-masing bahasa dengan membandingkan contoh-contoh praktis. Ini membantu kita melihat bagaimana bahasa yang berbeda mendekati masalah yang serupa.

Dengan menguji skrip dalam kondisi terkendali, kita dapat mengetahui bahasa mana yang paling sesuai dengan kebutuhan kita. Hal ini juga memungkinkan kami membuat keputusan yang lebih baik terkait pengembangan dan pengoptimalan.

Dalam kasus kami, tes ini dapat membantu Anda mengetahui bahasa mana yang paling cocok untuk Anda. Mari perbaiki skrip JavaScript yang kita gunakan sebelumnya:

const axios = require('axios');

const { performance } = require('perf_hooks');

const url="https://demo.opencart.com";

async function fetch() {

const startTime = performance.now();

await axios.get(url);

const endTime = performance.now();

return endTime - startTime;

}

async function runScraper() {

const requestPromises = Array.from({ length: 10 }, () => fetch());

const times = await Promise.all(requestPromises);

return times;

}

async function main() {

const startTime = performance.now();

const requestTimes = await runScraper();

const totalExecutionTime = performance.now() - startTime;

const sumOfRequestTimes = requestTimes.reduce((a, b) => a + b, 0);

const averageRequestTime = sumOfRequestTimes / requestTimes.length;

console.log(`Total Execution Time: ${totalExecutionTime / 1000} seconds`);

console.log(`Average Request Time: ${averageRequestTime / 1000} seconds`);

}

main().catch(console.error);Sekarang mari kita sesuaikan skrip Python yang dibahas sebelumnya. Kita perlu mengganti perpustakaan permintaan dengan aiohttp dan asyncio agar program kita dapat berjalan secara asinkron. Dari segi fungsionalitas, kami mereplikasi skrip JavaScript:

import aiohttp

import asyncio

import time

url="https://demo.opencart.com"

async def fetch(session, url):

start_time = time.time()

async with session.get(url) as response:

await response.text()

end_time = time.time()

return end_time - start_time

async def run_scraper():

async with aiohttp.ClientSession() as session:

tasks = (fetch(session, url) for _ in range(5))

times = await asyncio.gather(*tasks)

return times

async def main():

start_time = time.time()

request_times = await run_scraper()

total_execution_time = time.time() - start_time

average_request_time = sum(request_times) / len(request_times)

print(f"Total Execution Time: {total_execution_time} seconds")

print(f"Average Request Time: {average_request_time} seconds")

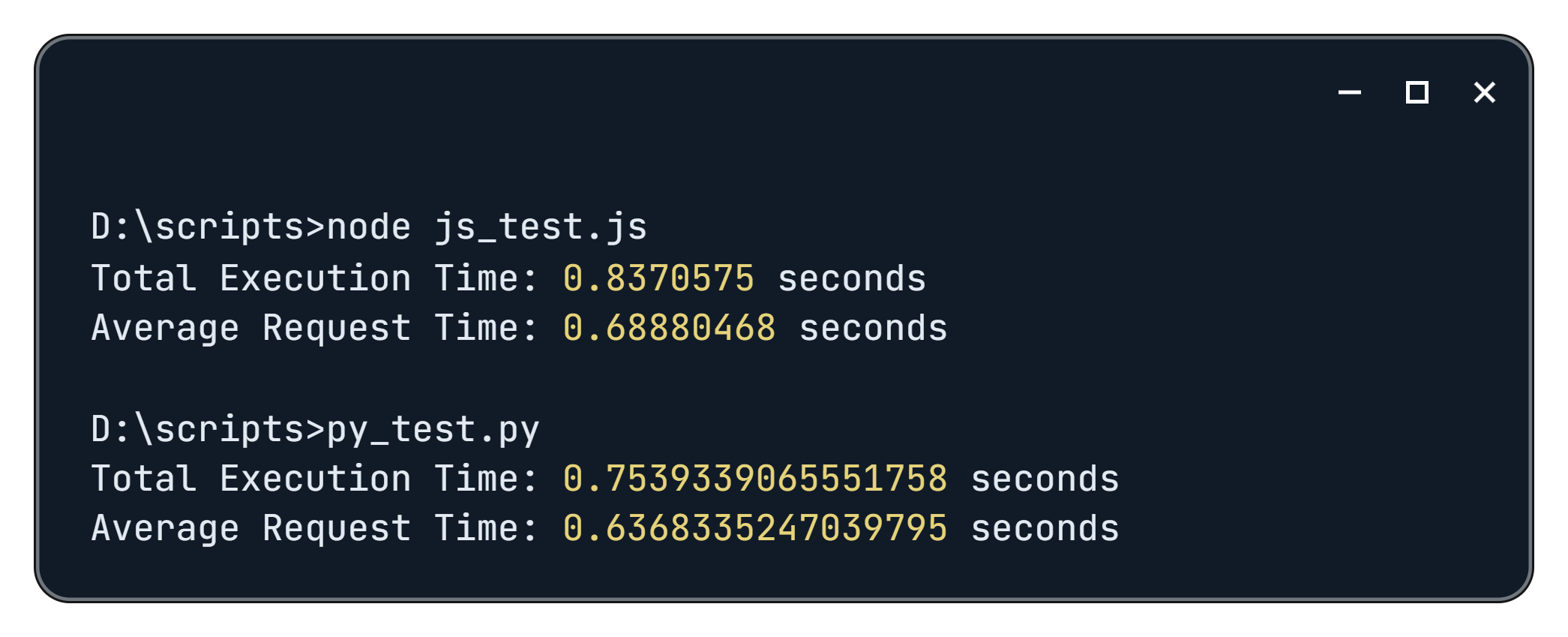

asyncio.run(main())Ketika dijalankan kita mendapatkan hasil sebagai berikut:

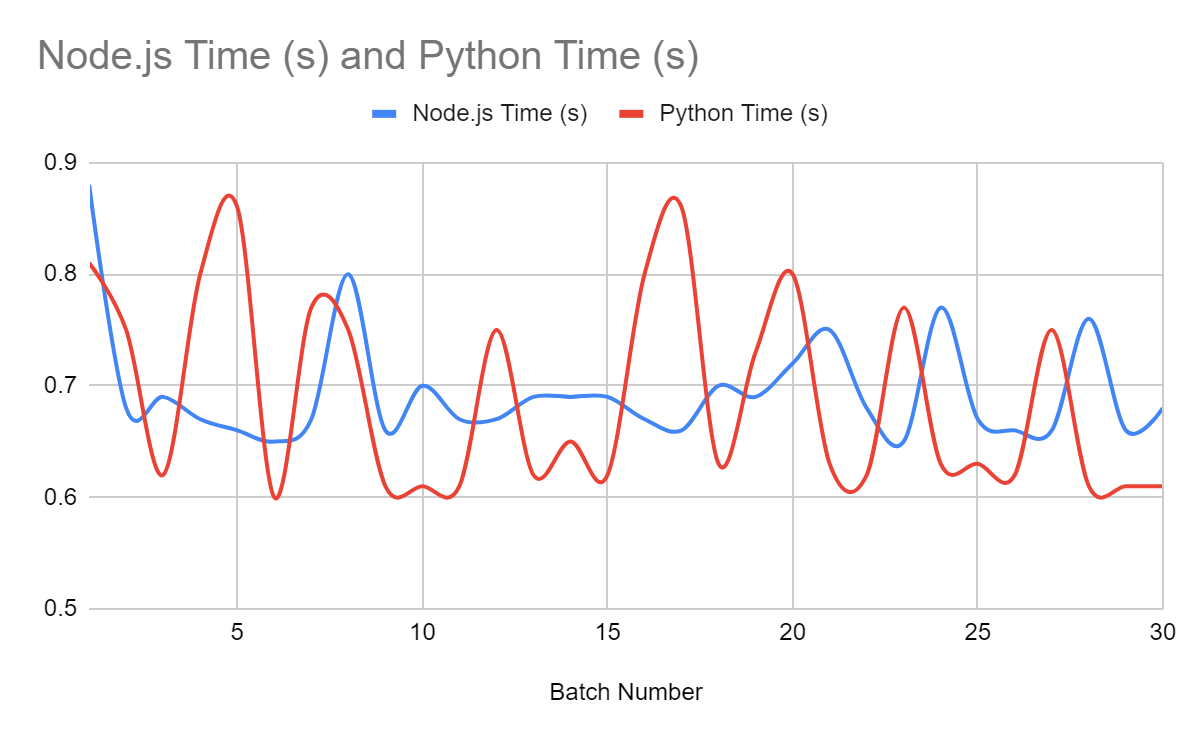

Jangan menarik kesimpulan berdasarkan satu pengujian saja. Kami menjalankan skrip 30 kali dalam satu putaran untuk mendapatkan hasil yang lebih andal. Dengan cara ini kami mengumpulkan data yang cukup untuk analisis yang lebih baik.

Grafik menunjukkan bahwa Python dan JavaScript menghasilkan hasil yang serupa ketika berhubungan dengan web scraping. Artinya, pilihan bahasa pemrograman mungkin tidak terlalu penting saat membuat web scraper. Kedua bahasa tersebut bekerja sama baiknya dalam tugas ini.

Kesimpulan dan temuan

Saat memilih bahasa pemrograman untuk web scraping, keputusan Anda sangat bergantung pada pemahaman Anda dengan bahasa tersebut dan persyaratan proyek. Jika Anda mengetahui Python, Anda mungkin akan lebih mudah menulis scraper yang lebih efisien daripada JavaScript, meskipun JavaScript memiliki kelebihan. Jika Anda baru mengenal pemrograman, penting untuk mempertimbangkan kekuatan dan kelemahan setiap bahasa untuk menemukan solusi terbaik untuk proyek Anda.

Kapan harus memilih JavaScript

JavaScript adalah pilihan terbaik jika:

- Anda sudah familiar dengan JavaScript.

- Anda perlu mengintegrasikan scraper ke dalam proyek berbasis JavaScript.

- Proyek Anda berisi elemen yang memerlukan JavaScript agar berfungsi dengan baik.

Misalnya, jika Anda membuat ekstensi browser yang perlu mengumpulkan data dari halaman web, JavaScript adalah pilihan yang tepat karena dijalankan langsung di lingkungan browser. Hal yang sama berlaku jika Anda mengembangkan alat untuk Google Spreadsheet yang menggunakan versi sederhana JavaScript yang disebut Google Apps Script untuk berinteraksi dengan dan memanipulasi data spreadsheet.

Kapan harus memilih Python

Python adalah pilihan terbaik jika:

- Anda sudah familiar dengan Python.

- Ini adalah bahasa pemrograman pertama Anda.

- Apakah Anda tidak hanya ingin mengumpulkan data, tetapi juga menganalisis dan mengolahnya dalam skrip yang sama?

Python sangat bagus untuk proyek yang melibatkan analisis data dan pembelajaran mesin, menjadikannya ideal untuk tugas-tugas yang memerlukan pemrosesan dan interpretasi kumpulan data besar. Pustaka dan alatnya yang luas menjadikannya pilihan yang ampuh untuk mengumpulkan dan menganalisis data secara efisien.