Bagaimana perekrut dapat memperoleh manfaat dari web scraping?

Menemukan talenta yang Anda butuhkan untuk bisnis Anda sangat penting untuk kesuksesan, namun bisa memakan waktu dan membosankan. Ada banyak agensi dan karyawan yang dapat ditemukan dan banyak database yang harus dicari. Untungnya, scraper dapat mengotomatiskan beberapa pekerjaan.

Teknik pengikisan data adalah cara yang menghemat waktu dan hemat biaya untuk menemukan lowongan pekerjaan yang paling relevan. Ini juga merupakan cara yang baik bagi pencari kerja individu untuk mendapatkan semua informasi yang mereka butuhkan tentang suatu perusahaan atau institusi.

Perusahaan dan institusi juga menggunakan metode ini untuk menentukan posisi mana yang dibutuhkan di pasar tenaga kerja, keterampilan apa yang dibutuhkan, berapa gaji yang harus ditawarkan kepada calon kandidat, dan lain-lain.

Layanan web scraping membantu mengekstrak informasi dari berbagai sumber seperti media sosial, papan pekerjaan, atau situs web lain. Data yang diekstrak kemudian dapat dianalisis menggunakan berbagai alat analisis untuk mengetahui tipe orang seperti apa yang paling cocok untuk pekerjaan tersebut. Analisis data yang konstan adalah proses mendasar yang membantu mengambil keputusan dan meningkatkan efisiensi perusahaan.

Alat pengikis web memungkinkan Anda mencari dengan cepat dan efisien:

- Karyawan baru;

- Perusahaan yang beroperasi di industri sasaran;

- Objek tertentu yang menarik minat Anda.

Dalam kasus terakhir, kriterianya bisa spesifik. Dengan bantuan Pengikisan web Misalnya, Anda dapat dengan mudah menemukan daftar semua calon karyawan yang tinggal di New York, memiliki pengalaman profesional lebih dari lima tahun, dan sedang mencari pekerjaan.

Katakanlah Anda perlu mencari pengembang C++ dengan pengalaman sepuluh tahun, portofolio, dan banyak proyek di GitHub dan secara aktif mencari pekerjaan.

Untuk melakukan hal ini, Anda harus terlebih dahulu mencari semua calon karyawan yang saat ini menganggur. Layanan Monster, Indeed, dan LinkedIn cocok untuk ini. Hasil pencarian dapat dirayapi menggunakan scraper dan diringkas dalam tabel praktis yang nantinya dapat dianalisis dengan mudah. Katakanlah kita hanya tertarik pada nama belakang, tautan profil, pengalaman kerja, ketersediaan pekerjaan saat ini, dan tautan GitHub.

Setelah tabel difilter berdasarkan pengalaman kerja, ketersediaan pekerjaan, dan tautan GitHub, Anda dapat melanjutkan ke bagian analisis proyek. Untuk melakukan ini, Anda perlu mengikuti tautan semua pengguna dan mengumpulkan data tentang proyek mereka. Ini cukup untuk memahami minat seseorang, tingkat pengetahuan dan keterampilan apa yang dimilikinya, dan bahasa apa yang bisa ia tulis.

Dan bagian terbaiknya adalah semua informasi ini dapat diambil secara otomatis. Dan jika Anda sudah memiliki data seperti itu, Anda bisa belajar banyak tentang seorang karyawan.

Cari kandidat yang paling memenuhi syarat

Sebelum Anda menerima informasi ini, Anda harus memutuskan bagaimana Anda akan menerimanya. Ada beberapa cara untuk mendapatkan data tersebut secara otomatis:

- Pembelian alas yang sudah jadi sesuai kriteria tertentu. Namun, perlu diingat bahwa database semacam itu sering kali harus dibeli dan tidak selalu ada jaminan kualitas atau kelengkapannya.

- Penggunaan alat pengikis yang sudah jadi. Opsi ini lebih murah dibandingkan opsi sebelumnya dan memungkinkan Anda memutuskan data mana yang akan dikikis, namun tidak fleksibel. Oleh karena itu, mereka mungkin tidak berfungsi di situs web dengan struktur yang rumit.

- Mengembangkan aplikasi pengumpulan data baru dari awal. Namun, kemudian Anda perlu mengambil berbagai tindakan terhadap pemblokiran IP, mencari proxy, menghubungkan layanan penyelesaian captcha, dan banyak lagi.

- Buat infrastruktur internal untuk mengumpulkan data menggunakan API web scraping yang membantu mengatasi semua masalah umum web scraping yang kami cantumkan di paragraf sebelumnya.

Penting untuk memahami kelebihan dan kekurangannya untuk memutuskan opsi mana yang cocok. Membeli pangkalan baru adalah pilihan termudah dan termahal. Selain itu, Anda bukanlah orang yang memiliki akses terhadap data yang diterima, tetapi juga menyediakannya. Jadi data Anda bisa dijual kembali lebih dari satu kali. Lebih jauh lagi, relevansinya kemudian dipertanyakan.

Menggunakan alat pengikis yang sudah jadi, seperti disebutkan di atas, merupakan alat yang lebih murah tetapi kurang fleksibel. Biasanya, tidak selalu mudah untuk menerima data hanya dalam bentuk yang disediakan oleh pengembang.

Secara otomatis mengumpulkan data pasar tenaga kerja

Pengikisan web adalah cara terbaik untuk mendapatkan akses real-time ke pasar kerja. Cepat, efisien, dan memberi Anda semua data yang Anda inginkan.

- 1.000 kredit API gratis

- Tidak diperlukan kartu kredit

- Uji coba 30 hari

Mengembangkan aplikasi Anda adalah solusi yang baik, tetapi hanya untuk orang-orang dengan pengetahuan pemrograman yang luas atau untuk staf pemrogram dan analis. Namun kelebihannya adalah aplikasi tidak bergantung pada siapa pun. Kemudian muncul masalah melewati kunci.

Dan opsi terakhir adalah menciptakan infrastruktur pengikisan pekerjaan internal. Ini optimal dan memungkinkan Anda mendapatkan data terkini dengan biaya rendah tanpa harus khawatir tentang proxy dan pemblokiran.

Dua opsi pertama tidak memerlukan penjelasan rinci. Ketiga, kami memiliki beberapa artikel:

- Pengantar pengikisan situs web dengan Axios dan Cheerio

- Pengikisan web dengan C#

- Scraping Web dengan Python: Dari Dasar hingga Latihan

- Pengikisan web dengan Selenium Python

Oleh karena itu, pada artikel ini kami akan fokus pada opsi terakhir.

Mengumpulkan data SDM menggunakan Web Scraping API

Untuk menggunakan API web scraping, daftar ke layanan kami. Setelahnya, Anda akan menerima 1000 kredit API gratis yang dapat Anda gunakan untuk pengujian selama sebulan.

Untuk memahami cara kerja permintaan dan cara menyusunnya, kami menggunakan pembuat khusus. Anda bisa menggunakan bidang di sisi kanan jendela untuk mengkustomisasi kueri dan kemudian menjalankan kueri yang dihasilkan. Yuk dapatkan data dari Indeed Find Jobs.

Misalnya, kami menggunakan kueri “Pengembang”. Di bidang URL, tempelkan link ke halaman hasil pencarian. Jika Anda menjalankan scraper sekarang, Anda akan mendapatkan kode sumber halaman yang perlu diproses lebih lanjut untuk mengekstrak data yang diinginkan.

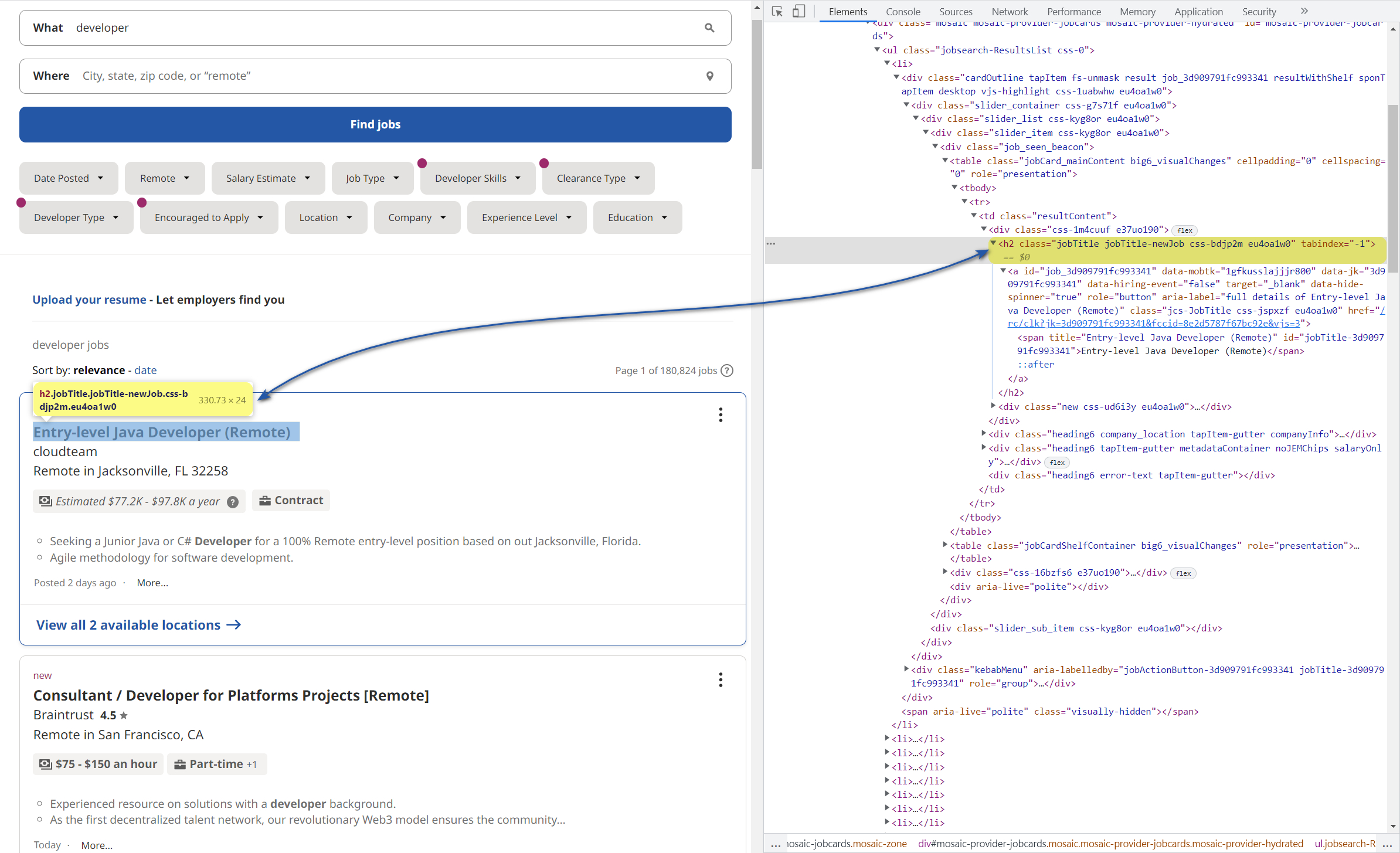

Untuk segera mendapatkan data yang Anda perlukan dalam format JSON, gunakan “Aturan Ekstraksi”. Untuk melakukan ini, buka situs web halaman hasil Indeed dan jelajahi. Untuk melakukan ini, buka DevTools (F12) dan pilih judul apa pun untuk mendapatkan kodenya.

Selanjutnya, klik kanan elemen di kolom kode dan salin pemilihnya. Dalam kasus kami, pemilih jabatan terlihat seperti ini:

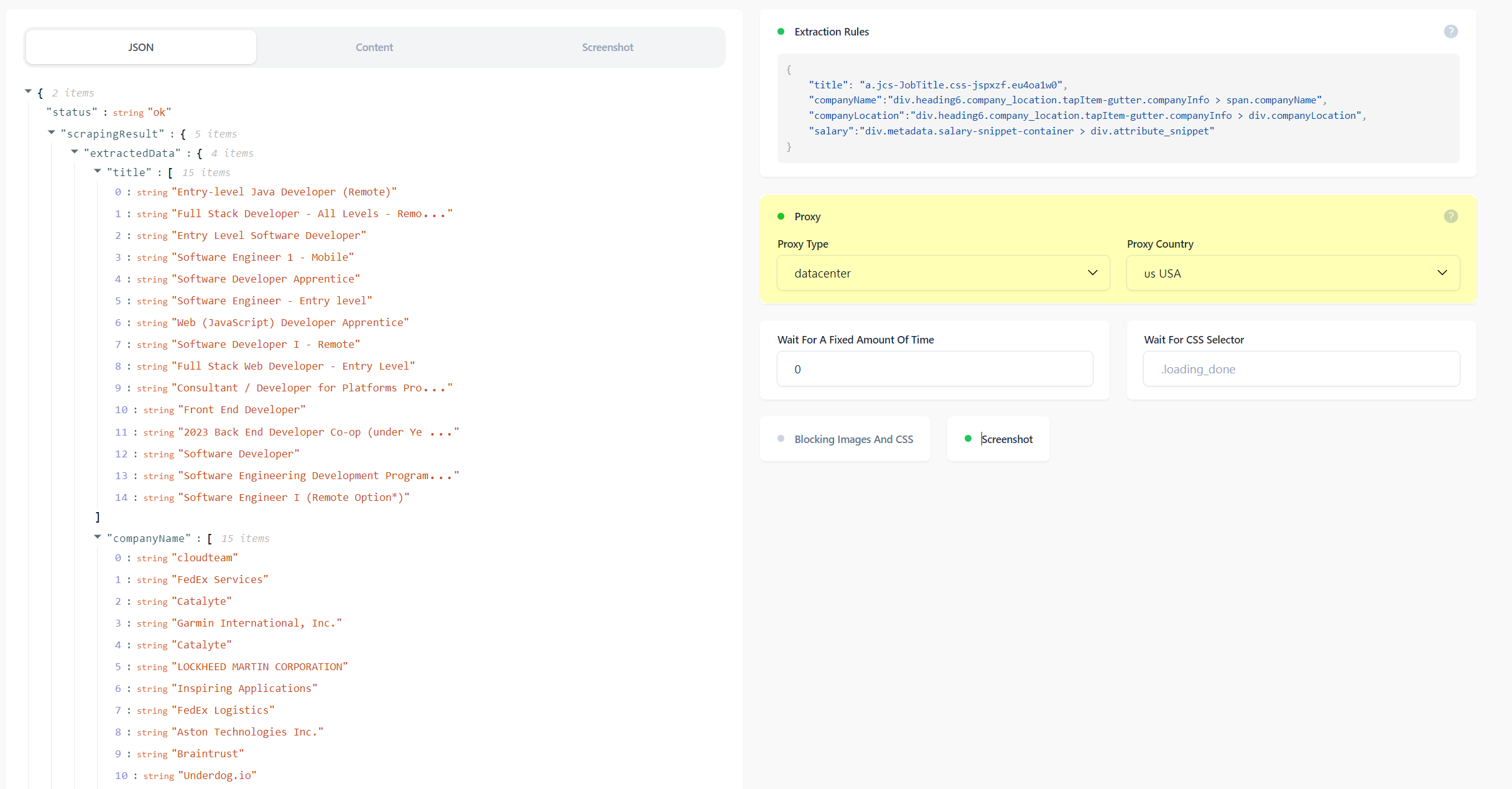

a.jcs-JobTitle.css-jspxzf.eu4oa1w0Sekarang jika Anda memasukkan pemilih yang dihasilkan ke dalam aturan ekstraksi, hasil kueri akan jauh lebih baik:

Demikian pula, di situs perekrutan, Anda benar-benar bisa mendapatkan semua data berharga yang akan mempermudah pencarian calon karyawan. Misalnya, Anda dapat menggunakan aturan berikut untuk mengambil jabatan, nama perusahaan, lokasi, dan gaji.

{

"title": "a.jcs-JobTitle.css-jspxzf.eu4oa1w0",

"companyName":"div.heading6.company_location.tapItem-gutter.companyInfo > span.companyName",

"companyLocation":"div.heading6.company_location.tapItem-gutter.companyInfo > div.companyLocation",

"salary":"div.metadata.salary-snippet-container > div.attribute_snippet"

}Buat permintaan melalui proxy dan putar sesuai kebutuhan

Jika, saat membuat scraper, Anda perlu memperhatikan cara mengumpulkan kumpulan proxy IP dan mengonfigurasi modifikasinya, saat menggunakan API cukup mengaktifkan fungsi yang sesuai:

Ada dua jenis proxy: proxy penduduk dan proxy pusat data. Perbedaan utamanya adalah proxy swasta disediakan oleh penyedia, tetapi pusat data tidak. Perlu dicatat bahwa permintaan akan proxy pusat data tinggi.

Secara umum, proxy memungkinkan situs untuk mengenali bukan komputer Anda, tetapi komputer lain dari negara yang ditentukan.

Isu lain yang diangkat adalah captcha. Untuk menghindarinya, browser tanpa kepala digunakan dan layanan khusus digunakan untuk menyelesaikannya. Namun masalah ini juga bisa dilupakan saat menggunakan API.

Kesimpulan dan temuan

Pengikisan web untuk perekrut adalah alat utama untuk menemukan karyawan terbaik dengan cepat dan efisien. Ini membantu Anda melakukan segalanya mulai dari menemukan kandidat yang memenuhi syarat dalam hitungan menit hingga menyaring kandidat terpilih dan menemukan kandidat yang tepat untuk Anda. Tentu saja, membeli basis yang sudah dibangun akan menghemat waktu, tetapi membangun infrastruktur berbasis API adalah solusi sederhana, fleksibel, dan kaya fitur untuk mengumpulkan data SDM dengan web scraping.

Selain itu, cukup mengatur dan melakukan semuanya satu kali, dan kemudian Anda bisa mendapatkan data serupa secara otomatis. Untuk meyakinkan hal ini, cukup mencobanya sekali, dan Anda dapat melakukannya secara gratis.