Kecerdasan Buatan (AI) telah menjadi bidang sistem komputer yang berkembang pesat yang dapat melakukan tugas-tugas yang membutuhkan kecerdasan manusia dengan sempurna.

Statistik memperkirakan bahwa ukuran pasar AI diperkirakan akan mencapai $738,80 miliar pada tahun 2030. Hal ini pada dasarnya berarti bahwa permintaan terhadap layanan terkait AI semakin meningkat, sehingga berdampak pada perluasan pasar.

Sistem AI dibuat dengan mengumpulkan dan melatih data dalam jumlah besar dan mengenali pola informasi yang berbeda. Artinya AI mampu memberikan rekomendasi, mengambil keputusan, menawarkan solusi dan melakukan prediksi.

Membuat model AI yang efektif dan akurat memerlukan kumpulan data yang beragam, komputer yang kuat, dan algoritma yang canggih. Pengikisan web memungkinkan kami memenuhi kebutuhan ini dengan mengumpulkan data dari kumpulan data yang luas dan beragam di Internet.

Memahami pengikisan web

Pengikisan web adalah proses mengekstraksi sejumlah besar data dari berbagai situs web secara otomatis, manual, atau hibrid. Berbagai alat dan perangkat lunak dapat digunakan untuk mengambil data dari platform e-commerce dan media sosial. Hal ini memungkinkan perusahaan memperoleh wawasan yang berarti, menghasilkan prospek, melakukan riset pasar dan analisis persaingan, memantau harga, dan banyak lagi.

Ada berbagai penyedia layanan ekstraksi data yang tersedia di pasar. Mereka membantu perusahaan mengambil data mentah dari Internet ke dalam database dan spreadsheet yang terorganisir dengan baik. Mereka juga menyediakannya melalui API (Application Programming Interfaces).

Dengan munculnya AI dan pembelajaran mesin, banyak bidang yang menggunakan AI dalam berbagai fungsi. Misalnya, e-commerce telah mengadaptasi AI untuk mengoptimalkan dan mengotomatisasi tugas berulang seperti chatbots untuk permintaan pengguna. Demikian pula, layanan kesehatan, kedokteran, periklanan pemasaran, pendidikan, penambangan data, dan keamanan siber juga telah mengintegrasikan AI ke dalam sistem mereka.

Algoritme yang mendasari AI di bidang tersebut perlu dilatih, dan hal ini memerlukan data dalam jumlah besar.

Oleh karena itu, layanan web scraping yang luar biasa seperti kami (Grepsr) secara efektif mengumpulkan dan membersihkan data dalam jumlah besar agar Anda dapat membuat database pelatihan untuk model AI.

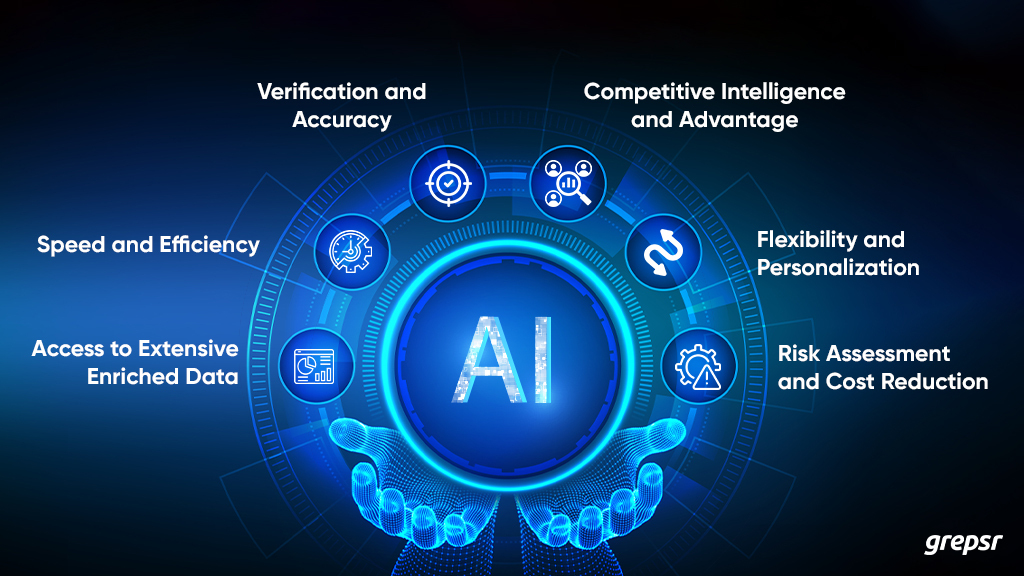

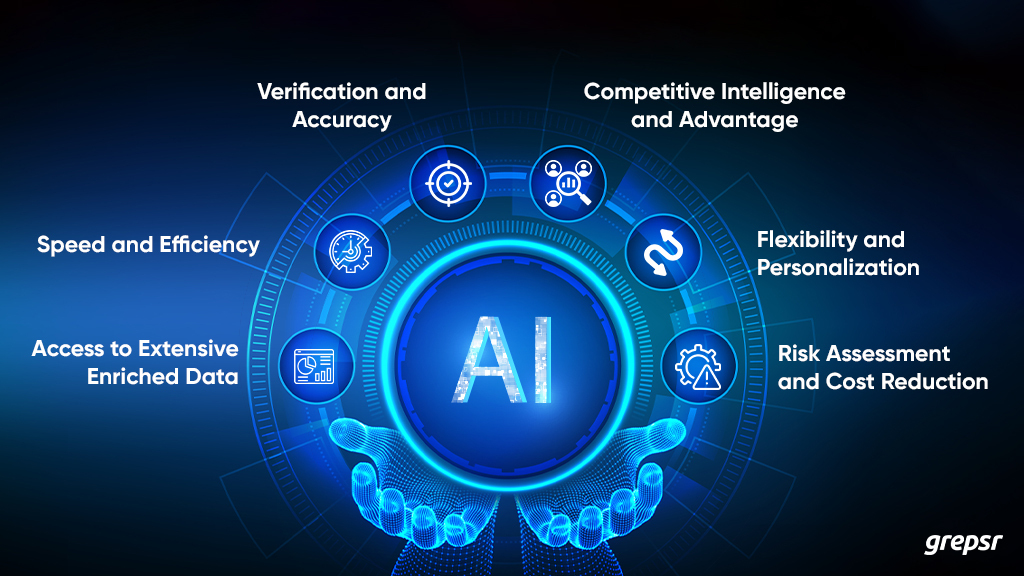

Pentingnya web scraping untuk AI

Berikut beberapa hal lagi yang menjelaskan mengapa AI memerlukan web scraping:

1. Akses terhadap data ekstensif yang diperkaya

Seperti yang kita ketahui, membangun model kecerdasan buatan dan pembelajaran mesin di berbagai sistem memerlukan upaya pelatihan dan pengujian yang signifikan. Hal ini memerlukan banyak kumpulan data dari Internet untuk setiap informasi tertentu.

Pengikisan web sangat penting untuk hal ini karena memberikan peluang bagi perusahaan untuk mengumpulkan data dari Internet. Ini adalah arsip data ekstensif dari berbagai sumber. Untuk membuat aplikasi AI yang berfungsi secara efektif, web scraping membantu dengan seringnya perubahan dan peningkatan yang dapat dilakukan pada algoritme.

Hasilnya, model AI menjadi semakin baik dalam menyediakan informasi penting dan berfungsi secara efektif. Hal ini dimungkinkan karena algoritme mampu beradaptasi dengan berbagai kumpulan data kompleks dan mengekstrak informasi baru dari kumpulan data tersebut.

2. Kecepatan dan efisiensi

Dengan terus menguji model AI untuk memberikan kinerja dan hasil yang lebih lancar dan lebih baik setiap saat, web scraping secara bersamaan meningkatkan kecepatan dan efisiensi. Perusahaan dapat menangkap data dalam jumlah besar dengan cepat dan efektif dengan mengotomatiskan proses ekstraksi data menggunakan layanan web scraping.

Pengikisan web otomatis memungkinkan Anda menghindari proses yang membosankan dalam mengumpulkan data dalam jumlah besar secara manual dari situs web. Hal ini membantu mencapai kesimpulan dengan lebih cepat dan menyelesaikan tugas dengan ahli seperti menemukan prospek dan menganalisis perilaku pengguna.

3. Verifikasi dan Akurasi

Pengikisan web otomatis membantu sistem AI selalu mengamankan informasi real-time atau terkini untuk memvalidasi prediksi yang mendekati akurasi. Dengan mengotomatiskan proses pengumpulan data dan menghapus materi yang tidak relevan atau salah, web scraping dapat memastikan keandalan dan keabsahan data.

Perusahaan dapat memperoleh manfaat dari informasi yang lebih akurat untuk memodelkan algoritma AI dan pembelajaran mesin mereka. Analisis pola dan prosedur pembersihan data yang berteknologi maju meningkatkan kemungkinan pengambilan keputusan didasarkan pada data yang akurat dan terverifikasi.

4. Kecerdasan dan keunggulan kompetitif

Sistem AI yang menggunakan web scraping memiliki keunggulan kompetitif di pasar. Mereka mampu mengumpulkan tren terkini, review produk dan opini konsumen dari review dan media sosial.

Dengan mengamati preferensi pelanggan, pola harga, umpan balik pelanggan, dan strategi bersaing, web scraping memberi perusahaan keunggulan dibandingkan pesaing mereka. Dengan mengumpulkan dan mengevaluasi data berkualitas tinggi, perusahaan dapat memperoleh pemahaman yang lebih mendalam tentang pasar mereka sambil membuat keputusan yang lebih baik.

Oleh karena itu, perusahaan dengan sistem AI mendapatkan keuntungan yang signifikan dari penggunaan alat web scraping. Anda dapat memantau situs web pesaing, ulasan mereka, strategi penetapan harga, dan tren pasar berdasarkan perilaku pelanggan dan mengambil tindakan yang tepat.

5. Fleksibilitas dan personalisasi

Pengikisan web dapat disesuaikan agar sesuai dengan preferensi khusus perusahaan. Mereka bebas mengumpulkan dan menganalisis data tertentu yang berharga bagi mereka dari berbagai database dan mencapai tujuan mereka sesuai dengan industrinya.

Layanan web scraping yang dipersonalisasi menawarkan solusi yang disesuaikan untuk bisnis, memungkinkan mereka memanfaatkan kekuatan AI dan sistem pembelajaran mesin. Hal ini memungkinkan perusahaan untuk menggunakan data penting secara strategis, sehingga menghasilkan peningkatan layanan dan mendorong pertumbuhan di sektor masing-masing.

Selain itu, sistem berbasis AI mengandalkan data yang disediakan pengguna untuk menampilkan informasi yang dipersonalisasi. Dengan demikian, web scraping membantu dalam mengumpulkan dan menganalisis perilaku pengguna situs web dan media sosial untuk personalisasi algoritma yang lebih baik untuk setiap pengguna.

6. Penilaian risiko dan pengurangan biaya

Pengikisan web yang didukung kecerdasan buatan menghilangkan kebutuhan akan pekerjaan manual dengan mengotomatiskan proses ekstraksi data. Perusahaan dapat meningkatkan efektivitas dan produktivitas karyawan sekaligus mengurangi biaya operasional dengan memfokuskan kembali karyawan pada tugas-tugas yang lebih penting.

Demikian pula, web scraping dengan kecerdasan buatan di perbankan, lembaga keuangan, dan industri asuransi bahkan dapat membantu mendeteksi dan memantau perilaku penipuan dan potensi risiko kredit. Faktanya, berinvestasi dalam web scraping untuk memajukan kecerdasan buatan mungkin tampak mahal.

Namun, setelah beroperasi, teknologi ini dapat menghemat banyak uang dengan mengurangi biaya ekstraksi dan analisis data lebih lanjut sehingga perusahaan dapat mengambil keputusan yang tepat.

Tantangan dan masalah etika dalam web scraping

Pengikisan web terbukti rumit, terutama bila kecerdasan buatan digunakan.

Ketergantungan pada kualitas data:

Pertama, efektivitas solusi AI bergantung pada persiapan menyeluruh dengan beberapa pengujian dan eksekusi.

Hal ini memerlukan pengaturan keandalan sumber data, penyempurnaan teknik pengumpulan data, dan minimalisasi hambatan teknis.

Bergantung pada seberapa berat pekerjaan web scraping, AI mungkin tidak selalu memberikan jawaban terbaik dan mungkin menghadapi keterbatasan.

Standar hukum dan etika:

Selain itu, saat mengekstraksi data, penting untuk mematuhi standar hukum dan etika untuk melindungi privasi pengguna dan keamanan data.

Untuk memastikan privasi data Anda selama web scraping, langkah-langkah keamanan yang ketat harus diterapkan. Hal ini mencakup integrasi teknologi enkripsi canggih, kontrol akses kredensial yang ketat, dan anonimisasi pengguna.

Oleh karena itu, langkah-langkah yang diterapkan Grepsr ini secara kolektif melindungi informasi sensitif dan mempertahankan standar perlindungan data tertinggi.

Masa depan web scraping

Saat ini, penyedia layanan web scraping seperti Grepsr sudah familiar dengan web scraping berbasis AI dan siap membantu perusahaan dengan tujuan pengumpulan datanya sendiri.

Ke depan, kami mengharapkan inovasi berkelanjutan dalam web scraping. Selain kecerdasan buatan dan pembelajaran mesin, alat pengikis berpotensi berkembang menjadi sistem yang lebih cerdas.

Ini dapat memahami hubungan, beradaptasi secara instan terhadap perubahan situs web, dan bahkan memprediksi pola data. Namun, kita juga dapat memperkirakan bahwa situs web akan mengambil tindakan defensif yang lebih kuat seiring dengan meningkatnya kekhawatiran mengenai keamanan dan kerahasiaan data. Hal ini akan memberikan lebih banyak peluang bagi pendukung privasi dan ekstraktor data untuk melampaui batasan mereka.

Dengan perkembangan era digital modern dan kemajuan teknologi baru blockchain, masa depan web scraping memiliki potensi tantangan besar dan peluang yang lebih besar lagi.

Kesimpulannya

Selanjutnya, di era digital, web scraping sangat penting untuk pengumpulan otomatis data berskala besar dari berbagai sumber. Misalnya website online dan media sosial untuk mencatat perilaku pengguna, tren pasar, strategi pemantauan harga dan tujuan pribadi lainnya.

Agar AI berfungsi dan berkinerja terbaik, diperlukan sejumlah besar pengetahuan tentang setiap topik, yang dapat diberikan melalui web scraping yang disesuaikan untuk mendapatkan data berharga.

Oleh karena itu, web scraping yang didukung AI menawarkan banyak keuntungan di pasar. Misalnya, hasil yang dioptimalkan dengan kecepatan dan akurasi tinggi, keunggulan kompetitif, peningkatan efektivitas, fleksibilitas, dan pengurangan biaya.

Grepsr juga memiliki cerita serupa untuk diceritakan tentang terobosan ekstensi web scraping terintegrasi AI “Pline” di blog mendatang. Pantau terus!