Mengumpulkan data pekerjaan dari dewan pekerjaan sangat penting bagi pencari kerja dan perusahaan perekrutan. Pada artikel sebelumnya, kita membahas cara mengumpulkan data tersebut dari jejaring sosial profesional LinkedIn. Hari ini kami fokus pada Indeed, salah satu platform pencarian kerja terbesar.

Indeed memungkinkan pengguna memposting resume, berlangganan pemberitahuan pekerjaan, mencari, menyimpan, dan melamar pekerjaan. Artikel ini akan membahas berbagai metode untuk mengotomatiskan pengumpulan data pekerjaan dari platform ini sehingga Anda bisa mendapatkan informasi yang Anda butuhkan, terlepas dari keahlian pemrograman Anda.

Kasus penggunaan untuk Memang Job Scraping

Sebelum kita membahas praktiknya, mari kita lihat skenario spesifik di mana pengumpulan data Indeed bisa sangat berguna. Singkatnya, ada beberapa alasan penting untuk hal ini:

- Analisis tren pasar tenaga kerja dan identifikasi keterampilan yang dibutuhkan. Dengan menganalisis lowongan pekerjaan di Indeed, Anda bisa mendapatkan wawasan berharga tentang lanskap pasar kerja saat ini, termasuk keterampilan yang paling banyak dibutuhkan dan tren yang sedang berkembang.

- Cari tahu tentang kisaran gaji untuk jabatan dan lokasi pekerjaan tertentu. Indeed menyediakan data gaji untuk berbagai jabatan dan lokasi pekerjaan.

- Kumpulkan data untuk perekrutan dan perolehan bakat. Platform ini berfungsi sebagai sumber data talenta yang kaya dan memungkinkan Anda mengidentifikasi kandidat yang memenuhi syarat, menyaring mereka berdasarkan kriteria tertentu, dan menjangkau calon karyawan baru.

- Lacak aktivitas perekrutan pesaing Anda dan identifikasi calon pelamar. Memantau aktivitas perekrutan pesaing Anda di Indeed dapat memberikan wawasan berharga mengenai kebutuhan dan strategi talenta mereka.

- Melakukan penelitian tentang budaya perusahaan, ulasan karyawan, dan lingkungan kerjaIndeed memberikan akses ke ulasan karyawan dan informasi perusahaan, memberi Anda wawasan tentang budaya perusahaan, lingkungan kerja, dan kepuasan karyawan.

Mari kita lihat masing-masing bidang ini secara lebih rinci.

Analisis pasar tenaga kerja

Analisis berkala terhadap pasar tenaga kerja membantu memantau secara konsisten perubahan dalam perekrutan dan lowongan pekerjaan. Hal ini memungkinkan kami untuk lebih memahami profesional mana yang paling banyak dibutuhkan saat ini, mengidentifikasi tren berdasarkan berbagai kondisi, dan melacak perubahan dalam persyaratan pekerjaan dan keterampilan yang dicari pemberi kerja.

Pendekatan ini membantu pencari kerja tidak hanya lebih memahami persyaratan pemberi kerja, namun juga menilai penawaran dan permintaan untuk posisi dan pekerjaan tertentu.

Penelitian gaji

Alasan lain Indeed mengumpulkan data adalah untuk memperoleh informasi gaji dari lowongan pekerjaan. Ini dapat membantu Anda membandingkan gaji di berbagai wilayah dan industri, serta tingkat pengalaman dan ukuran perusahaan yang berbeda.

Ini dapat membantu Anda menemukan kemungkinan tolok ukur negosiasi gaji selama wawancara. Atau, jika Anda seorang profesional HR, ini dapat membantu Anda memahami gaji yang relevan dengan kriteria yang Anda perlukan, yang dapat membantu saat merekrut karyawan baru.

Rekrutmen dan akuisisi bakat

Bagi Anda sebagai profesional HR, Indeed dapat menjadi alat yang berharga untuk mengoptimalkan proses perekrutan Anda. Dengan menggunakan fitur otomatisasi, Anda dapat mengidentifikasi dan merekrut kandidat potensial secara efisien, sehingga mengurangi tugas manual secara signifikan.

Indeed memungkinkan Anda membuat daftar kandidat yang ditargetkan berdasarkan persyaratan pekerjaan dan keterampilan tertentu. Hal ini memungkinkan Anda berfokus pada orang-orang yang paling memenuhi syarat, sehingga menghemat waktu dan tenaga.

Kecerdasan kompetitif

Dengan mengamati tawaran pekerjaan, Anda dapat lebih memahami persyaratan apa yang dikenakan pesaing Anda terhadap karyawannya. Dengan melacak aktivitas perekrutan pesaing, Anda dapat mengidentifikasi peluang kerja baru dan strategi akuisisi bakat.

Untuk meningkatkan proses Anda dalam menemukan kandidat potensial, Anda dapat mencoba mengadopsi praktik pesaing Anda. Analisis deskripsi pekerjaan mereka untuk memahami profil kandidat ideal mereka dan pertimbangkan bagaimana hal ini dapat membantu meningkatkan profil Anda.

Ikhtisar Memang

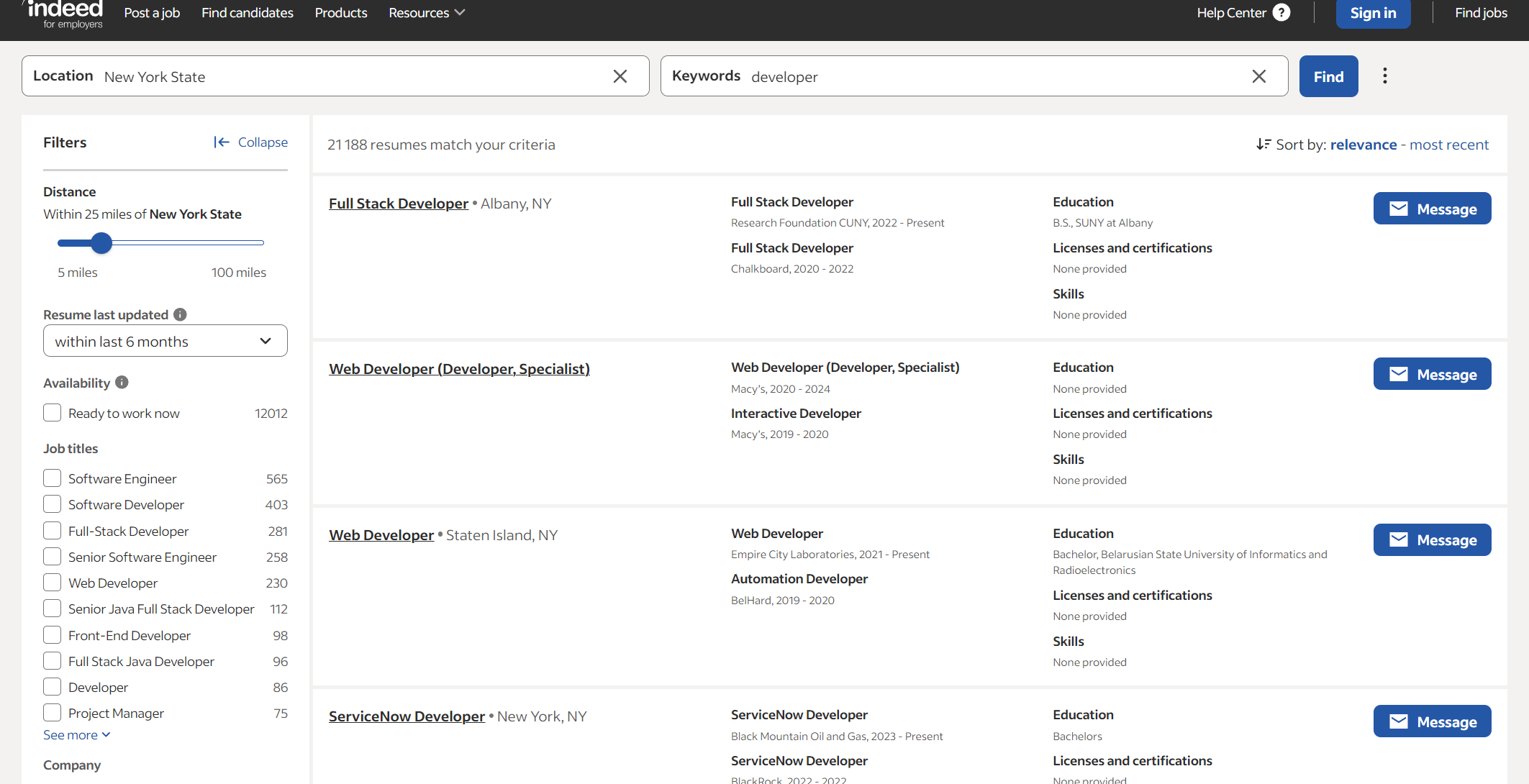

Sekarang mari kita lihat lebih dekat Indeed dan lihat data apa saja yang bisa kita peroleh. Jika kita ingin mengumpulkan data dari pencari kerja, kita perlu membuka halaman pencarian resume, menetapkan lokasi dan kata kunci, yang bisa berupa keahlian atau jabatan, lalu masuk ke halaman hasil.

Seperti yang Anda lihat, Anda tidak dapat melihat informasi pekerjaan secara detail tanpa izin. Keterbatasan informasi yang Anda terima mungkin tidak cukup. Itu sebabnya kami tidak berhenti mencari kandidat.

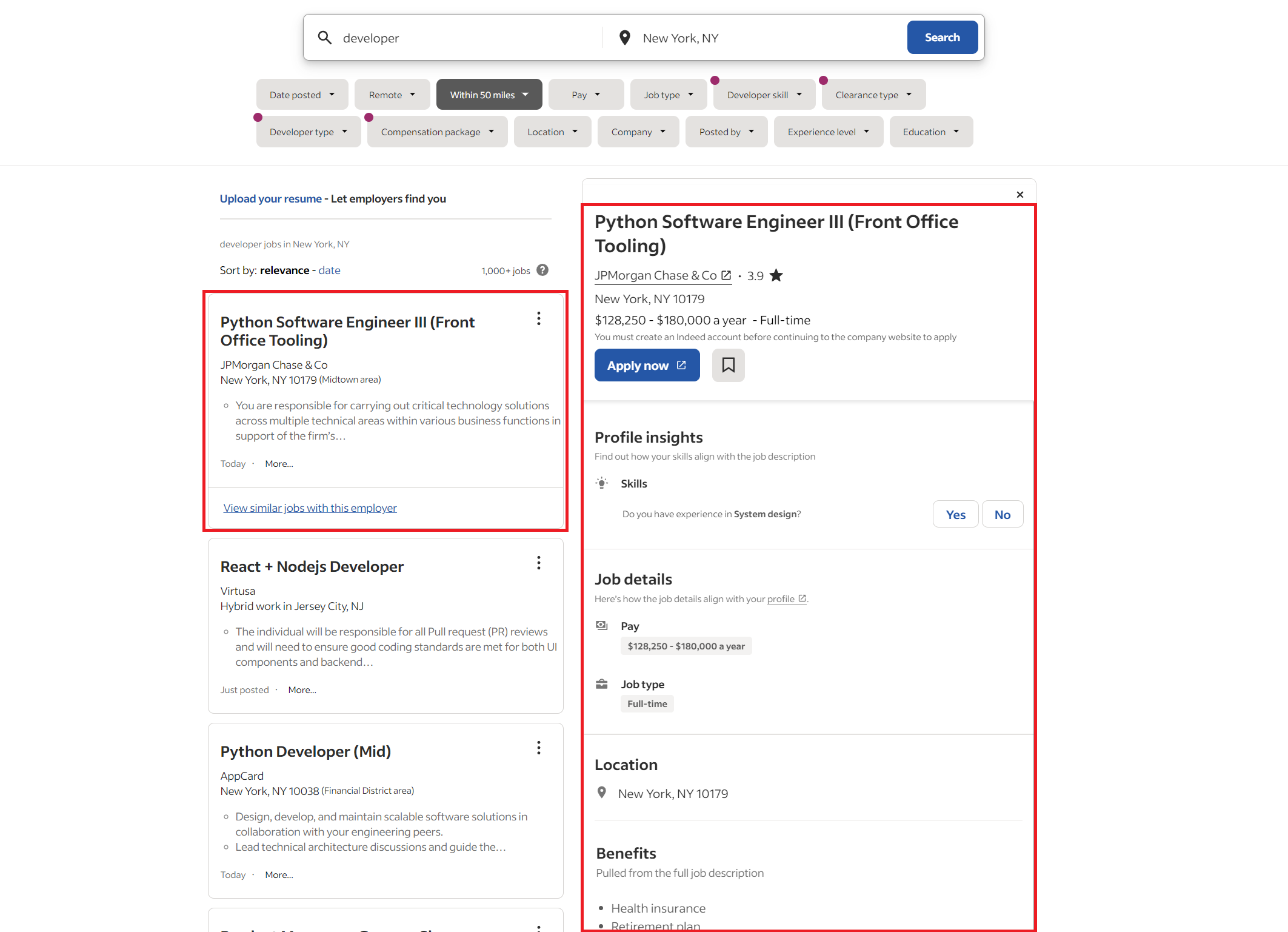

Mari beralih ke halaman pencarian kerja dan temukan semua posisi pengembang yang tersedia.

Daftar pekerjaan yang disajikan di sini memberikan gambaran menyeluruh tentang posisi yang tersedia. Di sisi kiri Anda akan menemukan ikhtisar semua posisi terbuka, sedangkan sisi kanan menawarkan informasi rinci tentang posisi saat ini.

Misalkan Anda perlu mengumpulkan data tentang pekerjaan tertentu. Dalam hal ini, saat ini Anda memiliki dua opsi: Anda dapat menavigasi ke setiap pekerjaan secara manual, mengkliknya dan mengumpulkan informasi terperinci satu per satu, atau membatasi diri Anda pada informasi singkat dalam daftar pekerjaan umum.

Memilih metode pengikisan

Metode yang Anda pilih untuk mengumpulkan data dari Indeed bergantung pada kebutuhan spesifik Anda, keahlian pemrograman, persyaratan volume data, dan kecepatan pengumpulan data yang diinginkan. Berikut rincian tiga opsi utama:

- Pengumpulan data secara manual. Metode ini melibatkan penyalinan dan penempelan data secara manual dari lowongan pekerjaan Indeed ke dalam spreadsheet atau format penyimpanan data lainnya. Metode ini cocok untuk tugas pengumpulan data kecil yang hanya dilakukan satu kali dan tidak memerlukan pengetahuan pemrograman apa pun. Namun, hal ini memakan waktu, membosankan, rawan kesalahan, dan tidak dapat diskalakan untuk kumpulan data besar.

- Menggunakan Scraper Tanpa Kode Memang yang telah dibuat sebelumnya. Banyak sekali Pengikisan webLayanan menawarkan scraper Indeed bawaan yang memungkinkan Anda mengekstrak data tanpa coding. Pencakar ini menyediakan antarmuka yang ramah pengguna dan mengirimkan file data terstruktur. Namun, mereka tidak memiliki fleksibilitas dan opsi penyesuaian, dan Anda terbatas pada data yang dapat diekstraksi oleh scraper.

- Buat Scraper Memang Anda sendiri. Saat Anda membuat scraper sendiri menggunakan bahasa pemrograman seperti Python atau Node.js, Anda memiliki kendali penuh dan kemampuan untuk menyesuaikannya. Anda dapat menyesuaikan scraper untuk memenuhi kebutuhan data spesifik Anda dan mengubahnya seiring perubahan situs web Indeed. Namun, hal ini memerlukan pengetahuan pemrograman dan pemeliharaan berkelanjutan.

- Menggunakan API Memang. Meskipun API resmi Indeed tidak menyediakan fungsi pengikisan data langsung, Anda dapat menggunakan API pengikisan pihak ketiga yang terhubung ke Indeed dan mengekstrak data berdasarkan kriteria Anda. API ini menyediakan data terstruktur dalam format JSON, sehingga Anda tidak perlu membuat kode atau mengelola scraper.

Metode terbaik bergantung pada keadaan spesifik Anda. Untuk pengumpulan data kecil dan satu kali, pengumpulan data manual atau scraper yang sudah dibuat sebelumnya adalah opsi yang cocok. Pada saat yang sama, membuat scraper Anda sendiri atau menggunakan API pihak ketiga untuk pengumpulan data yang sering atau kebutuhan data tertentu memberikan lebih banyak fleksibilitas dan kontrol. Untuk pengumpulan data berkelanjutan sebagai pengembang, menggunakan API pihak ketiga atau membuat scraper dengan mempertimbangkan pemeliharaan adalah opsi yang efisien.

Metode 1: Mengikis data Indeed tanpa kode

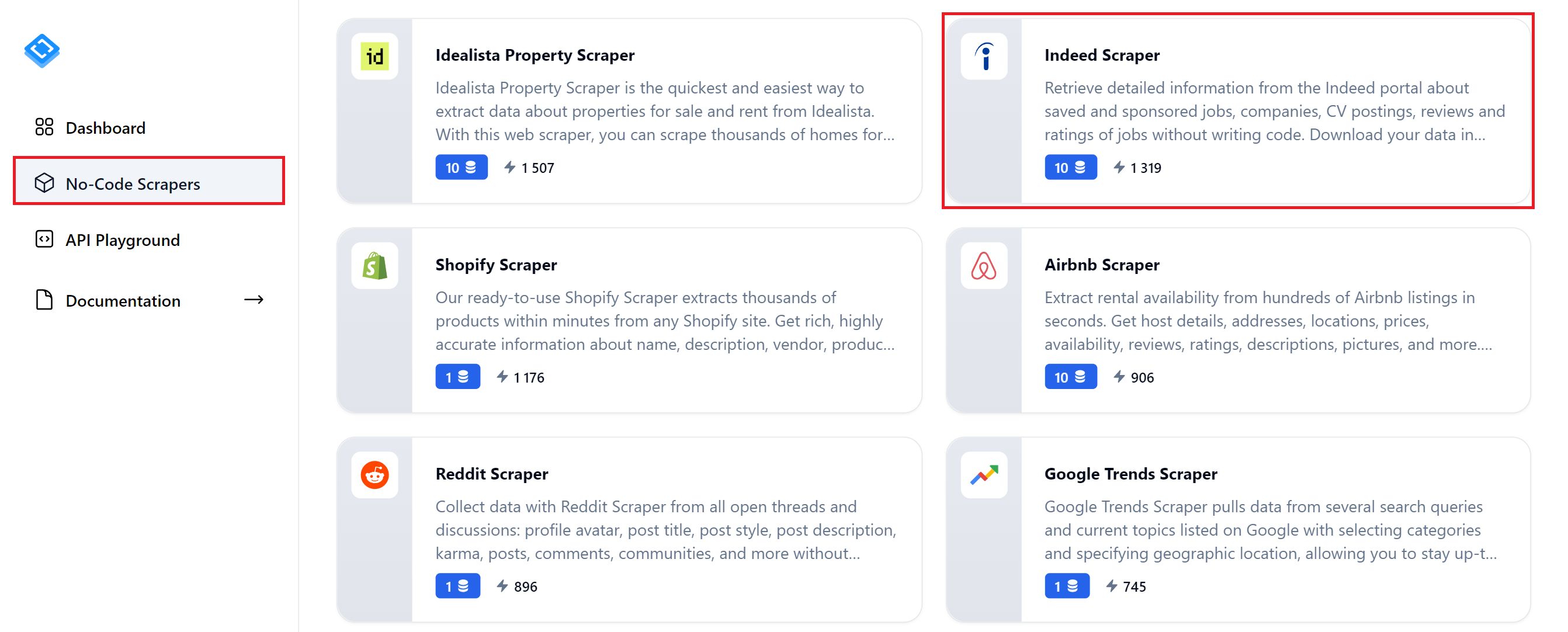

Mari kita mulai dengan metode paling sederhana dan jelajahi bagaimana Anda dapat dengan cepat mengumpulkan data pekerjaan menggunakan scraper tanpa kode HasData Memang. Untuk menggunakan alat ini, daftar di situs web kami dan navigasikan ke tab No-Code Scraper di dasbor Anda. Temukan "Memang Scraper" dan klik di atasnya.

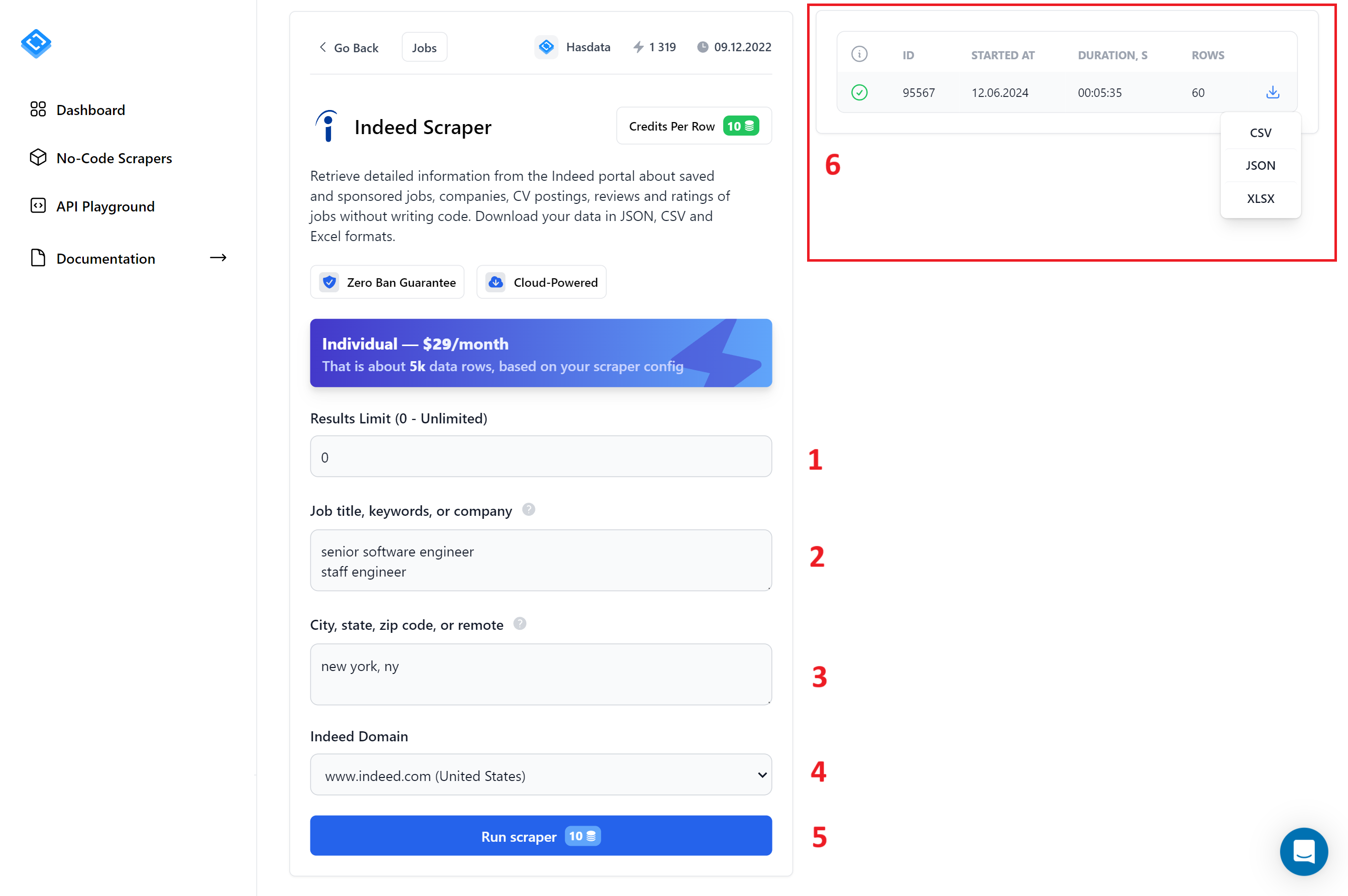

Mari kita lihat lebih dekat halaman ini:

Untuk menyederhanakan prosesnya, kami telah memberi nomor pada berbagai bidang:

- Batas hasil. Masukkan 0 di sini untuk mendapatkan jumlah hasil maksimal untuk setiap kueri.

- Judul pekerjaan, kata kunci, perusahaan. Masukkan kata kunci yang ingin Anda gunakan untuk pencarian pekerjaan Anda. Anda dapat memasukkan beberapa kata kunci, masing-masing pada baris baru.

- KotaNegara

- kode Pos. Masukkan kota tempat Anda ingin mencari pekerjaan.

- Memang domain. Pilih domain Indeed untuk negara tempat Anda mencari pekerjaan.

- Jalankan pengikisKlik tombol ini untuk memulai proses pengikisan.

Tugas pengikis

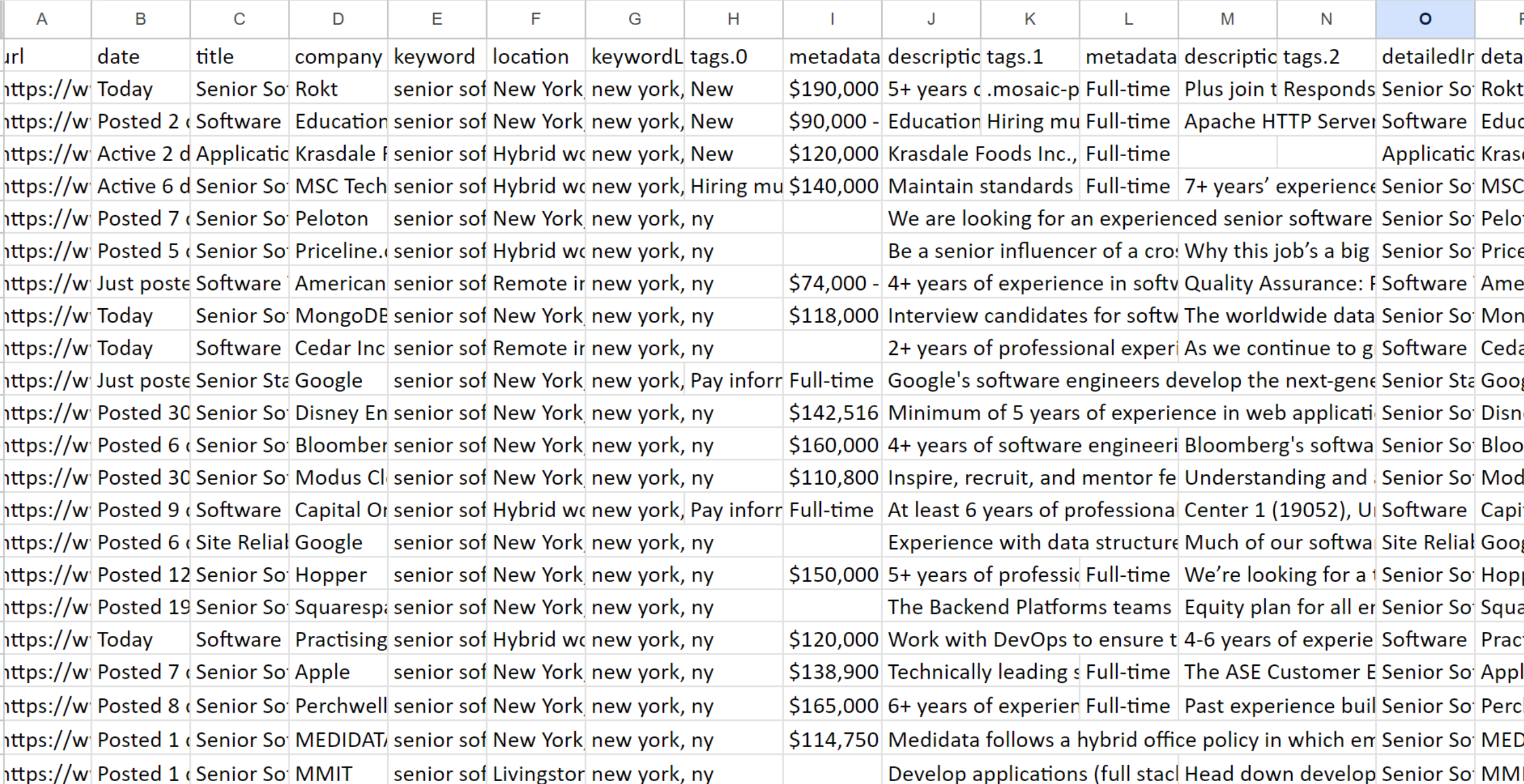

Jelajahi hasilnya

Jelajahi hasilnya

Karena gambarnya terlalu besar, hanya menampilkan sebagian saja. Oleh karena itu, pengikis tanpa kode mengumpulkan semua informasi yang tersedia tentang setiap lowongan pekerjaan, termasuk deskripsi lengkap.

Menggunakan scraper tanpa kode dari Indeed cocok untuk siapa saja yang membutuhkan data dengan cepat dan tidak ingin menulis alat sendiri. Selain itu, karena ia mengumpulkan semua informasi yang tersedia untuk setiap lowongan pekerjaan, Anda bisa mendapatkan kumpulan data terlengkap.

Metode 2: Mengikis data properti Indeed menggunakan Python

Sekarang mari kita membuat alat sederhana menggunakan perpustakaan Permintaan dan menyelesaikan dengan contoh menggunakan browser tanpa kepala. Kami memilih Python sebagai bahasa pemrograman karena cukup sederhana untuk pemula.

Kami juga akan membahas bagaimana mengintegrasikan API dapat membuat pembuatan scraper menjadi lebih mudah. Sementara itu, mari fokus pada persiapan pengumpulan data.

Menyiapkan lingkungan pengembangan Anda

pip install requests bs4 selenium timeUntuk memulai, Anda perlu menginstal penerjemah dan aplikasi yang memungkinkan Anda mengedit kode, atau lingkungan pengembangan lengkap. Kami sudah menulis tentang cara melakukan ini untuk Python.

Anda memerlukan Python versi 3.10 atau lebih baru untuk menjalankan kode yang kami gunakan. Mari kita instal perpustakaan yang akan kita gunakan dengan manajer paket:

Kami telah mencantumkan semua perpustakaan yang diperlukan di sini, termasuk perpustakaan permintaan, yang sudah diinstal sebelumnya jika Anda ingin menggunakan lingkungan virtual. Dalam hal ini Anda perlu menginstal semua perpustakaan lainnya.

Untuk menjalankan Selenium dengan benar, Anda juga memerlukan driver web terpisah tergantung pada browser Anda. Kami menjelaskan penggunaan Selenium dalam artikel terpisah dan menyediakan tautan ke semua driver web (tidak diperlukan untuk versi Selenium terbaru).

Ambil data dengan kueri dan BS4

Mari kita mulai dengan pendekatan sederhana: kita menggunakan perpustakaan permintaan untuk mendapatkan HTML halaman daftar pekerjaan dan kemudian menguraikannya dengan BeautifulSoup. Kami menyimpan data yang diekstraksi dalam sebuah variabel sehingga dapat dengan mudah disimpan ke file.

import requests

from bs4 import BeautifulSoupAnda dapat melihat dan menjalankan skrip bawaan langsung di Google Colaboratory. Namun, Indeed tidak mengembalikan data dalam permintaan, sehingga pengumpulan data dengan cara ini tidak dapat dilakukan.

base_url = "https://www.indeed.com/jobs"

query = "developer"

location = "New York, NY"Jika Anda masih ingin mencobanya sendiri, buat file baru dengan ekstensi .py dan impor perpustakaan:

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/125.0.0.0 Safari/537.36",

"Accept-Language": "en-US,en;q=0.5",

"Referer": "https://www.google.com/",

"Accept-Encoding": "gzip, deflate, br",

"Connection": "keep-alive"

}Selanjutnya, tentukan variabel untuk menampung parameter dinamis seperti jabatan, kata kunci, dan kota:

Selanjutnya, tetapkan judul agar lebih manusiawi:

url = f"{base_url}?q={query}&l={location.replace(' ', '+').replace(',', '%2C')}"Anda dapat menemukan agen pengguna terkini di tabel kami yang diperbarui secara berkala.

response = requests.get(url, headers=headers)

response.raise_for_status()Selanjutnya, buat tautan berdasarkan parameter yang ditentukan.

requests.exceptions.HTTPError: 403 Client Error: Forbidden for url: https://www.indeed.com/jobs?q=developer&l=New+York%2C+NYBuat permintaan dan periksa statusnya:

Akibatnya, Anda akan menerima pesan kesalahan:

Sayangnya, satu-satunya cara untuk mengatasi masalah ini adalah dengan menggunakan browser tanpa kepala, bukan pustaka permintaan, atau dengan menggunakan API scraping Indeed yang telah dibuat sebelumnya.

Menangani konten dinamis dengan Selenium

from selenium import webdriver

from selenium.webdriver.common.by import By

from selenium.webdriver.chrome.options import Options

from bs4 import BeautifulSoup

import timeMari kita atasi masalah dari contoh sebelumnya dan menulis ulang kode menggunakan perpustakaan Selenium. Skrip yang sudah selesai juga tersedia di Google Colaboratory. Namun, karena tidak mendukung browser tanpa kepala, Anda perlu mengunduh dan menjalankannya di komputer lokal Anda untuk mengujinya.

base_url = "https://www.indeed.com/jobs"

query = "developer"

location = "New York, NY"

url = f"{base_url}?q={query}&l={location.replace(' ', '+').replace(',', '%2C')}"Buat file baru dengan ekstensi *.py dan impor modul yang diperlukan:

chrome_options = Options()

driver = webdriver.Chrome(options=chrome_options)

driver.get(url)

time.sleep(5)Kami juga mengimpor perpustakaan waktu untuk memperkenalkan penundaan setelah browser dimulai. Selanjutnya, kita atur parameternya dan buat tautannya:

page_source = driver.page_sourceUntuk berinteraksi dengan halaman web, Anda harus terlebih dahulu membuat instance driver web dan mengonfigurasi pengaturannya. Setelah driver web diinisialisasi, Anda dapat memulainya dan menavigasi ke URL yang diinginkan:

output_data = ()

job_listings = driver.find_elements(By.CLASS_NAME, 'result')

for job in job_listings:

try:

company_location = job.find_element(By.CLASS_NAME, 'company_location')

company_name = company_location.find_element(By.CSS_SELECTOR, 'span(data-testid="company-name")').text

job_location = company_location.find_element(By.CSS_SELECTOR, 'div(data-testid="text-location")').text

print(f"Company Name: {company_name}")

print(f"Job Location: {job_location}")

job_metadata = job.find_element(By.CLASS_NAME, 'jobMetaDataGroup')

posted_date = job_metadata.find_element(By.CSS_SELECTOR, 'span(data-testid="myJobsStateDate")').text.splitlines()(1).strip()

print(f"Posted Date: {posted_date}")

job_data = {

"Company Name": company_name,

"Job Location": job_location,

"Posted Date": posted_date

}

output_data.append(job_data)

except Exception as e:

print(f"Error extracting job information: {e}")

print("\n" + "-"*100 + "\n")Dapatkan sumber halaman:

driver.quit()Sekarang buat variabel untuk menyimpan data. Kemudian temukan blok postingan pekerjaan dan ekstrak informasi yang relevan. Terakhir, tampilkan data yang diekstrak dan simpan dalam variabel:

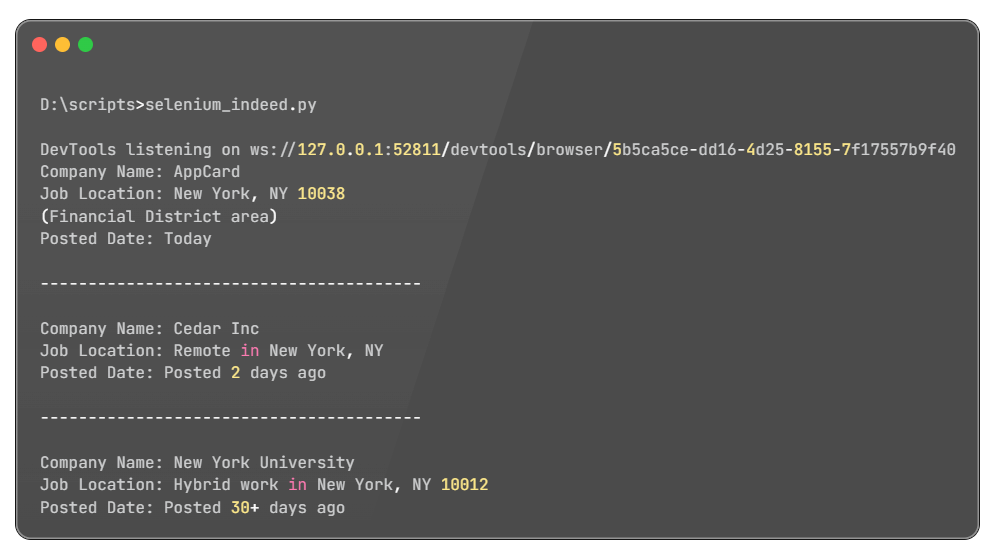

Menguji skrip

Menguji skrip

Skrip ini dapat diperluas untuk mengumpulkan informasi terperinci secara efisien dari setiap lowongan pekerjaan. Anda dapat mencapai hal ini dengan menelusuri semua lowongan pekerjaan yang tersedia dan mengekstrak data yang relevan menggunakan penyeleksi yang sesuai. Selain itu, Anda dapat menyesuaikan skrip untuk fokus pada informasi spesifik sesuai kebutuhan Anda.

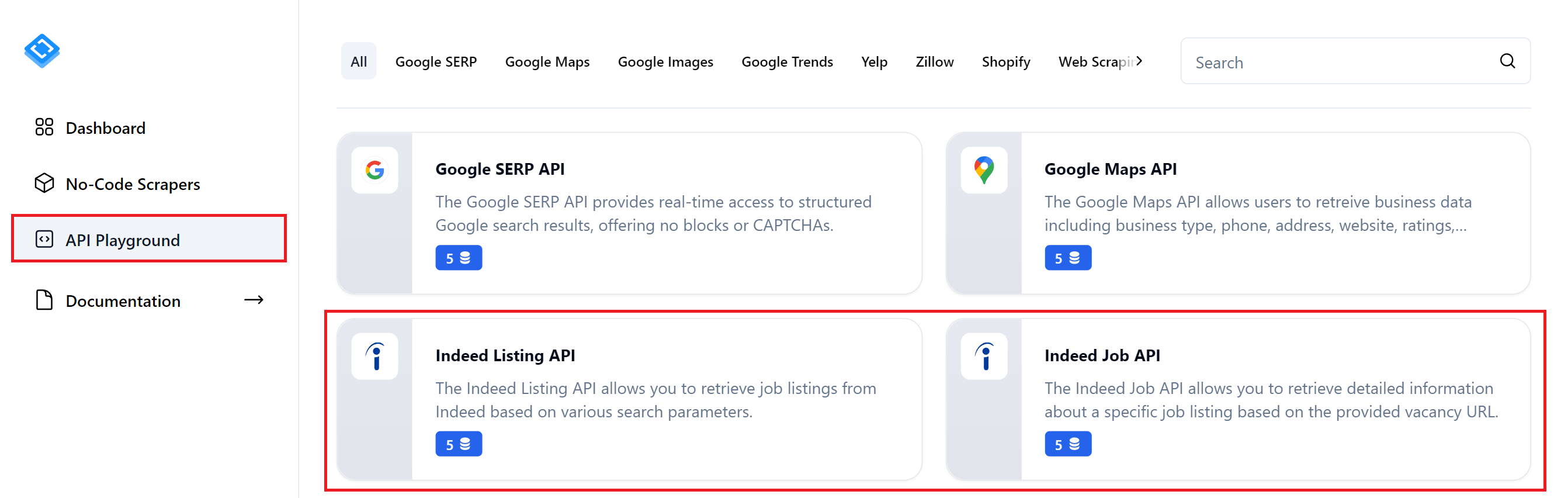

- Metode 3: Mengikis Memang menggunakan APISekarang mari kita lihat bagaimana Anda dapat mengintegrasikan API Indeed ke dalam skrip Anda untuk menghindari kebutuhan akan browser tanpa kepala dan penguraian situs kerja untuk mengambil data. Kita akan melihat lebih dekat dua API Indeed:

- API Daftar Memang. Mengambil data dari halaman hasil pencarian kerja. Datanya kurang komprehensif, namun mencakup semua pekerjaan yang terdaftar.

API Properti Memang

Taman Bermain API Penelitian

Temukan API Memang

API ini memenuhi berbagai kebutuhan pengambilan data. Jika API Listingan Indeed tidak memberikan tingkat detail yang Anda perlukan, Anda dapat menggunakan API Properti Indeed untuk mengumpulkan data detail untuk listingan pekerjaan tertentu.

Mengikis daftar menggunakan Indeed API

import requests

import jsonPertama, mari kita lihat daftar lowongan pekerjaan dan informasi singkatnya. Anda dapat meninjau dan menjalankan skrip yang telah disiapkan di Google Colaboratory. Saat menggunakannya, ingatlah untuk memberikan kunci HasData API dan parameter kueri pencarian pekerjaan Anda.

base_url = "https://api.hasdata.com/scrape/indeed/listing"

keyword = "software engineer"

location = "New York, NY"

domain = "www.indeed.com"Buat file baru dan impor perpustakaan yang diperlukan:

url = f"{base_url}?keyword={keyword.replace(' ', '+')}&location={location.replace(' ', '+').replace(',', '%2C')}&domain={domain}"Tentukan variabel dan titik akhir untuk Inleed Listing API HasData:

headers = {

'Content-Type': 'application/json',

'x-api-key': 'PUT-YOUR-API-KEY'

}Tulis tautannya:

response = requests.get(url, headers=headers)

if response.status_code == 200:

data = response.json()

print(json.dumps(data, indent=2))

else:

print(f"Error: {response.status_code} - {response.text}")Tentukan header permintaan, termasuk kunci API Anda:

Contoh respons JSON

Contoh respons JSON

Data ini seharusnya cukup untuk mendapatkan gambaran tentang berbagai tawaran pekerjaan. Namun, jika Anda memerlukan informasi lebih detail tentang tawaran pekerjaan, lihat titik akhir berikut.

Mengikis properti menggunakan Indeed API

pip install urllibTitik akhir ini ideal jika Anda sudah memiliki daftar lowongan pekerjaan yang ingin Anda kumpulkan informasi lebih detailnya. Anda juga dapat menemukan skrip ini di Google Colaboratory

import requests

import json

import urllib.parseDalam contoh ini, kami juga menggunakan perpustakaan urllib untuk memproses URL postingan pekerjaan. Jika Anda belum menginstalnya, gunakan perintah berikut:

base_url = "https://api.hasdata.com/scrape/indeed/job"

job_url = "https://www.indeed.com/viewjob?jk=cf56b58ab740db2a"

encoded_job_url = urllib.parse.quote(job_url, safe="")

url = f"{base_url}?url={encoded_job_url}"Pertama, impor perpustakaan yang diperlukan ke dalam skrip Anda:

headers = {

'Content-Type': 'application/json',

'x-api-key': 'YOUR-API-KEY'

}Selanjutnya, kami menentukan URL untuk titik akhir API dan postingan pekerjaan yang diinginkan, dan membuat URL umum untuk mengambil data:

response = requests.get(url, headers=headers)

if response.status_code == 200:

data = response.json()

print(json.dumps(data, indent=2))

else:

print(f"Error: {response.status_code} - {response.text}")Tetapkan header permintaan, termasuk kunci API HasData Anda:

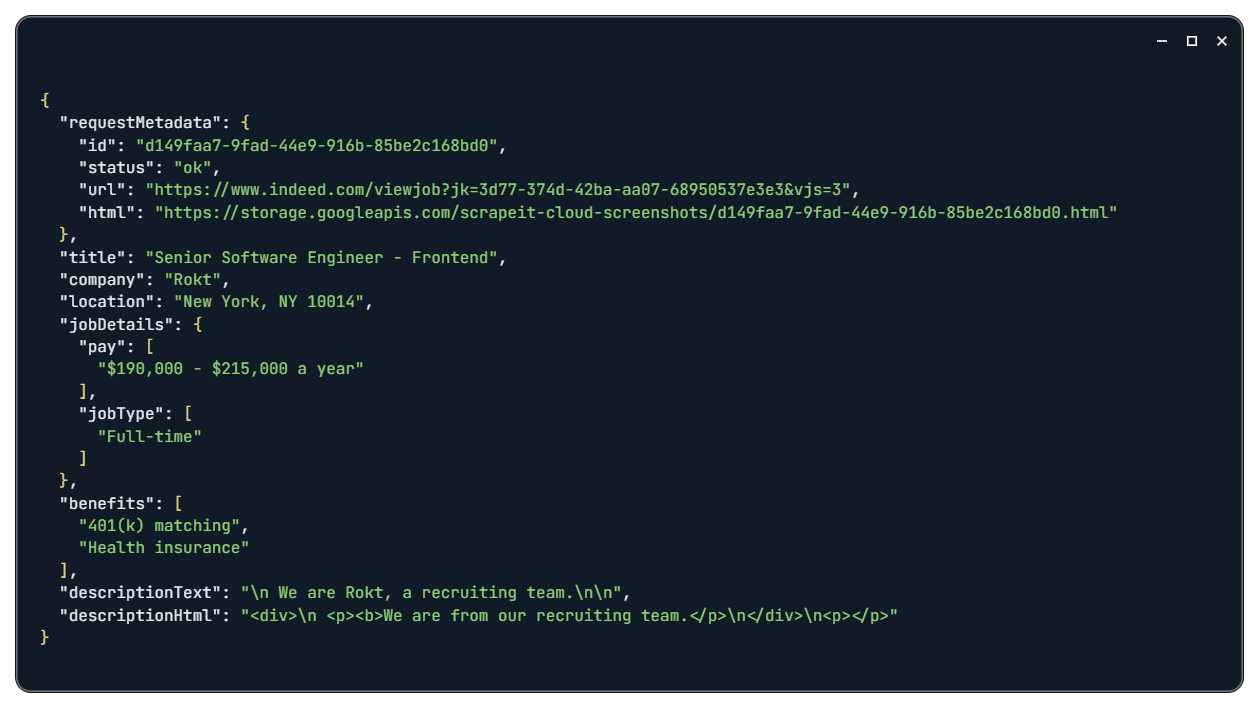

Memang Hasil Pekerjaan

Memang Jawaban Pekerjaan

Dengan memasukkan teks deskripsi pekerjaan lengkap, Anda dapat mengakses semua informasi yang tersedia tentang lowongan masing-masing.

pip install json csvPemrosesan dan penyimpanan data

import json

import csvAnda memerlukan perpustakaan yang sesuai untuk menyimpan data ke file dengan Python. Mari instal pustaka JSON dan CSV menggunakan manajer paket:

csv_file="jobs_data.csv"

with open(csv_file, 'w', newline="", encoding='utf-8') as csvfile:

fieldnames = ('Company Name', 'Job Location', 'Posted Date')

writer = csv.DictWriter(csvfile, fieldnames=fieldnames)

writer.writeheader()

for job in output_data:

writer.writerow(job)Selanjutnya, impor perpustakaan ke dalam skrip Python Anda:

json_file="jobs_data.json"

with open(json_file, 'w', encoding='utf-8') as jsonfile:

json.dump(output_data, jsonfile, ensure_ascii=False, indent=4)Sekarang tambahkan logika untuk menyimpan data ke file. Mari gunakan variabel yang dibuat sebelumnya sebagai sumber data. Untuk menyimpan sebagai file CSV:

Untuk menyimpan sebagai file JSON:

Ini berarti data yang ditentukan sebelumnya disimpan dalam file dan tersedia untuk Anda dalam format yang sesuai untuk diproses lebih lanjut.

Diploma

Mengambil data pekerjaan dari Indeed memberikan wawasan pasar tenaga kerja yang berharga, meningkatkan strategi perekrutan, dan memastikan keunggulan kompetitif dalam proses perekrutan. Artikel ini membahas metode utama pengumpulan data dari platform ini. Kami telah memberikan perincian mendetail dari setiap pendekatan, mulai dari penggunaan scraper tanpa kode hingga membuat scraper khusus dari awal.

Selain itu, kami telah membuat semua skrip yang dibahas dalam artikel ini tersedia di Google Colaboratory. Jika Anda lebih tertarik pada hasil daripada teori, Anda dapat langsung mengakses halaman terkait dan melihat skrip yang sudah jadi. Tautan ke skrip ini dapat ditemukan di awal setiap subbagian yang relevan. Secara keseluruhan, kami berharap artikel ini menggambarkan manfaat dari scraping Indeed dan memberi Anda wawasan berharga yang dapat Anda terapkan dalam upaya Anda sendiri.